1. はじめに¶

1.1. 対象読者と目的¶

1.2. 本書の構成¶

「2. システム構成を決定する」:動作環境の確認や設定について説明します。

「3. クラスタシステムを設計する」:クラスタシステムの設計方法について説明します。

「4. CLUSTERPRO をインストールする」:CLUSTERPRO をインストールする手順について説明します。

「5. ライセンスを登録する」:ライセンスの登録方法について説明します。

「6. クラスタ構成情報を作成する」:クラスタ構成情報の作成について説明します。

「7. クラスタシステムを確認する」:作成したクラスタシステムが正常に動作するかを確認します。

「9. 運用開始前の準備を行う」:本番運用を開始する際に注意事項について説明します。

「10. CLUSTERPRO をアンインストール/再インストールする」:アンインストール、再インストール情報について説明します。

「11. トラブルシューティング」:インストールや設定関連のトラブルとその解決策について説明します。

1.3. CLUSTERPRO マニュアル体系¶

CLUSTERPRO のマニュアルは、以下の 4 つに分類されます。各ガイドのタイトルと役割を以下に示します。

『CLUSTERPRO X スタートアップガイド』 (Getting Started Guide)

すべてのユーザを対象読者とし、製品概要、動作環境、アップデート情報、既知の問題などについて記載します。

『CLUSTERPRO X インストール&設定ガイド』 (Install and Configuration Guide)

CLUSTERPRO を使用したクラスタシステムの導入を行うシステムエンジニアと、クラスタシステム導入後の保守・運用を行うシステム管理者を対象読者とし、CLUSTERPRO を使用したクラスタシステム導入から運用開始前までに必須の事項について説明します。実際にクラスタシステムを導入する際の順番に則して、CLUSTERPRO を使用したクラスタシステムの設計方法、CLUSTERPRO のインストールと設定手順、設定後の確認、運用開始前の評価方法について説明します。

『CLUSTERPRO X リファレンスガイド』 (Reference Guide)

管理者、および CLUSTERPRO を使用したクラスタシステムの導入を行うシステムエンジニアを対象とし、CLUSTERPRO の運用手順、各モジュールの機能説明およびトラブルシューティング情報等を記載します。『インストール&設定ガイド』を補完する役割を持ちます。

『CLUSTERPRO X メンテナンスガイド』 (Maintenance Guide)

管理者、および CLUSTERPRO を使用したクラスタシステム導入後の保守・運用を行うシステム管理者を対象読者とし、CLUSTERPRO のメンテナンス関連情報を記載します。

1.4. 本書の表記規則¶

本書では、注意すべき事項、重要な事項および関連情報を以下のように表記します。

注釈

この表記は、重要ではあるがデータ損失やシステムおよび機器の損傷には関連しない情報を表します。

重要

この表記は、データ損失やシステムおよび機器の損傷を回避するために必要な情報を表します。

参考

この表記は、参照先の情報の場所を表します。

また、本書では以下の表記法を使用します。

表記 |

使用方法 |

例 |

|---|---|---|

[ ] 角かっこ |

コマンド名の前後

画面に表示される語 (ダイアログボックス、メニューなど) の前後

|

[スタート] をクリックします。

[プロパティ] ダイアログ ボックス

|

コマンドライン中の [ ] 角かっこ |

かっこ内の値の指定が省略可能であることを示します。 |

|

モノスペースフォント |

パス名、コマンド ライン、システムからの出力 (メッセージ、プロンプトなど)、ディレクトリ、ファイル名、関数、パラメータ |

|

太字 |

ユーザが実際にコマンドプロンプトから入力する値を示します。 |

以下を入力します。

clpcl -s -a

|

|

ユーザが有効な値に置き換えて入力する項目 |

|

本書の図では、CLUSTERPROを表すために このアイコンを使用します。

本書の図では、CLUSTERPROを表すために このアイコンを使用します。

2. システム構成を決定する¶

本章では、CLUSTERPROを用いたクラスタシステムのシステム構成を決定する方法について説明します。

本章で説明する項目は以下の通りです。

2.1. クラスタシステム設計から運用開始前テストまでの流れ¶

参考

本ガイドの流れに従って操作を行うためには、本ガイドの手順に従いながら、随時『リファレンスガイド』を参照する必要があります。また、動作環境やリリース情報などの最新情報は、『スタートアップガイド』を参照してください。

手順は下記の章に対応します。

クラスタシステムの設計

CLUSTERPRO を実際にインストールする前に、ハードウェア構成、クラスタシステム設計、およびクラスタ構成情報の作成を行います。

CLUSTERPRO X のインストールと設定

CLUSTERPRO をインストールし、ライセンス登録およびクラスタ構成情報の適用を行います。

運用開始前のクラスタシステムの評価

クラスタシステムを実際に運用開始する前に必要な偽障テスト、パラメータ調整、業務シミュレーションを行います。また、アンインストールおよび再インストール手順についても説明します。

2.2. CLUSTERPRO とは?¶

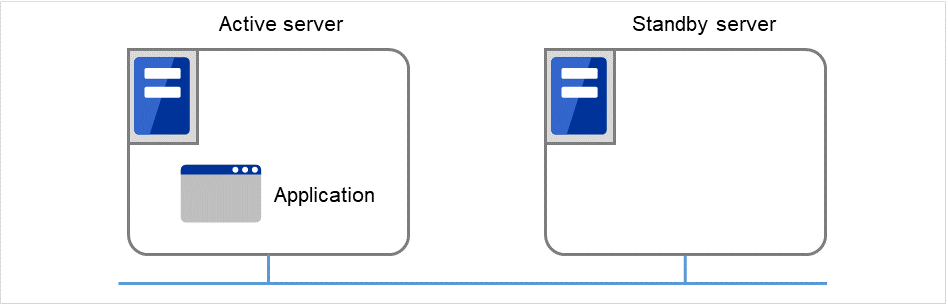

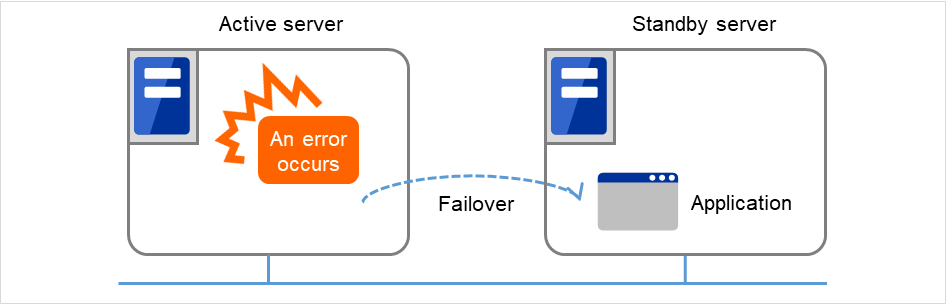

CLUSTERPRO とは、冗長化 (クラスタ化) したシステム構成により、現用系のサーバでの障害が発生した場合に、自動的に待機系のサーバで業務を引き継がせることで、飛躍的にシステムの可用性と拡張性を高めることを可能にするソフトウェアです。

図 2.1 クラスタシステム(正常動作時)¶

図 2.2 クラスタシステム(エラー発生時)¶

CLUSTERPRO を使用したクラスタシステムの導入により、次の効果を得られます。

- 高可用性クラスタを構成するサーバのうち一台が障害などにより停止しても、そのサーバが処理していた業務を他の健全なサーバへ自動的に引き継ぐことにより、障害時の業務停止時間を最小限に抑えます。

- 高拡張性最大で Windows版、Linux版ともに32台までの大規模クラスタ構成をサポートしています。

参考

CLUSTERPRO の詳細については、『スタートアップガイド』の「CLUSTERPRO について」を参照してください。

2.2.1. CLUSTERPRO のソフトウェア構成¶

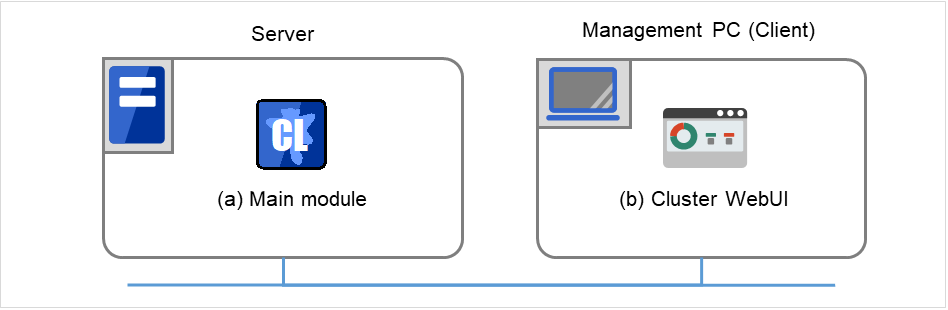

CLUSTERPRO X は、以下の 2 つのソフトウェアで構成されています。

- CLUSTERPRO 本体CLUSTERPRO のメインモジュールです。クラスタを構成する各サーバにインストールします。

- Cluster WebUICLUSTERPRO の構成情報の作成や運用管理を行うための管理ツールです。ユーザインターフェースとしてWeb ブラウザを利用します。実体はCLUSTERPRO 本体に組み込まれていますが、操作は管理端末上の Web ブラウザで行うため、CLUSTERPRO 本体とは区別されています。

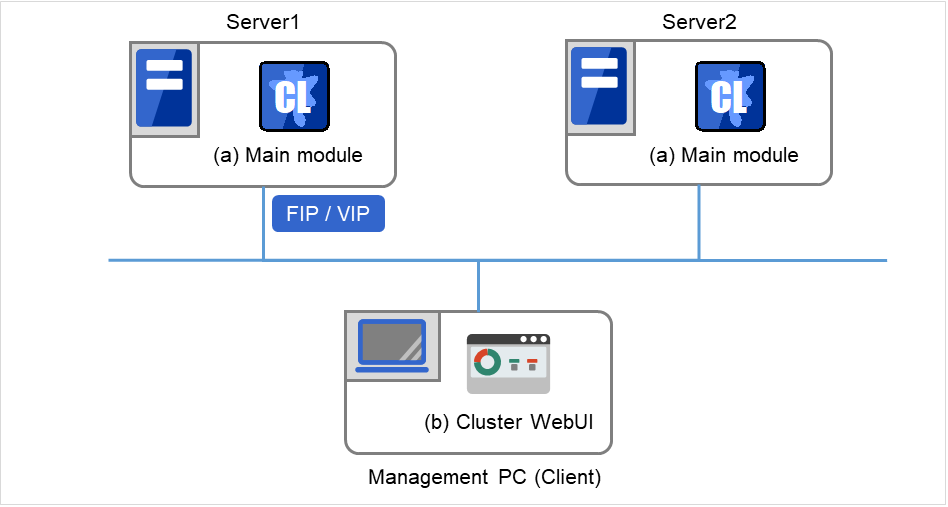

図 2.3 ソフトウェア構成¶

2.3. システム構成の検討¶

構築するクラスタの用途や運用形態を良く確認してから、ハードウェア構成を決定します。以下に CLUSTERPRO の構成例を記載します。

参考

動作環境やリリース情報などの最新情報は 『スタートアップガイド』の「CLUSTERPRO の動作環境」、および「最新バージョン情報」で確認してください。

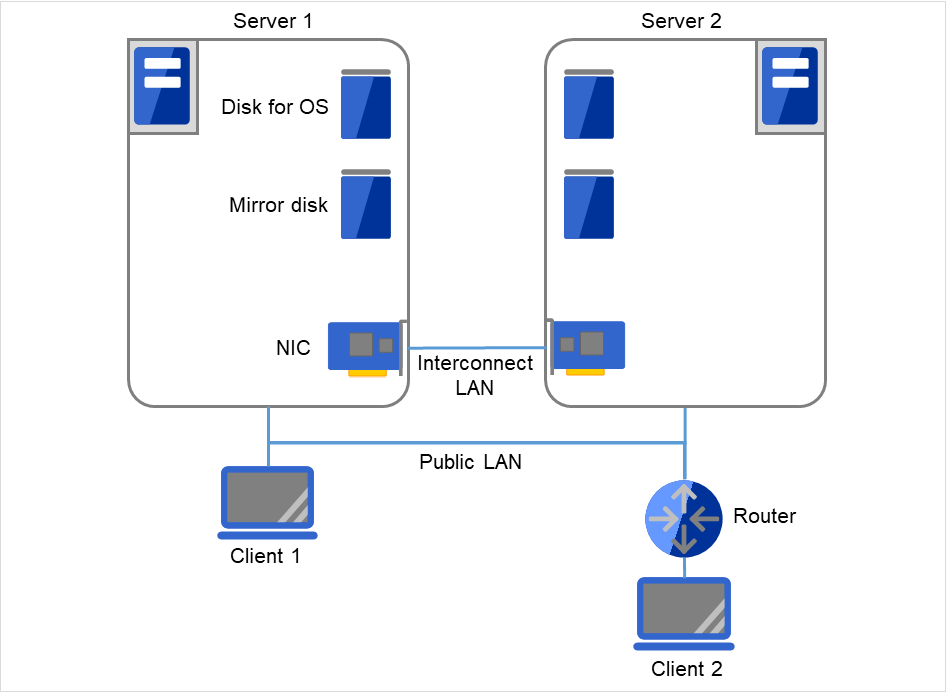

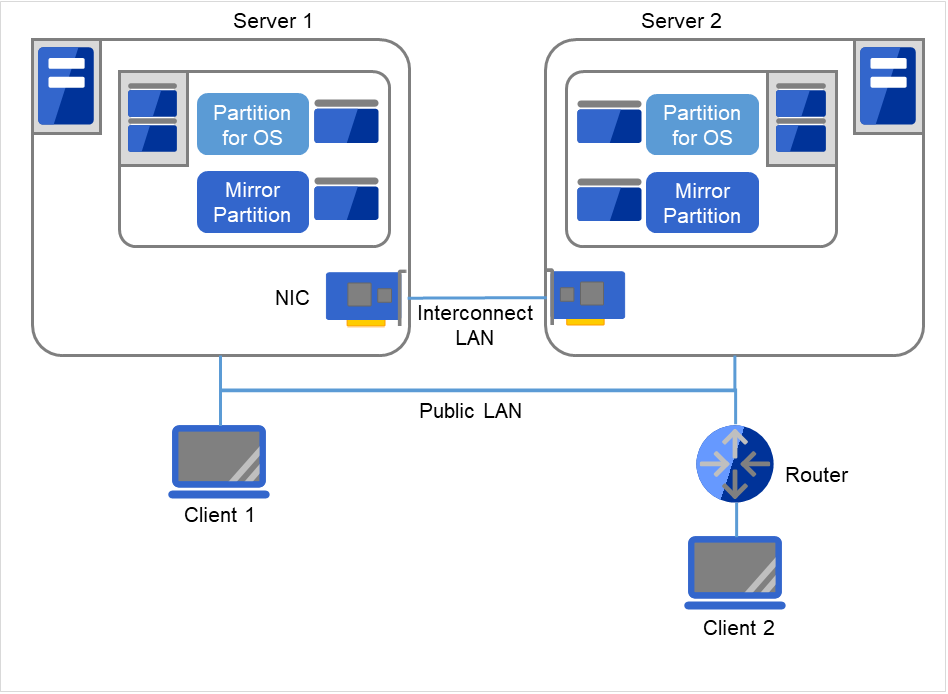

2.3.3. 2 ノードでミラーディスクを使用する場合の構成例¶

クラスタサーバである Server 1、Server 2では、同じドライブ文字を設定する必要があります。 異なる機種で構成することもできます。 ただし、ミラー用パーティションはByte単位で完全に同じサイズでなければなりません。ディスクのジオメトリが異なると、同じサイズのパーティションを作成できない可能性があります。 インタコネクトを接続します。 サーバ間を直接ケーブルで接続することを推奨しますが、HUB などを経由して接続してもかまいません。 クラスタサーバと同一LAN上のクライアント(Client 1)は、フローティングIPを使用してクラスタサーバと接続できます。 リモートLAN上のクライアント(Client 2)も、フローティングIPを使用してクラスタサーバと接続できます。 フローティングIPを使用するために、ルータ(Router)に特別な設定をする必要はありません。

図 2.5 2 ノードでミラーディスクを使用する場合の構成例¶

2.3.4. 2 ノードでミラー用領域を OS 用領域と混在させる場合の構成例¶

Server 1、Server 2では、同じドライブ文字を設定する必要があります。 異なる機種で構成することもできます。 ただし、ミラー用パーティションはByte単位で完全に同じサイズでなければなりません。 ディスクのジオメトリが異なると、同じサイズのパーティションを作成できない可能性があります。 ミラー用のパーティションは、OS 用に使用しているディスクと同じディスク上に確保することが可能です。 クラスタサーバと同一LAN上のクライアント(Client 1)は、フローティングIPを使用してクラスタサーバと接続できます。 リモートLAN上のクライアント(Client 2)も、フローティングIPを使用してクラスタサーバと接続できます。 フローティングIPを使用するために、ルータ(Router)に特別な設定をする必要はありません。

図 2.6 2 ノードでミラー用領域を OS 用領域と混在させる場合の構成例¶

参考

ミラー用パーティションの設定に関しては『リファレンスガイド』の「グループリソースの詳細」の「ミラーディスクリソースを理解する」を参照してください。

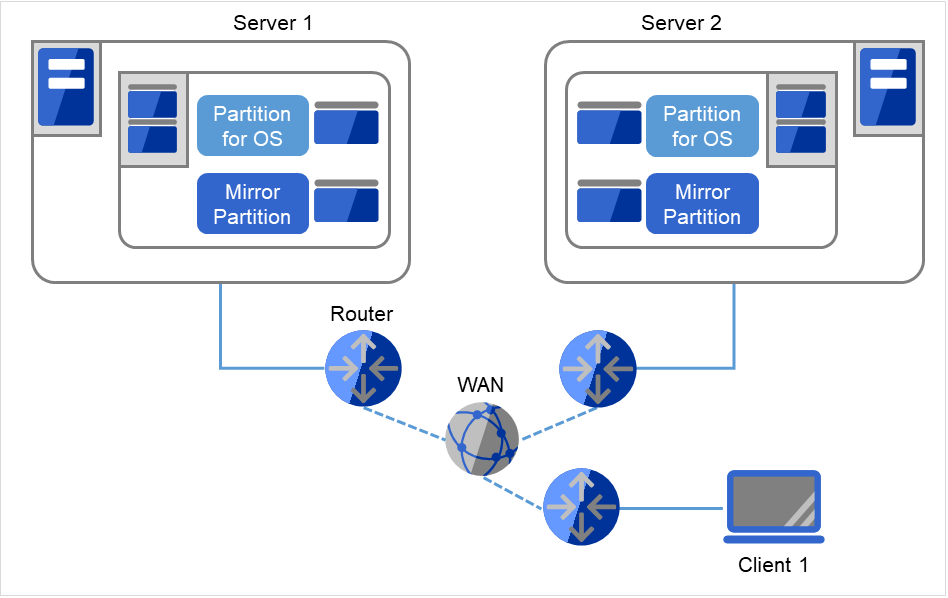

2.3.5. 2 ノードで非同期ミラーディスクによる遠隔クラスタを構成する場合の構成例¶

Server 1、Server 2では、同じドライブ文字を設定する必要があります。 異なる機種で構成することもできます。 ただし、ミラー用パーティションはByte単位で完全に同じサイズでなければなりません。 ディスクのジオメトリが異なると、同じサイズのパーティションを作成できない可能性があります。 VIPを使用するためには、RIPのホストルートを伝達するルータを使用する必要があります。 クライアントからはVIPを使用してクラスタサーバとの接続が可能です。

災害対策として、下図のように WAN を経由して遠隔地間でクラスタ構築を行うことが可能です。

非同期方式のミラーディスクを用いることにより、ネットワークの遅延によるディスク性能低下を抑えることができますが、フェイルオーバ発生時に直前のディスク更新情報が失われる可能性があります。

ミラーディスク上のデータ更新量に対して十分な通信帯域を確保する必要があります。帯域が狭いと業務クライアントとの通信遅延やミラーリングの中断が発生します。

接続先の切り替えにはダイナミックDNSリソース、あるいは仮想IPリソースを使用します。

図 2.7 2 ノードで非同期ミラーディスクによる遠隔クラスタを構成する場合の構成例¶

参考

ネットワークパーティション解決と VIP の設定に関しては 『リファレンスガイド』の「グループリソースの詳細」の「仮想 IP リソースを理解する」、および「ネットワークパーティション解決リソースの詳細」を参照してください。

2.4. CLUSTERPRO モジュール別の動作環境を確認する¶

CLUSTERPRO X の基本モジュールは、CLUSTERPRO Server (本体モジュール)、Cluster WebUI の 2 つで構成されています。各モジュールを使用するマシンごとに、動作環境を確認してください。動作環境については、『スタートアップガイド』の「CLUSTERPRO の動作環境」を参照してください。

2.5. ハードウェア構成の決定¶

ハードウェア構成の決定は、クラスタシステム上で二重化するアプリケーションとクラスタシステムの設計を考慮して行う必要があります。次章の「 3. クラスタシステムを設計する 」を確認した後に行ってください。

参考

「3. クラスタシステムを設計する 」を参照してください。

2.6. ハードウェア構成後の設定¶

ハードウェア構成を決定し、実際にハードウェアの設置を行った後に、以下を確認してください。

2.6.2. ミラー用パーティションを設定する (ミラーディスク使用時は必須)¶

以下の手順でミラー用パーティションの設定を行います。この作業はハイブリッド方式で共有ディスクとミラーリングを行うローカルディスク (1 台のサーバにのみ接続されたディスク) に対しても必要です。

注釈

単体サーバをクラスタ化する場合などで、既存のパーティション上のデータを引き続き使用する場合、そのパーティションの再作成など行わないでください。パーティションの再作成など行われると既存のパーティション上のデータは削除されます。

注釈

下記で確保するパーティションを NTFS フォルダにマウントして使用することはできません。

注釈

クラスタパーティションは 1024MiB 以上確保してください。また、クラスタパーティションはフォーマットせず RAW パーティションのままにしてください。

注釈

CLUSTERPRO を再インストールする場合など、既にミラーリング対象のパーティション (ドライブ) が存在する場合、パーティションを作り直す必要はありません。特に、パーティション上にミラーリングすべきデータが既にある場合は、パーティションの作り直しやフォーマットを行うとデータが消去されますのでご注意ください。システムドライブやページファイルのあるドライブ、CLUSTERPRO をインストールしたドライブはミラーリソース用パーティションとして使用できません。ミラーリングする 2 つのデータパーティションは、バイト単位で正確に同じサイズである必要があります。ディスクのジオメトリが異なる場合、正確に同じサイズのパーティションが作成できない場合がありますので、clpvolsz コマンドによりパーティションサイズを確認・調整してください。また、これらのパーティションには各サーバで同じドライブ文字を設定する必要があります。

2.6.3. CLUSTERPRO のサービス起動時間を調整する (必須)¶

クラスタシステムを構成する各サーバに電源を投入してから、CLUSTERPROのサービス が起動するまでの時間を、以下の 2 つより長くなるように設定する必要があります。

共有ディスクに電源を投入してから使用可能になるまでの時間(共有ディスクを使用する場合)

ハートビート タイムアウト時間 ※既定値 30 秒

これは、以下の問題を回避するためです。

共有ディスクとサーバの電源を入れてクラスタシステムを起動した際に、共有ディスクの起動が CLUSTERPRO の起動処理に間に合わず、共有ディスクが認識されない状態で CLUSTERPRO が起動することにより、ディスクリソースの活性に失敗する

サーバの再起動でフェイルオーバを発生させたい場合に、ハートビートタイムアウト時間内にそのサーバが再起動(CLUSTERPROのサービスが起動)してしまうと、相手側からはハートビートが継続しているとみなされフェイルオーバが発生しない

そのため、上記 2 点の時間を計測後、以下のいずれかの方法で起動時間を調整してください。

2.6.4. ネットワーク設定を確認する (必須)¶

クラスタ内のすべてのサーバで、ipconfig コマンドや ping コマンドを使用して、以下のネットワークリソースが正常に動作しているかどうかを確認します

パブリック LAN (他のマシンとの通信用)

インタコネクト専用 LAN (CLUSTERPRO のサーバ間接続用)

ホスト名

注釈

クラスタで使用する フローティング IP リソース、仮想 IP リソースの IP アドレスは OS 側への設定は不要です。

2.6.5. ファイアウォールの設定を確認する (必須)¶

CLUSTERPRO はモジュール間の通信にいくつかのポート番号を使用します。使用するポート番号については、『スタートアップガイド』の「注意制限事項」の「CLUSTERPRO インストール前」を参照してください。

2.6.6. サーバの時刻を同期させる (必須)¶

クラスタシステムでは、クラスタ内のすべてのサーバの時刻を定期的に同期する運用を推奨します。1 日 1 回程度を目安に ntp などを使用してサーバの時刻を同期させる設定にしてください。

注釈

各サーバの時刻が同期されていない場合、フェイルオーバやグループ移動の際にクライアントから見たサーバ側のシステム時間が変動し、業務アプリケーションの動作に支障をきたす可能性があります。また、サーバ間でログの時刻にずれが発生し、障害時に原因の解析に時間がかかることがあります。

注釈

システム監視リソース/プロセスリソース監視リソース動作中に OS の日付/時刻を変更した場合、正しく動作しない場合があります。

2.6.7. パワーセービング機能をオフにする (必須)¶

CLUSTERPRO 環境では、パワーセービング (スタンバイやハイバネーション) は使用できません。この機能は、必ずオフに設定してください。

2.6.8. BMC と ipmiutil をセットアップする (物理マシンの強制停止機能を使用する場合は必須)¶

物理マシンの強制停止機能を使用する場合は、ベースボード管理コントローラー(BMC) のマネージメント用LAN ポートのIP アドレスとOS が使用するIP アドレスの間で通信ができるように、各サーバのBMC を設定してください。サーバにBMC が搭載されていない場合や、BMC のマネージメント用のネットワークが閉塞している状態では、これらの機能は使用できません。BMC の設定方法については、各サーバのマニュアルを参照してください。

ipmiutil のバージョンは 2.0.0 ~ 3.0.8 を使用してください。

CLUSTERPRO ではIpmiutil のhwreset コマンドまたはireset コマンドと、alarms コマンドまたはialarms コマンドを使用します。これらのコマンドがパス指定無しで実行可能なように、ipmiutil の実行ファイルのパスをシステム環境変数 "PATH" に含めるか、既に含まれているいずれかのフォルダ (例えばCLUSTERPROのインストール先フォルダ配下にある bin フォルダ) に実行ファイルをコピーしてください。CLUSTERPRO では IPMI ドライバを必要とする機能は使用していないため、IPMI ドライバのインストールは必要ありません。

上記のコマンドによりLAN 経由でBMC を制御するには、各サーバのBMC にAdministrator権限のある IPMI アカウントが必要です。NEC Express5800/100 シリーズのサーバを使用する場合は、User ID 3 までは他のツールで予約されているため、アカウントを追加・変更する場合は User ID 4 以降を使用してください。アカウント設定の確認・変更には IPMITool 等の IPMI 規格に準拠したツールを使用してください。

2.6.9. ネットワーク警告灯メーカー提供の rsh 相当の機能をセットアップする(必須)¶

ネットワーク警告灯機能を使用する場合は、警告灯のメーカーがサポートする rsh 相当のコマンドをセットアップしてください。

3. クラスタシステムを設計する¶

本章では、二重化するアプリケーションの要件、運用形態、クラスタを構成する各種リソースの説明など、クラスタ設計に際して必要な情報を提供します。

本章で説明する項目は以下の通りです。

3.1. クラスタシステムの設計¶

本章では、クラスタシステムの設計について、以下を行います。

クラスタシステムの運用形態の決定

二重化するアプリケーションの決定

クラスタ構成情報の作成

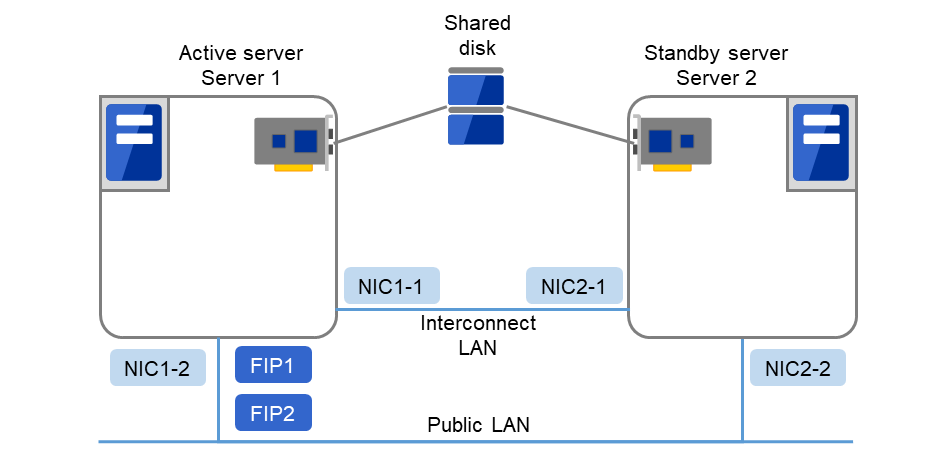

なお、以下の図は、典型的な 2 ノード、片方向スタンバイ構成のクラスタ環境を構築する場合の例です。

図 3.1 2 ノード、片方向スタンバイクラスタの例¶

FIP1 |

10.0.0.11

(Cluster WebUIクライアントからのアクセス先)

|

FIP2 |

10.0.0.12

(業務クライアントからのアクセス先)

|

NIC1-1 |

192.168.0.1 |

NIC1-2 |

10.0.0.1 |

NIC2-1 |

192.168.0.2 |

NIC2-2 |

10.0.0.2 |

共有ディスク (Shared disk)

DISKハートビート ドライブ文字

Q

ファイルシステム

RAW

リソース用切替パーティション ドライブ文字

R

ファイルシステム

NTFS

3.2. 運用形態を決定する¶

CLUSTERPRO は、複数の運用形態をサポートしています。片方のサーバを現用系、他方を待機系とする片方向スタンバイ形式と、両方のサーバがお互いに異なる業務の現用系、待機系となる双方向スタンバイ形式があります。

- 片方向スタンバイクラスタクラスタシステム全体で同一の業務アプリケーションが 1 つしか動作しないシステム形態です。フェイルオーバ発生後もパフォーマンスの劣化等はありませんが、正常時、待機系の資源が無駄になります。

図 3.2 片方向スタンバイクラスタ¶

- 同一アプリケーション双方向スタンバイクラスタクラスタシステム全体で同一の業務アプリケーションが複数動作するシステム形態です。この構成を構築するには業務アプリケーションが多重起動に対応している必要があります。

図 3.3 同一アプリケーション双方向スタンバイクラスタ¶

- 異種アプリケーション双方向スタンバイクラスタ複数の種類の業務アプリケーションが、それぞれ異なるサーバで稼動し、相互に待機するシステム形態です。正常時も資源が無駄になりません。ただし、フェイルオーバ発生後は、1 台のサーバで 2 種の業務が動作するため、業務のパフォーマンスが低下します。

図 3.4 異種アプリケーション双方向スタンバイクラスタ¶

3.2.1. 片方向スタンバイクラスタのフェイルオーバの流れ¶

片方向スタンバイクラスタでは、ある業務が動作するグループがクラスタ内で常に 1 台のサーバ上で動作するように制限されています。

3.2.1.1. 共有ディスク使用時¶

1. Server 1上で業務A(Application A)が実行されています。 ここで、業務Aは同一クラスタ内で複数実行することができません。

図 3.5 片方向スタンバイクラスタ(共有ディスク使用): (1) 通常運用時¶

3.2.1.2. ミラーディスク使用時¶

1. Server 1上で業務A(Application A)が実行されています。 ここで、業務Aは同一クラスタ内で複数実行することができません。

図 3.9 片方向スタンバイクラスタ(ミラーディスク使用): (1) 通常運用時¶

何らかの異常が発生し、Server 1がダウンします。

図 3.10 片方向スタンバイクラスタ(ミラーディスク使用): (2) サーバダウン時¶

Server 1からServer 2へ、業務の引継ぎが行われます。

図 3.11 片方向スタンバイクラスタ(ミラーディスク使用): (3) フェイルオーバ時¶

業務を再開するため、Server 2に接続されたMirror diskからデータ復旧を行います。

図 3.12 片方向スタンバイクラスタ(ミラーディスク使用): (4) データ復旧時¶

Server 1が復旧した後、Server 2からServer 1へ、業務A(Application A)のグループ移動を行うことができます。

図 3.13 片方向スタンバイクラスタ(ミラーディスク使用): (5) サーバ復旧後¶

3.2.2. 双方向スタンバイクラスタフェイルオーバの流れ¶

双方向スタンバイクラスタでは、各サーバ上で別々の業務が動作します。フェイルオーバが発生すると、片サーバで複数の業務が動作するため、正常状態に比べ負荷が増大し、パフォーマンスが低下します。

3.2.2.1. 共有ディスク使用時¶

Server 1上で業務A(Application A)、Server 2上で業務B(Application B)が実行されています。

図 3.14 双方向スタンバイクラスタ(共有ディスク使用): (1) 通常運用時¶

何らかの異常が発生し、Server 1がダウンします。

図 3.15 双方向スタンバイクラスタ(共有ディスク使用): (2) サーバダウン時¶

Server 1からServer 2へ、業務Aの引継ぎが行われます。

図 3.16 双方向スタンバイクラスタ(共有ディスク使用): (3) フェイルオーバ時¶

Server 1が復旧した後、Server 2からServer 1へ、業務A(Application A)のグループ移動を行うことができます。

図 3.17 双方向スタンバイクラスタ(共有ディスク使用): (4) サーバ復旧後¶

3.2.2.2. ミラーディスク使用時¶

Server 1上で業務A(Application A)、Server 2上で業務B(Application B)が実行されています。

図 3.18 双方向スタンバイクラスタ(ミラーディスク使用): (1) 通常運用時¶

何らかの異常が発生し、Server 1がダウンします。

図 3.19 双方向スタンバイクラスタ(ミラーディスク使用): (2) サーバダウン時¶

Server 1からServer 2へ、業務Aの引継ぎが行われます。

図 3.20 双方向スタンバイクラスタ(ミラーディスク使用): (3) フェイルオーバ時¶

業務Aを再開するため、Server 2のMirror partition 1からデータ復旧を行います。

図 3.21 双方向スタンバイクラスタ(ミラーディスク使用): (4) データ復旧時¶

Server 1が復旧した後、Server 2からServer 1へ、業務A(Application A)のグループ移動を行うことができます。

図 3.22 双方向スタンバイクラスタ(ミラーディスク使用): (5) サーバ復旧後¶

3.3. 二重化するアプリケーションを決定する¶

二重化するアプリケーションを決定するには、アプリケーションが CLUSTERPRO によるクラスタシステム上でのクラスタ対象として適しているかどうかを、以下の注意事項を十分に検討して判断します。

3.3.1. 対象アプリケーションについての注意事項¶

3.3.1.1. 注意事項 1: 障害発生後のデータ修復¶

障害発生時に現用系のアプリケーションが更新していたファイルは、フェイルオーバ後に待機系でアプリケーションがそのファイルにアクセスするとき、データ更新として完結していない状態にある場合があります。

非クラスタ (単体サーバ) での障害後のリブートでも同様のことが発生するため、本来アプリケーションはこのような障害に対処するメカニズムを持っている必要がありますが、クラスタシステム上ではこれに加え人間の関与なしに (スクリプトから) 復旧が行える必要があります。

3.3.1.2. 注意事項 2: アプリケーションの終了¶

CLUSTERPRO が業務グループを停止・移動 (オンラインフェイルバック) する場合、その業務グループが使用していたファイルシステムをアンマウントします。このため、アプリケーションへの終了指示にて、共有ディスクまたはミラーディスク上の全てのファイルに対するアクセスが停止される必要があります。

通常は終了スクリプトでアプリケーション終了指示コマンドを実行しますが、終了指示コマンドが (アプリケーションの終了と) 非同期で完了してしまう場合注意が必要です。

3.3.1.3. 注意事項 3: データ格納位置¶

CLUSTERPRO がサーバ間で引き継ぐことのできるデータは次の通りです。

データの種類

例

配置場所

引き継ぎたいデータ

ユーザデータなど

ディスクリソースの切替パーティションまたはミラーディスクリソース/ハイブリッドディスクリソースデータパーティション

引き継ぎたくないデータ

プログラム、設定情報など

サーバのローカルディスク

3.3.1.4. 注意事項 4: 複数業務グループ¶

同一の業務アプリケ―ションを双方向スタンバイで運用する形態では、(障害による縮退時) 1 つのサーバ上で同一アプリケーションによる複数業務グループが稼動することを想定しなくてはなりません。アプリケーションは次のいずれかの方法で引き継がれた資源を引き取り、単一サーバ上で複数業務グループを実行できなければなりません。以下の図は共有ディスク型の例ですが、ミラーディスク型の場合も同様です。

図 3.23 各サーバ上で業務が正常稼働(双方向スタンバイクラスタ)¶

3.3.1.5. 注意事項 5: アプリケーションとの相互干渉、相性問題¶

CLUSTERPRO の機能や動作に必要な OS 機能との相互干渉によってアプリケーションまたは CLUSTERPRO が動作できない場合があります。

- 共有ディスクとミラーディスクのアクセス制御ディスクリソースで管理される共有ディスク上の切替パーティションや、ミラーディスクリソース/ハイブリッドディスクリソースでミラーリングされるデータパーティションはリソースが非活性の状態ではアクセスが制限され、読み込みも書き込みもできない状態となります。アプリケーションが非活性状態の (つまりユーザやアプリケーションからアクセスできない) 共有ディスクまたはミラーディスクにアクセスすると、I/O エラーとなります。通常、CLUSTERPRO から起動されるアプリケーションは、それが起動された時点でアクセスすべき切替パーティションまたはデータパーティションが既にアクセス可となっていることを想定してかまいません。

- マルチホーム環境及び IP アドレスの移動クラスタシステムでは、通常、1つのサーバが複数の IP アドレスを持ちます。また、フローティングIP アドレスや仮想IP アドレスはサーバ間で移動するため、各サーバの IP アドレスの構成は動的に変化します。このようなマルチホーム環境に業務アプリケーションが対応していないと、例えば自サーバのIP アドレスを取得しようとして誤ってインタコネクト専用LAN のアドレスを取得し、クライアントとの通信に使用するアドレスと異なるために誤動作する、といったことがあります。このため、サーバ側のIP アドレスを意識する業務アプリケーションの場合、使用する IP アドレスを明示的に指定できる必要があります。

- アプリケーションの共有ディスクまたはミラーディスクへのアクセス業務アプリケーションと共存するほかのアプリケーションには、業務グループの停止が通知されません。もし、業務グループの停止のタイミングでそのグループが使用している切替パーティションまたはデータパーティションにアクセスしている場合、ディスクの切り離しに失敗してしまいます。システム監視サービスを行うようなアプリケーションの中には、定期的に全てのディスクパーティションをアクセスするようなものがあります。この場合、監視対象パーティションを指定できる機能などが必要になります。

3.3.2. 注意事項に該当する構成¶

対象アプリケーションをどのようなスタンバイ形態にするかで注意事項が異なります。注意事項については「注意事項」 (1 ~ 5) に対応します。

片方向スタンバイ [運用-待機] 注意事項: 1 2 3 5

双方向スタンバイ [運用-運用] 注意事項: 1 2 3 4 5

- 共存動作 注意事項: 5クラスタシステムによるフェイルオーバの対象とはせず、共存動作する運用形態です。

3.3.3. 注意事項に対する対策¶

問題点 |

対策 |

注意事項に対応する番号 |

|---|---|---|

データファイル更新中に障害が発生した場合、待機系にてアプリケーションが正常に動作しない |

プログラム修正、または更新途中のデータを復旧する処理をフェイルオーバ時に実行するようスクリプトリソースを追加/修正する。 |

注意事項 1 |

アプリケーションを停止しても一定時間の間、共有ディスクまたはミラーディスクへアクセスしつづける |

停止スクリプト中に sleep コマンドを使用し待ち合わせる |

注意事項 2 |

一台のサーバ上で同一アプリケーションを複数起動できない |

双方向スタンバイ運用では、フェイルオーバ時にアプリケーションを再起動し共有データを引き継ぐ |

注意事項 3 |

3.3.4. 業務形態の決定¶

本章全体を踏まえた上で、業務形態を決定してください。

どのアプリケーションをいつ起動するか

起動時やフェイルオーバ時に必要な処理は何か

切替パーティションまたはデータパーティションに置くべき情報は何か

3.4. フェイルオーバグループの構成を設計する¶

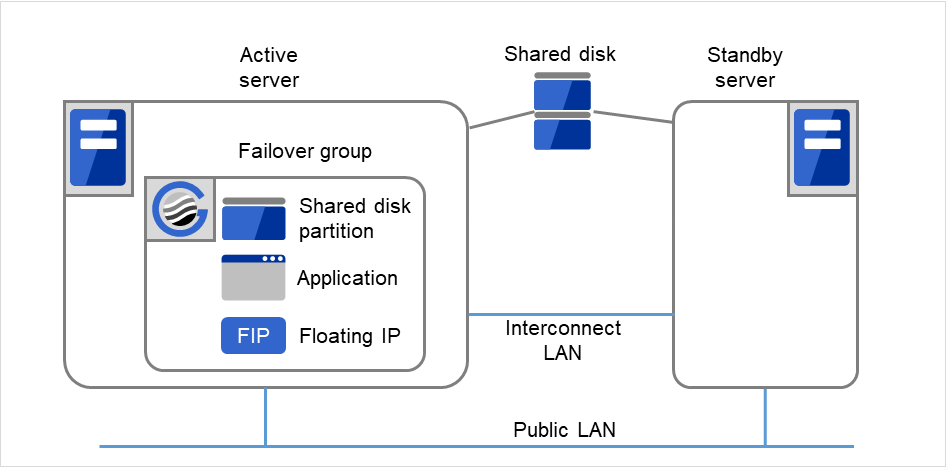

図 3.27 フェイルオーバグループとグループリソース¶

3.5. グループリソースを検討する¶

クラスタシステムでフェイルオーバを実現するには、フェイルオーバの単位となるグループを作成する必要があります。グループを構成するのは、グループリソースです。最適なクラスタを作成するためには、作成するグループにどのようなグループリソースを追加し、どのような設定で運用するかをよく理解する必要があります。

参考

各リソースの詳細は、『リファレンスガイド』の「グループリソースの詳細」を参照してください。

現在サポートされているグループリソースは以下です。

グループリソース名 |

略称 |

|---|---|

アプリケーションリソース |

appli |

CIFS リソース |

cifs |

ダイナミックDNSリソース |

ddns |

フローティング IP リソース |

fip |

ハイブリッドディスクリソース |

hd |

ミラーディスクリソース |

md |

レジストリ同期リソース |

regsync |

スクリプトリソース |

script |

ディスクリソース |

sd |

サービスリソース |

service |

仮想コンピュータ名リソース |

vcom |

仮想 IP リソース |

vip |

AWS Elastic IPリソース |

awseip |

AWS 仮想IPリソース |

awsvip |

AWS セカンダリ IP リソース |

awssip |

AWS DNS リソース |

awsdns |

Azure プローブポートリソース |

azurepp |

Azure DNS リソース |

azuredns |

Google Cloud 仮想 IP リソース |

gcvip |

Google Cloud DNS リソース |

gcdns |

Oracle Cloud 仮想 IP リソース |

ocvip |

Oracle Cloud DNS リソース |

ocdns |

3.6. モニタリソースを理解する¶

- 常時監視

クラスタ起動時~クラスタ停止時まで監視します。

- 活性時監視

グループ活性時~グループ非活性時まで監視します。

参考

各リソースの詳細は、『リファレンスガイド』の「モニタリソースの詳細」を参照してください。

現在サポートされているモニタリソースは以下です。

モニタリソース名 |

略称 |

常時監視 |

活性時監視 |

|---|---|---|---|

アプリケーション監視リソース |

appliw |

✓ |

|

CIFS 監視リソース |

cifsw |

✓ |

|

DB2 監視リソース |

db2w |

✓ |

|

ダイナミックDNS監視リソース |

ddnsw |

✓ |

|

ディスク RW 監視リソース |

diskw |

✓ |

|

フローティング IP 監視リソース |

fipw |

✓ |

|

FTP 監視リソース |

ftpw |

✓ |

|

カスタム監視リソース |

genw |

✓ |

|

ハイブリッドディスク監視リソース |

hdw |

✓ |

|

ハイブリッドディスク TUR 監視リソース |

hdtw |

✓ |

|

HTTP 監視リソース |

httpw |

✓ |

|

IMAP4 監視リソース |

imap4w |

✓ |

|

IP 監視リソース |

ipw |

✓ |

✓ |

ミラーディスク監視リソース |

mdw |

✓ |

|

NIC Link Up/Down 監視リソース |

miiw |

✓ |

✓ |

マルチターゲット監視リソース |

mtw |

✓ |

|

ODBC 監視リソース |

odbcw |

✓ |

|

Oracle 監視リソース |

oraclew |

✓ |

|

WebOTX 監視リソース |

otxw |

✓ |

|

POP3 監視リソース |

pop3w |

✓ |

|

PostgreSQL 監視リソース |

psqlw |

✓ |

|

レジストリ同期監視リソース |

regsyncw |

✓ |

|

ディスク TUR 監視リソース |

sdw |

✓ |

|

サービス監視リソース |

servicew |

✓ |

✓ |

SMTP 監視リソース |

smtpw |

✓ |

|

SQL Server 監視リソース |

sqlserverw |

✓ |

|

Tuxedo 監視リソース |

tuxw |

✓ |

|

仮想コンピュータ名監視リソース |

vcomw |

✓ |

|

仮想 IP 監視リソース |

vipw |

✓ |

|

WebSphere 監視リソース |

wasw |

✓ |

|

WebLogic 監視リソース |

wlsw |

✓ |

|

外部連携監視リソース |

mrw |

✓ |

|

JVM 監視リソース |

jraw |

✓ |

✓ |

システム監視リソース |

sraw |

✓ |

|

プロセスリソース監視リソース |

psrw |

✓ |

|

プロセス名監視リソース |

psw |

✓ |

✓ |

ユーザ空間監視リソース |

userw |

✓ |

|

AWS Elastic IP 監視リソース |

awseipw |

✓ |

|

AWS 仮想 IP 監視リソース |

awsvipw |

✓ |

|

AWS セカンダリ IP 監視リソース |

awssipw |

✓ |

|

AWS AZ 監視リソース |

awsazw |

✓ |

|

AWS DNS 監視リソース |

awsdnsw |

✓ |

|

Azure プローブポート監視リソース |

azureppw |

✓ |

|

Azure ロードバランス監視リソース |

azurelbw |

✓ |

|

Azure DNS 監視リソース |

azurednsw |

✓ |

|

Google Cloud 仮想 IP 監視リソース |

gcvipw |

✓ |

|

Google Cloud ロードバランス監視リソース |

gclbw |

✓ |

|

Google Cloud DNS 監視リソース |

gcdnsw |

✓ |

|

Oracle Cloud 仮想 IP 監視リソース |

ocvipw |

✓ |

|

Oracle Cloud ロードバランス監視リソース |

oclbw |

✓ |

|

Oracle Cloud DNS 監視リソース |

ocdnsw |

✓ |

3.7. ハートビートリソースを理解する¶

クラスタ内のサーバは他のサーバの死活監視を行います。サーバ間の死活監視はハートビートリソースを使用します。

カーネルモードLANハートビート(プライマリインタコネクト)

図 3.28 カーネルモードLANハートビート(プライマリインタコネクト)¶

カーネルモードLANハートビート(セカンダリインタコネクト)

図 3.29 カーネルモードLANハートビート(セカンダリインタコネクト)¶

Witnessハートビート

図 3.30 Witnessハートビート¶

ハートビートリソースの種類 |

略称 |

機能概要 |

|---|---|---|

カーネルモード LAN ハートビート

リソース (1), (2)

|

lankhb |

カーネルモードのモジュールが LAN を使用してサーバの死活監視を行います |

Witness ハートビートリソース (3) |

witnesshb |

Witness サーバを使用してサーバの死活監視を行います。 |

優先度が一番高いインタコネクトには、全サーバ間で通信可能なカーネルモード LAN ハートビートを設定してください。

カーネルモード LAN ハートビートリソースを 2 つ以上設定することを推奨します(クラウド環境や遠隔クラスタ環境のようにネットワークの追加が難しい場合はその限りではありません)。

インタコネクト専用の LAN をカーネルモード LAN ハートビートリソースとして登録し、さらにパブリック LAN もカーネルモード LAN ハートビートリソースとして登録することを推奨します。

3.8. ネットワークパーティション解決リソースを理解する¶

ネットワークパーティション解決方式には下記の方法があります。

PING 方式

- ping コマンドを受信し、応答を返却可能な常時稼動している装置(以下、「ping用装置」と省略します) が必要です。

- ping 用装置は複数指定することができます。

- 他サーバからのハートビートの途絶を検出した際に、ping 用装置から ping コマンドの応答がある場合にはハートビートの途絶したサーバがダウンしたと判断してフェイルオーバを実施し、ping コマンドの応答がない場合はネットワークパーティション状態により自身がネットワークから孤立したものと判断して緊急シャットダウンします。これにより、ネットワークパーティション状態が発生した際に、クライアントと通信可能な方のサーバで業務を継続することができます。

HTTP 方式

- 常時稼働している Web サーバが必要です。

- 他サーバからのハートビートの途絶を検出した際に、HTTP HEAD リクエストに対するレスポンスがある場合にはハートビートの途絶したサーバがダウンしたと判断してフェイルオーバを実施し、レスポンスがない場合はネットワークパーティション状態により自身がネットワークから孤立したものと判断して緊急シャットダウンします。これにより、ネットワークパーティション状態が発生した際に、クライアントと通信可能な方のサーバで業務を継続することができます。

- Web サーバの障害などにより、ハートビートが途絶する前に HTTP HEAD リクエストへのレスポンスがない状態が続くと、ネットワークパーティションの解決ができなくなりますので、この状態でハートビート切れを検出した場合、全サーバが緊急シャットダウンを実行します。

DISK 方式

- 共有ディスクを使用するクラスタで選択できます。

- 共有ディスク上に専用のディスクパーティション (ディスクハートビート用パーティション)が必要です。

- 共有ディスク上に定期的にデータを書き込み、他サーバの最終生存時刻を計算することでネットワークパーティション状態の判定を行います。

- 共有ディスクや共有ディスクへの経路 (SCSI バスなど) に異常が発生している状態で他サーバからのハートビートの途絶を検出した場合は、ネットワークパーティションの解決が失敗するため、フェイルオーバできません。正常なサーバも緊急シャットダウンします。

- 共有ディスクが正常な状態で全てのネットワーク通信路に障害が発生した場合は、ネットワークパーティションを検出して、マスタサーバ及びマスタサーバと通信できるサーバがフェイルオーバ処理を実施します。それ以外のサーバは全て緊急シャットダウンします。

- 他の方式に比べ、ディスク I/O の遅延を考慮する必要があるため、ネットワークパーティション解決に時間がかかります。この時間はクラスタのプロパティで設定するハートビートタイムアウト時間とディスク I/O 待ち時間の長いほうの約 2 倍となります。

- 共有ディスクへの I/O 時間がディスク I/O 待ち時間より長くかかる場合にはネットワークパーティション解決処理がタイムアウトしてフェイルオーバできないことがあります。

注釈

VERITAS Storage Foundation を使用する場合、DISK 方式は使用できません。

PING + DISK 方式

- PING 方式と DISK 方式を組み合わせた方式です。

- ping コマンドを受信し、応答を返却可能な常時稼動している装置 (ping 用装置) が必要です。ping 用装置は複数指定することができます。また、共有ディスク上に専用のディスクパーティション (ディスクハートビート用パーティション) が必要です。

- 通常は PING 方式と同様に動作しますが、ping 用装置の故障などにより、ハートビートが途絶する前に全サーバで ping コマンドの応答が返らない状態が続くと、DISK 方式に切り替わります。ただし、PING 方式と DISK 方式それぞれの NP 解決リソースを使用するサーバが一致していない場合 (例えば全サーバで使用する PING 方式のリソースと共有ディスク装置が接続された一部のサーバでのみ使用する DISK 方式のリソースがある場合など) では、それぞれのリソースが個別に動作しますので、ping 用装置の状態によらず DISK 方式も動作します。

- 共有ディスクや共有ディスクへの経路に異常が発生している状態で他サーバからのハートビートの途絶を検出した場合、ping コマンドの応答がある状態でも緊急シャットダウンします。

多数決方式

- 3 ノード以上のクラスタで使用できます。

- ネットワーク障害によってクラスタ全体の過半数のサーバと通信できなくなったサーバが緊急シャットダウンすることにより、ネットワークパーティション症状によるデータ破壊を防ぎます。なお、ちょうど半数のサーバと通信できない場合は、マスタサーバと通信できないサーバが緊急シャットダウンします。

- 半数以上のサーバがダウンした場合は、残りの全ての正常サーバもダウンします。

- ハブの故障などによって全てのサーバが孤立した場合は全サーバダウンとなります。

ネットワークパーティション解決しない

- ディスクリソース (共有ディスク) を使用しないクラスタで選択できます。

- 万一、クラスタサーバ間の全てのネットワーク通信路に障害が発生した場合には、全サーバがフェイルオーバを実行します。

推奨するネットワークパーティション解決方式は下記です。

3 ノード以上で共有ディスクを使用するクラスタには、PING + DISK 方式を推奨します。ハイブリッドを使用する場合は、共有ディスクが接続されたサーバでは PING + DISK 方式、共有ディスクが接続されていないサーバでは PING 方式のみを使用します。

3 ノード以上で共有ディスクを使用しないクラスタには、PING 方式を推奨します。

2 ノードで共有ディスクを使用するクラスタには DISK 方式または、PING + DISK 方式を推奨します。

2 ノードで共有ディスクを使用しないクラスタを使用するクラスタには、PING 方式を推奨します。

Witness ハートビートリソースを使用し、共有ディスクを使用しないクラスタには HTTP 方式を推奨します。

ネットワークパーティション解決方式 |

ノード数 |

必要 HW |

フェイルオーバ不可のケース |

全ネットワーク経路断線時 |

両サーバがフェイルオーバするケース |

ネットワークパーティション解決に必要な時間 |

|---|---|---|---|---|---|---|

DISK |

制限なし |

共有ディスク |

ディスク異常 |

マスタサーバが生存 |

なし |

ハートビートタイムアウトとディスクI/O待ち時間から計算される時間が必要 |

PING |

制限なし |

ping コマンドを受信し応答を返却する装置 |

なし |

ping コマンドの応答が有るサーバが生存 |

ping コマンドが指定回数連続タイムアウト後に、全ネットワーク断線 |

0 |

HTTP |

制限なし |

Web サーバ |

Web サーバ障害 |

Web サーバと通信可能なサーバが生存 |

なし |

0 |

PING +DISK |

制限なし

|

ping コマンドを受信し応答を返却する装置,

共有ディスク

|

なし

|

ping コマンドの応答が有るサーバが生存

|

なし

|

0

|

多数決 |

3 以上 |

なし |

過半数サーバダウン |

過半数サーバと通信できるサーバが生存 |

なし |

0 |

なし |

制限なし |

なし |

なし |

全サーバがフェイルオーバ実施 |

全ネットワーク断線時 |

0 |

4. CLUSTERPRO をインストールする¶

本章では、CLUSTERPRO のインストール手順について説明します。本章で説明する項目は以下のとおりです。

4.1. CLUSTERPRO のインストールからクラスタ生成までの流れ¶

CLUSTERPRO のインストールからライセンス登録、クラスタシステム生成、クラスタシステムの状態確認までの流れを以下に示します。

以下の手順に進む前に、必ず「2. システム構成を決定する」「3. クラスタシステムを設計する」 を読み、必要な動作環境や生成するクラスタの構成内容について確認してください。

- CLUSTERPRO Server のインストールクラスタを構成する各サーバに、CLUSTERPRO のメインのモジュールである CLUSTERPRO Server をインストールします。インストール時、ライセンスの登録も行います。(「4.2. CLUSTERPRO Server のインストール」) (サーバ OS の再起動が必要)

参考

本ガイドの流れに従って操作を行うためには、本ガイドの手順に従いながら、随時『リファレンスガイド』を参照する必要があります。また、動作環境やリリース情報などの最新情報は、『スタートアップガイド』の「CLUSTERPRO の動作環境」、および「最新バージョン情報」を参照してください。

4.2. CLUSTERPRO Server のインストール¶

CLUSTERPRO Server は以下のシステムサービスで構成されます。

サービス表示名 |

サービス名 |

説明 |

スタートアップの種類 |

サービスの状態(通常時) |

|---|---|---|---|---|

CLUSTERPRO |

clpstartup |

CLUSTERPRO 本体 |

自動 |

実行中 |

CLUSTERPRO API |

clprstd |

CLUSTERPRO Restful API 制御 |

自動 |

停止 |

CLUSTERPRO Disk Agent |

clpdiskagent |

共有ディスク、ミラーディスク、ハイブリッドディスク制御 |

手動 |

実行中 |

CLUSTERPRO Event |

clpevent |

イベントログ出力 |

自動 |

実行中 |

CLUSTERPRO Information Base |

clpibsv |

クラスタ情報管理 |

自動 |

実行中 |

CLUSTERPRO Java Resource Agent |

clpjra |

Java Resource Agent |

手動 |

停止 |

CLUSTERPRO Manager |

clpwebmgr |

WebManager サーバ |

自動 |

実行中 |

CLUSTERPRO Node Manager |

clpnm |

ハートビート、ネットワークパーティション解決制御 |

自動 |

実行中 |

CLUSTERPRO Server |

clppm |

CLUSTERPRO サーバ |

自動 |

実行中 |

CLUSTERPRO System Resource Agent |

clpsra |

System Resource Agent |

手動 |

実行中 |

CLUSTERPRO Transaction |

clptrnsv |

通信処理 |

自動 |

実行中 |

CLUSTERPRO Web Alert |

clpwebalt |

アラート同期 |

自動 |

実行中 |

注釈

CLUSTERPRO Java Resource Agent は、JVM監視リソースを設定した場合、実行中状態となります。

注釈

CLUSTERPRO System Resource Agent は、システム監視リソースやプロセスリソース監視リソースを設定した場合、または [クラスタのプロパティ] - [監視] タブ- [システムリソース情報を収集する] のチェックボックスをオンに設定した場合に実行中状態となります。

4.2.1. CLUSTERPRO Server を新規にインストールするには¶

以下の手順に従って、クラスタを構成する各サーバに CLUSTERPRO Serverをインストールします。

重要

共有ディスクを使用する場合、共有ディスクに接続した CLUSTERPRO インストール前のサーバで OS を複数同時に起動しないでください。共有ディスク上のデータが破壊される可能性があります。

注釈

CLUSTERPRO Server は Administrator 権限を持つアカウントでインストールしてください。

注釈

CLUSTERPRO Server をインストールすると、Windows のメディアセンス機能 (LANケーブル抜け等によるリンクダウン発生時に IP アドレスを非活性にする機能) が無効になります。

注釈

インストール DVD-ROM を DVD-ROM ドライブに入れます。

メニュー画面が表示されたら CLUSTERPRO® for Windows を選択します。

注釈

メニュー画面が自動で起動しない場合は、DVD-ROM のルートフォルダにあるmenu.exe をダブルクリックします。

CLUSTERPRO® X 5.2 for Windows を選択します。

[CLUSTERPRO Server Setup へようこそ] が表示されます。[次へ] をクリックします。

[インストール先の選択] が表示されます。変更する場合は [参照] をクリックしてディレクトリを指定します。[次へ] をクリックします。

[インストール準備の完了] が表示されます。[インストール] をクリックしてインストールを開始します。

インストールが終了すると、[通信ポート番号設定] 画面が表示されます。通常は、既定値のまま [次へ] をクリックします。

[共有ディスクのフィルタリング設定] が表示されます。共有ディスクに接続されているSCSI コントローラまたは HBA を右クリックして [フィルタリング] をクリックします。[次へ] をクリックします。

重要

共有ディスクを使用する場合、共有ディスクを接続するSCSI コントローラ、または HBA に対し必ずフィルタリングの設定を行ってください。フィルタリングの設定を行っていない状態で共有ディスクを接続すると共有ディスク上のデータが破壊される可能性があります。ディスクパスを二重化している場合は、いずれかの HBA 配下にのみ共有ディスクが接続されているように見えますが、共有ディスクが物理的に接続されている全てのHBAに対してフィルタリングの設定をする必要があります。

重要

ここで設定した共有ディスクのフィルタリング設定は一時的なものです。OS再起動後、Cluster WebUIにてクラスタ構成情報を作成し、設定の反映を実行する際に出力される以下のメッセージに対し、必ず [はい] を選択してください。「HBAのフィルタリング設定をクラスタ構成情報に反映しますか?」重要

ミラーディスクリソースを使用する場合、ミラーリング対象の内蔵ディスクが接続されたSCSI コントローラ/HBA に対してフィルタリング設定は行わないでください。ミラーディスクリソースの起動に失敗します。なお、ハイブリッドディスクリソースを使って共有ディスクをミラーリングする場合は、フィルタリング設定が必要になります。

フィルタリング設定を行うかの確認画面が表示されます。[はい] をクリックします。

[ライセンスマネージャ] が表示されます。[登録] をクリックしてライセンスを登録します。登録手順の詳細は本ガイドの「5. ライセンスを登録する」を参照してください。

[終了] をクリックして、ライセンスマネージャを終了します。

[InstallShield Wizard の完了] が表示されます。再起動するかの確認画面が表示されるので、再起動を選択し [完了] をクリックします。サーバが再起動されます。

注釈

共有ディスクを使用する環境では、OS の再起動が完了した後、アクセス制限がかかっているため共有ディスクにアクセスできない状態になっています。

4.2.2. CLUSTERPRO Server を新規にサイレントモードでインストールするには¶

注釈

注釈

CLUSTERPRO Server は Administrator 権限を持つアカウントでインストールしてください。

注釈

CLUSTERPRO Server をインストールすると、Windows のメディアセンス機能 (LANケーブル抜け等によるリンクダウン発生時に IP アドレスを非活性にする機能) が無効になります。

注釈

<事前準備>

インストール先のフォルダ(既定値は、

"C:\Program Files\CLUSTERPRO")を変更する場合は、事前に応答ファイルを作成します。以下の手順で応答ファイルを作成してください。

Windows\5.2\common\server\x64\response\setup_inst_jp.issをコピーします。応答ファイル(setup_inst_jp.iss)をテキストエディタで開き、szDirの行に書かれたフォルダを変更します。

Count=4 Dlg1={8493CDB6-144B-4330-B945-1F2123FADD3A}-SdAskDestPath-0 Dlg2={8493CDB6-144B-4330-B945-1F2123FADD3A}-SdStartCopy2-0 Dlg3={8493CDB6-144B-4330-B945-1F2123FADD3A}-SdFinishReboot-0 [{8493CDB6-144B-4330-B945-1F2123FADD3A}-SdWelcome-0] Result=1 [{8493CDB6-144B-4330-B945-1F2123FADD3A}-SdAskDestPath-0] szDir=C:\Program Files\CLUSTERPRO Result=1

<インストール手順>

Windows\5.2\common\server\x64\silent-install.bat※ 既定値("C:\Program Files\CLUSTERPRO")でインストールする場合、<応答 ファイルのパス>は省略してください。サーバを再起動します。

4.2.3. 旧バージョンの CLUSTERPRO Server からアップグレードするには¶

まず、以下の注意事項をご確認ください。

本アップグレード手順は CLUSTERPRO X 3.3 for Windows の内部バージョン 11.35 以降より可能です。

CLUSTERPRO X 4.2 for Windows 以降、CLUSTERPRO が使用するポート番号が追加されました。CLUSTERPRO X 4.1 for Windows 以前のバージョンからアップグレードする場合、事前に必要なポート番号にアクセスできるようにしてください。 CLUSTERPRO が使用するポート番号は、『スタートアップガイド』の「通信ポート番号」を参照してください。

ミラーディスクリソース/ハイブリッドディスクリソースを使用している場合、クラスタパーティションのサイズとして 1024MiB 以上の領域が必要になります。また、ミラーディスクリソース/ハイブリッドディスクリソースのフルコピーが必要となります。

ミラーディスクリソース/ハイブリッドディスクリソースを使用している場合、事前にデータのバックアップを取ることを推奨します。バックアップ手順については『メンテナンスガイド』の「保守情報」の「スナップショットバックアップを行う」を参照してください。

CLUSTERPRO Server は Administrator 権限を持つアカウントでアップグレードしてください。

参考

同一メジャーバージョン間のアップデート手順は、『アップデート手順書』を参照してください。

以下、CLUSTERPRO X 3.3/4.x for Windows からアップグレードする場合の手順について説明します。

アップグレードを開始する前に、クラスタ運用中の各サーバの状態、および全リソースの状態が正常状態であることを Cluster WebUI、WebManager またはコマンドから確認してください。

クラスタ構成情報をバックアップします。クラスタ構成情報は作成時に Cluster WebUI、Builder で保存する他に、clpcfctrl コマンドでバックアップを作成することもできます。詳細は『リファレンスガイド』の「CLUSTERPRO コマンドリファレンス」- 「クラスタ生成、クラスタ構成情報バックアップを実行する (clpcfctrl コマンド)」 - 「クラスタ構成情報をバックアップする (clpcfctrl --pull)」を参照してください。

各サーバについて、CLUSTERPRO Server サービスが自動起動になっている場合は、手動起動に変更します。

クラスタをシャットダウンします。

サーバを1台起動し、CLUSTERPRO をアンインストールします。アンインストール手順は「10. CLUSTERPRO をアンインストール/再インストールする」の「10.1.1. CLUSTERPRO 本体のアンインストール」を参照してください。

手順 5 でアンインストールしたサーバに、CLUSTERPRO X 5.2 を新規インストールします。新規インストール手順は本章の「 4.2.1. CLUSTERPRO Server を新規にインストールするには 」を参照してください。

CLUSTERPRO X 5.2 をインストールしたサーバをシャットダウンします。

手順 5 から 7 を、クラスタを構成する全サーバにて実施します。

クラスタを構成する全サーバを起動します。

新規インストールしたいずれかのサーバでクラスタ構成情報変換コマンドを実行します。

クラスタ構成情報変換コマンドを実行する作業ディレクトリ(例: C:\tmp 等) に移動します。

- 移動した作業ディレクトリ配下に、手順 2. でバックアップしたクラスタ構成情報をコピーして配置します。clp.conf および scripts ディレクトリを配置してください。

注釈

Cluster WebUI でバックアップした場合、クラスタ構成情報は zip 圧縮されています。zip を解凍すると clp.conf および scripts ディレクトリが展開されます。 以下のコマンドを実行し、クラスタ構成情報を変換します。

# clpcfconv.bat -i .

作業ディレクトリ配下にあるクラスタ構成情報(clp.conf) と scripts ディレクトリを zip で圧縮します。

注釈

zipファイルを展開するとclp.confファイルとscriptsディレクトリが解凍されるよう配置してください。

- Cluster WebUI の設定モードを開き、「設定のインポート」をクリックします。手順 10. で生成したクラスタ構成情報(zip) をインポートしてください。

手動でクラスタ構成情報の変更が必要な項目を更新します。

『スタートアップガイド』-「注意制限事項」-「CLUSTERPRO バージョンアップ時」-「削除機能一覧」を参照し、対処列に記載がある機能を使用している場合は、対処列の記載に従いクラスタ構成情報を変更してください。

- クラスタパスワード方式のパスワードを設定していた場合、パスワードがクリアされています。Cluster WebUI を使用してパスワードを再設定してください。

X 3.3 からのアップグレードで、かつ、ミラーリソース/ハイブリッドディスクリソースを使用している場合は、以下を実施してください。

クラスタパーティションとして 1024MiB 以上のサイズのパーティションを準備します。

- ミラーディスクリソース/ハイブリッドディスクリソース用のクラスタパーティションのドライブ文字が構成情報と異なる場合は、構成情報を変更します。また、ミラーディスクリソース/ハイブリッドディスクリソースが所属するグループの[プロパティ]の[属性]タブにある[グループ起動属性]が自動起動となっている場合には手動起動に設定します。また、フェイルオーバ回数のカウント単位を、アップグレード前の動作と同様にするため、[クラスタのプロパティ] - [拡張] タブ - [フェイルオーバ回数のカウント単位] を 「クラスタ」に変更します。

強制停止機能または強制停止スクリプトを使用している場合は、以下を実施してください。

- [クラスタのプロパティ] - [フェンシング] タブ - [強制停止] - [タイプ] を設定します。強制停止スクリプトを使用している場合は [カスタム] を選択してください。強制停止スクリプトを使用しておらず、CLUSTERPRO が物理マシン上で動作する場合は [BMC] を、仮想マシン上で動作する場合は [vCenter] を選択してください。

[プロパティ] をクリックして強制停止リソースのプロパティ画面を表示し、各パラメータを設定してください。

- Cluster WebUI の「設定の反映」をクリックして構成情報を反映します。[クラスタ構成情報にあるディスク情報とサーバ上のディスク情報が異なっています。自動修正しますか?] というポップアップメッセージが表示された場合は [はい] を選択してください。期限付きライセンスを使用している場合は、以下のコマンドを実行します。

clplcnsc --distribute

Cluster WebUI の操作モードを開き、クラスタを開始します。

X 3.3 からのアップグレードで、かつ、ミラーリソース/ハイブリッドディスクリソースを使用している場合は、以下を実施してください。

ミラーディスクリストから、最新情報を保有しているサーバをコピー元として、フルコピーを行います。

グループを起動し、各リソースが正常に起動することを確認します。

手順 13 で[グループ起動属性]を自動起動から手動起動に変更した場合は、Cluster WebUI の設定モードで自動起動に戻し、[設定の反映] をクリックして クラスタ構成情報をクラスタに反映します。

以上で CLUSTERPRO Server のアップグレードは完了です。Cluster WebUI またはclpstat コマンドで、各サーバがクラスタとして正常に動作していることを確認してください。

4.2.4. SNMP 連携機能を手動で設定するには¶

注釈

SNMP トラップ送信機能のみを使う場合は、本手順は必要ありません。

このような場合、以下の手順に従って、手動で登録を行ってください。

注釈

設定は Administrator 権限を持つアカウントで実行してください。

Windows SNMP Service をインストールします。

Windows SNMP Serviceを停止します。

- Windows SNMP Service にCLUSTERPRO の SNMP 連携機能を登録します。3-1. レジストリエディタを起動します。3-2. 以下のキーを開きます。

HKEY_LOCAL_MACHINE\SYSTEM\CurrentControlSet\Services\SNMP\Parameters\ExtensionAgents

3-3. 開いたキーに以下の内容で文字列値を作成します。値の名前 :mgtmib値の種類 :REG_SZ値のデータ :SOFTWARE\NEC\CLUSTERPRO\SnmpAgent\mgtmib\CurrentVersion3-4. レジストリエディタを終了します。 クラスタが起動中の場合、Cluster WebUI または clpcl コマンドでクラスタのサスペンド・リジュームを実行します。

Windows SNMP Serviceを起動します。

注釈

SNMP 通信に必要な設定は Windows SNMP Service 側で行います。

5. ライセンスを登録する¶

5.1. ライセンスの登録¶

CLUSTERPRO のライセンスは、インストール時のライセンス登録以外にも、追加で登録/ 参照/ 削除が可能です。

5.1.1. CPU ライセンスの登録¶

下記 CLUSTERPRO X 5.2 for Windows CPUライセンスの登録は、クラスタを構築しようとしているサーバのうち、マスタサーバとして設定しているサーバで行います。

本体製品

CLUSTERPRO X 5.2 for Windows

CLUSTERPRO X SingleServerSafe 5.2 for Windows

CLUSTERPRO X SingleServerSafe for Windows アップグレードライセンス

5.1.2. ノードライセンスの登録¶

下記 CLUSTERPRO X 5.2 for Windows ノードライセンスを使用する場合には、使用する各サーバにそれぞれの製品のライセンスを登録する必要があります。

本体製品

CLUSTERPRO X 5.2 for Windows VM

CLUSTERPRO X SingleServerSafe 5.2 for Windows VM

CLUSTERPRO X SingleServerSafe for Windows VM アップグレードライセンス

オプション製品

CLUSTERPRO X Replicator 5.2 for Windows

CLUSTERPRO X Replicator DR 5.2 for Windows

CLUSTERPRO X Replicator DR 5.2 アップグレードライセンス for Windows

CLUSTERPRO X Database Agent 5.2 for Windows

CLUSTERPRO X Internet Server Agent 5.2 for Windows

CLUSTERPRO X Application Server Agent 5.2 for Windows

CLUSTERPRO X Java Resource Agent 5.2 for Windows

CLUSTERPRO X System Resource Agent 5.2 for Windows

CLUSTERPRO X Alert Service 5.2 for Windows

注釈

オプション製品のライセンスがインストールされていない場合、ライセンスに対応するリソースおよび監視リソースはCluster WebUI の一覧に表示されません。

ライセンスの登録方法には、ライセンスシートに記載された情報を入力する方法と、ライセンス ファイルを指定する方法の 2 つがあります。

ライセンス製品に添付されたライセンス情報を入力し、ライセンスを登録する (「 5.1.4. ライセンス情報を入力してライセンスを登録するには 」を参照)

ライセンスファイルを指定し、ライセンスを登録する (「 5.1.5. ライセンスファイルを指定してライセンスを登録するには 」を参照)

5.1.3. CPU ライセンスの注意事項¶

ライセンスを使用する場合の注意事項を示します。

マスタサーバでCPUライセンスを登録した後、「6. クラスタ構成情報を作成する」におけるクラスタ構成情報の作成と反映は、マスタサーバに接続した Cluster WebUI から実施する必要があります。

5.1.4. ライセンス情報を入力してライセンスを登録するには¶

CPU ライセンスを登録する場合

販売元から正式に入手したライセンスシートが手元にあることを確認してください。ライセンスシートは製品を購入すると販売元から送付されます。このライセンスシートに記載されている値を入力します。

クラスタシステムを構築しようとしているサーバの中で、マスタサーバとして設定しようとしているサーバに管理者としてログイン可能であることを確認してください。

ノードライセンスを登録する場合

販売元から正式に入手したライセンスシートが手元にあることを確認してください。ライセンスシートは製品を購入すると販売元から送付されます。ノードライセンスのライセンスシートは使用しようとしているサーバの台数分必要です。このライセンス シートに記載されている値を入力します。

クラスタシステムを構築しようとしているサーバの中で、オプション製品を使用しようとしているサーバに管理者としてログイン可能であることを確認してください。

[スタート] メニューから、[CLUSTERPRO Server] の [ライセンスマネージャ] をクリックします。

[ライセンスマネージャ] ダイアログボックスが表示されます。[登録] をクリックします。

ライセンス登録方法の選択画面が表示されます。[ライセンス項目を入力して登録] をクリックします。

[製品選択] ダイアログボックスが表示されます。登録するライセンスの製品区分を選択して、[次へ] をクリックします。

[ライセンスキー入力] ダイアログボックスが表示されます。製品に添付されているライセンスシートの、シリアル No とライセンスキーを入力します。[次へ] をクリックします。

[ライセンス登録確認] ダイアログボックスが表示されます。入力した情報に誤りがないか確認します。誤りがないようであれば、[次へ] をクリックします。

ポップアップメッセージ [ライセンスを登録しました。] が表示されることを確認します。表示されれば、ライセンス登録は完了です。ライセンスの登録に失敗した場合は、手順 2 から再度ライセンス登録を行ってください。

5.1.5. ライセンスファイルを指定してライセンスを登録するには¶

CPUライセンスを登録する場合

クラスタシステムを構築しようとしているサーバの中で、マスタサーバとして設定しようとしているサーバに管理者としてログイン可能であることを確認してください。

ライセンスファイルが、クラスタシステムを構築しようとしているサーバの中で、マスタサーバとして設定しようとしているサーバの任意の位置に存在していることを確認してください。

ノードライセンスを登録する場合

使用しようとしているサーバに管理者としてログイン可能であることを確認してください。

ライセンスファイルが、クラスタシステムを構築しようとしているサーバの中で、使用しようとしているサーバの任意の位置に存在していることを確認してください。

[スタート] メニューから、[CLUSTERPRO Server] の [ライセンスマネージャ] をクリックします。

[ライセンスマネージャ] ダイアログボックスが表示されます。[登録] をクリックします。

ライセンス登録方法の選択画面が表示されます。[ライセンスファイルから登録] をクリックします。

[ライセンスファイル指定] ダイアログボックスが表示されます。登録するライセンスファイルを指定して、[開く] をクリックします。

ライセンス登録の確認メッセージが表示されます。[OK] をクリックします。

[終了] をクリックして、ライセンスマネージャを閉じます。

5.2. ライセンスの参照/削除¶

5.2.1. 登録されているライセンスを参照/削除するには¶

登録されているライセンスを参照および削除する手順を示します。

[スタート] メニューから、[CLUSTERPRO Server] の [ライセンスマネージャ] をクリックします。

[ライセンスマネージャ] ダイアログボックスが表示されます。[参照/削除] をクリックします。

登録されているライセンスが一覧表示されます。

削除する場合、削除するライセンスを選択して [削除] をクリックします。

削除を確認するメッセージが表示されます。[OK] をクリックします。

5.3. 期限付きライセンスの登録¶

下記 CLUSTERPRO X 5.2 for Windows 本体製品ならびにオプション製品が期限付きライセンスに対応しています。期限付きライセンスは、本体製品、オプション製品に関わらずクラスタを構築しようとしているサーバのうち、マスタサーバとして設定しているサーバで行います。

本体製品

CLUSTERPRO X 5.2 for Windows VM

オプション製品

CLUSTERPRO X Replicator 5.2 for Windows

CLUSTERPRO X Replicator DR 5.2 for Windows

CLUSTERPRO X Database Agent 5.2 for Windows

CLUSTERPRO X Internet Server Agent 5.2 for Windows

CLUSTERPRO X Application Server Agent 5.2 for Windows

CLUSTERPRO X Java Resource Agent 5.2 for Windows

CLUSTERPRO X System Resource Agent 5.2 for Windows

CLUSTERPRO X Alert Service 5.2 for Windows

注釈

オプション製品のライセンスがインストールされていない場合、ライセンスに対応するリソースおよび監視リソースはCluster WebUI の一覧に表示されません。

5.3.1. 期限付きライセンスの注意事項¶

期限付きライセンスを使用する場合の注意事項を示します。

クラスタ内の一部のサーバのみに期限付きライセンスを登録し、運用することはできません。

マスタサーバでライセンスを登録した後、「6. クラスタ構成情報を作成する」におけるクラスタ構成情報の作成と反映は、マスタサーバに接続した Cluster WebUI から実施する必要があります。

期限付きライセンスは、クラスタを構成するサーバ台数以上のライセンスが必要です。

クラスタの運用開始後、期限付きライセンスを追加する場合も、マスタサーバ上でライセンスを登録する必要があります。

一度有効化された期限付きライセンスは、サーバ削除、サーバ交換、ライセンス削除した場合は期限内であっても再登録することはできません。

5.3.2. 期限付きライセンスを登録するには¶

クラスタシステムを構築しようとしているサーバの中で、マスタサーバとして設定しようとしているサーバに管理者としてログイン可能であることを確認してください。

使用する製品の全てのライセンスファイルが、クラスタシステムを構築しようとしているサーバの中で、マスタサーバとして設定しようとしているサーバの任意の位置に存在していることを確認してください。

以下の手順で、使用する製品の全てのライセンスファイルを登録します。期限切れに備え、同一製品のライセンスファイルを複数入手している場合も、同様の手順で余剰分のライセンスを登録します。

[スタート] メニューから、[CLUSTERPRO Server] の [ライセンスマネージャ] をクリックします。

[ライセンスマネージャ] ダイアログボックスが表示されます。[登録] をクリックします。

ライセンス登録方法の選択画面が表示されます。[ライセンスファイルから登録] をクリックします。

[ライセンスファイル指定] ダイアログボックスが表示されます。登録するライセンスファイルを指定して、[開く] をクリックします。

ライセンス登録の確認メッセージが表示されます。[OK] をクリックします。

[終了] をクリックして、ライセンスマネージャを閉じます。

5.4. 期限付きライセンスの参照/削除¶

5.4.1. 登録されている期限付きライセンスを参照/削除するには¶

登録されている期限付きライセンスを参照および削除する手順は、「 5.2.1. 登録されているライセンスを参照/削除するには 」の手順と同様です。

6. クラスタ構成情報を作成する¶

CLUSTERPRO では、クラスタシステムの構成内容を記述するデータのことを、クラスタ構成情報と呼びます。Cluster WebUI を用いてクラスタ構成情報を作成します。本章では、Cluster WebUI の起動方法、およびクラスタ構成情報の作成手順をサンプルの構成例を用いて説明します。

本章で説明する項目は以下のとおりです。

6.1. クラスタ構成情報を作成する¶

クラスタ構成情報の作成は、クラスタ構成情報の作成 / 変更用の機能であるCluster WebUI の設定モードを用いて行います。

管理用 PC からアクセスした Cluster WebUI を起動し、クラスタ構成情報を作成します。作成したクラスタ構成情報は、Cluster WebUI からクラスタシステムに反映します。

6.2. Cluster WebUI を起動する¶

クラスタ構成情報を作成するには、Cluster WebUIにアクセスする必要があります。ここでは、まず Cluster WebUI の概要を説明し、その後、クラスタ構成情報を作成する方法について説明します。

参考

Cluster WebUI の動作環境については、『スタートアップガイド』の「CLUSTERPRO の動作環境」を参照してください。

6.2.1. Cluster WebUI とは¶

Cluster WebUI とは、Web ブラウザ経由でクラスタの設定と状態監視、サーバ/グループの起動/停止及び、クラスタ動作ログの収集などを行うための機能です。以下の図に Cluster WebUI の概要を示します。

CLUSTERPRO Server (Main module)

Cluster WebUI

図 6.1 Cluster WebUI¶

図の2台のサーバにはCLUSTERPROがインストールされています。管理用PC(Management PC)上のウェブブラウザを使っていずれかのサーバに接続すると、Cluster WebUIの画面が表示されます。 この際の接続先としては、管理グループのフローティングIP(FIP)アドレス、または仮想IP(VIP)アドレスを指定します。

管理用 PC の Web ブラウザから接続する際の URL には、接続用のフローティング IP アドレスまたは仮想 IP アドレスを指定します。これらのアドレスは管理グループのリソースとして登録されます。管理グループが存在しない場合、クラスタを構成するいずれかのサーバの実 IP アドレス (そのサーバに固定的に割り当てられたアドレス) を指定して接続することもできますが、この場合は接続先サーバがダウンしているとクラスタの状態を取得できなくなります。

6.2.2. Cluster WebUI がサポートしているブラウザ¶

動作確認済ブラウザついては、『スタートアップガイド』を参照してください。

6.2.3. Cluster WebUI を起動するには¶

Cluster WebUI を起動する手順を示します。

Web ブラウザを起動します。

ブラウザのアドレスバーに、CLUSTERPRO Serverをインストールしたサーバの実 IP アドレスとポート番号を入力します。

http://ip-address:port/

- ip-address

インストール直後は管理グループが存在しないため、クラスタを構成する1台目のサーバの実IPアドレスを指定します。

- port

インストール時に指定したWebManagerのポート番号と同じ番号を指定します(既定値29003)。

Cluster WebUI が起動します。クラスタ構成情報を作成する場合、ツールバーのドロップダウンメニューで [設定モード] を選択してください。

[クラスタ生成ウィザード] をクリックしてウィザードを開始します。

参考

https://ip-address:29003/

6.3. 設定値を確認する¶

クラスタ生成ウィザードを使用して実際にクラスタ構成情報を作成する前に、クラスタ構成情報として設定する値を確認します。値を書き出して、クラスタが効果的に作成されているか、情報に漏れがないかを確認しておきましょう。

6.3.1. クラスタ環境のサンプル¶

本章では、以下の図に記載されている、典型的な 2 ノードのクラスタ環境とハイブリッド方式の 3 ノードクラスタ構成を構築する場合を例にとって説明を行います。

2 ノード 共有ディスク使用時

図 6.2 2 ノードクラスタの例(共有ディスク使用時)¶

FIP1

FIP2

NIC1-1

192.168.0.1

NIC1-2

10.0.0.1

NIC2-1

192.168.0.2

NIC2-2

10.0.0.2

共有ディスク (Shared disk)

DISKハートビート ドライブ文字

E

ファイルシステム

RAW

切替パーティション ドライブ文字

F

ファイルシステム

NTFS

2 ノード ミラーディスク使用時

図 6.3 2 ノードクラスタの例(2ノードミラーディスク使用時)¶

FIP1

FIP2

NIC1-1

192.168.0.1

NIC1-2

10.0.0.1

NIC2-1

192.168.0.2

NIC2-2

10.0.0.2

クラスタパーティション ドライブ文字

E

ファイルシステム

RAW

データパーティション ドライブ文字

F

ファイルシステム

NTFS

2 ノード遠隔構成 ミラーディスクリソース使用時

この構成はWANがレイヤー2タイプの場合(拠点間で同一ネットワークアドレスを使用できる)の例です。

図 6.4 2 ノードクラスタの例(遠隔構成ミラーディスクリソース使用時)¶

FIP1

FIP2

NIC1

10.0.0.1

NIC2

10.0.0.2

クラスタパーティション ドライブ文字

E

ファイルシステム

RAW

データパーティション ドライブ文字

F

ファイルシステム

NTFS

3 ノード ハイブリッドディスク使用時

図 6.5 3 ノードクラスタの例(3ノードハイブリッドディスク使用時)¶

FIP1

FIP2

NIC1-1

192.168.0.1

NIC1-2

10.0.0.1

NIC2-1

192.168.0.2

NIC2-2

10.0.0.2

NIC3-1

192.168.0.3

NIC3-2

10.0.0.3

共有ディスク

ハートビート用パーティション ドライブ文字

E

ファイルシステム

RAW

クラスタパーティション ドライブ文字

F

ファイルシステム

RAW

データパーティション ドライブ文字

G

ファイルシステム

NTFS

ディスク

クラスタパーティション ドライブ文字

F

ファイルシステム

RAW

データパーティション ドライブ文字

G

ファイルシステム

NTFS

以下に、上図のクラスタシステムを構築するためのクラスタ構成情報のサンプル値を記載します。以降のトピックでは、この条件でクラスタ構成情報を作成する手順をステップバイステップで説明します。実際に値を設定する際には、構築するクラスタの構成情報と置き換えて入力してください。値の決定方法については、『リファレンスガイド』を参照してください。

2 ノードの構成設定例

設定対象

設定パラメータ

設定値 (共有ディスク使用時)

設定値 (ミラーディスク使用時)

設定値 (遠隔構成)

クラスタ構成

クラスタ名

cluster

cluster

cluster

サーバ数

2

2

2

管理用グループ数

1

1

1

フェイルオーバ グループ数

1

1

1

モニタ リソース数

5

6

6

ハートビート リソース

カーネルモードLAN ハートビート数

2

2

1

1 台目のサーバの情報(マスタ サーバ)

サーバ名

server1

server1

server1

192.168.0.1

192.168.0.1

10.0.0.1

10.0.0.1

10.0.0.1

-

パブリックの IP アドレス

10.0.0.1

10.0.0.1

10.0.0.1

ミラーディスクコネクト I/F

-

192.168.0.1

10.0.0.1

HBA

共有ディスクに接続しているHBA

-

-

2 台目のサーバの情報

サーバ名

server2

server2

server2

192.168.0.2

192.168.0.2

10.0.0.2

10.0.0.2

10.0.0.2

-

パブリックの IP アドレス

10.0.0.2

10.0.0.2

10.0.0.2

ミラーディスクコネクト I/F

-

192.168.0.2

10.0.0.2

HBA

共有ディスクに接続しているHBA

-

-

1 つ目の NP 解決リソース

タイプ

Ping

-

Ping

ターゲット

10.0.0.254

-

10.0.0.254

server1

使用する

-

使用する

server2

使用する

-

使用する

2 つ目の NP 解決リソース

タイプ

DISK

-

-

ターゲット

-

-

-

server1

E:

-

-

server2

E:

-

-

管理用のグループ(Cluster WebUI用)

タイプ

クラスタ

クラスタ

クラスタ

グループ名

ManagementGroup

ManagementGroup

ManagementGroup

起動サーバ

全てのサーバ

全てのサーバ

全てのサーバ

グループ リソース数

1

1

1

管理用グループのグループリソース 1

タイプ

フローティング IP リソース

フローティング IPリソース

フローティング IP リソース

グループ リソース名

ManagementIP

ManagementIP

ManagementIP

IP アドレス

10.0.0.11

10.0.0.11

10.0.0.11

フェイルオーバグループ

タイプ

フェイルオーバ

フェイルオーバ

フェイルオーバ

グループ名

failover1

failover1

failover1

起動サーバ

全てのサーバ

全てのサーバ

全てのサーバ

グループ リソース数

3

3

3

1 つ目のグループリソース

タイプ

フローティング IP リソース

フローティング IPリソース

フローティング IP リソース

グループリソース名

fip1

fip1

fip1

IP アドレス

10.0.0.12

10.0.0.12

10.0.0.12

2 つ目のグループリソース

タイプ

ディスクリソース

ミラーディスクリソース

ミラーディスクリソース

グループ リソース名

sd1

md1

md1

ディスクリソースドライブ文字

F:

-

-

ミラーディスク/ハイブリッドディスクリソース クラスタパーティションドライブ文字

-

E:

E:

ミラーディスク/ハイブリッドディスクリソース データパーティションドライブ文字

-

F:

F:

3 つ目のグループリソース

タイプ

アプリケーションリソース

アプリケーションリソース

アプリケーションリソース

グループ リソース名

appli1

appli1

appli1

常駐タイプ

常駐

常駐

常駐

開始パス

実行ファイルのパス

実行ファイルのパス

実行ファイルのパス

1 つ目のモニタリソース(デフォルト作成)

タイプ

ユーザ空間監視

ユーザ空間監視

ユーザ空間監視

モニタリソース名

userw

userw

userw

2 つ目のモニタリソース

タイプ

ディスクRW監視

ディスクRW監視

ディスクRW監視

モニタリソース名

diskw1

diskw1

diskw1

ファイル名

C:\check.txt2

C:\check.txt2

C:\check.txt2I/O サイズ

2000000

2000000

2000000

ストール異常検出時の動作

意図的なストップエラーの発生

意図的なストップエラーの発生

意図的なストップエラーの発生

ディスクフル検出時動作

回復動作を実行する

回復動作を実行する

回復動作を実行する

回復対象

LocalServer

LocalServer

LocalServer

最終動作

意図的なストップエラーの発生

意図的なストップエラーの発生

意図的なストップエラーの発生

3 つ目のモニタリソース(ディスクリソース作成後自動作成)

タイプ

ディスクTUR監視

-

-

モニタリソース名

sdw1

-

-

ディスクリソース

sd1

-

-

回復対象

sd1

-

-

最終動作

何もしない

-

-

4 つ目のモニタリソース(ManagementIPリソース作成後自動作成)

タイプ

フローティング IP 監視

フローティング IP 監視

フローティング IP 監視

モニタリソース名

fipw1

fipw1

fipw1

監視対象

ManagementIP

ManagementIP

ManagementIP

回復対象

ManagementIP

ManagementIP

ManagementIP

5 つ目のモニタリソース(fip1リソース作成後自動作成)

タイプ

フローティング IP 監視

フローティング IP 監視

フローティング IP 監視

モニタリソース名

fipw2

fipw2

fipw2

監視対象

fip1

fip1

fip1

回復対象

fip1

fip1

fip1

6 つ目のモニタリソース

タイプ

IP 監視

IP 監視

IP 監視

モニタリソース名

ipw1

ipw1

ipw1

監視 IP アドレス

192.168.0.254

192.168.0.254

192.168.0.254

(ゲートウェイ)

(ゲートウェイ)

(ゲートウェイ)

回復対象

All Groups

All Groups

All Groups

タイプ

アプリケーション監視

アプリケーション監視

アプリケーション監視

モニタリソース名

appliw1

appliw1

appliw1

対象リソース

appli1

appli1

appli1

回復対象

appli1

failover1

failover1

8 つ目のモニタリソース(ミラーディスクリソース作成後自動作成)

タイプ

-

ミラーディスク監視

ミラーディスク監視

モニタリソース名

-

mdw1

mdw1

ミラーディスクリソース

-

md1

md1

回復対象

-

md1

md1

最終動作

-

何もしない

何もしない

ハイブリッドディスク構成の設定例

設定対象

設定パラメータ

設定値

クラスタ構成

クラスタ名

cluster

サーバ数

3

管理用グループ数

1

フェイルオーバ グループ数

1

モニタ リソース数

6

ハートビート リソース

カーネルモード LAN ハートビート数

2

1 台目のサーバの情報(マスタ サーバ)

サーバ名

server1

192.168.0.1

10.0.0.1

パブリックの IP アドレス

10.0.0.1

ミラーディスクコネクト I/F

192.168.0.1

HBA

共有ディスクに接続しているHBA

2 台目のサーバの情報

サーバ名

server2

192.168.0.2

10.0.0.2

パブリックの IP アドレス

10.0.0.2

ミラーディスクコネクト I/F

192.168.0.2

HBA

共有ディスクに接続しているHBA

3 台目のサーバの情報

サーバ名

server3

192.168.0.3

10.0.0.3

パブリックの IP アドレス

10.0.0.3

ミラーディスクコネクト I/F

192.168.0.3

HBA

-

1 つ目の NP 解決リソース

タイプ

DISK

ターゲット

-

server1

E:

server2

E:

server3

使用しない

2 つ目の NP 解決リソース

タイプ

Ping

ターゲット

10.0.0.254 (ゲートウェイ)

server1

使用する

server2

使用する

server3

使用する

3 つ目の NP 解決リソース 3

タイプ

Ping

ターゲット

10.0.0.254 (ゲートウェイ)

server1

使用する

server2

使用する

server3

使用しない

1 つ目のサーバグループ

サーバグループ名

svg1

所属するサーバ

server1, server2

2 つ目のサーバグループ

サーバグループ名

svg2

所属するサーバ

server3

管理用のグループ(Cluster WebUI 用)

タイプ

フェイルオーバ

グループ名

ManagementGroup

起動サーバ

全てのサーバ

グループ リソース数

1

管理用グループのグループリソース 4

タイプ

フローティング IP リソース

グループ リソース名

ManagementIP

IP アドレス

10.0.0.11

フェイルオーバグループ

タイプ

フェイルオーバ

グループ名

failover1

サーバグループ

svg1→svg2

グループ リソース数

3

1 つ目のグループリソース

タイプ

フローティング IP リソース

グループリソース名

fip1

IP アドレス

10.0.0.12

2 つ目のグループリソース

タイプ

ハイブリッドディスクリソース

グループ リソース名

hd1

クラスタパーティションドライブ文字

F:

データパーティションドライブ文字

G:

3 つ目のグループリソース

タイプ

アプリケーションリソース

グループ リソース名

appli1

常駐タイプ

常駐

開始パス

実行ファイルのパス

1 つ目のモニタリソース(デフォルト作成)

タイプ

ユーザ空間監視

モニタリソース名

userw

2 つ目のモニタリソース

タイプ

ディスクRW監視

モニタリソース名

diskw1

ファイル名

C:\check.txt5I/O サイズ

2000000

ストール異常検出時の動作

意図的なストップエラーの発生

ディスクフル検出時動作

回復動作を実行する

回復対象

LocalServer

最終動作

意図的なストップエラーの発生

3 つ目のモニタリソース(ハイブリッドディスクリソース作成後自動作成)

タイプ

ハイブリッドディスク監視

モニタリソース名

hdw1

ハイブリッドディスクリソース

hd1

回復対象

failover1

最終動作

何もしない

4 つ目のモニタリソース(ハイブリッドディスクリソース作成後自動作成)

タイプ

ハイブリッドディスクTUR監視

モニタリソース名

hdtw1

ハイブリッドディスクリソース

hd1

回復対象

failover1

最終動作

何もしない

5 つ目のモニタリソース(ManagementIPリソース作成後自動作成)

タイプ

フローティング IP 監視

モニタリソース名

fipw1

監視対象

ManagementIP

回復対象

ManagementIP

6 つ目のモニタリソース(fip1リソース作成後自動作成)

タイプ

フローティング IP 監視

モニタリソース名

fipw2

監視対象

fip1

回復対象

fip1

7 つ目のモニタリソース

タイプ

IP 監視

モニタリソース名

ipw1

監視 IP アドレス

10.0.0.254 (ゲートウェイ)

回復対象

All Groups

8 つ目のモニタリソース(アプリケーションリソースが常駐の場合、アプリケーションリソース作成後自動作成)

タイプ

アプリケーション監視

モニタリソース名

appliw1

対象リソース

appli1

回復対象

appli1

- 3

共有ディスクが接続されている 1 台目と 2 台目のサーバのみ、ネットワークパーティション解決方式として Ping + 共有ディスク方式を使用するため、クラスタ全体で使用する Ping 方式の NP 解決リソースの他に、1 台目と 2 台目のサーバのみ使用する Ping 方式のリソースを設定します。

- 4

Cluster WebUI に接続するフローティング IP を 用意します。この IP により、障害発生時も Web ブラウザから動作している方のサーバが実行する Cluster WebUI にアクセスできます。

- 5

ローカルディスク監視を行う場合、ディスク RW 監視のファイル名にはシステムパーティション上のファイル名を指定します。

6.4. クラスタ構成情報の作成手順¶

クラスタ構成情報を作成するには、基本的に、クラスタの作成、グループの作成、モニタリソースの作成のステップを踏みます。新規に構成情報を作成する場合は、クラスタ生成ウィザードを使います。以下に手順の流れを示します。

注釈

作成したクラスタ構成情報は名称変更機能やプロパティ表示機能を使用して後から変更できます。

-

クラスタを作成します。

「6.4.1.3. サーバグループを作成する」:サーバグループを作成します。

「6.4.1.4. ネットワーク構成を設定する」:クラスタを構築するサーバ間のネットワーク構成を設定します。

- 「6.4.1.5. ネットワークパーティション解決処理を設定する」:ネットワークパーティション解決リソースを設定します。

-

フェイルオーバを行う際の単位である、フェイルオーバグループを作成します。

「6.4.2.1. フェイルオーバグループを追加する」:フェイルオーバの単位となる、グループを追加します。

「6.4.2.2. グループリソース (フローティング IP リソース) を追加する」:グループを構成するリソースを追加します。

「6.4.2.3. グループリソース (ディスクリソース/ミラーディスクリソース/ハイブリッドディスクリソース) を追加する」:グループを構成するリソースを追加します。

- 「6.4.2.4. グループリソース (アプリケーションリソース) を追加する」:グループを構成するリソースを追加します。

-

指定された監視対象を監視する、モニタリソースをクラスタ内に追加します。

「6.4.3.1. モニタリソース (ディスク RW 監視リソース) を追加する」:使用するモニタリソースを追加します。

- 「6.4.3.2. モニタリソース (IP 監視リソース) を追加する」:使用するモニタリソースを追加します。

-

クラスタ動作を有効、または無効にします。

6.4.1. クラスタの作成¶

まず、クラスタを作成します。作成したクラスタに、クラスタを構成するサーバを追加し、優先度とハートビートの優先度を決定します。

6.4.1.1. クラスタを追加する¶

[クラスタ生成ウィザード] の [クラスタ] 画面で、[言語] フィールドをクリックして、Cluster WebUI を使用するマシンの OS で使用している言語を選択します。

注釈

1 つのクラスタ内で使用できる言語は 1 つのみです。複数の言語の OS をクラスタ内で使用している場合は、文字化けを避けるために「英語」を指定してください。

[クラスタ名] ボックスにクラスタ名 (cluster) を入力します。

- Cluster WebUI の接続に使用するフローティング IP アドレス (192.168.0.11) を[管理 IP アドレス] ボックスに入力します。[次へ] をクリックします。サーバの[基本設定] 画面が表示されます。Cluster WebUI 起動時に URL で指定したIP アドレスのサーバ (server1) が一覧に登録されています。

6.4.1.2. サーバを追加する¶

クラスタを構成する 2 台目以降のサーバを追加します。

[サーバの定義一覧] で [追加] をクリックします。

[サーバ追加] ダイアログボックスが開きます。2 台目のサーバのサーバ名かFQDN 名、または IP アドレスを入力し、[OK] をクリックします。[サーバの定義一覧] に 2 台目のサーバ (server2) が追加されます。

ハイブリッドディスク構成の場合、同様にして 3 台目のサーバ (server3) を追加します。

ハイブリッドディスク構成の場合、「1-3 サーバグループを作成する」 を行います。

[次へ] をクリックします。

6.4.1.3. サーバグループを作成する¶

ハイブリッドディスク構成の場合、ハイブリッドディスクリソースを作成する前に、ミラーリングするそれぞれのディスク毎に、ディスクに接続しているサーバのグループを作成します。

[サーバグループの設定] の [設定] をクリックします。

[サーバグループの定義一覧] で [追加] をクリックします。

[サーバグループの設定] ダイアログボックスが開きます。[名前] ボックスにサーバグループ名 (svg1) を入力します。

- [利用可能なサーバ] の [server1] をクリックし、[追加] をクリックします。[server1] が [起動可能なサーバ] に追加されます。同様に、[server2] を追加します。

[OK] をクリックします。[サーバグループの定義一覧] に [svg1] が表示されます。

[追加] をクリックして [サーバグループの設定] ダイアログボックスを開き、[名前] ボックスにサーバグループ名 (svg2) を入力します。

[利用可能なサーバ] の [server3] をクリックし、[追加] をクリックします。[server3] が [起動可能なサーバ] に追加されます。

[OK] をクリックします。[サーバグループの定義一覧] に [svg1] と [svg2] が表示されます。

[閉じる] をクリックします。

[次へ] をクリックします。

6.4.1.4. ネットワーク構成を設定する¶

クラスタを構成するサーバ間のネットワーク構成を設定します。

[追加]・[削除] で通信経路を追加・削除し、各サーバの列のセルをクリックして IP アドレスを選択または入力してください。一部のサーバが接続されていない通信経路の場合は、接続されていないサーバのセルを空欄にしてください。

- ハートビートの送受信に使用する通信経路 (インタコネクト) は、[種別] 列のセルをクリックして、[カーネルモード] を選択してください。ハートビートに使用せず、ミラーディスクリソースやハイブリッドディスクリソースのデータミラーリング通信にのみ使用する場合は、 [ミラー通信専用] を選択してください。必ず一つ以上の通信経路をインタコネクトに設定する必要があります。なるべく全ての通信経路をインタコネクトに設定してください。なお、インタコネクトを複数設定する場合、[優先度] 列の番号が小さい通信経路が優先的にクラスタサーバ間の内部通信に使用されます。優先度を変更する場合は、矢印で通信経路の順位を変更してください。

Witness ハートビートを使用する場合、[種別] 列のセルをクリックし、[Witness] を選択してください。[プロパティ] ボタンをクリックして、[ターゲットホスト] に Witness サーバのサーバアドレスを入力し、[サービスポート] にポート番号を入力してください。Witness ハートビートを使用しないサーバは、そのサーバのセルをクリックして [使用しない] を選択してください。

ミラーディスクリソースやハイブリッドディスクリソースのデータミラーリング通信に使用する通信経路 (ミラーディスクコネクト) は、[MDC] 列のセルをクリックして、その通信経路に割り当てるミラーディスクコネクト名 (mdc1~mdc16) を選択してください。データミラーリング通信に使用しない通信経路は [使用しない] を選択してください。

[次へ] をクリックします。

6.4.1.5. ネットワークパーティション解決処理を設定する¶

ネットワークパーティション解決リソースを設定します。

- DISK 方式の NP 解決を行う場合、[追加] をクリックして [NP 解決一覧] に行を追加し、[種別] 列のセルをクリックして [DISK] を選択し、各サーバのセルをクリックして、ディスクハートビート用パーティションとして使用するドライブを選択します。共有ディスク装置に接続されていないサーバがある場合は、そのサーバのセルを空欄にしてください。本章の設定例では、共有ディスクを使用する場合に DISK 方式の行を追加し、各サーバの列をクリックして [E:ドライブ] を選択します。ハイブリッドディスクを使用する場合は、DISK 方式の列を追加し、[server1] と [server2] のセルをクリックして[E:ドライブ] を選択します。[server3] のセルは空欄にしてください。

- PING 方式の NP 解決を行う場合、[追加] をクリックして [NP 解決一覧] に行を追加し、[タイプ] 列のセルをクリックして [Ping] を選択し、[ターゲット] 列のセルをクリックして各サーバのセルをクリックして ping 送信の対象とする機器(ゲートウェイ等) のIP アドレスを入力します。カンマ区切りで複数の IP アドレスを入力すると、その全てに ping 応答がない場合にネットワークから孤立した状態と判断します。一部のサーバのみ PING 方式を使用する場合、使用しないサーバのセルを [使用しない] にしてください。本章の設定例では、ハイブリッドディスクを使用する場合に PING 方式の行を1つ追加し、[ターゲット] に192.168.0.254を設定します。

- HTTP 方式の NP 解決を行う場合、[追加] をクリックして [NP 解決一覧] に行を追加し、[種別] 列のセルをクリックして [HTTP/HTTPS] を選択してください。[プロパティ] ボタンをクリックして、[ターゲットホスト] に Web サーバのサーバアドレスを入力し、[サービスポート] にポート番号を入力してください。一部のサーバのみ HTTP 方式を使用する場合、使用しないサーバのセルを [使用しない] にしてください。本章の設定例では、HTTP 方式は使用しません。

- 多数決方式の NP 解決を行う場合、[追加] をクリックして [NP 解決一覧] に行を追加し、[タイプ] 列のセルをクリックして [多数決] を選択します。本章の設定例では、多数決方式は使用しません。

[次へ] をクリックします。

6.4.2. フェイルオーバグループの作成¶

クラスタに、業務用のアプリケーションを実行するフェイルオーバグループ (以下「グループ」と省略する場合あり) を追加します。

6.4.2.1. フェイルオーバグループを追加する¶

障害発生時にフェイルオーバを行う単位となる、グループの設定を行います。

[グループ一覧] で [追加] をクリックします。[グループの定義] 画面が開きます。本章の設定例では、ハイブリッドディスクを使用する場合、[サーバグループ設定を使用する] チェックボックスをオンにします。[名前] ボックスにグループ名 (failover1) を入力し、[次へ] をクリックします。

- フェイルオーバグループが起動可能なサーバを設定します。本章の設定例では、共有ディスク及びミラーディスクを使用する場合、[全てのサーバでフェイルオーバ可能] チェックボックスをオンにするか、[利用可能なサーバ] リストから [server1] 、[server2] の順で [起動可能なサーバ] に追加します。 ハイブリッドディスクを使用する場合、[利用可能なサーバグループ] リストから [svg1]、[svg2] の順で [起動可能なサーバグループ] に追加します。

[次へ] をクリックします。

- フェイルオーバグループの各属性値を設定します。本章の設定例では、全て既定値を使用しますので、そのまま [次へ] をクリックします。[グループリソース一覧] が表示されます。

6.4.2.2. グループリソース (フローティング IP リソース) を追加する¶

ステップ 2-1 で作成したフェイルオーバグループに、グループの構成要素であるグループリソースを追加します。

[グループリソース一覧] で [追加] をクリックします。

[グループ のリソース定義 | failover1] 画面が開きます。[タイプ] ボックスでグループリソースのタイプ (フローティング IP リソース) を選択し、[名前] ボックスにグループリソース名 (fip1) を入力します。[次へ] をクリックします。

依存関係設定のページが表示されます。何も指定せず [次へ] をクリックします。

- [活性異常検出時の復旧動作]、[非活性異常検出時の復旧動作] が表示されます。[次へ] をクリックします。

- [IP アドレス] ボックスに IP アドレス (10.0.0.12) を入力し、 [完了] をクリックします。[グループリソース一覧] にフローティング IP リソースが追加されました。

6.4.2.3. グループリソース (ディスクリソース/ミラーディスクリソース/ハイブリッドディスクリソース) を追加する¶

共有ディスクの場合

共有ディスクをグループリソースとして追加します。

[グループリソース一覧] で、[追加] をクリックします。

[グループ のリソース定義 | failover1] 画面が開きます。[タイプ] ボックスでグループリソースのタイプ (ディスクリソース) を選択し、[名前] ボックスにリソース名 (sd1) を入力します。[次へ] をクリックします。

依存関係設定のページが表示されます。何も指定せず [次へ] をクリックします。

[起動可能サーバ] で、[server1] を選択し [追加] をクリックします。

[パーティションの選択] ダイアログボックスが表示されます。パーティション (F:) を選択し、[OK] をクリックします。

重要

ディスクリソースで指定するパーティションには、フィルタリング設定されたHBA に接続された共有ディスク上のパーティションを指定してください。

またディスクリソースで指定したパーティションは、ディスクハートビート用パーティションやミラーディスクリソースのクラスタパーティション、データパーティションには指定しないでください。共有ディスク上のデータが破壊される可能性があります。

ミラーディスクの場合

ミラーディスクをグループリソースとして追加します。

[グループリソース一覧] で、[追加] をクリックします。

[グループ のリソース定義 | failover1] 画面が開きます。[タイプ] ボックスでグループリソースのタイプ (ミラーディスクリソース) を選択し、[名前] ボックスにリソース名 (md1) を入力します。[次へ] をクリックします。

注釈

[タイプ] ボックスに (ミラーディスクリソース) が表示されない場合は、CLUSTERPRO X Replicatorライセンスの登録状況を確認の上、[ライセンス情報取得] をクリックしてください。

依存関係設定のページが表示されます。何も指定せず [次へ] をクリックします。

[起動可能サーバ] で、[server1] を選択し [追加] をクリックします。

[パーティションの選択] ダイアログボックスが表示されます。[接続] をクリックし、データパーティション (F:) と、クラスタパーティション (E:) を選択し、[OK] をクリックします。

重要

データパーティション、クラスタパーティションに指定するパーティションはそれぞれ別々のパーティションを指定してください。同一のパーティションを指定した場合、データが破壊される可能性があります。

また、ミラーディスクリソースのデータパーティション、クラスタパーティションには共有ディスク上のパーティションを指定しないでください。

ハイブリッドディスクの場合

ハイブリッドディスクをグループリソースとして追加します。

[グループリソース一覧] で、[追加] をクリックします。

[グループ (failover1) のリソース定義] 画面が開きます。[タイプ] ボックスでグループリソースのタイプ (ハイブリッドディスクリソース) を選択し、[名前] ボックスにリソース名 (sd1) を入力します。[次へ] をクリックします。

依存関係設定のページが表示されます。何も指定せず [次へ] をクリックします。

[データパーティションのドライブ文字] ボックスにミラーリングするデータパーティションのドライブ文字 (G:) を入力し、[クラスタパーティションのドライブ文字] ボックスにクラスタパーティションのドライブ文字 (F:) を入力します。

重要

データパーティション、クラスタパーティションに指定するパーティションはそれぞれ別々のパーティションを指定してください。同一のパーティションを指定した場合、データが破壊される可能性があります。

6.4.2.4. グループリソース (アプリケーションリソース) を追加する¶

アプリケーションの起動/終了を行う、アプリケーションリソースを追加します。

[グループリソース一覧] で、[追加] をクリックします。

[グループ のリソース定義 | failover1] 画面が開きます。[タイプ] ボックスでグループリソースのタイプ (アプリケーションリソース) を選択し、[名前] ボックスにグループ名 (appli1) を入力します。[次へ] をクリックします。

依存関係設定のページが表示されます。何も指定せず [次へ] をクリックします。

- [活性異常検出時の復旧動作]、[非活性異常検出時の復旧動作] が表示されます。[次へ] をクリックします。

[常駐タイプ] で [常駐] を選択します。また、[開始パス] に、実行ファイルのパスを指定します。

注釈

[開始パス]、および [終了パス] には実行可能ファイル名の絶対パス、あるいは環境変数で設定されたパスの通った実行可能ファイル名を設定します。相対パスは指定しないでください。相対パスを指定した場合、アプリケーションリソースの起動に失敗する可能性があります。

- [完了] をクリックします。[グループリソース一覧] に[アプリケーションリソース]が追加されました。

[完了] をクリックします。

6.4.3. モニタリソースの作成¶

指定した対象を監視するモニタリソースをクラスタに追加します。

6.4.3.1. モニタリソース (ディスク RW 監視リソース) を追加する¶

ローカルディスクを監視するためにディスク RW 監視リソースを追加します。

[グループ一覧] で、[次へ] をクリックします。

[モニタリソース一覧] が表示されます。[追加] をクリックします。[タイプ] ボックスでモニタリソースのタイプ (ディスク RW 監視) を選択し、[名前] ボックスにモニタリソース名 (diskw1) を入力します。[次へ] をクリックします。

監視設定を入力します。監視タイミングを [常時] に設定して、[次へ] をクリックします。

ファイル名 (

C:\check.txt)、I/O サイズ (2000000)、ストール異常検出時動作 (意図的なストップエラーの発生) 、ディスクフル検出時動作 (回復動作を実行する) を設定します。[次へ] をクリックします。ファイル名は OS がインストールされているパーティションのファイルを指定して下さい。[回復動作] ボックスで [最終動作のみ実行] を選択します。また、[回復対象] に[LocalServer] を設定して下さい。

- [最終動作] ボックスで [意図的なストップエラーの発生] を選択し、[完了] をクリックします。[モニタリソース一覧] にディスク RW 監視リソース (diskw1) が追加されました。

注釈

ディスク RW 監視リソースの監視対象に、ローカルディスクのファイルを指定することで、ローカルディスク監視として監視を行うことができます。その際、[最終動作] は、[意図的なSTOPエラーの発生] を選択してください。

6.4.3.2. モニタリソース (IP 監視リソース) を追加する¶

IP を監視するモニタリソースを追加します。

[モニタリソース一覧] で [追加] をクリックします。[タイプ] ボックスでモニタリソースのタイプ (IP 監視) を選択し、[名前] ボックスにモニタリソース名 (ipw1) を入力します。[次へ] をクリックします。

監視設定を入力します。ここではデフォルト値のまま変更せず、[次へ] をクリックします。

- [IP アドレス一覧] が表示されます。[追加] をクリックします。[IP アドレス] ボックスに監視 IP アドレス (192.168.0.254) を入力し [OK] をクリックします。

注釈

IP 監視リソースの監視対象には、パブリック LAN 上で、常時稼動が前提とされている機器 (例えば、ゲートウェイ) の IP アドレスを指定します。

入力した IP アドレスが [IP アドレス一覧] に設定されます。[次へ] をクリックします。

回復対象を設定します。[参照] をクリックします。

表示されるツリービューで [All Groups] を選択し、[OK] をクリックします。[回復対象] に [All Groups] が設定されます。

- [完了] をクリックします。[モニタリソース一覧] に IP 監視リソース (ipw1) が追加されました。

6.4.4. クラスタ動作を無効化する¶

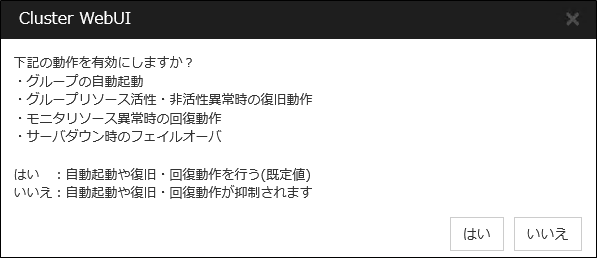

[いいえ] をクリックすると、グループの自動起動、グループリソース活性・非活性異常時の復旧動作、モニタリソース異常時の回復動作、およびサーバダウン時のフェイルオーバを行わなくなります。クラスタ構成情報を作成した後で初めてクラスタを起動する場合は、自動起動や復旧・回復動作を無効化して、クラスタ構成情報に誤りがないか確認することを推奨します。

なお、本機能は、[クラスタのプロパティ] の [拡張] タブの [クラスタ動作の無効化] で設定可能です。

注釈

モニタリソース異常時の回復動作の無効化は、ディスク RW 監視リソースのストール検出機能には適用されません。

6.5. クラスタ構成情報を保存する¶

作成したクラスタ構成情報は、使用中の PC のディレクトリ上または外部メディアに保存することができます。

6.5.1. クラスタ構成情報を保存するには¶

クラスタ構成情報を保存するには、以下の手順に従ってください。

Cluster WebUI の設定モードから [設定のエクスポート] をクリックします。

保存先を選択し、保存します。

注釈

保存されるのはファイル 1 点 (clp.conf) とディレクトリ 1 点 (scripts) です。これらのファイルとディレクトリがすべて揃っていない場合はクラスタ生成の実行が不成功に終わりますので、移動する場合はかならずこの 2 点をセットとして取り扱ってください。なお、新規作成した構成情報を変更した場合は、上記 2 点に加えて clp.conf.bak が作成されます。

注釈

CLUSTERPRO インストール時に [通信ポート番号設定] 画面で既定値と異なるポート番号を指定した場合、クラスタ構成情報を保存する前に [クラスタプロパティ] - [ポート番号] タブで [WebManager HTTP ポート番号] と [ディスクエージェントポート番号] をインストール時と同じ値に設定してください。

6.6. クラスタ構成情報をチェックする¶

Cluster WebUI で作成したクラスタ構成情報をクラスタサーバに反映する前に、設定したクラスタ構成情報のチェックを行うことができます。

Cluster WebUI の設定モードから [クラスタ構成情報チェック] をクリックします

チェックが完了すると結果が別画面で表示されます。作成したクラスタ構成情報の設定内容によってはチェック完了まで時間がかかる場合があります。

以下に各チェック内容の詳細について記載します。

クラスタプロパティ

チェック内容 |

説明 |

|---|---|

pingnpのpingチェック |

ネットワークパーティション解決を行うための ping ターゲットに対して ping が到達可能であるかを確認します。 |

disknpのパーティション存在チェック |

設定されたパーティションがシステムに存在するかを確認します。 |

ポート番号タブ:ポート番号チェック |

OS が管理している通信ポート番号の自動割り当ての範囲が、CLUSTERPRO が使用する通信ポート番号と重複していないかを確認します。 |

グループリソース

チェック内容 |

説明 |

|---|---|

fipのpingチェック |

設定された IP アドレスに対して ping を実行し、該当の IP アドレスが、同一ネットワーク内で既に使用されていないかを確認します。 |

vipのpingチェック |

設定された IP アドレスに対して ping を実行し、該当の IP アドレスが、同一ネットワーク内で既に使用されていないかを確認します。 |

sdのパーティション存在チェック |

設定されたパーティションがシステムに存在するかを確認します。 |

mdのパーティション存在チェック |

設定されたパーティションがシステムに存在するかを確認します。 |

hdのパーティション存在チェック |

設定されたパーティションがシステムに存在するかを確認します。 |

mdのクラスタパーティションサイズチェック |

設定されたクラスタパーティションのサイズが十分か確認します。 |

hdのクラスタパーティションサイズチェック |

設定されたクラスタパーティションのサイズが十分か確認します。 |

azureppのポート番号チェック |

OS が管理している通信ポート番号の自動割り当ての範囲が、設定された通信ポート番号と重複していないかを確認します。 |

ハートビートリソース

チェック内容 |

説明 |

|---|---|

khbのpingチェック |

ハートビートリソースとして設定された IP アドレスに対して ping を実行し、該当 IP アドレスが使用可能であるかを確認します。 |

その他

チェック内容 |

説明 |

|---|---|

AWSCLIコマンド実行チェック |

AWS CLI が実行可能であるかを確認します。 |

OS起動時間チェック |

OS が起動するまでの時間が、ハートビートタイムアウトよりも長くなるように設定されているかをチェックします。 |

非推奨設定確認

チェック内容 |

説明 |

|---|---|

非活性異常時の復旧動作チェック |

各グループリソースの非活性異常時の最終動作に、「何もしない」以外が設定されているかを確認します。 |

注釈

出力されるメッセージについて「クラスタ構成情報チェックの詳細情報」を参照してください。

6.7. クラスタを生成する¶

Cluster WebUI でクラスタ構成情報を作成したら、クラスタを構成するサーバに構成情報を反映させクラスタシステムを生成します。

6.7.1. クラスタを生成するには¶

Cluster WebUI でクラスタ構成情報の作成が終了したら、以下の手順でクラスタを生成します。

- Cluster WebUI の設定モード から、[設定の反映] をクリックします。[設定を反映しますか。] というポップアップメッセージが表示されますので、[OK] をクリックします。アップロードに成功すると、[反映に成功しました。] のメッセージが表示されますので、[OK] をクリックします。アップロードに失敗した場合は、表示されるメッセージに従って操作を行ってください。

Cluster WebUI の ツールバーのドロップダウンメニューで [操作モード] を選択して、操作モードに切り替えます。

- Cluster WebUI の[ステータス] タブから [クラスタ開始] をクリックし、確認画面で [開始] をクリックします。クラスタが開始され、クラスタの状態が Cluster WebUI に表示されることを確認します。正常に起動できない場合はエラーメッセージに従って対処を行ってください。

Cluster WebUI の操作・確認方法についてはオンラインマニュアルを参照してください。オンラインマニュアルは画面右上部の [

Cluster WebUI の操作・確認方法についてはオンラインマニュアルを参照してください。オンラインマニュアルは画面右上部の [ ] から参照できます。

] から参照できます。

注釈

CLUSTERPRO インストール時に [通信ポート番号設定] 画面で既定値と異なるポート番号を指定した場合、クラスタを生成する前に [クラスタプロパティ] - [ポート番号] タブで [WebManager HTTP ポート番号] と [ディスクエージェントポート番号] をインストール時と同じ値に設定してください。

7. クラスタシステムを確認する¶

7.1. Cluster WebUI による状態確認¶

本トピックでは、Cluster WebUI を使用してクラスタシステムの確認を行う方法について説明します。Cluster WebUI は、CLUSTERPRO Server のインストール時点ですでにインストールされています。新たにインストールを行う必要はありません。ここでは、まず Cluster WebUI の概要を説明し、その後、Cluster WebUI にアクセスし、クラスタの状態を確認する方法について説明します。

参考

Cluster WebUI の動作環境については、『スタートアップガイド』を参照してください。

クラスタを生成し、Cluster WebUI に接続後、以下の手順で動作を確認します。

参考

Cluster WebUI の操作方法についてはオンラインマニュアルを参照してください。また、状態確認で異常がある場合は『リファレンスガイド』の「トラブルシューティング」を参照して障害を取り除いてください。

- ハートビートリソースCluster WebUI 上で各サーバのステータスが起動済であることを確認します。また、各サーバのハートビートリソースのステータスが正常であることを確認します。Cluster WebUI のアラートログに警告や異常が記録されていないことも確認します。

- モニタリソースCluster WebUI 上で各モニタリソースのステータスが正常であることを確認します。

- グループ起動グループを起動します。Cluster WebUI 上でグループのステータスが起動済であることを確認します。また、グループに含まれる各グループリソースのステータスが起動済であることを確認します。Cluster WebUI のアラートログに警告や異常が記録されていないことも確認します。

- ディスクリソース/ミラーディスクリソース/ハイブリッドディスクリソースディスクリソース/ミラーディスクリソース/ハイブリッドディスクリソースが起動しているサーバで、このリソースの切替パーティション/データパーティションにアクセスできることを確認します。また、このリソースが起動していないサーバでは、このリソースの切替パーティション/データパーティションにアクセスできないことを確認します。

- フローティング IP リソースフローティング IP リソースが起動している状態で、フローティング IP アドレスに対して ping コマンドが成功することを確認します。

- アプリケーションリソースアプリケーションリソースが起動しているサーバで、アプリケーションが動作していることを確認します。

- サービスリソースサービスリソースが起動しているサーバで、サービスが動作していることを確認します。

- グループ停止グループを停止します。Cluster WebUI 上でグループのステータスが 停止済であることを確認します。また、グループに含まれる各グループリソースのステータスが停止済であることを確認します。Cluster WebUI のアラートログに警告や異常が記録されていないことも確認します。

- グループ起動グループを起動します。Cluster WebUI 上でグループのステータスが起動済であることを確認します。

- グループ移動グループを他のサーバに移動します。Cluster WebUI 上で、グループのステータスが移動先サーバで起動済になっていることを確認します。また、各グループリソースが正常に起動していることを確認します。Cluster WebUI のアラートログに警告や異常が記録されていないことも確認します。フェイルオーバポリシーに含まれる全サーバに対してグループを移動して、同様の確認を行います。

- フェイルオーバグループが起動しているサーバをシャットダウンします。ハートビートタイムアウト経過後、グループがフェイルオーバされることを確認します。また、Cluster WebUI 上で、フェイルオーバ先のサーバでグループのステータスが起動済になることも確認します。

- フェイルバック (設定している場合)自動フェイルバックを設定している場合は、フェイルオーバの確認でシャットダウンしたサーバを起動し、クラスタに復帰させ、グループがフェイルバックすることを確認します。また、Cluster WebUI 上で、フェイルバック先のサーバでグループのステータスが起動済になることも確認します。

注釈

ミラーディスクリソース/ハイブリッドディスクリソースを含むグループの場合、ミラー復帰が必要なため、自動フェイルバックに設定できません。

- 通報オプション (設定している場合)通報オプションを設定している場合は、フェイルオーバの確認で、通報メールが送信されることを確認します。

- クラスタシャットダウンクラスタをシャットダウンします。クラスタ内の全サーバが正常にシャットダウンされることを確認します。また、全サーバを再起動して、正常に起動することを確認します。その間、Cluster WebUI のアラートログに警告や異常が記録されていないことも確認します。

7.2. コマンドによるクラスタの状態確認¶

クラスタを生成後、コマンドラインを使用してクラスタを構成するサーバ上からクラスタの状態を確認するには、以下の手順で状態を確認します。

参考

コマンドの操作方法については『リファレンスガイド』の「CLUSTERPRO コマンドリファレンス」を参照してください。また、状態確認で異常がある場合は『リファレンスガイド』の「トラブルシューティング」を参照して障害を取り除いてください。

- ハートビートリソースclpstat コマンドを使用して、各サーバのステータスが起動済であることを確認します。各サーバのハートビートリソースのステータスが正常であることを確認します。

- モニタリソースclpstat コマンドを使用して、各モニタリソースのステータスが正常であることを確認します。

- グループ起動clpgrp コマンドを使用して、グループを起動します。clpstat コマンドを使用して、グループのステータスが起動済であることを確認します。

- ディスクリソース/ミラーディスクリソース/ハイブリッドディスクリソースディスクリソース/ミラーディスクリソース/ハイブリッドディスクリソースが起動しているサーバで、このリソースの切替パーティション/データパーティションにアクセスできることを確認します。また、このリソースが起動していないサーバでは、このリソースの切替パーティション/データパーティションにアクセスできないことを確認します。

- フローティング IP リソースフローティング IP リソースが起動している状態で、フローティング IP アドレスに対して ping コマンドが成功することを確認します。

- アプリケーションリソースアプリケーションリソースが起動しているサーバで、アプリケーションが動作していることを確認します。

- サービスリソースサービスリソースが起動しているサーバで、サービスが動作していることを確認します。

- グループ停止clpgrp コマンドを使用して、グループを停止します。clpstat コマンドを使用して、グループのステータスが停止済であることを確認します。

- グループ起動clpgrp コマンドを使用して、グループを起動します。clpstat コマンドを使用して、グループのステータスが起動済であることを確認します。

- グループ移動clpgrp コマンドを使用して、グループを他のサーバに移動します。clpstat コマンドを使用して、グループのステータスが起動済であることを確認します。フェイルオーバポリシーに含まれる全サーバに対してグループを移動してステータスがONLINE になることを確認します。

- フェイルオーバグループが起動しているサーバをシャットダウンします。ハートビートタイムアウト経過後、clpstat コマンドを使用して、グループがフェイルオーバされることを確認します。また、clpstat コマンドを使用して、フェイルオーバ先のサーバでグループのステータスが起動済になることも確認します。

- フェイルバック (設定している場合)自動フェイルバックを設定している場合は、11. フェイルオーバでシャットダウンしたサーバを起動します。サーバ起動後、clpstat コマンドを使用して、グループがフェイルバックすることを確認します。また、clpstat コマンドを使用して、フェイルバック先のサーバでグループのステータスが起動済になることも確認します。

- 通報オプション (設定している場合)通報オプションを設定している場合は、フェイルオーバの確認で Mail が送信されることを確認します。

- クラスタシャットダウンclpstdn コマンドを使用して、クラスタをシャットダウンします。クラスタ内の全サーバが正常にシャットダウンされることを確認します。

8. 動作チェックを行う¶

8.1. 動作確認テストを行う¶

- 擬似障害発生による回復動作の遷移障害検証機能を利用して、異常を検出したモニタリソースの回復動作が設定で意図したとおりに動作することを確認してください。本機能は、Cluster WebUI 、または clpmonctrl コマンドからテストすることが出来ます。詳細については、オンラインマニュアルまたは『リファレンスガイド』の「CLUSTERPRO コマンドリファレンス」をご参照ください。

- 共有ディスクの擬似障害(共有ディスクが RAID 化されていて擬似障害評価が可能な場合)共有ディスクの RAID の障害、交換、復旧を想定したテストを行ってください。- 共有ディスクの擬似障害を発生させる- RAID を縮退状態から正常状態へ復帰する共有ディスクによっては縮退運転への切り替え、RAID の再構築時に一時的に I/O の停止、遅延が発生する場合があります。ディスク RW 監視リソース、ディスク TUR 監視リソースなどにタイムアウトや遅延警告が発生した場合には各モニタリソースのタイムアウト値を調整してください。

- 共有ディスクへのパスの擬似障害(共有ディスクへのパスが二重化されていて擬似障害評価が可能な場合)パスの障害、切替を想定したテストを行ってください。- プライマリパスの擬似障害を発生させるパス切り替えソフトウェア (ドライバ) によっては正常なパスが切り替わるまでに時間がかかり OS (ソフト) 側へ制御を戻さない場合があります。ディスク RW 監視リソース、ディスク TUR 監視リソースなどにタイムアウトや遅延警告が発生した場合には各モニタリソースのタイムアウト値を調整してください。

- バックアップ / リストア定期バックアップなどを行う場合には、実際にバックアップを試行してください。バックアップソフトやアーカイブコマンドの中には CPU 負荷やディスクの I/O 負荷が高いものがあります。ハートビートや各種モニタリソースの遅延警告/タイムアウトが発生した場合には、ハートビートタイムアウト値や各モニタリソースのタイムアウト値を調整してください。

以下に、デバイス別の擬似障害と、発生する現象ついて記載します。なお、擬似障害により発生する現象は、システム構成やリソースの設定により異なります。以下の表では一般的な設定・構成における動作例を記載しています。

装置 |

擬似障害 |

発生する現象 |

|---|---|---|

共有ディスク装置

SCSI/FC パス

|

現用系サーバに接続されているディスクケーブルを抜く(ディスクケーブルを二重化している場合は二本とも抜く) |

共有ディスクを監視している場合、異常を検出して待機系へフェイルオーバする (ディスクを監視していない場合は業務停止)。

フェイルオーバ時に、ディスクリソースの非活性化に失敗することがある。

|

待機系サーバに接続されているディスクケーブルを抜く(二重化している場合は二本とも抜く) |

ディスクTUR監視リソースで待機系のディスクパスを監視している場合、異常を検出する。

業務は現用系でそのまま継続動作する。

|

|

ディスクパスを二重化している場合、プライマリパスのケーブルを抜く (FCスイッチを使用している場合は、FCスイッチの電源OFFも試す) |

パス切替ソフトウェアによるディスクパスの切替が行われる。

CLUSTERPRO では異常は検出されず、業務もそのまま継続動作する。

|

|

上記の片パス状態でグループ移動やクラスタシャットダウンによる再起動を行う |

ディスクパスが正常な場合と同様に動作する。 |

|

ディスク装置の RAID を縮退・復旧させる |

CLUSTERPRO では異常は検出されず、業務もそのまま継続動作する。 |

|

ディスク装置のコントローラが二重化されている場合、片側を停止する |

パスを二重化している場合はパス切替ソフトウェアによるディスクパスの切替が行われる。CLUSTERPRO では異常は検出されず、業務もそのまま継続動作する。

パスを二重化せず、各サーバをディスクに直結している場合は、停止したコントローラに接続されていたサーバでディスクTUR監視リソースが異常を検出し、待機系へフェイルオーバする (待機系側のコントローラを停止した場合はそのまま業務継続)。

|

|

インタコネクト LAN |

インタコネクト専用 LAN のケーブルを抜く |

インタコネクト側の LAN ハートビートリソースがOFFLINE になり、アラートログに警告が表示される。

サーバ間通信はパブリック LAN (バックアップのインタコネクト LAN )を使用して継続

=業務は継続

|

パブリック LAN |

パブリック LAN のケーブルを抜く、または HUB の電源 OFF |

業務クライアントとの通信途絶。業務アプリケーションによってはアプリケーションストール/エラーが発生する。

パブリック側の LAN ハートビートリソースが非活性になり、アラートログに警告が表示される。

IP 監視リソースや NIC Link Up/Down 監視リソースを使用している場合、異常を検出する。現用系のケーブルを抜いた場合はフェイルオーバが発生する (HUBの電源を切った場合は設定された最大回数までフェイルオーバが繰り返される)。

遠隔クラスタ構成など、サーバ間の通信路がパブリック LAN のみの場合、ping 方式のネットワークパーティション解決により、LAN ケーブルを抜いた方のサーバが緊急シャットダウンされる。

|

サーバ側 UPS |

現用系の UPS の電源ケーブルをコンセントから抜く |

現用系サーバがシャットダウン

=待機系へフェイルオーバ

|

共有ディスク側 UPS |

共有ディスクの電源を二重化している場合、片側の UPS の電源ケーブルをコンセントから抜く |

CLUSTERPRO では異常は検出されず、業務もそのまま継続動作する。

UPS が片サーバの電源も供給している場合は、サーバのシャットダウンも発生する (現用系の場合は待機系へフェイルオーバ)。

|

UPS 用 LAN |

LAN ケーブルを抜く |

UPS が制御不能となるが、CLUSTERPRO では異常は検出されず、業務もそのまま継続動作する。 |

OS 障害 |

現用系でシャットダウンコマンドを実行 |

現用系サーバがシャットダウン

=待機系へフェイルオーバ

|

ミラーディスクコネクト |

ミラーディスクコネクトに LAN ケーブルが複数設定されている、かつLAN ケーブルが一本以上つながっている場合

ミラーディスクコネクトとして利用しているLAN ケーブルを一本のみ抜く

|

ミラーリング継続 |

ミラーディスクコネクトに LAN ケーブルが複数設定されていない、またはミラーディスクコネクトに LAN ケーブルが複数設定されているが LAN ケーブルがすべてつながっていない場合

ミラーディスクコネクトとして利用しているLAN ケーブルのみ抜く

|

アラートログに警告が表示される(ミラーリング停止)

業務は現用系で継続動作するが、待機系への切り替えができない

|

|

ミラーディスク監視リソースまたはハイブリッドディスク監視リソースで異常検出 |

リソース |

擬似障害 |

発生する現象 |

|---|---|---|

ディスクリソース |

ディスクパスを抜いた状態のサーバで、ディスクリソースを起動する。 |

ディスクリソースが活性しない

待機系へフェイルオーバ

|

アプリケーションリソース |

アプリケーションリソースの開始パスに設定されているファイル/フォルダ名を一時的に書き換えた状態のサーバでアプリケーションリソースを起動する。 |

アプリケーションリソースが活性しない

待機系へフェイルオーバ

|

アプリケーション監視リソース |

監視対象のプロセスをタスクマネージャ等により停止する。 |

異常を検出し、アプリケーションを再起動、または待機系にフェイルオーバ |

サービスリソース |

サービスの実行ファイルのパス/ファイル名を一時的に書き換えた状態のサーバでサービスリソースを起動する。 |

サービスリソースが活性しない

待機系へフェイルオーバ

|

サービス監視リソース |

監視対象のサービスを停止する。 |

異常を検出し、サービスを再起動、または待機系にフェイルオーバ |

フローティング IP リソース |

フローティング IP リソースに設定されている IP アドレスと同じ IP アドレスを同一セグメント内のマシンに設定し、フローティング IP リソースを起動する。 |

フローティング IP リソースが活性しない

待機系へフェイルオーバ

(フェイルオーバ先でも活性失敗し、設定された最大回数までフェイルオーバが繰り返される)

|

参考

各パラメータの変更方法は『リファレンスガイド』を参照してください。

8.2. バックアップ / リストア手順を確認する¶

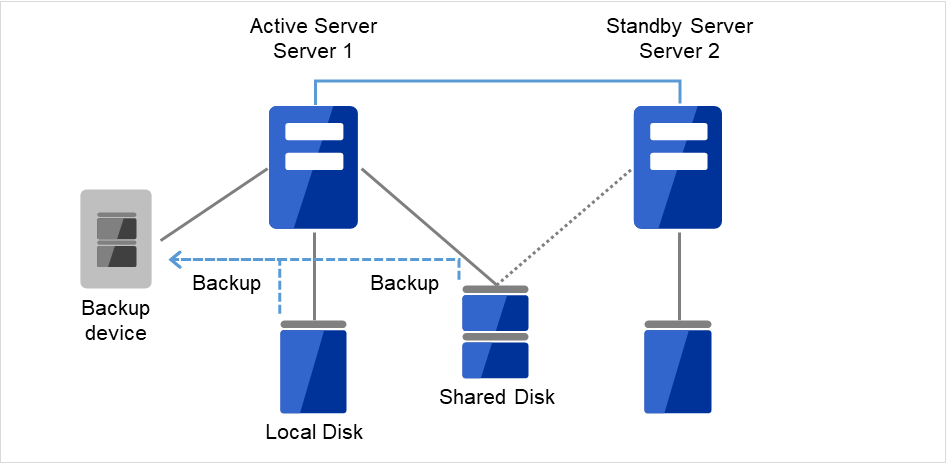

データのバックアップ/リストアは、以下のようなイメージで行います。バックアップ方法の詳細は『メンテナンスガイド』の「保守情報」、およびバックアップソフトのマニュアルを参照してください。

共有ディスク(Shared Disk)、ローカルディスク(Local Disk)のデータは、現用系サーバ(Server 1)に接続されたデバイスにバックアップします。

図 8.1 片方向スタンバイでのバックアップの例 (1)¶

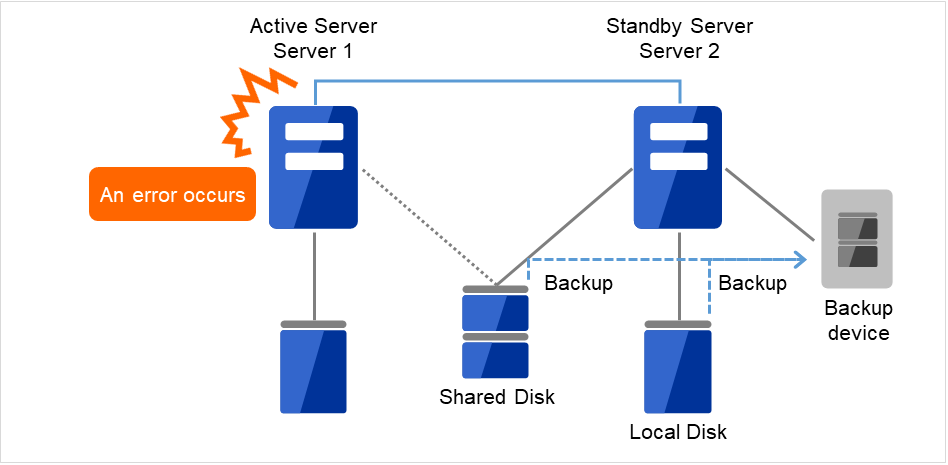

現用系サーバ(Server1)に障害が発生した場合、待機系サーバ(Server 2)に接続されたデバイスに共有ディスク(Shared Disk)、ローカルディスク(Local Disk)のデータをバックアップします。

図 8.2 片方向スタンバイでのバックアップの例 (2)¶

9. 運用開始前の準備を行う¶

9.1. 基本的な運用、操作手順を理解する¶

9.1.1. クラスタを起動する¶

以下の手順に従って、クラスタを起動してください。

共有ディスクまたは外付けの増設ディスクを使用している場合は、ディスクの電源を投入します。

クラスタを構成している全てのサーバの電源を投入します。

サーバ間でのクラスタ起動の同期を待ち合わせた後、各サーバでクラスタが起動します。クラスタが起動した後、設定に従い適切なサーバでグループが起動します。

注釈

クラスタ内の全てのサーバの電源投入は、Cluster WebUI の [クラスタのプロパティ] - [タイムアウト] タブで設定する [同期待ち時間] 内に行ってください。この時間内にサーバの起動が確認されない場合には、フェイルオーバが発生するため注意してください。

注釈

共有ディスクは、電源投入後数分間の時間をかけて初期化処理を行います。初期化処理中にサーバが起動すると、共有ディスクを認識できません。共有ディスクの初期化完了後、サーバが起動するように設定してください。

9.1.2. クラスタシャットダウン、サーバシャットダウンを実行する¶

クラスタのシャットダウンやサーバのシャットダウンは、CLUSTERPRO コマンドまたは Cluster WebUI を使用して行ってください。

注釈

Replicator / Replicator DR を使用している場合には、CLUSTERPRO コマンドまたは Cluster WebUI を使用しないでクラスタのシャットダウンを行うとミラーブレイクが発生することがあります。

9.1.3. クラスタ全体をシャットダウンするには¶

clpstdn コマンド、または Cluster WebUI からクラスタシャットダウン、またはスタートメニューからクラスタシャットダウンを実行することでクラスタをシャットダウンすることができます。クラスタシャットダウンでは、全てのグループの停止を待ち合わせた後、各サーバを終了させます。クラスタシャットダウンにより、クラスタ内の全サーバをクラスタとして正常に終了させることができます。

9.1.4. サーバ単体をシャットダウンするには¶

9.1.5. クラスタサスペンド、クラスタリジュームを実行する¶

サスペンド状態では、活性していたリソースはそのまま活性した状態で CLUSTERPROサービスが停止するため以下の機能が停止します。

全てのハートビートリソースが停止します。

全てのネットワークパーティション解決リソースが停止します。

全てのモニタリソースが停止します。

グループまたはグループリソースの操作ができなくなります。(起動、停止、移動)

以下のコマンドが使用不可となります。

clpcl の --resume以外のオプション

clpdown

clpstdn

clpgrp

clptoratio

clpmonctrl

clprsc

9.1.6. クラスタをサスペンドするには¶

clpcl コマンド、または Cluster WebUI からクラスタサスペンドを実行することでクラスタをサスペンドすることができます。

9.1.7. クラスタをリジュームするには¶

clpcl コマンド、または Cluster WebUI からクラスタリジュームを実行することでクラスタをリジュームすることができます。

9.2. CLUSTERPRO を一時停止する¶

CLUSTERPRO の動作を停止する方法としては、CLUSTERPRO Serverサービスを停止する方法と、CLUSTERPRO Server サービスを手動起動設定にする方法の 2 つがあります。

9.2.1. CLUSTERPRO Server サービスの停止¶

OS をシャットダウンしないで CLUSTERPRO Server サービスだけを停止する場合、clpcl コマンド、または Cluster WebUI から [クラスタ停止] を使用します。

参考

clpcl コマンドの詳細については『リファレンスガイド』の「CLUSTERPRO コマンドリファレンス」を参照してください。

9.2.2. CLUSTERPRO Server サービスの手動起動設定¶

OS 起動時に CLUSTERPRO Server サービスが起動しないようにするには、OS のサービスマネージャで CLUSTERPRO Server サービスを手動起動に設定します。これにより、次回 OS 起動時から CLUSTERPRO の動作が停止した状態となります。

9.2.3. 手動起動設定にした CLUSTERPRO Server サービスを自動起動設定にする¶

手動起動設定にした際と同様に、OS のサービスマネージャで CLUSTERPRO Server サービスを再び自動起動に設定します。設定変更後も、サーバを再起動するか CLUSTERPRO Server サービスを直接起動するまで CLUSTERPRO が停止した状態のままとなります。

9.3. クラスタ構成情報を変更する¶

クラスタ作成後、構成情報を変更する際の手順と注意事項について説明します。

9.3.1. Cluster WebUI を使用してクラスタ構成情報を変更する¶

Cluster WebUI を起動します。

Cluster WebUI の ツールバーのドロップダウンメニューで [設定モード] を選択します。

現在のクラスタ構成情報が表示されるので、構成情報を変更します。

- 変更した構成情報をアップロードします。その際、変更した情報によってはクラスタのサスペンドや停止、クラスタシャットダウンによる再起動などが必要になります。このような場合はアップロードが一旦キャンセルされ、必要な操作が表示されますので、表示されたメッセージにしたがって操作を行い、再度アップロードを実施してください。

9.3.2. クラスタ構成情報変更時の反映方法¶

変更したクラスタ構成情報をCluster WebUI や clpcfctrl コマンドでアップロードする際に、変更内容により以下のいずれかの操作が必要になります。各パラメータの変更反映に必要な操作については、『リファレンスガイド』の「パラメータの詳細」を参照してください。

反映方法によって、業務アプリケーションや CLUSTERPRO 本体の動作に影響する場合があります。詳細は以下の表を参照してください。

反映方法 |

影響 |

|---|---|

アップロードのみ |

業務アプリケーションや CLUSTERPRO 本体の動作に影響はありません。

ハートビートリソースやグループリソース、モニタリソースは停止しません。

|

アップロードしてから API サービス再起動 |

〃 |

アップロードしてから WebManager サーバを再起動 |

〃 |

アップロードしてから Information Base サービス再起動 |

〃 |

アップロードしてから Node Manager サービス再起動 |