1. 前言¶

1.1. 读者对象及用途¶

《EXPRESSCLUSTER® X SingleServerSafe操作指南》的读者对象为导入系统后进行维护和操作的系统管理员,说明EXPRESSCLUSTER X SingleServerSafe的操作方法。

1.2. 本手册的构成¶

1.3. 本手册记述的术语¶

为提高与集群软件EXPRESSCLUSTER X 的操作性等方面的兼容性,本手册中介绍的EXPRESSCLUSTERX SingleServerSafe使用了相同的画面及命令。因此,采用了部分集群相关的术语。

请参照下列术语的说明来阅读本手册。

- 集群,集群系统

导入了EXPRESSCLUSTER X SingleServerSafe的单一服务器的系统

- 集群停止/重启

导入了EXPRESSCLUSTER X SingleServerSafe的系统的关闭/重启

- 集群资源

EXPRESSCLUSTER X SingleServerSafe所使用的资源

- 集群对象

EXPRESSCLUSTER X SingleServerSafe所使用的各种资源的对象

- 失效切换组

汇集了EXPRESSCLUSTER X SingleServerSafe所使用的组资源(应用程序,服务等)的组

1.4. EXPRESSCLUSTER X SingleServerSafe 手册体系¶

EXPRESSCLUSTER X SingleServerSafe的手册分为以下4类。各指南的标题和用途如下所示。

《EXPRESSCLUSTER X SingleServerSafe 安装指南》(Install Guide)

本手册的读者对象为导入使用EXPRESSCLUSTER X SingleServerSafe的系统的系统工程师,对EXPRESSCLUSTER X SingleServerSafe的安装步骤进行说明。

《EXPRESSCLUSTER X SingleServerSafe 设置指南》(Configration Guide)

本手册的读者对象为导入使用EXPRESSCLUSTER X SingleServerSafe的集群系统的系统工程师以及导入系统后进行维护和操作的系统管理员,对EXPRESSCLUSTER X SingleServerSafe的构建工作进行说明。

《EXPRESSCLUSTER X SingleServerSafe 操作指南》(Operation Guide)

本手册的读者对象为使用EXPRESSCLUSTER X SingleServerSafe导入后的进行维护和操作的系统管理员,对EXPRESSCLUSTER X SingleServerSafe的操作方法进行说明。

《EXPRESSCLUSTER X SingleServerSafe 兼容功能指南》(Legacy Feature Guide)

本手册的读者对象为导入使用EXPRESSCLUSTER X SingleServerSafe的系统的系统工程师,对EXPRESSCLUSTER X SingleServerSafe 4.0 WebManager以及Builder进行了说明。

1.5. 本手册的标记规则¶

在本手册中,需要注意的事项,重要的事项以及相关信息等用如下方法标记。

注解

表示虽然比较重要,但是并不会引起数据损失或系统以及机器损伤的信息。

重要

表示为避免数据损失和系统,机器损坏所必需的信息。

参见

表示参考信息的位置。

另外,在手册中使用以下标记法。

标记 |

使用方法 |

例 |

|---|---|---|

[ ] 方括号

|

在命令名的前后,

显示在画面中的字句 (对话框,菜单等) 的前后。

|

点击[开始]。

[属性]对话框

|

命令行中的[ ] 方括号 |

表示括号内的值可以不予指定(可省)。 |

|

# |

表示Linux用户正以root身份登录的提示符。 |

|

等宽字体 |

路径名,命令行,系统输出(消息,提示符等),目录,文件名,函数,参数。 |

|

粗体

|

表示用户在命令行中实际输入的值。

|

输入以下内容。

#clpcl -s -a

|

斜体 |

用户将其替换为有效值后输入的项目

|

rpm -i expresscls -<版本号> -<发布号>.x86_64.rpm |

在本手册的图中,为了表示EXPRESSCLUSTER X SingleServerSafe,使用该图标。

在本手册的图中,为了表示EXPRESSCLUSTER X SingleServerSafe,使用该图标。

2. EXPRESSCLUSTER X SingleServerSafe 命令参考¶

本章中说明了在EXPRESSCLUSTER X SingleServerSafe 中可以使用的命令。

为提高与集群链接软件EXPRESSCLUSTER X的操作性等方面的兼容性,EXPRESSCLUSTER X SingleServerSafe 使用了相同的画面。

本章中介绍了以下内容。

2.1. 通过命令行操作¶

EXPRESSCLUSTER X SingleServerSafe中有通过命令提示符执行的多种命令。构筑集群或无法使用Cluster WebUI时很方便。命令行可以进行Cluster WebUI中可执行的上述种类的操作。

注解

进行查出监视资源时的设置时,在复原对象中指定组资源(磁盘资源,...),监视资源查出异常时进行复原运行的迁移时(重新启动 ->最终动作) 请不要执行以下命令或对Cluster WebUI中的服务及组进行控制。

服务的停止/挂起

组的启动/停止

由于监视资源异常而进行复原运行的迁移时执行上述控制,则该组的其它组资源可执行不会停止。此外,即使处于监视资源异常状态,若执行了最终动作,即可执行上述控制。

重要

安装目录下有本手册中未记载的执行形式文件和脚本文件,但请不要从EXPRESSCLUSTER X SingleServerSafe以外执行这些文件。不对执行这些文件后出现的任何问题负责。

2.2. 命令列表¶

构筑相关

命令

说明

请参阅

clpcfctrl将Cluster WebUI创建的配置信息发送到服务器中。为了在Cluster WebUI中使用,备份集群配置信息。clplcnsc

管理本产品的产品版,试用版License。

clpcfchk

检查集群配置信息。

状态显示相关

命令

说明

请参阅

clpstat

显示EXPRESSCLUSTER X SingleServerSafe状态和设置信息。

clphealthchk

确认进程的健全性。

操作相关

命令

说明

请参阅

clpcl

执行集群Daemon的启动,停止,挂起,复原等。

clpstdn

停止EXPRESSCLUSTER Daemon,关闭服务器。

clpgrp

执行组的启动,停止。

clptoratio

延长,显示集群中的各种超时值。

clpmonctrl

暂时停止/重新启动单个服务器上的监视资源。

clpregctrl

显示/初始化单个服务器上的重启次数。

clprsc

组资源的暂时停止/重新启动。

clpcpufreq

控制CPU频率。

clptrnreq

要求服务器处理执行。

clprexec

外部监视请求EXPRESSCLUSTER服务器执行处理。

clpbmccnf

更改BMC用户名,密码信息。

日志相关

命令

说明

请参阅

clplogcc

收集日志,OS信息等。

clplogcf

更改,显示日志级别,日志输出文件大小的设置。

clpperfc

显示组,监视资源相关的集群统计信息。

脚本相关

命令

说明

请参阅

clplogcmd

在EXEC资源的脚本中描述,将任意消息输出到输出目标中。

系统监视相关 (使用System Resorce Agent情况)

命令

说明

请参阅

clpprer

通过给出的资源使用量数据的趋势,预测未来值。

重要

虽然安装目录下面有本手册中未记载的执行方式文件及脚本文件,但是请勿从EXPRESSCLUSTER X SingleServerSafe以外执行。否则,由此导致的影响将不属于技术支持的范围。

2.3. 显示状态 (clpstat 命令)¶

显示EXPRESSCLUSTER X SingleServerSafe 的状态及设置信息。

-

命令行 - clpstat -s [--long]clpstat -gclpstat -mclpstat -i [--detail]clpstat --cl [--detail]clpstat --sv [--detail]clpstat --grp [group_name] [--detail]clpstat --rsc [resource_name] [--detail]clpstat --mon [monitor_name] [--detail]

-

说明 显示服务器的状态及设置信息。

-

选项 -

-s¶

-

无选项¶ 显示状态。

-

--long¶ 显示集群名,资源名等信息的全部。

-

-g¶ 显示组地图。

-

-m¶ 显示各监视资源的状态。

-

-i¶ 显示设置信息。

-

--cl¶ 显示设置信息。

-

--sv¶ 显示服务器的设置信息。

-

--grp[group_name]¶ 显示组的设置信息。通过指定组名,只能显示指定的组信息。

-

--rsc[resource_name]¶ 显示组资源的设置信息。通过指定组资源名,只能显示指定的组资源信息。

-

--mon[monitor_name]¶ 显示监视资源的设置信息。通过指定监视资源名,只能显示指定的监视资源信息。

-

--detail¶ 通过使用该选项,可以显示更加详细的设置信息。

-

-

返回值 0

成功

9

二次启动

上记以外

异常

-

注意事项

-

错误消息 消息

原因/处理办法

Log in as root.

请以拥有root权限的用户身份执行该命令。

Invalid configuration file. Create valid cluster configuration data.

请使用Cluster WebUI创建正确的集群配置信息。

Invalid option.

请指定正确的选项。

Could not connect to the server. Check if the cluster daemon is active.

请确认EXPRESSCLUSTER Daemon是否启动。

Invalid server status.

请确认EXPRESSCLUSTER Daemon是否启动。

Server is not active. Check if the cluster daemon is active.

请确认EXPRESSCLUSTER Daemon是否启动。

Invalid server name. Specify a valid server name in the cluster.

请指定集群内正确的服务器名。

Invalid heartbeat resource name. Specify a valid heartbeat resource name in the cluster.

请指定集群内正确的心跳资源名。

Invalid network partition resourcename. Specify a valid networkpartition resource name in the cluster.请指定集群内正确网络分区解决资源名。Invalid group name. Specify a valid group name in the cluster.

请指定集群内正确的组名。

Invalid group resource name. Specify a valid group resource name in the cluster.

请指定集群内正确的组资源名。

Invalid monitor resource name. Specify a valid monitor resource name in the cluster.

请指定集群内正确的监视资源名。

Connection was lost. Check if there is a server where the cluster daemon is stopped in the cluster.

请确认集群内是否存在EXPRESSCLUSTER Daemon停止的服务器。

Invalid parameter.

可执行是命令的参数中设置了非法的值。

Internal communication timeout has occurred in the cluster server. If it occurs frequently, set the longer timeout.EXPRESSCLUSTER的内部通信中发生超时。如果频繁发生超时,请延长内部通信超时时间。Internal error. Check if memory or OS resources are sufficient.

内存不足或者OS资源不足。请确认。

Invalid server group name. Specify a valid server group name in the cluster.

请指定集群内正确的服务器组名。

This command is already run.本命令已被执行。不能双重启动本命令。The cluster is not created.

请做成集群配置文件并上传。

Could not connect to the server. Internal error. Check if memory or OS resources are sufficient.

内存不足或者OS资源不足。请确认。

Cluster is stopped. Check if the cluster daemon is active.

请确认EXPRESSCLUSTER Daemon是否启动。

Cluster is suspended. To display the cluster status, use --local option.集群处于暂停状态。要显示集群的状态,请使用--local选项。

2.4. 操作EXPRESSCLUSTER Daemon (clpcl 命令)¶

操作EXPRESSCLUSTER Daemon。

-

命令行 - clpcl -sclpcl -t [-w timeout] [--apito timeout]clpcl -r [-w timeout] [--apito timeout]clpcl --suspend [--force] [-w timeout] [--apito timeout]clpcl --resume

-

说明 执行EXPRESSCLUSTER Daemon的启动,停止,暂停,复原等命令。

-

选项 -

-s¶ 启动EXPRESSCLUSTERDaemon。

-

-t¶ 停止EXPRESSCLUSTERDaemon。

-

-r¶ 重启EXPRESSCLUSTERDaemon。

-

--suspend¶ 暂停EXPRESSCLUSTERDaemon。

-

--resume¶ 复原EXPRESSCLUSTERDaemon。

-

-wtimeout¶ - 只有使用-t, -r, --suspend选项时,指定clpcl命令等待EXPRESSCLUSTERDaemon停止或等待完成挂起的等待时间。单位为秒。未指定timeout时将一直等待。timeout中指定了"0"时,不作等待。未指定-w选项时,等待时间为(心跳超时×2)秒。

-

--force¶ 由于和--suspend选项一起使用,不管服务器状态,强行执行挂起。

-

--apitotimeout¶ - 以秒为单位指定等待EXPRESSCLUSTER Damon的停止,重启,挂起的时间(内部通信超时)。可指定1-9999的值。不指定[--apito]选项时,按照集群属性的内部通信超时所设置的值,进行等待。

-

-

返回值 0

成功

0 以外

异常

-

备考 - 指定-s或--suspend选项来执行本命令时,在对象服务器中处理开始时返回控制。指定-t或--suspend选项来执行本命令时,等待处理结束后返回控制。指定-r选项来执行本命令时,对象服务器的EXPRESSCLUSTER X SingleServerSafeDaemon服务从暂停到启动时返回控制。请使用clpstat命令确认EXPRESSCLUSTER X SingleServerSafeDaemon服务是否未启动或挂起。

-

注意事项 - 请以拥有root权限的用户身份执行该命令。在组的启动处理中和停止处理中不能执行该命令。请在EXPRESSCLUSTERDaemon处于已启动的状态下执行挂起。如果使用--force选项,强制执行挂起。执行复原时,请使用clpstat命令确认EXPRESSCLUSTERDaemon是否未启动。

-

执行示例 例1: 启动服务器EXPRESSCLUSTERDaemon时

# clpcl -s

关于挂起/复原

要更新集群配置信息,升级EXPRESSCLUSTER等时,可以在继续操作业务时停止EXPRESSCLUSTER Daemon服务。此种状态称为挂起。从挂起状态返回到普通的业务状态叫做复原。对服务器请求挂起/复原处理。请在服务器的ExpressCluterDaemon已启动的状态下执行挂起。在挂起状态下,启动的资源保持启动状态,停止ExpressCluter服务,会导致以下功能停止。停止所有监视资源。

无法操作组及组资源。(启动,停止)

不能使用以下命令。

clpcl --resume以外的其他选项

clpstdn

clpgrp

clptoratio

clpmonctrl

-

错误消息 消息

原因/处理方法

Log in as root.

请以拥有root权限的用户身份执行该命令。

Invalid configuration file. Create valid cluster configuration data.

请在Cluster WebUI中创建正确的集群配置信息。

Invalid option.

请指定正确的选项。

Performed stop processing to the stopped cluster daemon.

对停止的EXPRESSCLUSTER Daemon执行停止处理。

Performed startup processing to the active cluster daemon.

对启动的EXPRESSCLUSTER Daemon执行启动处理。

Could not connect to the server. Check if the cluster daemon is active.

请确认EXPRESSCLUSTER Daemon是否启动。

Could not connect to the data transferserver. Check if the server has startedup.请确认服务器已经启动。Failed to obtain the list of nodes. Specify a valid server name in the cluster.

请指定集群内正确的服务器名。

Failed to obtain the daemon name.

取得集群名失败。

Failed to operate the daemon.

控制集群失败。

Resumed the daemon that is not suspended.

对于非挂起状态的EXPRESSCLUSTER Daemon执行复原。

Invalid server status.

请确认EXPRESSCLUSTER Daemon是否启动。

Server is busy. Check if this command is already run.

可执行已经执行本命令。请确认。

Server is not active. Check if the cluster daemon is active.

请确认EXPRESSCLUSTER Daemon是否启动。

There is one or more servers of which cluster daemon is active. If you want to perform resume, check if there is any server whose cluster daemon is active in the cluster.

执行复原时,请确认集群内是否有已启动EXPRESSCLUSTER Daemon的服务器。

All servers must be activated. When suspending the server, the cluster daemon need to be active on all servers in the cluster.

执行挂起时,需要集群内所有的服务器都启动EXPRESSCLUSTER Daemon。

Resume the server because there is one or more suspended servers in the cluster.

集群中有挂起的服务器,请执行复原。

Invalid server name. Specify a valid server name in the cluster.

请指定集群内正确的服务器名。

Connection was lost. Check if there is a server where the cluster daemon is stopped in the cluster.

请确认集群内是否存在EXPRESSCLUSTER Daemon停止的服务器。

invalid parameter.

命令参数中可执行设置了错误的值。

Internal communication timeout has occurred in the cluster server. If it occurs frequently, set the longer timeout.

EXPRESSCLUSTER内部通信发生超时。如果频繁发生超时,请延长内部通信超时时间。Processing failed on some servers. Check the status of failed servers.存在处理失败的服务器。请确认集群内的服务器状态。请执行集群内所有启动的服务器。Internal error. Check if memory or OS resources are sufficient.

内存不足或者OS资源不足。请确认。

There is a server that is not suspended in cluster. Check the status of each server.

集群内存在不处于挂起状态的服务器。请确认各服务器的状态。

Suspend %s : Could not suspend in time.

服务器在超时时间内未完成EXPRESSCLUSTER Daemon的挂起处理。请确认服务器的状态。

Stop %s : Could not stop in time.

服务器在超时时间内未完成EXPRESSCLUSTER Daemon的停止处理。请确认服务器的状态。

Stop %s : Server was suspended.Could not connect to the server. Check if the cluster daemon is active..已要求EXPRESSCLUSTER Daemon停止,但服务器已处于挂起状态。Could not connect to the server. Check if the cluster daemon is active.

已要求EXPRESSCLUSTER Daemon停止,但无法连接服务器。请确认服务器的状态。

Suspend %s : Server already suspended.Could not connect to the server. Check if the cluster daemon is active.已要求EXPRESSCLUSTER Daemon挂起,但服务器已处于挂起状态。Event service is not started.

事件服务没有启动。请确认。

Mirror Agent is not started.

镜像Agent没有启动。请确认。

Event service and Mirror Agent are not started.

事件服务和镜像Agent没有启动。请确认。

Some invalid status. Check the status of cluster.

可执行存在迁移中的组。请在组迁移结束后,重新执行。

2.5. 服务器关机 (clpstdn命令)¶

服务器关机。

-

命令行 clpstdn [-r]

-

说明 停止服务器的EXPRESSCLUSTER Daemon,关机。

-

返回值 0

成功

0 以外

异常

注解

本命令,在组停止处理完成的时候才能被返回。

-

注意事项 - 请由拥有root权限的用户身份执行该命令。在组的启动处理中和停止处理中不能执行该命令。

-

执行示例 例1:进行服务器关机时

# clpstdn

例2:进行服务器的关机重启时

# clpstdn -r

2.6. 操作组 (clpgrp 命令)¶

操作组。

-

命令行 - clpgrp -s [group_name] [--apito timeout]clpgrp -t [group_name] [--apito timeout]

-

说明 执行组的启动,停止。

-

选项 -

-s[group_name]¶ 启动组。指定组名,则仅启动指定的组。如果未指定组名,则启动所有组。

-

-t[group_name]¶ 停止组。指定组名,则仅停止指定的组。如果未指定组名,则停止所有组。

-

--apitotimeout¶ - 以秒为单位指定等待EXPRESSCLUSTER Damon的停止,重启,挂起的时间(内部通信超时)。可指定1-9999的值。不指定[--apito]选项时,按照集群属性的内部通信超时所设置的值,进行等待。

-

-

返回值 0

成功

0 以外

异常

-

注意事项 - 请由拥有root权限的用户身份执行该命令。执行本命令的服务器必须启动EXPRESSCLUSTER Daemon。

-

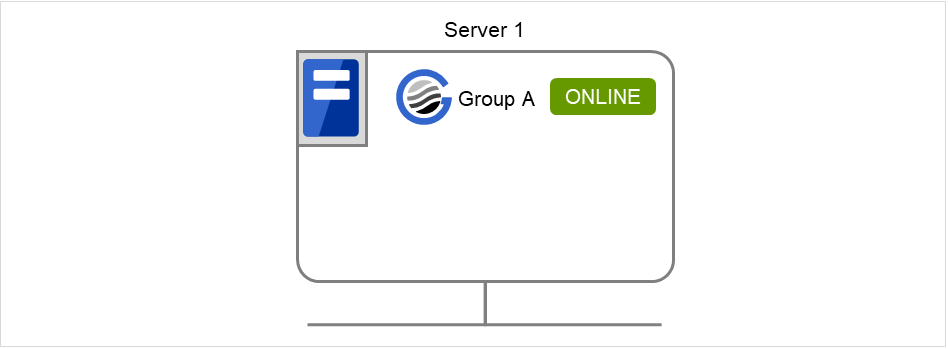

执行示例 - 通过简单的示例对执行组操作进行说明。服务器拥有[组groupA]时

在server1 服务器上执行以下的命令。启动groupA。

# clpgrp -s groupA

图 2.1 启动组¶

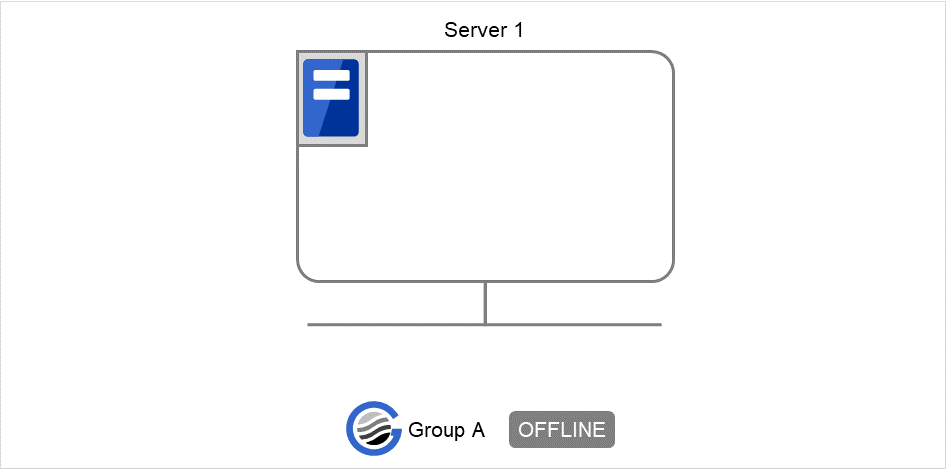

在server2上执行以下命令。停止groupA。

# clpgrp -t groupA

图 2.2 停止组¶

-

错误消息 消息

原因/处理方法

Log in as root.

请以拥有root权限的用户身份执行该命令。

Invalid configuration data. Create valid cluster configuration data.

请在Cluster WebUI中作成正确的集群配置信息。

Invalid option.

请指定正确的选项。

Could not connect to the server. Check if the cluster daemon is active.

请确认EXPRESSCLUSTER Daemon是否启动。

Invalid server status. Check if the cluster daemon is active.

请确认EXPRESSCLUSTER Daemon是否启动。

Server is not active. Check if the cluster daemon is active.

请确认EXPRESSCLUSTER Daemon是否启动。

Invalid server name. Specify a valid server name in the cluster.

请指定集群内正确的服务器名。

Connection was lost. Check if there is a server where the cluster daemon is stopped in the cluster.

请确认集群内是否存在EXPRESSCLUSTER Daemon停止的服务器。

Invalid parameter.

命令参数中可执行设置了错误的值。

Internal communication timeout has occurred in the cluster server. If it occurs frequently, set the longer timeout.EXPRESSCLUSTER内部通信发生超时。如果频繁发生超时,请延长内部通信超时时间。Invalid server. Specify a server that can run and stop the group, or a server that can be a target when you move the group.启动,停止,移动组的目标服务器有误。请指定正确的服务器。Could not start the group. Try it again after the other server is started, or after the Wait Synchronization time is timed out.

请等待其它服务器启动或等待启动等待时间超时,启动组。

No operable group exists in the server.

请确认请求处理的服务器中是否存在可处理的组。

The group has already been started on the local server.

请通过Cluster WebUI或clpstat命令确认组的状态。

The group has already been started on the other server. To start/stop the group on the local server, use -f option.请通过Cluster WebUI或clpstat命令确认组的状态。如果要在自身服务器上启动/停止其它服务器上启动的组,请执行组的移动,或加上-f选项执行。The group has already been started on the other server. To move the group, use "-h <hostname>" option.请通过Cluster WebUI或clpstat命令确认组的状态。如果要移动其他服务器上启动的组,请添加"-h <hostname>" 选项来执行。The group has already been stopped.

请通过Cluster WebUI或clpstat命令确认组的状态。

Failed to start one or more resources.Check the status of group

请通过Cluster WebUI或clpstat命令确认组的状态。

Failed to stop one or more resources.Check the status of group

请通过Cluster WebUI或clpstat命令确认组的状态。

The group is busy. Try again later.

组正处于启动处理或停止处理中,请稍后再执行。

An error occurred on one or more groups.Check the status of group

请通过Cluster WebUI或clpstat命令确认组的状态。

Invalid group name. Specify a valid group name in the cluster.

请指定集群内正确的组名。

Server is not in a condition to start group or any critical monitor error is detected.请通过Cluster WebUI或clpstat命令确认服务器的状态。在准备启动组的服务器中检测出包含在可排除列表中的监视器的异常。There is no appropriate destination for the group. Other servers are not in a condition to start group or any critical monitor error is detected.请通过Cluster WebUI或clpstat命令确认服务器的状态。在其他服务器中检测出包含在可排除列表中的监视器的异常。The group has been started on the other server. To migrate the group, use "-h <hostname>" option.请通过Cluster WebUI或clpstat命令确认组的状态。如果要移动在其他服务器上启动的组,请添加"-h <hostname>"选项来执行。The specified group cannot be migrated.

指定的组不能迁移。

The specified group is not vm group.

指定的组不是虚拟机的组。

Migration resource does not exist.请通过Cluster WebUI或clpstat命令确认组的状态。不存在迁移对象的资源。Migration resource is not started.请通过Cluster WebUI或clpstat命令确认组的状态。没有启动迁移对象的资源。Some invalid status. Check the status of cluster.

某些状态不正常。请确认集群状态。

Internal error. Check if memory or OS resources are sufficient.

内存不足或者OS资源不足。请确认。

2.7. 收集日志 (clplogcc 命令)¶

收集日志。

-

命令行 clplogcc [-t collect_type] [-r syslog_rotate_number] [-o path]

-

说明 连接到数据传送服务器,收集日志,OS信息等。

-

选项 -

无¶ 收集日志。

-

-tcollect_type¶ 指定日志收集模式。如果省略则日志收集模式为type1。

-

-rsyslog_rotate_number¶ 指定syslog 的收集版本数。省略时收集2版本。

-

-opath¶ 指定收集文件的输出目标。如果省略则将日志输出到安装路径的tmp下。

-

-

返回值 0

成功

0 以外

异常

-

备注 使用tar.gz压缩日志文件,所以请在tar命令上加上xzf 选项进行解压缩。

-

注意事项 请由拥有root权限的用户身份执行该命令。

-

执行示例 例1:从服务器收集日志时

# clplogcc Collect Log server1 : Success

显示执行了日志收集的服务器的执行结果(服务器状态)。

处理过程 服务器名 :执行结果(服务器状态)

执行结果

该命令的结果所显示的处理过程如下所示。

处理过程

说明

Connec

连接失败时显示。

Get Filesize

文件大小获取失败时显示。

Collect Log

显示获取文件的结果。

执行结果(服务器状态)如下所示。

执行结果(服务器状态)

说明

Success

成功。

Timeout

超时。

Busy

服务器正忙。

Not Exist File

文件不存在。

No Freespace

磁盘没有剩余空间。

Failed

因其它的错误导致失败。

-

错误消息 消息

原因/处理方法

Log in as root.

请以拥有root权限的用户身份执行该命令。

Invalid configuration file. Create valid cluster configuration data.

请在Cluster WebUI中作成正确的配置信息。

Invalid option.

请指定正确的选项。

Specify a number in a valid range.

请在正确的范围内指定数字。

Specify a correct number.

请指定正确的数字。

Specify correct generation number of syslog.

请指定正确的syslog版本数。

Collect type must be specified 'type1' or 'type2' or 'type3' or 'type4' or 'type5' or 'type6'. Incorrect collection type is specified.

错误指定收集类型。

Specify an absolute path as the destination of the files to be collected.

请在绝对路径下指定收集文件的输出目标。

Specifiable number of servers are the max number of servers that can constitute a cluster.

可指定的服务器数为可进行集群配置的最大服务器数。

Could not connect to the server. Check if the cluster daemon is active.

请确认EXPRESSCLUSTER Daemon是否启动。

Invalid server status.

请确认EXPRESSCLUSTER Daemon是否启动。

Server is busy. Check if this command is already run.

可执行已经执行本命令。请确认。

Internal error. Check if memory or OS resources are sufficient.

内存不足或者OS资源不足。请确认。

2.7.1. 收集指定类型的日志 (-t 选项)¶

仅想收集指定类型的日志时,请使用clplogcc命令指定-t选项。

日志的收集类型可指定为type1 ~ 6。

type1

type2

type3

type4

type5

type6

按缺省设置收集日志

✓

✓

✓

✓

n/a

n/a

syslog

✓

✓

✓

n/a

n/a

n/a

core文件

✓

✓

n/a

✓

n/a

n/a

OS信息

✓

✓

✓

✓

n/a

n/a

脚本

✓

✓

n/a

n/a

n/a

n/a

ESMPRO/AC

✓

✓

n/a

n/a

n/a

n/a

HA 日志

n/a

✓

n/a

n/a

n/a

n/a

镜像统计信息

n/a

n/a

n/a

n/a

n/a

n/a

集群统计信息

n/a

n/a

n/a

n/a

n/a

✓

系统资源统计信息

✓

✓

✓

✓

n/a

✓

# clplogcc -t type2

未指定选项时的日志收集类型为type1。

按缺省设置收集日志

EXPRESSCLUSTER服务器的各模块日志

警告日志

EXPRESSCLUSTER服务器的各模块的属性信息(ls -l)

bin,lib下

alert/bin,webmgr/bin下

drivers/md下

drivers/khb下

drivers/ka下

安装完毕的所有packge信息(rpm -qa的执行结果)

EXPRESSCLUSTER的版本信息(rpm -qi expresscls的执行结果)

Distribution信息(/etc/*-release)

License信息

配置信息文件

策略文件

EXPRESSCLUSTER正在使用的共享内存的dump

EXPRESSCLUSTER的状态(clpstat -local的执行结果)

进程,线程信息(ps 的执行结果)

PCI设备信息(lspci 的执行结果)

服务信息(systemctl,chkconfig,ls命令等的执行结果)

kernel参数的输出结果(sysctl -a 的执行结果)

glibc版本(rpm -qi glibc 的执行结果)

kernel Loadable模块设置信息(/etc/modules.conf,/etc/modprobe.conf)

kernel的Ring缓冲信息(dmesg 的执行结果)

文件系统信息 (/etc/fstab)

IPC资源信息(ipcs 的执行结果)

系统信息(uname -a 的执行结果)

网络统计信息(netstat, ss的执行结果 IPv4/IPv6)

ip (ip addr,link,maddr,route,-s l 的执行结果)

全网络界面信息(ethtool 的执行结果)

OS紧急关闭时的信息采集

libxml2版本(rpm -qi libxml2 的执行结果)

静的Host表(/etc/hosts)

文件系统的export table (exportfs -v 的执行结果)

用户资源限制信息(ulimit -a 的执行结果)

kernelbase的NFS中输出的文件系统(/etc/exports)

本地OS (locale)

Terminal session的环境变量(export 的执行结果)

本地语言(/etc/sysconfig/i18n)

Time zone (env - date 的执行结果)

EXPRESSCLUSTER服务器的工作领域信息

- 各监视选项产品相关的信息若安装了监视选项产品,则相关信息将被收集

监视器资源超时时采集的转储信息

Oracle监视器资源检出异常时采集的Oracle详细信息

syslog

syslog (/var/log/messages)

syslog (/var/log/syslog)

指定的版本数的syslog (/var/log/messages.x)

journal 日志(/var/run/log/journal/ 下的文件等)

Core文件

- EXPRESSCLUSTER模块的core文件/opt/nec/clusterpro/log下可以容纳以下存档名。

警报关联

altyyyymmdd_x.tar

WebManager服务器关联

wmyyyymmdd_x.tar

EXPRESSCLUSTER core关联

clsyyyymmdd_x.tar srayyyymmdd_x.tar jrayyyymmdd_x.tar

yyyymmdd为日志收集日期,x为连续编号。

OS信息

内核模式LAN心跳,启动信息

/proc/khb_moninfo

/proc/ka_moninfo

/proc/devices

/proc/mdstat

/proc/modules

/proc/lvm

/proc/mounts

/proc/meminfo

/proc/cpuinfo

/proc/partitions

/proc/pci

/proc/version

/proc/ksyms

/proc/net/bond*

/proc/scsi/目录内的全文件

/proc/ide/目录内的全文件

/etc/fstab

/etc/rc*.d

/etc/syslog.conf

/etc/syslog-ng/syslog-ng.conf

/proc/sys/kernel/core_pattern

/proc/sys/kernel/core_uses_pid

/etc/snmp/snmpd.conf

内核的Ring缓冲信息(dmesg 的执行结果)

ifconfig (ifconfig的执行结果)

iptables (iptables -L的执行结果)

ipchains (ipchains -L的执行结果)

df (df的执行结果)

raw设备信息 (raw -qa的执行结果)

内核模块road信息(lsmod的执行结果)

主机名,域名信息(hostname,domainname的执行结果)

dmidecode (dmidecode的执行结果)

LVM 设备信息(vgdisplay -v 的执行结果)

snmpd版本信息(snmpd -v的执行结果)

虚拟化基础架构信息(virt-what的执行结果)

执行日志收集时,有时在控制台上显示下列消息,这并非是异常现象。日志可以正常收集。

hd#: bad special flag: 0x03 ip_tables: (C) 2000-2002 Netfilter core team

(在hd#中加入服务器上存在的IDE的设备名)- 脚本在Cluster WebUI创建的组启动/停止脚本如果指定了上述以外的用户定义脚本(/opt/nec/clusterpro/scripts以外),则由于不包含在日志收集的采集信息中,需要另外采集。

- ESMPRO/AC相关日志通过执行acupslog命令收集的文件

HA 日志

系统资源信息

JVM监视日志

系统监视日志

- 镜像统计信息此版本中不能收集。

集群统计信息

集群统计信息

perf/cluster 下

系统资源统计信息

系统资源统计信息

/perf/system 下

2.7.2. syslog的版本 (-r 选项)¶

收集指定的版本数时如下执行syslog。

例)使用版本数3收集日志时

# clplogcc -r 3

收集的日志包含以下的syslog。

未指定选项时收集第2版本的。

可以指定的版本数为0~99 。

指定0时收集所有的syslog。

版本数 |

获取的版本 |

|---|---|

0 |

所有版本 |

1 |

当前 |

2 |

当前 + 版本1 |

3 |

当前 + 版本1~2 |

: |

|

x |

当前 + 版本1~(x-1) |

2.7.3. 日志文件的输出目标 (-o 选项)¶

文件名保存为 "服务器名-log.tar.gz"。

使用tar.gz压缩日志文件,所以请在tar命令上加上xzf 选项进行解压缩。

未指定-o选项时

在安装路径的tmp下输出日志。

# clplogcc Collect Log 服务器名: Success # ls /opt/nec/clusterpro/tmp 服务器名-log.tar.gz

指定-o选项时

若执行以下命令,则将日志输出到指定的目录/home/log下。

# clplogcc -o /home/log Collect Log 服务器名: Success # ls /home/log 服务器名-log.tar.gz

2.7.4. 采集发生异常时的信息¶

发生下列异常时,采集如下信息用于故障分析。

构成集群的集群Daemon由于信号的插入而结束(core dump),或因内部状态异常等异常结束时

组资源的启动异常,停止异常发生时

监视资源的监视异常发生时

采集的信息如下。

信息

EXPRESSCLUSTER服务器的部分模块的日志

EXPRESSCLUSTER X SingleServerSafe正在使用的共享内存的dump

配置信息文件

EXPRESSCLUSTER模块的core文件

OS情報(/proc/*)

/proc/devices

/proc/partitions

/proc/mdstat

/proc/modules

/proc/mounts

/proc/meminfo

/proc/net/bond*

执行命令产生的信息

sysctl -a 的结果

ps的结果

top的结果

ipcs的结果

netstat -in的结果

netstat -apn的结果

netstat -gn的结果

netstat -m的结果

ifconfig的结果

ip addr的结果

ip -s l的结果

df的结果

raw -qa的结果

journalctl -e 的结果

由于该信息作为日志收集的默认收集信息进行采集,因此无须单独采集。

2.8. 反映配置信息,备份配置信息 (clpcfctrl 命令)¶

2.8.1. 反映配置信息 (clpcfctrl --push)¶

在服务器上反映配置信息。

-

命令行 clpcfctrl --push -l|-w [-p portnumber] [-x directory] [--nocheck]

-

说明 向服务器上反映Cluster WebUI创建的配置信息。

-

选项 -

--push¶ - 反映时指定。不能省略。

-

-l¶ - 在Linux上使用通过Cluster WebUI保存的配置信息时指定。不能与-w同时指定。

-

-w¶ - Windows上使用通过Cluster WebUI保存的配置信息时指定。不能与-l同时指定。

-

-pportnumber¶ - 指定数据发送端口的端口号。省略时使用初始值。一般无需指定。

-

-xdirectory¶ - 反映指定目录下的配置信息时指定。与-l或者-w一同使用。指定-l时,使用Linux上通过Cluster WebUI保存在文件系统上的配置信息。指定-w时,使用Windows上通过Cluster WebUI保存的配置信息。

-

--nocheck¶ 不执行集群配置信息的检查。只在服务器删除时使用。平时请不要使用。

-

-

返回值 0

成功

0以外

异常

-

注意事项 请以拥有root权限的用户身份执行该命令。

-

执行示例 例1: 在Linux上使用Cluster WebUI发送文件系统上保存的配置信息时

# clpcfctrl --push -l -x /mnt/config file delivery to server 127.0.0.1 success. The upload is completed successfully.(cfmgr:0) Command succeeded.(code:0)

-

错误消息 消息

原因/处理方法

Log in as root.

请以拥有root权限的用户身份执行该命令。

This command is already run.

本命令已经启动。

Invalid option.

选项非法。请确认选项。

Invalid mode.Check if --push or --pull option is specified.请确认是否已指定--pull。The target directory does not exist.

制定的目录不存在。

Invalid host name.Server specified by -h option is not included in the configuration data.使用-h指定的服务器不包含配置信息。请确认指定的服务器名或者IP地址是否正确。Canceled.

在命令的查询中输入"y"以外的值时显示。

Failed to initialize the xml library.Check if memory or OS resources are sufficient.内存不足或者OS资源不足。请确认。

Failed to load the configuration file.Check if memory or OS resources are sufficient.内存不足或者OS资源不足。请确认。

Failed to change the configuration file.Check if memory or OS resources are sufficient.内存不足或者OS资源不足。请确认。

Failed to load the all.pol file.Reinstall the RPM.请重新安装EXPRESSCLUSTER服务器RPM。Failed to load the cfctrl.pol file.Reinstall the RPM.请重新安装EXPRESSCLUSTER服务器RPM。Failed to get the install path.Reinstall the RPM.请重新安装EXPRESSCLUSTER服务器RPM。Failed to get the cfctrl path.Reinstall the RPM.请重新安装EXPRESSCLUSTER服务器RPM。Failed to get the list of group.

组列表取得失败。

Failed to get the list of resource.

资源列表取得失败。

Failed to initialize the trncl library.Check if memory or OS resources are sufficient.内存不足或者OS资源不足。请确认。Failed to connect to server %1.Check if the other server is active and then run the command again.与服务器连接失败。请确认是否已启动其他服务器。请启动服务器后再执行命令。Failed to connect to trnsv.Check if the other server is active.与服务器连接失败。请确认是否已启动其他服务器。File delivery failed.Failed to deliver the configuration data. Check if the other server is active and run the command again.发送配置信息失败。请确认是否已启动其他服务器。请启动服务器后再执行命令。Multi file delivery failed.Failed to deliver the configuration data. Check if the other server is active and run the command again.发送配置信息失败。请确认是否已启动其他服务器。请启动服务器后再执行命令。Failed to deliver the configuration data.Check if the other server is active and run the command again.发送配置信息失败。请确认是否已启动其他服务器。请启动服务器后再执行命令。The directory "/work" is not found.Reinstall the RPM.请重新安装EXPRESSCLUSTER服务器RPM。Failed to make a working directory.

内存不足或者OS资源不足。请确认。

The directory does not exist.

内存不足或者OS资源不足。请确认。

This is not a directory.

内存不足或者OS资源不足。请确认。

The source file does not exist.

内存不足或者OS资源不足。请确认。

The source file is a directory.

内存不足或者OS资源不足。请确认。

The source directory does not exist.

内存不足或者OS资源不足。请确认。

The source file is not a directory.

内存不足或者OS资源不足。请确认。

Failed to change the character code set (EUC to SJIS).

内存不足或者OS资源不足。请确认。

Failed to change the character code set (SJIS to EUC).

内存不足或者OS资源不足。请确认。

Command error.

内存不足或者OS资源不足。请确认。

Failed to initialize the cfmgr library.Check if memory or OS resources are sufficient.内存不足或者OS资源不足。请确认。Failed to get size from the cfmgr library.Check if memory or OS resources are sufficient.内存不足或者OS资源不足。请确认。Failed to allocate memory.

内存不足或者OS资源不足。请确认。

Failed to change the directory.

内存不足或者OS资源不足。请确认。

Failed to run the command.

内存不足或者OS资源不足。请确认。

Failed to make a directory.

内存不足或者OS资源不足。请确认。

Failed to remove the directory.

内存不足或者OS资源不足。请确认。

Failed to remove the file.

内存不足或者OS资源不足。请确认。

Failed to open the file.

内存不足或者OS资源不足。请确认。

Failed to read the file.

内存不足或者OS资源不足。请确认。

Failed to write the file.

内存不足或者OS资源不足。请确认。

Internal error.Check if memory or OS resources are sufficient.内存不足或者OS资源不足。请确认。The upload is completed successfully.To apply the changes you made, shutdown and reboot the cluster.上载成功。要反映变动,请执行服务器的关机,重启。The upload was stopped.To upload the cluster configuration data, stop the cluster.上载停止。要上载配置信息,请停止服务器。The upload was stopped.To upload the cluster configuration data, stop the Mirror Agent.上载停止。要上载配置信息,请停止镜像Agent。The upload was stopped.To upload the cluster configuration data, stop the resources to which you made changes.上载停止。要上载配置信息,请停止增加变动的资源。The upload was stopped.To upload the cluster configuration data, stop the groups to which you made changes.上载停止。要上载配置信息,需要挂起服务器。为了上载,请停止增加变动的组。The upload was stopped.To upload the cluster configuration data, suspend the cluster.上载停止。要上载配置信息,需要挂起服务器。请停止增加变动的组。The upload is completed successfully.To apply the changes you made, restart the Alert Sync.To apply the changes you made, restart the WebManager.上载成功。要反映配置信息,请重启AlertSync服务。要反映配置信息,请重新启动WebManager服务。Internal error.Check if memory or OS resources are sufficient.内存不足或者OS资源不足。请确认。The upload is completed successfully.

上载成功。

The upload was stopped.Failed to deliver the configuration data.Check if the other server is active and run the command again.上载停止。发送配置信息失败。请确认其他服务器的启动状态,重新执行命令。The upload was stopped.There is one or more servers that cannot be connected to.To apply cluster configuration information forcibly, run the command again with "--force" option.上载停止。存在无法连接的服务器。要强行上载配置信息,请指定—force选项,再重新执行命令。

2.8.2. 备份配置信息 (clpcfctrl --pull)¶

备份配置信息。

-

命令行 clpcfctrl --pull -l|w [-p portnumber] [-x directory]

-

说明 为了在Cluster WebUI上使用,备份集群配置信息。

-

选项 -

--pull¶ - 备份时指定。不能省略。

-

-l¶ - 作为Linux上的Cluster WebUI使用的配置信息备份时指定。不能与-w同时指定。

-

-w¶ - 作为Windows上的Cluster WebUI使用的配置信息备份时指定。不能与-l同时指定。

-

-pportnumber¶ - 指定数据发送端口的端口号。省略时使用初始值。一般无需指定。

-

-xdirectory¶ - 在指定目录下备份配置信息。与-l或者-w一同使用。指定-l时,作为Linux上使用Cluster WebUI所能读取的配置信息备份。指定-w时,作为Windows上使用Cluster WebUI所能写入的配置信息保存。

-

-

返回值 0

成功

0以外

异常

-

注意事项 请以拥有root权限的用户身份执行该命令。

-

执行示例 例1: Linux 上的Cluster WebUI为了将读取的配置信息备份到指定目录上时

# clpcfctrl --pull -l -x /mnt/config Command succeeded.(code:0)

-

错误消息 消息

原因/处理方法

Log in as root.

请以拥有root权限的用户身份执行该命令。

This command is already run.

已启动。

Invalid option.

选项非法。请确认选项。

Invalid mode.Check if --push or --pull option is specified.请确认是否已指定--push。The target directory does not exist.

不存在指定的目录。

Canceled.

在命令的查询中输入"y"以外的值时显示。

Failed to initialize the xml library.Check if memory or OS resources are sufficient.内存不足或者OS资源不足。请确认。

Failed to load the configuration file.Check if memory or OS resources are sufficient.内存不足或者OS资源不足。请确认。

Failed to change the configuration file.Check if memory or OS resources are sufficient.内存不足或者OS资源不足。请确认。

Failed to load the all.pol file.Reinstall the RPM.请重新安装EXPRESSCLUSTER服务器RPM。

Failed to load the cfctrl.pol file.Reinstall the RPM.请重新安装EXPRESSCLUSTER服务器RPM。Failed to get the install path.Reinstall the RPM.请重新安装EXPRESSCLUSTER服务器RPM。Failed to get the cfctrl path.Reinstall the RPM.请重新安装EXPRESSCLUSTER服务器RPM。Failed to initialize the trncl library.Check if memory or OS resources are sufficient.内存不足或者OS资源不足。请确认。

Failed to connect to server %1.Check if the other server is active and then run the command again.与服务器连接失败。请确认是否已启动其他服务器。请启动服务器后再执行命令。Failed to connect to trnsv.Check if the other server is active.与服务器连接失败。请确认是否已启动其他服务器。Failed to get configuration data.Check if the other server is active.配置信息获取失败。请确认是否已启动其他服务器。The directory "/work" is not found.Reinstall the RPM.请重新安装EXPRESSCLUSTER服务器RPM。Failed to make a working directory.

内存不足或者OS资源不足。请确认。

The directory does not exist.

内存不足或者OS资源不足。请确认。

This is not a drirectory.

内存不足或者OS资源不足。请确认。

The source file does not exist.

内存不足或者OS资源不足。请确认。

The source file is a directory.

内存不足或者OS资源不足。请确认。

The source directory does not exist.

内存不足或者OS资源不足。请确认。

The source file is not a directory.

内存不足或者OS资源不足。请确认。

Failed to change the character code set (EUC to SJIS).

内存不足或者OS资源不足。请确认。

Failed to change the character code set (SJIS to EUC).

内存不足或者OS资源不足。请确认。

Command error.

内存不足或者OS资源不足。请确认。

Failed to initialize the cfmgr library.Check if memory or OS resources are sufficient.内存不足或者OS资源不足。请确认。Failed to get size from the cfmgr library.Check if memory or OS resources are sufficient.内存不足或者OS资源不足。请确认。Failed to allocate memory.

内存不足或者OS资源不足。请确认。

Failed to change the directory.

内存不足或者OS资源不足。请确认。

Failed to run the command.

内存不足或者OS资源不足。请确认。

Failed to make a directory.

内存不足或者OS资源不足。请确认。

Failed to remove the directory.

内存不足或者OS资源不足。请确认。

Failed to remove the file.

内存不足或者OS资源不足。请确认。

Failed to open the file.

内存不足或者OS资源不足。请确认。

Failed to read the file.

内存不足或者OS资源不足。请确认。

Failed to write the file.

内存不足或者OS资源不足。请确认。

Internal error.Check if memory or OS resources are sufficient.内存不足或者OS资源不足。请确认。

2.9. 超时临时调整命令 (clptoratio 命令)¶

延长,显示当前的超时倍率。

-

命令行 - clptoratio -r ratio -t timeclptoratio -iclptoratio -s

-

说明 暂时延长下列各种超时值。

监视资源

心跳资源

警报同步服务

WebManager 服务

显示当前超时倍率。

-

选项 -

-rratio¶ - 指定超时倍率。请设置为大于等于1的整数值。最大超时倍率为10000倍。如果指定"1",则与-i选项一样,可将已更改的超时倍率还原。

-

-ttime¶ - 指定延长期间。可指定分m,小时h,日d。最大延长期间为30日。例)2m,3h,4d

-

-i¶ 还原更改的超时倍率。

-

-s¶ 参考当前的超时倍率。

-

-

返回值 0

成功

0 以外

异常

-

注意事项 - 请以拥有root权限的用户身份执行该命令。请在启动了服务器的EXPRESSCLUSTER Daemon的状态下执行。设置超时倍率时,请务必指定延长期间。但如果超时倍率指定为"1",则无法指定延长期间。指定延长期间时不能指定为"2m3h"等组合。

-

执行示例 例1: 将超时倍率设为3天2倍时

# clptoratio -r 2 -t 3d

例2: 还原超时倍率时

# clptoratio -i

例3: 参考当前超时倍率时

# clptoratio -s present toratio : 2

即可知当前的超时倍率为2。

-

错误消息 消息

原因/处理方法

Log in as root.

请以拥有root权限的用户身份执行该命令。

Invalid configuration file. Create valid cluster configuration data.

请在Cluster WebUI中作成正确的集群配置信息。

Invalid option.

请指定正确的选项。

Specify a number in a valid range.

请在正确的范围内指定数字。

Specify a correct number.

请指定正确的数字。

Scale factor must be specified by integer value of 1 or more.

请将倍率指定为1以上的整数值。

Specify scale factor in a range less than the maximum scale factor.

请在不超越最大倍率的范围内指定倍率。

Set the correct extension period.

请设置正确的延长期间。

Ex) 2m, 3h, 4d

请在不超越最大延长期间的范围内设置延长时间。

Set the extension period in a range less than the maximum extension period.

请确认EXPRESSCLUSTER Daemon是否启动。

Could not connect to the server. Check if the cluster daemon is active.

请确认EXPRESSCLUSTER Daemon是否启动。

Server is not active. Check if the cluster daemon is active.

请确认集群内是否存在EXPRESSCLUSTER Daemon停止的服务器。

Connection was lost. Check if there is a server where the cluster daemon is stopped in the cluster.

请确认集群内是否存在EXPRESSCLUSTER Daemon停止的服务器。

Invalid parameter.

命令参数中可执行设置了错误的值。

Internal communication timeout has occurred in the cluster server. If it occurs frequently, set the longer timeout.

EXPRESSCLUSTER内部通信发生超时。如果频繁发生超时,请延长内部通信超时时间。

Processing failed on some servers. Check the status of failed servers.

存在处理失败的服务器。请确认集群内服务器的状态。在集群内所有服务器都为启动状态下执行。Internal error. Check if memory or OS resources are sufficient.

可执行是内存不足或者OS资源不足。请确认。

2.10. 日志级别/大小更改命令 (clplogcf 命令)¶

更改和显示日志级别,日志输出文件大小的设置。

-

命令行 clplogcf -t type -l level -s size

-

说明 - 更改日志级别,日志输出文件大小的设置。显示当前的设置值。

-

选项 -

-ttype¶ - 指定要更改设置的模块类型。省略-l或-s时,显示指定的模块类型中设置的信息。可指定的类型请参考"日志级别/大小更改命令 (clplogcf 命令)"表。

-

-llevel¶ - 指定日志级别。可指定的日志级别如下。1,2,4,8,16,32数值越大输出的日志越详细。

-

-ssize¶ - 指定要输出日志的文件的大小。单位是byte。

-

无¶ 显示当前设置的所有信息。

-

-

返回值 0

成功

0以外

异常

-

备注 EXPRESSCLUSTER输出的日志在各类型上使用 4个日志文件。因此需要4 倍于-s 所指定的磁盘容量。

-

注意事项 - 请以拥有root权限的用户身份执行该命令。执行本命令需要EXPRESSCLUSTER事件服务处于运行状态。服务器重启的话设定会被恢复为原来到设置。

-

执行示例 例1: 更改pm的日志级别时

# clplogcf -t pm -l 8

例2: 参考pm的日志级别,日志文件大小时

# clplogcf -t pm TYPE, LEVEL, SIZE pm, 8, 1000000

例3: 显示当前的设置值

# clplogcf TYPE, LEVEL, SIZE trnsv, 4, 1000000 xml, 4, 1000000 logcf, 4, 1000000

-

错误消息 消息

原因/处理方法

Log in as root.

请用root用户执行。

Invalid option.

选项无效。请确认选项。

Failed to change the configuration. Check if clpevent is running.

可执行clpevent未启动。

Invalid level

指定的级别无效。

Invalid size

指定的大小无效。

Failed to load the configuration file. Check if memory or OS resources are sufficient.

未被生成的服务器。

Failed to initialize the xml library. Check if memory or OS resources are sufficient.

可执行是内存不足或OS资源不足。请确认。

Failed to print the configuration. Check if clpevent is running.

可执行clpevent未启动。

-t选项中可指定的类型

类型

模块

说明

本体

apicl

libclpapicl.so.1.0

API客户端库

✓

apisv

libclpapisv.so.1.0

API服务器

✓

bmccnf

clpbmccnf

BMC信息更新命令

✓

cl

clpcl

启动,停止命令

✓

cfctrl

clpcfctrl

生成,信息备份命令

✓

cfmgr

libclpcfmgr.so.1.0

配置信息操作库

✓

cpufreq

clpcpufreq

CPU频率控制命令

✓

grp

clpgrp

组启动,停止命令

✓

rsc

clprsc

组资源启动,停止命令

✓

haltp

clpuserw

关机停止(stall)监视

✓

healthchk

clphealthchk

进程健全性确认命令

✓

ibsv

clpibsv

Information Base 服务器

✓

lcns

libclplcns.so.1.0

License库

✓

lcnsc

clplcnsc

License登录命令

✓

logcc

clplogcc

日志收集命令

✓

logcf

clplogcf

日志级别,大小更改命令

✓

logcmd

clplogcmd

警报输出命令

✓

clpmail

Mail通告

✓

mgtmib

libclpmgtmib.so.1.0

SNMP 联动库

✓

monctrl

clpmonctrl

监视控制命令

✓

nm

clpnm

节点图管理

✓

pm

clppm

进程管理

✓

rc/rc_ex

clprc

组,组资源管理

✓

reg

libclpreg.so.1.0

重启次数控制库

✓

regctrl

clpregctrl

重启次数控制命令

✓

rm

clprm

监视器管理

✓

roset

clproset

磁盘控制

✓

relpath

clprelpath

进程强行结束命令

✓

scrpc

clpscrpc

脚本日志轮询执行命令

✓

stat

clpstat

状态显示命令

✓

stdn

clpstdn

服务器关机命令

✓

toratio

clptoratio

超时倍率更改命令

✓

trap

clptrap

SNMP Trap发送命令

✓

trncl

libclptrncl.so.1.0

事务库

✓

rexec

clprexec

外部监视联动处理请求命令

✓

trnsv

clptrnsv

事务服务器

✓

volmgrc

clpvolmgrc

VxVM磁盘组 import/deport命令

✓

alert

clpaltinsert

警报

✓

webmgr

clpwebmc

WebManager服务

✓

webalert

clpaltd

警报同步

✓

exec

clpexec

EXEC资源

✓

vm

clpvm

VM资源

✓

diskw

clpdiskw

磁盘监视资源

✓

ipw

clpipw

IP监视资源

✓

miiw

clpmiiw

NIC Link Up/Down监视资源

✓

mtw

clpmtw

Multi-Target监视资源

✓

pidw

clppidw

PID监视资源

✓

volmgrw

clpvolmgrw

卷管理器监视资源

✓

userw

clpuserw

用户空间监视资源

✓

vmw

clpvmw

VM监视资源

✓

mrw

clpmrw

消息接收监视资源

✓

snmpmgr

libclp snmpmgr

SNMP Trap接收库

✓

lanhb

clplanhb

LAN心跳

✓

oraclew

clp_oraclew

Oracle监视资源

✓

db2w

clp_db2w

DB2监视资源

✓

psqlw

clp_psqlw

PostgreSQL监视资源

✓

mysqlw

clp_mysqlw

MySQL监视资源

✓

sybasew

clp_sybasew

Sybase监视资源

✓

odbcw

clp_odbcw

ODBC监视资源

✓

sqlserverw

clp_sqlserverw

SQL Server监视资源

✓

sambaw

clp_sambaw

Samba监视资源

✓

nfsw

clp_nfsw

NFS监视资源

✓

httpw

clp_httpw

HTTP监视资源

✓

ftpw

clp_ftpw

FTP监视资源

✓

smtpw

clp_smtpw

SMTP监视资源

✓

pop3w

clp_pop3w

POP3监视资源

✓

imap4w

clp_imap4w

IMAP4监视资源

✓

tuxw

clp_tuxw

Tuxedo监视资源

✓

wlsw

clp_wlsw

WebLogic监视资源

✓

wasw

clp_wasw

WebSphere监视资源

✓

otxw

clp_otxw

WebOTX监视资源

✓

jraw

clp_jraw

JVM 监视资源

✓

sraw

clp_sraw

系统监视资源

✓

psrw

clp_psrw

进程资源监视资源

✓

psw

Clppsw

进程名监视资源

✓

vmctrl

libclpvmctrl.so.1.0

VMCTRL库

✓

vmwcmd

clpvmwcmd

VMW 命令

✓

perfc

clpperfc

集群统计信息显示命令

✓

cfchk

clpcfchk

集群配置信息检查命令

✓

2.11. License管理命令 (clplcnsc 命令)¶

进行License的管理。

-

命令行: - clplcnsc -i [licensefile...]clplcnsc -l [-a]clplcnsc -d serialno [-q]clplcnsc -d -t [-q]clplcnsc -d -a [-q]clplcnsc --reregister licensefile...

-

说明 进行本产品的产品版/试用版License的登录,参照,删除。

-

选项 -

-i[licensefile...]¶ 如果指定License文件,则通过该文件获取并登录License信息。可以指定多个License文件。如果不指定,则通过交互方式输入并登录License信息。

-

-l[-a]¶ 浏览注册的License。显示的项目如下所示。

项目名

说明

Serial No

序列号(只适用产品版)

User name

用户名(只适用试用版)

Key

License Key

Licensed Number of CPU

License许可数(CPU个数)

Licensed Number of Computers

License许可数(节点个数)

Start date

End date

Status

License的状态

License的状态

状态

说明

valid

有效

invalid

无效

unknown

未知

inactive

expired

未指定-a选项时,不显示状态为invalid,unknown, expired的License。指定-a选项时,无论License的状态如何,显示全部的License。

-

-d<param>¶ param

- serialno

删除指定序列号的License。

- -t

删除已注册的全部试用版License。

- -a

删除已注册的全部License。

-

-q¶ 删除License时不显示确认信息。请与-d选项一起指定。

-

--reregisterlicensefile...¶ 请重新注册期间定制License。一般不需要执行该选项命令。

-

-

返回值 0

正常结束

1

取消

3

初始化错误

5

选项无效

8

其它内部错误

-

执行示例 注册 交互方式

# clplcnsc -i

产品版,期间定制版

选择产品区分

Selection of License Version 1. Product Version 2. Trial Version e. Exit Select License Version. [1, 2, or e (default:1)]...

输入序列号

Enter serial number [ Ex. XXXXXXXX000000 ] ...

输入License key

Enter license key [ Ex. XXXXXXXX-XXXXXXXX-XXXXXXXX-XXXXXXXX] ...

试用版

选择产品区分

Selection of License Version 1. Product Version 2. Trial Version e. Exit Select License Version. [1, 2, or e (default:1)]...

输入用户名

Enter user name [ 1 to 63byte ]...

输入License key

Enter license key [Ex. XXXXX-XXXXXXXX-XXXXXXXX-XXXXXXXX]...

指定License文件

# clplcnsc -i /tmp/cpulcns.key

浏览

# clplcnsc -l

产品版

< EXPRESSCLUSTER X SingleServerSafe <PRODUCT> > Seq... 1 Key..... A1234567-B1234567-C1234567-D1234567 Licensed Number of CPU... 2 Status... valid Seq... 2 Serial No..... AAAAAAAA000002 Key..... E1234567-F1234567-G1234567-H1234567 Licensed Number of Computers... 1 Status... valid

期间定制版

< EXPRESSCLUSTER X SingleServerSafe <PRODUCT> > Seq... 1 Serial No..... AAAAAAAA000001 Key..... A1234567-B1234567-C1234567-D1234567 Start date..... 2018/01/01 End date...... 2018/01/31 Status........... valid Seq... 2 Serial No..... AAAAAAAA000002 Key..... E1234567-F1234567-G1234567-H1234567 Status........... inactive

试用版

< EXPRESSCLUSTER X SingleServerSafe <TRIAL> > Seq... 1 Key..... A1234567-B1234567-C1234567-D1234567 User name... NEC Start date..... 2018/01/01 End date...... 2018/02/28 Status........... valid

删除

# clplcnsc -d AAAAAAAA000001 -q

删除

# clplcnsc -d -t -q

删除

# clplcnsc -d -a

删除确认

Are you sure to remove the license? [y/n] ...

-

注意事项 - 请以拥有root权限的用户身份执行该命令。使用-d选项时,同时指定-a选项,试用版License和产品版License将被全部删除。仅删除试用版License时,请并用-t选项。如果删除了产品版License时,请重新注册产品版License。浏览License时,如果License中包含多个License,它们将分别显示。

-

错误消息 消息

原因/处理方法

Processed license num(success : %d, error : %d).处理的License数(成功: %d, 失败: %d)失败数不为0时,说明某种原因下处理License失败。请确认License信息是否正确。Command succeeded.

命令成功。

Command failed.

命令失败。

Log in as root.

无执行命令的权限。请用有root权限的用户执行。

Invalid cluster configuration data. Check the cluster configuration information.

集群配置信息无效。请使用Cluster WebUI确认集群配置信息。

Initialization error. Check if memory or OS resources are sufficient.

初始化失败。可执行是内存不足或OS资源不足。请确认。

The command is already run.

命令已经执行。请用ps命令等确认执行状态。

The license is not registered.

未注册License。请注册License。

Could not opened the license file. Check if the license file exists on the specified path.Could not read the license file. Check if the license file exists on the specified path.无法向License文件进行I/O。请确认License文件是否存在于指定的路径。The field format of the license file is invalid. The license file may be corrupted. Check the destination from where the file is sent.

License文件的域格式无效。可执行License文件有破损。请确认文件的发送源。

The cluster configuration data may be invalid or not registered.

可执行是集群配置信息无效或未被登录。请确认。

Failed to terminate the library. Check if memory or OS resources are sufficient.

可执行是内存不足或OS资源不足。请确认。

Failed to register the license. Check if the entered license information is correct.Failed to open the license. Check if the entered license information is correct.请确认输入的License信息是否正确。Failed to remove the license.

删除License失败。可执行是参数错误或内存不足或OS资源不足。请确认。

This license is already registered.

该License已注册。请确认已注册的License。

This license is already activated.

该License已经被使用。请确认已注册的License。

This license is unavailable for this product.

该License不适用于该产品。请确认License。

The maximum number of licenses was reached.

已达到可以注册的最大License数。请删除到期的License。

Internal error. Check if memory or OS resources are sufficient.

可执行是内存不足或OS资源不足。请确认。

2.12. 消息输出命令 (clplogcmd 命令)¶

将指定的消息登录syslog,警报日志或者mail通告的命令。

-

命令行 clplogcmd -m message [--syslog] [--alert] [--mail] [-i eventID] [-l level]

注解

一般在 服务器的构筑和操作中不必要执行该命令。该命令是在EXEC资源的脚本中描述后使用的命令。

-

说明 在EXEC资源的脚本中描述,将任意的消息输出到输出目标。

-

选项 -

-

--syslog¶

-

--alert¶

-

--mail¶

-

--trap¶ - 从syslog,alert,mail,trap中指定输出目标(可指定多个。)。该参数可省略。省略时,输出目标是syslog和alert。

-

-ieventID¶ - 指定事件ID。事件ID的最大值是10000。该参数可省略。省略时,eventID被设为1。

-

-llevel¶ - 指输出警报的级别。指定ERR,WARN,INFO中的任意一个。通过该级别指定Cluster WebUI上的警报日志的图标。该参数可省略。省略时,level被设为INFO。详细信息请参考在线版手册。

-

-

返回值 0

成功

0 以外

异常

-

注意事项 - 请以拥有root权限的用户身份执行该命令。输出目标中指定mail时,请进行可用mail命令发送mail的设置。

-

执行示例 - 例1: 只指定消息时(输出目标syslog,alert)EXEC资源的脚本中进行了以下描述时,往syslog,alert中输出消息。

clplogcmd -m test1

syslog中输出以下日志。

Sep 1 14:00:00 server1 clusterpro: <type: logcmd><event: 1> test1

例2: 指定消息,输出目标,事件ID,级别时(输出目标 mail)EXEC资源的脚本中进行了以下描述时,消息被发送到Cluster WebUI的集群的属性中设置的邮件地址。clplogcmd -m test2 --mail -i 100 -l ERR

以下内容的邮件被发送到mail的发送目标。

Message:test2 Type: logcmd ID: 100 Host: server1 Date: 2018/09/01 14:00:00

例3: 指定消息,输出目标,事件ID,级别时(输出目标trap)EXEC资源的脚本中进行了以下描述时,消息被发送到Cluster WebUI集群的属性中设置的SNMP Trap 发送目标。clplogcmd -m test3 --trap -i 200 -l ERR

以下内容的SNMP Trap被发送到SNMP Trap的发送目标。

Trap OID: clusterEventError添付数据1: clusterEventMessage = test3添付数据2: clusterEventID = 200添付数据3: clusterEventDateTime = 2011/08/01 09:00:00添付数据4: clusterEventServerName = server1添付数据5: clusterEventModuleName = logcmd

- 3

消息中含有记号时的注意事项如下。

需要用""括起来的记号

# & ' ( ) ~ | ; : * < > , .(例 在消息中指定"#"时,输出#。)需要在前面加\的记号

\ ! " & ' ( ) ~ | ; : * < > , .(例 在消息中指定\\时,输出\。)需要用""括起来,且前面需要加上\的记号

`(例 在消息中指定"\ `"时,输出`。)

消息中含有空格时,需要用""括起来。

消息中不能使用%。

2.13. 控制监视资源 (clpmonctrl 命令)¶

控制监视资源。

-

命令行 - clpmonctrl -s [-m resource_name] [-w wait_time]clpmonctrl -r [-m resource_name] [-w wait_time]clpmonctrl -c [-m resource_name]clpmonctrl -v [-m resource_name]clpmonctrl -e -m resource_nameclpmonctrl -n [-m resource_name]

-

说明 暂停/重新启动监视资源。

-

选项 -

-s¶ 暂停监视。

-

-r¶ 重新启动监视。

-

-c¶ 复位复原操作次数的计数器。

-

-v¶ 显示复原操作次数的计数器。

-

-e¶ 将障碍验证功能设为有效。请务必使用-m选项指定监视资源名。

-

-n¶ 将障碍验证功能设为无效。请务必使用-m选项指定监视资源名,此时只有该资源属于对象。省略-m选项时,所有监视资源属于对象。

-

-mresource_name¶ - 指定要控制的监视资源。可省略。省略时对所有监视资源进行控制。

-

-wwait_time¶ - 以监视资源为单位等待监视控制。(秒)可省略。省略时的默认值是5秒。

-

-

返回值 0

正常结束

1

执行权限非法

2

选项非法

3

初始化错误

4

配置信息非法

5

监视资源未登录

6

指定监视资源非法

10

EXPRESSCLUSTER未启动状态

11

EXPRESSCLUSTER Daemon挂起状态

90

监视控制等待超时

128

二重启动

255

其它内部错误

-

执行示列 例1: 暂停所有的监视资源时

# clpmonctrl -s Command succeeded.

例2: 重新启动所有的监视资源时

# clpmonctrl -r Command succeeded.

-

备注 对已经暂停的监视资源进行暂停或者对已经启动的监视资源进行重新启动操作时,本命令异常结束,监视资源状态不变化。

-

注意事项 - 请以拥有root权限的用户身份执行该命令。监视资源的状态通过状态显示命令或Cluster WebUI确认。请通过clpstat命令或Cluster WebUI确认监视资源的状态处于"已启动"或"暂停"后执行。监视资源的恢复动作设置为如下内容时,通过-v选项显示的"FinalAction Count"显示"最终动作前脚本"的执行次数。

最终动作前执行脚本: 有效

最终动作: "不操作"

-

错误消息 消息

原因/处理

Command succeeded.

命令成功。

Log in as root.

无执行命令的权限。请使用有root权限的用户执行。

Initialization error. Check if memory or OS resources are sufficient.

可执行是内存不足或OS资源不足。请确认。

Invalid cluster configuration data. Check the cluster configuration information.

集群配置信息无效。请使用Cluster WebUI确认集群配置信息。

Monitor resource is not registered.

监视资源未被登录。

Specified monitor resource is not registered. Check the cluster configuration information.指定的监视资源未被登录。请使用Cluster WebUI确认集群配置信息。The cluster has been stopped. Check the active status of the cluster daemon by using the command such as ps command.集群处于停止状态。请用ps命令等确认EXPRESSCLUSTER Daemon的启动状态。The cluster has been suspended. The cluster daemon has been suspended. Check activation status of the cluster daemon by using a command such as the ps command.

EXPRESSCLUSTER Daemon处于挂起状态。请用ps命令等确认EXPRESSCLUSTER Daemon的启动状态。

Waiting for synchronization of the cluster. The cluster is waiting for synchronization. Wait for a while and try again.集群处于同步等待状态。请在集群同步等待结束后再次执行。Monitor %1 was unregistered, ignored. The specified monitor resources %1 is not registered, but continue processing. Check the cluster configuration data.

有未登录到指定监视资源的监视资源,但可以忽略继续进行处理。请使用Cluster WebUI确认集群配置信息。%1:监视资源名Monitor %1 denied control permission, ignored. but continue processing.在指定的监视资源中存在无法控制的监视资源,请忽略,继续处理。%1:监视资源名This command is already run.

命令已经执行。请用ps 命令等确认执行状态。

Internal error. Check if memory or OS resources are sufficient.

可执行是内存不足或OS资源不足。请确认。

可指定-m选项的监视资源类型

diskw

✓

✓

✓

ipw

✓

✓

✓

miiw

✓

✓

✓

mtw

✓

✓

✓

pidw

✓

✓

✓

volmgrw

✓

✓

✓

userw

✓

✓

n/a

vmw

✓

✓

n/a

mrw

✓

✓

n/a

genw

✓

✓

✓

oraclew

✓

✓

✓

db2w

✓

✓

✓

psqlw

✓

✓

✓

mysqlw

✓

✓

✓

sybasew

✓

✓

✓

odbcw

✓

✓

✓

sqlserverw

✓

✓

✓

sambaw

✓

✓

✓

nfsw

✓

✓

✓

httpw

✓

✓

✓

ftpw

✓

✓

✓

smtpw

✓

✓

✓

pop3w

✓

✓

✓

imap4w

✓

✓

✓

tuxw

✓

✓

✓

wlsw

✓

✓

✓

wasw

✓

✓

✓

otxw

✓

✓

✓

jraw

✓

✓

✓

sraw

✓

✓

✓

psrw

✓

✓

✓

psw

✓

✓

✓

2.14. 控制组资源 (clprsc命令)¶

执行组资源的控制。

-

命令行 - clprsc -s resource_name [-f] [--apito timeout]clprsc -t resource_name [-f] [--apito timeout]

-

说明 启动/停止组资源。

-

选择 -

-s¶ 启动组资源。

-

-t¶ 停止组资源。

-

-f¶ - 启动组资源时,启动指定的组资源所依赖的所有的组资源。停止组资源时,停止依赖指定组资源的所有组资源。

-

--apito¶ - 以秒为单位指定等待EXPRESSCLUSTER Damon的停止,重启,挂起的时间(内部通信超时)。可指定1-9999的值。不指定[--apito]选项时,按照集群属性的内部通信超时所设置的值,进行等待。

-

-

返回值 0

正常终止

0以外

异常终止

-

执行示例 组资源构成

# clpstat ========== CLUSTER STATUS ========== Cluster : cluster <server> server1 : Online lanhb1 : Normal lanhb2 : Normal <group> ManagementGroup : Online current : server1 ManagementIP : Online failover1 : Online current : server1 exec1 : Online <monitor> ipw1 : Normal ==================================例1:停止组failover1的资源exec1时

# clprsc -t exec1 Command succeeded. # clpstat ========== CLUSTER STATUS ========== <省略> <group> ManagementGroup: Online Current: server1 ManagementIP: Online failover1: Online current: server1 exec1: Offline <省略>

例2:启动组failover1的资源exec1时

# clprsc -s exec1 Command succeeded. # clpstat ========== CLUSTER STATUS ========== <省略> <group> ManagementGroup: Online Current: server1 ManagementIP: Online failover1: Online current: server1 exec1: Online <省略>

-

注意事项 - 请使用有root权限的用户执行该命令。组资源的状态,请通过状态显示命令或者Cluster WebUI确认。

-

错误消息 消息

原因/处理方法

Log in as root.

请使用有root权限的用户执行。

Invalid cluster configuration data. Check the cluster configuration information.

集群配置信息不正确。请通过Cluster WebUI确认集群配置信息。

Invalid option.

请使用正确的选项。

Could not connect server. Check if the cluster service is active.

请确认EXPRESSCLUSTER的服务是否已经启动。

Invalid server status. Check if the cluster service is active.

请确认EXPRESSCLUSTER的服务是否已经启动。

Server is not active. Check if the cluster service is active.

请确认EXPRESSCLUSTER的服务是否已经启动。

Invalid server name. Specify a valid server name in the cluster.

请指定集群内的正确的服务器名。

Connection was lost. Check if there is a server where the cluster service is stopped in the cluster.

请确认集群内是否有EXPRESSCLUSTER服务停止的服务器。

Internal communication timeout has occurred in the cluster server. If it occurs frequently, set the longer timeout.EXPRESSCLUSTER的内部通讯发生超时。如果频繁出现,请将内部通讯超时延长。The group resource is busy. Try again later.

由于组资源正处于启动处理过程中,或停止处理过程中,请稍等片刻再执行。

An error occurred on group resource. Check the status of group resource.

请使用Cluster WebUI或clpstat命令确认组资源状态。

Could not start the group resource. Try it again after the other server is started, or after the Wait Synchronization time is timed out.

等待其他服务器启动,或等待启动等待超时,启动组资源。

No operable group resource exists in the server.

请确认请求的服务器中是否有可以处理的组资源。

The group resource has already been started on the local server.

请使用Cluster WebUI或clpstat命令确认组资源状态。

The group resource has already been started on the other server.

请使用Cluster WebUI或clpstat命令确认组资源状态。通过本地服务器启动组资源时,请停止组。The group resource has already been stopped.

请使用Cluster WebUI或clpstat命令确认组资源状态。

Failed to start group resource. Check the status of group resource.

请使用Cluster WebUI或clpstat命令确认组资源状态。

Failed to stop resource. Check the status of group resource.

请使用Cluster WebUI或clpstat命令确认组资源状态。

Depended resource is not offline. Check the status of resource.

由于所依赖的组资源状态不是停止,无法停止组资源。请停止依赖的组资源或者指定-f选项。

Depending resource is not online. Check the status of resource.

由于所依赖的组资源状态不是启动,无法启动组资源。请启动依赖的组资源或者指定-f选项。

Invalid group resource name. Specify a valid group resource name in the cluster.

组资源未登录。

Server is not in a condition to start resource or any critical monitor error is detected.请使用Cluster WebUI或clpstat命令确认组资源状态。在准备启动组资源的服务器上检测出排除列表中包含的监视异常。Internal error. Check if memory or OS resources are sufficient.

可执行是由于内存不足或OS资源不足。请确认。

2.15. CPU频率控制命令 (clpcpufreq 命令)¶

进行CPU频率控制。

-

命令行 - clpcpufreq --highclpcpufreq --lowclpcpufreq -iclpcpufreq -s

-

说明 通过CPU频率控制,控制节能模式的有效/无效。

-

选项 -

--high¶ 将CPU频率数设置到最大。

-

--low¶ 降低CPU频率数设置为节能模式。

-

-i¶ 对CPU频率的控制返回到由EXPRESSCLUSTER X SingleServerSafe 控制。

-

-s¶ 显示当前的设置状态。

performance 将CPU频率数设置到最大。

powersave 降低CPU频率数设置为节能模式。

-

-

返回值 0

正常结束

0以外

异常结束

-

备注 - CPU频率控制用驱动器没有被负载时会出错。如果在服务器属性的节能设置中没有选中[使用CPU频率控制功能],则执行本命令会出错。

-

注意事项 - 请以拥有root权限的用户身份执行该命令。使用CPU频率控制功能时,可以在BIOS设置中变更CPU频率,CPU通过OS电源管理功能支持频率控制,以及内核必须对应。

-

错误消息 消息

原因/处理方法

Log in as root.

请以拥有root权限的用户身份执行该命令。

This command is already run.

该命令已经被执行。

Invalid option.

请指定正确的选项。

Invalid mode.Check if --high or --low or -i or -s option is spedified.请确认--high, --low, -l, -s其中一个选项已经被指定。Failed to initialize the xml library.Check if memory or OS resources are sufficient.内存不足或者OS资源不足。请确认。Failed to load the configuration file.Check if memory or OS resources are sufficient.内存不足或者OS资源不足。请确认。Failed to load the all.pol file.Reinstall the RPM.请重新安装EXPRESSCLUSTER服务器RPM。Failed to load the cpufreq.pol file.Reinstall the RPM.请重新安装EXPRESSCLUSTER服务器RPM。Failed to get the install path.Reinstall the RPM.请重新安装EXPRESSCLUSTER服务器RPM。Failed to get the cpufreq path.Reinstall the RPM.请重新安装EXPRESSCLUSTER服务器RPM。Failed to initialize the apicl library.Reinstall the RPM.内存不足或者OS资源不足。请确认。Failed to change CPU frequency settings.Check the BIOS settings and the OS settings.Check if the cluster is started.Check if the setting is configured so that CPU frequencycontrol is used.请确认BIOS和OS的设置。请确认是否已启动EXPRESSCLUSTER服务。请确认是否设置为使用CPU频率控制功能。Failed to acquire CPU frequency settings.Check the BIOS settings and the OS settings.Check if the cluster is started.Check if the setting is configured so that CPU frequencycontrol is used.请确认BIOS和OS的设置。请确认是否已启动EXPRESSCLUSTER服务。请确认是否设置为使用CPU频率控制功能。Internal error. Check if memory or OS resources are sufficient.

内存不足或者OS资源不足。请确认。

2.16. 集群间的处理请求命令 (clptrnreq 命令)¶

向服务器请求执行处理。

-

命令行 clptrnreq -t request_code -h IP [-r resource_name] [-s script_file] [-w timeout]

-

说明 向运行EXPRESSCLUSTER X SingleServerSafe的其他服务器及通过EXPRESSCLUSTER X配置集群的其他服务器发送指定的处理执行请求。

-

选项 -

-trequest_code¶ - 指定执行处理的Request Code。可以指定以下的Request Code。GRP_FAILOVER 组失效切换EXEC_SCRIPT 脚本执行

-

-hIP¶ - 通过IP地址指定发出处理执行请求的服务器。可以指定多个,用逗号隔开。可以指定的IP地址最大数为32。在Request Code中指定组失效切换时,请指定集群内所有服务器的IP地址。

-

-rresource_name¶ - 在Request Code中指定GRP_FAILOVER时,指定作为处理请求对象的服务器所属的资源名。指定了GRP_FAILOVER时,不可省略-r。

-

-sscript_file¶ - 在Request Code中指定EXEC_SCRIPT时,指定执行的脚本(Shell script或可执行文件等)文件名。必须在-h指定的各个服务器的EXPRESSCLUSTER安装目录下的work\trnreq目录中预先做成脚本。指定了EXEC_SCRIPT时,不可以省略-s。

-

-wtimeout¶ - 命令的超时值以秒为单位指定。超时值最小可以指定为5秒。如果没有指定-w选项,则脚本固定等待30秒。

-

-

返回值 0

正常结束

0以外

异常结束

-

注意事项 请以拥有root权限的用户身份执行该命令。

-

执行示例 例1: 让拥有其他集群的exec1资源的组失效切换时

# clptrnreq -t GRP_FAILOVER -h 10.0.0.1,10.0.0.2 -r exec1 Command succeeded.

例2: 在IP地址10.0.0.1的服务器中执行脚本scrpit1.sh时

# clptrnreq -t EXEC_SCRIPT -h 10.0.0.1 -s script1.sh Command Succeeded.

-

错误消息 消息

原因/处理方法

Log in as root.

请以拥有root权限的用户身份执行该命令。

Invalid option.

命令行选项不正确。请指定正确的选项。

Could not connect to the data transfer server.Check if the server has started up.请确认是否启动服务器。Could not connect to all data transfer server.Check if the server has started up.请确认是否启动集群内所有的服务器。Command timeout.

考虑OS负荷等原因。请确认。

All server are busy. Check if this command is already run.

可执行已经执行本命令。请确认。

GRP_FAILOVER %s : Group that specified resource(%s) belongs to is offline.

被指定的资源所属组因为处于停止状态,失效切换处理不能进行。

EXEC_SCRIPT %s : Specified script(%s) does not exist.

指定的脚本不存在。请确认。

EXEC_SCRIPT %s : Specified script(%s) does not executable.

指定的脚本不能执行。请确认是否具有执行权限。

%s %s : This server is not permitted to execute clptrnreq.

执行命令的服务器没有执行权限。请确认是否被登录到Cluster WebUI的连接限制IP一览表中。

GRP_FAILOVER %s : Specified resource(%s) is not exist.

指定的资源不存在。请确认。

%s %s : %s failed in execute..

执行指定的处理失败。

Internal error. Check if memory or OS resource is sufficient.

内存不足或者OS资源不足。请确认。

2.17. 请求集群服务器处理 (clprexec命令)¶

要求安装了EXPRESSCLUSTER的其他服务器处理执行。

-

命令行 - clprexec --failover [group_name] -h IP [-r resource_name] [-w timeout] [-p port_number] [-o logfile_path]clprexec --script script_file -h IP [-p port_number] [-w timeout] [-o logfile_path]clprexec --notice [mrw_name] -h IP[-k category[.keyword]] [-p port_number] [-w timeout] [-o logfile_path]clprexec --clear [mrw_name] -h IP [-k category[.keyword]] [-p port_number] [-w timeout] [-o logfile_path]

-

说明 是在原有clptrnreq命令中添加了外部监视向EXPRESSCLUSTER服务器发出处理请求等功能(出现异常通知)的命令。

-

选项 -

--failover¶ 执行组失效切换请求。请在group_name中指定组名。

省略组名时,请使用-r选项指定组所属资源名。

-

--scriptscript_name¶ 请求执行脚本。

在scirpt_name中指定要执行脚本(shell脚本及可执行文件等)的文件名。

需事先在以-h指定的各服务器上的EXPRESSCLUSTER安装目录下的work/rexec子目录下创建脚本。

-

--notice¶ 向EXPRESSCLUSTER服务器发送异常发生通知。

请在mrw_name中指定消息接收监视资源名。

省略监视资源名时,请使用-k选项指定消息接收监视资源的监视类型,监视对象。

-

--clear¶ 请求将消息接收监视资源的状态从"异常"更改为"正常"。

请在mrw_name中指定消息接收监视资源名。

省略监视资源名时,请使用-k选项指定消息接收监视资源的监视类型,监视对象。

-

-hIP Address¶ 请指定发出处理请求的EXPRESSCLUSTER服务器的IP地址。

通过使用逗号隔开可指定多个IP地址,最多可指定32个IP地址。

※ 如省略本选项,则处理请求发行目标变成自身服务器。

-

-rresource_name¶ 指定—failover选项时,指定成为处理请求对象的组所属的资源名。

-

-kcategory[.keyword]¶ 指定—notice或—clear选项时,请在category中指定消息接收监视资源上设置的category。

指定消息接收监视资源的关键字时,请使用逗号在catergory的后面进行指定。

-

-pport_number¶ 指定端口号。

请在port_number中指定处理请求发行目标服务器中设置的数据传送端口号。

省略本选项时,使用缺省29002。

-

-ologfile_path¶ 在logfile_path指定输出本命令详细日志的文件路径。

文件中会保存1次命令的日志。

※ 未安装EXPRESSCLUSTER的服务器不指定本选项时,则只变成标准输出。

-

-wtimeout¶ 指定命令的超时时间。不指定时,为缺省30秒。

最大可指定为5~MAXINT。

-

-

返回值 0

正常结束

0以外

异常结束

-

注意事项 使用[clprexec]命令发行异常发生通知时,需预先登录/启动EXPRESSCLUSTER服务器中已设置的想要执行的异常时动作的消息接受监视资源。

拥有以-h选项指定的IP地址的服务器需满足以下条件。=安装有EXPRESSCLUSTER X3.0以上版本= EXPRESSCLUSTER已启动( 除--script 选项以外时)=已设置/启动mrw( --notice, --clear 选项时)[根据客户端IP地址限制连接]有效时,要追加执行[clprexec]命令设备的IP地址。

[根据客户端IP地址限制连接]的详细信息,请参考《设置指南》的"其他设置的详细信息" - "集群属性" - "WebManager标签页"。

-

实行示例 例1: 向EXPRESSCLUSTER服务器1(10.0.0.1)发行组failover1的失效切换请求时

# clprexec --failover failover1 -h 10.0.0.1 -p 29002

例2: 向EXPRESSCLUSTER服务器1(10.0.0.1)发行组资源(exec1)所在组的失效切换请求时

# clprexec --failover -r exec1 -h 10.0.0.1

例3: 向EXPRESSCLUSTER服务器1(10.0.0.1)发行脚本(script1.sh)执行请求时

# clprexec --script script1.sh -h 10.0.0.1

例4: 向EXPRESSCLUSTER服务器1(10.0.0.1)发行异常发生通知

※ mrw1设置 监视类型:earthquake,监视对象:scale3

指定消息接收监视资源名时

# clprexec --notice mrw1 -h 10.0.0.1 -w 30 -p /tmp/clprexec/ lprexec.log

指定消息接收监视资源中设置的监视类型和监视对象时

# clprexec --notice -h 10.0.0.1 -k earthquake.scale3 -w 30 -p /tmp/clprexec/clprexec.log

例5: 向EXPRESSCLUSTER服务器1(10.0.0.1)发行mrw1的监视状态更改请求

※ mrw1设置 监视类型:earthquake,监视对象:scale3

指定消息接收监视资源名时

# clprexec --clear mrw1 -h 10.0.0.1

指定消息接收监视资源中设置的监视类型和监视对象时

# clprexec --clear -h 10.0.0.1 -k earthquake.scale3

-

错误消息 消息

原因/处理方法

rexec_ver:%s

-

%s %s : %s succeeded.

-

%s %s : %s will be executed from now.

请通过请求发行目标的服务器确认处理结果。

%s %s : Group Failover did not execute because Group(%s) is offline.

-

%s %s : Group migration did not execute because Group(%s) is offline.

-

Invalid option.

请确认命令的参数。

Could not connect to the data transfer servers. Check if the servers have started up.

请确认指定IP地址是否正确或拥有IP地址的服务器是否已启动。

Command timeout.

请确认拥有指定IP地址的服务器是否已完成处理。

All servers are busy.Check if this command is already run.

可执行已经执行本命令。请确认。

%s %s : This server is not permitted to execute clprexec.

请确认执行命令的服务器的IP地址是否已注册到限制Cluster WebUI连接的客户端IP地址列表中。

%s %s : Specified monitor resource(%s) does not exist.

请确认命令的参数。

%s failed in execute.

请确认发行请求的目标EXPRESSCLUSTER服务器的状态。

2.18. BMC信息变更命令 (clpbmccnf 命令)¶

变更BMC用户名/密码信息。

-

命令行 clpbmccnf [-u username] [-p password]

-

说明 变更EXPRESSCLUSTER使用的基板管理控制器(BMC)的用于访问LAN的用户名/密码。

-

选项 -

-uusername¶ - 指定EXPRESSCLUSTER使用的BMC LAN访问用的用户名。必须指定拥有root权限的用户名。-u选项可以省略。省略时如果指定-p选项,用户名为当前设置的值。如果没有指定选项,则以对话形式设置。

-

-ppassword¶ 指定EXPRESSCLUSTER使用的BMC LAN访问用的密码。-p选项可以省略。省略时如果-u选项被指定,则密码为当前设置的值。如果没有指定选项,则以对话形式设置。

-

-

返回值 0

正常结束

0以外

异常结束

-

注意事项 - 请以拥有root权限的用户身份执行该命令。请在服务器正常状态下执行本命令。通过本命令进行BMC信息的更新,在下一次集群启动时/复原时设为有效。命令不是变更BMC的设置。要进行BMC账户设置的确认/变更,请使用服务器自带的工具或者以IPMI规格为基准的其他工具。

-

执行示例 server1的BMC的IPMI账户密码变更为mypassword时,在server1上执行下述命令。

# clpbmccnf -p mypassword

此外,以如下的对话形式输入。

# clpbmccnf New user name: <- If there is no change, press Return to skip New password: ************** Retype new password: ************** Cluster configuration updated successfully.

-

错误消息 消息

原因/处理方法

Log in as root.

请以拥有root权限的用户身份执行该命令。

Invalid option.

命令行选项不正确。请指定正确的选项。

Failed to download the cluster configuration data. Check if the cluster status is normal.

下载集群配置信息失败。请确认集群状态是否正常。

Failed to upload the cluster configuration data. Check if the cluster status is normal.

上传集群配置信息失败。请确认集群状态是否正常。

Invalid configuration file. Create valid cluster configuration data.

集群配置信息不正确。请在Cluster WebUI中确认集群配置信息。

Internal error. Check if memory or OS resources are sufficient.

内存不足或者OS资源不足。请确认。

2.19. 重启次数控制命令 (clpregctrl 命令)¶

进行重启次数限制的控制。

-

命令行 - clpregctrl --getclpregctrl -gclpregctrl --clear -t type -r registryclpregctrl -c -t type -r registry

-

说明 在服务器上显示/初始化重启次数。

-

选项 -

-g,--get¶ 显示重启次数信息。

-

-c,--clear¶ 初始化重启次数。

-

-ttype¶ 指定要初始化重启次数的类型。可指定的类型是rc或rm。

-

-rregistry¶ 指定注册表名称。可指定的注册表名称是haltcount。

-

-

返回值 0

正常结束

1

执行权限无效

2

二重启动

3

选项无效

4

配置信息非法

10~17

内部错误

20~22

获取重启次数信息失败

90

内存定位失败

91

工作目录更改失败

-

执行示例 显示重启次数信息

# clpregctrl -g ****************************** ------------------------- type : rc registry : haltcount comment : halt count kind : int value : 0 default : 0 ------------------------- type : rm registry : haltcount comment : halt count kind : int value : 3 default : 0 ****************************** Command succeeded.(code:0) #

例1,2初始化重启次数。

例1: 因组资源异常而初始化重启次数时

# clpregctrl -c -t rc -r haltcount Command succeeded.(code:0) #

例2: 因监视资源异常而初始化重启次数时

# clpregctrl -c -t rm -r haltcount Command succeeded.(code:0) #

-

注意事项 请以拥有root权限的用户身份执行该命令。

-

错误消息 消息

原因/处理

Command succeeded.

命令成功。

Log in as root.

无执行命令的权限。请使用有root 权限的用户执行。

The command is already executed. Check the execution state by using the "ps" command or some other command.

命令已经执行。请用ps 命令等确认执行状态。

Invalid option.

选项无效。

Internal error. Check if memory or OS resources are sufficient.

可执行是内存不足或OS资源不足。请确认。

2.20. 资源使用量预测 (clpprer命令)¶

通过输入文件中记载的资源使用量数据的趋势,预测未来值,并将预测结果输出到文件。另外,也能够确认预测数据的阈值。

-

命令行 clpprer -i <inputfile> -o <outputfile> [-p <number>] [-t <number> [-l]]

-

说明 通过给出的资源使用量数据的趋势,预测未来值。

-

选项 -

-i<inputfile>¶ 指定要计算的未来值的资源数据。

-

-o<outputfile>¶ 指定输出预测结果的文件。

-

-p<number>¶ 指定预测数据数。不指定时,求得30条预测数据。

-

-t<number>¶ 指定与预测数据相比较的阈值。

-

-l¶ 仅在通过[-t]选项设置阈值时有效的选项。小于阈值时,判定为异常。

-

-

返回值 0

没有执行阈值判定,正常结束的情况。

1

发生异常的情况

2

输入数据经过阈值判定,判定为大于阈值的情况。

3

预测数据经过阈值判定,判定为大于阈值的情况。

4

阈值判定的结果,判定为小于阈值的情况。

5

分析目标数据数少于分析推荐数据数(120)的情况下,

输入数据经过阈值判定的结果,判定为大于阈值的情况。

6

分析目标数据数少于分析推荐数据数(120)的情况下,

预测数据经过阈值判定的结果,判定为大于阈值的情况。

7

分析目标数据数少于分析推荐数据数(120)的情况下,

经阈值判定的结果,判定为小于阈值的情况。

-

注意事項 - 仅在系统监视资源(System Resource Agent) 已登录权限的情况下,可以使用本命令。(注册License后需要在集群构成中配置系统监视资源。)在选项-i 中指定的资源数据文件最多为500条输入数据。预测资源使用量需要一定的输入数据数。但是,输入数据数过多时,会延长分析所需的处理时间,因此,推荐的输入数据数为120条左右。另外,在选项-p可指定的输出数据最多为500条。输入数据的时刻数据没有按升序排列时会发生不能执行正确预测的情况。输入文件,请按升序排列时刻数据。

-

输入文件 - 有关输入文件格式的说明。输入文件中关于取得预测结果所希望的资源使用量,请按照如下格式准备文件。输入文件为CSV格式,1条数据按照[日期时间,数值]的形式进行记载。另外,日期时间格式为YYYY/MM/DD hh:mm:ss。

文件例

2012/06/14 10:00:00,10.0 2012/06/14 10:01:00,10.5 2012/06/14 10:02:00,11.0

-

执行例 通过简单的预测未来值例进行说明

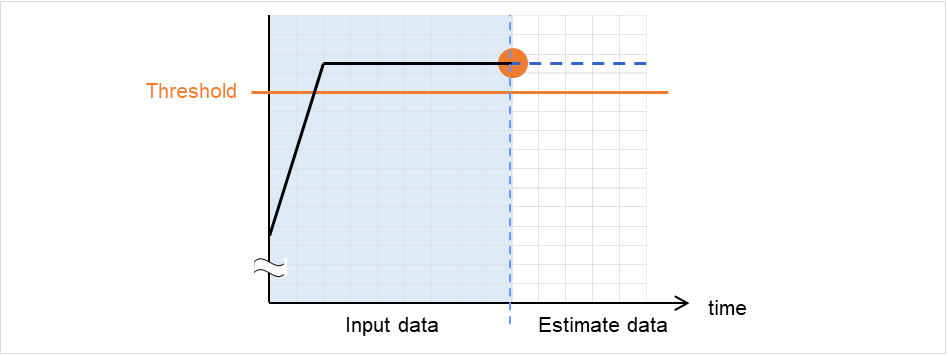

在输入数据中检测异常

输入数据的最新值大于阈值的情况下,判定为异常并返回值2。输入数据数少于推荐值(=120)的情况下,返回值5。

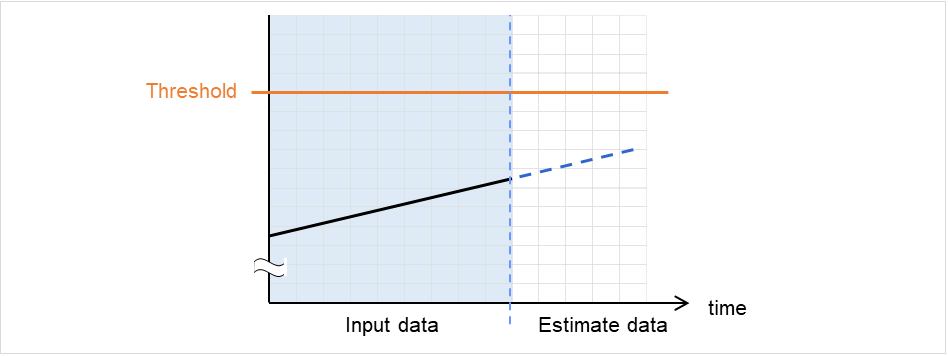

图 2.3 在输入数据中检测出异常¶

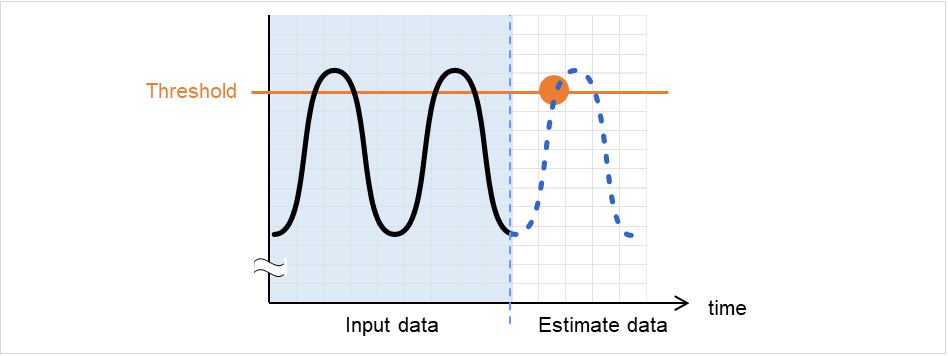

在预测数据中检测出异常

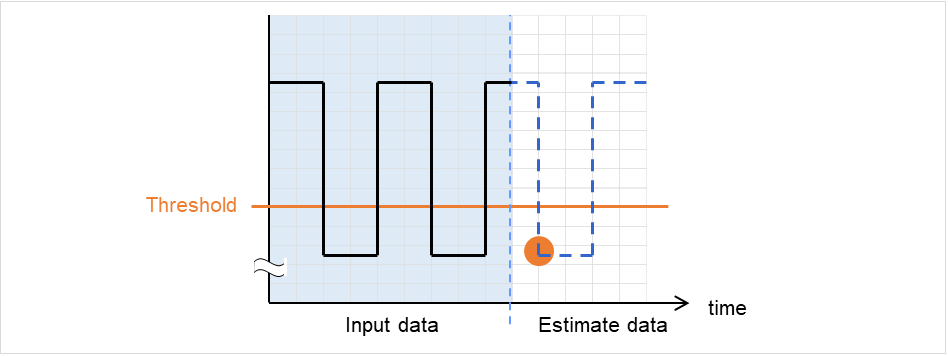

预测数据大于阈值的情况下,判定为异常并返回值3。输入数据数少于推荐值(=120)的情况下,返回值6。

图 2.4 在预测数据中检测出异常¶

没有检测出阈值异常

输入数据,预测数据均小于阈值的情况下,返回值4。输入数据数少于推荐值(=120)的情况下,返回值7。

图 2.5 没有检测出阈值异常¶

使用-l选项的情况下

使用-l选项的情况下,低于阈值时,判定为异常。

图 2.6 利用 -l 选项¶

-

执行示例 准备指定格式的文件,通过执行clpprer命令将预测结果作为输出文件来确认。

输入文件 test.csv

2012/06/14 10:00:00,10.0 2012/06/14 10:01:00,10.5 2012/06/14 10:02:00,11.0

# clpprer -i test.csv -o result.csv

输出结果 result.csv

2012/06/14 10:03:00,11.5 2012/06/14 10:04:00,12.0 2012/06/14 10:05:00,12.5 2012/06/14 10:06:00,13.0 2012/06/14 10:07:00,13.5 :

另外,通过在选项中设置阈值能够在命令提示符上确认预测值的阈值判定结果。

# clpprer -i test.csv -o result.csv -t 12.5

执行结果

Detect over threshold. datetime = 2012/06/14 10:06:00, data = 13.00, threshold = 12.5

-

错误消息 消息

原因/处理方法

Normal state.

经过阈值判定的结果,没有大于阈值的数据。

Detect over threshold. datetime = %s, data = %s, threshold = %s

经过阈值判定的结果,检测出大于阈值的数据。

Detect under threshold. datetime = %s, data = %s, threshold = %s

通过-l选项的阈值判定结果,检测出小于阈值的数据。

License is nothing.

没有登录有效的System Resrouce Agent权限。请确认权限。

Inputfile is none.

指定的输入数据文件不存在。

Inputfile length error.

指定的输入数据文件路径过长。请指定在1023字节以下。

Output directory does not exist.

在输出文件指定的目录不存在。请确认指定的目录是否存在。

Outputfile length error.

指定的输出文件路径过长。请指定在1023字节以下。

Invalid number of -p.

指定-p选项的值不正确。

Invalid number of -t.

指定-t选项的值不正确。

Not analyze under threshold(not set -t).

没有指定-t选项。使用-l选项时,请指定-t选项。

File open error [%s]. errno = %s

打开文件失败。认为内存不足或OS资源不足。请确认。

Inputfile is invalid. cols = %s

输入数据不正确。请将输入数据设定在2条以上。

Inputfile is invalid. rows = %s

输入数据的格式不正确。每行必须为2列。

Invalid date format. [expected YYYY/MM/DD HH:MM:SS]

输入数据的日期格式不正确。请确认数据。

Invalid date format. Not sorted in ascending order.

输入数据没有按升序排列。请确认数据。

File read error.

输入数据设定错误值。请确认数据。

Too large number of data [%s]. Max number of data is %s.

输入数据数大于最大值 (500)。请减少数据数。

Input number of data is smaller than recommendable number.输入数据数少于分析推荐数据数(120)。※即使分析推荐数据很少的情况下,也进行分析。Internal error.

发生内部错误。

2.21. 确认进程的健全性 (clphealthchk 命令)¶

确认进程的健全性。

-

命令行 clphealthchk [ -t pm | -t rc | -t rm | -t nm | -h]

注解

本命令在单一服务器上确认进程的健全性。请在要确认健全性的服务器上执行。

-

说明 确认单一服务器上的进程健全性。

-

选项 -

无¶ 确认pm/rc/rm/nm的健全性。

-

-t<process>¶ process

- pm

确认pm的健全性。

- rc

确认rc的健全性。

- rm

确认rm的健全性。

- nm

确认nm的健全性。

-

-h¶ 显示Usage。

-

-

返回值

0 |

正常结束 |

1 |

执行权限非法 |

2 |

二重启动 |

3 |

初始化错误 |

4 |

选项无效 |

10 |

进程失控监视功能未设置 |

11 |

集群未启动状态(包含集群启动处理中,集群停止处理中) |

12 |

集群挂起状态 |

100 |

存在一定时间内没有更新健全性信息的进程 -t选项指定时,指定进程的健全性信息一定时间内未更新 |

255 |

其它内部错误 |

-

执行示例 例1:健全时

# clphealthchk pm OK rc OK rm OK nm OK

例2:clprc失控时

# clphealthchk pm OK rc NG rm OK nm OK # clphealthchk -t rc rc NG

例3:集群停止时

# clphealthchk The cluster has been stopped

-

备注 集群停止或挂起时进程是停止的。

-

注意事项 请以拥有root权限的用户身份执行该命令。

-

错误消息 消息

原因/处理方法

Log in as root.

无执行命令的权限。请用有root权限的用户执行。

Initialization error. Check if memory or OS resources are sufficient.

可执行是内存不足或OS资源不足。请确认。

Invalid option.

请指定正确的选项。

The function of process stall monitor is disabled.

进程失控监视功能无效。

The cluster has been stopped.

集群处于停止状态。

The cluster has been suspended.

集群处于挂起状态。

This command is already run.

命令已经执行。请用ps 命令等确认执行状态。

Internal error. Check if memory or OS resources are sufficient.

可执行是内存不足或OS资源不足。请确认。

2.22. 显示集群统计信息(clpperfc 命令)¶

显示集群统计信息。

-

命令行 - clpperfc --starttime -g group_nameclpperfc --stoptime -g group_nameclpperfc -g [group_name]clpperfc -m monitor_name

-

说明 显示组的启动,停止时间的中位数(毫秒)。

显示监视资源的监视处理时间(毫秒)。

-

选项 -

--starttime-g group_name¶ 显示组的启动时间的中位数。

-

--stoptime-g group_name¶ 显示组的停止时间的中位数。

-

-g[group_name]¶ 显示组的启动,停止时间的中位数。

省略groupname时,显示所有组的启动,停止时间的中位数。

-

-mmonitor_name¶ 显示最近的监视资源的监视处理时间。

-

-

返回值 0

正常结束

1

命令选项不正确

2

用户认证错误

3

加载配置信息错误

4

加载配置信息错误

5

初始化错误

6

内部错误

7

内部通信初始化错误

8

内部通信连接错误

9

内部通信处理错误

10

对象组检查错误

12

超时错误

-

执行示例 (显示组的启动时间的中位数时) # clpperfc --starttime -g failover1 200

-

执行示例 (显示特定组的启动,停止时间的中位数时) # clpperfc -g failover1 start time stop time failover1 200 150

-

执行示例 (显示监视资源的监视处理时间时) # clpperfc -m monitor1 100

-

备注 本命令输出的时间单位为毫秒。

无法取得有效的组的启动时间,停止时间时,显示 - 。

无法取得有效的监视资源的监视时间时,显示0。

-

注意事项 请有root权限的用户执行本命令。

-

错误消息 消息

原因/处理办法

Log in as root.

请以拥有root权限的用户身份执行该命令。

Invalid option.

命令选项不正确。请确认命令选项。

Command timeout.

命令执行超时。

Internal error.

内存不足或者OS资源不足。请确认。

2.23. 检查集群配置信息 (clpcfchk 命令)¶

检查集群配置信息。

-

命令行 - clpcfchk -o path [-i conf_path]

-

说明 根据集群配置信息,确认设定值的妥当性。

-

返回值 0

正常结束

0以外

异常结束

-

执行示例 (检查已反映的配置信息时) # clpcfchk -o /tmp server1 : PASS

-

执行示例 (检查已保存的配置信息时) # clpcfchk -o /tmp -i /tmp/config server1 : PASS

-

执行结果 在本命令的结果中显示的检查结果(综合结果)如下所示。

检查结果(综合结果)

说明

PASS

没有问题。

FAIL

存在问题。请确认检查结果。

-

备注 仅显示各服务器的综合结果。

-

注意事项 请有root权限的用户执行本命令。

要使用Cluster WebUI 检查导出的配置信息时,请事先对其进行解压缩。

-

错误消息 消息

原因/处理方法

Log in as root.

请有root权限的用户执行本命令。

Invalid option.

请指定正确的选项。

Could not opened the configuration file. Check if the configuration file exists on the specified path.

指定的路径不存在。请指定正确的路径。

Server is busy. Check if this command is already run.

本命令已启动。

Failed to obtain properties.

获取属性失败。

Failed to check validation.

检查集群配置失败。

Internal error. Check if memory or OS resources are sufficient.

内存不足或者OS资源不足。请确认。

3. 注意限制事项¶

本章将说明注意事项,现有问题及其避免方法。

本章中介绍的内容如下。

3.1. 操作EXPRESSCLUSTER X SingleServerSafe后¶

请注意集群操作开始后的现象。

3.1.1. 关于驱动程序加载时的消息¶

加载clpka驱动程序时,如下消息有时显示在控制台和syslog上,此现象不属于异常。

kernel: clpka: no version for "struct_module" found: kernel tainted.

kernel: clpka: module license 'unspecified' taints kernel.

3.1.2. 关于ipmi的消息¶

在用户空间监视资源中使用IPMI时,将向syslog输出许多下述kernel模块警告日志。

modprobe: modprobe: Can't locate module char-major-10-173

要避免该日志的输出,请重命名/dev/ipmikcs。

3.1.3. 恢复运行中的操作限制¶

使用查出监视资源异常时的设置,为恢复对象指定组资源(磁盘资源,EXEC资源......),请不要在查出监视资源异常,正在恢复运行时(重新启动 -> 最终运行),控制如下命令或者来源于Cluster WebUI的集群和组。

服务器的停止/挂起

组的开始 / 停止

如果在监视资源异常,正在恢复运行时执行上述控制,该组的其他组资源可执行不会停止。然而,监视资源异常时,如果执行了最终运行,则可以进行上述的控制。

3.1.4. 关于命令参考里没有记载的可执行文件和脚本文件¶

安装目录下存在命令篇中未被记载的执行形式的文件及脚本文件。但是,请不要在EXPRESSCLUSTER X SingleServerSafe以外执行。

不支持执行后的影响。

3.1.5. 收集日志时的消息¶

执行日志收集时,控制台上可执行显示下列消息,不属于异常。日志被正常收集。

hd#: bad special flag: 0x03 ip_tables: (C) 2000-2002 Netfilter core team

(在hd#内有存在于服务器IDE的设备名)