1. 前言¶

1.1. 读者对象和用途¶

《EXPRESSCLUSTER X开始指南》以首次使用EXPRESSCLUSTER的用户为对象,介绍了EXPRESSCLUSTER的产品概要,集群系统导入的过程,其他手册的使用方法等。同时还介绍了最新的运行环境信息以及限制事项等。

1.2. 本手册的构成¶

1.3. EXPRESSCLUSTER手册体系¶

EXPRESSCLUSTER 的手册分为以下 5 类。各指南的标题和用途如下所示。

《EXPRESSCLUSTER X 开始指南》(Getting Started Guide)

本手册的读者对象为使用EXPRESSCLUSTER的用户,对产品概要,运行环境,升级信息以及现有的问题等进行了说明。

《EXPRESSCLUSTER X 安装&设置指南》(Install and Configuration Guide)

本手册的读者对象为导入使用EXPRESSCLUSTER的集群系统的系统工程师以及导入集群系统后进行维护和操作的系统管理员。对导入使用了EXPRESSCLUSTER的集群系统后到开始操作前的必备事项进行说明。本手册按照实际导入集群系统时的顺序,对使用EXPRESSCLUSTER的集群系统的设计方法,EXPRESSCLUSTER的安装设置步骤,设置后的确认以及开始操作前的测试方法进行说明。

《EXPRESSCLUSTER X 参考指南》(Reference Guide)

本手册的读者对象为管理员以及导入使用了EXPRESSCLUSTER的集群系统的系统工程师。手册说明了EXPRESSCLUSTER 的操作步骤,各模块的功能以及疑难解答信息等,是对《安装&设置指南》的补充。

《EXPRESSCLUSTER X 维护指南》(Maintenance Guide)

本手册的读者对象为管理员以及导入使用EXPRESSCLUSTER的集群系统后进行维护和操作的系统管理员,对EXPRESSCLUSTER的维护的相关信息进行了说明。

《EXPRESSCLUSTER X 硬件整合指南》 (Hardware Feature Guide)

本手册的读者对象为管理员以及导入使用EXPRESSCLUSTER的集群系统的系统工程师,对特定的硬件以及与其整合的功能进行说明。是对《安装&设置指南》的补充。

1.4. 本手册的标记规则¶

在本手册中,需要注意的事项,重要的事项以及相关信息等用如下方法标记。

注解

表示虽然比较重要,但是并不会引起数据损失或系统以及机器的损伤的信息。

重要

表示为避免数据损失和系统,机器损坏所必需的信息。

参见

表示参考信息的位置。

另外在本手册中使用以下标记法。

标记 |

使用方法 |

例 |

|---|---|---|

[ ]方括号

|

在命令名的前后,

显示在画面中的字句 (对话框,菜单等) 的前后。

|

点击[开始]。

[属性]对话框

|

命令行中的[ ]方括号

|

表示括号内的值可以不予指定

(可省)。

|

clpstat -s[-h host_name] |

# |

表示Linux用户正以root身份登录的提示符。 |

|

等宽字体

|

路径名,命令行,系统输出(消息,提示等),目录,文件名,函数,参数。

|

/Linux/5.0/cn/server/

|

粗体

|

表示用户在命令提示符后实际输入的值。

|

输入以下值。

clpcl -s -a

|

斜体 |

用户将其替换为有效值后输入的项目。

|

clpstat -s[-h host_name] |

在本手册的图中,为了表示EXPRESSCLUSTER,使用该图标。

在本手册的图中,为了表示EXPRESSCLUSTER,使用该图标。

2. 何谓集群系统¶

本章介绍集群系统的概要。

本章介绍以下内容。

2.1. 集群系统的概要¶

在今天的计算机社会中,不中断地持续提供服务是成功的关键所在。例如仅仅由于1台机器因故障或超负荷运行而宕机,从而造成向客户提供的服务全面中断。这样不仅会造成不可估量的损失,还可执行失去客户的信赖。

而集群系统就是避免这种事态发生的系统。导入集群系统后,或者能够将万一发生系统运行停止时的停止时间(DownTime)缩到最短,或者能够通过分散负载的方法回避系统宕机。

所谓集群就是"群""团"的意思,顾名思义,集群系统就是"将多个计算机集合成一个群(或多个群),从而提高可靠性和处理性能的系统"。集群系统有很多种,分为以下3类。其中,EXPRESSCLUSTER属于高可用性集群。

HA (High Availability) 集群

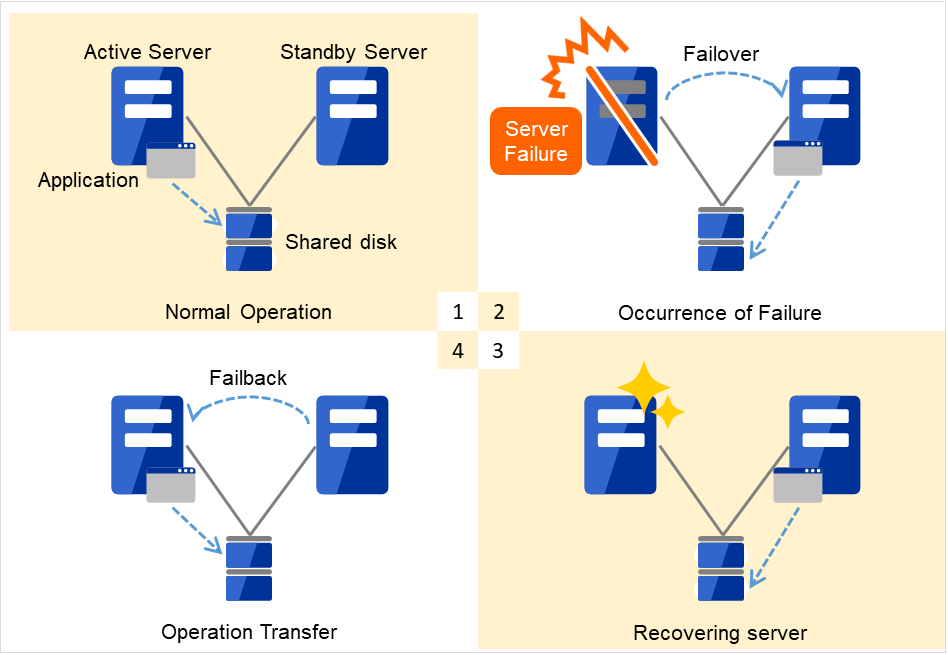

指在正常时将其中一方用作运行服务器,提供业务,运行服务器发生故障时将业务交接给待机服务器的集群形态。该集群主要目的是实现高可用性,可以交接数据。该集群包含共享磁盘型,镜像磁盘型,远程集群型。

负载均衡集群

指能够将客户端发送的请求按照合适的负载均衡原则,分配给各负载均衡主机的集群形态。该集群的主要目的实现高扩展性,一般情况不能进行数据交接。该集群包含负载均衡集群,并列数据库集群。

HPC(High Performance Computing)集群

使用所有节点的CPU,实现单一业务的集群。该集群的主要目的是实现高性能,应用范围不大。另外,该集群是HPC的一种,将更广泛范围内的节点和计算机集群捆绑在一起的网格运算技术也成为近年来关注的焦点。

2.2. HA(High Availability)集群¶

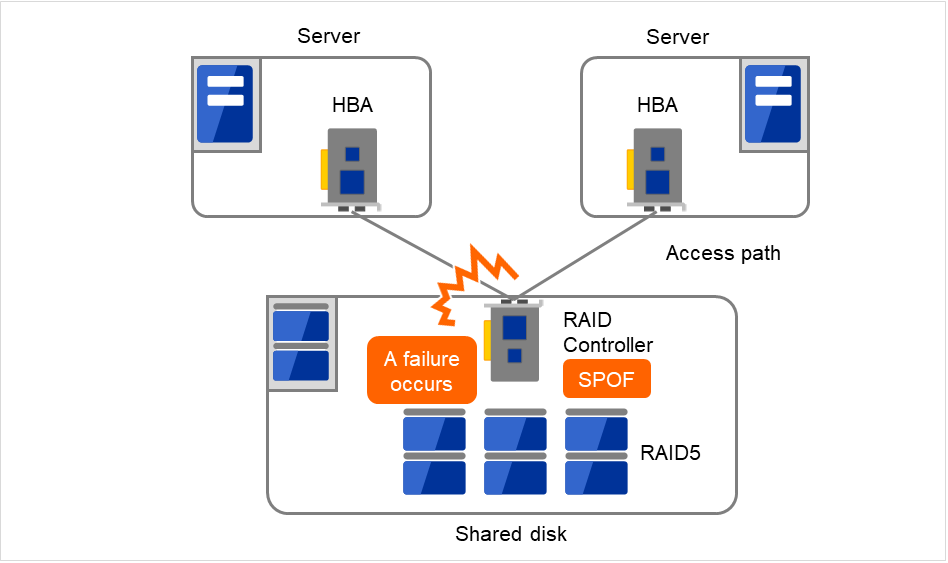

为了提高系统的可用性,普遍认为将系统部件冗余化,排除Single Point of Failure是至关重要的。所谓Single Point of Failure是指因为计算机的配置要素(硬件)只有一个,在这个部件上发生故障时则会造成业务中断这一弱点。HA集群则是通过使用多台服务器使系统冗余化,从而将系统的中断时间限制在最小,提高业务可用性(availability)的集群系统。

绝对不容许系统中断的骨干业务系统自不必说,在系统中断会给业务带来巨大影响的系统中也需要导入HA集群。

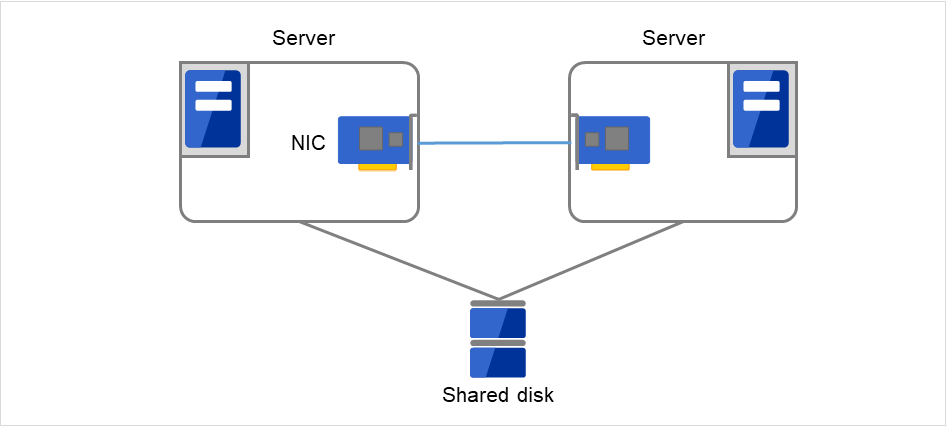

HA集群可以分为共享磁盘型和数据镜像型。下面分别介绍两种类型。

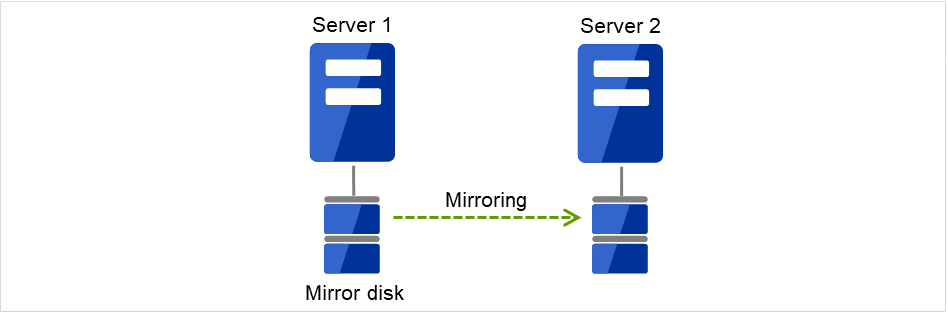

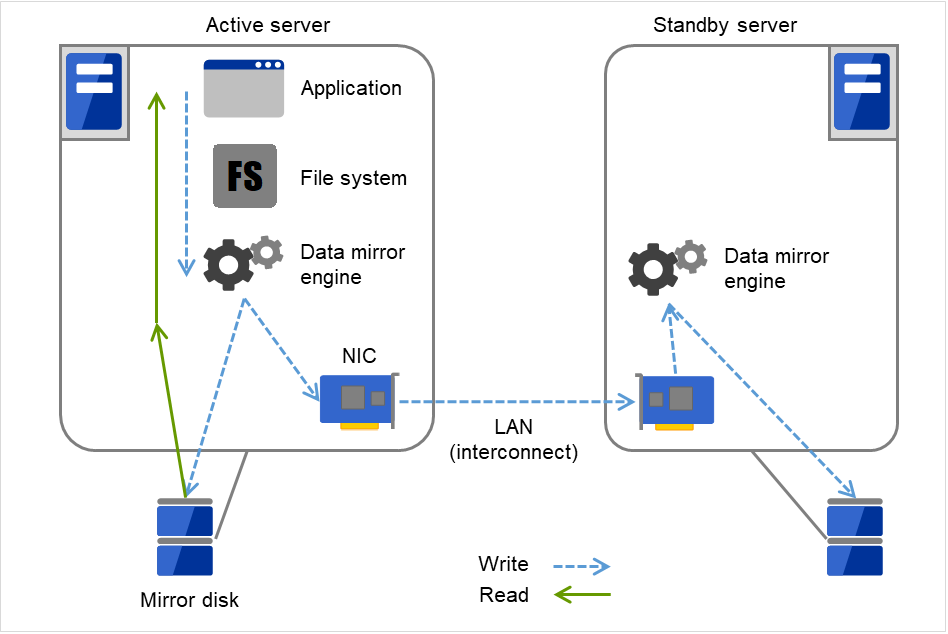

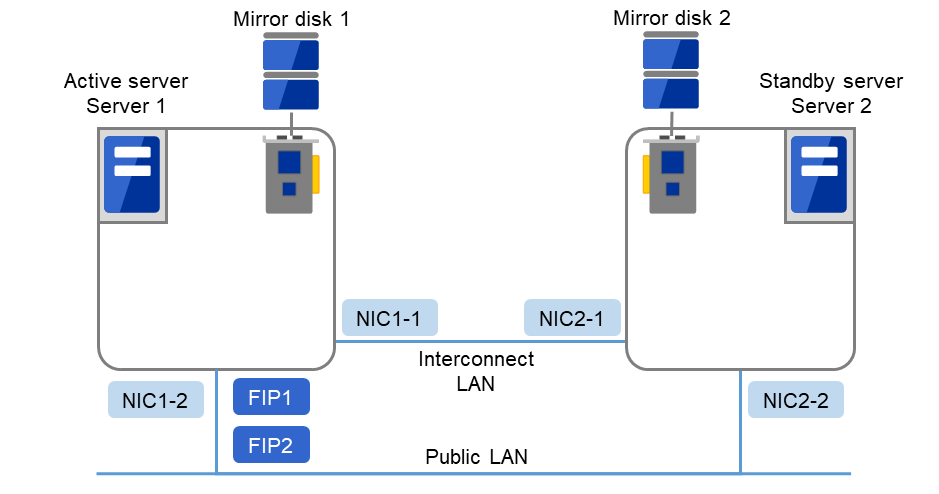

2.2.2. 数据镜像型¶

之前介绍的共享磁盘型适用于大规模系统,但是由于共享磁盘大多很昂贵,所以搭建系统的成本也就随之增加。不使用共享磁盘,在各服务器之间对各服务器上的磁盘进行镜像,通过该方法用低廉的价格实现相同功能的集群系统称为数据镜像型。

图 2.5 HA集群配置图(数据镜像型)¶

由于不需要共享磁盘而价格便宜

适用于由于镜像而导致数据量不大的系统

但是,因为需要在服务器之间进行数据的镜像,因此不适用于需要大量数据的大规模系统。

应用程序发出write请求时,数据镜像引擎会将数据写入本地磁盘的同时,通过心跳线将write请求同时分发给待机服务器。所谓心跳线是指连接各服务器的网络,在集群系统中需要使用心跳线进行服务器的生存状态监视。在数据镜像类型中,心跳线除了用于生存状态监视,还用于数据传输。待机服务器数据镜像引擎将收到的数据写入待机服务器的本地磁盘,从而实现运行服务器和待机服务器间的数据同步。

应用程序发出Read请求时,则只需单纯从运行服务器的磁盘中读取数据即可。

图 2.6 数据镜像的结构¶

作为数据镜像的一个应用示例,可以使用快照备份。数据镜像类型的集群系统由于同时在2处保存共享数据,因此只需将待机服务器从集群中分离开,无需备份,就可以将磁盘作为快照备份保存。

失效切换的机制和问题

至此,我们一口气介绍了包含失效切换集群,负载均衡集群,HPC(High Performance Computing)集群等多种多样的集群系统。我们了解了失效切换集群称为HA(High Availability)集群,其目的是通过将服务器多重化,发生故障时将运行的业务转移到其他服务器上,从而提高业务的可用性(Availability)。下面介绍集群的结构和问题。

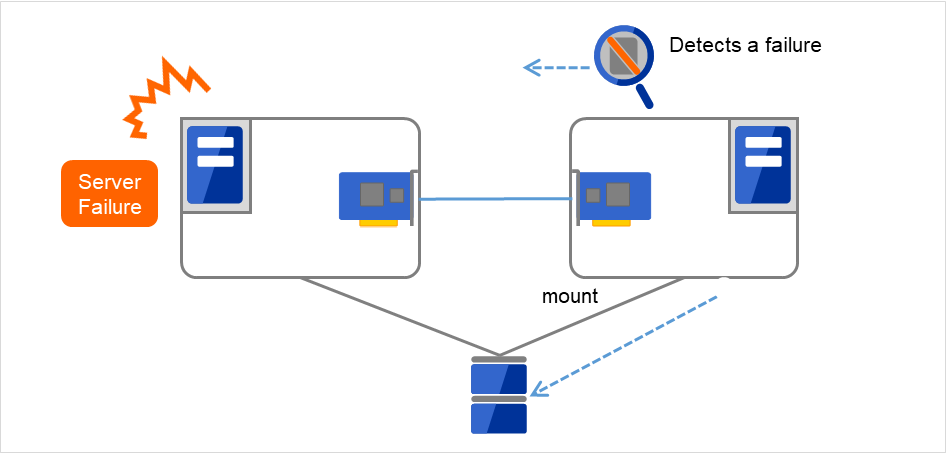

2.3. 查出故障的原理¶

集群软件一旦查出影响业务继续运行的故障,就会进行业务的切换(失效切换)。在介绍失效切换处理的详细内容之前,先简单了解一下集群软件是如何检测故障的。

心跳和服务器的故障检测

在集群系统中,应该查出的最基本故障是配置集群的各服务器均停止运行。服务器故障中,包括电源故障,内存错误等硬件故障和OS的panic。要查出该故障,则需要在服务器生存状态监视中使用心跳。

心跳也可以是确认ping应答这样的简单的生存状态监视,但是使用集群软件还能够互相传送本服务器的状态信息。集群软件进行心跳信息的收发信息,没有心跳应答时则认为该服务器发生故障,开始进行失效切换处理。但是考虑到服务器也可执行是因为负载较高,收发心跳信息有延迟,在做出服务器故障判断之前留有一定的缓冲时间。因此,实际发生故障的时间和集群软件查出故障的时间之间有一定时滞。

资源的故障检测

造成业务中断的原因不仅仅是配置集群服务器全部中断,还有可执行是因为业务应用程序使用的磁盘设备或NIC 发生故障,亦或是业务应用程序本身发生故障造成业务中断。为了提高可用性,这些资源故障同样需要查出来并进行失效切换。

作为检测资源故障的方法,如果监视的对象资源是物理设备,则采取实际访问的方法。在应用程序的监视中,除了应用程序进程自身的生存状态监视,还考虑在不影响业务的范围内使用服务端口等手段。

2.4. 集群资源的交接¶

集群管理的资源中有磁盘,IP地址,应用程序等。下面介绍失效切换集群系统中用于交接这些集群资源的功能。

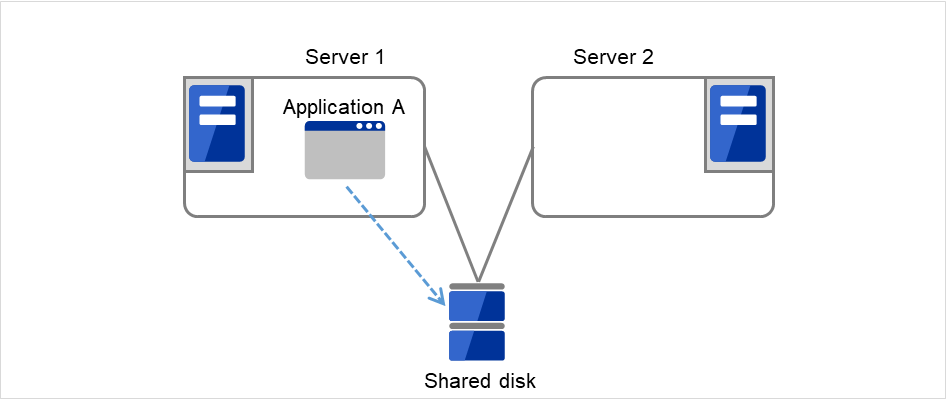

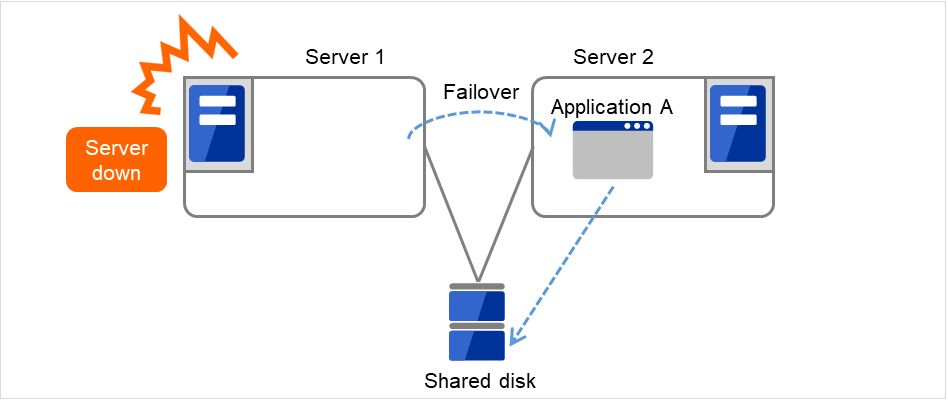

2.4.1. 数据的交接¶

在集群系统中,服务器之间交接的数据存放在共享磁盘设备的分区中。即,所谓的交接数据无非就是将保存有应用程序所使用的文件的文件系统在正常的服务器上重新mount。共享磁盘设备与交接对象服务器物理连接,集群软件需要做的就是文件系统的mount。

图 2.9 数据的交接¶

虽然这个过程看似简单,但是在设计构建集群系统时还是有很多需要注意的地方。

首先是文件系统的恢复时间问题。要交接的文件系统在发生故障之前可执行正在其他服务器上使用,或者正在更新。所以交接的文件系统一般是会有些垃圾,需要检查文件系统的一致性。文件系统越大,则一致性检查所需的时间就越长,有时甚至需要花几个小时,而这个时间将直接转嫁到失效切换时间(业务的交接时间)中,成为造成系统可用性下降的原因。

还有一个就是写入保证的问题。应用程序将重要的数据写入文件时,要利用同步写入等方法保证在磁盘中也写入该数据。因此,应用程序认为已经写入的数据在失效切换后希望该数据也能够被交接。例如,邮件服务器已经将收到的邮件写入缓冲处理区时,会向客户端或者其他邮件服务器发出收信结束的应答。这样,即使服务器发生故障,在服务器重启后,能够重新传输被缓冲处理的邮件。在集群系统中也一样,必须保证一方服务器写入缓冲处理区的邮件在失效切换后另一个服务器能够读取。

2.4.2. 应用程序的交接¶

集群软件在业务交接的最后工作是交接应用程序。与容错计算机(FTC)不同,在一般的失效切换集群中,不交接包含正在执行应用程序的内存内容的进程状态。即,在发生故障的服务器上运行的应用程序只能通过在正常的服务器上重新执行来完成应用程序的交接。

例如,交接数据库管理系统(DBMS)的实例时,将在启动实例时自动进行数据库的恢复(回滚/前滚等)。数据库恢复所需时间可以通过设置DBMS的Check Point Interval等进行一定的控制,但是一般都需要几分钟。

很多应用程序只要重新执行就可以重新开始运行业务,但是也有些应用程序在发生故障后需要一定的业务恢复步骤。对于这样的应用程序,集群软件将业务恢复步骤写在脚本中,在重启时将不启动应用程序,而是启动该脚本。在脚本中,记载了脚本的执行原因,执行服务器等信息,需要时还会记载尚未更新完毕的文件的整理等恢复步骤。

2.5. Single Point of Failure的排除¶

在构建高可用性系统时,把握所追求的或者说目标的可用性级别是很重要的。即,在设计系统时,必须考虑到对于可执行阻碍系统运行的各种故障应该采取的措施,如通过冗余结构保证系统持续运行,或者能够在短时间恢复到运行状态等,以及这些措施的性价比等。

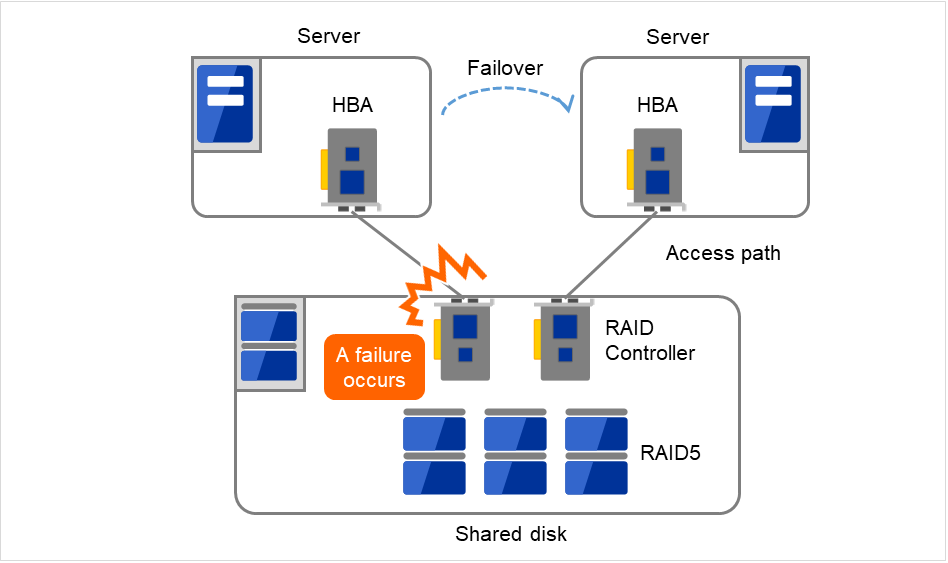

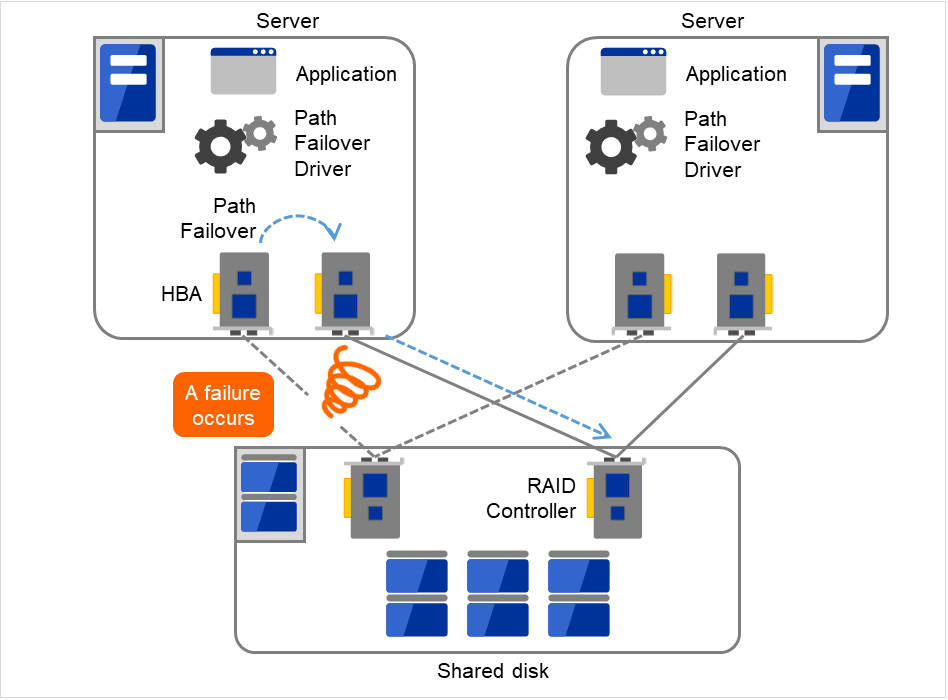

Single Point of Failure(SPOF)之前已经介绍过,是指可执行造成系统中断的部位。在集群系统中,实现了服务器的多重化,能够排除系统的SPOF,但是共享磁盘等在服务器之间共享的部分可执行造成SPOF。设计系统时将这些共享部分多重化或者排除是构建高可用性系统的关键点。

集群系统虽然提高了可用性,但是失效切换时,还是需要几分钟的系统切换时间的。因此,失效切换时间也是造成可用性下降的原因之一。但是因为在高可用性系统中,ECC内存或冗余电源技术对于提高单体服务器的可用性原本就是很重要的,在本文中我们暂且不谈这些提高单体服务器可用性的技术,在集群系统中,我们挖掘可执行造成SPOF的以下3点原因,看看对此能够采取什么对策。

共享磁盘

共享磁盘的访问路径

LAN

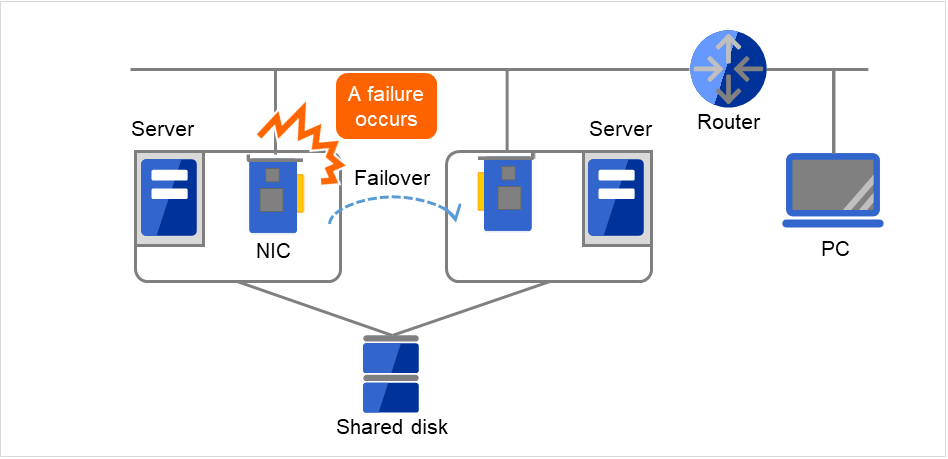

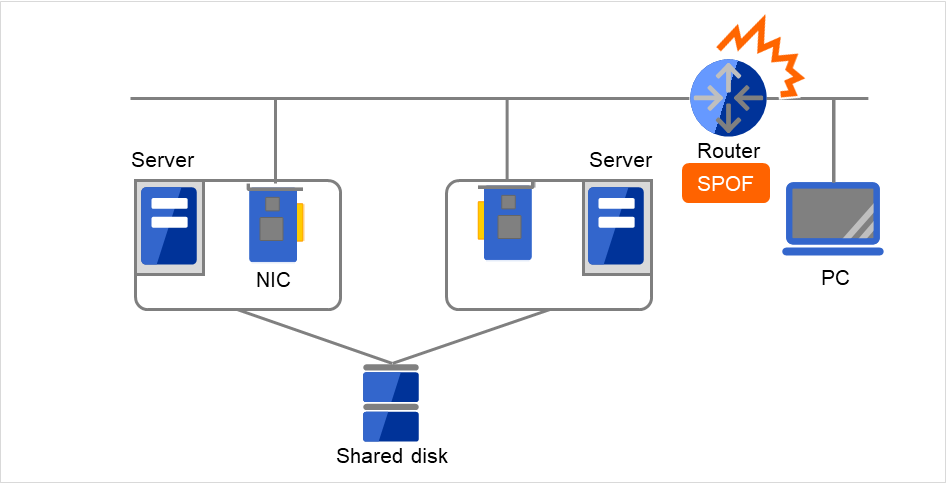

2.5.3. LAN¶

不仅仅是集群系统,所有需要在网络上执行某种服务的系统,LAN故障都是阻碍系统运行的重要原因。在集群系统中,如果配置恰当,可以在NIC发生故障时在节点之间进行失效切换,从而提高可用性,但是集群系统外的网络设备如果发生故障仍然会阻碍系统的运行。

图 2.14 LAN故障的示例(NIC)¶

图中所示的情况,即使服务器上的NIC发生故障,也可以通过失效切换,继续从PC访问服务器上的服务。

图 2.15 LAN故障的示例(Router)¶

该图所示的情况,如果路由器发生故障,则无法继续从PC访问服务器上的服务(路由器为SPOF)。

在这种情况下,可以通过LAN的冗余化提高系统的可用性。在集群系统中,也可以直接使用单体服务器上的技术提高LAN的可用性。如,一种原始方法是准备好备用的网络设备,先不打开电源,发生故障时手动切换,或者冗余配置高性能的网络设备,通过将网络路径多重化实现路径的自动切换等方法。另外,也可以考虑使用类似于因特尔公司ANS驱动程序的支持NIC冗余结构驱动程序。

负载均衡设备(Load Balance Appliance)和防火墙服务器(Firewall Appliance)都是容易发生SPOF的网络设备。这些可以通过标配或可选的软件,使其能够搭建失效切换结构。同时因为这些设备大多在系统整体中的位置非常重要,所以一般必须配置冗余结构。

2.6. 支持可用性的操作¶

2.6.1. 操作前测试¶

系统问题大多起因于配置错误或操作维护。从这一点来考虑,在实现高可用性系统时,操作前的测试和完善故障恢复手册对系统的稳定运行非常重要。作为测试观点,结合实际操作,进行以下操作可以提高可用性。

筛选故障发生位置,讨论对策,进行模拟故障测试验证

进行假定集群生存周期的测试,验证降级运行时的性能

以这些测试为基础,完善系统操作,故障恢复手册

简化集群系统的设计,能够简化上述的验证操作和手册,提高系统的可用性。

2.6.2. 故障监视¶

虽然我们已经做了上述的努力,可执行还是会发生故障。系统长期持续运行后,必然会发生故障,其原因可执行是硬件老化,软件的内存泄漏,或者操作时超过系统当初设计的承受能力等。因此,在提高硬件,软件可用性的同时,需要进一步监视故障,在发生故障时采取恰当的处理,这一点非常重要。例如,万一服务器发生故障,可以通过搭建集群系统,只需要几分钟的切换时间就可以使系统继续运行,但是如果置之不管,系统失去冗余性,发生下一个故障时集群系统就没有任何意义了。

因此,发生故障时,系统管理员必须要采取措施防范下一故障的发生,排除新发生的SPOF。在支持系统管理业务上,远程维护,故障通知等功能非常重要。勿庸置疑,Linux在远程维护方面非常优秀,故障通告的机制也在逐渐完备。

以上介绍了使用集群系统实现高可用性时所需的周边技术以及其他的一些要点。简单总结一下,就是要注意以下几点:

排除或掌握Single Point of Failure

设计简洁的抵抗故障能力强的系统,在操作前测试的基础上完善操作故障恢复步骤手册

及早查出发生的故障并进行恰当的处理

3. EXPRESSCLUSTER的使用方法¶

本章介绍EXPRESSCLUSTER各个组件的说明,从集群系统的设计到运行步骤之间的流程。

本章将介绍以下内容。

3.1. 何谓EXPRESSCLUSTER¶

现在大家已经了解了集群,下面开始介绍EXPRESSCLUSTER。所谓EXPRESSCLUSTER 就是通过冗余化(集群化)的系统结构,运行服务器发生故障时,自动用待机服务器交接业务的软件,该软件实现了系统可用性和扩展性的飞越性的提高。

3.2. EXPRESSCLUSTER的产品结构¶

EXPRESSCLUSTER大致由2个模块组成。

- EXPRESSCLUSTER ServerEXPRESSCLUSTER主体,包含所有服务器的高可用性功能。还包含Cluster WebUI的服务器一端的功能。

- Cluster WebUI创建EXPRESSCLUSTER的配置信息或者进行操作管理的管理工具。使用Web浏览器作为用户接口。实体嵌入在EXPRESSCLUSTER Server中,通过管理终端上的Web浏览器进行操作,据此与EXPRESSCLUSTER Server主体区分。

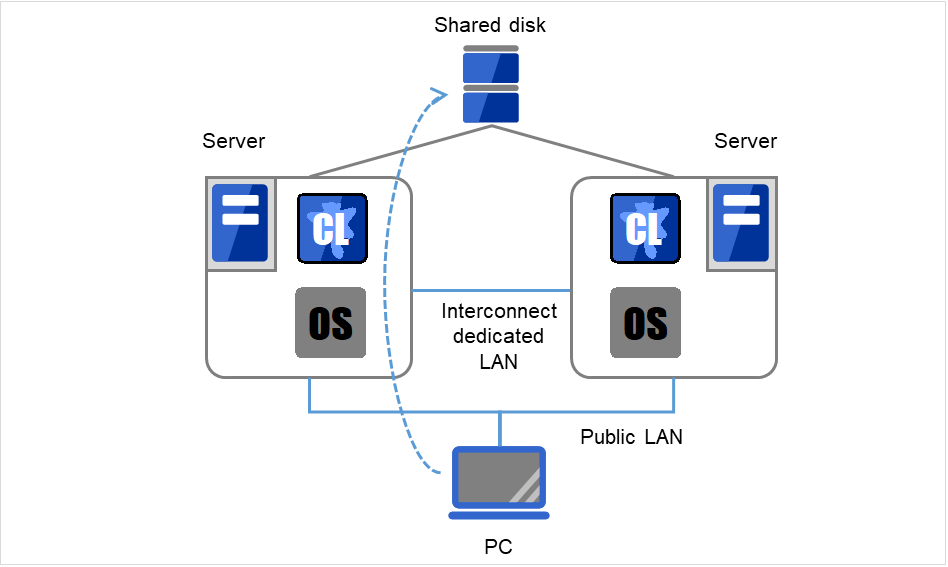

3.3. EXPRESSCLUSTER的软件配置¶

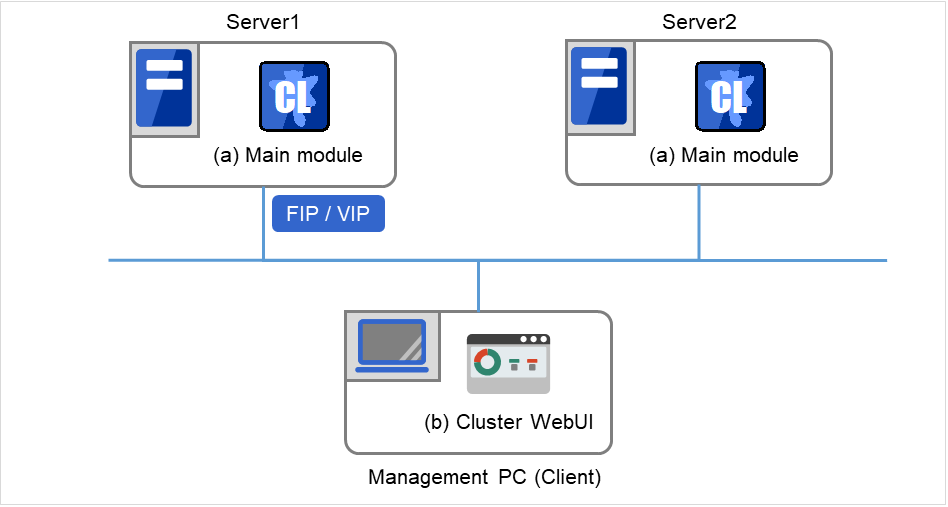

EXPRESSCLUSTER的软件配置如下图所示。在Linux服务器上安装"EXPRESSCLUSTER Server(EXPRESSCLUSTER主体)"。Cluster WebUI的主体功能包括在EXPRESSCLUSTER Server内,因此无需另行安装。除了通过管理PC上的Web浏览器以外,Cluster WebUI还能通过构成集群的各服务器上的Web浏览器进行操作。

EXPRESSCLUSTER Server

Cluster WebUI

图 3.1 EXPRESSCLUSTER的软件配置¶

3.3.1. EXPRESSCLUSTER的故障监视原理¶

通过EXPRESSCLUSTER可以进行服务器监视,业务监视,内部监视等3种监视,从而能够迅速准确查出故障。下面详细介绍各种监视。

3.3.2. 何谓服务器监视¶

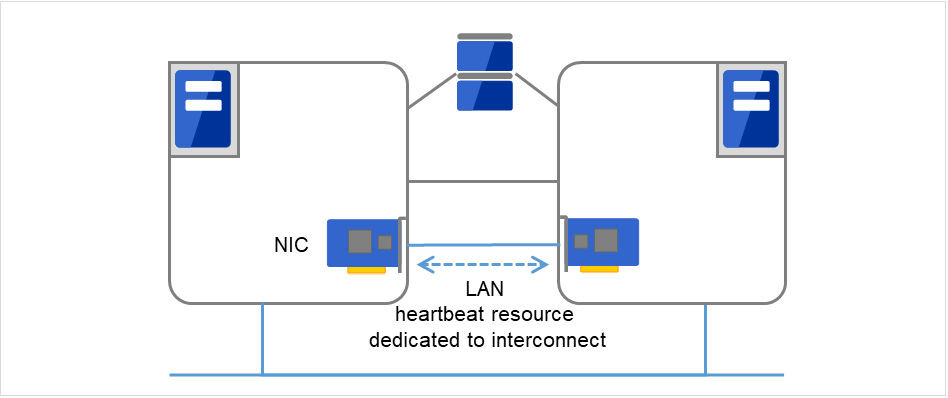

- 私网在失效切换型集群专用的通信线路上,使用普通的Ethernet NIC。除了确认心跳,还可以用于服务器之间的信息交换。

图 3.2 LAN心跳/内核模式LAN心跳(Primary interconnect)¶

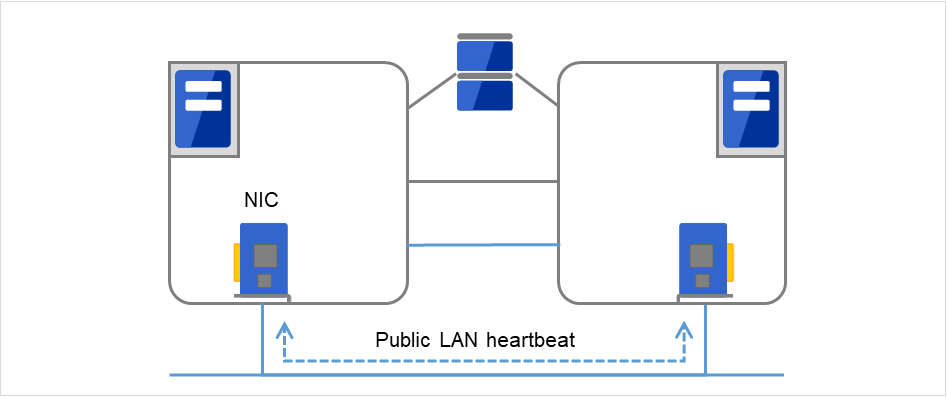

- 公网作为备用心跳线,使用与客户端进行通信的通信线路。只要是能够使用TCP/IP的NIC即可。除了确认心跳,还可以用于服务器之间的信息交换。

图 3.3 LAN心跳/内核模式LAN心跳(Secondary interconnect)¶

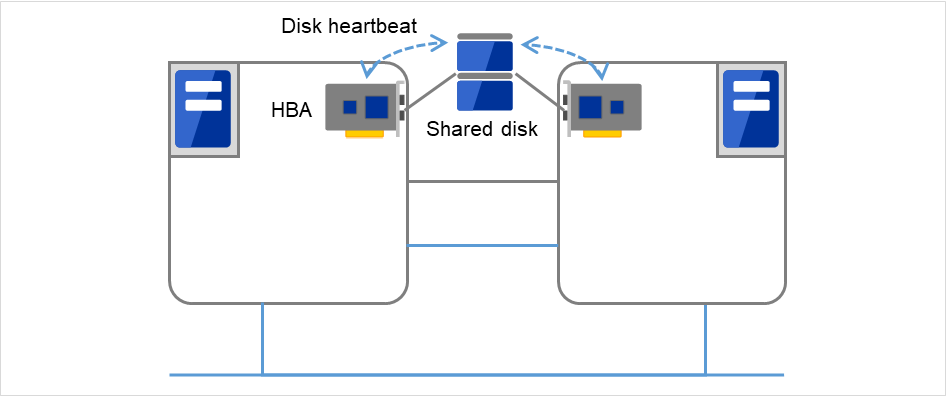

- 共享磁盘在连接到配置失效切换型集群的所有服务器上的磁盘中,创建EXPRESSCLUSTER专用分区(Cluster分区),在Cluster分区上进行心跳确认。

图 3.4 磁盘心跳¶

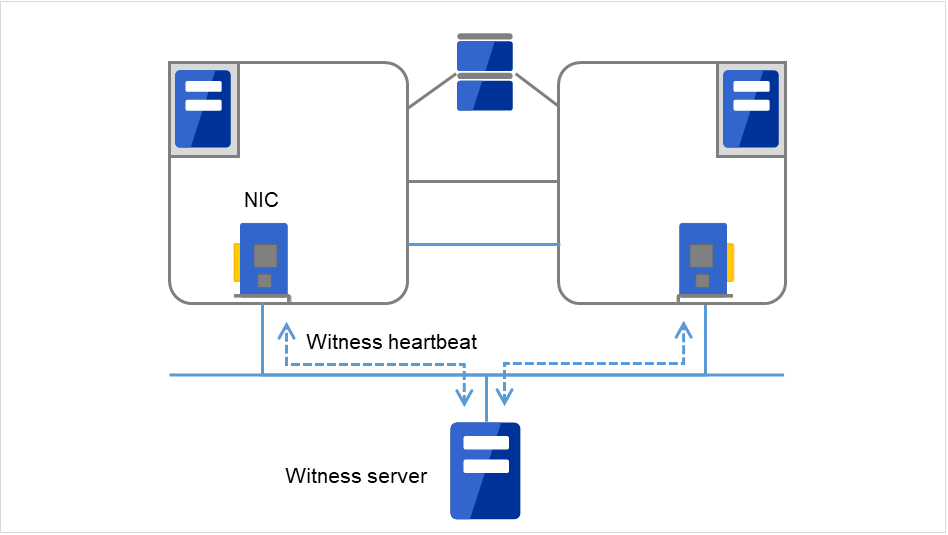

- Witness构成失效切换型集群的各服务器与运行Witness 服务器服务的外部服务器(Witness 服务器)间进行通信,通过与保持Witness 服务器的其他服务器间的通信信息确认生存。

图 3.5 Witness心跳¶

使用这些通信路径能够大幅度提高服务器间通信的可靠性,防止网络分区状态的发生。

注解

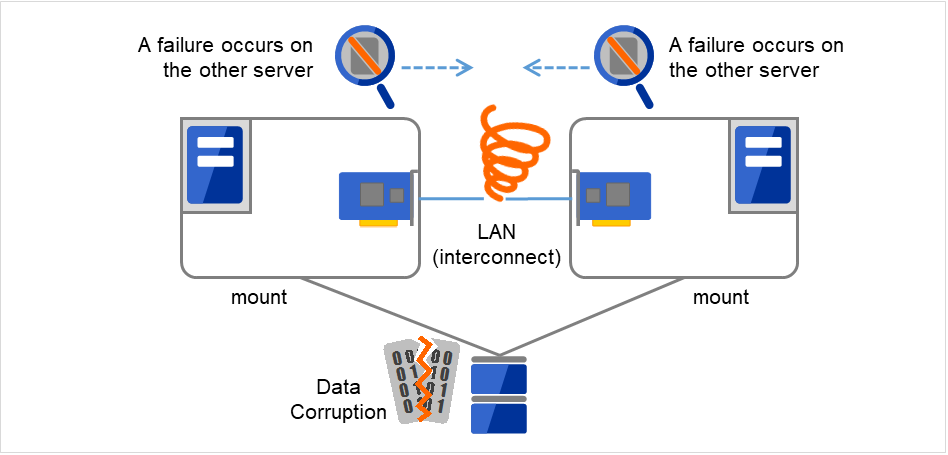

网络分区状态:集群服务器之间所有的通信线路均发生故障,造成网络性中断的状态。在不能对应网络分区状态的集群系统中,不能区分通信线路故障和服务器故障,多个服务器同时访问同一资源,就可执行造成数据损坏。

3.3.3. 何谓业务监视¶

业务监视用于监视业务应用程序自身或者造成陷入无法执行业务状态的故障原因。

- 应用程序的生存状态监视能够使用启动资源(称为EXEC资源)启动应用程序,通过监视资源(称为PID监视资源)定期监视进程的生存。在由于业务应用程序异常退出造成业务中断时有效。

注解

如果EXPRESSCLUSTER直接启动的应用程序为启动,结束监视对象的常驻进程的应用程序,则无法查出常驻进程的异常。

无法查出应用程序内部状态的异常(应用程序的停止,结果异常)。

- 资源的监视通过EXPRESSCLUSTER的监视资源能够监视集群资源(磁盘分区,IP地址等)和公网的状态。在由于必须资源异常造成业务中断时有效。

3.3.4. 何谓内部监视¶

EXPRESSCLUSTER进程的生存状态监视

3.3.5. 可监视的故障和无法监视的故障¶

EXPRESSCLUSTER 中有可监视的故障和无法监视的故障。在构建集群系统时,需要先了解哪些故障能够监视,而哪些不能监视。

3.3.6. 通过服务器监视可以查出的故障和无法查出的故障¶

监视条件:故障服务器的心跳中断

可监视的故障示例

硬件故障(OS不能继续运行)

panic

无法监视的故障示例

OS局部功能故障(仅鼠标,键盘等出现故障等)

3.3.7. 通过业务监视可以查出的故障和无法查出的故障¶

监视条件:故障应用程序的消失,持续的资源异常,与某网络设备通信的路径中断

可监视故障示例

应用程序的异常退出

共享磁盘访问故障(HBA [#s1]__的故障等)

公网NIC故障

无法监视故障示例

- 应用程序的停止/结果异常EXPRESSCLUSTER虽无法直接监视应用程序的停止/结果异常,但是可以监视应用程序,在查出异常时能够创建退出自身的程序,通过EXEC资源启动该程序,利用PID监视资源进行监视,从而使其发生失效切换。

- 1

Host Bus Adapter的缩写,不是指共有磁盘一端的适配器,而是指服务器主机一端的适配器。

3.4. Fencing 功能¶

EXPRESSCLUSTER 具有“网络分区解决”和“强制停止”作为Fencing机制。

3.4.1. 网络分区解决¶

ping方式

http方式

参见

关于网络分区解决方法设置的详细内容,请参考《参考指南》的 "网络分区解决资源的详细信息" 。

3.4.2. 强制停止¶

当检测到服务器故障时,正常的服务器可以向发生故障的服务器发出停止请求。通过将有故障的服务器迁移到停止状态,排除了业务应用同时在多台服务器上启动的可能性。强制停止的处理在失效切换开始前执行。

参见

关于设置强制停止的详细内容, 请参考《参考指南》的"强制停止资源的详细信息"。

3.5. 失效切换的原理¶

EXPRESSCLUSTER查出故障时,在开始失效切换之前会判断查出的故障是服务器的故障还是网络分区状态。之后会在正常的服务器上启动各种资源,启动业务应用程序,执行失效切换。

此时,同时移动的资源集合称为失效切换组。从使用者角度来看,可以把失效切换组看作虚拟的计算机。

注解

在集群系统中,通过在正常的节点上重启应用程序来执行失效切换。因此,在应用程序的内存上保存的执行状态不能进行失效切换。

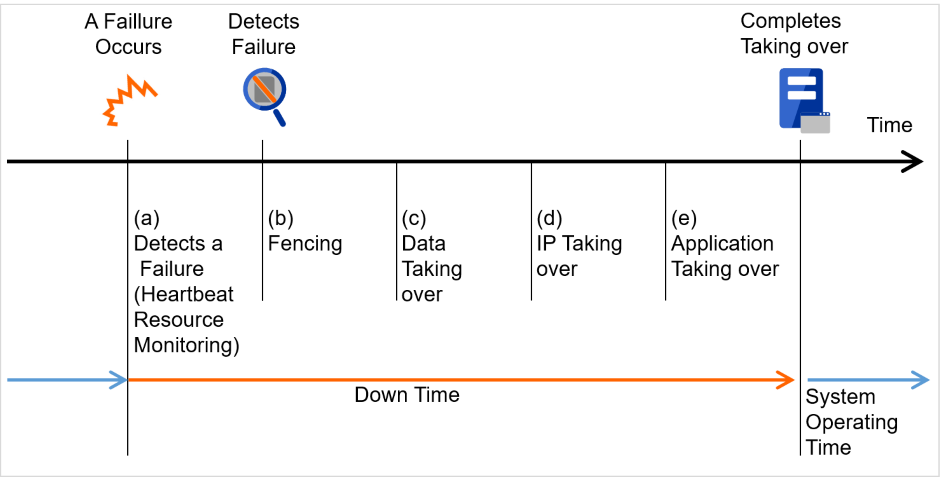

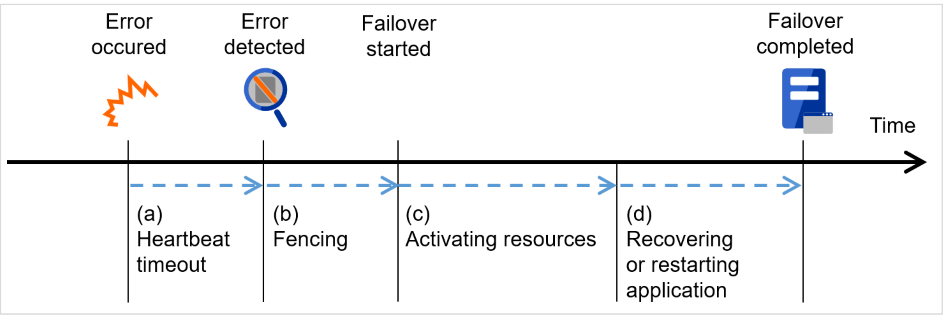

从发生故障到失效切换结束需要几分钟时间。下面是时间图。

图 3.6 失效切换的时间图¶

心跳确认超时

正在执行业务的服务器发生故障后,到待机服务器查出该故障之间的时间。

- 可以根据业务的负载调整集群属性的设置值。(出厂设置是90秒。)

Fencing

为了执行网络分区解决和强制停止的时间。

- 网络分区解决,是为了确认对方服务器的心跳的中断(心跳超时)是由于网络分区状态引起还是实际上对方服务器发生故障引起的所需时间。通常是瞬间完成确认。

- 强制停止是,对判断发生了故障的对方服务器发出停止请求。所需时间根据集群的运行环境(物理环境、虚拟环境、Cloud等)不同而有所不同。

启动各种资源

启动业务所需资源的时间。

文件系统恢复,磁盘内数据交接,IP地址交接等。

- 一般配置情况下,启动需要几秒,失效切换组中登录的资源种类数量不同,所需时间会相应变化。(具体请参考《安装&设置指南》。)

开始脚本执行时间

数据库的回滚/前滚等数据恢复时间和业务中使用的应用程序的启动时间。

通过调整Check Point Interval时间,可以预测回滚/前滚的时间。详细内容请参考各软件产品的文档。

3.5.1. 失效切换资源¶

EXPRESSCLUSTER能够作为失效切换对象的主要资源如下。

切换分区(磁盘资源等)

保存业务应用程序应该交接的数据的磁盘分区。

浮动IP地址(浮动IP资源)

使用浮动IP地址连接业务,这样客户端可以不必考虑失效切换带来的业务执行位置(服务器)的变化。

浮动IP地址通过向公网适配器动态分配IP地址和发送ARP包来实现。大多数网络设备都能通过浮动IP地址连接。

脚本(EXEC资源)

在EXPRESSCLUSTER中,从脚本启动业务应用程序。

通过共享磁盘交接的文件虽然作为文件系统是正常的,但是作为数据可执行是不完整的。在脚本中,除了启动应用程序,还记载了失效切换时业务特有的恢复处理。

注解

在集群系统中,通过在正常的节点上重启应用程序来执行失效切换。因此,在应用程序的内存上保存的执行状态不能进行失效切换。

3.5.2. 失效切换型集群的系统配置¶

失效切换型集群在集群服务器间共享磁盘阵列设备。服务器发生故障时,待机服务器使用共享磁盘上的数据交接业务。

图 3.7 失效切换型集群的系统配置¶

失效切换型集群根据运行形态分为以下几类。

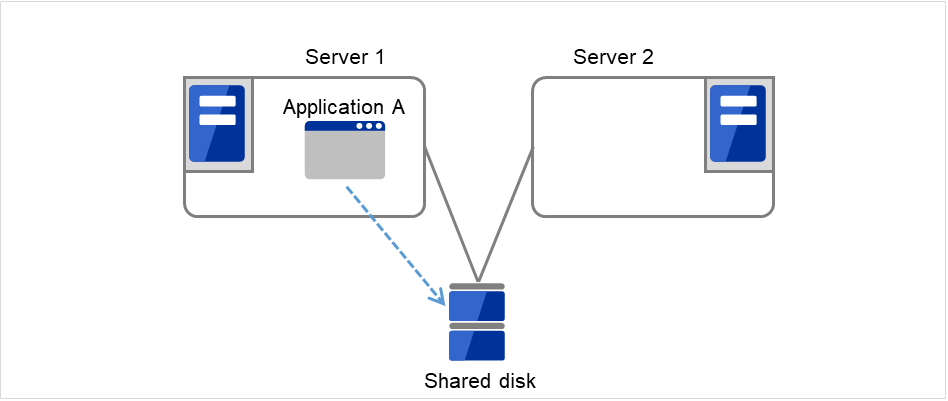

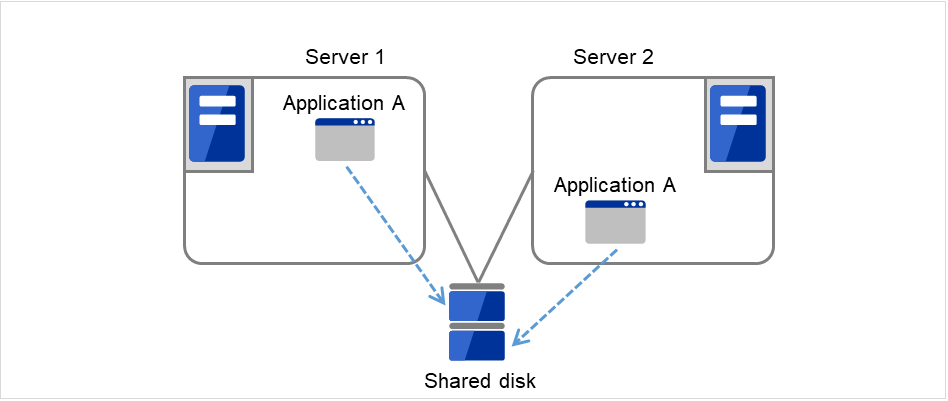

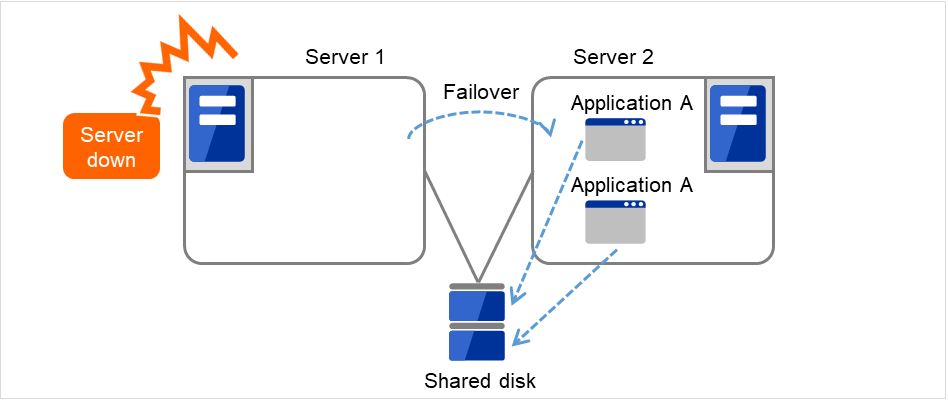

单向待机集群

其中一个服务器作为运行服务器运行业务,另外一个服务器作为待机服务器不运行业务的运行形态。这是最简单的一种运行形态,使用该形态构建的系统失效切换后性能不会降低,可用性高。

同一应用程序双向待机集群

在多个服务器上同时运行某业务应用程序,互为待机的运行形态。应用程序必须支持双向待机运行。将某业务数据分割成数份时,根据要访问的数据来更改客户端所要连接的目标服务器,可以构建以数据分割为单位的负载均衡系统。

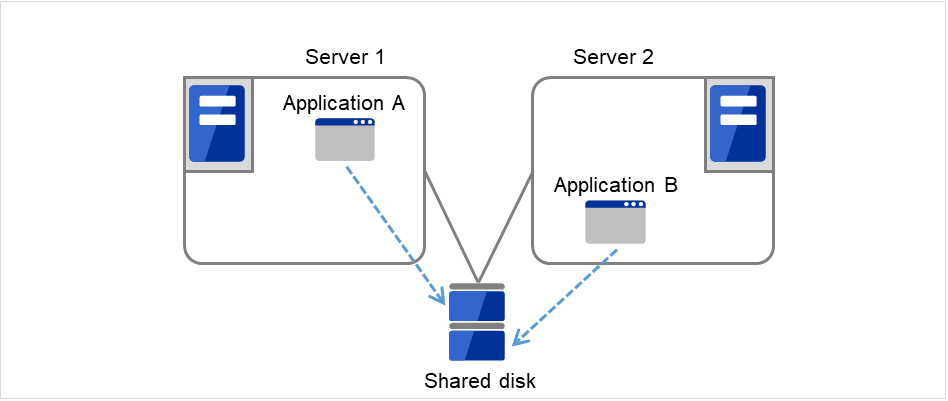

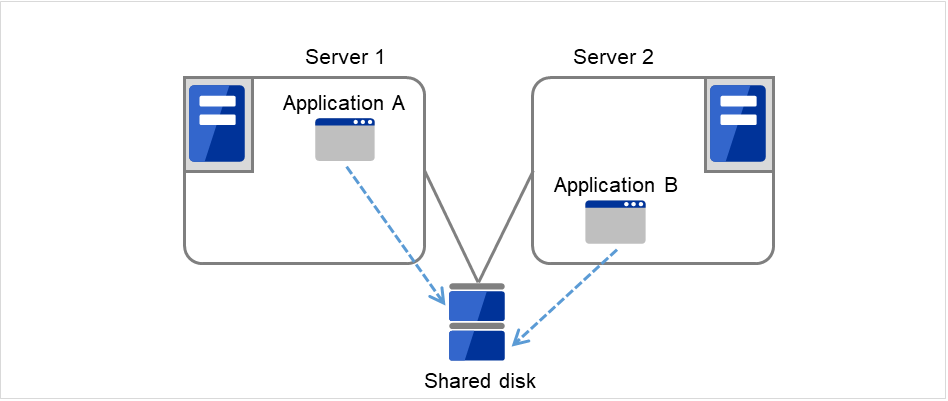

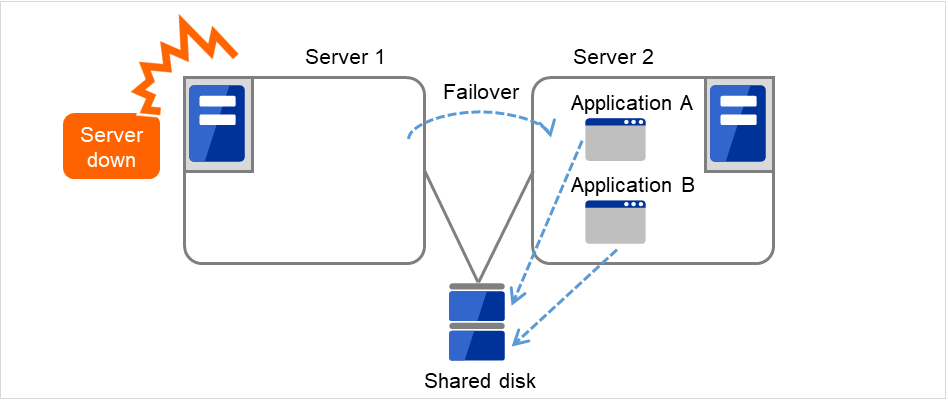

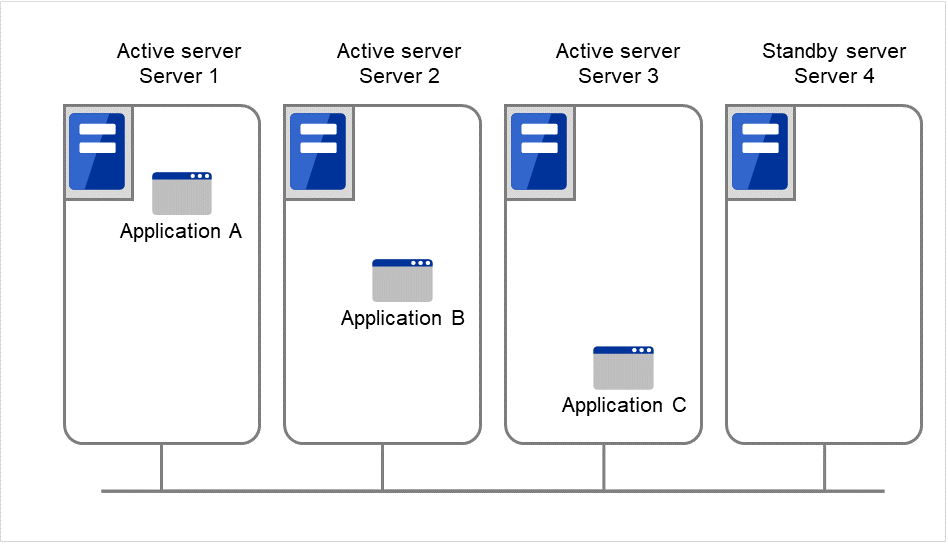

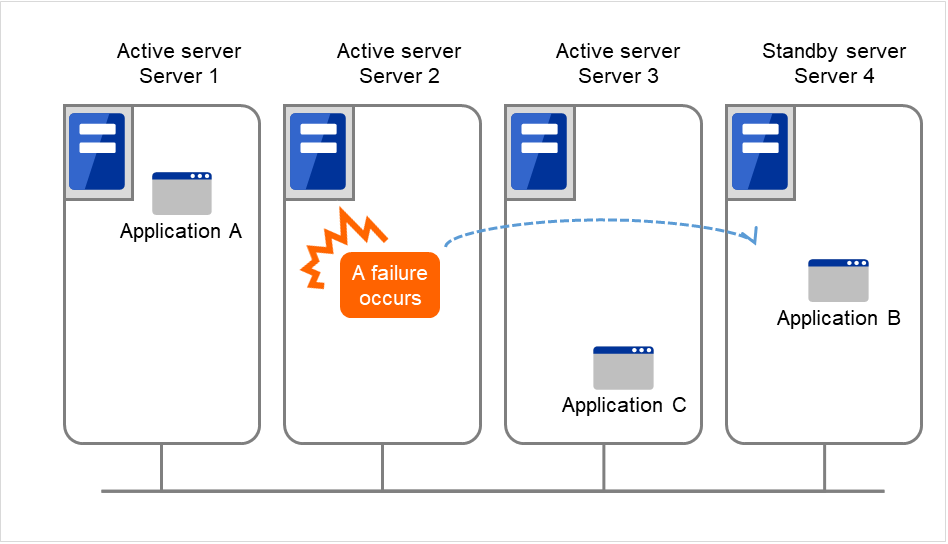

不同应用程序双向待机集群

多种业务应用程序分别在不同服务器上运行,互为待机的运行形态。应用程序没有必要一定支持双向待机运行。能够构建以业务为单位的负载均衡系统。

Application A和Application B为不同应用程序。

N + N结构

应用前面介绍的结构,可以将系统扩展为使用更多节点的结构。在下图所示的结构中,在3台服务器上执行3种业务,一旦发生问题,将把业务交接给1台待机服务器。在单向待机中,正常时的资源浪费是1/2,在此结构中正常时的资源浪费降低到1/4,而且如果1台发生故障,不会造成系统性能下降。

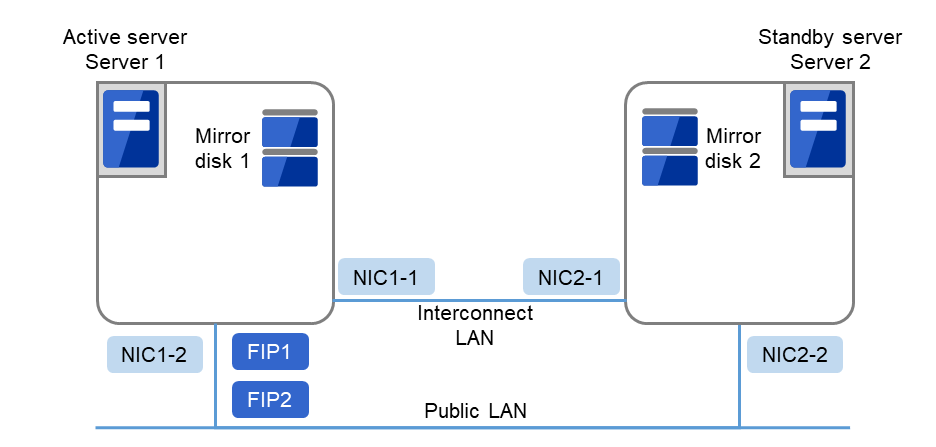

3.5.4. 镜像磁盘型的硬件配置¶

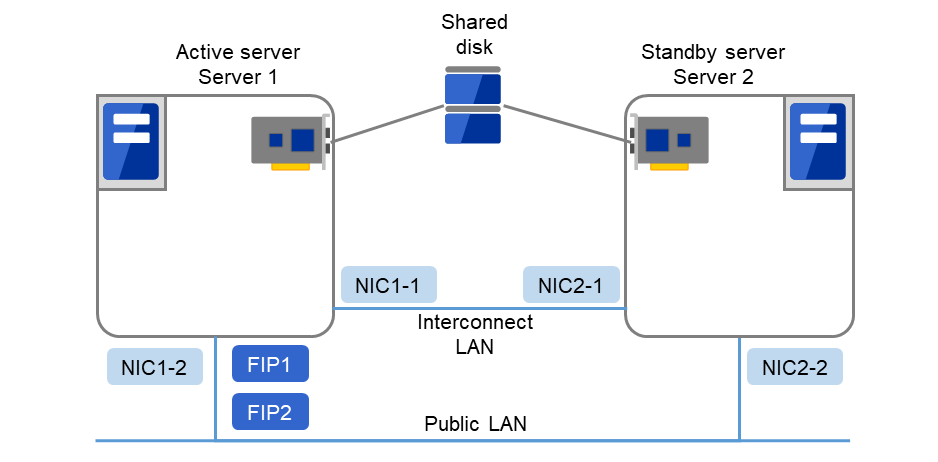

镜像磁盘型的EXPRESSCLUSTER配置如下图所示。

与共享磁盘配置相比,需要配备镜像磁盘数据复制所使用的网络,但是一般是使用EXPRESSCLUSTER的内部通信用NIC代替。

另外,镜像磁盘不依存于连接接口(IDE or SCSI)。

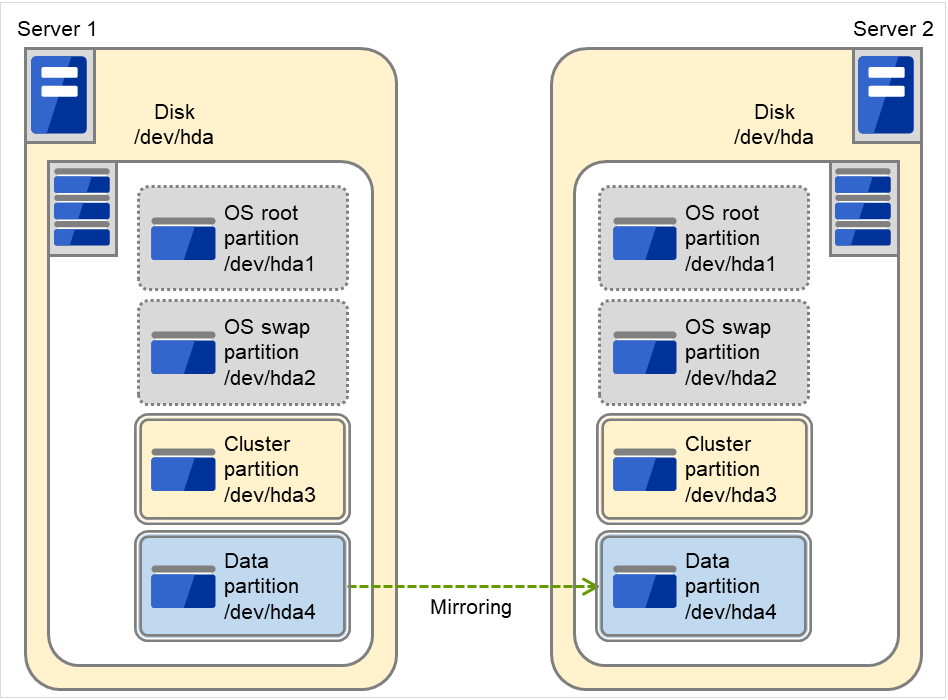

使用镜像磁盘时的集群环境示例(在安装OS的磁盘中确保集群分区和数据分区时)

在以下配置中,将安装了OS的磁盘的空闲分区作为集群分区和数据分区使用。

图 3.17 集群配置示例(1)(镜像磁盘型)¶

FIP1

10.0.0.11 (从Cluster WebUI客户端访问)

FIP2

10.0.0.12 (从业务客户端访问)

NIC1-1

192.168.0.1

NIC1-2

10.0.0.1

NIC2-1

192.168.0.2

NIC2-2

10.0.0.2

RS-232C 设备

/dev/ttyS0

OS的/boot设备

/dev/sda1

OS的swap设备

/dev/sda2

OS的/(root)设备

/dev/sda3

集群分区用设备

/dev/sda5

数据分区用设备

/dev/sda6

Mount点

/mnt/sda6

文件系统

ext3

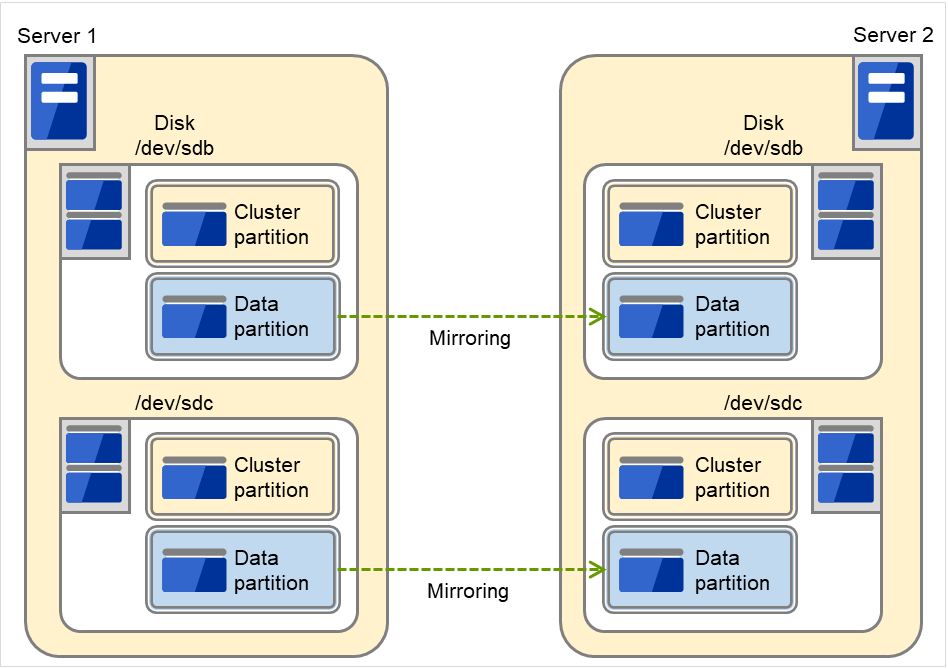

使用镜像磁盘时的集群环境示例(准备了用于集群分区和数据分区的磁盘时)

在以下配置中,已准备并连接了用于集群分区和数据分区的磁盘。

图 3.18 集群配置示例(2)(镜像磁盘型)¶

FIP1

10.0.0.11 (从Cluster WebUI客户端访问)

FIP2

10.0.0.12 (从业务客户端访问)

NIC1-1

192.168.0.1

NIC1-2

10.0.0.1

NIC2-1

192.168.0.2

NIC2-2

10.0.0.2

RS-232C 设备

/dev/ttyS0

OS的/boot设备

/dev/sda1

OS的swap设备

/dev/sda2

OS的/(root)设备

/dev/sda3

集群分区用设备

/dev/sdb1

镜像资源磁盘设备

/dev/sdb2

Mount点

/mnt/sdb2

文件系统

ext3

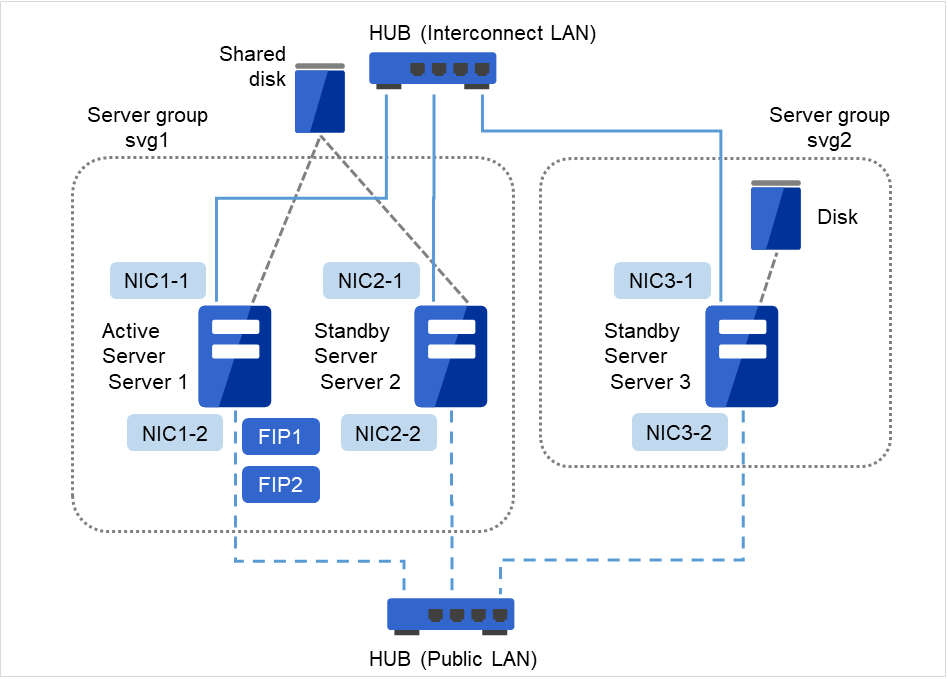

3.5.5. 共享型镜像磁盘型的硬件配置¶

共享型配置的EXPRESSCLUSTER配置如下图所示。

与共享磁盘配置相比,需要配备复制数据所使用的网络,但是一般是使用EXPRESSCLUSTER的内部通信用NIC代替。

另外,磁盘不依存于连接接口(IDE or SCSI)。

使用共享型镜像磁盘时的集群环境的示例 (在2台服务器中使用共享磁盘,并镜像第3台服务器的常规磁盘时)

图 3.19 集群配置示例(共享型镜像磁盘型)¶

FIP1

10.0.0.11 (从Cluster WebUI客户端访问)

FIP2

10.0.0.12 (从业务客户端访问)

NIC1-1

192.168.0.1

NIC1-2

10.0.0.1

NIC2-1

192.168.0.2

NIC2-2

10.0.0.2

NIC3-1

192.168.0.3

NIC3-2

10.0.0.3

共享磁盘

共享型镜像设备

/dev/NMP1

Mount点

/mnt/hd1

文件系统

ext3

集群分区用设备

/dev/sdb1

共享型镜像磁盘资源磁盘设备

/dev/sdb2

DISK心跳设备名

/dev/sdb3

Raw设备名

/dev/raw/raw1

用于共享型镜像磁盘资源的磁盘

共享型镜像设备

/dev/NMP1

Mount点

/mnt/hd1

文件系统

ext3

集群分区用设备

/dev/sdb1

共享型镜像磁盘资源磁盘设备

/dev/sdb2

3.5.6. 何谓集群对象¶

在EXPRESSCLUSTER中,使用以下结构管理各种资源。

- 集群对象配置集群的单位。

- 服务器对象表示实体服务器的对象,属于集群对象。

- 服务器组对象捆绑服务器的对象,属于集群对象。

- 心跳资源对象表示实体服务器的NW部分的对象,属于服务器对象。

- 网络分区解决资源对象表示网络分区解决机构的对象,属于服务器对象。

- 组对象表示虚拟服务器的对象,属于集群对象。

- 组资源对象表示拥有虚拟服务器的资源 (NW,磁盘)的对象,属于组对象。

- 监视资源对象表示监视机构的对象,属于集群对象。

3.6. 何谓资源¶

在EXPRESSCLUSTER中,监视端和被监视端的对象都称为资源,分类进行管理。这样不仅能够明确区分监视/被监视的对象,还能够使构建集群或查出故障时的对应更简便。资源分为心跳资源,网络分区解决资源,组资源和监视资源4类。以下简要介绍各类资源。

3.6.1. 心跳资源¶

在服务器之间互相确认生存状态所使用的资源。

现在支持的心跳资源如下所示:

- LAN心跳资源使用Ethernet的通信。

- 内核模式LAN心跳资源使用Ethernet的通信。

- 磁盘心跳资源使用共享磁盘上的特定分区(磁盘心跳分区)的通信。仅限共享磁盘配置时使用。

- Witness 心跳资源表示从Witness 服务器服务运行的外部服务器中取得的与各服务器间的通信状态。

3.6.3. 组资源¶

组成失效切换的单位——失效切换组的资源。

现在支持的组资源如下所示:

- 浮动IP资源 (fip)提供虚拟IP地址。客户端可以像普通IP地址一样访问。

- EXEC资源 (exec)提供启动/停止业务(DB,httpd,etc..)的机制。

- 磁盘资源 (disk)提供共享磁盘上的指定分区。仅限(共享磁盘)配置时使用。

- 镜像磁盘资源 (md)提供镜像磁盘上的指定分区。仅限(镜像磁盘)配置时使用。

- 共享型镜像磁盘资源 (hd)提供共享磁盘或磁盘上的指定分区。仅限(共享型镜像磁盘)配置时使用。

- 卷管理资源 (volmgr)将多个存储器及磁盘用作一个逻辑磁盘。

- 虚拟IP资源 (vip)提供虚拟IP地址。可以像访问客户端的普通IP地址一样访问虚拟IP地址。用于配置网络地址在不同区间的远程集群。

- 动态域名解析资源(ddns)将虚拟主机名及启动服务器的IP地址登录在Dynamic DNS服务器上。

- AWS Elastic IP资源 (awseip)在AWS上利用EXPRESSCLUSTER时,提供可授予Elastic IP(以下称为EIP)的机能。

- AWS虚拟IP资源 (awsvip)在AWS上利用EXPRESSCLUSTER时,提供可授予虚拟IP(以下称为VIP)的机能。

- AWS辅助IP资源 (awssip)在AWS上利用EXPRESSCLUSTER时,提供可授予辅助IP的机能。

- AWS DNS资源 (awsdns)在AWS上利用EXPRESSCLUSTER时,在Amazon Route 53上登录虚拟主机名和启动服务器的IP地址。

- Azure 探头端口资源 (azurepp)在Microsoft Azure上利用EXPRESSCLUSTER时,提供可在运行业务的节点开放特定的端口的机能。

- Azure DNS资源 (azuredns)Microsoft Azure上利用EXPRESSCLUSTER时,在Azure DNS上登录虚拟主机名和启动服务器的IP地址。

- Google Cloud 虚拟 IP 资源 (gcvip)在Google Cloud Platform上使用ExpressCluster时,提供了一种在业务运行的节点上打开特定端口的机制。

- Google Cloud DNS 资源 (gcdns)Google Cloud Platform上利用EXPRESSCLUSTER时,在Cloud DNS上登录虚拟主机名和启动服务器的IP地址。

- Oracle Cloud 虚拟 IP 资源 (ocvip)在Oracle Cloud Infrastructure上使用ExpressCluster时,提供了一种在业务运行的节点上打开特定端口的机制。

3.6.4. 监视资源¶

是集群系统内进行监视的主体资源。

现在支持的监视资源如下所示:

- 浮动 IP 监视资源 (fipw)提供浮动 IP 资源中启动的 IP 地址的监视机构。

- IP监视资源 (ipw)提供外部IP地址的监视机构。

- 磁盘监视资源 (diskw)提供磁盘的监视机构。也可以用于共享磁盘的监视。

- 镜像磁盘监视资源 (mdw)提供镜像磁盘的监视机构。

- 镜像磁盘接口监视资源 (mdnw)提供镜像磁盘接口的监视机构。

- 共享型镜像磁盘监视资源 (hdw)提供共享型镜像磁盘的监视机构。

- 共享型镜像磁盘接口监视资源 (hdnw)提供共享型镜像磁盘接口的监视机构。

- PID监视资源 (pidw)提供EXEC资源启动的进程的生存状态监视功能。

- 用户空间监视资源 (userw)提供用户空间的停止监视机构。

- NIC Link Up/Down监视资源 (miiw)提供LAN线缆的链接状态的监视机构。

- 卷管理监视资源 (volmgrw)提供多个存储器及磁盘的监视机构。

- Multi-Target监视资源 (mtw)提供捆绑多个监视资源的状态。

- 虚拟IP监视资源 (vipw)提供送出虚拟IP资源RIP包的机构。

- ARP监视资源 (arpw)提供送出浮动IP或虚拟IP资源ARP包的机构。

- 自定义监视资源 (genw)提供有进行监视处理的命令或脚本时,根据其动作结果监视系统的机构。

- 消息接收监视资源 (mrw)用于实现"设置接收异常发生通知时执行的异常时动作"及"异常发生通知的Cluster WebUI显示"的监视资源。

- 动态域名解析监视资源 (ddnsw)定期将虚拟主机名及启动服务器的IP地址登录在Dynamic DNS服务器上。

- 进程名监视资源 (psw)通过指定进程名,提供任意的进程死活监视功能。

- DB2监视资源 (db2w)提供IBM DB2数据库的监视机构。

- ftp监视资源 (ftpw)提供FTP服务器的监视机构。

- http监视资源 (httpw)提供HTTP服务器的监视机构。

- imap4监视资源 (imap4w)提供IMAP4服务器的监视机构。

- MySQL监视资源 (mysqlw)提供MySQL数据库的监视机构。

- nfs监视资源 (nfsw)提供nfs文件服务器的监视机构。

- Oracle监视资源 (oraclew)提供Oracle数据库的监视机构。

- Oracle Clusterware同步管理监视资源(osmw)提供Oracle Clusterware联动进程的监视和成员信息同步功能。

- pop3监视资源(pop3w)提供POP3服务器的监视机构。

- PostgreSQL监视资源 (psqlw)提供PostgreSQL数据库的监视机构。

- samba监视资源 (sambaw)提供samba文件服务器的监视机构。

- smtp监视资源 (smtpw)提供SMTP服务器的监视机构。

- Tuxedo监视资源 (tuxw)提供Tuxedo应用程序服务器的监视机构。

- WebSphere监视资源 (wasw)提供WebSphere应用程序服务器的监视机构。

- WebLogic监视资源 (wlsw)提供WebLogic应用程序服务器的监视机构。

- WebOTX监视资源 (otxw)提供WebOTX应用程序服务器的监视机构。

- JVM 监视资源 (jraw)提供Java VM的监视机构。

- 系统监视资源 (sraw)提供系统整体资源的监视机构。

- 进程资源监视资源(psrw)提供个别进程资源的监视机构。

- AWS Elastic IP监视资源 (awseipw)提供在AWS Elastic IP资源所附加的EIP的监视机构。

- AWS虚拟IP监视资源 (awsvipw)提供在AWS虚拟IP资源所附加的VIP的监视机构。

- AWS辅助IP监视资源 (awssipw)提供在AWS辅助IP资源所附加的辅助IP的监视机构。

- AWS AZ监视资源 (awsazw)提供Availability Zone(以下称为AZ)的监视机构。

- AWS DNS监视资源 (awsdnsw)提供在AWS DNS资源授予的虚拟主机名和IP地址的监视机构。

- Azure 探头端口监视资源 (azureppw)针对Azure探头端口资源所启动的节点提供探头端口的监视机构。

- Azure负载均衡监视资源 (azurelbw)针对Azure探头端口资源所启动的节点提供与Probe端口相同的端口号是否被开放的监视机构。

- Azure DNS监视资源 (azurednsw)提供在Azure DNS资源授予的虚拟主机名和IP地址的监视机构。

- Google Cloud 虚拟 IP 监视资源 (gcvipw)对启动了Google Cloud虚拟IP资源的节点,提供用于进行心跳存活监视的端口的监控机制。

- Google Cloud 负载均衡监视资源 (gclbw)对没有启动Google Cloud虚拟IP资源的节点,提供确认是否开放以及用于心跳存活侦测的端口相同的端口号的监控机制。

- Google Cloud DNS监视资源 (gcdnsw)提供在Google Cloud DNS资源授予的虚拟主机名和IP地址的监视机构。

- Oracle Cloud 虚拟 IP 监视资源 (ocvipw)对启动了Oracle Cloud虚拟IP资源的节点,提供用于进行心跳存活监视的端口的监控机制。

- Oracle Cloud 负载均衡监视资源 (oclbw)对没有启动Oracle Cloud虚拟IP资源的节点,提供确认是否开放以及用于心跳存活侦测的端口相同的端口号的监控机制。

4. EXPRESSCLUSTER的运行环境¶

本章介绍EXPRESSCLUSTER的运行环境。

本章介绍的项目如下。

4.1. 硬件¶

EXPRESSCLUSTER在以下架构的服务器上运行。

x86_64

IBM POWER (不支持Replicator,Replicator DR,Database Agent以外的Agent)

IBM POWER LE (不支持Replicator,Replicator DR,各Agent)

4.1.1. 规格¶

EXPRESSCLUSTER Server所需的规格如下所示。

RS-232C板卡 一个(构建3节点以上集群时不需要)

Ethernet板卡 两个以上

共享磁盘

镜像用磁盘或镜像用剩余分区

DVD-ROM驱动器

4.2. 软件¶

4.2.1. EXPRESSCLUSTER Server的运行环境¶

4.2.2. 可运行的Distribution和kernel¶

注解

EXPRESSCLUSTER X的安装光盘,可执行没有对应最新的kernel的rpm安装包。请对比确认运行环境中的kernel版本和本章记载的"可操作的Distribution和Kernel"是否相符,并安装"EXPRESSCLUSTER Version"记载的适当的版本进行升级。

独自的kernel模块 |

说明 |

|---|---|

Kernel模式LAN心跳驱动程序 |

使用Kernel模式LAN心跳资源。 |

Keepalive驱动程序

|

当用户空间监视资源的监视方法选择keepalive时使用。

当关机监视的监视方法选择keepalive时使用。

|

镜像驱动程序 |

使用镜像磁盘资源。 |

关于运行确认完毕的发布版和kernel版本信息,请参照以下的Web站点。

EXPRESSCLUSTER的Web站点-> System Requirements-> EXPRESSCLUSTER X for Linux

注解

EXPRESSCLUSTER支持的CentOS的内核版本请确认Red Hat Enterprise Linux的支持内核版本。

4.2.3. 运行确认完毕的监视选项应用程序信息¶

监视资源的监视对象的应用程序版本信息

x86_64

Oracle监视

Oracle Database 19c (19.3)

5.0.0-1~

DB2监视

DB2 V11.5

5.0.0-1~

PostgreSQL监视

PostgreSQL 14.1

5.0.0-1~

PowerGres on Linux 13.5

5.0.0-1~

MySQL监视

MySQL 8.0

5.0.0-1~

MariaDB 10.5

5.0.0-1~

SQL Server监视

SQL Server 2019

5.0.0-1~

samba监视

Samba 3.3

4.0.0-1~

Samba 3.6

4.0.0-1~

Samba 4.0

4.0.0-1~

Samba 4.1

4.0.0-1~

Samba 4.2

4.0.0-1~

Samba 4.4

4.0.0-1~

Samba 4.6

4.0.0-1~

Samba 4.7

4.1.0-1~

Samba 4.8

4.1.0-1~

Samba 4.13

4.3.0-1~

nfs监视

nfsd 2 (udp)

4.0.0-1~

nfsd 3 (udp)

4.0.0-1~

nfsd 4 (tcp)

4.0.0-1~

mountd 1(tcp)

4.0.0-1~

mountd 2(tcp)

4.0.0-1~

mountd 3(tcp)

4.0.0-1~

http监视

未指定版本

4.0.0-1~

smtp监视

未指定版本

4.0.0-1~

pop3监视

未指定版本

4.0.0-1~

imap4监视

未指定版本

4.0.0-1~

ftp监视

未指定版本

4.0.0-1~

Tuxedo监视

Tuxedo 12c Release 2 (12.1.3)

4.0.0-1~

WebLogic监视

WebLogic Server 11g R1

4.0.0-1~

WebLogic Server 11g R2

4.0.0-1~

WebLogic Server 12c R2 (12.2.1)

4.0.0-1~

WebLogic Server 14c (14.1.1)

4.2.0-1~

WebSphere监视

WebSphere Application Server 8.5

4.0.0-1~

WebSphere Application Server 8.5.5

4.0.0-1~

WebSphere Application Server 9.0

4.0.0-1~

WebOTX监视

WebOTX Application Server V9.1

4.0.0-1~

WebOTX Application Server V9.2

4.0.0-1~

WebOTX Application Server V9.3

4.0.0-1~

WebOTX Application Server V9.4

4.0.0-1~

WebOTX Application Server V10.1

4.0.0-1~

WebOTX Application Server V10.3

4.3.0-1~

JVM监视

WebLogic Server 11g R1

4.0.0-1~

WebLogic Server 11g R2

4.0.0-1~

WebLogic Server 12c

4.0.0-1~

WebLogic Server 12c R2 (12.2.1)

4.0.0-1~

WebLogic Server 14c (14.1.1)

4.2.0-1~

WebOTX Application Server V9.1

4.0.0-1~

WebOTX Application Server V9.2

4.0.0-1~

进程组监视需要进行WebOTX update

WebOTX Application Server V9.3

4.0.0-1~

WebOTX Application Server V9.4

4.0.0-1~

WebOTX Application Server V10.1

4.0.0-1~

WebOTX Application Server V10.3

4.3.0-1~

WebOTX Enterprise Service Bus V8.4

4.0.0-1~

WebOTX Enterprise Service Bus V8.5

4.0.0-1~

WebOTX Enterprise Service Bus V10.3

4.3.0-1~

JBoss Enterprise Application Platform 7.0

4.0.0-1~

JBoss Enterprise Application Platform 7.3

4.3.2-1~

Apache Tomcat 8.0

4.0.0-1~

Apache Tomcat 8.5

4.0.0-1~

Apache Tomcat 9.0

4.0.0-1~

WebSAM SVF for PDF 9.0

4.0.0-1~

WebSAM SVF for PDF 9.1

4.0.0-1~

WebSAM SVF for PDF 9.2

4.0.0-1~

WebSAM Report Director Enterprise 9.0

4.0.0-1~

WebSAM Report Director Enterprise 9.1

4.0.0-1~

WebSAM Report Director Enterprise 9.2

4.0.0-1~

WebSAM Universal Connect/X 9.0

4.0.0-1~

WebSAM Universal Connect/X 9.1

4.0.0-1~

WebSAM Universal Connect/X 9.2

4.0.0-1~

系统监视

未指定版本

4.0.0-1~

进程资源监视

未指定版本

4.1.0-1~

注解

x86_64环境中使用监视选项时,监视对象的应用程序也请使用x86_64版的应用程序。

IBM POWER

DB2监视

DB2 V10.5

4.0.0-1~

PostgreSQL监视

PostgreSQL 9.3

4.0.0-1~

PostgreSQL 9.4

4.0.0-1~

PostgreSQL 9.5

4.0.0-1~

PostgreSQL 9.6

4.0.0-1~

PostgreSQL 10

4.0.0-1~

PostgreSQL 11

4.1.0-1~

注解

IBM POWER环境中使用监视选项时,监视对象的应用程序也请使用IBM POWER版的应用程序。

4.2.4. JVM监视器的运行环境¶

使用JVM监视器时,需要可Java 的执行环境。此外,监视JBoss Enterprise Application Platform 的domain 模式时,需要安装Java(TM) SE Development Kit。

Java(TM) Runtime Environment |

Version 7.0 Update 6 (1.7.0_6) 以上 |

Java(TM) SE Development Kit |

Version 7.0 Update 1 (1.7.0_1) 以上 |

Java(TM) Runtime Environment |

Version 8.0 Update 11 (1.8.0_11) 以上 |

Java(TM) SE Development Kit |

Version 8.0 Update 11 (1.8.0_11) 以上 |

Java(TM) Runtime Environment |

Version 9.0 (9.0.1) 以上 |

Java(TM) SE Development Kit |

Version 9.0 (9.0.1) 以上 |

Java(TM) SE Development Kit |

Version 11.0 (11.0.5) 以上 |

Open JDK |

Version 7.0 Update 45 (1.7.0_45) 以上

Version 8.0 (1.8.0) 以上

Version 9.0 (9.0.1) 以上

|

4.2.5. AWS Elastic IP资源,AWS虚拟IP资源,AWS Elastic IP监视资源,AWS虚拟IP监视资源,AWS AZ监视资源的运行环境¶

想使用AWS Elastic IP资源,AWS虚拟IP资源,AWS Elastic IP监视资源,AWS虚拟IP监视资源,AWS AZ监视资源时,需要以下的软件。

软件 |

Version |

备注 |

|---|---|---|

AWS CLI |

1.6.0~

2.0.0~

|

|

Python

|

2.6.5~

2.7.5~

3.5.2~

3.6.8~

3.8.1~

3.8.3~

|

AWS CLI 附带的 Python 不可以

|

4.2.6. AWS辅助IP资源,AWS辅助IP监视资源的运行环境¶

想使用AWS辅助IP资源,AWS辅助IP监视资源时,需要以下的软件。

软件 |

Version |

备注 |

|---|---|---|

AWS CLI |

2.0.0~ |

4.2.7. AWS DNS资源,AWS DNS监视资源的运行环境¶

想使用AWS DNS资源,AWS DNS监视资源时,需要以下的软件。

软件 |

Version |

备注 |

|---|---|---|

AWS CLI |

1.11.0~ |

|

Python (Red Hat Enterprise Linux 6, Cent OS 6, SUSE Linux Enterprise Server 11, Oracle Linux 6的场合)

|

2.6.6~

3.6.5~

3.8.1~

|

AWS CLI 附带的 Python 不可以

|

Python (Red Hat Enterprise Linux 6, Cent OS 6, SUSE Linux Enterprise Server 11, Oracle Linux 6 以外的场合)

|

2.7.5~

3.5.2~

3.6.8~

3.8.1~

3.8.3~

|

AWS CLI 附带的 Python 不可以

|

4.2.8. AWS 强制停止资源的运行环境¶

想使用AWS 强制停止资源时,需要以下的软件。

软件 |

Version |

备注 |

|---|---|---|

AWS CLI |

2.0.0~ |

4.2.9. Azure 探头端口资源,Azure 探头端口监视资源,Azure负载均衡监视资源的运行环境¶

x86_64

部署模型

备注

资源管理器

4.0.0-1~

需要追加负载均衡器

4.2.10. Azure DNS资源,Azure DNS监视资源的运行环境¶

想使用Azure DNS资源,Azure DNS监视资源时,需要以下的软件。

软件 |

版本 |

备注 |

|---|---|---|

Azure CLI (Red Hat Enterprise Linux 6, Cent OS 6, Asianux Server 4, SUSE Linux Enterprise Server 11, Oracle Linux 6 的情况) |

1.0~ |

不需要Python |

Azure CLI (Red Hat Enterprise Linux 6, Cent OS 6, Asianux Server 4, SUSE Linux Enterprise Server 11, Oracle Linux 6 以外的情况) |

2.0~ |

执行了Azure DNS资源,Azure DNS监视资源运行确认的Microsoft Azure上的部署模型如下所示。Azure DNS的设置方法请参考《EXPRESSCLUSTER X Mircosoft Azure的HA Cluster构筑指南 (Linux版)》。

x86_64

资源管理器

4.0.0-1~

需要追加Azure DNS

4.2.11. Google Cloud 虚拟 IP 资源,Google Cloud 虚拟 IP 监视资源,Google Cloud 负载均衡监视资源的运行环境¶

4.2.12. Google Cloud DNS 资源,Google Cloud DNS 监视资源的运行环境¶

想使用Google Cloud DNS资源,Google Cloud DNS监视资源时,需要以下的软件。

软件

版本

备注

Google Cloud SDK

295.0.0~

4.2.13. Oracle Cloud 虚拟 IP 资源,Oracle Cloud 虚拟 IP 监视资源,Oracle Cloud 负载均衡监视资源的运行环境¶

4.2.14. OCI 强制停止资源的运行环境¶

想使用OCI 强制停止资源时,需要以下的软件。

软件 |

Version |

备注 |

|---|---|---|

OCI CLI |

3.5.3~

|

4.2.16. 所需内存容量和磁盘容量¶

所需内存容量

(用户模式)

|

200MB 2

|

|---|---|

所需内存容量

(内核模式)

|

同步模式时

1MB +(请求队列数×I/O大小)+

(2MB+差分Bitmap大小)×(镜像磁盘资源,共享型镜像磁盘资源数)

异步模式时

1MB +{请求队列数}×{I/O大小}

+[3MB

+({I/O大小}×{异步队列数})

+({I/O大小}÷ 4KB × 8字节 + 0.5KB)× ({历史文件大小限制值}÷{I/O大小}+{异步队列数})

+{差分Bitmap大小}

]×(镜像磁盘资源,共享型镜像磁盘资源数)

内核模式 LAN心跳驱动程序时

8MB

KeepAlive驱动程序时

8MB

|

所需磁盘容量

(安装后)

|

300MB

|

所需磁盘容量

(运行时)

|

5.0GB + 1.0GB 3

|

注解

I/O大小的标准如下所示。

关于请求队列数,异步队列数的设置值,请参考《参考指南》的"组资源的详细信息"的"理解镜像磁盘资源"。

关于磁盘心跳资源使用的分区所需的大小,请参考"关于共享磁盘"。

关于集群分区所需的大小请参考"关于镜像用磁盘","关于共享型镜像磁盘资源用磁盘"。

4.3. Cluster WebUI 的运行环境¶

4.3.1. 运行确认完毕的OS,浏览器¶

现在的支持情况如下。

浏览器 |

语言 |

|---|---|

Internet Explorer 11 |

日文/英文/中文 |

Internet Explorer 10 |

日文/英文/中文 |

Firefox |

日文/英文/中文 |

Google Chrome |

日文/英文/中文 |

Microsoft Edge (Chromium) |

日文/英文/中文 |

注解

通过IP地址连接时,需要事先将该IP地址登录到 [本地Intranet] 的 [站点] 中。

注解

用 Internet Explorer11连接Cluster WebUI时,Internet Explorer可执行会停止。为了避免发生,请更新Internet Explorer(KB4052978或更高版本)。此外,为了在Windows 8.1/Windows Server 2012R2中应用KB4052978以上的版本,请提前应用KB2919355。相关信息请参考Microsoft部署的信息。

注解

不支持平板电脑和智能手机等移动设备。

4.3.2. 所需内存容量/磁盘容量¶

所需内存容量 500MB以上

所需磁盘容量 200MB以上

5. 最新版本信息¶

在本章中对EXPRESSCLUSTER的最新信息进行说明。为您介绍新发布版本中强化和改善的内容。

5.1. EXPRESSCLUSTER和手册的对应表¶

本手册中以下列版本的EXPRESSCLUSTER为前提进行说明。请注意EXPRESSCLUSTER的版本和手册的版本。

EXPRESSCLUSTER内部版本 |

手册 |

版本数 |

备注 |

|---|---|---|---|

5.0.1-1 |

开始指南 |

第2版 |

|

安装&设置指南 |

第1版 |

||

参考指南 |

第2版 |

||

维护指南 |

第1版 |

||

硬件整合指南 |

第1版 |

5.2. 功能强化¶

对于各个版本,分别进行了以下的功能强化。

No |

内部版本 |

功能强化项目 |

|---|---|---|

1 |

5.0.0-1 |

支持新发布的kernel。 |

2 |

5.0.0-1 |

支持Ubuntu 20.04.3 LTS。 |

3 |

5.0.0-1 |

支持SUSE LINUX Enterprise Server 12 SP3。 |

4 |

5.0.0-1 |

随着主版本升级,部分功能被移除。 详细信息请参考功能删除列表。 |

5 |

5.0.0-1 |

添加了当服务器宕机时为整个集群集体抑制失效切换的功能。 |

6 |

5.0.0-1 |

当由于检测到组资源的启动·停止异常时以及监视资源异常时的最终动作而重新启动服务器的次数被重置时,将会通过警报日志通知。 |

7 |

5.0.0-1 |

在动态失效切换以外的自动失效切换中,可以从失效切换目标中排除在指定的监视资源中检测出异常的服务器。 |

8 |

5.0.0-1 |

添加了用于添加防火墙规则的clpfwctrl 命令。 |

9 |

5.0.0-1 |

添加了 AWS 辅助 IP 资源和 AWS 辅助 IP 监视资源。 |

10 |

5.0.0-1 |

使用 BMC 的强制停止功能已更新为 BMC 强制停止资源。 |

11 |

5.0.0-1 |

虚拟机强制停止功能已更新为 vCenter 强制停止资源。 |

12 |

5.0.0-1 |

AWS环境的强制停止功能已添加到强制停止资源中。 |

13 |

5.0.0-1 |

OCI环境的强制停止功能已添加到强制停止资源中。 |

14 |

5.0.0-1 |

强制停止脚本已更新为自定义强制停止资源。 |

15 |

5.0.0-1 |

添加了一项功能,将伴随 OS 关闭的所有操作(例如检测到监视异常时的恢复操作等)更改为 OS 重新启动。 |

16 |

5.0.0-1 |

改进了有关组之间开始和停止等待处理的警报消息。 |

17 |

5.0.0-1 |

资源启动属性的设置值可以在clpstat的设置信息的显示选项中显示。 |

18 |

5.0.0-1 |

即使在本地服务器为集群停止状态,也可以使用clpcl/clpstdn命令指定-h选项。 |

19 |

5.0.0-1 |

使用非真实 IP 地址连接到 Cluster WebUI 并切换到设置模式时,会输出警告消息。 |

20 |

5.0.0-1 |

可以在Cluster WebUI的设置模式中在已注册组资源的状态下删除组。 |

21 |

5.0.0-1 |

更改了 Cluster WebUI 中发生通信超时时的错误消息的内容。 |

22 |

5.0.0-1 |

更改了 Cluster WebUI 的镜像磁盘画面上执行完整复制等失败时的错误消息的内容。 |

23 |

5.0.0-1 |

添加了可以复制Cluster WebUI 的设置模式下注册的组、组资源、监视资源的功能。 |

24 |

5.0.0-1 |

添加了在Cluster WebUI 的设置模式下,将注册的组资源移动到其他组的功能。 |

25 |

5.0.0-1 |

可以在Cluster WebUI的设置模式下从[组的属性]的组资源列表中更改设置。 |

26 |

5.0.0-1 |

可以在Cluster WebUI的设置模式下从[监视通用属性]的监视资源列表中更改设置。 |

27 |

5.0.0-1 |

可在Cluster WebUI的设置模式中显示组资源停止时的依赖关系。 |

28 |

5.0.0-1 |

添加了在Cluster WebUI 的设置模式中显示组资源启动时以及停止时的依赖关系图的功能。 |

29 |

5.0.0-1 |

添加了在Cluster WebUI 的状态画面中按照组资源/监视资源的类型和资源名缩小范围检索的功能。 |

30 |

5.0.0-1 |

用户空间监视资源、动态DNS监视资源支持集群统计信息功能。 |

31 |

5.0.0-1 |

WebManager 服务使用HTTPS 作为通信方式时,可以使用中间证书作为证书文件。 |

32 |

5.0.0-1 |

添加了clpcfconv.sh命令,将集群配置信息文件从旧版本转换为当前版本。 |

33 |

5.0.0-1 |

添加了OS启动时延迟启动集群服务的功能。 |

34 |

5.0.0-1 |

扩展了集群配置信息检查功能的检查项目。 |

35 |

5.0.0-1 |

Cluster WebUI的集群配置信息检查的错误结果中,可以显示处理方法等详细内容。 |

36 |

5.0.0-1 |

可以在指定 clpcfset 命令的create选项时指定OS类型。 |

37 |

5.0.0-1 |

添加了在 clpcfset 命令中添加 del 选项,并从集群配置信息中删除资源和参数的功能。 |

38 |

5.0.0-1 |

添加了增强clpcfset命令界面的clpcfadm.py命令。 |

39 |

5.0.0-1 |

更改了 AWS DNS 资源的启动完成时间,是在确认记录集已经传播到AWS Route53后启动的。 |

40 |

5.0.0-1 |

AWS DNS监视资源的监视开始等待时间的默认值更改为300秒。 |

41 |

5.0.0-1 |

对于不应该受到磁盘IO延迟影响的监视资源进行了改进,使得如果监视进程在磁盘等待休眠状态(D状态)超时,则判断为警告而不是异常。 |

42 |

5.0.0-1 |

clpstat命令可以二重启动。 |

43 |

5.0.0-1 |

添加了Node Manager服务。 |

44 |

5.0.0-1 |

添加了心跳统计信息功能。 |

45 |

5.0.0-1 |

HTTP NP解决资源中,即使在不使用Witness心跳资源时,也可以使用Proxy服务器。 |

46 |

5.0.0-1 |

支持SELinux的Enforcing模式。 |

47 |

5.0.0-1 |

HTTP监视资源支持Digest认证。 |

48 |

5.0.0-1 |

可以在FTP监视资源中监视使用FTPS的FTP服务器。 |

49 |

5.0.0-1 |

JVM监视资源的JBoss EAP域模式可以在Java 9 及更高版本上进行监视。 |

5.3. 修改信息¶

各版本做了以下修改。

No.

|

修改版本

/ 发生版本

|

修改项目

|

重要性

|

发生条件

发生频率

|

|---|---|---|---|---|

1 |

5.0.0-1

/ 1.0.0-1~4.3.2-1

|

组资源单体启动成功时,同组内的其他组资源会执行恢复操作。

|

小 |

在存在启动异常状态的组资源的状态下,同组内的其他组资源单体启动时会发生。 |

2 |

5.0.0-1

/ 4.1.0-1~4.3.2-1

|

Cluster WebUI 的设定模式下修改组资源的"注释"时,修改内容可能会没有被更新。 |

小 |

在修改组资源的"注释"并按下[适用]按钮后,如将"注释"返回到修改前的状态并点击[OK]按钮时会有修改内容没有被更新的情况。 |

3 |

5.0.0-1

/ 4.1.0-1~4.3.2-1

|

Cluster WebUI 的设定模式下修改监视资源的"注释"时,修改内容可能会没有被更新。 |

小 |

在修改监视资源的"注释"并按下[适用]按钮后,如将"注释"返回到修改前的状态并点击[OK]按钮时会有修改内容没有被更新的情况。

|

4 |

5.0.0-1

/ 4.0.0-1~4.3.2-1

|

在 Cluster WebUI 的状态画面上执行集群操作时,如果发生通信超时,则会再次发出相同的请求。 |

中 |

如果Cluster WebUI和集群服务器之间发生通信超时,则一定会发生该情况。 |

5 |

5.0.0-1

/ 4.1.0-1~4.3.2-1

|

Cluster WebUI 的设定模式下设置依赖关系时,Cluster WebUI 可能会冻结。 |

小 |

2个组资源互相依赖时发生。 |

6 |

5.0.0-1

/ 4.2.0-1~4.3.2-1

|

Clpstat命令的应答可能会延迟。 |

小 |

和其他服务器的通信切断时会发生。 |

7 |

5.0.0-1

/ 3.1.0-1~4.3.2-1

|

集群服务可能不会停止。 |

小 |

在执行集群服务停止时极小可能会发生。 |

8 |

5.0.0-1

/ 4.0.0-1~4.3.2-1

|

监视资源可能会错误地检测到监视超时。 |

中 |

在执行监视资源的监视处理时极小可能会发生。 |

9 |

5.0.0-1

/ 4.2.0-1~4.3.2-1

|

如果使用 clpcfchk 命令通过"-o"选项指定上一次检查结果文件所在的目录,则上一次检查结果将与当前检查结果混合在一起。 |

小 |

在 clpcfchk 命令的"-o"选项中指定上一个检查结果文件 (cfchk_result.csv) 所在的目录时发生。 |

10 |

5.0.0-1

/ 4.3.0-1~4.3.2-1

|

与集群配置检查的 fstab 相关的检查处理可能会失败。 |

小 |

当/etc/fstab的设备名和mount point的路径以"/"结尾时发生。 |

11 |

5.0.0-1

/ 4.3.0-1~4.3.2-1

|

clpcfset 命令可能会异常终止。 |

小 |

属性值中指定了空字符串时会发生。 |

12 |

5.0.0-1

/ 4.0.0-1~4.3.2-1

|

在AWS环境中,强制停止的脚本可能会超时。 |

小 |

在AWS环境中执行强制停止脚本时会发生。 |

13 |

5.0.0-1

/ 4.2.0-1~4.3.2-1

|

HTTP方式的NP解决资源中,当目标响应为状态编码301时会异常。 |

小 |

响应为状态编码301时才会发生。 |

14 |

5.0.0-1

/ 4.0.0-1~4.3.2-1

|

"客户端会话超时"可能在 WebManager 服务中不起作用。 |

小 |

在"客户端会话超时"过去之前未发出下一个请求时会发生。 |

15 |

5.0.0-1

/ 4.0.0-1~4.3.2-1

|

使用共享型(hybrid)镜像磁盘资源时,Cluster WebUI 的状态画面和镜像磁盘画面的服务器显示顺序不一致。 |

小 |

状态画面的服务器显示顺序是优先顺序,镜像磁盘画面的服务器显示顺序是按照所属服务器组的服务器组名的升序排列的,因此当依赖服务器组名时判断时会发生。 |

16 |

5.0.0-1

/ 4.0.0-1~4.3.2-1

|

监视资源的监视处理超时时,可能需要花费一段时间才能检测到监视异常。 |

小 |

监视资源的监视处理超时时极少情况下会发生。 |

17 |

5.0.0-1

/ 1.0.0-1~4.3.2-1

|

当设置了IP监视资源和PING NP解决资源时,可能会发送大量的ICMP包。 |

小 |

在 ICMP 通信处理期间收到意外数据包时发生。 |

18 |

5.0.0-1

/ 4.0.0-1~4.3.2-1

|

将进程资源监视资源的[内存使用量监视]的[持续时间(分)]的表述修改为[最大更新次数(次)]。 |

小 |

在使用 Cluster Web UI 或 clpstat 命令显示属性时发生。 |

19 |

5.0.0-1

/ 3.3.2-1~4.3.2-1

|

当镜像磁盘连接为断开状态时,镜像磁盘相关命令的响应可能会慢。 |

小 |

在多个镜像磁盘连接中,优先度高的为断线状态时会发生。 |

20 |

5.0.0-1

/ 1.0.0-1~4.3.2-1

|

磁盘类型为"raw"的磁盘资源停止可能会失败。 |

小 |

当磁盘资源的磁盘类型为"raw",且资源停止时有进程访问设备时会发生。

|

21 |

5.0.0-1

/ 1.0.0-1~4.3.2-1

|

当镜像磁盘连接断开时,OS可能会间歇性停止响应。 |

小 |

如果镜像磁盘资源或者共享型镜像磁盘资源的模式为"非同步",且发生断开连接时 I/O 负载较高,则可能会发生。 |

22 |

5.0.0-1

/ 4.2.0-1~4.3.2-1

|

EXPRESSCLUSTER Information Base服务可能会异常终止。 |

小 |

当执行以下任一操作时,极小概率会发生发生。

- 集群启动

- 集群停止

- 集群挂起

- 集群恢复

|

23 |

5.0.1-1

/ 5.0.0-1

|

Ubuntu环境下集群配置信息文件转换命令clpcfconv.sh会失败。 |

小 |

在Ubuntu环境下会发生。 |

24 |

5.0.1-1

/ 5.0.0-1

|

当EXPRESSCLUSTER X 3.3 for Linux创建的集群配置信息文件被集群配置信息文件转换命令转换并应用于集群时,镜像代理无法启动。 |

中 |

从 EXPRESSCLUSTER X 3.3 for Linux 升级时使用磁盘镜像资源/共享型镜像磁盘资源时发生。 |

25 |

5.0.1-1

/ 5.0.0-1

|

clprexec 命令的 --script 选项无效。 |

小 |

指定 --script 选项,执行 clprexec 命令时发生。 |

26 |

5.0.1-1

/ 5.0.0-1

|

使用 clpcfset 命令添加强制停止资源时,集群启动失败。 |

小 |

使用clpcfset命令,启动添加了强制停止资源的集群配置信息的集群时发生。 |

27 |

5.0.1-1

/ 5.0.0-1

|

在Amazon Linux 2 环境中无法正常启动内核模式LAN心跳。 |

中 |

在 Amazon Linux 2 环境中发生。 |

28 |

5.0.1-1

/ 4.3.0-1~4.3.2-1,5.0.0-1

|

在使用了ext4文件系统的镜像磁盘资源以及共享型镜像磁盘资源中,通过完全复制进行镜像恢复时,可能无法将正确数据复制到复制目标中。 |

大 |

在使用了ext4文件系统的镜像磁盘资源以及共享型镜像磁盘资源中,通过完全复制进行镜像恢复时发生。 |

29 |

5.0.1-1

/ 4.3.2-1,5.0.0-1

|

在 Oracle 监视资源中,发生监视超时时,重试处理可能无法正常工作。 |

中 |

在 Oracle 监视资源中的监视处理超时时发生。 |

6. 注意限制事项¶

本章将阐述注意事项,现有问题及其避免方法。

本章阐述事项如下。

6.1. 研究系统配置时¶

下文将阐述准备HW,可选产品License,构筑系统和配置共享磁盘时的注意事项。

6.1.1. 功能列表与所需License¶

下述可选产品需要同服务器个数相当的license。

没有进行License登录的资源,监视器资源不会显示在Cluster WebUI的一览表中。

想要使用的功能 |

所需License |

|---|---|

镜像磁盘资源 |

EXPRESSCLUSTER X Replicator 5.0 4 |

共享型镜像磁盘资源 |

EXPRESSCLUSTER X Replicator DR 5.0 5 |

Oracle监视器资源 |

EXPRESSCLUSTER X Database Agent 5.0 |

DB2监视器资源 |

EXPRESSCLUSTER X Database Agent 5.0 |

PostgreSQL监视器资源 |

EXPRESSCLUSTER X Database Agent 5.0 |

MySQL监视器资源 |

EXPRESSCLUSTER X Database Agent 5.0 |

SQL Server监视器资源 |

EXPRESSCLUSTER X Database Agent 5.0 |

ODBC监视器资源 |

EXPRESSCLUSTER X Database Agent 5.0 |

Samba监视器资源 |

EXPRESSCLUSTER X File Server Agent 5.0 |

nfs监视器资源 |

EXPRESSCLUSTER X File Server Agent 5.0 |

http监视器资源 |

EXPRESSCLUSTER X Internet Server Agent 5.0 |

smtp监视器资源 |

EXPRESSCLUSTER X Internet Server Agent 5.0 |

pop3监视器资源 |

EXPRESSCLUSTER X Internet Server Agent 5.0 |

imap4监视器资源 |

EXPRESSCLUSTER X Internet Server Agent 5.0 |

ftp监视器资源 |

EXPRESSCLUSTER X Internet Server Agent 5.0 |

Tuxedo监视器资源 |

EXPRESSCLUSTER X Application Server Agent 5.0 |

WebLogic监视器资源 |

EXPRESSCLUSTER X Application Server Agent 5.0 |

WebSphere监视器资源 |

EXPRESSCLUSTER X Application Server Agent 5.0 |

WebOTX监视器资源 |

EXPRESSCLUSTER X Application Server Agent 5.0 |

JVM监视器资源 |

EXPRESSCLUSTER X Java Resource Agent 5.0 |

系统监视器资源 |

EXPRESSCLUSTER X System Resource Agent 5.0 |

进程资源监视资源 |

EXPRESSCLUSTER X System Resource Agent 5.0 |

邮件通报功能 |

EXPRESSCLUSTER X Alert Service 5.0 |

网络警告灯 |

EXPRESSCLUSTER X Alert Service 5.0 |

6.1.2. 关于镜像磁盘的需求¶

通过Linux的md设定的等量磁盘组,卷组,镜像链接,带奇偶校验的等量磁盘组,不能作为镜像磁盘资源的集群分区或数据分区来使用。

- 通过Linux的 LVM,可将卷作为集群分区或数据分区来使用。但是,在SuSE上不能通过LVM或MultiPath将卷作为集群分区或数据分区来使用。(这是因为在SuSE上,针对这些卷,EXPRESSCLUSTER无法进行ReadOnly,ReadWrite的控制。)

作为镜像磁盘资源使用的磁盘不支持基于Linux的md的Stripe Set,Volume Set,磁盘镜像建立,带校验的Stripe Set的功能。

使用镜像磁盘资源时需要镜像用的分区(数据分区和集群分区)。

确保镜像用分区有以下2个方法:

和OS(root分区或swap分区)在同一磁盘上确保镜像用的分区(集群分区和数据分区)

和OS准备(添加)其他磁盘(或者LUN)确保镜像用的分区

可以参考以下条目来选择上面的某种方法。

- 重视故障维护,性能时- 建议在OS之外另外准备镜像用磁盘。

- 受H/W Raid规格的限制无法添加LUN时用H/W Raid的预装模式难于更改LUN的配置时- 在同一OS上确保磁盘的镜像用分区。

- 使用多个镜像磁盘资源时,建议为每个镜像磁盘资源准备(添加)磁盘。在同一磁盘上确保使用多个镜像磁盘资源时,可执行出现性能低下或镜像恢复时间较长现象。这与访问Linux OS磁盘的性能相关。

将磁盘作为镜像用磁盘使用时,需要在各服务器间使用相同磁盘。

磁盘接口

请统一用于确保双方服务器镜像磁盘或镜像用分区的磁盘的接口。

例)

组合

服务器1

服务器2

OK

SCSI

SCSI

OK

IDE

IDE

NG

IDE

SCSI

磁盘类型

请统一用于确保双方服务器镜像磁盘或镜像用分区的磁盘的类型。

例)

组合

服务器1

服务器2

OK

HDD

HDD

OK

SSD

SSD

NG

HDD

SSD

磁盘的扇区大小

请统一用于确保双方服务器镜像磁盘或镜像用分区的磁盘的逻辑扇区大小。

例)

组合

服务器1

服务器2

OK

逻辑扇区512B

逻辑扇区512B

OK

逻辑扇区4KB

逻辑扇区4KB

NG

逻辑扇区512B

逻辑扇区4KB

各服务器间作为镜像用磁盘使用的磁盘几何数据不同时,请注意以下事项:

用fdisk等命令确保的分区容量按照柱面附近的块(单元)数分配。请确保数据分区,以使数据分区容量和初始镜像构筑方向形成如下关系。复制来源服务器 ≦ 复制目标服务器

复制来源服务器是指镜像磁盘资源所属的失效切换组中失效切换原则较高的服务器。复制目标服务器是指镜像磁盘资源所属的失效切换组中失效切换原则较低的服务器。

另外,数据分区的大小在复制源和复制目标处差别较大时,有时会出现初始镜像构筑失败。请确保数据分区为相同程度的大小。

另外,请注意数据分区的大小在复制来源端和复制目标端上不要超过32GiB, 64GiB, 96GiB, ... (32GiB的倍数)。若数据分区的大小超过32GiB的倍数时,构建初始镜像时有可执行会失败。请确保数据分区的大小为相同程度。

例)

组合

数据分区的大小

说明

服务器1侧

服务器2侧

OK

30GiB

31GiB

由于双方均在0~32GiB不足的范围内,因此OK

OK

50GiB

60GiB

由于双方均在2GiB以上~64GiB不足的范围内,因此OK

NG

30GiB

39GiB

由于超过了32GiB,因此NG

NG

60GiB

70GiB

由于超过了64GiB,因此NG

6.1.4. 关于作为共享型镜像磁盘使用的磁盘的需求¶

作为共享型镜像磁盘资源使用的磁盘不支持基于Linux的md的Stripe Set,Volume Set,镜像化,带校验的Stripe Set的功能。

- 通过Linux的 LVM,可将卷作为集群分区或数据分区来使用。但是,在SuSE上不能通过LVM或MultiPath将卷作为集群分区或数据分区来使用。(这是因为在SuSE上,针对这些卷,EXPRESSCLUSTER无法进行ReadOnly,ReadWrite的控制。)

使用共享型镜像磁盘资源时需要共享型镜像磁盘用的分区(数据分区和集群分区)。

使用共享磁盘装置确保共享型镜像磁盘用的磁盘时,需要有通用共享磁盘装置的服务器之间的磁盘心跳资源用的分区。

从非共享磁盘装置确保共享型镜像磁盘用的磁盘时,分区的确保方法有以下2种。

在同一OS(root分区或swap分区)中的磁盘上确保共享型镜像磁盘用分区(集群分区和数据分区)

准备(添加)不在同一OS上的磁盘(或者LUN),确保共享型镜像磁盘用的分区

可以参考以下条目来选择上面的某种方法。

- 重视故障维护,性能时- 建议在OS之外另外准备共享型镜像磁盘用磁盘。

- 受H/W Raid规格的限制无法添加LUN时用H/W Raid的预装模式难于更改LUN的配置时- 在同一OS上确保磁盘的共享型镜像磁盘用分区。

确保共享型镜像磁盘资源的装置

必要的分区的种类

共享磁盘装置

非共享型磁盘装置

数据分区

必要

必要

集群分区

必要

必要

磁盘心跳用分区

必要

不要

确保和OS同一磁盘(LUN)

-

可执行

- 使用多个共享型镜像磁盘资源时,建议为每个共享型镜像磁盘资源单独准备(添加)LUN。在同一磁盘上确保使用多个共享型镜像磁盘资源时,可执行出现性能低下或镜像恢复时间较长的现象。这与访问Linux OS磁盘的性能相关。

各服务器间作为共享型镜像磁盘用磁盘所使用的磁盘的种类及几何数据不同时,请注意以下事项:

请确保数据分区的容量和初始镜像构筑方向形成如下关系

复制来源服务器 ≦ 复制目标服务器

复制来源服务器是指共享型镜像磁盘资源所属的失效切换组中失效切换原则较高的服务器。复制目标服务器是指共享型镜像磁盘资源所属的失效切换组中失效切换原则较低的服务器

另外,数据分区的大小在复制源和复制目标处差别较大时,有时会出现初始镜像构筑失败。请确保数据分区为相同程度的大小。

另外,请注意数据分区的大小在复制来源端和复制目标端上不要超过32GiB, 64GiB, 96GiB, ... (32GiB的倍数)。若数据分区的大小超过32GiB的倍数时,构建初始镜像时有可执行会失败。请确保数据分区的大小为相同程度。

例)

组合

数据分区的大小

说明

服务器1侧

服务器2侧

OK

30GiB

31GiB

由于双方均在0~32GiB不足的范围内,因此OK

OK

50GiB

60GiB

由于双方均在2GiB以上~64GiB不足的范围内,因此OK

NG

30GiB

39GiB

由于超过了32GiB,因此NG

NG

60GiB

70GiB

由于超过了64GiB,因此NG

6.1.5. 关于IPv6环境¶

在IPv6环境下,不能使用以下功能。

AWS Elastic IP 资源

AWS 虚拟 IP资源

AWS 辅助 IP资源

AWS DNS资源

Azure 探头端口资源

Azure DNS资源

Google Cloud 虚拟 IP 资源

Google Cloud DNS 资源

Oracle Cloud 虚拟 IP 资源

AWS Elastic IP 监视资源

AWS 虚拟 IP监视资源

AWS 辅助 IP监视资源

AWS AZ监视资源

AWS DNS监视资源

Azure 探头端口监视资源

Azure 负载均衡监视资源

Azure DNS监视资源

Google Cloud 虚拟 IP 监视资源

Google Cloud 负载均衡监视资源

Google Cloud DNS 监视资源

Oracle Cloud 虚拟 IP 监视资源

Oracle Cloud 负载均衡监视资源

以下功能不能使用本地链路地址。

LAN心跳资源

内核模式LAN心跳资源

镜像磁盘连接

PING网络分区解决资源

FIP资源

VIP资源

6.1.6. 关于网络设置¶

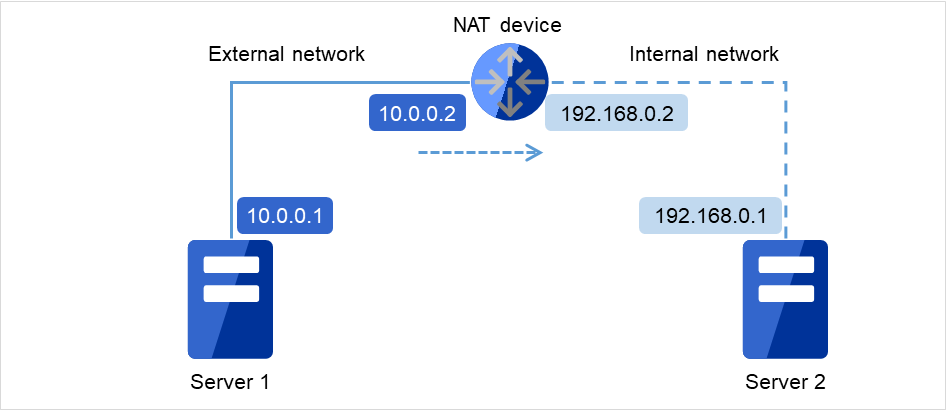

在NAT环境等自身服务器的IP地址和对方服务器的IP地址在不同服务器上形成不同的配置时,不能构筑/运用集群。

图 6.1 无法配置集群的环境的示例¶

Server 1中的集群设置

自身服务器: 10.0.0.1

对方服务器: 10.0.0.2

Server 2中的集群设置

自身服务器: 192.168.0.1

对方服务器: 10.0.0.1

6.1.7. 关于监视器资源恢复工作的"最终工作前执行脚本"¶

6.1.8. NIC Link Up/Down监视资源¶

ethtool eth0

Settings for eth0:

Supported ports: [ TP ]

Supported link modes: 10baseT/Half 10baseT/Full

100baseT/Half 100baseT/Full

1000baseT/Full

Supports auto-negotiation: Yes

Advertised link modes: 10baseT/Half 10baseT/Full

100baseT/Half 100baseT/Full

1000baseT/Full

Advertised auto-negotiation: Yes

Speed: 1000Mb/s

Duplex: Full

Port: Twisted Pair

PHYAD: 0

Transceiver: internal

Auto-negotiation: on

Supports Wake-on: umbg

Wake-on: g

Current message level: 0x00000007 (7)

Link detected: yes

在ethtool命令的执行结果中,没有显示LAN网线状况("Link detected: yes")时

EXPRESSCLUSTER的NIC Link Up/Down监视资源不可运行的可执行性很高。请使用IP监视资源代替。

在ethtool命令的执行结果中,显示LAN网线状况("Link detected: yes")时

大多数情况下 EXPRESSCLUSTER的NIC Link Up/Down监视资源可以运行,但也有时无法运行。

尤其是在以下硬件下可执行无法运行。请使用IP监视资源代替。

如同刀片服务器一样,硬件位于LAN连接器和NIC芯片之间。

监视对象的NIC处于Bonding环境时,请确认MII Polling Interval的设置值已设置为0以上。

在实际的机器上使用EXPRESSCLUSTER确认能否使用NIC Link Up/Down监视资源时,请按照以下步骤进行运行确认。

- 请在配置信息中注册NIC Link Up/Down监视资源。在NIC Link Up/Down监视资源的查出异常时的复归操作的设置中,选择"无操作"。

启动集群。

- 请确认NIC Link Up/Down监视资源的状态。LAN网线的链接状态是正常状态时, NIC Link Up/Down监视资源的状态为异常的情况下, NIC Link Up/Down监视资源不可运行。

- LAN网线的连接状态是异常状态(链接断开状态) 时,NIC Link Up/Down监视资源的状态为异常的情况下,NIC Link Up/Down监视资源可以运行。状态保持正常不做变化时,NIC Link Up/Down监视资源不可运行。

6.1.9. 关于镜像磁盘资源,共享型镜像磁盘资源的write性能¶

镜像磁盘资源/共享型镜像磁盘资源的磁盘镜像建立有同步镜像和非同步镜像2种方式。

同步镜像时,每当向镜像化对象的数据分区发出写入请求,都会向两台服务器的磁盘执行写入,并等待其结束。虽然向各服务器的写入是同时执行的,但向其它服务器的磁盘写入是通过网络进行的,所以与不进行镜像化的普通本地磁盘相比写入性能会降低。特别是网络通信速度慢,延迟时间长的远程集群结构,性能会大幅下降。

非同步镜像时,向自身服务器写出是立即执行的,而向其它服务器的写出会先保存到本地队列中,在后台写出。是即使是非同步镜像时,也会在每次发出写入请求时将更新数据保存在队列中,与不建立镜像的普通本地磁盘和共享磁盘相比,写入性能会有降低。因此,向磁盘的写入处理需要较高吞吐量的系统(更新服务器较多的数据库系统等) ,推荐使用共享磁盘。

此外,非同步镜像时,虽然保证写入顺序,但运行服务器如宕机,可执行会丢失最新的更新内容。因此,如想在故障发生前一刻保证此刻信息切实被交接,需要使用同步镜像或者共享磁盘。

6.1.10. 关于非同步镜像的历史文件¶

在非同步模式的镜像磁盘/共享型镜像磁盘中,内存上的队列里记录不下的写入数据,会临时作为历史文件记录到被指定为历史文件夹的目录下。没有设置该历史文件的大小限制时,可以不受限制地写出到所指定的文件夹内。因此在这种设置的情况下,如果线路速度比业务应用程序的磁盘更新量低很多,则向远程服务器的写入处理赶不上磁盘更新的速度,磁盘里就会充斥历史文件。因此,远程集群结构也需要根据业务AP的磁盘更新量保证通信线路的速度。

另外,如果由于长时间的通信延迟或持续的磁盘更新导致历史文件存储目录溢出,需要确保指定的目录中有足够的可用空间来写入历史文件,设置历史文件的大小限制,或指定与系统磁盘不同的磁盘上的目录。

6.1.11. 勿将镜像磁盘资源,共享型镜像磁盘资源作为syslog的输出目的地¶

使用bonding作为镜像磁盘连接的路径二重化方法。

调整用户空间监视的超时值和镜像相关的超时值。

6.1.12. 镜像磁盘资源,共享型镜像磁盘资源终止时的注意事项¶

- 若有对加载了镜像磁盘资源和共享型磁盘资源的目录和子目录,文件进行访问的进程,在关机或失效切换等各磁盘资源处于停止状态时,请使用结束脚本等终止对各磁盘资源的访问。根据各磁盘资源的设置,有时会发生当卸载时查出异常而进行的操作(强行终止访问了磁盘资源的进程),卸载失败停止异常时的复归操作(OS关机等)。

- 若对加载了镜像磁盘资源和共享型磁盘资源的目录和子目录,文件进行了大量访问,当对磁盘资源执行停止卸载时,将文件系统缓存写入磁盘时可执行耗费很长时间。此时,为了保证对磁盘的写能正常终止,在设置卸载超时时间时,请留出足够的富余。

6.1.13. 多个异步镜像之间的数据一致性¶

6.1.14. 关于中断了镜像同步时的参照同步方的镜像数据¶

6.1.15. 关于O_DIRECT在镜像磁盘,共享型镜像磁盘资源上的使用¶

6.1.16. 关于镜像磁盘,共享型镜像磁盘初始化构筑的时间¶

在ext2/ext3/ext4/xfs与其他文件系统中,初始化镜像以及全面镜像所需的时间各异。

注解

xfs时,资源停止时所需的时间将更短。

6.1.17. 关于镜像磁盘,共享型镜像磁盘连接¶

对镜像磁盘,共享型镜像磁盘连接进行冗余化处理时,需要两个IP地址使用同一版本。

请将所有镜像磁盘连接的IP地址设置为IPv4或者IPv6的其中一方。

6.1.18. 关于JVM监视资源¶

可同时进行监视的Java VM最多是25个。可同时监视的Java VM指,通过Cluster WebUI ([监视(固有)]标签->[识别名])可进行唯一识别的Java VM的数量。

Java VM和Java Resource Agent之间的回收不支持SSL。

有时可执行不能检测出线程死锁。这是已经确认的来自JavaVM的缺陷。详细内容请参考Oracle的Bug Database的"Bug ID: 6380127 "。(2011年10月现在)。

JVM监视资源可监视的Java VM需与JVM监视器资源工作时的服务器在同一服务器内。

JVM监视资源可监视的JBoss的服务器实例1个服务器上最多只有一个实例。

通过Cluster WebUI (集群属性->[JVM监视]标签页->[Java安装路径])进行设定的Java安装路径在集群内的服务器内属于共通设定。关于JVM监视中使用的Java VM的版本以及升级版本,请在集群内服务器上使用同一版本。

通过Cluster WebUI (集群属性->[JVM监视]标签页->[连接设定]对话框->[管理端口号])进行设定的管理端口号在集群内的服务器内属于共通设定。

x86_64版OS上运行IA32版的监视对象的应用程序时,不能进行监视。

如果将通过Cluster WebUI (集群属性->[JVM监视]标签页->[最大Java堆大小])设置的最大Java堆大小值设置为3000等大数值,则JVM监视资源会启动失败。由于依赖于系统环境,请根据系统的内存搭载容量来决定。

- 在监视对象Java VM的启动选项添加了「-XX:+UseG1GC」时,在Java 7以前则不能监视JVM监视资源的[属性]-[监视(固有)]标签页-[调整]属性-[内存]标签内的设置项目。在Java 8以上则可通过在JVM监视资源的[属性]-[监视(固有)]标签页- [JVM类型]选择[Oracle Java(usage monitoring)]来进行监视。

6.1.19. 关于邮件通知¶

不提供STARTTLS和SSL的邮件通知功能。

6.1.20. 关于网络警告灯的要求¶

使用"DN-1000S","DN-1500GL"时,请勿设置警告灯密码。

- 因回放音频文件而出现警告时,应将音频文件重新登录到"音频文件回放对应的网络警告灯"上。有关音频文件登录,请参阅"各网络警告灯"使用说明书。

在网络警告灯里请设置允许来自集群内的服务器的rsh命令执行。

6.2. 安装OS前,安装OS时¶

请在安装OS时注意即将决定的参数,资源确保,命名规则等。

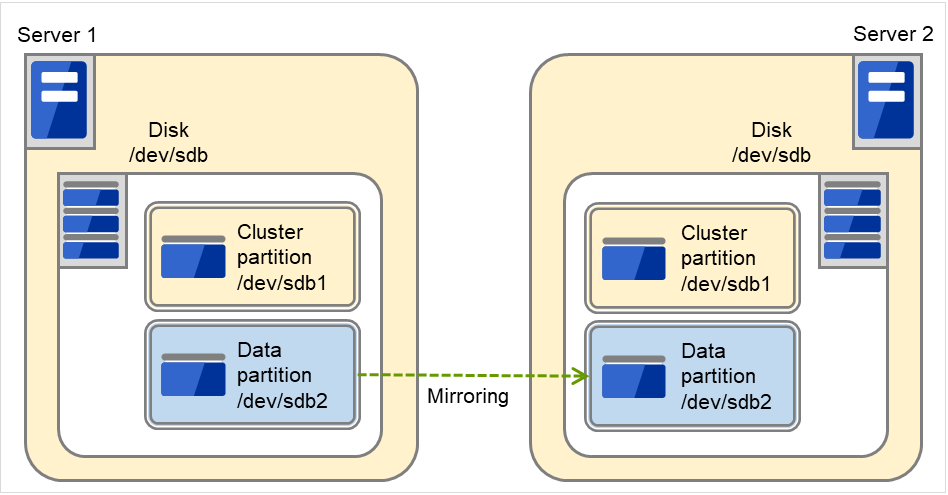

6.2.1. 关于镜像用磁盘¶

磁盘分区

例)在双方服务器上增加1个SCSI磁盘,创建1个镜像磁盘Pair时

图中的2台服务器中都添加了SCSI磁盘。磁盘被分为集群分区(Cluster partition)和数据分区(Data partition)。这个分区的组是镜像磁盘资源的失效切换单位,被称为镜像分区设备。

图 6.2 磁盘和分区配置(添加SCSI磁盘时)¶

例)使用存储双方服务器OS的IDE磁盘剩余容量创建镜像磁盘Pair时

在该图中,内置磁盘的OS未使用的区域被用作镜像分区设备(集群分区,数据分区)。

图 6.3 磁盘和分区配置(使用现有磁盘的可用空间时)¶

镜像分区设备是EXPRESSCLUSTER磁盘镜像驱动程序向上层提供的设备。

确保集群分区和数据分区的2个分区为Pair。

可以在处于和OS(root分区或swap分区)相同的磁盘上确保镜像分区(集群分区,数据分区)。

- 重视故障维护,性能时建议准备OS(root分区或swap分区)之外的镜像用磁盘。

- 受H/W Raid规格的限制无法添加LUN时用H/W Raid的预装模式难于更改LUN的配置时

可以在处于OS(root分区或swap分区)内的磁盘上确保镜像分区(集群分区,数据分区)。

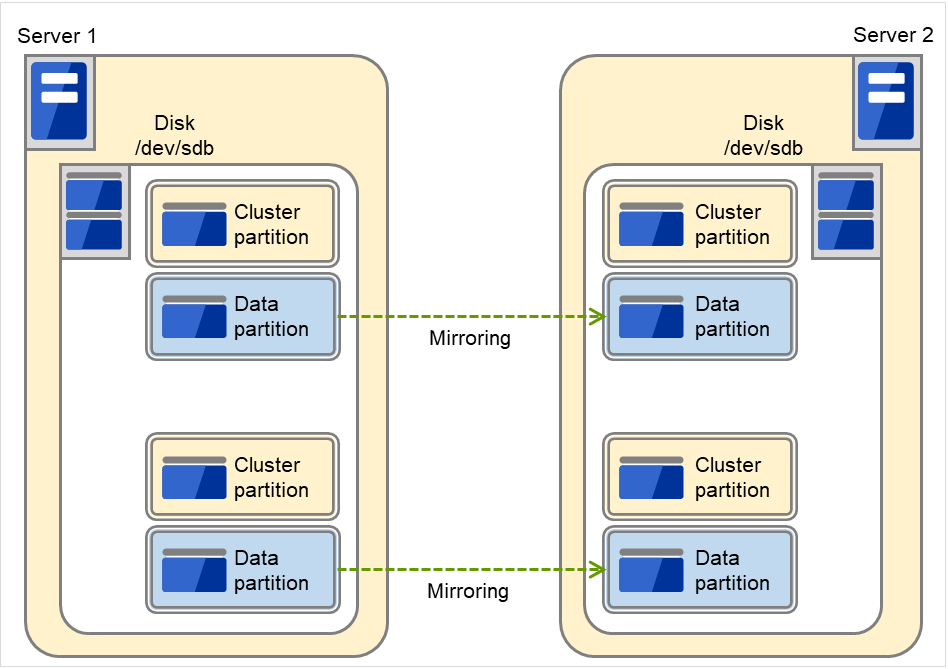

磁盘配置

可以将多个磁盘用作镜像磁盘。

另外,可以在1个磁盘中分配多个镜像分区设备加以利用。

例)在双方服务器上增设2个SCSI磁盘,创建2个镜像磁盘Pair时。

图 6.4 多个磁盘被用作镜像分区¶

请在1个磁盘上用Pair确保集群分区和数据分区。

不能将数据分区作为第1个磁盘,集群分区作为第2个磁盘使用。

例)在双方服务器上增设1个SCSI磁盘,创建2个镜像分区时

该图显示了在1个磁盘内保留2个镜像分区时的情况。

图 6.5 将磁盘内的多个区域用作镜像分区¶

磁盘不支持基于Linux的md的Stripe Set,Volume Set,磁盘镜像建立,带校验的Stripe Set的功能。

6.2.2. 关于共享型镜像磁盘资源用磁盘¶

磁盘分区

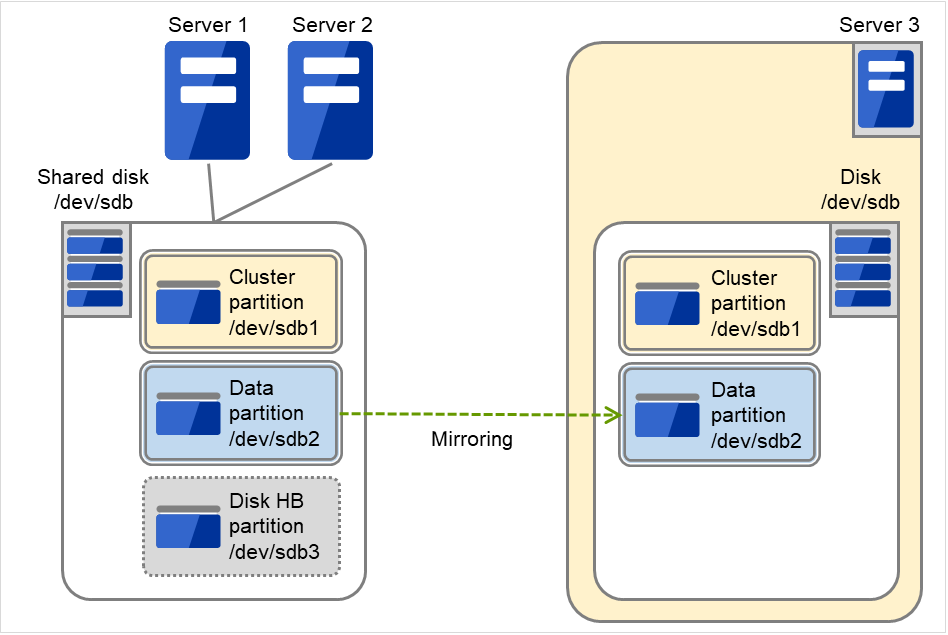

可以使用共享磁盘或非共享型磁盘(服务器内置,服务器间不共享的外置型磁盘机箱等)。

例)在2台服务器上使用共享磁盘,并在第3台服务器上使用服务器的内置磁盘时

该图显示的是,将Server 3的内置磁盘用作镜像分区设备。

图 6.6 磁盘和分区配置(使用共享磁盘和内置磁盘时)¶

镜像分区设备是EXPRESSCLUSTER磁盘镜像驱动程序向上层提供的设备。

确保集群分区和数据分区的2个分区为Pair。

使用非共享型磁盘(服务器内置,服务器间不共享的外置型磁盘机箱等)时,可以在处于OS(root分区或swap分区)内的磁盘上确保镜像分区(集群分区,数据分区)。

可以在OS(root分区或swap分区)所在的磁盘上确保镜像分区(集群分区,数据分区)。

使用共享磁盘装置确保共享型镜像磁盘用的磁盘时,需要有通用共享磁盘装置的服务器之间的磁盘心跳资源用的分区。

不支持基于Linux的md的Stripe Set,Volume Set,磁盘镜像建立,带校验的Stripe Set的功能。

6.2.3. 依存库¶

libxml2

请在安装OS时安装libxml2。

6.2.4. 依存驱动程序¶

softdog

在用户空间监视资源的监视方法softdog时,需要该驱动程序。

请构筑Loadable模块。不能在静态驱动程序上运行。

6.2.6. 镜像驱动程序的主编号¶

6.2.7. 内核模式LAN心跳驱动程序,KeepAlive驱动程序的主编号¶

内核模式LAN心跳驱动程序使用主编号10,副编号240。

KeepAlive驱动程序使用主编号10,副编号241。

请确保不要在其他驱动程序上使用上述主,副编号。

6.2.8. 确保磁盘监视资源用于RAW监视的分区¶

请在设置磁盘监视资源的RAW监视时准备监视专用的分区。请确保分区大小为10MB。

6.2.9. 设置SELinux¶

- 使用系统监视资源或进程资源监视资源时, 请将SELinux设置为permissive或者disabled。如果设为enforcinfg,则有时无法用EXPRESSCLUSTER进行必要的通信。

要在设置为enforcing 时载入 EXPRESSCLUSTER 驱动程序, 请执行《安装&设置指南》 的 “进行SELinux相关的设置(必需)” 中记载的步骤。

6.2.10. 设置NetworkManager¶

在Red Hat Enterprise Linux 6环境中运行NetworkManager服务的情况下,网络切断时会出现意外动作(通信径路迂回,网络接口消失等),建议进行停止NetworkManager 的设置。

6.2.11. LVM 元数据服务的配置¶

- 在Red Hat Enterprise Linux 7以后的环境中,卷管理资源以及卷管理监视资源执行LVM的控制/监视时,需要将LVM元数据服务设定为无效。将元数据服务变为无效的步骤如下。

通过以下的命令,请停止LVM元数据服务。

# systemctl stop lvm2-lvmetad.service

编辑/etc/lvm/lvm.conf,将use_lvmetad的值设定为0。

6.2.12. 设置安全启动¶

禁用安全启动设置。

6.3. 安装OS后,安装EXPRESSCLUSTER前¶

OS安装结束后,请注意OS和磁盘的设置。

6.3.1. 通信端口号¶

安装EXPRESSCLUSTER后可以通过clpfwctrl命令设置防火墙。详细内容请参考《参考指南》的"EXPRESSCLUSTER命令参考"的"添加防火墙规则(clpfwctrl命令)"。 此外,关于clpfwctrl命令设置的端口,是下表clpfwctrl列中打✓ 的端口。

在Cloud环境的情况下,不仅可以在实例侧的防火墙设置中访问以下端口号,还可以在Cloud基盘侧的安全设置中访问以下端口号

[服务器/服务器间] [服务器内循环]

From

To

备注

clpfwctrl

服务器

自动分配 6

服务器

29001/TCP

内部通信

✓

服务器

自动分配

服务器

29002/TCP

数据发送

✓

服务器

自动分配

服务器

29002/UDP

心跳

✓

服务器

自动分配

服务器

29003/UDP

警告同步

✓

服务器

自动分配

服务器

29004/TCP

镜像代理间通信

✓

服务器

自动分配

服务器

29006/UDP

心跳(内核模式)

✓

服务器

自动分配

服务器

29008/TCP

集群信息管理

✓

服务器

自动分配

服务器

29010/TCP

Restful API 内部通信

✓

服务器

自动分配

服务器

XXXX 7 /TCP

镜像磁盘资源数据同步

✓

服务器

自动分配

服务器

XXXX 8 /TCP

镜像驱动程序间通信

✓

服务器

自动分配

服务器

XXXX 9 /TCP

镜像驱动程序间通信

✓

服务器icmp服务器icmp镜像驱动程序间KeepAliveFIP/VIP资源的重复确认镜像代理服务器

自动分配

服务器

XXXX 10 /UDP

内部日志用通信

✓

[服务器・客户端之间]

From

To

备注

clpfwctrl

Restful API 客户端

自动分配

服务器

29009/TCP

http通信

✓

[服务器・Cluster WebUI之间]

From

To

备注

clpfwctrl

Cluster WebUI

自动分配

服务器

29003/TCP

http通信

✓

[其他]

From

To

备注

clpfwctrl

服务器

自动分配

网络警告灯

请参照各产品的手册

控制网络警告灯

服务器

自动分配

服务器的BMC的管理LAN

623/UDP

控制BMC (强制停止)

服务器

自动分配

Witness 服务器

通过Cluster WebUI中设定的通信端口号

Witness 心跳资源的连接目标主机

服务器

icmp

监视对象

icmp

IP监视

服务器

icmp

监视对象

icmp

Ping方式网络分区解决资源的监视对象

服务器

自动分配

监视目标

通过Cluster WebUI 设定的通信端口号

HTTP 方式网络分区解决资源的监视目标

服务器

自动分配

服务器

通过Cluster WebUI设定的管理端口号 11

JVM监视器

✓

服务器

自动分配

监视对象

通过Cluster WebUI设定的管理端口号 11

JVM监视器

服务器

自动分配

服务器

通过Cluster WebUI设定的Probe端口 12

Azure 探头端口资源

✓

服务器自动分配AWS区域端点443/tcp 13AWS Elastic IP资源AWS虚拟IP资源AWS辅助IP资源AWS DNS资源AWS Elastic IP监视资源AWS虚拟IP监视资源AWS辅助IP监视资源AWS AZ监视资源AWS DNS监视资源AWS 强制停止资源服务器

自动分配

Azure端点

443/tcp 14

Azure DNS资源

服务器

自动分配

Azure的权威DNS服务器

53/udp

Azure DNS监视资源

服务器

自动分配

服务器

在Cluster WebUI中设置的端口号 12

Google Cloud 虚拟 IP 资源

✓

服务器

自动分配

服务器

在Cluster WebUI中设置的端口号 12

Oracle Cloud 虚拟 IP 资源

✓

- 6

自动分配是指该时刻未使用的端口号将被分配。

- 7

即每个镜像磁盘资源,共享型镜像磁盘资源使用的端口号。在创建镜像磁盘资源,共享型镜像磁盘资源时设置。初始值设置为29051。此外,每添加1个镜像磁盘资源,共享型镜像磁盘资源,值就会自动加1。更改时,用Cluster WebUI的 [镜像磁盘资源属性]-[详细],[共享型镜像磁盘资源属性]-[详细]标签页设置。详细内容请参考《参考指南》的"组资源的详细信息"。

- 8

即每个镜像磁盘资源,共享型镜像磁盘资源使用的端口号。在创建镜像磁盘资源,共享型镜像磁盘资源时设置。初始值设置为29031。此外,每添加1个镜像磁盘资源,共享型镜像磁盘资源,值就会自动加1。更改时,用Cluster WebUI的 [镜像磁盘资源属性]-[详细],[共享型镜像磁盘资源属性]-[详细]标签页设置。详细内容请参考《参考指南》的"组资源的详细信息"。

- 9

即每个镜像磁盘资源,共享型镜像磁盘资源使用的端口号。在创建镜像磁盘资源,共享型镜像磁盘资源时设置。初始值设置为29071。此外,每添加1个镜像磁盘资源,共享型镜像磁盘资源,值就会自动加1。更改时,用Cluster WebUI的 [镜像磁盘资源属性]-[详细],[共享型镜像磁盘资源属性]-[详细]标签页设置。详细内容请参考《参考指南》的"组资源的详细信息"。

- 10

在集群属性, 端口号(日志)的标签中,将[日志的通信方式]选为 [UDP],使用在端口号中设定的端口号。日志的通信方法[UNIX Domain] 默认为不使用通信端口。

- 11(1,2)

JVM监视资源使用以下的2个端口号。

- 12(1,2,3)

负载均衡器进行各服务器的死活监视时所使用的端口号。

- 13

以下的AWS相关资源执行AWS CLI。AWS CLI使用上述端口号。

AWS Elastic IP 资源

AWS 虚拟 IP资源

AWS 辅助 IP资源

AWS DNS资源

AWS Elastic IP 监视资源

AWS 虚拟 IP监视资源

AWS 辅助 IP监视资源

AWS AZ监视资源

AWS DNS监视资源

AWS 强制停止资源

- 14

对于Azure DNS 资源,执行Azure CLI。Azure CLI中使用上述端口。

6.3.2. 更改通信端口号的自动分配的范围¶

OS所管理的通信端口号的自动分配的范围有可执行与EXPRESSCLUSTER所使用的通信端口号重复。

通信端口号的自动分配的范围与EXPRESSCLUSTER所使用的通信端口号重复时,请更改OS的设置使通信端口号不重复。

OS的设置状态的确认例/显示例

通信端口号的自动分配的范围需依靠Distribution。

# cat /proc/sys/net/ipv4/ip_local_port_range 1024 65000如上是应用程序向OS请求通信端口号的自动分配时,被分配到1024~65000的范围内的状态。

# cat /proc/sys/net/ipv4/ip_local_port_range 32768 61000如上是应用程序向OS请求通信端口号的自动分配时,被分配到32768~61000的范围内的状态。

更改OS设置例

在/etc/sysctl.conf 增加如下所示的一行。(更改为30000~65000时)

net.ipv4.ip_local_port_range = 30000 65000此设置要在OS重启后才能变为有效。

修改/etc/sysctl.conf之后,通过执行以下的命令可以实现即时反映。

# sysctl -p

6.3.3. 关于避免端口数不足的设置¶

6.3.4. 时钟同步的设置¶

建议在集群系统上定期进行多个服务器的时钟同步。请使用ntp等同步服务器的时间。

6.3.5. 关于NIC设备名¶

根据ifconfig命令的规则,若NIC设备名被缩短,则EXPRESSCLUSTER所处理的NIC设备名的长短也需要相应变更。

6.3.7. 关于镜像用磁盘¶

设置镜像磁盘资源管理用分区(集群分区)和镜像磁盘资源使用的分区(数据分区)。

- 镜像磁盘上的文件系统由EXPRESSCLUSTER控制。请不要将镜像磁盘的文件系统登录到OS的/etc/fstab中。(请不要将镜像分区设备以及镜像的mount point,镜像分区以及数据分区登录到OS 的/etc/fstab。)(也不要登录到带ignore参数的 /etc/fstab中。在ignore登录时,mount的执行时登录会被忽视,在fsck执行时有可执行发生错误。)

(此外,在noauto 参数登录到/etc/fstab时,也有可执行错误地进行手动mount,或不能排除因某种应用程序而进行mount的可执行性,因此不推荐这种操作方法。)

请为集群分区至少保留1024MiB。(即使精确指定1024MB,由于磁盘的几何数据差异,实际上将保留大于1024BM的大小,但这并不是问题)。此外,请勿在集群分区上构筑文件系统。

镜像磁盘的设置步骤请参考《安装&设置指南》。

6.3.8. 关于共享型镜像磁盘资源用磁盘¶

设置共享型镜像磁盘资源管理用分区(集群分区)和共享型镜像磁盘资源使用的分区(数据分区)。

使用共享磁盘装置确保共享型镜像磁盘时,确保通用共享磁盘装置的服务器间的磁盘心跳资源用分区。

- 共享型镜像磁盘上的文件系统由EXPRESSCLUSTER控制。请不要将共享型镜像磁盘的文件系统登录到OS的/etc/fstab中。(请不要将镜像分区设备以及镜像的mount point,镜像分区以及数据分区登录到OS 的/etc/fstab。)(也不要登录到带ignore参数的 /etc/fstab中。在ignore登录时,mount的执行时登录会被忽视,在fsck执行时有可执行发生错误。)(此外,在noauto 参数登录到/etc/fstab时,也有可执行错误地进行手动mount,或不能排除因某种应用程序而进行mount的可执行性,因此不推荐这种操作方法。)

请为集群分区至少保留1024MiB。(即使精确指定1024MB,由于磁盘的几何数据差异,实际上将保留大于1024BM的大小,但这并不是问题)。此外,请勿在集群分区上构筑文件系统。

共享型镜像磁盘用磁盘的设置步骤请参考《安装&设置指南》。

在本系统内,必须手动在共享型镜像磁盘所使用的数据分区上设置文件系统。忘记设置时,请参照《安装&设置指南》的"确定系统配置 配置硬件后的设置"。

6.3.9. 在镜像磁盘资源,共享型磁盘资源使用ext3或者ext4时¶

6.3.9.1. 关于Block size¶

对于镜像磁盘资源或者共享性磁盘资源的数据分区,手动执行mkfs命令,构建ext3或者ext4文件系统时,请不要将Block size指定为1024。

镜像磁盘资源以及共享型磁盘资源不支持Block size 1024。要明确指定Block size时,请指定2048或者4096。

6.3.10. OS启动时间的调整¶

请将从开启电源到OS启动为止的时间,调整为超过如下2种时间的长度。

使用共享磁盘时,从接通磁盘的电源到可以使用的时间

心跳超时时间

设置步骤请参考《安装&设置指南》。

6.3.12. 关于OpenIPMI¶

在以下功能中使用OpenIPMI。

组资源启动异常时/停止异常时的最终运行

监视资源异常时的运行

用户空间监视资源

关机监视

物理机的强制停止功能

在EXPRESSCLUSTER中没有附加OpenIPMI。用户请另行自行安装OpenIPMI的 rpm 文件。

对于能否支持已经预定要使用的服务器(硬件)的OpenIPMI的问题,请用户提前进行确认。

即使在作为硬件依据IPMI规格标准时,由于实际上OpenIPMI有时不运行,因此请多加注意。

- 使用服务器厂商所提供的服务器监视软件时,请不要选择IPMI作为用户空间监视资源和Shutdownstall监视的监视方法。由于这些服务器监视软件和OpenIPMI共同使用服务器上的BMC(Baseboard Management Controller),因此会发生冲突,令监视无法正常进行。

6.3.13. 关于用户空间监视资源,关机监视(监视方法softdog)¶

- 监视方法中设置为softdog时,请使用softdog驱动。在EXPRESSCLUSTER以外使用softdog驱动的功能请设置为不运行。例如:确认了相应的以下那样的功能。

OS标准附带的heartbeat

i8xx_tco驱动

iTCO_WDT驱动

systemd 的watchdog功能,关机监视功能。

监视方法中设置为softdog时,请设置为不运行OS标准附带的heartbeat。

在SUSE LINUX 11中,监视方法设为softdog时,无法与i8xx_tco驱动同时使用。不使用i8xx_tco驱动时,请设置为不装载i8xx_tco。

Red Hat Enterprise Linux 6时,监视方法里设置了softdog的场合,不能同时使用iTCO_WDT驱动。不使用iTCO_WDT时,请设定为不Load iTCO_WDT。

6.3.14. 关于收集日志¶

在SUSE LINUX 10/11中,使用EXPRESSCLUSTER的日志收集功能获取OS的syslog时,由于被rotate了的syslog(message)文件的suffiies不同,因此syslog的世代的指定功能无法运行。若要指定日志收集功能的syslog的世代,则需要将syslog的rotate的设置作如下修改在进行应用。

注释掉 /etc/logrotate.d/syslog文件的compress和dateext

各服务器中日志的总大小超出2GB时,有时会导致日志收集失败。

6.3.15. 关于nsupdate,nslookup¶

下列功能使用nsupdate和nslookup。

组资源的动态域名解析资源 (ddns)

监视资源的动态域名解析监视资源 (ddnsw)

EXPRESSCLUSTER中未附带nsupdate及nslookup。请用户另行自行安装nsupdate及nslookup的 rpm 文件。

本公司不负责与nsupdate,nslookup相关的以下事项。请用户在自行判断,自负责任的基础上再予以使用。

对nsupdate,nslookup 本身的相关咨询

nsupdate,nslookup的运行保证

nsupdate,nslookup的问题解决及由此引发的故障

对各服务器的nsupdate,nslookup的支持情况的咨询

6.3.16. 关于FTP监视资源¶

FTP服务器上登录的横幅通知,连接时的通知的文字列过长或者为复数行时,有可执行出现监视异常。使用FTP监视资源监视时,请不要登录横幅通知,连接时的通知。

6.3.17. 使用Red Hat Enterprise Linux 7时的注意事项¶

邮件通报功能使用操作系统提供的[mail]命令。最小构成中由于未安装[mail]命令,请执行以下任意一项

集群属性的[Alert服务]页中,[邮件发送方法]项设置为[SMTP]。

安装mailx

6.3.18. 使用Ubuntu时的注意事项¶

执行EXPRESSCLUSTER相关命令时,请由root用户执行。

Application Server Agent只支持WebSphere监视。因为其他应用服务器不支持Ubuntu

邮件通报功能使用操作系统提供的[mail]命令。最小构成中由于未安装[mail]命令,请执行以下任意一项

集群属性的[Alert服务]页中,[邮件发送方法]项设置为[SMTP]。

安装mailx

不执行根据SNMP取得信息功能

6.3.19. AWS环境中的时刻同步¶

6.3.20. 关于AWS环境中IAM的设置¶

IAM的设置步骤如下所示。

首先请创建IAM policy。请参考后面的"IAM policy的创建"。

- 接下来进行实例设置。使用IAM角色时,请参考后面的“实例的设置-使用IAM角色”。使用IAM用户时,请参考后面的“实例的设置-使用IAM用户”。

IAM policy的创建

创建policy,该policy记载了针对AWS的EC2和S3等的服务的动作的访问许可。EXPRESSCLUSTER的AWS关联资源以及监视资源执行AWS CLI所允许的必要的动作如下所示。

必要的policy有可执行将来被变更。

AWS虚拟IP资源/AWS虚拟IP监视资源

动作

说明

取得VPC,路由表,网络接口的信息时必需。

ec2:ReplaceRoute

更新路由表时必需。

AWS Elastic IP资源/AWS Elastic IP监视资源

动作

说明

取得EIP,网络接口的信息时必需。

ec2:AssociateAddress

将EIP分配到ENI时必需。

ec2:DisassociateAddress

将EIP从ENI分离时必需。

AWS辅助IP资源/AWS辅助IP监视资源

动作

说明

取得网络接口和子网的信息时必需。

ec2:AssignPrivateIpAddresses

分配辅助IP地址时必需。

ec2:UnassignPrivateIpAddresses

取消分配辅助IP地址时必需。

AWS AZ监视资源

动作

说明

ec2:DescribeAvailabilityZones

取得可用区的信息时必需。

AWS DNS资源/AWS DNS监视资源

动作

说明

route53:ChangeResourceRecordSets

追加,删除资源记录集,更新设置内容时必需。

route53:GetChange

添加资源记录集、更新设置内容时必需。

route53:ListResourceRecordSets

取得资源记录集信息时必需。

AWS 强制停止资源

Action

Description

ec2:DescribeInstances

取得实例的信息时必需。

ec2:StopInstances

停止实例时必需。

ec2:RebootInstances

重启实例时必需。

向Amazon CloudWatch发送监视资源的监视处理时间的功能

动作

说明

cloudwatch:PutMetricData

发送自定义指标时所需。

向 Amazon SNS发送警报服务消息的功能

动作

说明

sns:Publish

发送消息时所需。

以下的自定义policy的例子是许可全部AWS关联资源以及监视资源所使用的动作。

{ "Version": "2012-10-17", "Statement": [ { "Action": [ "ec2:Describe*", "ec2:ReplaceRoute", "ec2:AssociateAddress", "ec2:DisassociateAddress", "ec2:AssignPrivateIpAddresses", "ec2:UnassignPrivateIpAddresses", "ec2:StopInstances", "ec2:RebootInstances", "route53:ChangeResourceRecordSets", "route53:GetChange", "route53:ListResourceRecordSets" ], "Effect": "Allow", "Resource": "*" } ] }通过IAM Management Console的[Policies] - [Create Policy]可创建自定义policy。

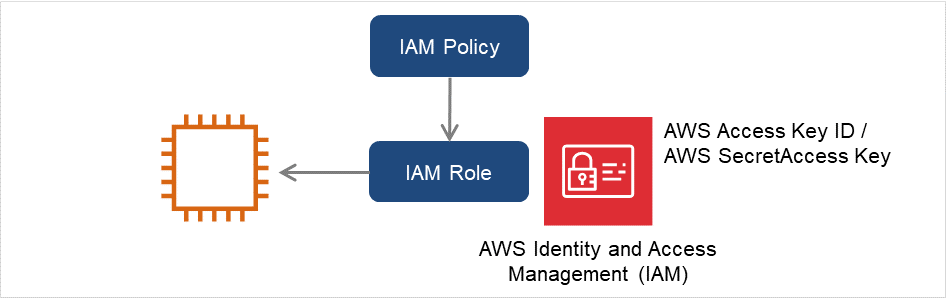

实例的设置-使用IAM角色

通过创建IAM角色并赋给实例从而使AWS CLI可执行的方法。

图 6.7 设置使用IAM角色的实例¶

创建IAM角色。在创建的角色上附加IAM policy。

通过IAM Management Console的[Roles] - [Create New Role]可创建IAM角色。

创建实例时,指定[IAM Role]上做成的IAM角色。

登录实例。

/sbin,/bin,/usr/sbin,/usr/bin

只安装了Python3, /usr/bin/python 不存在时,请对于/usr/bin/python3.x (x为版本)或者 /usr/bin/python3 创建 /usr/bin/python 的符号链接。安装AWS CLI。

AWS CLI的安装路径必须为以下之一。/sbin,/bin,/usr/sbin,/usr/bin,/usr/local/bin关于AWS CLI的更新方法详情请参考如下。(安装Python或AWS CLI时已经安装了EXPRESSCLUSTER时,请重启OS再执行EXPRESSCLUSTER的操作。)

从shell执行以下的命令。

$ sudo aws configure针对提问输入执行AWS CLI所必需的信息。请注意不要输入AWS Access ID,AWS Secret Access Key。

AWS Access Key ID [None]: (只按Enter键) AWS Secret Access Key [None]: (只按Enter键) Default region name [None]: <默认的区域名> Default output format [None]: text"Default output format"可以指定为"text"之外的格式。如果内容设置错误时,删除/root/.aws目录后,再重新执行上述操作。

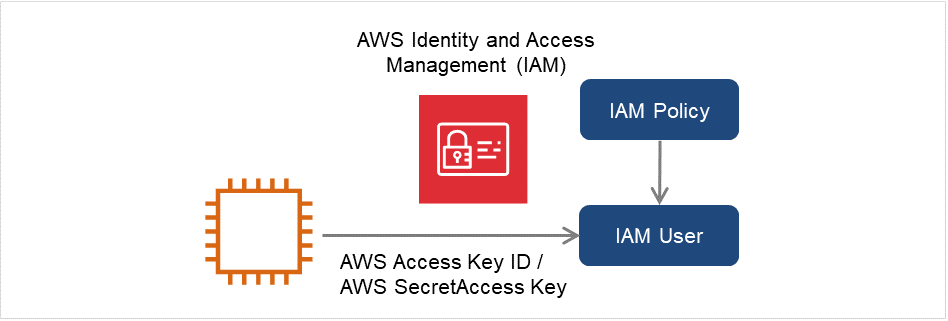

实例的设置-使用IAM用户

创建IAM用户,通过将Access ID,Secret Access Key保存在实例内部使AWS CLI能够执行的方法。实例创建时不需要IAM角色的授予。

图 6.8 设置使用IAM用户的实例¶

登录实例。

/sbin,/bin,/usr/sbin,/usr/bin

只安装了Python3, /usr/bin/python 不存在时,请对于/usr/bin/python3.x (x为版本)或者 /usr/bin/python3 创建 /usr/bin/python 的符号链接。安装AWS CLI。

AWS CLI的安装路径必须为以下之一。/sbin,/bin,/usr/sbin,/usr/bin,/usr/local/bin关于AWS CLI 的安装方法,详情请参考下述。(安装Python或AWS CLI时已经安装了EXPRESSCLUSTER时,请重启OS再执行EXPRESSCLUSTER的操作。)

从shell执行以下的命令。

$ sudo aws configure针对提问输入执行AWS CLI所必需的信息。AWS Access ID,AWS Secret Access Key处输入从已创建的IAM用户的详细信息画面取得的内容。

AWS Access Key ID [None]: <AWS Access Key > AWS Secret Access Key [None]: <AWS Secret Access Key > Default region name [None]: <默认的区域名> Default output format [None]: text"Default output format"可以指定为"text"之外的格式。如果内容设置错误时,请将/root/.aws目录删除后再重新执行上述操作。

6.3.21. 关于Azure DNS资源¶

安装Azure CLI,服务主体创建的步骤请参考《EXPRESSCLUTER X Microsoft Azure HA 集群构筑指南 (Linux 版)》。

为了利用Azure DNS资源,需要安装Azure CLI和Python。Python与Redhat Enterprise Linux/Cent OS等操作系统是捆绑在一起的。关于Azure CLI的具体内容,请参考以下Web站点。

Microsoft Azure的文档:为了利用Azure DNS资源,需要Azure DNS的服务。关于Azure DNS的具体内容,请参考以下Web站点。

EXPRESSCLUTER为了和Microsoft Azure联动,需要Microsoft Azure的组织账户。组织账户以外的账户在Azure CLI运行时需要对话形式的登录,因此不能使用。

- 使用Azure CLI,需要创建服务主体。Azure DNS资源是登录到Microsoft Azure,执行对DNS区域的登记。登录到Microsoft Azure时,利用通过服务主体的Azure登录。关于服务主体和具体步骤,请参考以下的Web站点。使用Azure CLI 2.0进行登录:在Azure CLI 2.0 上创建 Azure 服务主体:创建出服务主体的角色由默认的Contributor(共同创造者)改为别的角色时,作为Actions 属性,请选择拥有以下的全部操作的访问权的角色。如果改变为不满足该条件的角色时,启动Azure DNS 资源就会发生错误而失败。

Azure CLI 1.0时

Microsoft.Network/dnsZones/readMicrosoft.Network/dnsZones/A/writeMicrosoft.Network/dnsZones/A/readMicrosoft.Network/dnsZones/A/deleteMicrosoft.Network/dnsZones/NS/readAzure CLI 2.0 时

Microsoft.Network/dnsZones/A/writeMicrosoft.Network/dnsZones/A/deleteMicrosoft.Network/dnsZones/NS/read 不支持Azure私有DNS。

6.3.22. 关于Google Cloud DNS资源¶

使用Google Cloud的Cloud DNS。关于Cloud DNS的详细信息,请参考以下Web网站。

Cloud DNS要使用Cloud DNS操作,需要安装Cloud SDK。关于Cloud SDK的详细信息,请参考以下网站。

Cloud SDK需要用具有以下权限的帐户批准Cloud SDK。

dns.changes.createdns.changes.getdns.managedZones.getdns.resourceRecordSets.createdns.resourceRecordSets.deletedns.resourceRecordSets.listdns.resourceRecordSets.update关于批准Cloud SDK,请参考以下Web网站。

Cloud SDK工具批准

6.3.23. 关于Samba监视资源¶

Samba监视资源为了支持SMB协议版本2.0以上的版本,支持NTLM认证,支持SMB署名,使用内部版本4.1.0-1共享库的libsmbclient.so.0。由于libsmbclient.so.0包含在libsmbclient 包中,所以请确认是否已安装。

Libsmbclient的版本为3以下时(例.捆绑在RHEL 6中的libsmbclient.so),[端口号]只能指定139或者445。请指定包含在smb.conf的smb ports中的端口号。

Samba监视资源支持的SMB协议的版本依赖于已安装的libsmbclient中。可以尝试用各Distributor提供的smbclient命令连接共享监视对象,来确认libsmbclient是否支持。

6.3.24. 关于HTTP网络分区解决资源,Witness心跳资源¶

- 在HTTP 网络分区解决资源,Witness 心跳资源中使用SSL时,使用OpenSSL 1.0/1.1。默认使用的库如下。

libssl.so.10 (安装ExpressCluster rpm数据包时)

libssl.so.1.0.0 (安装EXPRESSCLUSTER deb数据包后)

要更改要使用的库时,请在集群属性的加密标签页中设置[SSL库]和[Crypto库]。

6.3.25. 关于OCI环境中CLI的设置¶

6.3.26. 关于OCI强制停止资源的设置¶

<EXPRESSCLUSTER 安装路径>/cloud/oci/clpociforcestop.sh ・根据 OCI CLI 命令的安装目录更改的参数 export PATH=$PATH:[OCI CLI 命令安装目录 ] <例> export PATH=$PATH:/root/bin ・根据 OCI 配置文件的存储位置更改的参数 OCI_Path="[OCI配置文件路径]" <例> OCI_Path="/root/.oci/config"

6.4. 创建EXPRESSCLUSTER的信息时¶

下文将阐述设计和创建EXPRESSCLUSTER构筑信息之前,需要依照系统构筑确认和注意的事项。

6.4.1. 有关EXPRESSCLUSTER安装路径下的目录,文件¶

6.4.2. 环境变量¶

在环境变量被设为大于256个的环境中,无法执行下列处理。若使用下列功能或资源,请将环境变量设为小于255个。

组启动/停止处理

Exec资源启动/停止时执行的开始/停止脚本

自定义监视器资源在监视时执行的脚本

组资源,监视器资源异常被查出时最终操作执行前脚本

组资源的启动/停止前后执行的脚本

强制停止脚本

注解

请将系统设定的环境变量和EXPRESSCLUSTER设定的环境变量之总和设定在255个以下。EXPRESSCLUSTER设定的环境变量约为30个。

6.4.3. 服务器的Reset,Panic,Power off¶

EXPRESSCLUSTER执行"Server reset"或"Server panic"或"Server power off"时,服务器不能被正常关闭。所以会有以下风险。

对mount中的文件系统造成损坏

丢失未保存的数据

OS dump 收集中断

发生"Server reset"或"Server panic"的设置如下。

组资源启动时/停止时异常的处理

sysrq panic

keepalive reset

keepalive panic

BMC reset

BMC poweroff

BMC cycle

BMC NMI

监视资源查出异常的最终运行

sysrq panic

keepalive reset

keepalive panic

BMC reset

BMC poweroff

BMC cycle

BMC NMI

用户空间监视查出超时的处理

监视方法 softdog

监视方法 ipmi

监视方法 keepalive

注解

"Server panic"仅在监视方法为KeepAlive时才可以设置。

Shutdown stall监视

监视方法 softdog

监视方法 ipmi

监视方法 keepalive

注解

"Server panic"仅在监视方法为keepalive时才可以设置。

强制停止功能的操作

BMC reset

BMC poweroff

BMC cycle

BMC NMI

VMware vSphere poweroff

6.4.4. 组资源停止异常时的最终运行¶

查出停止异常时,对最终运行选择[无操作],则组将在启动失败的状态下停止。在正式的运行环境下,请不要设置为[无操作]。

6.4.7. 关于多定义镜像磁盘时的单体服务器的启动时间¶

多定义镜像磁盘资源的个数,将「启动服务器时等待其他服务器启动的时间」设置的比较短时,如果启动单体服务器,启动镜像代理就可执行花费较多的时间,且镜像磁盘资源,镜像磁盘服务器的监视资源等可执行不能正常启动。

如果启动单体服务器时进入上述的状态,请将同步等待监视([集群属性] - [超时] 标签页 - [同步等待时间] 中设置)的值替换为较大的值进行设置变更。

6.4.8. 关于磁盘监视资源的RAW监视¶

设置磁盘监视资源的RAW监视时,无法监视已经mount的分区或可以mount的分区。另外,不能将设备名设置为已经mount的分区或可以mount的分区的whole device(显示磁盘整体的设备)进行监视。

请准备监视专用的分区,将其设置到磁盘监视资源的RAW监视内。

6.4.9. 迟延警告比例¶

将迟延警告比例设置为0或100时,可以进行如下操作。

- 将迟延警告比例设置为0时每次执行监视都会通报迟延警告。可利用该功能计算出服务器在高负荷状态下监视资源的监视时间,从而决定监视资源的监视超时时间。

- 将迟延警告比例设置为100时迟延警告将不发出通报。

除了测试运行以外,请不要将值设置为诸如0%之类的低值。

6.4.10. 关于磁盘监视资源的监视方法TUR¶

- 不能在不支持SCSI的Test Unit Ready命令或SG_IO命令的磁盘,磁盘接口(HBA)上使用。有时硬件支持但驱动程序不支持,所以请结合驱动程序的规格进行确认。

- 根据磁盘控制器的类型或使用版本的不同,OS可执行将S-ATA接口磁盘视为IDE接口的磁盘(hd),也可执行视为SCSI接口的磁盘(sd)。被视为IDE接口时,所有TUR方式将无法使用。被视为SCSI接口时,TUR(legacy)和TUR(generic)不能使用。

与read方式相比,对OS和磁盘的负荷较小。

有时用Test Unit Ready不能查出物理媒介的I/O错误。

6.4.11. 关于LAN 心跳设置/内核模式 LAN 心跳设置¶

对于优先级最高的私网,请设置允许所有服务器之间通信的LAN心跳或者内核模式LAN心跳。

建议设置两个以上内核模式LAN心跳资源(除非是在很难添加网络时,例如Cloud环境或远程集群环境中)。

建议将私网专用的LAN注册为LAN心跳资源,同时,将公网LAN也注册为LAN心跳资源。

建议对内核模式LAN心跳可用版本的内核并用内核模式LAN心跳。

6.4.12. 关于能用于脚本注释等的2字节系字符编码¶

在EXPRESSCLUSTER中,Linux环境下编辑的脚本作为EUC使用,而Windows环境下编辑的脚本则作为Shift-JIS使用。如使用其他字符编码,可执行因环境不同而出现乱码的情况。

6.4.13. 关于脚本字符代码和换行代码¶

使用 clpcfctrl 命令设置反映用非 Cluster WebUI 创建的脚本时,请确保配置信息文件 (clp.conf) 和脚本的字符代码和换行代码在设置反映之前相同。如果字符代码或换行代码不同,脚本可能无法正常工作。

6.4.14. 关于系统监视器资源的设置¶

- 资源监视器的监测模式System Resource Agent通过「最多次数」和「监视持续时间」两个参数的组合进行检测。通过继续收集各系统资源(打开文件数,用户访问数,线程数,内存使用量,CPU 使用率,虚拟内存使用量),当一定时间内(指定为持续时间的时间)超过最多次数时,就会检测出异常。

6.4.15. 关于消息接收监视器资源的设定¶

向消息接收监视器资源通知异常时有3个方法。使用[clprexec] 命令的方法,和使用服务器管理平台整合功能的方法。

使用[clprexec]命令时,请使用与EXPRESSCLUSTER CD同箱捆包的文件。请根据通知源的服务器的OS和架构来适当使用。并且,通知源服务器和通知目标服务器要处于可通信状态。

关于服务器管理平台整合功能,请参考《硬件整合指南》的"与服务器管理基础设施的整合"。

6.4.16. 关于JVM监视器的设定¶

监视目标为WebLogic Server时,对于JVM监视器资源的设定值,由于系统环境(内存搭载量等)的原因,设定范围的上限值可执行会受到限制。

[监视Work Manager的要求]-[要求数]

[监视Work Manager的要求]-[平均值]

[监视线程Pool的要求]-[待机要求 要求数]

[监视线程Pool的要求]-[待机要求 平均值]

[监视线程Pool的要求]-[执行要求 要求数]

[监视线程Pool的要求]-[执行要求 平均值]

监视目标的JRockit JVM 为64bit 版时,从JRockit JVM获取的各最大储存量会减少,致使不能计算出使用率,因此不能对以下的参数进行监视。

[监视堆使用率]- [领域整体]

[监视堆使用率]- [Nursery Space]

[监视堆使用率]- [Old Space]

[监视非堆使用率]- [领域整体]

[监视非堆使用率]- [ClassMemory]

要使用JVM监视资源,请安装"4. EXPRESSCLUSTER的运行环境"的"JVM监视的运行环境"中记载的JRE(Java Runtime Environment)。可与使用监视对象(WebLogic Server和WebOTX)的JRE在相同的项目中使用,也可使用在其他项目。

监视资源名中不要含空白字符。

6.4.17. 关于使用卷管理器资源时的EXPRESSCLUSTER的启动处理¶

EXPRESSCLUSTER启动时,卷管理器为lvm时通过vgchange命令进行停止处理,因此系统的启动有可执行比较费时。如有问题时,可按照如下对EXPRESSCLUSTER本体的启动/停止脚本进行编辑。

init.d环境时,请将/etc/init.d/clusterpro按照如下进行编辑。

#!/bin/sh # # Startup script for the EXPRESSCLUSTER daemon # : : # See how we were called. case "$1" in start) : : # export all volmgr resource # clp_logwrite "$1" "clpvolmgrc start." init_main # ./clpvolmgrc -d > /dev/null 2>&1 # retvolmgrc=$? # clp_logwrite "$1" "clpvolmgrc end.("$retvolmgrc")" init_main : :

systemd环境时,请将/opt/nec/clusterpro/etc/systemd/clusterpro.sh按照如下进行编辑。

#!/bin/sh # # Startup script for the EXPRESSCLUSTER daemon # : : # See how we were called. case "$1" in start) : : # export all volmgr resource # clp_logwrite "$1" "clpvolmgrc start." init_main # ./clpvolmgrc -d > /dev/null 2>&1 # retvolmgrc=$? # clp_logwrite "$1" "clpvolmgrc end.("$retvolmgrc")" init_main

6.4.18. 关于AWS Elastic IP资源的设置¶

不支持IPv6。

在AWS环境下,不能利用浮动IP资源,浮动IP监视资源,虚拟IP资源和虚拟IP监视资源。

AWS Elastic IP资源不支持ASCII字符以外的字符。请确认以下命令的执行结果中不包含ASCII字符以外的字符。

aws ec2 describe-addresses --allocation-ids <EIP ALLOCATION ID>

AWS Elastic IP 资源将 EIP 与 ENI 的主专用 IP 地址相关联。它不能与辅助专用 IP 地址相关联。

6.4.19. 关于AWS虚拟IP资源的设置¶

不支持IPv6。

在AWS环境下,不能利用浮动IP资源,浮动IP监视资源,虚拟IP资源和虚拟IP监视资源。

AWS虚拟IP资源不支持ASCII字符以外的字符。请确认以下命令的执行结果中不包含ASCII字符以外的字符。

aws ec2 describe-vpcs --vpc-ids <VPC ID> aws ec2 describe-route-tables --filters Name=vpc-id,Values=<VPC ID> aws ec2 describe-network-interfaces --network-interface-ids <ENI ID>

在需要经由VPC-Peering连接的访问时,不能利用AWS虚拟IP资源。这是因为作为VIP使用的IP地址是在VPC范围之外的前提,这样的IP地址在VPC-Peering连接中被视为无效。需要经由VPC-Peering连接的访问时,请使用利用了Amazon Route 53的AWS DNS资源。

即使实例使用的路由表中不存在虚拟IP使用的IP地址的路由,AWS虚拟IP资源也能正常启动。这是规定好的。在启动AWS虚拟IP资源时,仅更新存在指定IP地址条目的路由表内容。即使没有找到任何一个路由表,也会因为没有更新目标而被判断为正常。由于该条目是否必须要存在于哪个路由表,是由系统配置决定的,因此,不作为检查AWS虚拟IP资源正常性的目标。

6.4.20. 关于AWS辅助IP资源的设置¶

不支持IPv6。

在AWS环境下,不能利用浮动IP资源,浮动IP监视资源,虚拟IP资源和虚拟IP监视资源。

AWS辅助IP资源不支持ASCII字符以外的字符。请确认以下命令的执行结果中不包含ASCII字符以外的字符。

aws ec2 describe-network-interfaces --network-interface-ids <ENI ID> aws ec2 describe-subnets --subnet-ids <SUBNET_ID>

AWS 辅助 IP 资源不可以在具有不同子网的配置中使用。

- AWS 辅助 IP 资源分配的辅助 IP 地址对每种实例类型都有限制。详细内容请参考以下所记。

6.4.21. 关于AWS DNS资源的设置¶

不支持IPv6。

在AWS 环境下,不能利用浮动 IP 资源,浮动IP监视资源,虚拟IP资源,虚拟IP监视资源。

如果[资源记录集名称]中包含转义码,则为监视异常。请设置不含转义码的[资源记录集名称]。

启动AWS DNS资源后,它不会等待DNS配置更改传播到所有Amazon Route 53 DNS服务器。 这是因为,根据Route 53的规范,将资源记录集更改应用于整个过程需要花费时间。请参考"关于AWS DNS监视资源的设置"。

由于AWS DNS资源绑定在一个账户上,因此,无法使用多个帐户,AWS访问ID,AWS秘密访问密钥。在这种情况下,请考虑使用通过EXEC资源执行AWS CLI的脚本。

6.4.22. 关于AWS DNS监视资源的设置¶

AWS DNS监视资源在监视时执行AWS CLI。执行AWS CLI的超时是利用在AWS DNS资源上设置的[AWS CLI超时]。

AWS DNS资源的启动后,根据以下的情况,AWS DNS监视资源的监视可执行会失败。这时,请将AWS DNS监视资源的 [开始监视等待时间] 设置为比Amazon Route 53中DNS设定改变反映的时间更长的时间(https://aws.amazon.com/jp/route53/faqs/)。

启动AWS DNS 资源时,追加和更新记录集合。

反映Amazon Route 53中的DNS设置改变前,监视AWS DNS监视资源时就会由于不能进行域名解析而失败。在DNS解析器缓存有效的期间内,之后,监视AWS DNS监视资源也会失败。

反映Amazon Route 53中的DNS设置改变。

经过AWS DNS资源的 [TTL] 有效期,由于域名解析成功,监视AWS DNS监视资源成功。

6.4.23. 关于Azure 探头端口资源的设置¶

不支持IPv6。

在Microsoft Azure环境下,不能利用浮动IP资源,浮动IP监视资源,虚拟IP资源和虚拟IP监视资源。

6.4.24. 关于Azure负载均衡监视资源的设置¶

Azure负载均衡监视资源检测出异常时,Azure的负载均衡器的主服务器和备份服务器转换可执行不能正确被执行。因此,建议设置Azure负载均衡监视资源的[最终动作]为[停止集群服务并关闭操作系统]。

6.4.25. 关于Azure DNS资源的设置¶

不支持IPv6。

在Microsoft Azure 环境下,不能利用浮动 IP 资源,浮动IP监视资源,虚拟IP资源,虚拟IP监视资源。

6.4.26. 关于Google Cloud 虚拟 IP 资源的设置¶

不支持IPv6。

6.4.27. 关于Google Cloud 负载均衡监视资源的设置¶

如果Google Cloud负载均衡监视资源检测到异常,则可执行无法正确地从负载均衡器在运行系统和待机系统之间进行切换。因此,建议在Google Cloud负载均衡监视资源的[最终动作]中选择[停止集群服务停止和关闭操作系统]。

6.4.28. 关于Google Cloud DNS资源的设置¶

不支持IPv6。

在Google Cloud Platform 环境下,不能利用浮动 IP 资源,浮动IP监视资源,虚拟IP资源,虚拟IP监视资源。

如果同时执行多个Google Cloud DNS资源的启动/停止处理,可执行会发生错误。因此,在集群中使用多个Google Cloud DNS资源时,需要进行设置,以便由于资源的依赖关系和组的启动/停止等待而不能同时执行启动/停止处理。

6.4.29. 关于Oracle Cloud 虚拟 IP 资源的设置¶

不支持IPv6。

6.4.30. 关于Oracle Cloud 负载均衡监视资源的设置¶

如果Oracle Cloud负载均衡监视资源检测到异常,则可执行无法正确地从负载均衡器在运行系统和待机系统之间进行切换。因此,建议在Oracle Cloud负载均衡监视资源的[最终动作]中选择[停止集群服务停止和关闭操作系统]。

6.4.31. 关于镜像磁盘资源与共享型镜像磁盘资源共存¶

镜像磁盘资源和共享型镜像磁盘资源不能混在同一失效切换组内。

6.5. 操作EXPRESSCLUSTER后¶

请注意集群操作开始后的现象。

6.5.1. 关于udev等环境下的镜像驱动程序加载时的错误信息¶

在udev环境下加载镜像驱动程序时,messages文件有时会登入以下日志。

kernel: [I] <type: liscal><event: 141> NMP1 device does not exist. (liscal_make_request) kernel: [I] <type: liscal><event: 141> - This message can be recorded on udev environment when liscal is initializing NMPx. kernel: [I] <type: liscal><event: 141> - Ignore this and following messages 'Buffer I/O error on device NMPx' on udev environment. kernel: Buffer I/O error on device NMP1, logical block 0

kernel: <liscal liscal_make_request> NMP1 device does not exist. kernel: Buffer I/O error on device NMP1, logical block 112

文件名:50-liscal-udev.rules

ACTION=="add", DEVPATH=="/block/NMP*",OPTIONS+="ignore_device"

ACTION=="add", DEVPATH=="/devices/virtual/block/NMP*", OPTIONS+="ignore_device"

6.5.2. 关于针对镜像分区设备的缓存I/O错误的日志¶

镜像磁盘资源或共享磁盘资源处于停止的状态时,若访问镜像分区设备,则如下所示的日志会被记录到messages文件。

kernel: [W] <type: liscal><event: 144> NMPx I/O port has been closed, mount(0), io(0). (PID=xxxxx) kernel: [I] <type: liscal><event: 144> - This message can be recorded on hotplug service starting when NMPx is not active. kernel: [I] <type: liscal><event: 144> - This message can be recorded by fsck command when NMPx becomes active. kernel: [I] <type: liscal><event: 144> - Ignore this and following messages 'Buffer I/O error on device NMPx' on such environment. : kernel: Buffer I/O error on device /dev/NMPx, logical block xxxx kernel: [W] <type: liscal><event: 144> NMPx I/O port has been closed, mount(0), io(0). (PID=xxxxx) : kernel: [W] <type: liscal><event: 144> NMPx I/O port has been closed, mount(0), io(0). (PID=xxxxx)

kernel: <liscal liscal_make_request> NMPx I/O port is close, mount(0), io(0). kernel: Buffer I/O error on device /dev/NMPx, logical block xxxx

(x或 xxxx中填入字符串)

因udev环境而导致的

在这种情况下,在镜像驱动程序加载时,与"kernel: Buffer I/O error on device /dev/NMPx, logical block xxxx"的消息一起,"kernel: [I] <type: liscal><event: 141>"的消息也会被记录。

本消息并不表示属于异常,也不会影响到EXPRESSCLUSTER的运作。

有关详情,请参阅本章的"关于udev等环境下的镜像驱动程序加载时的错误信息"。

运行OS的信息收集命令(sosreport, sysreport, blkid 命令等)时

在这种情况下,本消息并不表示属于异常,也不会影响到EXPRESSCLUSTER的运作。

若运行OS所提供的信息收集命令,则访问OS所识别的设备。此时,也会访问停止状态的镜像磁盘,其结果,上述的消息也会被记录。

没有通过EXPRESSCLUSTER的设置等抑制此消息的方法。

镜像磁盘的Unmount超时时

在这种情况下,与提示镜像磁盘资源的Unmount超时的消息一起,此消息也会被记录。

EXPRESSCLUSTER会进行镜像磁盘资源的"查出停止异常的恢复动作"。此外,文件系统有可执行发生不一致。

有关详情,请参阅本章的"因大量I/O而导致的缓存增大"。

在镜像磁盘停止食变为被Mount的状态的情况下

在这种情况下,在以下的流程后,上述的消息会被记录。

镜像磁盘资源变为启动状态后,可通过用户或应用程序(NFS等),针对镜像分区的设备(/dev/NMPx)或镜像磁盘资源的Mount point内,会添加进行Mount。

之后,保持不Unmount在(1)所添加的Mount point的状态,将镜像磁盘资源置为停止。

虽不影响到EXPRESSCLUSTER的运作,但文件系统有可执行发生不一致。

有关详情,请参阅本章的"在镜像磁盘资源等进行复数的Mount时"。

设置复数个镜像磁盘资源时

设置2个以上的镜像磁盘资源时,因启动时的一部分分配的fsck的行为的不同,有可执行输出上述的消息。

有关详情,请参阅本章的"关于使用复数个镜像磁盘资源,共享型磁盘资源时的syslog消息"。

其他,因被某种应用程序访问时

上述以外的情形时,可想象某种应用程序想访问停止状态的镜像磁盘资源。

镜像磁盘资源处于未启动的状态下,不会影响到EXPRESSCLUSTER的运作。

6.5.3. 因大量I/O而导致的缓存增大¶

- 若针对镜像磁盘资源或共享型磁盘资源进行超过磁盘性能的大量写入工作,即使镜像的通信尚未被切断等,但不能控制从写入工作中返回,或有可执行发生不能确保内存的错误。有大量超过处理性能的I/O要求时,文件系统需确保大量的缓存,若缓存或用户空间用的内存(HIGHMEM区)不足,则也有可执行使用内核空间用的内存(NORMAL区)。在这种情况下,请更改下述的内核参数,来抑制内核空间用的内存被利用为缓存。使用sysctl 命令等,设置在OS启动时可以更改参数。

/proc/sys/vm/lowmem_reserve_ratio

- 针对镜像磁盘资源或共享型磁盘资源进行大量的访问时,在磁盘资源停止时的Unmount,文件系统的缓存的内容写入到磁盘有可执行需要花费较长的时间。此时,若在从文件系统写入磁盘的工作结束之前,发生Unmount超时,则如下述所示的I/O错误的消息,Unmount失败的消息有可执行会被记录。在这种情况下,为了保证写入到磁盘的工作能够正常结束,请将相应磁盘资源的Unmount的超时时间设置为留有余力的值。

≪例1≫

clusterpro: [I] <type: rc><event: 40> Stopping mdx resource has started. kernel: [I] <type: liscal><event: 193> NMPx close I/O port OK. kernel: [I] <type: liscal><event: 195> NMPx close mount port OK. kernel: [I] <type: liscal><event: 144> NMPx I/O port has been closed, mount(0), io(0). kernel: [I] <type: liscal><event: 144> - This message can be recorded on hotplug service starting when NMPx is not active. kernel: [I] <type: liscal><event: 144> - This message can be recorded by fsck command when NMPx becomes active. kernel: [I] <type: liscal><event: 144> - Ignore this and following messages 'Buffer I/O error on device NMPx' on such environment. kernel: Buffer I/O error on device NMPx, logical block xxxx kernel: [I] <type: liscal><event: 144> NMPx I/O port has been closed, mount(0), io(0). kernel: Buffer I/O error on device NMPx, logical block xxxx :

≪例2≫