1. 前言¶

1.1. 读者对象及用途¶

《EXPRESSCLUSTER® X安装&设置指南》面向导入使用了EXPRESSCLUSTER的集群系统的系统工程师以及导入集群系统后进行维护/操作的系统管理员,对从导入使用了EXPRESSCLUSTER的集群系统到开始操作前的必需事项进行说明。

本手册按照实际导入集群系统时的顺序,依次对使用了EXPRESSCLUSTER的集群系统的设计方法,EXPRESSCLUSTER的安装和设置步骤以及操作开始前所必需的测试步骤进行说明。

1.2. 本手册的构成¶

4. 安装EXPRESSCLUSTER: 对安装EXPRESSCLUSTER的步骤进行说明。

11. 卸载/重装EXPRESSCLUSTER: 对卸载,重装信息进行说明。

1.3. EXPRESSCLUSTER X手册体系¶

EXPRESSCLUSTER X 的手册分为以下 5 类。各指南的标题和用途如下所示。

《EXPRESSCLUSTER X 开始指南》(Getting Started Guide)

本手册的读者对象为使用EXPRESSCLUSTER的用户,对产品概要,运行环境,升级信息,现有的问题等进行了说明。

《EXPRESSCLUSTER X 安装&设置指南》(Install and Configuration Guide)

本手册的读者对象为导入使用EXPRESSCLUSTER的集群系统的系统工程师以及导入集群系统后进行维护和操作的系统管理员,对导入使用EXPRESSCLUSTER的集群系统后到开始操作前的必备事项进行说明。手册按照实际导入集群系统时的顺序,对使用EXPRESSCLUSTER 的集群系统的设计方法,EXPRESSCLUSTER 的安装设置步骤,设置后的确认以及开始操作前的测试方法进行了说明。

《EXPRESSCLUSTER X 参考指南》(Reference Guide)

本手册的读者对象为管理员以及导入使用了EXPRESSCLUSTER的集群系统的系统工程师,对EXPRESSCLUSTER的操作步骤,各模块的功能以及疑难解答信息等进行了说明,是对《安装&设置指南》的补充。

《EXPRESSCLUSTER X 维护指南》(Maintenance Guide)

本手册的读者对象为管理员以及导入使用EXPRESSCLUSTER的集群系统后进行维护和操作的系统管理员,对EXPRESSCLUSTER的维护的相关信息进行了说明。

《EXPRESSCLUSTER X 硬件整合指南》 (Hardware Feature Guide)

本手册的读者对象为管理员以及导入使用EXPRESSCLUSTER的集群系统的系统工程师,对特定的硬件以及与其整合的功能进行说明。是对《安装&设置指南》的补充。

1.4. 本手册的标记规则¶

在本手册中,需要注意的事项,重要的事项以及相关信息等用如下方法标记。

注解

表示虽然比较重要,但是并不会引起数据损失或系统以及机器损伤的信息。

重要

表示为避免数据损失和系统,机器损坏所必需的信息。

参见

表示参考信息的位置。

另外,在手册中使用以下标记法。

标记 |

使用方法 |

例 |

|---|---|---|

[ ]方括号

|

在命令名的前后,

显示在画面中的字句 (对话框,菜单等) 的前后。

|

点击[开始]。

[属性]对话框

|

命令行中的[ ]方括号 |

表示括号内的值可以不予指定(可省)。 |

|

# |

表示Linux用户正以root身份登录的提示符。 |

|

等宽字体

|

路径名,命令行,系统输出(消息,提示等),目录,文件名,函数,参数。

|

/Linux/5.1/cn/server/ |

粗体

|

表示用户在命令提示符后实际输入的值。

|

输入以下内容。

clpcl -s -a

|

斜体 |

用户将其替换为有效值后输入的项目。

|

rpm -i expresscls -<版本编号>-<发行编号>.x86_64.rpm |

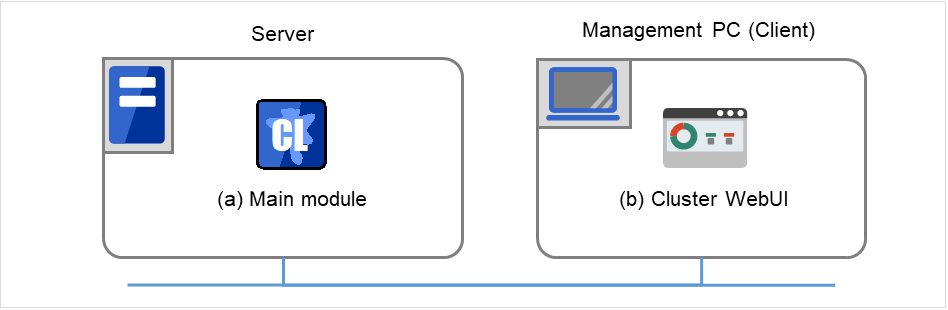

在本手册的图中,为了表示EXPRESSCLUSTER,使用该图标。

在本手册的图中,为了表示EXPRESSCLUSTER,使用该图标。

2. 确定系统配置¶

本章对使用EXPRESSCLUSTER的集群系统的系统配置的确定方法进行说明。

本章中说明的项目如下所示。

2.1. 从设计集群系统到开始操作前的流程¶

构筑使用EXPRESSCLUSTER的集群系统前,需要充分考虑所需的硬件环境,所用的软件,运行形态等,进行系统设计。

此外,构筑集群后开始操作前,需要测试集群系统是否构筑妥当。

本指南对这一系列的流程进行说明。请在实际执行导入集群系统的步骤的同时,一步一步阅读本手册。下面对从使用了EXPRESSCLUSTER的集群系统的设计到开始操作前的流程进行说明。

设计集群系统

进行安装EXPRESSCLUSTER前的必要工作。确定要构筑的集群系统的硬件配置,设置内容。

EXPRESSCLUSTER X的安装和设置

执行EXPRESSCLUSTER的安装。向服务器安装EXPRESSCLUSTER,使用步骤1,步骤2中创建的配置信息用Cluster WebUI生成配置信息文件,构筑集群系统。然后,确认系统是否正常运行。

操作集群系统前的准备

操作EXPRESSCLUSTER前,必须测试。检查完构筑的系统的运行情况后,确认操作前的必须事项。最后介绍卸载以及重装的步骤。

参见

要按照本指南介绍的流程进行操作时,需要在遵照本指南的步骤的同时,随时参考《EXPRESSCLUSTER X 参考指南》。此外,关于运行环境及发布信息等最新信息,请参考《EXPRESSCLUSTER X 开始指南》。

2.2. 何谓EXPRESSCLUSTER ?¶

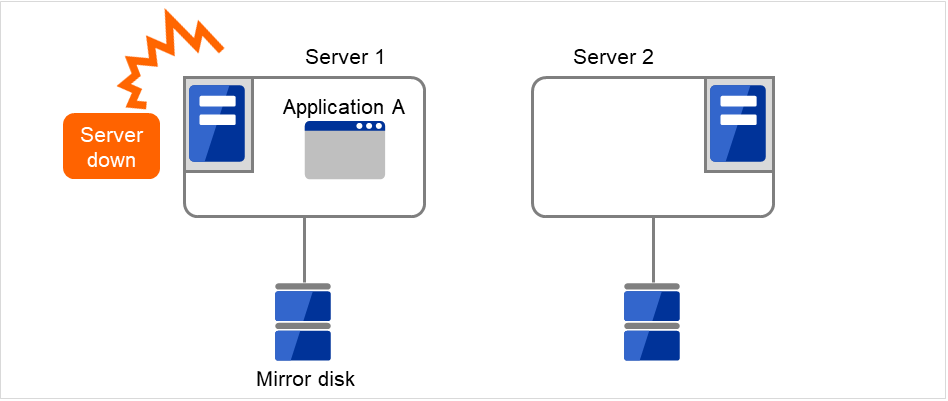

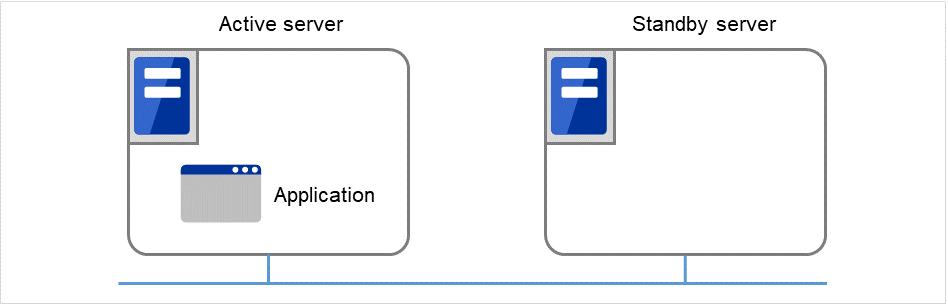

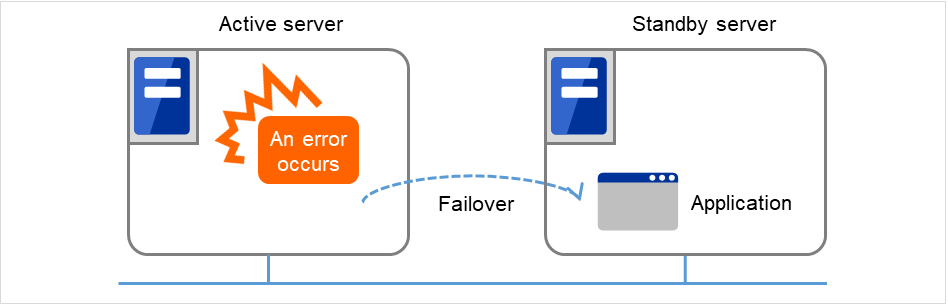

EXPRESSCLUSTER是指通过冗余化(集群化)的系统配置,当正在操作的服务器出现故障时,自动将业务交接到待机服务器,从而能够显著提高系统的可用性和扩展性。

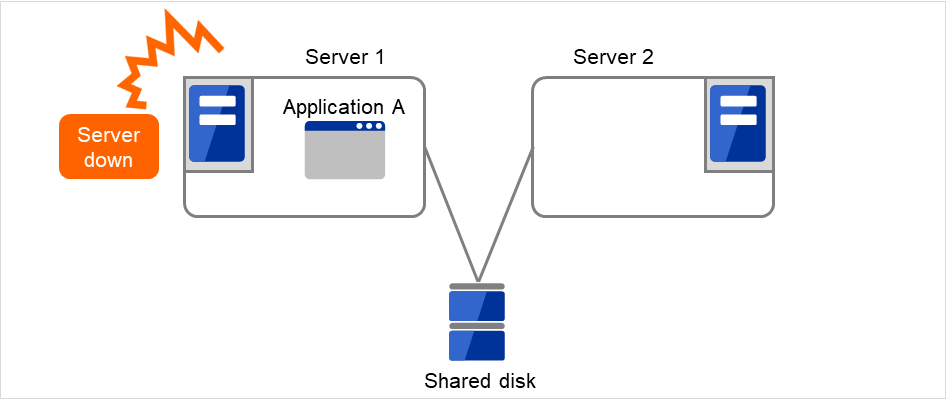

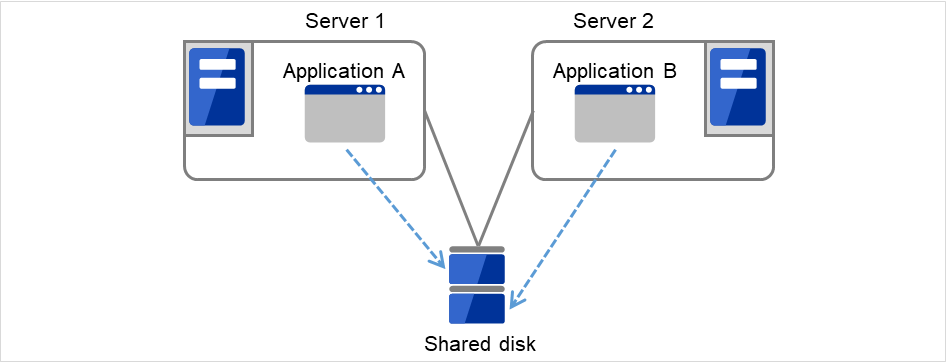

图 2.1 集群系统(正常运行时)¶

图 2.2 集群系统(发生错误时)¶

通过导入使用了EXPRESSCLUSTER的集群系统,可以获得以下效果。

- 高可用性即使由于故障等,构成集群的服务器中的一台停止了,也可以自动将该服务器正在处理的业务交接到其他的正常的服务器上,从而将故障时的业务停止时间控制在最小程度。

- 高扩展性最多可支持32台平行数据库,从而提供高扩展性的高性能数据库平台。

参见

关于EXPRESSCLUSTER的详细信息,请参考《开始指南》的"何谓集群系统", "EXPRESSCLUSTER的使用方法"。

2.3. 关于系统配置的讨论¶

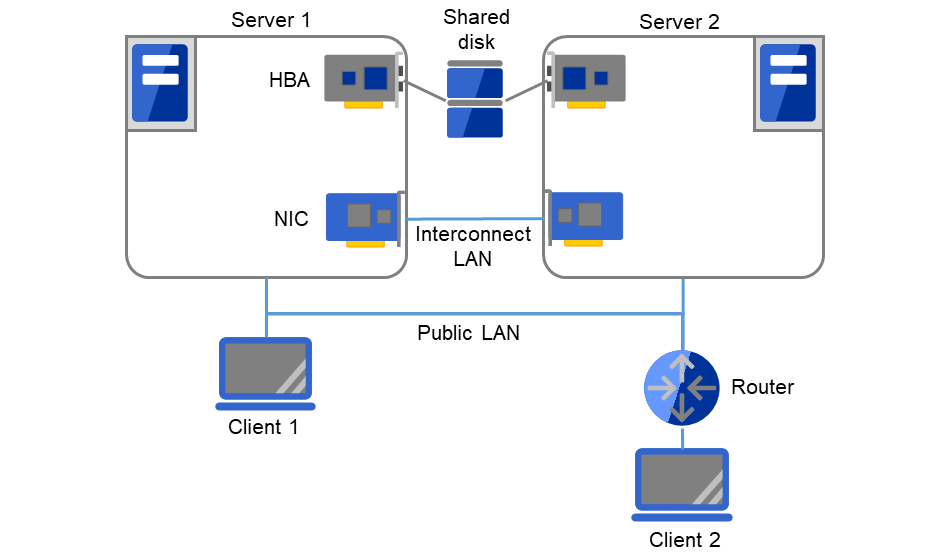

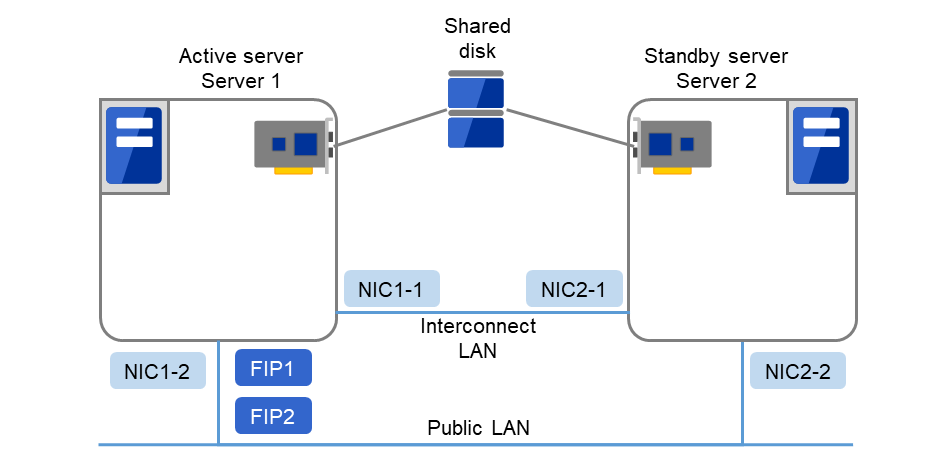

确认了要构筑的集群的用途和运行形态后,再确定硬件配置。下面描述了EXPRESSCLUSTER的配置示例。

参见

运行环境及发布信息等最新信息请参考《开始指南》。

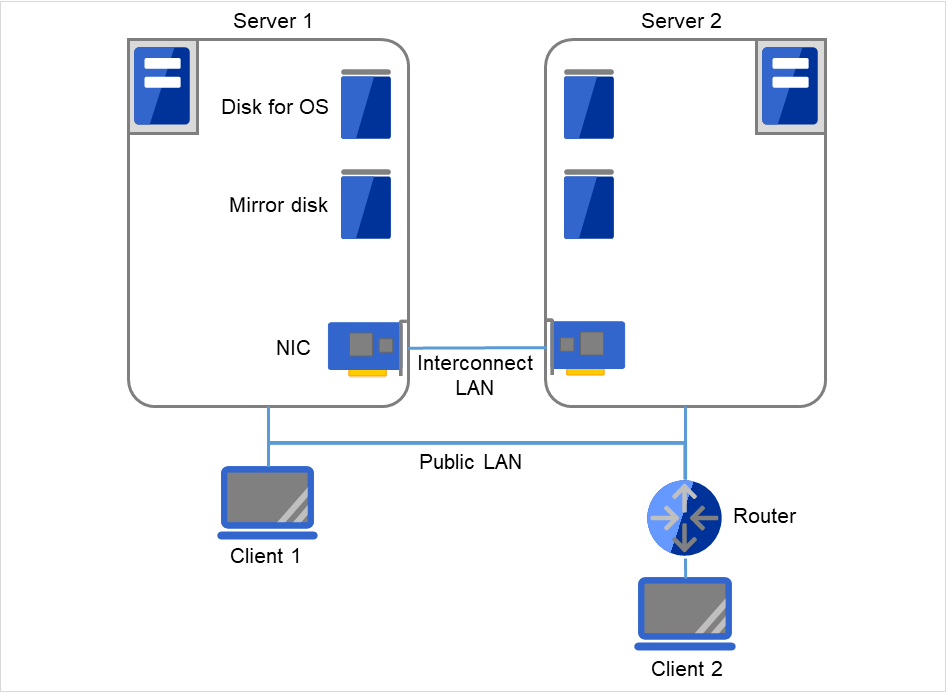

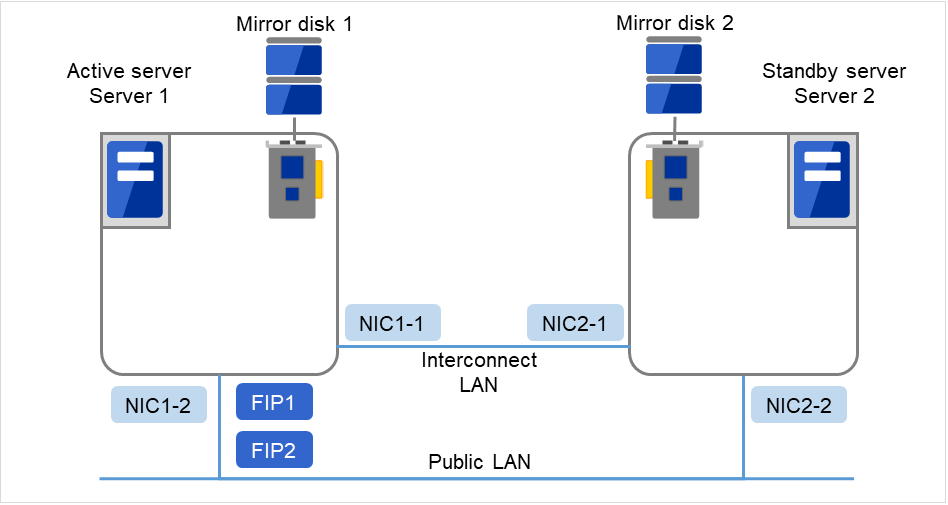

2.3.3. 在2个节点上使用镜像专用磁盘时的配置示例¶

服务器可以是不同的机型,但是必须是同一结构。

使用LAN电缆连接私网。用于镜像的私网(镜像磁盘传输线)通过LAN电缆直接连接,请不要通过HUB等进行连接。

图 2.5 在2个节点上使用镜像专用磁盘时的配置示例¶

集群服务器和同一个LAN上的客户端(Client 1),可以使用浮动IP连接到集群服务器。 远程LAN上的客户端(Client 2)也可以使用浮动IP连接到集群服务器。 在路由器(Router)中不需要进行特殊的设置,即可使用浮动IP。

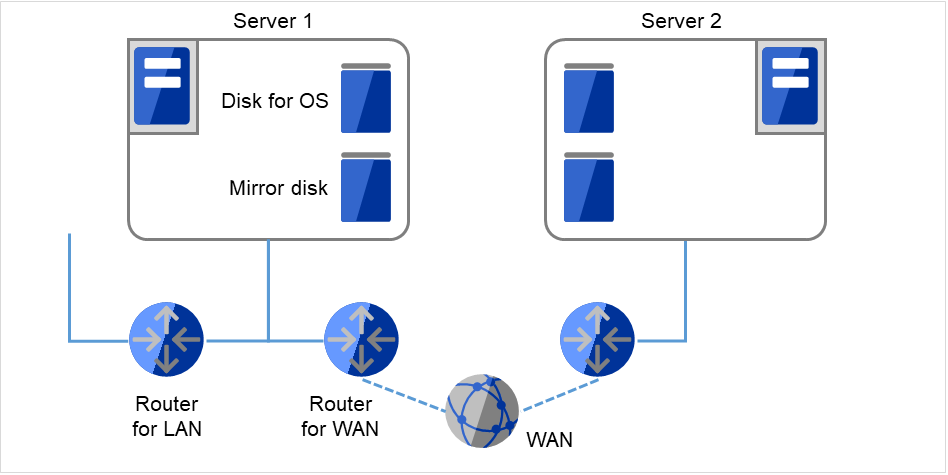

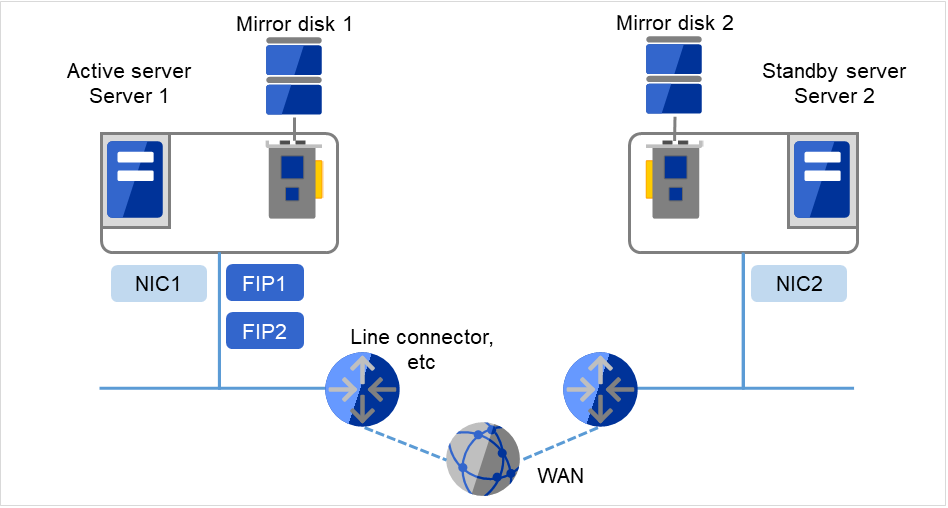

2.3.4. 在2个节点上使用镜像专用磁盘且LAN为1个系统时的配置示例¶

服务器可以是不同的机型,但是必须是同一结构。

图 2.6 在2个节点上使用镜像专用磁盘,且LAN为1个系统时的配置示例¶

将WAN路由器,LAN路由器等设置为Ping NP解决方式的监视目标。 WAN的吞吐量必须足够快,得以承受业务中的数据更新。 EXPRESSCLUSTER没有提高线速的功能。

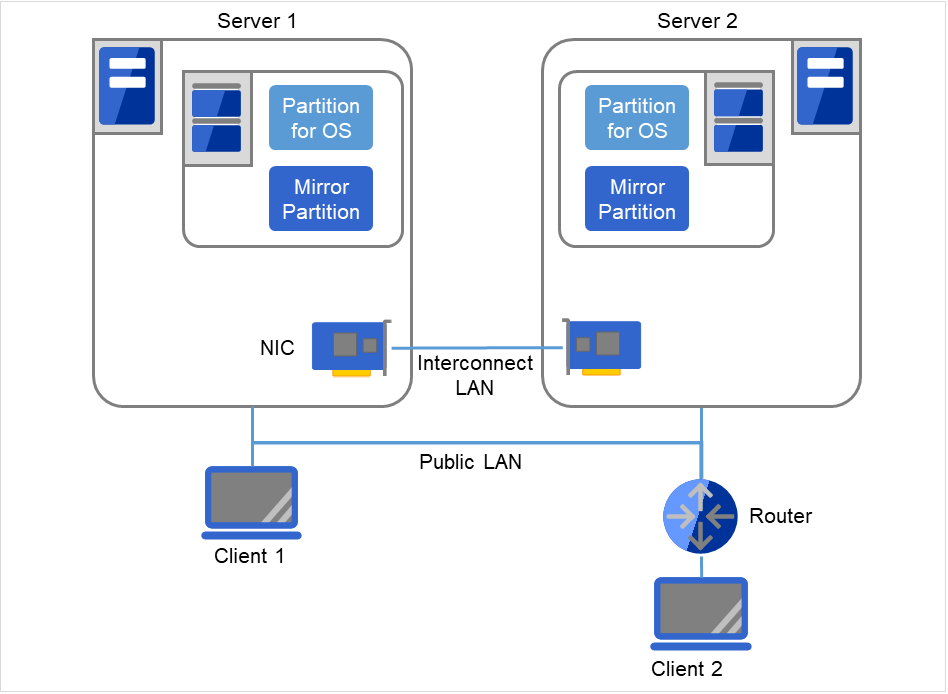

2.3.5. 在2个节点上为系统盘使用镜像空间时的配置示例¶

如下图所示,用于镜像的分区和OS使用的磁盘(系统盘)可以分配到同一磁盘。

图 2.7 在2个节点上为系统盘使用镜像空间时的配置示例¶

集群服务器和同一个LAN上的客户端(Client 1),可以使用浮动IP连接到集群服务器。 远程LAN上的客户端(Client 2)也可以使用浮动IP连接到集群服务器。 在路由器(Router)中不需要进行特殊的设置,即可使用浮动IP。

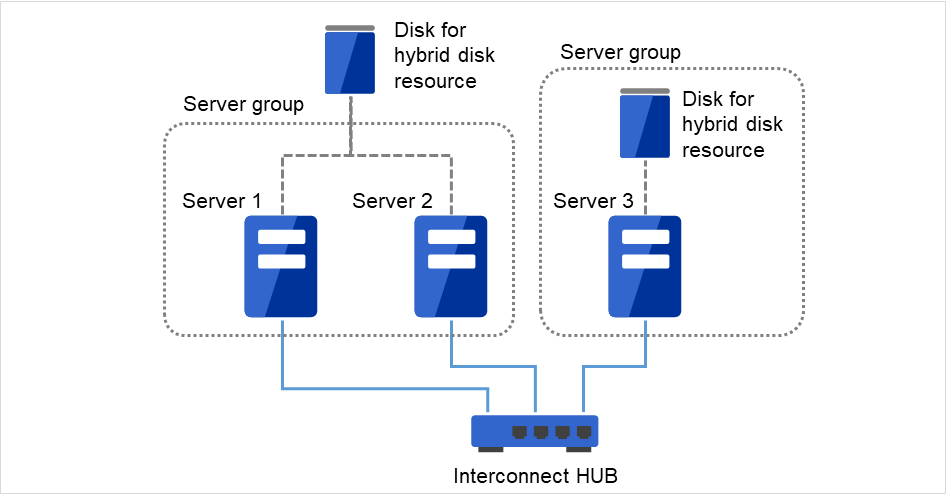

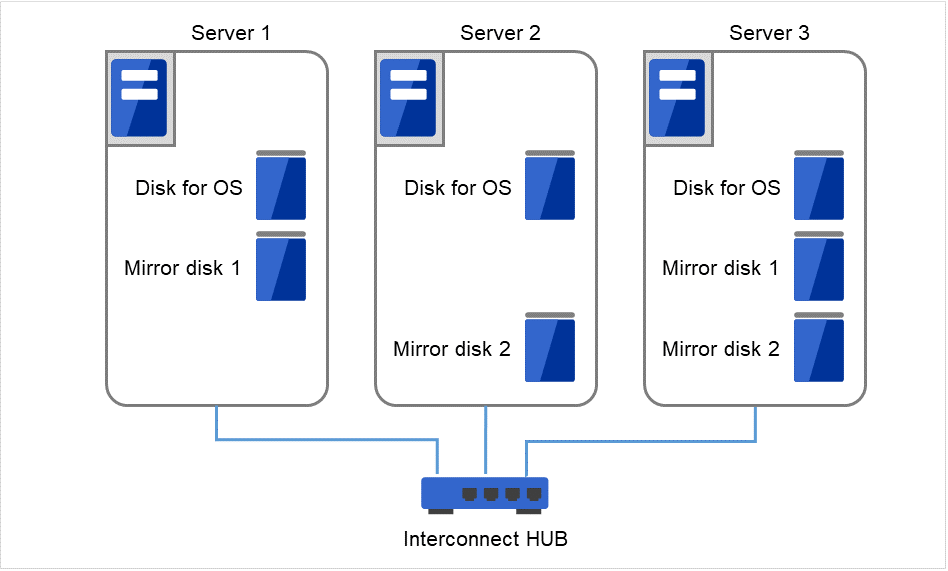

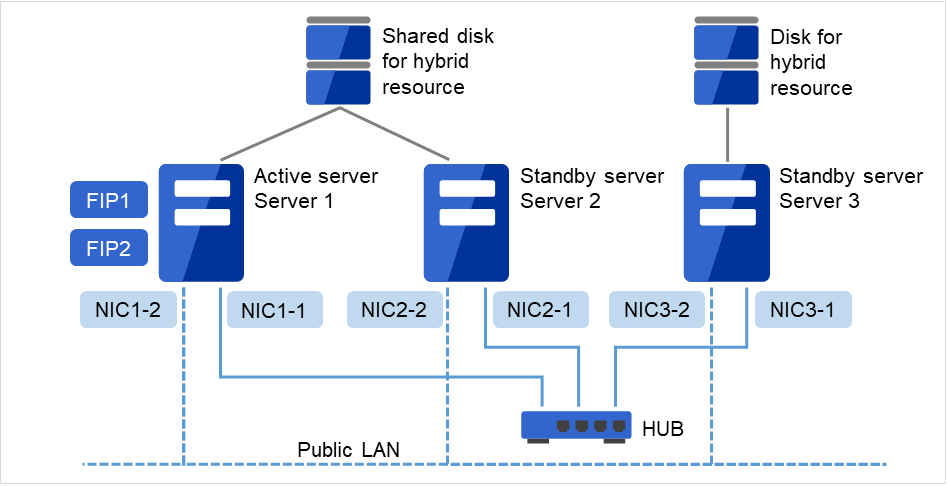

2.3.6. 3个节点的配置示例¶

3个节点时,镜像资源在待机系集约服务器(下图为服务器3)里准备2个镜像磁盘。

通过专用HUB进行私网兼镜像数据传输线LAN的连接。

请尽可执行使用高速的HUB。

不需要通过RS-232C进行服务器之间的连接。

图 2.8 3个节点的配置示例¶

私网LAN连接到私网专用HUB(Interconnect HUB)。私网专用HUB不能连接其他的服务器和客户端。

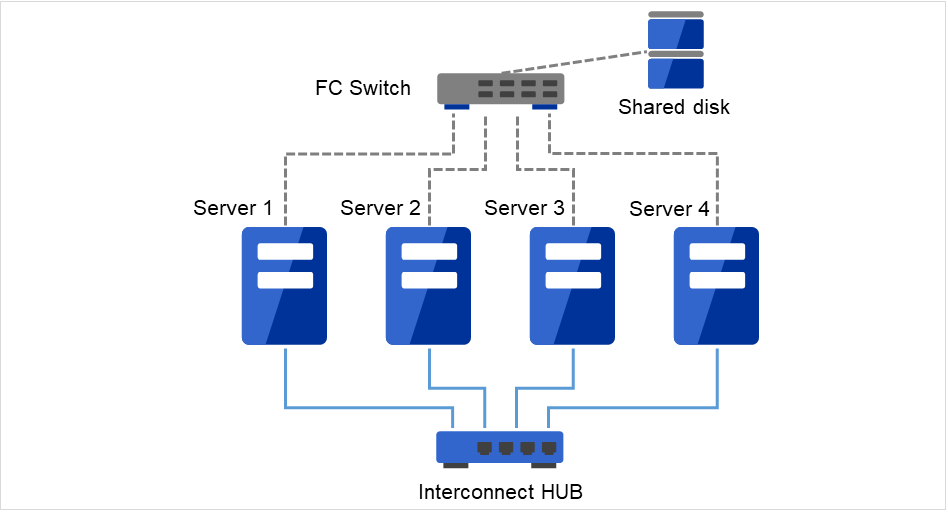

2.3.7. 4个节点的配置示例¶

与2节点时一样,连接共享磁盘

通过专用HUB连接私网。

不需要通过RS-232C进行服务器之间的连接。

图 2.9 4个节点的配置示例¶

私网LAN连接到私网专用HUB(Interconnect HUB)。私网专用HUB不能连接其他的服务器和客户端。

2.4. 确认各EXPRESSCLUSTER模块的运行环境¶

EXPRESSCLUSTER的基本模块由EXPRESSCLUSTER Server(本体模块),Cluster WebUI 构成。请分别确认使用各模块的机器的运行环境。运行环境请参照《开始指南》的"EXPRESSCLUSTER的运行环境"。

2.5. EXPRESSCLUSTER(本体模块)的硬件配置示例¶

EXPRESSCLUSTER的本体模块安装在构筑集群的各服务器上。Cluster WebUI 为EXPRESSCLUSTER 本体模块的一部分,安装EXPRESSCLUSTER本体时自动安装。

2.6. 确认Cluster WebUI 的运行环境¶

为了监视使用了EXPRESSCLUSTER的集群系统的状态,Cluster WebUI通过普通的Web浏览器从管理PC进行访问。为此,管理PC需要能够通过网络访问集群。该管理PC的操作系统可以是Linux也可以是Windows。

关于已经确认Cluster WebUI运行的OS,已经确认运行的浏览器,需要内存容量/磁盘容量等最新的运行环境信息,请参考《开始指南》。

2.8. 配置硬件后的设置¶

确定硬件配置并实际设置了硬件后,请确认以下事项。

2.8.2. 设置共享型磁盘资源用的共享磁盘 (使用Replicator DR时必需)¶

注解

如果要继续使用共享磁盘上的数据(重装服务器时等),请不要申请分区及创建文件系统。如果申请分区或创建文件系统,则共享磁盘上的数据将被删除。

- 确保集群分区创建镜像驱动独自使用的分区。该分区用于镜像驱动器或镜像代理对共享型磁盘的状态的管理。从使用共享磁盘的集群中的1台服务器创建。使用fdisk 命令申请。

注解

用于CLUSTER的分区请确保在1024MiB 以上。(即使刚好指定为1024MB,但由于磁盘几何信息的差异,实际上可以保证大于1024MB,因此没有问题)。并且,请不要在CLUSTER分区里构建文件系统。

- 初始化集群分区(仅在沿用过去作为EXPRESSCLUSTER镜像磁盘,共享型磁盘使用的共享磁盘时必需)

因为集群分区中留有以前的数据,所以需要初始化。

即使再申请分区,分区上的数据还是保留下来,所以再次使用作为EXPRESSCLUSTER镜像磁盘或共享型磁盘等使用过的磁盘时,必须执行该操作。

从使用共享磁盘的集群中的1台服务器执行以下命令。

dd if=/dev/zero of=[作为集群分区使用的分区设备名]

注解

执行dd命令后,of=中指定的分区的数据将被初始化。请充分确认分区设备名后再执行dd命令。

注解

执行dd命令时,虽然会显示以下的消息,但不是异常。

dd:writing to [作为集群分区使用的分区设备名]: No space left on device

- 申请共享型磁盘资源用的分区在共享磁盘上创建共享型磁盘资源使用的分区。在使用共享资源的集群中的1台服务器上创建该分区。使用fdisk命令申请。

- 关于文件系统做成对于共享型磁盘资源用的分区需要作成文件系统。

使用有数台服务器的组资源(共享型镜像磁盘资源)时,请在组资源内任意一台服务器作成文件系统。

虽然基本上与镜像资源中使用的文件系统没有依存关系,但根据文件系统的fsck的规格不同,有时候可执行会发生问题。

为了提高系统的故障应对能力,建议使用带分类日志功能的文件系统。

目前已完成运行确认的文件系统具体如下。

ext3

ext4

xfs

reiserfs

jfs

vxfs

不创建文件系统,直接访问分区的方法也是可以的。

注解

EXPRESSCLUSTER控制共享型磁盘资源上的文件系统。共享型磁盘资源和共享型磁盘用的分区不要记入操作系统的/etc/fstab中。(也请不要登录带ignore选项的/etc/fstab。)

注解

vxfs能够使用的版本和内核请参照vxfs的支持列表。

注解

如果因为忘记作成文件系统而发生了问题的时候,请执行下面的操作。

- 集群启动着的时候,停止集群。使用Cluster WebUI时:[服务] -> [停止集群]使用命令行时:使用clpcl命令

- 镜像代理启动着的时候,停止镜像代理。使用Cluster WebUI时:[服务] -> [停止镜像代理]使用命令行时:针对各服务器执行「service EXPRESSCLUSTER_md stop」

- 解除共享型磁盘分区的访问限制。使用clproset命令(例:clproset -w -d <作为集群分区使用的分区设备>等)

- 作成文件系统。使用mkfs命令(例:mkfs -t ext3<作为集群分区使用的分区设备> 等)

- 重启系统。

- 申请磁盘心跳分区在共享磁盘上创建EXPRESSCLUSTER单独使用的分区。该分区由磁盘心跳资源使用。通过使用共享磁盘的集群中的一台服务器创建分区。使用fdisk 命令申请。

注解

通常情况下,心跳资源使用1个分区。但,当磁盘故障等引起设备名不一致时,需要通过其他LUN进行心跳。因此,除了通常心跳使用的LUN之外,对各个LUN预留1个伪磁盘心跳资源的分区。这时,请确保磁盘心跳专用分区的分区号在各 LUN上是相同的。

注解

用于磁盘心跳的分区请确保在10MB (10*1024*1024 字节) 以上。此外,不要在磁盘心跳所使用的分区上创建文件系统。

- 创建Mount点创建mount共享型镜像磁盘资源分区的目录。在使用共享型镜像磁盘资源,连接共享磁盘的各服务器上创建。另外,对于共享型磁盘资源分区不使用文件系统时,不需要创建Mount点。

2.8.3. 设置共享型镜像磁盘资源用的分区(使用Replicator DR时必需)¶

按照以下步骤设置将非共享磁盘(服务器内置磁盘或非共享型外置磁盘)作为共享型磁盘资源使用时的分区。使用共享型磁盘资源时(使用Replicator时),请参考"设置共享型镜像磁盘用分区"。

普通的镜像构成 (使用Replicator时)请参考"2.8.4. 设置镜像磁盘资源用的分区(使用Replicator时必需)"。

使用共享磁盘作为共享型磁盘资源时,请参考"2.8.2. 设置共享型磁盘资源用的共享磁盘 (使用Replicator DR时必需)"。

注解

集群化单个服务器等,要继续使用既存分区上的数据的情况下,在重启服务器时,请不要创建镜像磁盘资源用的分区或做成文件系统。如果申请镜像磁盘资源用的分区或做成文件系统,则分区上的数据会被删除。

- 申请集群分区创建镜像驱动器单独使用的分区。该分区用于镜像驱动器或镜像代理对共享型磁盘状态的管理。使用fdisk命令申请。

注解

用于CLUSTER的分区请确保在1024MiB 以上。(即使刚好指定为1024MB,但由于磁盘几何属性的差异,实际上可以保证大于1024MB,因此没有问题)。此外,在集群分区上不要创建文件系统。

- 初期化集群分区(仅在沿用过去作为EXPRESSCLUSTER的镜像磁盘,共享型磁盘使用的磁盘时必需)

因为集群分区中留有以前的数据,所以需要初始化。

即使再申请分区,分区上的数据还是保留下来,所以再次使用作为EXPRESSCLUSTER镜像磁盘或共享型磁盘等使用过的磁盘时,必须执行该操作。

执行以下命令。

dd if=/dev/zero of=[作为集群分区使用的分区设备名]

注解

执行dd命令后,of=中指定的分区的数据将被初始化。请充分确认分区设备名后再执行dd命令。

注解

执行dd命令时,虽然会显示以下的消息,但不是异常。

dd:writing to [作为集群分区使用的分区设备名]: No space left on device

- 申请用于共享型镜像资源的分区创建共享型镜像磁盘资源使用的分区。使用fdisk命令申请。

- 创建文件系统需要为用于共享型镜像磁盘资源的分区创建文件系统。

虽然基本上与镜像资源中使用的文件系统没有依存关系,但根据文件系统的fsck 的规格不同,有时候可执行会发生问题。

为了提高系统的故障应对能力,建议使用带分类日志功能的文件系统。

目前已完成运行确认的文件系统具体如下。

ext3

ext4

xfs

reiserfs

jfs

vxfs

未创建文件系统,直接访问分区的方法也是可以的。

注解

镜像资源上的文件系统由EXPRESSCLUSTER控制。镜像资源及镜像资源用的分区请不要在OS 的 /etc/fstab 中登录。(也请不要登录带ignore选项的/etc/fstab。)

注解

可以使用vxfs 的磁盘发布版,内核依存于vxfs 的支持状况。

注解

如果因为忘记作成文件系统而发生了问题的时候,请执行下面的操作。

- 集群启动着的时候,停止集群。使用Cluster WebUI时:[服务] -> [停止集群]使用命令行时:使用clpcl命令

- 镜像代理启动着的时候,停止镜像代理。使用Cluster WebUI时:[服务] -> [停止镜像代理]使用命令行时:针对各服务器执行[service clusterpro_md stop]

- 解除共享型镜像磁盘分区的访问限制。使用clproset命令(例:clproset -w -d <作为集群分区使用的分区设备> 等)

- 作成文件系统。使用mkfs命令(例:mkfs -t ext3 <作为集群分区使用的分区设备> 等)

- 重启系统。

- 创建Mount点创建mount共享型镜像磁盘资源用分区的目录。

另外,对于共享型磁盘资源分区不使用文件系统时,不需要创建Mount点。

2.8.4. 设置镜像磁盘资源用的分区(使用Replicator时必需)¶

按照以下步骤设置镜像用分区。使用共享型磁盘资源时(使用Replicator时),请参考"2.8.3. 设置共享型镜像磁盘资源用的分区(使用Replicator DR时必需)"。

注解

集群化单个服务器等,要继续使用既存分区上的数据的情况下,在重启服务器时,请不要重新创建该分区。如果重建该分区,则既存分区上的数据会被删除。

申请集群分区

创建镜像驱动器单独使用的分区。该分区用于镜像驱动器或镜像代理的状态管理。在使用镜像资源的集群中的所有服务器上依次创建分区。使用fdisk命令申请。注解

用于CLUSTER的分区请确保在1024MiB 以上。(即使刚好指定为1024MB,但由于磁盘几何属性的差异,实际上可以保证大于1024MB,因此没有问题)。此外,不要在集群分区上创建文件系统。

- 集群分区初始化(沿用过去作为EXPRESSCLUSTER的镜像磁盘或共享型磁盘使用的磁盘时必需)

因为集群分区中留有以前的数据,所以需要初始化。

即使再申请分区,分区上的数据还是保留下来,所以再次使用作为EXPRESSCLUSTER镜像磁盘或共享型磁盘等使用过的磁盘时,必须执行该操作。

执行以下命令。

dd if=/dev/zero of=[作为集群分区使用的分区设备名]

注解

执行dd命令后,of=中指定的分区的数据将被初始化。请充分确认分区设备名后再执行dd命令。

注解

执行dd命令时,虽然会显示以下的消息,但不是异常。

dd:writing to [作为集群分区使用的分区设备名] : No space left on device

- 申请用于镜像资源的分区创建镜像资源使用的分区。在使用镜像资源的集群中的所有服务器上依次创建该分区。使用fdisk命令申请。

- 关于文件系统的创建镜像磁盘资源使用的分区的做成中【初始化mkfs】的设定有所不不同。

- 在Cluster WebUI创建集群配置信息时,如果设置了"进行初始mkfs",则EXPRESSCLUSTER自动构筑文件系统。请注意,分区上的既存数据会丢失。

- 在Cluster WebUI创建集群配置信息时,如果没有选择"进行初始mkfs",则EXPRESSCLUSTER不创建文件系统。如果想使用分区上既存文件系统,请事前做成。

关于镜像磁盘用分区,还有以下内容请注意。

虽然基本上与镜像资源中使用的文件系统没有依存关系,但根据文件系统的fsck的规格不同,有时候可执行会发生问题。

为了提高系统的故障应对能力,建议使用带分类日志功能的文件系统。

目前已完成运行确认的文件系统具体如下。

ext3

ext4

xfs

reiserfs

jfs

vxfs

未创建文件系统,直接访问分区的方法也是可以的。

注解

要继续使用原有分区上的数据时,重装服务器等情况下,请不要选择"初始mkfs"。

注解

镜像资源上的文件系统由EXPRESSCLUSTER控制。镜像资源及镜像资源用的分区请不要在OS的 /etc/fstab中登录。(也请不要登录带ignore选项的/etc/fstab。)

注解

可以使用vxfs的磁盘发布版,内核依存于vxfs的支持状况。

- 创建Mount点创建mount镜像资源用分区的目录。在使用镜像资源的集群中的所有服务器上依次创建。另外,对于镜像资源分区不使用文件系统时,不需要创建Mount点。

2.8.5. 调整EXPRESSCLUSTER的服务启动时间(必须)¶

从对构成集群系统的各服务器供电开始,到EXPRESSCLUSTER的服务启动为止的时间要设为比下面的两个时间长的值。

从对共享磁盘供电到可用为止的时间(使用共享磁盘时)

心跳超时的时间 ※默认值90秒

这种设置是为了避免下述问题。

如果开启共享磁盘和服务器的电源启动集群系统,则共享磁盘的启动赶不上EXPRESSCLUSTER的启动处理,在不识别共享磁盘的状态下启动EXPRESSCLUSTER,从而导致磁盘资源的启动失败

想要重启服务器进行失效切换时,如果在心跳超时时间内重启该服务器(启动EXPRESSCLUSTER服务),则另一方的服务器会认为心跳继续,导致无法进行失效切换

因此,测量以上2点的时间后,请通过以下任意一种方法调整启动时间。

请在《EXPRESSCLUSTER X 参考指南》的"参数的详细信息" 的 "集群属性" 的 "超时标签页" 中设置[服务启动延迟时间]。

根据OS boot loader的设置调整OS的启动时间。

(例)调整OS启动时间的示例

在OS boot loader中使用GRUB2时

- 编辑/etc/default/grub。指定GRUB_TIMEOUT=<启动时间 (单位:秒)> 。

(例 启动时间90秒)

GRUB_TIMEOUT=90

执行命令,反映设置变更。

基于BIOS的服务器

# grub2-mkconfig -o /boot/grub2/grub.cfg

基于UEFI的服务器

# grub2-mkconfig -o /boot/efi/EFI/redhat/grub.cfg

2.8.6. 确认网络设置(必需)¶

在集群内的所有服务器上通过ifconfig 命令和ping 命令确认网络是否正常运行。确认多个网络设备(eth0,eth1,eth2... )是否分配给了想要分配的角色(公网,私网)。确认以下网络的状态。

公网(用于与其它机器进行通信)

私网(用于EXPRESSCLUSTER Server间的连接)

主机名

注解

集群使用的浮动IP资源,虚拟IP资源的IP地址无需在OS端进行设置。

2.8.7. 确认防火墙设置(必需)¶

EXPRESSCLUSTER各模块之间的通信使用多个端口号。使用的端口号请参考《开始指南》的"注意限制事项"的"安装OS后,安装EXPRESSCLUSTER前"。

2.8.8. 同步服务器的时间(必需)¶

集群系统推荐定期对集群中的所有服务器的时间进行同步运行。进行相应设置,一天一次左右使用ntp等同步服务器的时间。

注解

如果各服务器的时间未同步,可执行会导致故障时解析原因的时间增加。

2.8.9. 设置 OpenSSL(可选)¶

以下功能中,可以进行使用OpenSSL的加密通信。

Cluster WebUI

Witness心跳

HTTP 网络分区解决资源

邮件通知

在Cluster WebUI中使用OpenSSL时,请准备好证书文件和私钥文件。

准备好的文件用于Cluster WebUI 设置模式的《EXPRESSCLUSTER X 参考指南》 的"参数的详细信息" 的 "集群属性"的"加密 标签页"中的设置。

2.8.10. 进行SELinux相关的设置(必需)¶

确认SELinux 是启用还是禁用。

# getenforce Enforcing

显示单词的含义如下。

Enforcing : 启用(强制执行SELinux策略)

Permissive : SELinux 策略未强制执行,系统继续工作,并改为将警告输出到日志。

Disabled : 禁用(未加载 SELinux 策略)

- 如果要禁用 SELinux,请编辑文件 /etc/selinux/config 中的 SELINUX = enforcing 行,并将 enforcing 更改为 disabled 或 permissive。如果要启用 SELinux,请更改为enforcing。SELINUX = 之后指定的词的含义如下。

enforcing : 启用(强制执行SELinux策略)

permissive : SELinux 策略未强制执行,系统继续工作,并改为将警告输出到日志。

disabled : 禁用(未加载 SELinux 策略)

# vi /etc/selinux/config如果更改设置,请重新启动服务器以使更改生效。

# reboot - 在启用 SELinux(enforcing)的情况下使用 EXPRESSCLUSTER 之前,必须允许加载 EXPRESSCLUSTER 驱动程序。这时请执行以下步骤 4 ~ 10。

请安装以下包。

RHEL8系列的情况

# dnf -y install selinux-policy-mls # dnf -y install selinux-policy-devel

RHEL7系列的情况

# yum -y install selinux-policy-mls # yum -y install selinux-policy-devel

创建一个工作目录并移动到该目录。

# mkdir -p /tmp/te # cd /tmp/te

创建一个用于clpka.ko 驱动程序的.te 文件。

# vi clpka.teclpka.te的文件内容:

# clpka.te module clpka 1.0; require { type unconfined_service_t; type usr_t; class system module_load; } #============= unconfined_service_t ============== allow unconfined_service_t usr_t:system module_load;

创建一个用于clpkhb.ko驱动程序的.te 文件。

# vi clpkhb.teclpkhb.te的文件内容:

# clpkhb.te module clpkhb 1.0; require { type unconfined_service_t; type usr_t; class system module_load; } #============= unconfined_service_t ============== allow unconfined_service_t usr_t:system module_load;

创建一个用于liscal.ko驱动程序的.te 文件。

# vi liscal.teliscal.te的文件内容:

# liscal.te module liscal 1.0; require { type usr_t; type unconfined_service_t; class system module_load; } #============= unconfined_service_t ============== allow unconfined_service_t usr_t:system module_load;

- 执行以下命令。安装包策略文件被创建并且安装。

# make -f /usr/share/selinux/devel/Makefile # semodule -i clpka.pp clpkhb.pp liscal.pp

确认是否已安装3个安装包策略文件。

# semodule -l | grep clp clpka clpkhb

# semodule -l | grep liscal liscal

注解

创建的工作目录也可以删除。

创建集群后,请确保已加载所需的驱动程序。

- 如果将keepalive指定为用户空间监视资源的监视方法,则在集群开始时加载clpka。此外,如果将keepalive指定为关机监视的监视方法时,则在关机监视开始时加载。

如果在私网上设置内核模式LAN心跳,或者使用clpka时,则会加载clpkhb。

在设置镜像磁盘资源或共享型镜像磁盘资源时,加载liscal。

# lsmod | grep clp clpka clpkhb

# lsmod | grep liscal liscal

3. 设计集群系统¶

本章将介绍进行冗余化的应用程序,运行形态,集群配置信息等内容,提供设计集群时的必要信息。

本章的内容如下。

3.1. 设计集群系统¶

设计集群系统主要由以下内容构成。

决定集群系统的运行形态

决定要冗余化的应用程序

创建集群配置信息

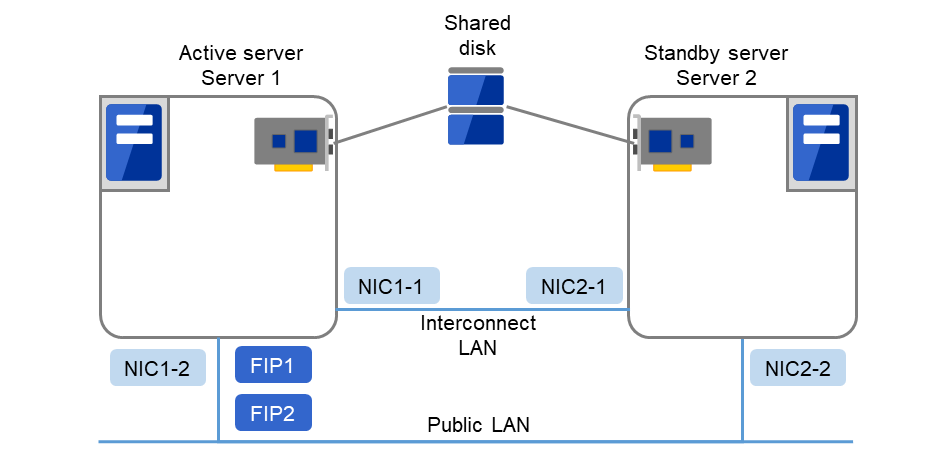

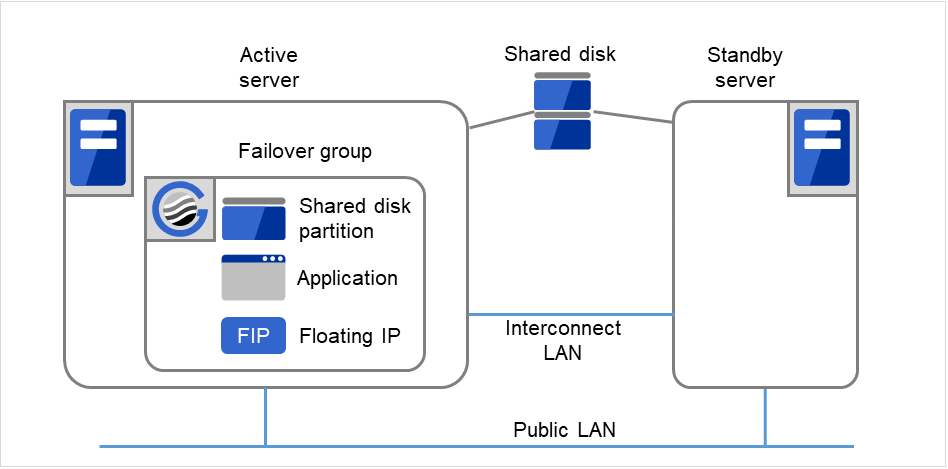

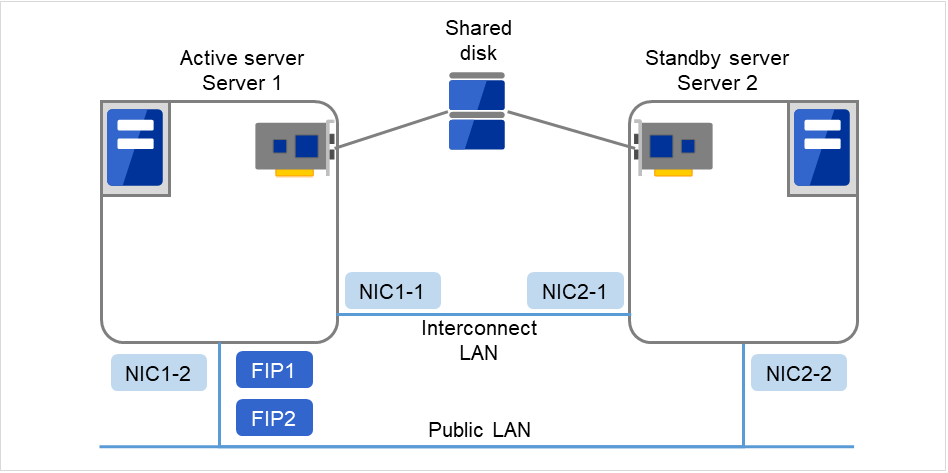

另外,本指南以下图所描述的构筑典型2节点,单向待机的集群环境为例进行说明。

图 3.1 2个节点,单向待机集群的示例¶

FIP1 |

10.0.0.11

(从Cluster WebUI客户端访问)

|

FIP2 |

10.0.0.12

(从业务客户端访问)

|

NIC1-1 |

192.168.0.1 |

NIC1-2 |

10.0.0.1 |

NIC2-1 |

192.168.0.2 |

NIC2-2 |

10.0.0.2 |

RS-232C 设备 |

/dev/ttyS0 |

共享磁盘 (Shared disk)

DISK心跳 设备名

/dev/sdb1

DISK心跳 Raw设备名

/dev/raw/raw1

共享磁盘设备

/dev/sdb2

Mount点

/mnt/sdb2

文件系统

ext3

raw monitor 设备名

不设置

raw monitor 监视对象Raw设备名

/dev/raw/raw1

3.2. 决定运行形态¶

EXPRESSCLUSTER 支持多种形式的运行形态。有以一方服务器作为运行服务器,另一方作为待机服务器的单向待机形式和双方服务器互为不同业务的当前和待机服务器的双向待机形式。

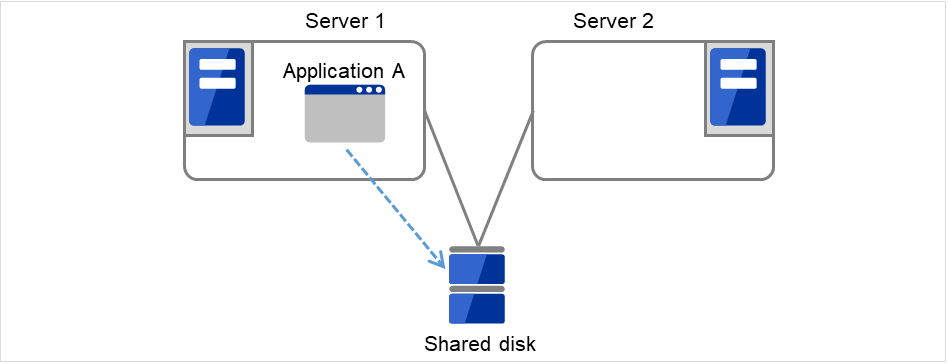

- 单向待机集群集群系统中,同一业务应用程序只有1个系统形态在运行。失效切换发生后虽然没有性能下降等问题,但正常运行时,待机服务器的资源是一种浪费。

图 3.2 单向待机集群¶

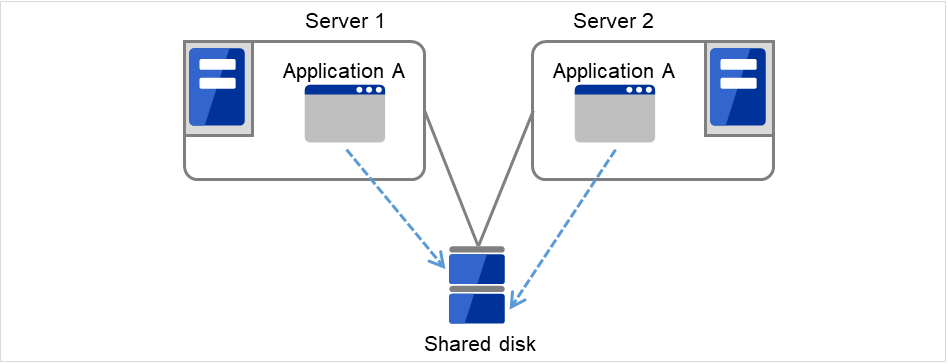

- 同一应用程序双向待机集群集群系统中,同一业务应用程序有多个系统形态在运行。构筑这样的形态,需要支持业务的多重启动。

图 3.3 同一应用程序双向待机集群¶

- 不同种类应用程序双向待机集群不同种类的业务应用程序在各自的服务器上运行,相互处于待机的系统形态。正常运行时,资源也不浪费。但是,失效切换发生后,因1台服务器上运行2种业务,所以,业务的性能会降低。

图 3.4 不同种类应用程序双向待机集群¶

3.2.1. 单向待机集群失效切换的流程¶

单向待机集群中,某一业务运行的组在集群内通常被限制在1台服务器上运行。

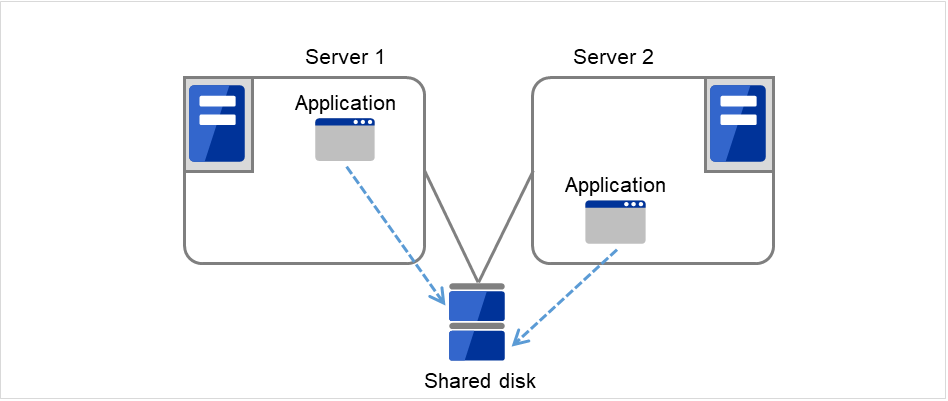

3.2.1.1. 使用共享磁盘时¶

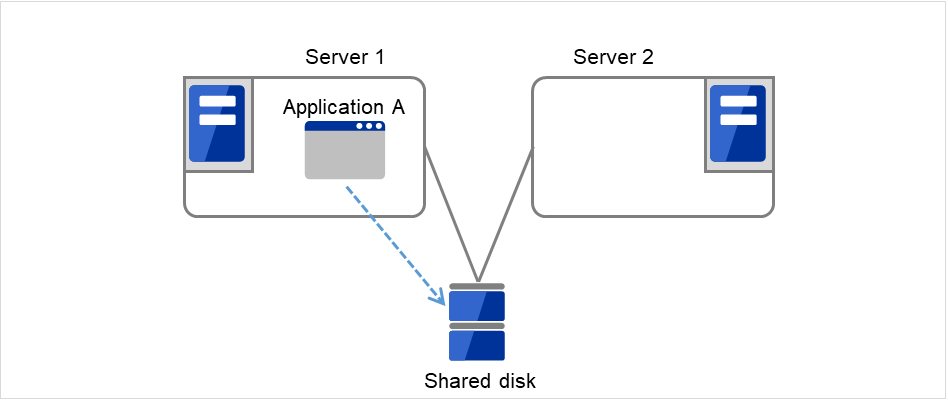

1. 在Server 1上执行业务A(Application A)。 在此,在同一集群内,业务A不能被执行多次。

图 3.5 单向待机集群(使用共享磁盘): (1) 一般使用时¶

3.2.2. 双向待机集群失效切换的流程¶

双向待机集群中,因某一业务可以同时在多个服务器上运行,所以,执行失效切换时,运行服务器会增加负荷。

3.2.2.1. 使用共享磁盘时¶

在Server 1执行业务A(Application A),在Server 2上执行业务B(Application B)。

图 3.14 双向待机集群(使用共享磁盘): (1) 一般使用时¶

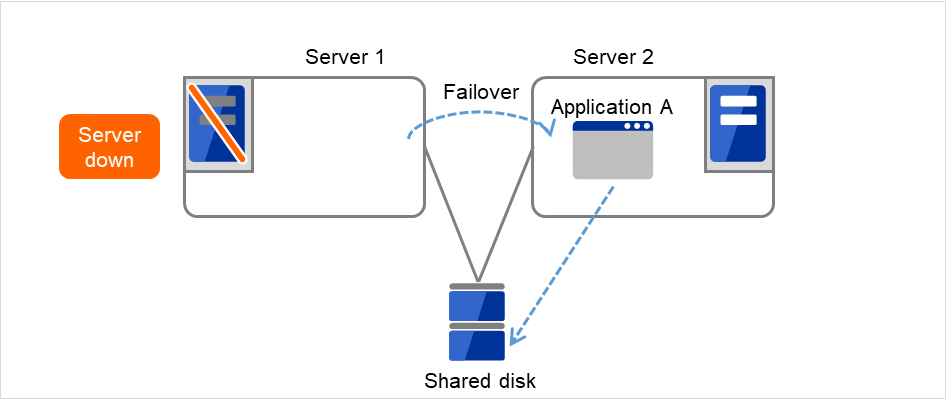

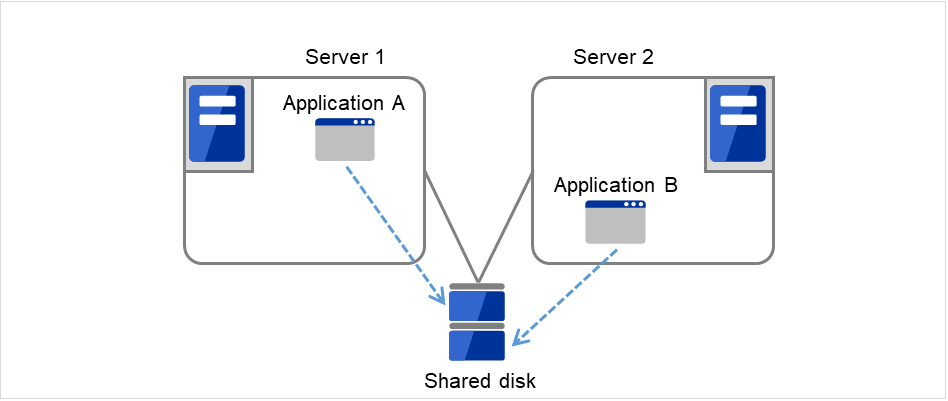

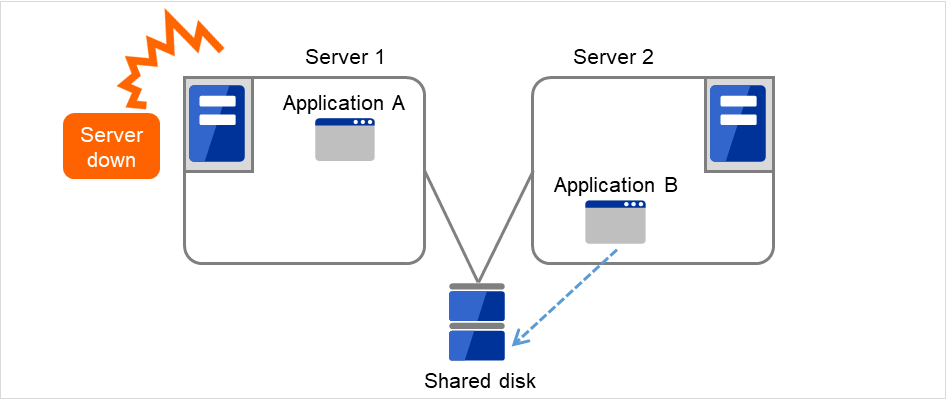

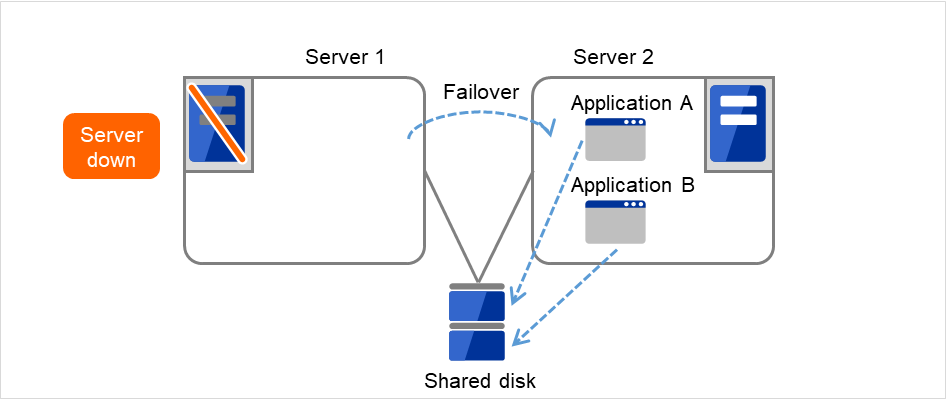

某处发生异常,Server 1宕机。

图 3.15 双向待机集群(使用共享磁盘): (2) 服务器宕机时¶

业务A从Server 1交接到Server 2。

图 3.16 双向待机集群(使用共享磁盘): (3) 失效切换时¶

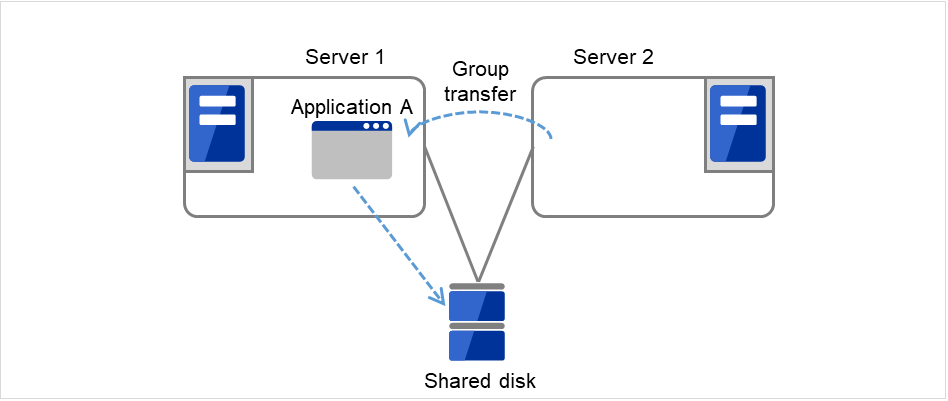

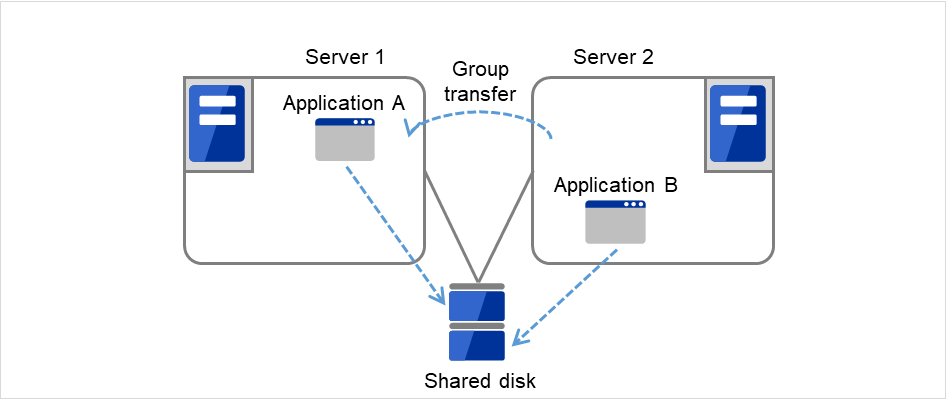

恢复Server 1后,可以将业务A(Application A)的组从Server 2移动到Server 1。

图 3.17 双向待机集群(使用共享磁盘): (4) 服务器恢复后¶

3.2.2.2. 使用镜像磁盘时¶

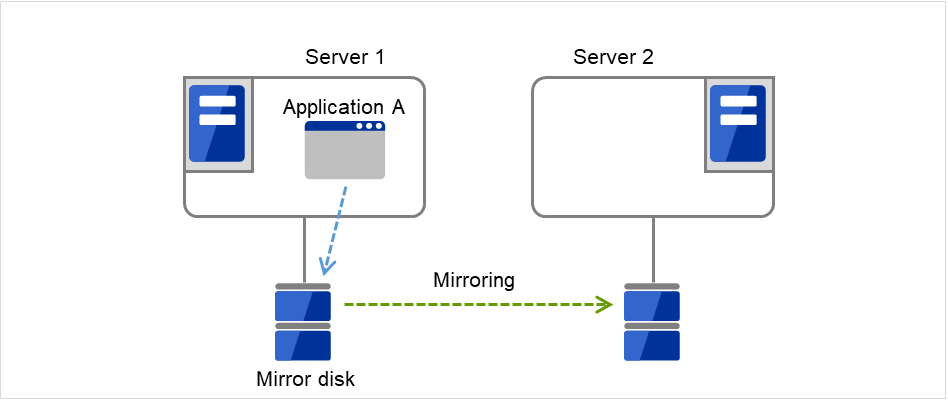

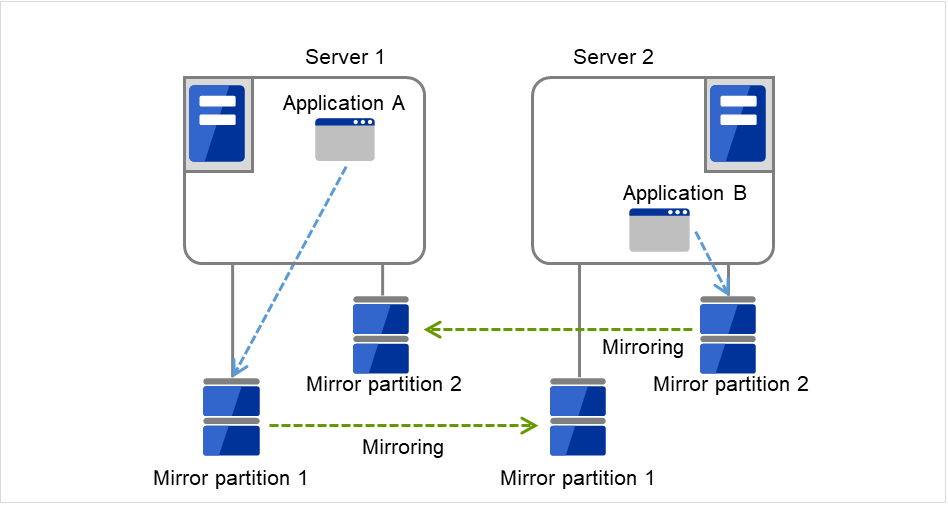

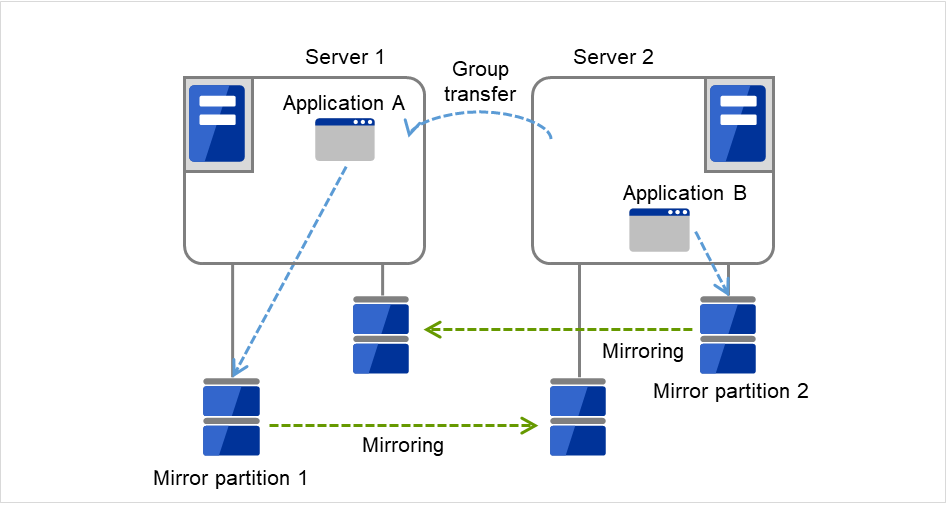

在Server 1执行业务A(Application A),在Server 2上执行业务B(Application B)。

图 3.18 双向待机集群(使用镜像磁盘): (1) 一般使用时¶

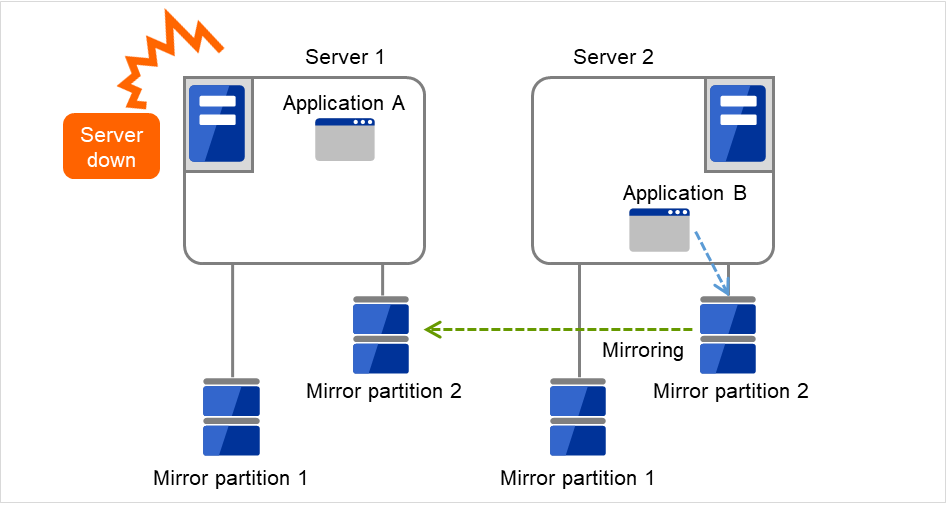

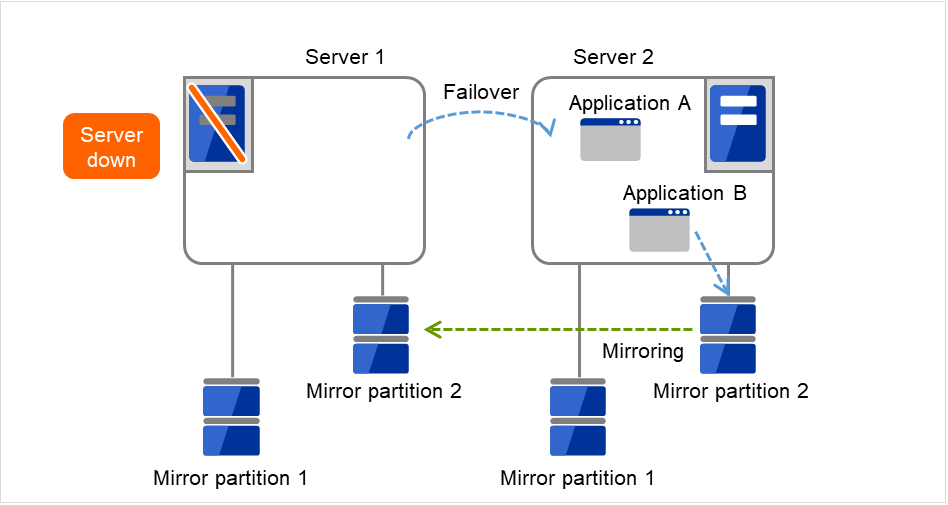

某处发生异常,Server 1宕机。

图 3.19 双向待机集群(使用镜像磁盘): (2) 服务器宕机时¶

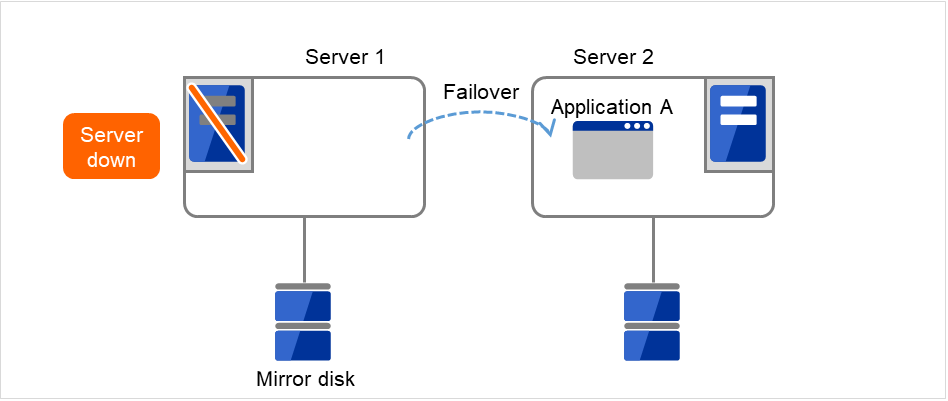

业务A从Server 1交接到Server 2。

图 3.20 双向待机集群(使用镜像磁盘): (3) 失效切换时¶

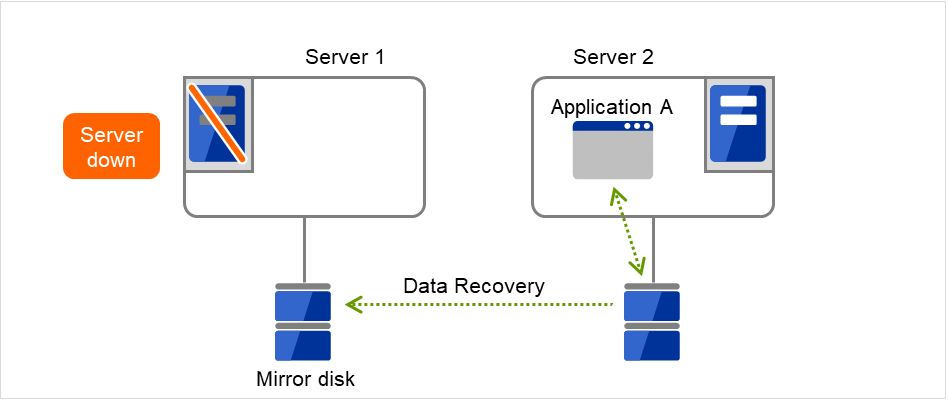

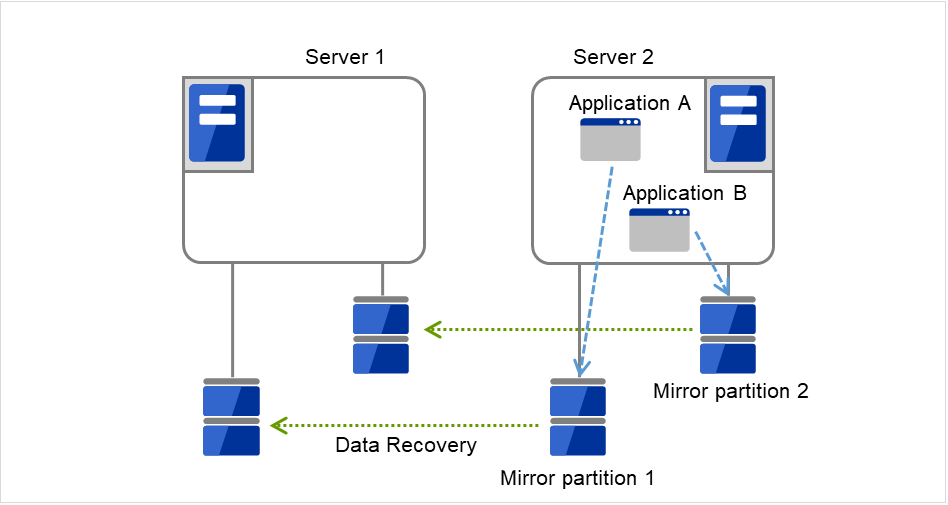

为了恢复业务A,将从Server 2的Mirror partition1中恢复数据。

图 3.21 双向待机集群(使用镜像磁盘): (4) 恢复数据时¶

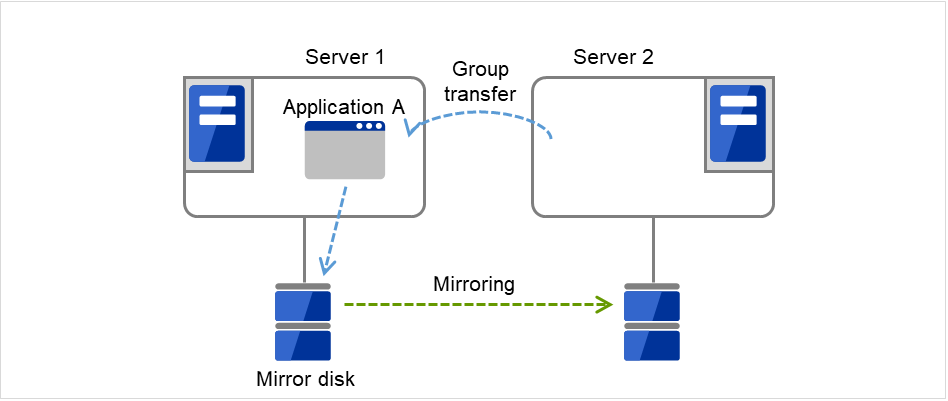

恢复Server 1后,可以将业务A(Application A)的组从Server 2移动到Server 1。

图 3.22 双向待机集群(使用镜像磁盘): (5) 服务器恢复后¶

3.3. 决定要冗余化的应用程序¶

应用程序作为 EXPRESSCLUSTER集群系统上的集群对象是否合适,需对以下内容进行充分讨论后再判断。

3.3.1. 注意事项的结构¶

对象应用程序在不同的待机形态下,有不同的注意事项。关于注意事项,请具体对照"注意事项1:出现故障时的数据恢复(1 ~ 5)。

单向待机[当前-待机] 注意事项: 1 2 3 5

双向待机[当前-当前] 注意事项: 1 2 3 4 5

- 共存运行 注意事项: 5以共享的方式运行,不进行集群系统下失效切换的运行形态。

3.3.2. 对象应用程序的注意事项¶

3.3.2.1. 注意事项1:出现故障时的数据恢复¶

发生故障时运行服务器的应用程序更新的文件,在失效切换后待机服务器中应用程序访问该文件时,可执行会处于数据不完整的状态。

非集群 (单个服务器)发生故障后的恢复过程中也会发生同样问题,需要应用程序自身带有处理此类故障的机制。在集群系统上,更是需要不用手动(从脚本)就可以恢复。

共享磁盘或者镜像磁盘的文件系统中需要fsck时,EXPRESSCLUSTER进行fsck。

3.3.2.2. 注意事项2:结束应用程序¶

EXPRESSCLUSTER 停止/移动业务组 (在线故障恢复) 时,将对业务组使用的文件系统进行Unmount。因此,在应用程序的结束指示中,需要停止对共享磁盘或者镜像磁盘上所有文件的访问。

一般通过结束脚本执行应用程序结束指示命令,但需要注意结束指示命令有时候会异步(同应用程序的结束)结束。

3.3.2.3. 注意事项3:保存数据的位置¶

EXPRESSCLUSTER 可以在服务器间继承的数据如下。

- 共享磁盘或者镜像磁盘上的数据需要将应用程序的数据和服务器间应共享的数据,服务器固有的数据保存在不同的配置位置。

数据的种类

例

配置位置

想继承的数据

用户数据等

共享磁盘或者镜像磁盘

不想继承的数据

程序,设置信息等

服务器的本地磁盘

3.3.2.4. 注意事项4:多个业务组¶

图 3.23 业务在各服务器上正常运行(双向待机集群)¶

- 多个实例启动是启动新的其他实例 (进程)的方法。需要能运行多个应用程序。

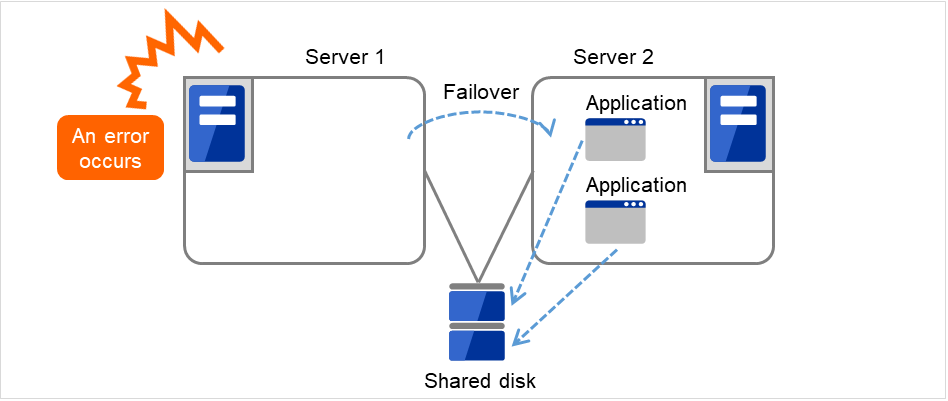

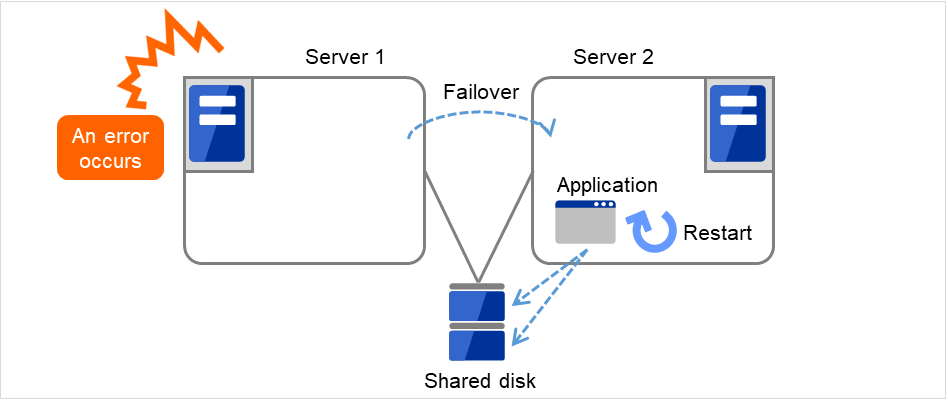

图 3.24 多个实例启动¶

- 应用程序重启通过停止,重启原来运行的应用程序,使添加的资源变得可以处理的方法。

图 3.25 应用程序重启¶

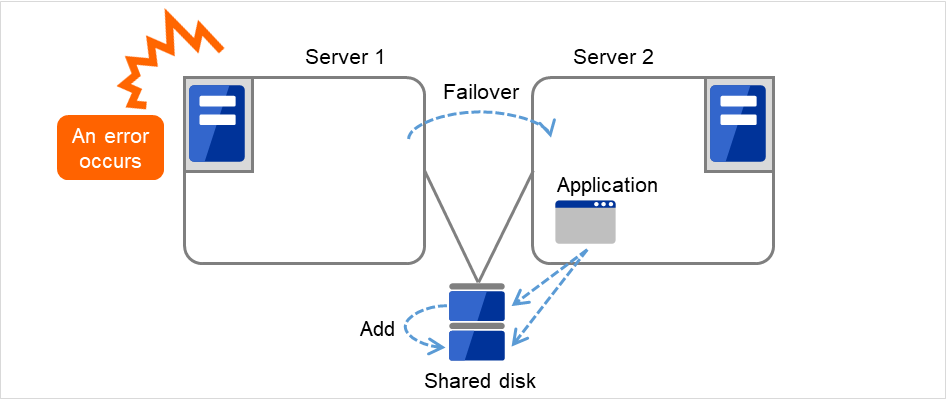

- 动态添加对运行中的应用程序,通过自动或者脚本的指示添加资源的方法。

图 3.26 动态添加¶

脚本指示添加资源的方法。

3.3.2.5. 注意事项5:与应用程序的相互干涉,亲和性问题¶

因与EXPRESSCLUSTER的功能和运行所需的OS功能相互干涉,应用程序或 EXPRESSCLUSTER有时会不能正常运行。

- 切换分区和镜像分区的访问控制停止状态的磁盘资源设置为禁止写入。停止状态的镜像资源,共享型镜像磁盘资源全部设置为禁止访问。应用程序不能访问停止状态的 (即无访问权限)磁盘资源或镜像磁盘资源,共享型镜像磁盘资源。一般可以假定,从集群脚本启动的应用程序在其启动的时点上,应该访问的磁盘资源或镜像磁盘资源,共享型镜像磁盘资源已处于可访问状态。

- Multihome环境以及IP地址的移动集群系统中,通常一个服务器拥有多个IP 地址,某IP 地址 (浮动 IP 地址等)在服务器间移动。

- 应用程序对共享磁盘或镜像磁盘的访问业务组的停止不会通知共享运行的应用程序。如果在业务组停止的时点上,正在访问该组使用的磁盘资源或镜像磁盘资源,共享型镜像磁盘资源,则Unmount失败。进行系统监视服务等应用程序中,有定期向所有的磁盘分区访问的程序。这时,需要可以指定监视对象分区等功能。

3.3.3. 注意事项的对策¶

问题点 |

对策 |

注意事项对应的编号 |

|---|---|---|

数据文件更新中发生故障时,待机服务器中的应用程序不能正常运行 |

修改程序 |

注意事项 1 |

即使停止应用程序,在一定的时间内,还在继续访问磁盘或文件系统 |

停止脚本中使用sleep命令,等待 |

注意事项 2 |

一台服务器上不能启动多个同一应用程序 |

双向待机操作中,失效切换时通过重启应用程序继承共享数据 |

注意事项 3 |

3.4. 设计集群配置¶

图 3.27 失效切换组和组资源¶

3.5. 理解组资源¶

要在集群系统实现失效切换,需要创建构成失效切换单位的组。组由组资源构成。为了创建最合适的集群,需要很好地理解添加什么样的组资源,如何设置等内容。

参见

各资源的详细信息请参考《参考指南》。

当前支持的组资源如下。

组资源名 |

简称 |

|---|---|

EXEC资源 |

exec |

磁盘资源 |

disk |

浮动IP资源 |

fip |

虚拟IP资源 |

vip |

镜像磁盘资源 |

md |

共享型镜像磁盘资源 |

hd |

卷管理资源 |

volmgr |

动态域名解析资源 |

ddns |

AWS Elastic IP资源 |

awseip |

AWS虚拟IP资源 |

awsvip |

AWS辅助IP资源 |

awssip |

AWS DNS资源 |

awsdns |

Azure 探头端口资源 |

azurepp |

Azure DNS资源 |

azuredns |

Google Cloud 虚拟 IP 资源 |

gcvip |

Google Cloud DNS 资源 |

gcdns |

Oracle Cloud 虚拟 IP 资源 |

ocvip |

3.6. 理解监视资源¶

- 常时监视

从集群启动时到集群停止时进行监视。

- 启动时监视

从组启动时到组停止时进行监视。

当前支持的监视资源如下

监视资源名称 |

略称 |

常时监视 |

启动时监视 |

|---|---|---|---|

磁盘监视资源 |

diskw |

✓ |

✓ |

IP 监视资源 |

ipw |

✓ |

✓ |

NIC Link Up/Down 监视资源 |

miiw |

✓ |

✓ |

镜像数据传输线监视资源 |

mdnw |

✓ |

|

镜像磁盘监视资源 |

mdw |

✓ |

|

共享型镜像磁盘连接监视资源 |

hdnw |

✓ |

|

共享型镜像磁盘监视资源 |

hdw |

✓ |

|

PID 监视资源 |

pidw |

✓ |

|

用户空间监视资源 |

userw |

✓ |

|

自定义监视资源 |

genw |

✓ |

|

卷管理监视资源 |

volmgrw |

✓ |

✓ |

多目标监视资源 |

mtw |

✓ |

|

虚拟 IP 监视资源 |

vipw |

✓ |

|

ARP 监视资源 |

arpw |

✓ |

|

消息接收监视资源 |

mrw |

✓ |

✓ |

动态域名解析监视资源 |

ddnsw |

✓ |

|

进程名监视资源 |

psw |

✓ |

✓ |

DB2 监视资源 |

db2w |

✓ |

|

浮动 IP 监视资源 |

fipw |

✓ |

|

FTP 监视资源 |

ftpw |

✓ |

✓ |

HTTP 监视资源 |

httpw |

✓ |

✓ |

IMAP4 监视资源 |

imap4 |

✓ |

✓ |

MySQL 监视资源 |

mysqlw |

✓ |

|

NFS 监视资源 |

nfsw |

✓ |

✓ |

Oracle 监视资源 |

oraclew |

✓ |

|

POP3 监视资源 |

pop3w |

✓ |

✓ |

PostgreSQL 监视资源 |

psqlw |

✓ |

|

Samba 监视资源 |

sambaw |

✓ |

✓ |

SMTP 监视资源 |

smtpw |

✓ |

✓ |

Tuxedo 监视资源 |

tuxw |

✓ |

✓ |

WebLogic 监视资源 |

wlsw |

✓ |

✓ |

WebSphere 监视资源 |

wasw |

✓ |

✓ |

WebOTX 监视资源 |

otxw |

✓ |

✓ |

JVM监视资源 |

jraw |

✓ |

✓ |

系统监视资源 |

sraw |

✓ |

|

进程资源监视资源 |

psrw |

✓ |

|

AWS Elastic IP监视资源 |

awseipw |

✓ |

|

AWS虚拟IP监视资源 |

awsvipw |

✓ |

|

AWS辅助IP监视资源 |

awssipw |

✓ |

|

AWS AZ监视资源 |

awsazw |

✓ |

|

AWS DNS 监视资源 |

awsdnsw |

✓ |

|

Azure 负载均衡监视资源 |

azurelbw |

✓ |

|

Azure 探头端口监视资源 |

azureppw |

✓ |

|

Azure DNS监视资源 |

azurednsw |

✓ |

|

Google Cloud 虚拟 IP 监视资源 |

gcvipw |

✓ |

|

Google Cloud 负载均衡监视资源 |

gclbw |

✓ |

|

Google Cloud DNS 监视资源 |

gcdnsw |

✓ |

|

Oracle Cloud 虚拟 IP 监视资源 |

ocvipw |

✓ |

|

Oracle Cloud 负载均衡监视资源 |

oclbw |

✓ |

3.7. 理解心跳资源¶

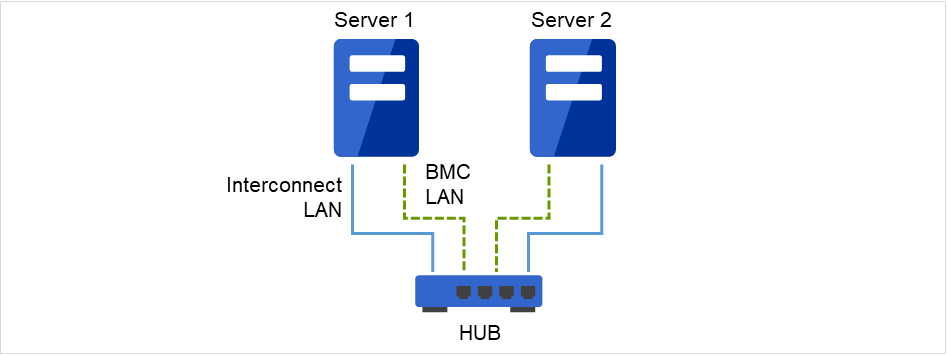

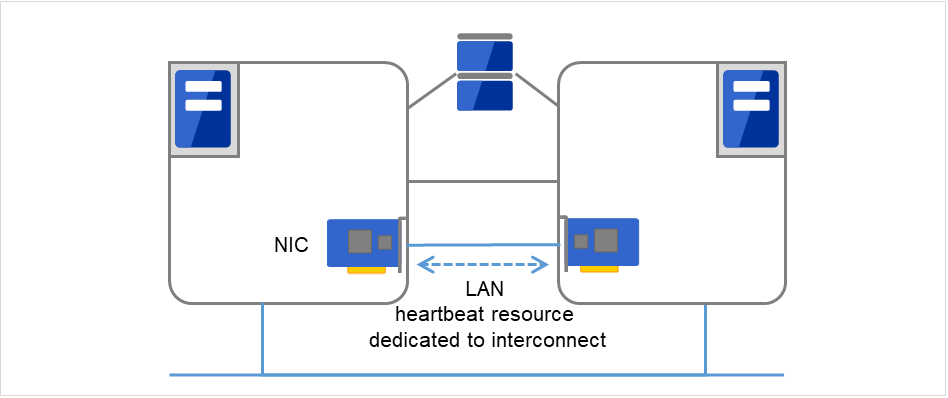

集群内的服务器对其它服务器进行死活监视。服务器间的死活监视使用心跳资源。心跳设备有以下几类。

LAN心跳/内核模式LAN心跳(Primary interconnect)

图 3.28 LAN心跳/内核模式LAN心跳(Primary interconnect)¶

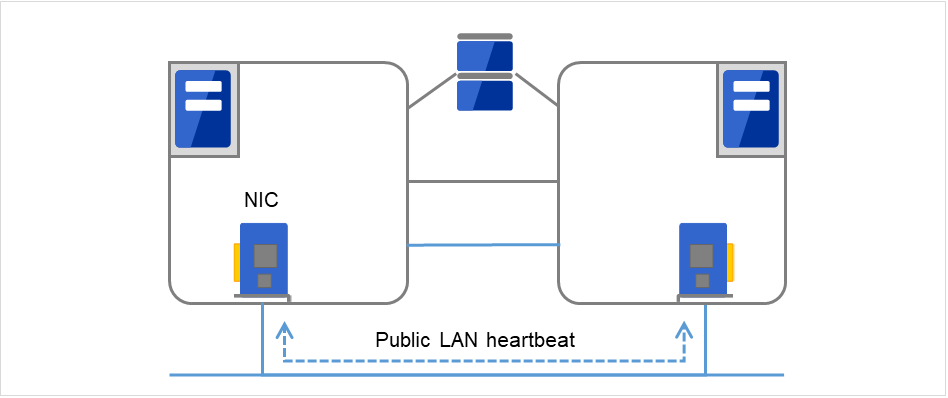

LAN心跳/内核模式LAN心跳(Secondary interconnect)

图 3.29 LAN心跳/内核模式LAN心跳(Secondary interconnect)¶

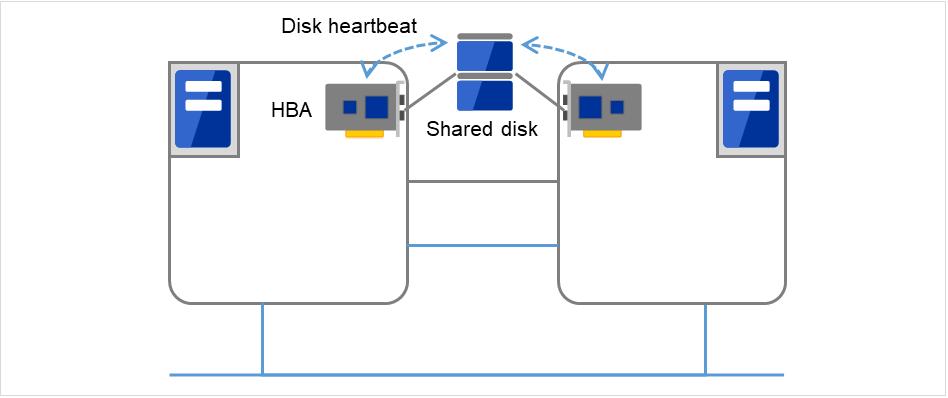

磁盘心跳

图 3.30 磁盘心跳¶

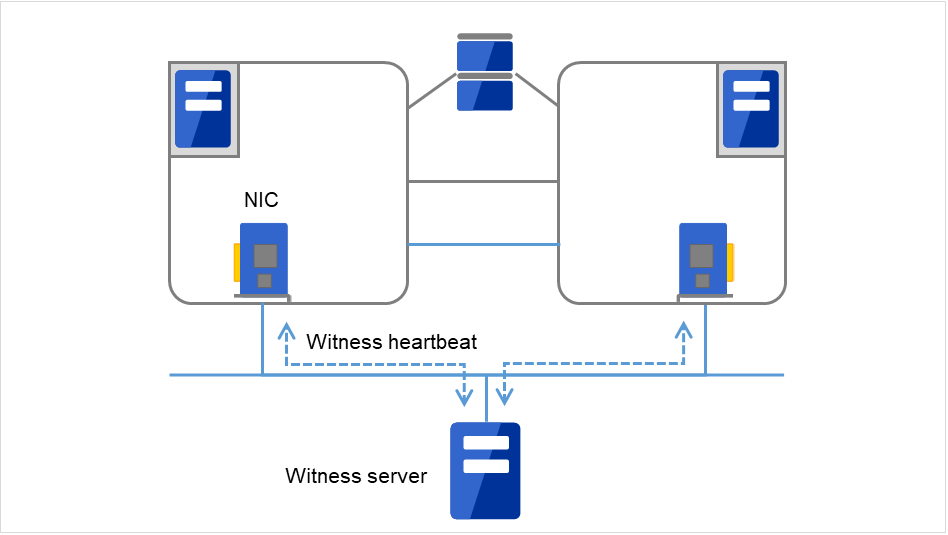

Witness心跳

图 3.31 Witness心跳¶

心跳资源名 |

略称 |

功能概要 |

|---|---|---|

LAN心跳资源 (1)(2)

|

lanhb

|

使用LAN进行服务器的死活监视

集群内的通信也使用

|

内核模式LAN心跳

资源 (1)(2)

|

lankhb

|

内核模式的模块使用LAN进行服务器的死活监视

集群内的通信也使用

|

磁盘心跳资源 (3) |

diskhb |

使用共享磁盘上的专用分区进行服务器的死活监视 |

Witness 心跳资源 (4) |

witnesshb |

使用Witness 服务器进行服务器的死活监视。 |

对于优先级最高的私网,请设置允许所有服务器之间通信的LAN心跳或者内核模式LAN心跳。

建议设置两个以上内核模式LAN心跳资源(除非是在很难添加网络时,例如Cloud环境或远程集群环境中)。

建议将私网专用的LAN注册为LAN心跳资源,同时,将公网LAN也注册为LAN心跳资源。

3.8. 理解网络分区解决资源¶

网络分区状态是指集群服务器间的所有通信路径都发生故障,导致网络切断的状态。

在无法处理网络分区状态的集群系统中,无法区分通信路径的故障和服务器的故障,有时会发生多个服务器访问同一资源导致数据被破坏的情况。在EXPRESSCLUSTER中,如果查出其他服务器的心跳中断,就会判断是服务器的故障还是网络分区状态。判定为服务器宕机时,在正常的服务器上启动各种资源,启动业务应用程序,来执行失效切换。判定为网络分区状态时,与维持业务运行相比要优先保护数据,所以会实施紧急关机等处理。

网络分区解析方式有如下方法。

Ping方式

需要可以接收ping命令,返回应答的常时运行的装置(以下简称为"ping装置")。

可以指定多个用于ping的装置。

查出其他服务器的心跳中断时,如果用于ping的装置对ping命令做出的应答,则判断心跳中断的服务器宕机,实施失效切换,如果没有对ping命令做出的应答,则根据网络分区状态判断其自身独立于网络并紧急关机。据此,发生网络分区状态时,可以在能与客户端进行通信的服务器上继续业务。

由于用于ping的装置的故障等,如果心跳中断前没有持续对ping命令的应答状态,则无法解析网络分区,在此状态下查出心跳中断时,所有服务器紧急关机。

HTTP 方式

需要保持Web服务器始终处于运行状态。

查出其他服务器心跳中断时,如果对HTTP HEAD的请求有响应,则判断心跳中断的服务器宕机,实施失效切换;如果没有响应,则根据网络分区状态判断其自身独立于网络并紧急关机。据此,发生网络分区状态时,可以在能与客户端进行通信的服务器上继续业务。

如果由于Web服务器故障等导致心跳中断之前,持续对HTTP HEAD 请求没有响应,则由于解决网络分区失败,在这种状态下查出心跳中断时,所有服务器全部紧急关机。

不解决网络分区症状

万一集群服务器间的所有网络通信路径发生故障,则对所有服务器执行失效切换。

推荐的网络分区症状解决方式如下所记。

网络分区症状解决方式

|

节点数

|

需要HW

|

不能进行失效切换的情况

|

所有网络断线时

|

两台服务器进行失效切换的情况

|

解决网络分区所需要的时间

|

|---|---|---|---|---|---|---|

Ping |

没有限制 |

接受ping命令,返回应答的装置 |

无 |

有ping命令应答的服务器 |

在超过ping命令指定连接次数后,所有网络断线 |

0 |

HTTP |

没有限制 |

Web 服务器 |

Web 服务器故障 |

能与Web 服务器通信的服务器可判定为在线 |

无 |

0 |

无 |

没有限制 |

无 |

无 |

所有的服务进行失效切换 |

所有网络断线时 |

0 |

4. 安装EXPRESSCLUSTER¶

4.1. 从安装EXPRESSCLUSTER到生成集群的流程¶

从安装EXPRESSCLUSTER到注册License,生成集群系统,确认集群系统状态为止的操作流程如下所示。

在执行以下的操作之前,请认真阅读"2. 确定系统配置","3. 设计集群系统",确认所需要的运行环境和要生成的集群的配置内容。

- 安装EXPRESSCLUSTER Server在构成集群的各服务器中安装EXPRESSCLUSTER的主要模块EXPRESSCLUSTER Server。

参见

要按照本指南的流程进行操作时,需要在遵照本指南的步骤的同时,随时参考《EXPRESSCLUSTER X 参考指南》。另外,关于运行环境和资源信息等最新的信息,请参考《EXPRESSCLUSTER X 开始指南》。

4.2. 设置EXPRESSCLUSTER Server¶

EXPRESSCLUSTER的主体模块EXPRESSCLUSTER Server由以下系统服务构成,通过安装EXPRESSCLUSTER Server RPM/deb安装包进行安装设置。

系统服务名 |

说明 |

|---|---|

clusterpro

|

EXPRESSCLUSTER daemon

EXPRESSCLUSTER本体的服务。

|

clusterpro_evt

|

EXPRESSCLUSTER 事件

用于控制EXPRESSCLUSTER输出的日志以及syslog的服务。

|

clusterpro_nm

|

EXPRESSCLUSTER 节点管理器

用于控制EXPRESSCLUSTER的心跳资源和网络分区解决资源的服务。

|

clusterpro_trn

|

EXPRESSCLUSTER 数据传送

用于控制集群内的License同步及配置信息的转发的服务。

|

clusterpro_ib

|

EXPRESSCLUSTER Information Base

管理ExpressCluster信息的服务。

|

clusterpro_api

|

EXPRESSCLUSTER API

控制ExpressCluster Restful API功能的服务。

|

clusterpro_md

|

EXPRESSCLUSTER 镜像代理

用于控制EXPRESSCLUSTER的镜像磁盘资源,共享型镜像磁盘资源以及镜像驱动程序的服务。

|

clusterpro_alertsync

|

EXPRESSCLUSTER 警报同步

用于在集群内的服务器中使警报同步的服务。

|

clusterpro_webmgr

|

EXPRESSCLUSTER WebManager

WebManager服务器的服务。

|

4.2.1. 安装EXPRESSCLUSTER Server RPM¶

按照以下步骤,在构成集群的各服务器中安装EXPRESSCLUSTER Server的RPM。

注解

请通过root用户身份安装EXPRESSCLUSTER Server的RPM。

EXPRESSCLUSTER X的CD媒体里包含的rpm可执行没有支持新的kernel。请确认运行环境的kernel版本和《EXPRESSCLUSTER X for Linux 开始指南》的"EXPRESSCLUSTER的运行环境"的"可运行的Distribution和kernel"。请安装"EXPRESSCLUSTER Version"里所记载版本的Update。

mount安装DVD-ROM。

- 执行rpm 命令,安装数据包文件。产品不同,用于安装的RPM也不相同。移动至DVD-ROM 内的/Linux/5.1/cn/server,执行

rpm -i expresscls-<版本号>-<结构>.rpm

结构分为x86-64,IBM POWER LE。请根据安装目标的环境进行选择。通过arch命令,可以确认结构。开始安装。注解

EXPRESSCLUSTER 被安装到以下位置。请不要更改该目录。另外,也不要对该目录进行符号链接。安装目录:/opt/nec/clusterpro 安装结束后,对安装DVD-ROM执行umount。

- 取出安装DVD-ROM。继续进行注册License的步骤。

参见

4.2.2. 安装EXPRESSCLUSTER Server deb安装包¶

按照以下步骤,在构成集群的各服务器中安装EXPRESSCLUSTER Server的deb安装包。

注解

请通过root用户身份安装EXPRESSCLUSTER Server的deb安装包。

mount安装DVD-ROM。

- 执行dpkg 命令,安装数据包文件。产品不同,用于安装的deb安装包也不相同。移动至DVD-ROM 内的/Linux/5.1/en/server,执行

dpkg -i expresscls-<版本号>-amd64.rpm

注解

EXPRESSCLUSTER 被安装到以下位置。请不要更改该目录。另外,也不要对该目录进行符号链接。安装目录:/opt/nec/clusterpro 安装结束后,对安装DVD-ROM执行umount。

- 取出安装DVD-ROM。继续进行注册License的步骤。

参见

4.2.3. 要设置SNMP联动功能¶

注解

仅使用SNMP陷阱发送送信功能时,不需要进行本步骤。

注解

请设置root用户。

安装步骤中的Net-SNMP相关记载内容可执行因发布版本的不同有差异。

安装Net-SNMP。

- 确认snmpd的版本。执行以下命令。

snmpd -v

停止snmpd Demon。

注解

通常执行以下的命令就能停止。

init.d环境时:

/etc/init.d/snmpd stop

systemd环境时:

systemctl stop snmpd

- snmpd Demon的结构文件上登录EXPRESSCLUSTER的SNMP联动功能。使用文本编辑器打开构成文件。根据snmpd的版本,请在文件末尾追加以下内容。

snmpd的版本低于5.7时:

dlmod clusterManagementMIB/opt/nec/clusterpro/lib/libclpmgtmib.so

snmpd的版本高于或等于5.7时:

dlmod clusterManagementMIB /opt/nec/clusterpro/lib/libclpmgtmib2.so

注解

通常Net-SNMP snmpd Demon的结构文件放置在以下目录。

/etc/snmp/snmpd.conf

注解

- 在snmpd Demo同意的MIB View (snmpd.conf 的view定义)中追加EXPRESSCLUSTER的OID。EXPRESSCLUSTER的 OID 是「.1.3.6.1.4.1.119.2.3.207」。

- 根据需要,创建操作SNMP联动功能所必需的向库的符号链接。必须的符号链接有以下3个。

libnetsnmp.so libnetsnmpagent.so libnetsnmphelpers.so

请根据以下的步骤来创建。5 - 1. 确认是否进行了符号链接。请向下一个目录移动。/usr/lib64

请确认上述的3个符号链接是否存在。如果存在,则不需进行步骤5 - 2的操作。请执行步骤6。如果不存在,请进行步骤5 - 2的操作。5 - 2. 创建符号链接。请执行以下的命令。ln -s libnetsnmp.so.X libnetsnmp.so ln -s libnetsnmpagent.so.X libnetsnmpagent.so ln -s libnetsnmphelpers.so.X libnetsnmphelpers.so

X表示整数值。该数值根据环境不同而异,请确认并指定。 启动snmpd Demon。

注解

通常执行以下的命令就能启动。

init.d环境时:

/etc/init.d/snmpd start

systemd环境时:

systemctl start snmpd

参见

卸载EXPRESSCLUSTER Server时,请一定解除SNMP联动功能的设置。要解除SNMP联动功能的设置,请参考" 11.1.2. 要解除设置的SNMP联动功能"。

注解

SNMP 通信所需的设置在SNMP Agent侧进行。

5. 注册License¶

5.1. 注册CPU License¶

实际运行要构建的集群系统,需要注册CPU License。

参见

以下表格记载了CPU License支持的 License产品名一览。

License产品名 |

|---|

EXPRESSCLUSTER X Professional Edition 5.1 for Linux |

EXPRESSCLUSTER X SingleServerSafe for Linux Upgrade |

EXPRESSCLUSTER X SingleServerSafe 5.1 for Linux |

通过要搭建集群的服务器中设置为主服务器的服务器执行CPU License的注册。注册方法有两种,即描述License Sheet中记载的信息的方法和指定License文件的方法。以下分别说明产品版和试用版的注册方法。

产品版

在License管理命令的参数中指定License 文件,"5. 注册License"。(请参考"5.1.2. 通过指定License文件注册License(产品版,试用版通用)")

执行License管理命令,以交互的形式,输入License产品附带的License信息,注册License。(请参考"5.1.3. 通过命令行以交互形式注册License(产品版)")。

试用版

在License管理命令的参数中指定License 文件,"5. 注册License"。(请参考"5.1.2. 通过指定License文件注册License(产品版,试用版通用)")

5.1.1. CPU License的注意事项¶

使用CPU License时的注意事项如下所示。

5.1.2. 通过指定License文件注册License(产品版,试用版通用)¶

可以通过root用户身份登录要搭建集群系统中指定为主服务器的服务器。

License 文件存在于要搭建集群系统中指定为主服务器的服务器上的任何位置。

以root用户身份登录要搭建的集群中指定为主服务器的服务器,执行以下命令。

# clplcnsc -i filepath

在-i 参数中指定的filepath内指定License 文件的文件路径。命令执行后,如果正常结束,则在控制台中显示"License registration succeeded."。如果显示其他结束消息,请参阅《EXPRESSCLUSTER 参考指南》的"EXPRESSCLUSTER命令参考"。执行以下命令,确认License的注册情况。

# clplcnsc -l -a

如果使用可选产品,请执行"5.3. 注册节点License"中的操作。

注解

启动OS时clusterpro_md会出错,请忽略该错误。这是由于集群环境尚未构建所输出的错误。

5.1.3. 通过命令行以交互形式注册License(产品版)¶

以下说明持有产品版的License时如何使用命令行以交互形式注册License。

执行本步骤操作之前,请确认以下内容。

手头有从经销商处正式获取的License Sheet。购买产品后,经销商会发送License Sheet。输入该License Sheet上记载的值。

可以通过root用户身份登录要搭建的集群系统中指定为主服务器的服务器。

参见

本步骤中使用clplcnsc命令。关于clplcnsc命令的使用方法的详细内容,请参考《参考指南》的"EXPRESSCLUSTER命令参考"。

- 准备License Sheet。本步骤假设手中的License Sheet内容如下。输入时,请使用您手中的License Sheet上所记录的值。

产品名 EXPRESSCLUSTER X Professional Edition 5.1 for Linux VM License信息 产品类型 产品版 License key A1234567-B1234567-C1234567-D1234567 序列号 AAAAAAAA000000 CPU 数 2 以root用户身份登录要搭建的集群中指定为主服务器的服务器,执行以下命令。

# clplcnsc -i

显示以下字符串,提醒用户输入产品类型。License Version (产品类型)是1,即Product (产品版),所以输入1。

Selection of License Version. 1 Product version 2 Trial version e Exit Select License Version. [1, 2, or e (default:1)]...1

显示以下字符串,提示用户输入序列号。请输入License Sheet上记述的序列号。请注意区分大小写。

Enter serial number[Ex. XXXXXXXX000000]... AAAAAAAA000000

显示以下字符串,提醒用户输入License key。请输入License Sheet上记述的License key。请注意区分大小写。

Enter license key [XXXXXXXX-XXXXXXXX-XXXXXXXX-XXXXXXXX]... A1234567-B1234567-C1234567-D1234567

命令执行后,如果正常结束,则在控制台中显示"License registration succeeded."。如果显示其他结束消息,请参阅《参考指南》的"EXPRESSCLUSTER命令参考"。

确认注册的License。执行以下命令。

# clplcnsc -l -a

如果使用可选产品,请执行"5.3. 注册节点License"中的操作。

注解

启动OS时clusterpro_md会出错,请忽略该错误。这是由于集群环境尚未构建所输出的错误。

5.2. 注册VM节点License¶

若要构建的集群系统中存在虚拟服务器,则虚拟服务器中不可使用CPU License,而使用VM节点License。

以下表格记载了VM节点 License支持的 License产品名一览。

License产品名 |

|---|

EXPRESSCLUSTER X Professional Edition 5.1 for Linux VM |

EXPRESSCLUSTER X SingleServerSafe 5.1 for Linux VM Upgrade |

EXPRESSCLUSTER X SingleServerSafe 5.1 for Linux VM |

在要构建集群的服务器中的所与虚拟服务器中注册VM节点License。注册方式有两种,一种是记录License Sheet中记录的信息,一种是指定License文件。

产品版

在License管理命令的参数中指定License文件,"5. 注册License"。(请参考"5.2.1. 通过指定License文件进行License注册(产品版,试用版通用)")

执行License管理命令,以交互形式时输入License产品附带的License信息,注册License。(请参考"5.3.2. 通过命令行以交互形式注册License(产品版)")

试用版

在License管理命令的参数中指定License 文件,"5. 注册License"。(请参考"5.2.1. 通过指定License文件进行License注册(产品版,试用版通用)")

5.2.1. 通过指定License文件进行License注册(产品版,试用版通用)¶

能以root用户登录将要构建集群的服务器中的虚拟服务器。

以root权限登录要构建集群的服务器中的虚拟服务器后,执行以下命令。

# clplcnsc -i filepath

在-i参数指定的filepath中指定包含文件名的License文件的路径。

若执行命令后命令正常完成,则控制台中显示"License registration succeeded."。若显示其他的结束消息,则请参考《参考指南》的 "EXPRESSCLUSTER命令参考"。

执行下列命令,确认License的注册情况。

# clplcnsc -l -a

若集群中还有其他虚拟服务器,则用同样的方法注册VM节点License。

使用可选产品时请参考 "5.3. 注册节点License"。

注解

OS启动时clusterpro_md会出错,请忽略。这是由于集群环境尚未构建而输出的消息。

5.2.2. 通过命令行以交互形式注册License (产品版)¶

- 持有从销售方购买的License Sheet。购买产品时销售方将提供License Sheet。输入该License Sheet中记录的值。

在要构建集群系统的服务器中,可以root权限登录虚拟服务器。

参见

本步骤使用clplcnsc命令。关于clplcnsc命令的使用方法的详细信息,请参考《参考指南》的"EXPRESSCLUSTER命令参考"。

- 准备好License Sheet。本步骤对附带的License Sheet进行示例说明。输入时请替换为您所持的License Sheet中记录的值。

产品名 EXPRESSCLUSTER X Professional Edition 5.1 for Linux VM License信息 产品区分 产品版 License key A1234567-B1234567-C1234567-D1234567 序列号 AAAAAAAA000000 注册服务器数 1 以root用户身份登录要搭建的集群系统中指定为虚拟服务器的服务器,执行以下命令。

# clplcnsc -i

显示以下字符串,提醒用户输入产品类型。License Version (产品类型)是1,即Product (产品版),所以输入1。

Selection of License Version. 1 Product version 2 Trial version e Exit Select License Version. [1, 2, or e (default:1)]...1

显示以下字符串,提醒用户输入序列号。输入License Sheet中记录的序列号。请注意区分文字大小写。

Enter serial number [Ex. XXXXXXXX000000]... AAAAAAAA000000

显示以下字符串,提醒用户输入License key。请输入License Sheet上记述的License key。请注意区分大小写。

Enter license key [XXXXXXXX- XXXXXXXX- XXXXXXXX- XXXXXXXX]... A1234567-B1234567-C1234567-D1234567

命令执行后,如果正常结束,则在控制台中显示"License registration succeeded."。如果显示其他结束消息,请参阅《参考指南》的"EXPRESSCLUSTER命令参考"。

确认注册的License。执行以下命令。

# clplcnsc -l -a

若集群中还有其他虚拟服务器,请用同样的方法注册VM License。

使用可选产品时,请参考"5.3. 注册节点License"。

注解

启动OS时clusterpro_md会出错,请忽略该错误。这是由于集群环境尚未构建所输出的错误。

5.3. 注册节点License¶

实际运行需要构建的X 5.1 Replicator,X 5.1 Replicator DR,X 5.1 Agent产品群,X 5.1 Alert Service (以下称为各可选产品) 的集群系统时,需要注册节点License。

以下表格记载了可选产品的节点 License支持的 License产品名一览。

License产品名 |

|---|

EXPRESSCLUSTER X Replicator 5.1 for Linux |

EXPRESSCLUSTER X Database Agent 5.1 for Linux |

EXPRESSCLUSTER X Internet Server Agent 5.1 for Linux |

EXPRESSCLUSTER X File Server Agent 5.1 for Linux |

EXPRESSCLUSTER X Application Server Agent 5.1 for Linux |

EXPRESSCLUSTER X Java Resource Agent 5.1 for Linux |

EXPRESSCLUSTER X System Resource Agent 5.1 for Linux |

EXPRESSCLUSTER X Alert Service 5.1 for Linux |

EXPRESSCLUSTER X Replicator DR 5.1 for Linux |

EXPRESSCLUSTER X Replicator DR 5.1 for Linux Upgrade |

在集群中使用可选产品的服务器中注册节点License。注册方法有两种,即描述License Sheet中记载的信息的方法和指定License文件的方法。以下分别说明产品版和试用版的注册方法。

产品版

在License管理命令的参数中指定License 文件,"5. 注册License"。 (请参考"5.3.1. 通过指定License文件注册License (产品版,试用版通用)")

执行License管理命令,以交互的形式,输入License产品附带的License信息,注册License。(请参考"5.2.2. 通过命令行以交互形式注册License (产品版)")。

试用版

在License管理命令的参数中指定License 文件,"5. 注册License"。(请参考"5.3.1. 通过指定License文件注册License (产品版,试用版通用)")

5.3.1. 通过指定License文件注册License (产品版,试用版通用)¶

能以root用户登录将要构建集群的服务器中使用可选产品的服务器。

以root用户身份登录要搭建的集群中使用可选产品的服务器,执行以下命令。

# clplcnsc -i filepath

在-i 参数中指定的filepath内指定包含文件名的License 文件的文件路径。

注解

没有安装选项产品的License时,License支持的资源,监视资源不会显示在Cluster WebUI的列表中。已注册License的状态下列表中不显示的情况以及启动Cluster WebUI后注册了License的情况下,请点击[获取License信息]按钮。命令执行后,如果正常结束,则在控制台中显示"License registration succeeded."。如果显示其他结束消息,请参阅《参考指南》的"EXPRESSCLUSTER命令参考"。

执行以下命令确认License的注册情况。

# clplcnsc -l -a

- 如果集群内还有其他使用可选产品的服务器,请按照同样的步骤注册节点License。请在双方服务器中注册Replicator/Replicator DR的License。

-

注解

启动OS时 EXPRESSCLUSTER_md会出错,请忽略该错误。这是由于集群环境尚未构建所输出的错误。

注解

作为集群开始操作后注册Replicator/Replicator DR的License时,请执行集群关机和重启。重启后Replicator/Replicator DR才可以使用。

5.3.2. 通过命令行以交互形式注册License(产品版)¶

手头有从经销商处正式获取的License Sheet。购买产品后,经销商会发送License Sheet。在多少台服务器上使用可选产品,就要有相应数量的节点License的License Sheet。输入此License Sheet中描述的值。

可以通过root用户身份登录要搭建的集群系统中使用可选产品的服务器。

参见

本步骤中使用clplcnsc 命令。关于clplcnsc命令的使用方法的详细内容,请参考《参考指南》的"EXPRESSCLUSTER命令参考"。

- 准备License Sheet。本步骤假设手头的License Sheet内容如下。输入时,请使用您手中的License Sheet上所记录的值。

产品名 EXPRESSCLUSTER X Replicator 5.1 for Linux License信息 产品类型 产品版 License key A1234567-B1234567-C1234567-D1234567 序列号 AAAAAAAA000000 节点数 1 以root用户身份登录要搭建的集群系统中指定为主服务器的服务器,执行以下命令。

# clplcnsc -i

注解

没有安装选项产品的License时,License支持的资源,监视资源不会显示在Cluster WebUI的列表中。

显示以下字符串,提醒用户输入产品类型。License Version (产品类型)是1,即Product (产品版),所以输入1。

Selection of License Version. 1 Product Version 2 Trial Version e Exit Select License Version. [1, 2, or e (default:1)]...1

显示以下字符串,提示用户输入序列号。请输入License Sheet上记述的序列号。请注意区分大小写。

Enter serial number[Ex. XXXXXXXX000000]... AAAAAAAA000000

显示以下字符串,提醒用户输入License key。请输入License Sheet上记述的License key。请注意区分大小写。

Enter license key [XXXXXXXX-XXXXXXXX-XXXXXXXX-XXXXXXXX]... A1234567-B1234567-C1234567-D1234567

命令执行后,如果正常结束,则在控制台中显示"License registration succeeded."。如果显示其他结束消息,请参阅《参考指南》的"EXPRESSCLUSTER命令参考"。

确认注册的License。执行以下命令。

# clplcnsc -l -a

- 如果集群内还有其他使用可选产品的服务器,请按照同样的步骤注册节点License。请在双方服务器中注册Replicator/Replicator DR的License。

-

注解

启动OS时clusterpro_md会出错,请忽略该错误。这是由于集群环境尚未构建所输出的错误。

注解

作为集群开始操作后注册Replicator/Replicator DR的License时,请执行集群关机和重启。重启后Replicator/Replicator DR才可以使用。

5.4. 注册期间定制License¶

本体产品

License产品名 |

|---|

EXPRESSCLUSTER X Professional Edition 5.1 for Linux VM |

可选产品

License产品名 |

|---|

EXPRESSCLUSTER X Replicator 5.1 for Linux |

EXPRESSCLUSTER X Database Agent 5.1 for Linux |

EXPRESSCLUSTER X Internet Server Agent 5.1 for Linux |

EXPRESSCLUSTER X File Server Agent 5.1 for Linux |

EXPRESSCLUSTER X Application Server Agent 5.1 for Linux |

EXPRESSCLUSTER X Java Resource Agent 5.1 for Linux |

EXPRESSCLUSTER X System Resource Agent 5.1 for Linux |

EXPRESSCLUSTER X Alert Service 5.1 for Linux |

EXPRESSCLUSTER X Replicator DR 5.1 for Linux |

不管是本体产品,还是可选产品,通过要搭建集群的服务器中设置为主服务器的服务器执行期间定制License的注册。可以通过指定License文件的方式来注册License。

License的注册方法请参考"5.4.2. 关于注册期间定制License"。

5.4.1. 期间定制License的注意事项¶

以下是使用期间定制License的注意事项。

5.4.2. 关于注册期间定制License¶

可以通过root用户身份登录要搭建集群系统中指定为主服务器的服务器。

所用产品的全部License文件,存在于要搭建集群系统中指定为主服务器的服务器上的任何位置。

用以下步骤注册所用产品的全部License文件

以root用户身份登录要搭建的集群中指定为主服务器的服务器,执行以下命令。

# clplcnsc -i filepath

在-i 参数中指定的filepath内指定License 文件的文件路径。

注解

如果没有安装可选产品的License,License支持的资源•监视资源不会显示在Cluster WebUI的列表中。

License注册后在一览表中无法显示,或者启动Cluster WebUI后又执行了注册License,请点击[获取License信息]按钮。

命令执行后,如果正常结束,则在控制台中显示"License registration succeeded."。如果显示其他结束消息,请参阅《参考指南》的"EXPRESSCLUSTER命令参考"。

为了防止License过期,同时购买了同一产品的多个License时,可以按照相同的步骤注册其余的License。

有其他要使用的产品时,请重复执行步骤1。

执行以下的命令,确认License的注册情况。

# clplcnsc -l -a

-

注解

由于没有搭建集群系统,在OS启动时候,会出现clusterpro_md失败的错误,请忽视该错误。

注解

集群开始运用后,注册Replicator / Replicator DR的License时,请对集群系统进行关机重启。重启后,Replicator / Replicator DR才可以使用。

6. 创建集群配置信息¶

在EXPRESSCLUSTER中将描述集群系统配置内容的数据称为集群配置信息。通过Cluster WebUI创建集群配置信息。本章通过示例说明Cluster WebUI的启动方法以及如何使用创建集群配置信息。

本章说明项目如下。

6.1. 创建集群配置信息¶

6.2. 启动Cluster WebUI¶

创建集群配置信息需要访问Cluster WebUI。在此首先说明Cluster WebUI的概要,之后说明创建集群配置信息的方法。

参见

关于Cluster WebUI的运行环境,请参考《开始指南》的"EXPRESSCLUSTER的运行环境"。

6.2.1. 何谓Cluster WebUI¶

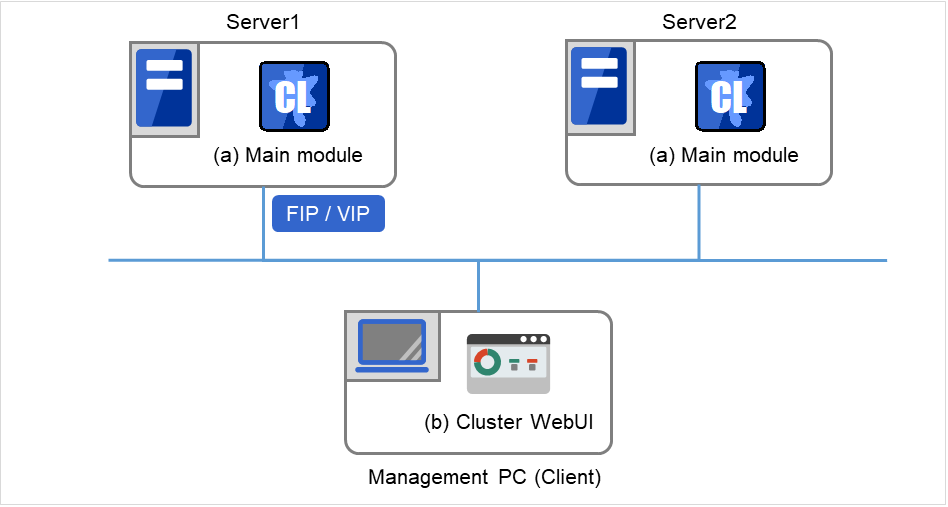

所谓Cluster WebUI ,就是通过Web 浏览器进行集群的设置及状态监视,启动/停止服务器/组,以及收集集群运行日志等的功能。下图显示Cluster WebUI的概要。

EXPRESSCLUSTER Server (Main module)

Cluster WebUI

图 6.1 Cluster WebUI¶

EXPRESSCLUSTER安装在图中所示的2台服务器中。使用管理PC(Management PC)上的浏览器,连接到任意一台服务器时,会显示Cluster WebUI的画面。 这时,指定管理组的浮动IP(FIP)地址或虚拟IP(VIP)地址作为连接目标。

6.2.3. 启动Cluster WebUI¶

Cluster WebUI的启动步骤如下所示。

启动Web浏览器。

在浏览器的地址栏中输入安装了EXPRESSCLUSTER Server的服务器的物理IP地址和端口号。

http://ip-address:port/

- ip-address

由于安装后,管理组不存在,因此请指定配置集群的第一台服务器的真实IP地址。

- port

指定与安装期间指定的WebManager的端口号相同的数字(默认值29003)。

启动Cluster WebUI。创建集群配置信息时,从工具栏的下拉菜单中选择[编辑模式]。

点击"集群生成向导"按钮,开始向导。

6.3. 确认2节点集群环境的设置值¶

在使用集群生成向导实际创建集群配置信息之前,需要确认集群配置信息的设置值。此时,需要写出这些值,确认集群的创建是否有效果,信息有无遗漏。

6.3.1. 集群环境示例¶

本章以搭建下图中的典型的2节点集群环境为例进行说明。

6.3.1.1. 使用磁盘资源时¶

图 6.2 2节点集群的示例(使用磁盘资源时)¶

FIP1 |

10.0.0.11

(从Cluster WebUI客户端访问)

|

FIP2 |

10.0.0.12

(从业务客户端访问)

|

NIC1-1 |

192.168.0.1 |

NIC1-2 |

10.0.0.1 |

NIC2-1 |

192.168.0.2 |

NIC2-2 |

10.0.0.2 |

RS-232C 设备 |

/dev/ttyS0 |

共享磁盘 (Shared disk)

DISK心跳

设备名

/dev/sdb1

共享磁盘设备

/dev/sdb2

Mount点

/mnt/sdb2

文件系统

ext3

磁盘监视设置

设备名

/dev/sdb1

监视对象Raw设备名

(空白栏)

监视方法

read(O_DIRECT)

6.3.1.2. 使用镜像磁盘资源时¶

图 6.3 2 节点集群的示例(使用镜像磁盘资源时)¶

FIP1 |

10.0.0.11

(从Cluster WebUI客户端访问)

|

FIP2 |

10.0.0.12

(从业务客户端访问)

|

NIC1-1 |

192.168.0.1 |

NIC1-2 |

10.0.0.1 |

NIC2-1 |

192.168.0.2 |

NIC2-2 |

10.0.0.2 |

RS-232C 设备 |

/dev/ttyS0 |

镜像磁盘资源设置

数据分区

/dev/sdb2

集群分区

/dev/sdb1

Mount点

/mnt/sdb2

文件系统

ext3

磁盘监视设置

设备名

/dev/sdb1

监视对象Raw设备名

(空白栏)

监视方法

read(O_DIRECT)

6.3.1.3. 远程配置 使用镜像磁盘资源时¶

图 6.4 2 节点集群的示例(远程配置使用镜像磁盘资源时)¶

FIP1 |

10.0.0.11

(从Cluster WebUI客户端访问)

|

FIP2 |

10.0.0.12

(从业务客户端访问)

|

NIC1 |

10.0.0.1 |

NIC2 |

10.0.0.2 |

镜像磁盘资源设置

数据分区

/dev/sdb2

集群分区

/dev/sdb1

Mount点

/mnt/sdb2

文件系统

ext3

磁盘监视设置

设备名

/dev/sdb1

监视对象Raw设备名

(空白栏)

监视方法

read(O_DIRECT)

※ 此配置是WAN是第2层类型(基地之间可以使用相同的网络地址)时的示例。

6.3.1.4. 使用卷管理资源时¶

图 6.5 2 节点集群的示例(使用卷管理资源时)¶

FIP1: 从Cluster WebUI客户端访问

FIP2: 从业务客户端访问

下表是构建上述集群系统时的集群配置信息示例。后文将按照这些条件分步说明创建集群配置信息的步骤。实际设置值时,请使用要构建的集群的配置信息代替文中设置内容。关于值的确定方法,请参阅《参考指南》。

2节点的配置设置示例

设置对象

|

设置参数

|

设置值

(使用磁盘资源时)

|

设置值

(使用镜像磁盘资源时)

|

设置值

(使用远程配置镜像磁盘资源时)

|

设置值

(使用卷管理资源时)

|

|---|---|---|---|---|---|

集群配置 |

集群名 |

cluster |

cluster |

cluster |

cluster |

服务器数 |

2 |

2 |

2 |

2 |

|

失效切换组数 |

2 |

2 |

2 |

2 |

|

监视资源数 |

4 |

6 |

6 |

5 |

|

心跳资源 |

内核模式 LAN

心跳数

|

2

|

2

|

1

|

2

|

磁盘心跳数 |

1 |

0 |

0 |

1 |

|

NP 资源 |

PingNP |

0 |

0 |

1 |

0 |

第 1 台服务器的信息(主服务器) |

服务器名 1 |

server1 |

server1 |

server1 |

server1 |

私网的 IP 地址

(专用)

|

192.168.0.1 (NIC1-1) |

192.168.0.1 (NIC1-1) |

10.0.0.1 (NIC1-2) |

192.168.0.1 (NIC1-1) |

|

私网的 IP 地址

(备份)

|

10.0.0.1 (NIC1-2) |

10.0.0.1 (NIC1-2) |

10.0.0.1 (NIC1-2) |

||

公网的 IP 地址 |

10.0.0.1 (NIC1-2) |

10.0.0.1 (NIC1-2) |

10.0.0.1 (NIC1-2) |

10.0.0.1 (NIC1-2) |

|

磁盘心跳设备 |

/dev/sdb1 |

- |

- |

/dev/sdb1 |

|

镜像磁盘连接 |

- |

192.168.0.1 (NIC1-1) |

10.0.0.1 (NIC1-2) |

- |

|

第 2 台服务器的信息 |

服务器名 1 |

server2 |

server2 |

server2 |

server2 |

私网的 IP 地址

(专用)

|

192.168.0.2 (NIC2-1) |

192.168.0.2 (NIC2-1) |

10.0.0.2 (NIC2-2) |

192.168.0.2 (NIC2-1) |

|

私网的 IP 地址

(备份)

|

10.0.0.2 (NIC2-2) |

10.0.0.2 (NIC2-2) |

10.0.0.2 (NIC2-2) |

||

公网的 IP 地址 |

10.0.0.2 (NIC2-2) |

10.0.0.2 (NIC2-2) |

10.0.0.2 (NIC2-2) |

10.0.0.2 (NIC2-2) |

|

磁盘心跳设备 |

/dev/sdb1 |

/dev/sdb1 |

|||

镜像磁盘连接 |

192.168.0.2 (NIC2-1) |

10.0.0.2 (NIC2-2) |

|||

用于管理的组(CIuster WebUI用) |

类型 |

失效切换 |

失效切换 |

失效切换 |

失效切换 |

组名

|

Management

Group

|

Management

Group

|

Management

Group

|

Management

Group

|

|

启动服务器 |

所有服务器 |

所有服务器 |

所有服务器 |

所有服务器 |

|

组资源数 |

1 |

1 |

1 |

1 |

|

用于管理的组的组资源 2 |

类型 |

浮动IP资源 |

浮动IP资源 |

浮动IP资源 |

浮动IP资源 |

组资源名 |

ManagementIP |

ManagementIP |

ManagementIP |

ManagementIP |

|

IP 地址 |

10.0.0.11 (FIP1) |

10.0.0.11 (FIP1) |

10.0.0.11 (FIP1) |

10.0.0.11 (FIP1) |

|

用于业务的组 |

类型 |

失效切换 |

失效切换 |

失效切换 |

失效切换 |

组名 |

failover1 |

failover1 |

failover1 |

failover1 |

|

启动服务器 |

所有服务器 |

所有服务器 |

所有服务器 |

所有服务器 |

|

组资源数 |

3 |

3 |

3 |

4 |

|

第 1 个组的资源 |

类型 |

浮动IP资源 |

浮动IP资源 |

浮动IP资源 |

浮动IP资源 |

组资源名 |

fip1 |

fip1 |

fip1 |

fip1 |

|

IP 地址 |

10.0.0.12 (FIP2) |

10.0.0.12 (FIP2) |

10.0.0.12 (FIP2) |

10.0.0.12 (FIP2) |

|

第 2 个组的资源 |

类型 |

磁盘资源 |

镜像磁盘资源 |

镜像磁盘资源 |

磁盘资源 |

组资源名 |

disk1 |

md1 |

md1 |

disk1 |

|

磁盘类型 |

disk |

lvm |

|||

文件系统 |

ext3 |

ext3 |

|||

设备名 |

/dev/sdb2 |

/dev/dg1/lv1 |

|||

Mount 点 |

/mnt/sdb2 |

/mnt/disk1 |

|||

镜像分区设备名 |

/dev/NMP1 |

/dev/NMP1 |

|||

Mount 点 |

/mnt/sdb2 |

/mnt/sdb2 |

|||

数据分区设备名 |

/dev/sdb2 |

/dev/sdb2 |

|||

集群分区设备名 |

/dev/sdb1 |

/dev/sdb1 |

|||

文件系统 |

ext3 |

ext3 |

|||

第 3 个组的资源 |

类型 |

EXEC资源 |

EXEC资源 |

EXEC资源 |

EXEC资源 |

组资源名 |

exec1 |

exec1 |

exec1 |

exec1 |

|

脚本 |

标准脚本 |

标准脚本 |

标准脚本 |

标准脚本 |

|

第 4 个组的资源(仅限使用卷管理时) |

类型 |

卷管理资源 |

|||

组资源名 |

volmgr1 |

||||

卷管理 |

lvm |

||||

目标名 |

vg1 |

||||

第 1 个监视资源(默认创建) |

类型 |

用户空间监视 |

用户空间监视 |

用户空间监视 |

用户空间监视 |

监视资源名 |

userw |

userw |

userw |

userw |

|

第 2 个监视

资源

|

类型 |

磁盘监视 |

磁盘监视 |

磁盘监视 |

磁盘监视 |

监视资源名 |

diskw1 |

diskw1 |

raww1 |

diskw1 |

|

设备名 |

/dev/sdb1 |

/dev/sdb1 |

/dev/sdb1 |

/dev/vg1/lv1 |

|

监视对象 Raw

设备名

|

|||||

监视方法

|

read

(O_DIRECT)

|

read

(O_DIRECT)

|

read

(O_DIRECT)

|

read

(O_DIRECT)

|

|

监视时间 |

常时 |

常时 |

常时 |

启动时 |

|

监视对象 |

volmgr1 |

||||

查出异常时

|

集群服务

停止,OS 关机

|

集群服务

停止,OS 关机

|

集群服务

停止,OS 关机

|

集群服务

停止,OS 关机

|

|

第 3 个监视

资源

(创建ManagementIP资源后自动创建)

|

类型 |

浮动IP监视 |

浮动IP监视 |

浮动IP监视 |

浮动IP监视 |

监视资源名 |

fipw1 |

fipw1 |

fipw1 |

fipw1 |

|

监视对象 |

ManagementIP |

ManagementIP |

ManagementIP |

ManagementIP |

|

查出异常时 |

"ManagementGroup"组的失效切换 3 |

"ManagementGroup"组的失效切换 3 |

"ManagementGroup"组的失效切换 3 |

"ManagementGroup"组的失效切换 3 |

|

第 4 个监视

资源

(创建fip1资源后自动创建)

|

类型 |

浮动IP监视 |

浮动IP监视 |

浮动IP监视 |

浮动IP监视 |

监视资源名 |

fipw2 |

fipw2 |

fipw2 |

fipw2 |

|

监视对象 |

fip1 |

fip1 |

fip1 |

fip1 |

|

查出异常时 |

"failover1"组的失效切换 3 |

"failover1"组的失效切换 3 |

"failover1"组的失效切换 3 |

"failover1"组的失效切换 3 |

|

第 5 个监视

资源

|

类型 |

IP监视 |

IP监视 |

IP监视 |

IP监视 |

监视资源名 |

ipw1 |

ipw1 |

ipw1 |

ipw1 |

|

监视IP地址

|

10.0.0.254

(网关)

|

10.0.0.254

(网关)

|

10.0.0.254

(网关)

|

10.0.0.254

(网关)

|

|

查出异常时 |

全组的失效切换 3 |

全组的失效切换 3 |

全组的失效切换 3 |

全组的失效切换 3 |

|

第 6 个监视资源(创建镜像磁盘资源后自动创建) |

类型 |

镜像磁盘连接监视 |

镜像磁盘连接监视 |

||

监视资源名 |

mdnw1 |

mdnw1 |

|||

监视镜像磁盘资源 |

md1 |

md1 |

|||

查出异常时 |

不执行任何

操作

|

不执行任何

操作

|

|||

第 7 个监视资源(创建镜像磁盘资源后自动创建) |

类型 |

镜像磁盘监视 |

镜像磁盘监视 |

||

监视资源名 |

mdw1 |

mdw1 |

|||

监视镜像磁盘资源 |

md1 |

md1 |

|||

查出异常时

|

不执行任何

操作

|

不执行任何

操作

|

|||

第 8 个组资源(仅限使用卷管理时,创建卷管理资源后自动创建) |

类型 |

卷管理监视 |

|||

监视资源名 |

volmgrw1 |

||||

卷管理 |

lvm |

||||

目标名 |

vg1 |

||||

监视时机 |

启动时 |

||||

监视对象 |

volmgr1 |

||||

第 1 个PingNP

资源

|

资源名 |

xxxx |

|||

监视对象1 |

xxxx |

||||

监视对象2 |

xxxx |

6.4. 创建2节点集群配置信息的步骤¶

要创建集群配置信息,基本上需要按照创建集群,创建组,创建监视资源3步来执行操作。以下具体说明各操作步骤。

注解

集群配置信息的操作可反复多次执行。另外,大部分设置完成的内容之后可通过改名功能或属性显示功能进行更改。

-

生成集群,添加服务器。

-

创建执行失效切换时的单位,即失效切换组。

"6.4.2.2. 添加组资源(浮动IP资源)": 添加组的构成资源。

"6.4.2.3. 添加组资源(卷管理资源)": 添加组的构成资源。

"6.4.2.4. 添加组资源(磁盘资源)": 使用磁盘资源时添加组的构成资源。

"6.4.2.5. 添加组资源(镜像磁盘资源)": 使用镜像磁盘资源时添加组的构成资源。

"6.4.2.6. 添加组资源(EXEC资源)": 添加组的构成资源。

-

在集群内添加用于监视指定的监视对象的监视资源。

"6.4.3.1. 添加监视资源 (磁盘监视)": 添加使用的监视资源。

"6.4.3.2. 添加监视资源 (IP监视)": 添加使用的监视资源。

-

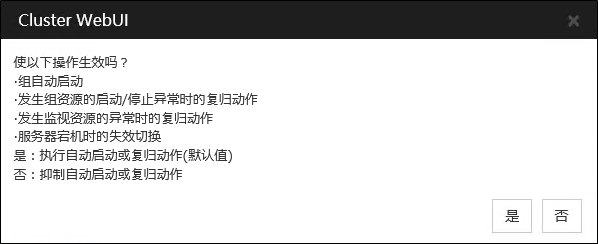

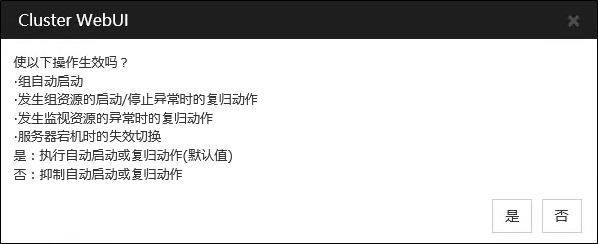

使集群动作有效或者无效。

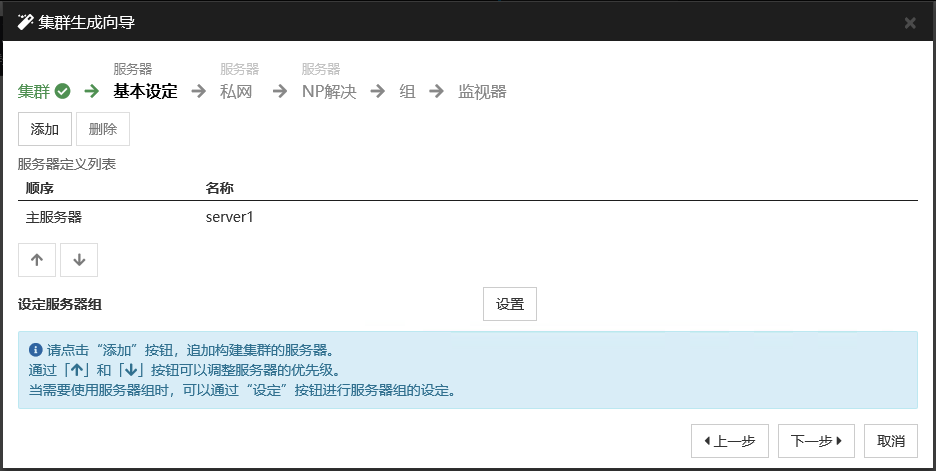

6.4.1. 创建集群¶

首先创建集群。在创建的集群内添加构成集群的服务器,设置优先级和心跳的优先级。

6.4.1.1. 添加集群¶

在[集群生成向导]的[集群]画面点击[语言]区域,选择使用Cluster WebUI的机器的OS所使用的语言。

注解

1个集群内可使用的语言只有1个。如果在集群内使用多种语言的OS,为了防止出现乱码,请指定为"英语"。

在[集群名]框内输入集群名(cluster)。

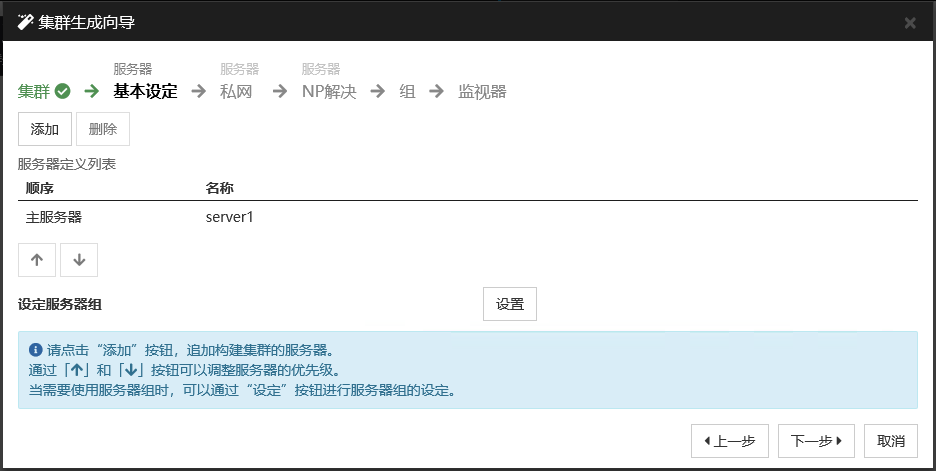

- 将用于Cluster WebUI 连接的浮动IP地址(10.0.0.11)输入[管理IP地址]框内。点击[下一步]。显示服务器的[基本设定]。Cluster WebUI启动时通过URL指定的IP地址的服务器(server1)已登录在列表中。

6.4.1.2. 添加服务器¶

添加构成集群的第2台服务器。

在[服务器定义列表]中点击[添加]。

打开[添加服务器]对话框。输入第2台服务器的服务器名,FQDN名或IP地址,点击[确定]。第2台服务器(server2)将添加入[服务器定义列表]。

点击[下一步]。

6.4.1.3. 设置网络配置¶

设置构筑集群的服务器间的网络配置。

请通过[添加][删除]添加或删除通信路径,并点击各服务器列表的单元格选择或输入IP地址。如通信路径有部分服务器未连接,请保持未连接的服务器的单元格为空白。

- 用于接收或发送心跳信息的通信路径(私网)请双击[种类]列表的单元格并选择[内核模式]。不用于心跳,而用于镜像磁盘资源或共享型磁盘资源的数据镜像通信时,请选择[镜像通信专用]。必须将一个或一个以上的通信路径设置为私网。尽量将全部通信路径设置为私网。此外,如设有多个私网,[优先级]列表中编号较小的通信路径将优先用于集群服务器间的内部通信。如需更改优先级,请通过箭头更改通信路径的排列顺序。

使用DISK心跳时,点击[种类]列的单元格,选择[DISK]。点击[服务器名]列的单元格,选择或输入磁盘设备。对于不使用DISK心跳的服务器,请将[服务器名]列的单元格设为空白。

使用Witness心跳时,点击 [种类]列表的单元格并选择 [Witness]。点击 [属性]按钮,在[目标主机] 中输入Witness 服务器的服务器地址,在 [服务端口]中输入端口号。不使用Witness 心跳的服务器时,请点击该服务器单元,选择[不使用]。

用于镜像磁盘资源的数据镜像通信的通信路径(镜像磁盘连接)请点击[MDC]列表的单元格并选择分配给该通信路径的镜像磁盘连接名(mdc1~mdc16)。不用于数据镜像通信的通信路径请选择[不使用]。

点击[下一步]。

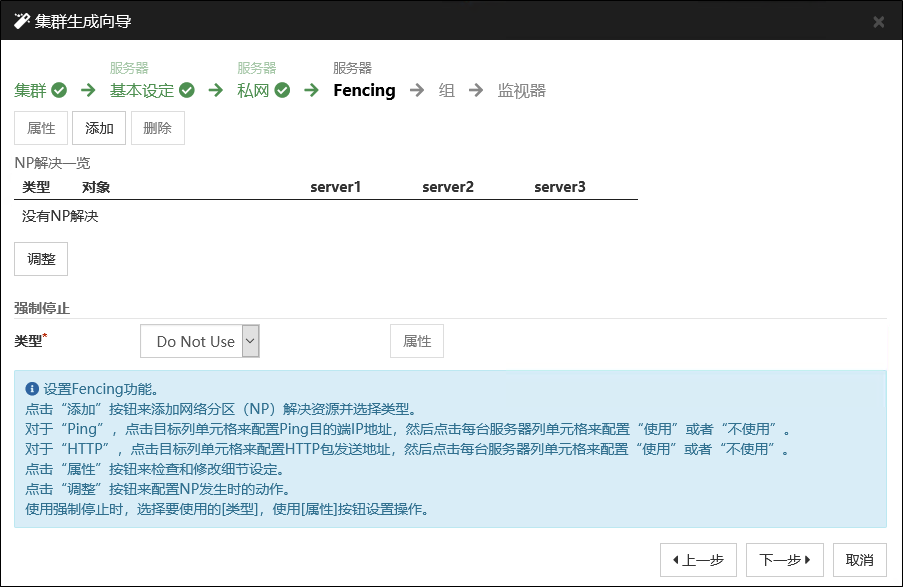

6.4.1.4. 设置网络分区解决处理¶

设置网络分区解决资源。

- 如进行PING方式的NP解决,点击[添加]在[NP解决一览]中添加行,点击[种类]列的单元格,选择[Ping],点击[Ping目标]列的单元格,然后点击各服务器的单元格,输入ping发送的目标机器(网关等)的IP地址。输入以逗号隔开的多个IP地址后,如这些地址全部没有ping响应,则可判断为孤立于网络的状态。若只有部分服务器使用PING方法,则请将不使用的服务器的单元格设为[不使用]。需要更改ping相关的参数的默认值时,选择[属性],在[Ping NP的属性]对话框中进行设置。在本章的设置示例中,添加一行PING方式行,[Ping目标]设为192.168.0.254。

- 进行HTTP 方式的NP 解决时,点击 [添加]后在[NP 解决一览]里添加一行,点击 [种类]列的单元格,选择[HTTP/HTTPS]。 点击[属性] 按钮,在 [对象主机] 中输入Web 服务器的服务器地址,在 [服务端口]中输入端口号。只有一部分的服务器使用HTTP 方式时,不使用的服务器的单元格请选择[不使用]。在本章的设置示例中,不使用HTTP方式。

- 选择[调整],设置检查出网络分区时的动作。选择[停止集群服务和关闭OS]或[停止集群服务],点击[确定]。在本章的设置示例中选择[停止集群服务]。

点击[下一步]。

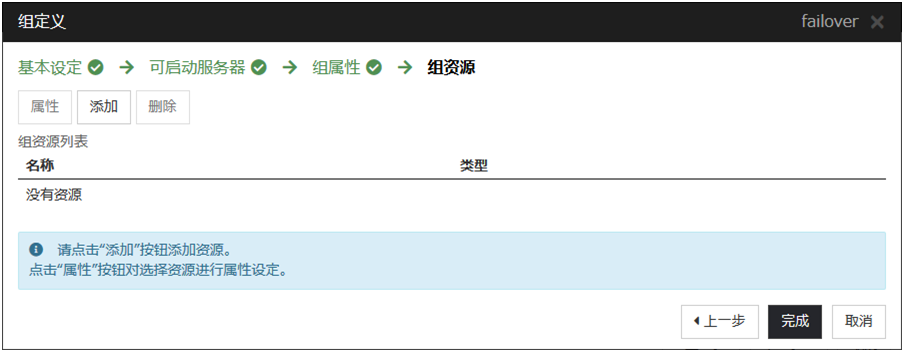

6.4.2. 创建失效切换组¶

在集群中添加运行业务应用程序的失效切换组(以下有时简称"组")。

6.4.2.1. 添加失效切换组¶

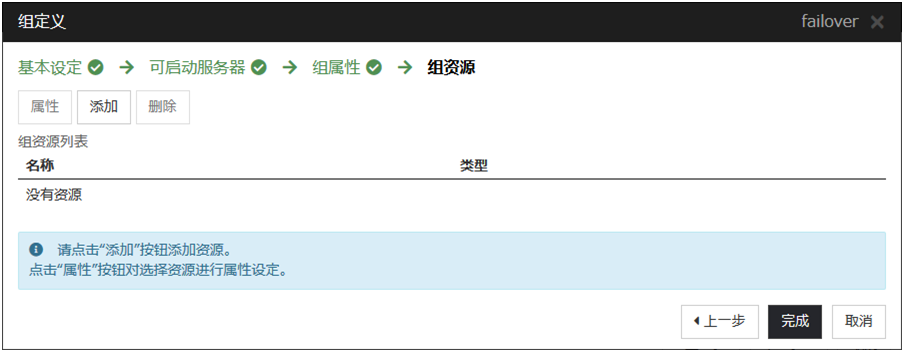

设置发生故障时作为进行失效切换单位的组。

在[组列表]中点击[添加]。

- 打开[组定义列表]对话框。在[名称]框内输入组名 (failover1),点击[下一步]。

设置可以启动失效切换组的服务器。在本章的设置示例中,使用共享磁盘及镜像磁盘时,选中[所有服务器都可以进行失效切换]的复选框。

- 设置失效切换组的各属性值。在本章的设置示例中,由于全部使用了默认值,因此直接点击[下一步]。显示[组资源]。

6.4.2.2. 添加组资源(浮动IP资源)¶

在步骤 "6.4.2.1. 添加失效切换组" 建的失效切换组添加组的构成要素,即组资源。

显示[组资源列表],点击[添加]。

打开[组的资源定义| failover1]对话框。在[类型]框中选择组资源的类型 (浮动IP资源),在[名称]框内输入组资源名 (fip1)。点击[下一步]。

显示设置依存关系的画面。无需指定任何内容,点击[下一步]按钮。

显示[检测到组资源的启动异常时的流程],[检测到组资源的停止异常时的流程]。点击[下一步]。

在[IP地址]对话框中输入IP地址(10.0.0.12),点击[完成]。

6.4.2.3. 添加组资源(卷管理资源)¶

如果集群环境使用卷管理器,作为组资源需要添加卷管理器。

在[组资源列表]中点击[添加]。

打开[组的资源定义| failover1]界面。在[类型]框中选择组资源的类型 (卷管理资源) ,在[名称]框内输入组资源名 (volmgr1) 。点击[下一步]。

显示设置依存关系的画面。不需要指定任何内容,直接点击[下一步]。

- 显示[检测到组资源的启动异常时的流程],[检测到组资源的停止异常时的流程]。点击[下一步]。

选择要使用的卷管理器名(lvm),在对话框中输入目标名(vg1)。点击[完成]。

6.4.2.4. 添加组资源(磁盘资源)¶

如果集群环境使用共享磁盘,作为组资源需要添加共享磁盘。

在[组资源列表]中点击[添加]。

显示[组的资源定义| failover1]画面。在[类型]框中选择组资源的类型 (磁盘资源),在[名称]框内输入组资源名 (disk1)。点击[下一步]。

显示设置依存关系的画面。不需要指定任何内容,直接点击[下一步]。

- 显示[检测到组资源的启动异常时的流程],[检测到组资源的停止异常时的流程]。点击[下一步]。

在[磁盘类型]框中选择磁盘类型(disk),在[文件系统]框中选择文件系统(ext3),分别在相应的框中输入磁盘名(/dev/sdb2),挂载点(/mnt/sdb2)。点击[完成]。

6.4.2.5. 添加组资源(镜像磁盘资源)¶

如果集群环境是镜像磁盘型,作为组资源需要添加镜像磁盘。

在[组资源列表]中点击[添加]。

显示[组的资源定义| failover1]画面。在[类型]框中选择组资源的类型(镜像磁盘资源),在[名称]框内输入组资源名 (md1)。点击[下一步]。

显示设置依存关系的画面。不需要指定任何内容,直接点击[下一步]。

- 显示[检测到组资源的启动异常时的流程],[检测到组资源的停止异常时的流程]。点击[下一步]。

在[镜像分区设备名]框中选择镜像分区名(/dev/NMP1)。分别在相应的框中输入挂载点(/mnt/sdb2),数据分区设备名(/dev/sdb2),集群分区设备名(/dev/sdb1)。在[文件系统]框中选择文件系统(ext3)。点击[完成]。

注解

[类型]框中不显示(镜像磁盘资源)时,在确认EXPRESSCLUSTER X Replicator License的已注册的情况下,请点击[获取License信息]。

6.4.2.6. 添加组资源(EXEC资源)¶

添加EXEC资源,用于通过脚本启动或者退出应用程序。

在[组资源列表]中点击[添加]。

显示[组的资源定义| failover1]画面。在[类型]框中选择组资源的类型(EXEC资源) ,在[名称]框内输入组资源名 (exec1)。点击[下一步]。

显示设置依存关系的画面。不需要指定任何内容,直接点击[下一步]。

- 显示[检测到组资源的启动异常时的流程],[检测到组资源的停止异常时的流程]。点击[下一步]。

- 选中[该产品创建的脚本]。用户编辑该脚本,记述业务应用程序的启动以及停止步骤。若已经确定了EXPRESSCLUSTER使用的应用程序,则在此处编辑脚本。点击[完成]。如果集群环境使用共享磁盘,failover1的[组资源定义列表]视图如下。

如果集群环境是镜像磁盘型,则failover1的[组资源定义列表]视图如下。

如果集群环境是镜像磁盘型,则failover1的[组资源定义列表]视图如下。

点击[完成]。

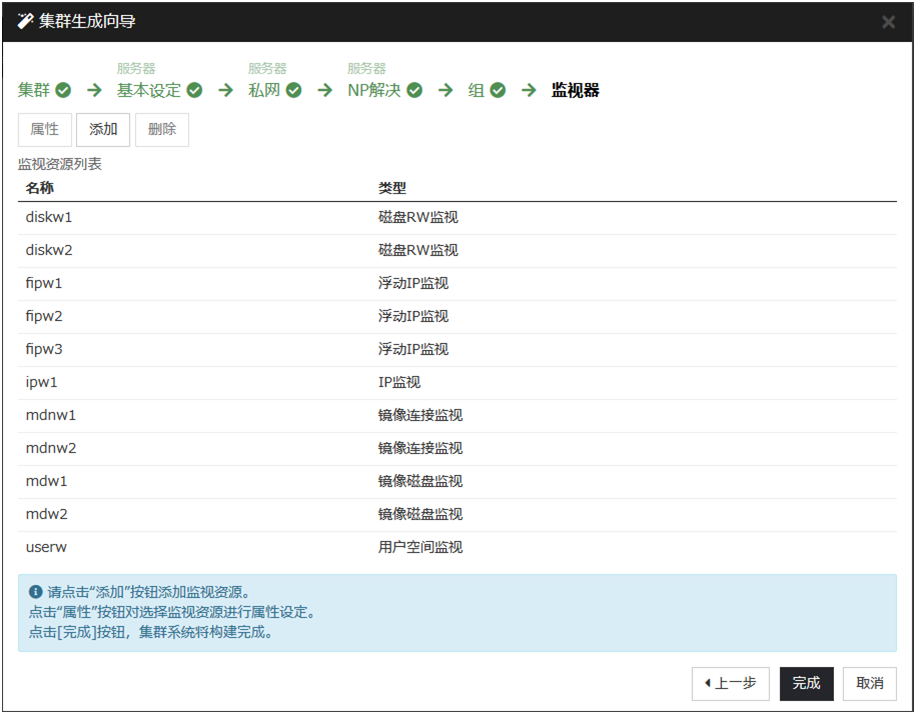

6.4.3. 创建监视资源¶

在集群中添加监视资源,用于监视指定的对象。

6.4.3.1. 添加监视资源 (磁盘监视)¶

添加用于监视磁盘的监视资源。该例中添加磁盘监视。

在[组定义]中点击[下一步]。

显示[监视资源列表]。点击[添加]。

- 打开[监视资源定义]对话框。集群环境使用共享磁盘的情况下,定义集群名时,默认创建第1个监视资源。使用镜像磁盘的情况下,定义集群名时,默认创建第1个监视资源。添加镜像磁盘资源时,默认创建第6个和第7个监视资源。在[类型]框中选择监视资源的类型 (磁盘监视),在[名称]框内输入监视资源名 (diskw1)。点击[下一步]。

输入监视设置。使用卷管理器时,输入监视时间(启动时),监视对象(volmgr1)。其余场合,保持默认设置,点击[下一步]。

- 卷管理器时,输入监视方法(READ(O_DIRECT)),监视对象RAW设备名(/dev/vg1/lv1)。其余场合,输入监视方法(READ(O_DIRECT)),监视目标(/dev/sdb1)。点击[下一步]。

设置复归对象。点击[浏览]。

在显示的树形图中选择[LocalServer],点击[OK]。在[复归对象]中设置[LocalServer]。

在[最终动作]框内选择[停止集群服务并关闭OS],点击[完成]。

6.4.3.2. 添加监视资源 (IP监视)¶

添加用于监视网络的监视资源。

显示[监视资源列表]。点击[添加]。

打开[监视资源定义]画面。在[类型]框中选择监视资源的类型(IP监视),在[名称]框内输入监视资源名(ipw1) 。点击[下一步]。

输入监视设置。此处不做更改,保留默认值,点击[下一步]。

- 点击[添加]。在[IP地址]框内输入监视IP地址(10.0.0.254),点击[确定]。

注解

IP监视资源的监视对象需指定在公网上以常时运行为前提的机器(如:网关)的IP地址。

输入的IP地址设置在 [IP地址列表]中。点击[下一步]。

设置复归对象。点击[参照]。

- 在显示的树形视图中选择[All Groups],点击[确定]。复归对象设置为[All Groups]。点击[完成]。[监视资源列表]视图如下。镜像磁盘资源使用时,添加并显示mdnw1,mdw1。卷管理资源使用时,添加并显示volmgrw1。

6.5. 确认3节点集群环境的设置值¶

6.5.1. 集群环境示例¶

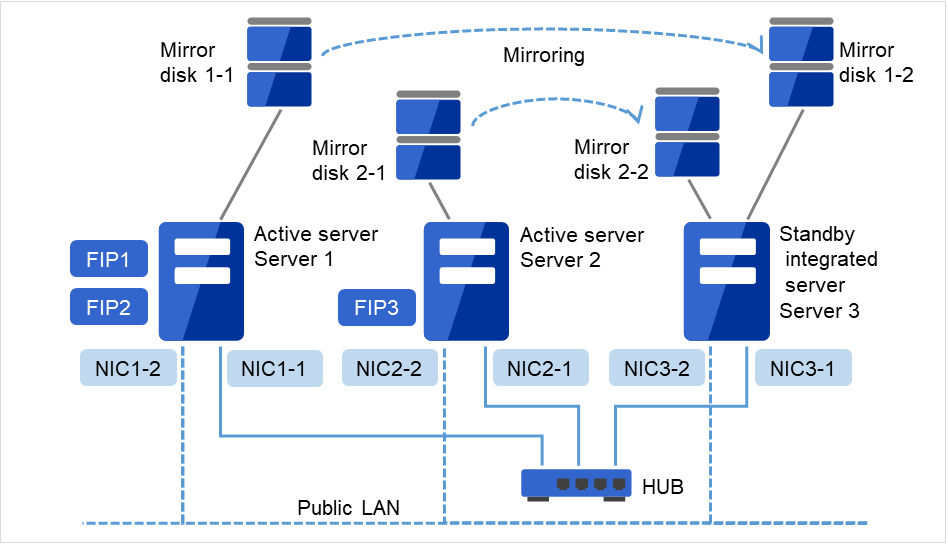

本章以下图所示3节点镜像的集群环境配置为例进行说明。

图 6.6 3节点集群的示例(镜像磁盘)¶

FIP1: 从Cluster WebUI客户端访问

FIP2: 从业务客户端访问

下表是构建上述集群系统时的集群配置信息示例。后文将按照这些条件分步说明创建集群配置信息的步骤。实际设置值时,请使用要构建的集群的配置信息代替文中设置内容。关于值的确定方法,请参阅《参考指南》。

3节点的配置设置示例

设置对象 |

设置参数 |

设置值 |

|---|---|---|

集群配置 |

集群名 |

cluster |

服务器数 |

3 |

|

失效切换组数 |

3 |

|

监视资源数 |

10 |

|

心跳资源 |

内核模式LAN心跳数 |

2 |

第1台服务器的信息

(主服务器)

|

服务器名 4 |

server1 |

私网的IP地址

(专用)

|

192.168.0.1 (NIC1-1)

|

|

私网的IP地址

(备份)

|

10.0.0.1 (NIC1-2)

|

|

公网的IP地址 |

10.0.0.1 (NIC1-2) |

|

镜像磁盘连接器1 |

192.168.0.1 (NIC1-1) |

|

第2台服务器的信息 |

服务器名 4 |

server2 |

私网的IP地址

(专用)

|

192.168.0.2 (NIC2-1)

|

|

私网的IP地址

(备份)

|

10.0.0.2 (NIC2-2)

|

|

公网的IP地址 |

10.0.0.2 (NIC2-2) |

|

镜像磁盘连接器1 |

192.168.0.2 (NIC2-1) |

|

第3台服务器的信息

(待机系集约服务器)

|

服务器名 4 |

server3 |

私网的IP地址

(专用)

|

192.168.0.3 (NIC3-1)

|

|

私网的IP地址

(备份)

|

10.0.0.3 (NIC3-2)

|

|

公网的IP地址 |

10.0.0.3 (NIC3-2) |

|

镜像磁盘连接器1 |

192.168.0.3 (NIC3-1) |

|

用于管理的组

(Cluster WebUI用)

|

类型 |

失效切换 |

组名 |

ManagementGroup |

|

启动服务器 |

所有服务器 |

|

组资源数 |

1 |

|

用于管理的组的资源 5 |

类型 |

浮动IP资源 |

组资源名 |

ManagementIP |

|

IP地址 |

10.0.0.11 (FIP1) |

|

用于业务的组1 |

类型 |

失效切换 |

组名 |

failover1 |

|

启动服务器 |

server1 -> server3 |

|

组资源数 |

3 |

|

第1个组的资源 |

类型 |

浮动IP资源 |

组资源名 |

fip1 |

|

IP地址 |

10.0.0.12 (FIP2) |

|

第2个组的资源

(Mirror disk 1-1

Mirror disk 1-2)

|

类型 |

镜像磁盘资源 |

组资源名 |

md1 |

|

镜像分区设备名 |

/dev/NMP1 |

|

Mount点 |

/mnt/md1 |

|

数据分区设备名 |

/dev/sdb2 |

|

集群分区设备名 |

/dev/sdb1 |

|

文件系统 |

ext3 |

|

镜像磁盘连接 |

mdc1 |

|

第3个组的资源

(Mirror disk 2-1

Mirror disk 2-2)

|

类型 |

EXEC资源 |

组资源名 |

exec1 |

|

脚本 |

标准脚本 |

|

用于业务的组2 |

类型 |

失效切换 |

组名 |

failover2 |

|

启动服务器 |

server2 -> server3 |

|

组资源数 |

3 |

|

第1个组的资源 |

类型 |

浮动IP资源 |

组资源名 |

fip2 |

|

IP 地址 |

10.0.0.13 (FIP3) |

|

第2个组的资源 |

类型 |

镜像磁盘资源 |

组资源名 |

md2 |

|

镜像分区设备名 |

/dev/NMP2 |

|

Mount点 |

/mnt/md2 |

|

数据分区设备名 |

/dev/sdb2 |

|

数据分区设备名

(server3 服务器进行其他设置)

|

/dev/sdc2

|

|

集群分区设备名 |

/dev/sdb1 |

|

集群分区设备名

(server3服务器进行其他设置)

|

/dev/sdc1

|

|

文件系统 |

ext3 |

|

镜像磁盘连接 |

mdc2 |

|

第3个组的资源 |

类型 |

EXEC资源 |

组资源名 |

exec2 |

|

脚本 |

标准脚本 |

|

第1个监视资源

(默认创建)

|

类型 |

用户空间监视 |

监视资源名 |

userw |

|

第2个监视资源

(Mirror disk 1-1

Mirror disk 1-2

Mirror disk 2-1)

|

类型 |

磁盘监视 |

监视资源名 |

diskw1 |

|

设备名 |

/dev/sdb1 |

|

监视对象Raw设备名 |

- |

|

查出异常时 |

集群服务停止, OS关机 |

|

监视方法 |

read(O_DIRECT) |

|

第3个监视资源

(Mirror disk 2-2)

|

类型 |

磁盘监视 |

监视资源名 |

diskw2 |

|

设备名 |

/dev/sdc1 |

|

监视对象Raw设备名 |

- |

|

查出异常时 |

集群服务停止, OS关机 |

|

监视方法 |

read(O_DIRECT) |

|

启动服务器指定 |

server3 |

|

第4个监视资源

(创建ManagementIP资源后自动创建)

|

类型 |

浮动IP监视 |

监视资源名 |

fipw1 |

|

监视对象 |

ManagementIP |

|

查出异常时 |

"ManagementGroup" 组的失效切换 6 |

|

第5个监视资源

(创建fip1资源后自动创建)

|

类型 |

浮动IP监视 |

监视资源名 |

fipw2 |

|

监视对象 |

fip1 |

|

查出异常时 |

"failover1" 组的失效切换 6 |

|

第6个监视资源

(创建fip1资源后自动创建)

|

类型 |

浮动IP监视 |

监视资源名 |

fipw3 |

|

监视对象 |

fip2 |

|

查出异常时 |

"failover2" 组的失效切换 6 |

|

第7个监视资源 |

类型 |

IP监视 |

监视资源名 |

ipw1 |

|

监视IP地址

|

10.0.0.254

(网关)

|

|

查出异常时 |

全组的失效切换 |

|

第8个监视资源

(创建镜像磁盘资源后自动创建)

|

类型 |

镜像磁盘连接监视 |

监视资源名 |

mdnw1 |

|

监视镜像磁盘资源 |

md1 |

|

查出异常时 |

不执行任何操作 |

|

第9个监视资源

(创建镜像磁盘资源后自动创建)

|

类型 |

镜像磁盘连接监视 |

监视资源名 |

mdnw2 |

|

监视镜像磁盘资源 |

md2 |

|

查出异常时 |

不执行任何操作 |

|

第10个监视资源

(创建镜像磁盘资源后自动创建)

|

类型 |

镜像磁盘监视 |

监视资源名 |

mdw1 |

|

监视镜像磁盘资源 |

md1 |

|

查出异常时 |

不执行任何操作 |

|

第11个监视资源

(创建镜像磁盘资源后自动创建)

|

类型 |

镜像磁盘监视 |

监视资源名 |

mdw2 |

|

监视镜像磁盘资源 |

md2 |

|

查出异常时 |

不执行任何操作 |

6.6. 创建3节点集群配置信息的步骤¶

要创建集群配置信息,基本上需要按照创建集群,创建组,创建监视资源3步来执行操作。以下具体说明各操作步骤。

注解

集群配置信息的操作可反复多次执行。另外,大部分设置完成的内容之后可通过改名功能或属性显示功能进行更改。

-

生成集群,添加服务器。

-

创建执行失效切换时的单位,即失效切换组。

"6.6.2.1. 添加失效切换组(业务用1)": 添加作为失效切换单位的组。

"6.6.2.2. 添加组资源(浮动IP资源)": 添加组的构成资源。

"6.6.2.3. 添加组资源(镜像磁盘资源)": 添加组的构成资源。

"6.6.2.4. 添加组资源(EXEC资源)": 添加组的构成资源。

"6.6.2.5. 添加失效切换组(业务用2)": 添加组的构成资源。

"6.6.2.6. 添加组资源(浮动IP资源)": 添加组的构成资源。

"6.6.2.7. 添加组资源(镜像磁盘资源)": 添加组的构成资源。

"6.6.2.8. 添加组资源(EXEC资源)": 添加组的构成资源。

-

在集群内添加用于监视指定的监视对象的监视资源。

"6.6.3.1. 添加监视资源(磁盘监视)": 添加使用的监视资源。

"6.6.3.2. 添加监视资源(磁盘监视)": 添加使用的监视资源。

"6.6.3.3. 添加监视资源(IP监视)": 添加使用的监视资源。

-

使集群动作有效或者无效。

6.6.1. 创建集群¶

首先创建集群。在创建的集群内添加构成集群的服务器,设置优先级和心跳的优先级。

6.6.1.1. 添加集群¶

点击Cluster WebUI编辑模式中的[集群生成向导],显示[集群生成向导]对话框。在[语言]域中选择使用Cluster WebUI的机器的OS所使用的语言。

注解

1个集群内可使用的语言只有1个。如果在集群内使用多种语言的OS,为了防止出现乱码,请指定为"English"。

在[集群名]框内输入集群名(cluster)。

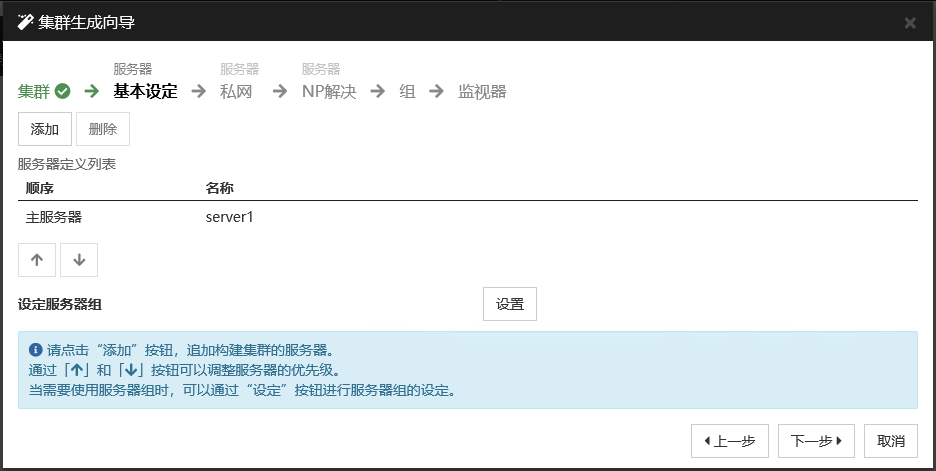

- 将用于Cluster WebUI连接的浮动IP地址(10.0.0.11)输入[管理IP地址]框内。点击[下一步]。显示[服务器]的[基本设定]。Cluster WebUI启动时通过URL指定的IP地址的服务器(server1)已登录在列表中。

6.6.1.2. 添加服务器¶

添加构成集群的第2台以后的服务器。

在[服务器定义列表]中点击[添加]。

打开[添加服务器]对话框。输入第2台服务器的服务器名,FQDN名或IP地址,点击[确定]。第2台服务器(server2)将添加入[服务器定义列表]。

以相同步骤添加第3台服务器(server3)。

点击[下一步]。

6.6.1.3. 设置网络配置¶

设置构筑集群的服务器间的网络配置。

请通过[添加][删除]添加或删除通信路径,并点击各服务器列表的单元格选择或输入IP地址。如通信路径有部分服务器未连接,请保持未连接的服务器的单元格为空白。

- 用于接收或发送心跳信息的通信路径(私网)请点击[种类]列表的单元格并选择[内核模式]。不用于心跳,而用于镜像磁盘资源或共享型磁盘资源的数据镜像通信时,请选择[镜像通信专用]。不用于心跳的通信路径请选择[不使用]。必须将一个或一个以上的通信路径设置为私网。尽量将全部通信路径设置为私网。此外,如设有多个私网,[优先级]列表中编号较小的通信路径将优先用于集群服务器间的内部通信。如需更改优先级,请点击箭头更改通信路径的排列顺序。

使用DISK心跳时,点击[种类]列的单元格,选择[DISK]。点击[服务器名]列的单元格,选择或输入磁盘设备。

使用Witness心跳时,点击 [种类]列表的单元格并选择 [Witness]。点击 [属性]按钮,在[目标主机] 中输入Witness 服务器的服务器地址,在 [服务端口]中输入端口号。不使用Witness 心跳的服务器时,请点击该服务器单元,选择[不使用]。

用于镜像磁盘资源或共享型镜像磁盘资源的数据镜像通信的通信路径(镜像磁盘连接)请点击[MDC]列表的单元格并选择分配给该通信路径的镜像磁盘连接名(mdc1~mdc16)。不用于数据镜像通信的通信路径请选择[不使用]。

点击[下一步]。

6.6.1.4. 设置网络分区解决处理¶

设置网络分区解决资源。

- 如进行PING方式的NP解决,点击[添加]在[NP解决一览]中添加行,点击[种类]列的单元格,选择[Ping],点击[Ping目标]列的单元格,然后点击各服务器的单元格,输入ping发送的目标机器(网关等)的IP地址。输入以逗号隔开的多个IP地址后,如这些地址全部没有ping响应,则可判断为孤立于网络的状态。若只有部分服务器使用PING方法,则请将不使用的服务器的单元格设为[不使用]。需要更改ping相关的参数的默认值时,选择[属性],在[Ping NP的属性]对话框中进行设置。在本章的设置示例中,添加一行PING方式行,[Ping目标]设为 192.168.0.254。

- 进行HTTP 方式的NP 解决时,点击 [添加]后在[NP 解决一览]里添加一行,点击 [种类]列的单元格,选择[HTTP/HTTPS]。 点击[属性] 按钮,在 [目标主机] 中输入Web 服务器的服务器地址,在 [服务端口]中输入端口号。只有一部分的服务器使用HTTP 方式时,不使用的服务器的单元格请选择[不使用]。在本章的设置示例中,不使用HTTP方式。

- 选择[调整],设置检查出网络分区时的动作。选择[停止集群服务和关闭OS]或[停止集群服务],点击[确定]。在本章的设置示例中选择[停止集群服务]。

点击[下一步]。

6.6.2. 创建失效切换组¶

在集群中添加运行业务应用程序的失效切换组(以下有时简称"组")。

6.6.2.1. 添加失效切换组(业务用1)¶

设置发生故障时作为进行失效切换单位的组。

在[组列表]中点击[添加]。

- 打开[组定义]界面。在[名称]框内输入组名 (failover1) ,点击[下一步]。

设置可以启动失效切换组的服务器。在本章的设置示例中,取消[所有服务器都可以进行失效切换],从[可以使用的服务器列表中按[server1],[server3]的顺序添加入[可以启动组的服务器]。

- 设置失效切换组的各属性值。在本章的设置示例中,由于全部使用了默认值,因此直接点击[下一步]。显示[组资源]。

6.6.2.2. 添加组资源(浮动IP资源)¶

在步骤"6.6.2.1. 添加失效切换组(业务用1)" 中创建的失效切换组内添加组的构成要素,即组资源。

在[组资源列表]中点击[添加]。

打开[组的资源定义| failover1]画面。在[类型]框中选择组资源的类型(浮动IP资源) ,在[名称]框内输入组资源名 (fip1) 。点击[下一步]。

显示设置依存关系的画面。无需指定任何内容,点击[下一步]按钮。

显示[检测到组资源的启动异常时的流程],[检测到组资源的停止异常时的流程]。点击[下一步]。

在[IP地址]框中输入IP地址(10.0.0.12),点击[完成]。

6.6.2.3. 添加组资源(镜像磁盘资源)¶

在[组资源列表]中点击[添加]。

打开[组的资源定义| failover1]画面。在[类型]框中选择组资源的类型(镜像磁盘资源),在[名称]框内输入组资源名 (md1)。点击[下一步]。

显示设置依存关系的画面。无需指定任何内容,点击[下一步]按钮。

显示[检测到组资源的启动异常时的流程],[检测到组资源的停止异常时的流程]。点击[下一步]。

在[镜像分区设备名]框内选择镜像分区设备名 (/dev/NMP1)。在对应的输入框内分别输入Mount点 (/mnt/md1),数据分区设备名 (/dev/sdb2),集群分区设备名 (/dev/sdb1)。在[文件系统]框内选择文件系统(ext3)。

点击[镜像磁盘连接 I/F 列表]中的[选择]。选择[顺序]的[2],点击[删除]。确认[镜像磁盘连接列表]中只有顺序]的[1]被选择,点击[确定]。

点击[组的资源定义| failover1]的[完成]。

注解

[类型]框中不显示(镜像磁盘资源)时,在确认已注册EXPRESSCLUSTER X Replicator License的情况下,请点击 [获取License信息]。

6.6.2.4. 添加组资源(EXEC资源)¶

添加EXEC资源,用于通过脚本启动或者退出应用程序。

在[组资源列表]中点击[添加]。

打开[组的资源定义| failover1]画面。在[类型]框中选择组资源的类型(EXEC资源) ,在[名称]框内输入组资源名 (exec1)。点击[下一步]。

显示设置依存关系的画面。无需指定任何内容,点击[下一步]按钮。

显示[检测到组资源的启动异常时的流程],[检测到组资源的停止异常时的流程]。点击[下一步]。

- 选中[用Cluster WebUI创建的脚本]。用户编辑该脚本,描述业务应用程序的启动以及停止步骤。如果已经确定EXPRESSCLUSTER中使用的应用程序,在此编辑脚本。点击[完成]。failover1的[组资源列表]视图如下。

点击[完成]。

6.6.2.5. 添加失效切换组(业务用2)¶

下面对发生故障时进行失效切换的单位,组进行设置。

在[组列表]中点击[添加]。

打开[定义组]画面。在[名称]对话框中输入组名(failover2),点击[下一步]。

设置可启动失效切换组的服务器。在本章的设置示例中,取消[所有服务器都可以进行失效切换]复选框,从[可以使用的服务器]列表中选择[server2],点击[添加]。则[server2]添加到[可以启动组的服务器]。同样添加[server3],点击[下一步]。

- 设置失效切换组的各属性值。本章的设置示例中都使用默认值,因此直接点击[下一步]。显示[组资源]。

6.6.2.6. 添加组资源(浮动IP资源)¶

在步骤 "6.6.2.6. 添加组资源(浮动IP资源)" 中创建的失效切换组添加组的构成要素,即组资源。

[组资源列表],点击[添加]。

打开[组的资源定义| failover2]画面。在[类型]框中选择组资源的类型 (浮动IP资源),在[名称]框内输入组资源名 (fIP2)。点击[下一步]。

显示设置依存关系的画面。不需要指定任何内容,直接点击[下一步]。

显示[检测到组资源的启动异常时的流程],[检测到组资源的停止异常时的流程]。点击[下一步]。

在[IP地址]框中输入IP地址(10.0.0.13),点击[完成]。

6.6.2.7. 添加组资源(镜像磁盘资源)¶

在[组资源列表]中点击[添加]。

打开[组的资源定义| failover2]画面。在[类型]框中选择组资源的类型(镜像磁盘资源),在[名称]框内输入组资源名 (md2)。点击[下一步]。

显示设置依存关系的画面。不需要指定任何内容,直接点击[下一步]。

显示[检测到组资源的启动异常时的流程],[检测到组资源的停止异常时的流程]。点击[下一步]。

在[镜像分区设备名]框中选择镜像分区设备名(/dev/NMP2)。分别在相应的框中输入挂载点(/mnt/md2),数据分区设备名 (/dev/sdb2),集群分区设备名(/dev/sdb1)。在[文件系统]框中选择文件系统(ext3)。

点击[镜像磁盘连接]的[选择]。选择[顺序]的[1],点击[删除]。确认[镜像磁盘连接列表]中只有[顺序] [2]被选择,点击[OK]。

选择[组的资源定义| failover2]]对话框的[server3]标签页,选中[个别设置]复选框。分别重新输入数据分区设备名(/dev/sdc2),集群分区设备名(/dev/sdc1)。

点击[完成]。

注解

[类型]框中不显示(镜像磁盘资源)时,在确认已注册EXPRESSCLUSTER X Replicator License的情况下,请点击 [获取License信息]。

6.6.2.8. 添加组资源(EXEC资源)¶

添加EXEC资源,用于通过脚本启动或者退出应用程序。

在[组资源列表]中点击[添加]。

显示[组的资源定义| failover2]画面。在[类型]框中选择组资源的类型(EXEC资源) ,在[名称]框内输入组资源名 (exec2)。点击[下一步]。

显示设置依存关系的画面。不需要指定任何内容,直接点击[下一步]。

- 选中[该产品创建的脚本]。用户编辑该脚本,描述业务应用程序的启动以及停止步骤。如果已经确定EXPRESSCLUSTER中使用的应用程序,在此编辑脚本。点击[下一步]。

- 显示[检测到组资源的启动异常时的流程],[检测到组资源的停止异常时的流程]。点击[完成]。如果集群环境是镜像磁盘型,则failover2的[组资源列表]视图如下。

点击[完成]。

6.6.3. 添加监视资源¶

在集群中添加监视资源,用于监视指定的对象。

6.6.3.1. 添加监视资源(磁盘监视)¶

添加用于监视磁盘的监视资源。该例中添加磁盘监视。

在[组]中点击[下一步]。

显示[监视资源列表]。点击[添加]。

- 打开[监视资源定义]对话框。定义集群名时,默认创建第1个监视资源。第7至第10个监视资源,在添加镜像磁盘资源时默认创建。在[类型]框中选择监视资源的类型 (磁盘监视),在[名称]框内输入监视资源名 (diskw1)。点击[下一步]。

输入监视设置。此处保持默认设置,点击[下一步]。

输入监视方法(READ(O_DIRECT)),监视目标(/dev/sdb1)。点击[下一步]。

设置复归对象。点击[浏览]。

在显示的树形图中选择[LocalServer],点击[OK]。[复归对象]设为[LocalServer]。

在[最终动作]框内选择[停止集群服务并关闭OS],点击[完成]。

6.6.3.2. 添加监视资源(磁盘监视)¶

添加用于监视磁盘的监视资源。该例中添加磁盘监视。

[监视资源列表]中点击[添加]。

打开[监视资源定义]对话框。在[类型]框中选择监视资源的类型 (磁盘监视),在[名称]框内输入监视资源名 (diskw2)。点击[下一步]。

输入监视设置。点击[Server]。

启动[选择]下拉菜单。选择[能够使用的服务器]的[server3],点击[添加]。确认[server3]被添加到[可以启动组的服务器],点击[确定]。

在[监视资源定义]画面中,点击[下一步]。

输入监视方法(READ(O_DIRECT)),监视目标(/dev/sdc1),点击[下一步]。

设置复归对象。点击[浏览]。

在显示的树形图中选择[LocalServer],点击[OK]。在[复归对象]中设置[LocalServer]。

在[最终动作]框内选择[停止集群服务并关闭OS],点击[完成]。

6.6.3.3. 添加监视资源(IP监视)¶

在[监视资源列表]中点击[添加]。

打开[监视资源定义]对话框。在[类型]框中选择监视资源的类型(IP监视) ,在[名称]框内输入监视资源名(ipw1) 。点击[下一步]。

输入监视设置。此处保持默认值,点击[下一步]。

- 点击[添加]。在[IP 地址]框内输入监视IP 地址(10.0.0.254),点击[确定]。

注解

ip 监视资源的监视对象需指定在公网上以常时运行为前提的机器(如:网关)的IP地址。

输入的IP 地址设置在[IP 地址列表]中。点击[下一步]。

设置复归对象。点击[参照]。

在显示的树形视图中选择[All Groups],点击[确定]。复归对象设置为[All Groups]。

- 点击[完成]。[监视资源列表]视图如下。

6.7. 确认3节点集群(共享型镜像方式)环境的设置值¶

6.7.1. 集群环境示例¶

本章以下图所示3节点共享型镜像方式的集群环境配置为例进行说明。

图 6.7 3节点集群的示例(共享型镜像)¶

FIP1: 从Cluster WebUI客户端访问

FIP2: 从业务客户端访问

下表是构建上述集群系统时的集群配置信息示例。后文将按照这些条件分步说明创建集群配置信息的步骤。实际设置值时,请使用要构建的集群的配置信息代替文中设置内容。关于值的确定方法,请参阅《参考指南》。

3节点的配置设置示例

设置对象 |

设置参数 |

设置值 |

|---|---|---|

集群配置 |

集群名 |

cluster |

服务器数 |

3 |

|

失效切换组数 |

2 |

|

服务器组数 |

2 |

|

监视资源数 |

6 |

|

服务器死机通知 |

关闭(不使用) |

|

心跳资源 |

内核模式LAN心跳数 |

2 |

磁盘心跳数 |

1 |

|

第1台服务器的信息

(主服务器)

|

服务器名 |

server1 |

私网的IP地址

(专用)

|

192.168.0.1

|

|

私网的IP地址

(备份)

|

10.0.0.1

|

|

共网的IP地址 |

10.0.0.1 |

|

磁盘心跳设备 |

/dev/sdb3 |

|

磁盘心跳raw设备 |

/dev/raw/raw1 |

|

镜像磁盘连接 |

192.168.0.1 |

|

第2台服务器的信息 |

服务器名 |

server2 |

私网的IP地址

(专用)

|

192.168.0.2

|

|

私网的IP地址

(备份)

|

10.0.0.2

|

|

共网的IP地址 |

10.0.0.2 |

|

磁盘心跳设备 |

/dev/sdb3 |

|

磁盘心跳raw设备 |

/dev/raw/raw1 |

|

镜像磁盘连接 |

192.168.0.2 |

|

第3台服务器的信息 |

服务器名 |

server3 |

私网的IP地址

(专用)

|

192.168.0.3

|

|

私网的IP地址

(备份)

|

10.0.0.3

|

|

共网的IP地址 |

10.0.0.3 |

|

磁盘心跳设备 |

不设置 |

|

磁盘心跳raw设备 |

不设置 |

|

镜像磁盘连接 |

192.168.0.3 |

|

第1个服务器组 |

服务器组名 |

svg1 |

所属服务器

|

server1

server2

|

|

第2个服务器组 |

服务器组名 |

svg2 |

所属服务器

|

server3

|

|

用于管理的组

(Cluster WebUI用)

|

类型 |

失效切换 |

组名 |

ManagementGroup |

|

启动服务器 |

所有服务器 |

|

组资源数 |

1 |

|

用于管理的组的组资源 |

类型 |

浮动IP资源 |

组资源名 |

ManagementIP |

|

IP地址 |

10.0.0.11 |

|

用于业务的组 |

类型 |

失效切换 |

组名 |

failover1 |

|

启动服务器 |

server1 -> server2 -> server3 |

|

服务器组 |

svq1-> svq2 |

|

组资源数 |

3 |

|

第1个组资源 |

类型 |

浮动IP资源 |

组资源名 |

fip1 |

|

IP地址 |

10.0.0.12 |

|

第2个组资源

(Shared disk for hybrid resource

Disk for hybrid resource)

|

类型 |

共享型镜像磁盘资源 |

组资源名 |

hd1 |

|

镜像分区设备名 |

/dev/NMP1 |

|

Mount点 |

/mnt/hd1 |

|

数据分区设备名 |

/dev/sdb2 |

|

集群分区设备名 |

/dev/sdb1 |

|

文件系统 |

ext3 |

|

镜像磁盘连接 |

mdc1 |

|

第3个组资源 |

类型 |

EXEC资源 |

组资源名 |

exec1 |

|

脚本 |

标准脚本 |

|

第1个监视资源

(默认创建)

|

种类 |

usew |

监视资源名 |

userw |

|

第2个监视资源 |

种类 |

diskw |

监视资源名 |

diskw1 |

|

监视对象 |

/dev/sdb2 |

|

监视方法 |

READ(O_DIRECT) |

|

查出异常时 |

集群服务停止, OS关机 |

|

第3个监视资源

(创建ManagementIP资源后自动创建)

|

种类 |

浮动IP监视 |

监视资源名 |

fipw1 |

|

监视对象 |

ManagementIP |

|

查出异常时 |

"ManagementGroup" 组的失效切换 |

|

第4个监视资源

(创建fip1资源后自动创建)

|

种类 |

浮动IP监视 |

监视资源名 |

fipw2 |

|

监视对象 |

fip1 |

|

查出异常时 |

"failover1" 组的失效切换 |

|

第5个监视资源 |

种类 |

IP监视 |

监视资源名 |

ipw1 |

|

监视IP地址

|

10.0.0.254

(网关)

|

|

查出异常时 |

全组的失效切换 |

|

第6个监视资源

(创建共享型镜像磁盘资源后自动创建)

|

种类 |

共享型镜像磁盘连接监视 |

监视资源名 |

hdnw1 |

|

监视共享型镜像磁盘资源 |

hd1 |

|

查出异常时 |

不执行任何操作 |

|

第7个监视资源

(创建共享型镜像磁盘资源后自动创建)

|

种类 |

共享型镜像磁盘监视 |

监视资源名 |

hdw1 |

|

监视镜像磁盘资源 |

hd1 |

|

查出异常时 |

不执行任何操作 |

6.8. 创建3节点集群(共享型镜像方式)配置信息的步骤¶

要创建集群配置信息,基本上需要按照创建集群,创建服务器组,创建组,创建监视资源,更改集群属性这5步来执行操作。以下具体说明各操作步骤。

注解

集群配置信息的操作可反复多次执行。另外,大部分设置完成的内容之后可通过改名功能或属性显示功能进行更改。

-

生成集群,添加服务器。

-

创建执行失效切换时的单位,即失效切换组。

"6.8.2.2. 添加组资源(浮动IP 资源)": 添加组的构成资源。

"6.8.2.3. 添加组资源(共享型镜像磁盘资源)": 添加组的构成资源。

"6.8.2.4. 添加组资源(EXEC资源)": 添加组的构成资源。

-

在集群内添加用于监视指定的监视对象的监视资源。

"6.8.3.1. 添加监视资源(磁盘监视)": 添加使用的监视资源。

"6.8.3.2. 添加监视资源(IP监视)": 添加使用的监视资源。

-

使集群动作有效或无效。

-

将设置更改为不通知服务器死机状态。

6.8.1. 创建集群¶

首先创建集群。在创建的集群内添加构成集群的服务器,设置优先级和心跳的优先级。

6.8.1.1. 添加集群¶

点击Cluster WebUI编辑模式中的 [集群生成向导] ,显示[集群生成向导]对话框。在[语言]域中选择使用Cluster WebUI的机器的OS所使用的语言。

注解

1个集群内可使用的语言只有1个。如果在集群内使用多种语言的OS,为了防止出现乱码,请指定为"English"。

在[集群名]框内输入集群名 (cluster)。

- 将用于Cluster WebUI 连接的浮动IP地址 (10.0.0.11) 输入[管理IP地址] 框内。点击[下一步]。显示[服务器]的[基本设定]。Cluster WebUI启动时通过URL指定的IP地址的服务器 (server1)已登录在列表中。

6.8.1.2. 添加服务器¶

添加构成集群的第2台以后的服务器。

在[服务器的定义列表]中点击[添加]。

打开[添加服务器]对话框。输入第2台服务器的服务器名,FQDN名或IP地址,点击 [确定]。第2台服务器(server2 )将添加入[服务器的定义列表] 。

以相同步骤添加第3台服务器(server3)。

使用共享型磁盘时,点击[设置],创建两个服务器组(svg1和svg2),在[svg1]中添加[server1]和[server2],在[svg2]中添加[server3]。

点击[下一步]。

6.8.1.3. 创建服务器组¶

共享型磁盘配置下,在创建共享型磁盘资源前,以要生成镜像的各磁盘为单位,创建连接到磁盘的服务器组。

点击[设定服务器组]的[设置]。

在[服务器组定义列表]中点击[添加]。

打开[设定服务器组]对话框。在[名称]框中输入服务器组名(svg1)。

- 点击[可以使用的服务器]的[server1],点击[添加]。[server1]添加到[可以启动组的服务器]中。用同样的方法添加[server2]。

点击[确定]。[服务器组定义列表]中显示[svg1]。

点击[添加]打开[设定服务器组]对话框,在[名前]框中输入服务器组名(svg2)。

点击[可以使用的服务器]的[server3],点击[添加]。[server3]添加到[可以启动组的服务器]中。

点击[确定]。[服务器组定义列表]中显示[svg1]和[svg2]。

点击[关闭]。

点击[下一步]。

6.8.1.4. 设置网络配置¶

设置构筑集群的服务器间的网络配置。

请通过 [添加][删除]添加或删除通信路径,并点击各服务器列表的单元格选择或输入IP地址。如通信路径有部分服务器未连接,请保持未连接的服务器的单元格为空白。

- 用于接收或发送心跳信息的通信路径(私网)请点击 [种类] 列表的单元格并选择 [内核模式]。不用于心跳,而用于镜像磁盘资源或共享型磁盘资源的数据镜像通信时,请选择[镜像通信专用]。必须将一个或一个以上的通信路径设置为私网。尽量将全部通信路径设置为私网。此外,如设有多个私网, [优先级]列表中编号较小的通信路径将优先用于集群服务器间的内部通信。如需更改优先级,请点击箭头更改通信路径的排列顺序。

使用Witness心跳时,点击 [种类]列表的单元格并选择 [Witness]。点击 [属性]按钮,在[对象主机] 中输入Witness 服务器的服务器地址,在 [服务端口]中输入端口号。不使用Witness 心跳的服务器时,请点击该服务器单元,选择[不使用]。

设定用于镜像磁盘资源或共享型镜像磁盘资源的数据镜像通信使用的路径对应的镜像磁盘连接名。请点击[MDC] 列表的单元格从mdc1~mdc16中分配。对于不用于数据镜像通信的路径请指定[不使用] 。

点击[下一步]。

6.8.1.5. 设置网络分区解决处理¶

设置网络分区解决资源。

- 如进行PING方式的NP解决,点击[添加]在[NP解决一览]中添加行,点击[种类]列的单元格,选择[Ping],点击[Ping目标]列的单元格,然后点击各服务器的单元格,输入ping发送的目标机器(网关等)的IP地址。输入以逗号隔开的多个IP地址后,如这些地址全部没有ping响应,则可判断为孤立于网络的状态。若只有部分服务器使用PING方法,则请将不使用的服务器的单元格设为[不使用]。需要更改ping相关参数的默认值时,请选择 [属性]后通过 [Ping NP的属性]对话框进行设置。在本章的设置示例中,添加一个PING方式的行,[Ping目标] 设为192.168.0.254。

- 进行HTTP 方式的NP 解决时,点击 [添加]后在[NP 解决一览]里添加一行,点击 [种类]列的单元格,选择[HTTP/HTTPS]。 点击[属性] 按钮,在 [对象主机] 中输入Web 服务器的服务器地址,在 [服务端口]中输入端口号。只有一部分的服务器使用HTTP 方式时,不使用的服务器的单元格请选择[不使用]。在本章的设置示例中,不使用HTTP方式。

- 选择[调整],设置检查出网络分区时的动作。选择[停止集群服务和关闭OS]或[停止集群服务],点击[确定]。在本章的设置示例中选择[停止集群服务]。

点击[下一步]。

6.8.2. 创建失效切换组¶

在集群中添加运行业务应用程序的失效切换组(以下有时简称"组")。

6.8.2.1. 添加失效切换组¶

设置发生故障时作为进行失效切换单位的组。

在[组列表]中点击[添加]。

打开[组定义]界面。

本章的设置示例中,使用共享型磁盘时,将[使用服务器组设置]设为有效。在[名称]框内输入组名 (failover1),点击[下一步]。从[可使用的服务器组]列表按照[svg1],[svg2]的顺序添加到[可启动得服务器与服务器组]中。

- 设置失效切换组的各属性值。在本章的设置示例中,由于全部使用了默认值,因此直接点击[下一步]。显示[组资源]。

6.8.2.2. 添加组资源(浮动IP 资源)¶

在步骤"6.8.2.1. 添加失效切换组" 中创建的失效切换组添加组的构成要素,即组资源。

在[组资源列表]中点击[添加]。

打开[组的资源定义列表| failover1]界面。在[类型]框中选择组资源的类型(浮动IP资源) ,在[名称]框内输入组资源名 (fip1) 。点击[下一步]。

显示设置依存关系的画面。无需指定任何内容,点击[下一步]按钮。

显示[检测到组资源的启动异常时的流程],[检测到组资源的停止异常时的流程]。点击[下一步]。

在[IP 地址]框内输入IP 地址 (10.0.0.12),点击[完成]。

6.8.2.3. 添加组资源(共享型镜像磁盘资源)¶

在[组资源列表]中点击[添加]。

打开[组的资源定义列表| failover1]对话框。在[类型]框中选择组资源的类型(共享型镜像磁盘资源),在[名称]框内输入组资源名 (hd1)。点击[下一步]。

显示设置依存关系的画面。无需指定任何内容,点击[下一步]按钮。

显示[检测到组资源的启动异常时的流程],[检测到组资源的停止异常时的流程]。点击[下一步]。

在[镜像分区设备名]框内选择镜像分区设备名 (/dev/NMP1)。在对应的输入框内分别输入Mount点 (/mnt/hd1),数据分区设备名 (/dev/sdb2),集群分区设备名 (/dev/sdb1),磁盘设备名 (/dev/sdb)。在[文件系统]框内选择文件系统(ext3)。点击[完成]。

注解

[类型]框中不显示(共享型镜像磁盘资源)时,在确认已注册EXPRESSCLUSTER X Replicator DR License的情况下,请点击[获取License信息]。

6.8.2.4. 添加组资源(EXEC资源)¶

根据不同脚本启动或者退出应用程序,添加EXEC资源。

在[组资源列表]中点击[添加]。

打开[组的资源定义列表| failover1]对话框。在[类型]框中选择组资源的类型(EXEC资源) ,在[名称]框内输入组资源名 (exec1)。点击[下一步]。

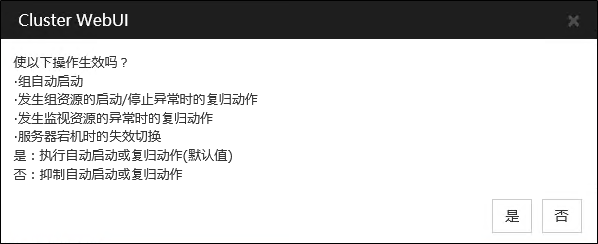

显示设置依存关系的画面。无需指定任何内容,点击[下一步]按钮。