1. はじめに¶

1.1. 対象読者と目的¶

『CLUSTERPRO X インストール&設定ガイド』は、CLUSTERPROを使用したクラスタシステムの導入を行うシステムエンジニアと、クラスタシステム導入後の保守・運用を行うシステム管理者を対象読者とし、CLUSTERPROを使用したクラスタシステム導入から運用開始前までに必須の事項について説明します。

実際にクラスタシステムを導入する際の順番に則して、CLUSTERPROを使用したクラスタシステムの設計方法、CLUSTERPROのインストールと設定手順、運用開始前に必要な評価手順について説明していきます。

1.2. 本書の構成¶

「2. システム構成を決定する」:動作環境の確認や設定について説明します。

「3. クラスタシステムを設計する」:クラスタシステムの設計方法について説明します。

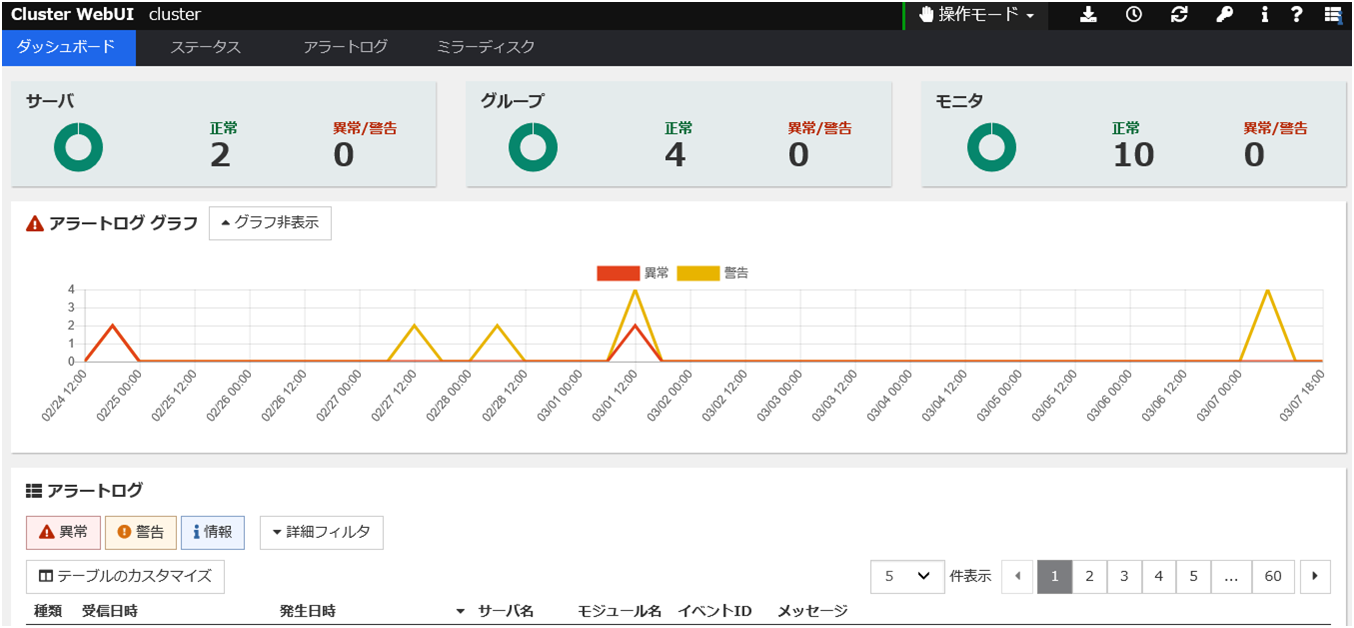

「4. CLUSTERPRO をインストールする」:CLUSTERPRO をインストールする手順について説明します。

「5. ライセンスを登録する」:ライセンスの登録方法について説明します。

「6. クラスタ構成情報を作成する」:Cluster WebUI を使用して、クラスタ構成情報を作成する手順について説明します。

「7. クラスタシステムを確認する」:作成したクラスタシステムが正常に動作するかを確認します。

「8. クラスタ構成情報を変更する」:クラスタ構成を変更する手順について説明します。

「10. 運用開始前の準備を行う」:本番運用を開始する際の注意事項について説明します。

「11. CLUSTERPRO をアンインストール/再インストールする」:アンインストール、再インストール情報について説明します。

「12. トラブルシューティング」:インストールや設定関連のトラブルとその解決策について説明します。

1.3. CLUSTERPRO マニュアル体系¶

CLUSTERPRO のマニュアルは、以下の 6 つに分類されます。各ガイドのタイトルと役割を以下に示します。

『CLUSTERPRO X スタートアップガイド』 (Getting Started Guide)

すべてのユーザを対象読者とし、製品概要、動作環境、アップデート情報、既知の問題などについて記載します。

『CLUSTERPRO X インストール&設定ガイド』 (Install and Configuration Guide)

CLUSTERPRO を使用したクラスタシステムの導入を行うシステムエンジニアと、クラスタシステム導入後の保守・運用を行うシステム管理者を対象読者とし、CLUSTERPRO を使用したクラスタシステム導入から運用開始前までに必須の事項について説明します。実際にクラスタシステムを導入する際の順番に則して、CLUSTERPRO を使用したクラスタシステムの設計方法、CLUSTERPRO のインストールと設定手順、設定後の確認、運用開始前の評価方法について説明します。

『CLUSTERPRO X リファレンスガイド』 (Reference Guide)

管理者、および CLUSTERPRO を使用したクラスタシステムの導入を行うシステムエンジニアを対象とし、CLUSTERPRO の運用手順、各モジュールの機能説明およびトラブルシューティング情報等を記載します。『CLUSTERPRO X インストール&設定ガイド』を補完する役割を持ちます。

『CLUSTERPRO X メンテナンスガイド』 (Maintenance Guide)

管理者、および CLUSTERPRO を使用したクラスタシステム導入後の保守・運用を行うシステム管理者を対象読者とし、CLUSTERPRO のメンテナンス関連情報を記載します。

『CLUSTERPRO X ハードウェア連携ガイド』 (Hardware Feature Guide)

管理者、および CLUSTERPRO を使用したクラスタシステムの導入を行うシステムエンジニアを対象読者とし、特定ハードウェアと連携する機能について記載します。『CLUSTERPRO X インストール&設定ガイド』を補完する役割を持ちます。

『CLUSTERPRO X 互換機能ガイド』 (Legacy Feature Guide)

管理者、および CLUSTERPRO を使用したクラスタシステムの導入を行うシステムエンジニアを対象読者とし、CLUSTERPRO X 4.0 WebManager および Builder に関する情報について記載します。

1.4. 本書の表記規則¶

本書では、注意すべき事項、重要な事項および関連情報を以下のように表記します。

注釈

この表記は、重要ではあるがデータ損失やシステムおよび機器の損傷には関連しない情報を表します。

重要

この表記は、データ損失やシステムおよび機器の損傷を回避するために必要な情報を表します。

参考

この表記は、参照先の情報の場所を表します。

また、本書では以下の表記法を使用します。

表記 |

使用方法 |

例 |

|---|---|---|

[ ] 角かっこ |

コマンド名の前後

画面に表示される語 (ダイアログボックス、メニューなど) の前後

|

[スタート] をクリックします。

[プロパティ] ダイアログボックス

|

コマンドライン中の [ ] 角かっこ |

かっこ内の値の指定が省略可能であることを示します。 |

|

# |

Linux ユーザが、root でログインしていることを示すプロンプト |

|

モノスペースフォント |

パス名、コマンドライン、システムからの出力 (メッセージ、プロンプトなど)、ディレクトリ、ファイル名、関数、パラメータ |

|

太字 |

ユーザが実際にコマンドラインから入力する値を示します。 |

以下を入力します。

clpcl -s -a

|

|

ユーザが有効な値に置き換えて入力する項目 |

|

本書の図では、CLUSTERPROを表すために このアイコンを使用します。

本書の図では、CLUSTERPROを表すために このアイコンを使用します。

2. システム構成を決定する¶

本章では、CLUSTERPROを用いたクラスタシステムのシステム構成を決定する方法について説明します。

本章で説明する項目は以下の通りです。

2.1. クラスタシステム設計から運用開始前テストまでの流れ¶

クラスタシステムの設計

CLUSTERPRO のインストール前に必要な作業を行います。構築するクラスタシステムのハードウェア構成と設定内容を決定します。

ステップ1. 「 2. システム構成を決定する 」

ステップ2. 「 3. クラスタシステムを設計する 」

CLUSTERPRO のインストールと設定

CLUSTERPRO のインストールを実行します。サーバマシンへ CLUSTERPRO をインストールし、ステップ 1、ステップ 2 で作成した構成情報を用いてCluster WebUI で構成情報ファイルを作成し、クラスタシステムを構築します。その後、システムが正常に稼動するかどうかの動作確認を行います。

ステップ3. 「4. CLUSTERPRO をインストールする 」

ステップ4. 「5. ライセンスを登録する 」

ステップ5. 「6. クラスタ構成情報を作成する 」

ステップ6. 「7. クラスタシステムを確認する 」

ステップ7. 「8. クラスタ構成情報を変更する 」

クラスタシステム運用開始前の準備

CLUSTERPRO の運用を開始する前に必須の評価作業を行います。構築したシステムの動作チェックを行った後、運用開始前に必要な事項について確認します。最後に、アンインストールおよび再インストールの手順について説明します。

ステップ9. 「10. 運用開始前の準備を行う」

ステップ10. 「11. CLUSTERPRO をアンインストール/再インストールする」

参考

本ガイドの流れに従って操作を行うためには、本ガイドの手順に従いながら、随時『リファレンスガイド』を参照する必要があります。また、動作環境やリリース情報などの最新情報は、『スタートアップガイド』を参照してください。

2.2. CLUSTERPRO とは?¶

CLUSTERPRO とは、冗長化 (クラスタ化) したシステム構成により、現用系のサーバでの障害が発生した場合に、自動的に待機系のサーバで業務を引き継がせることで、飛躍的にシステムの可用性と拡張性を高めることを可能にするソフトウェアです。

図 2.1 クラスタシステム(正常動作時)¶

図 2.2 クラスタシステム(エラー発生時)¶

CLUSTERPRO を使用したクラスタシステムの導入により、次の効果を得られます。

- 高可用性クラスタを構成するサーバのうち一台が障害などにより停止しても、そのサーバが処理していた業務を他の健全なサーバへ自動的に引き継ぐことにより、障害時の業務停止時間を最小限に抑えます。

- 高拡張性最大 32 台までのパラレルデータベースをサポートすることにより、拡張性の高い高性能なデータベースプラットフォームを提供します。

参考

CLUSTERPRO の詳細については、『スタートアップガイド』の「クラスタシステムとは?」、「CLUSTERPRO の使用方法」を参照してください。

2.3. システム構成の検討¶

構築するクラスタの用途や運用形態を良く確認してから、ハードウェア構成を決定します。以下に CLUSTERPRO の構成例を記載します。

参考

動作環境やリリース情報などの最新情報は 『スタートアップガイド』で確認してください。

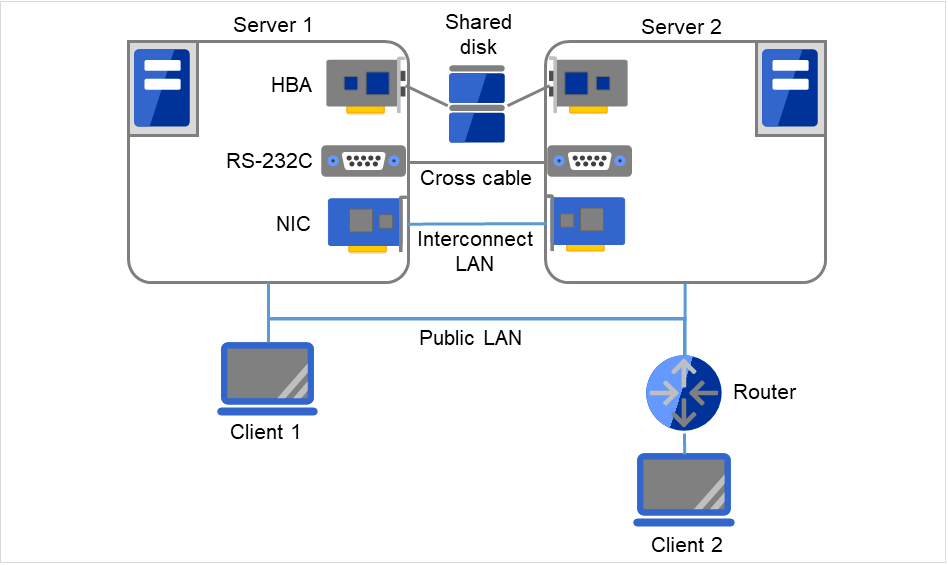

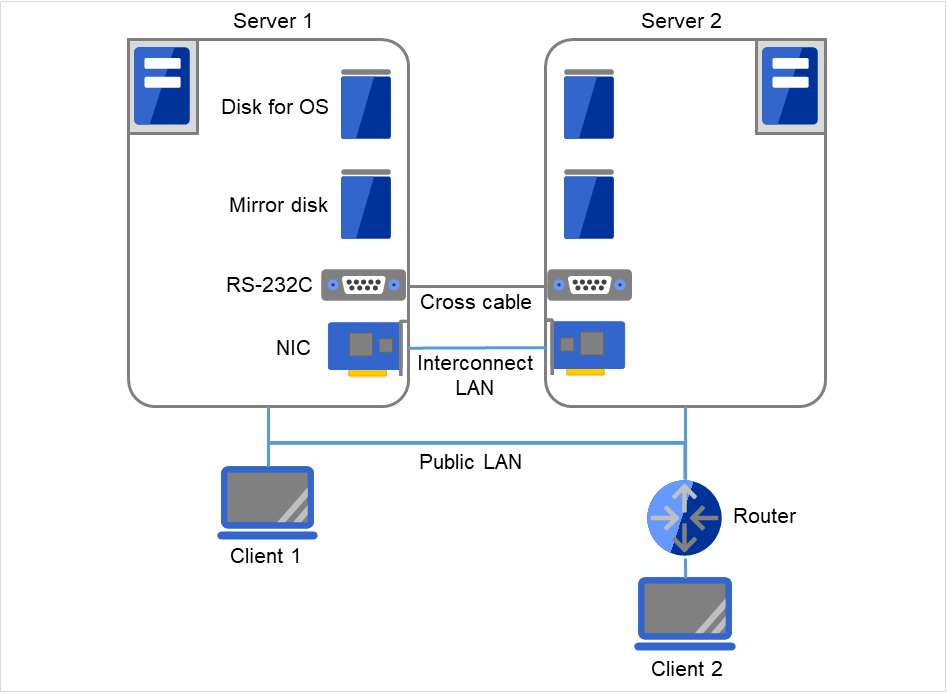

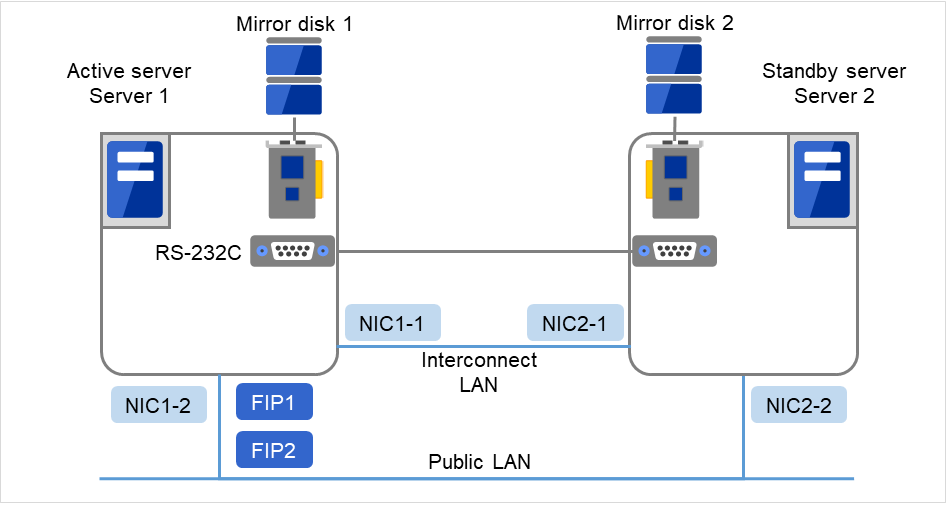

2.3.3. 2 ノードでミラー専用ディスクを使用する場合の構成例¶

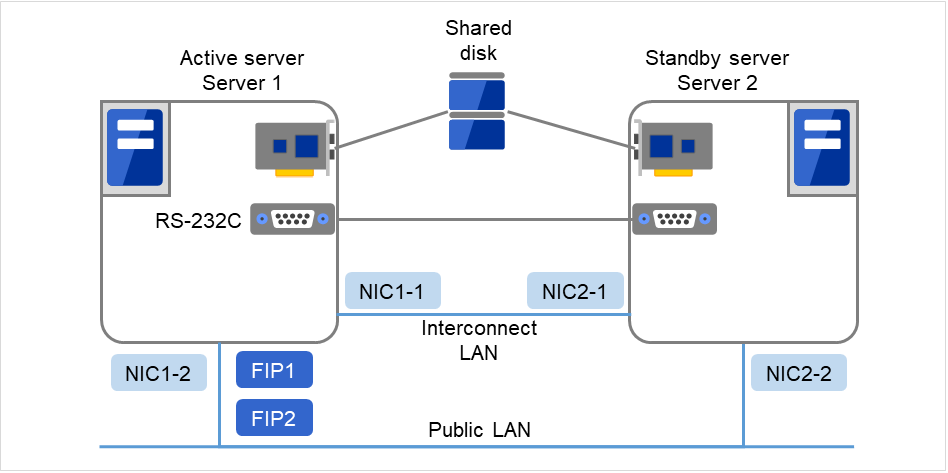

サーバは異機種でも構いませんが、同一アーキテクチャである必要があります。

インタコネクトを LAN ケーブルで接続します。ミラー用のインタコネクト (ミラーディスクコネクト) は LAN ケーブルで直結して、HUB などを経由しないようにしてください。

COM (RS-232C) ポートをクロスケーブルで接続します。

図 2.5 2 ノードでミラー専用ディスクを使用する場合の構成例¶

クラスタサーバと同一LAN上のクライアント(Client 1)は、フローティングIPを使用してクラスタサーバと接続できます。 リモートLAN上のクライアント(Client 2)も、フローティングIPを使用してクラスタサーバと接続できます。 フローティングIPを使用するために、ルータ(Router)に特別な設定をする必要はありません。

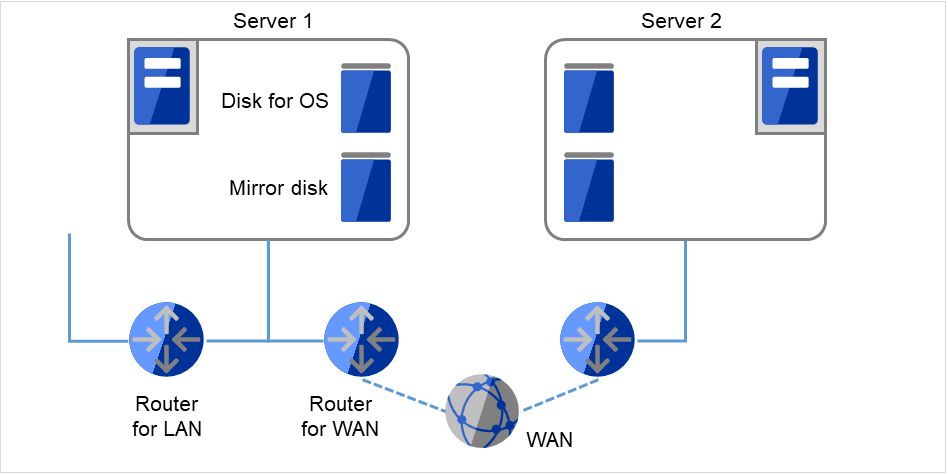

2.3.4. 2 ノードでミラー専用ディスクを使用する、LAN が 1 系統の場合の構成例¶

サーバは異機種でも構いませんが、同一アーキテクチャである必要があります。

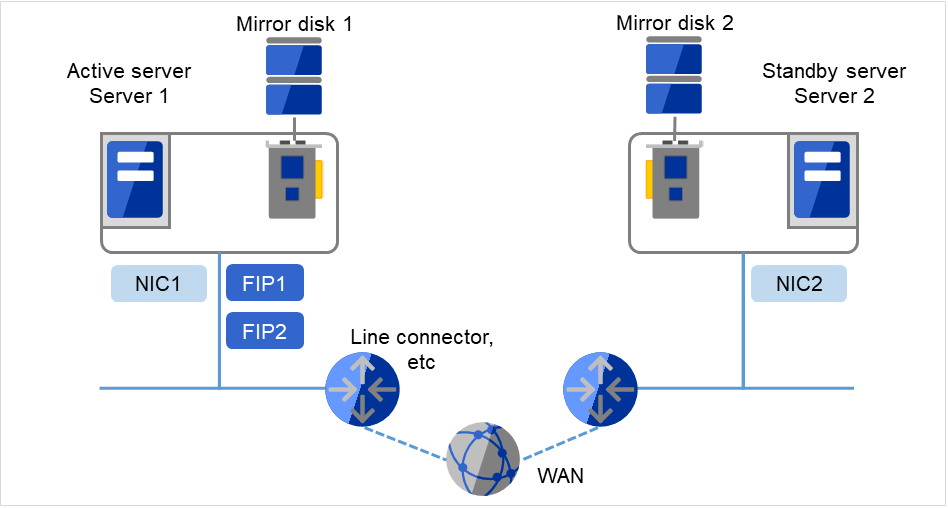

図 2.6 2 ノードでミラー専用ディスクを使用する、LAN が 1 系統の場合の構成例¶

WAN用ルータ、LAN用ルータなどをPing NP解決方式の監視先にします。 WANのスループットは業務におけるデータ更新に耐えうる速度である必要があります。 CLUSTERPROには回線速度をブーストする機能はありません。

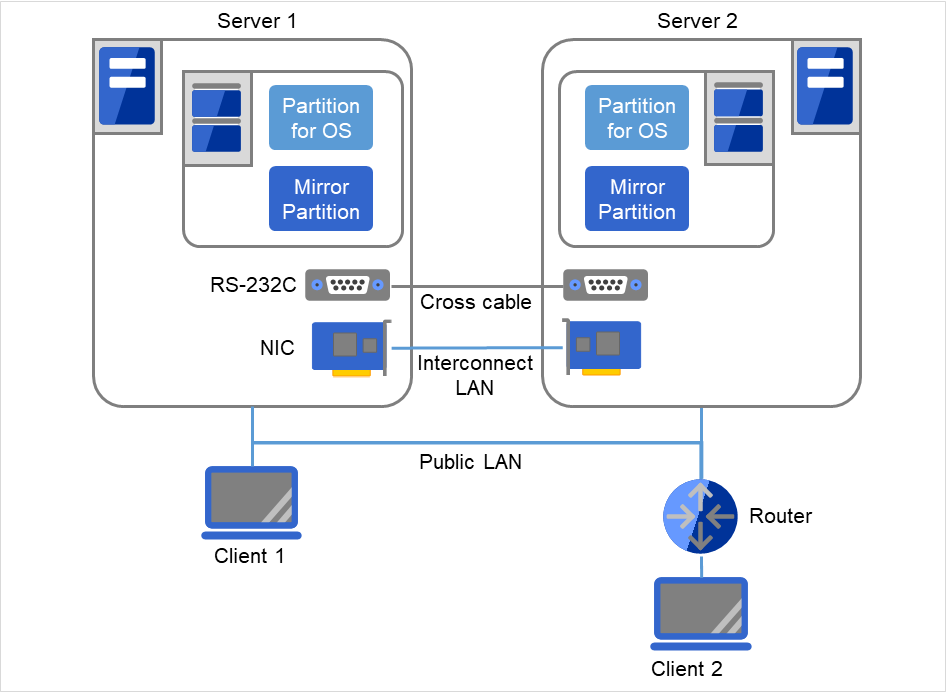

2.3.5. 2 ノードで OS 用ディスクにミラー領域を使用する場合の構成例¶

下図のようにミラー用のパーティションは、OS 用に使用しているディスクと同じディスクに確保することが可能です。

図 2.7 2 ノードで OS 用ディスクにミラー領域を使用する場合の構成例¶

クラスタサーバと同一LAN上のクライアント(Client 1)は、フローティングIPを使用してクラスタサーバと接続できます。 リモートLAN上のクライアント(Client 2)も、フローティングIPを使用してクラスタサーバと接続できます。 フローティングIPを使用するために、ルータ(Router)に特別な設定をする必要はありません。

参考

ミラー用パーティションの設定に関しては『リファレンスガイド』の「グループリソースの詳細」の「ミラーディスクリソースを理解する」を参照してください。

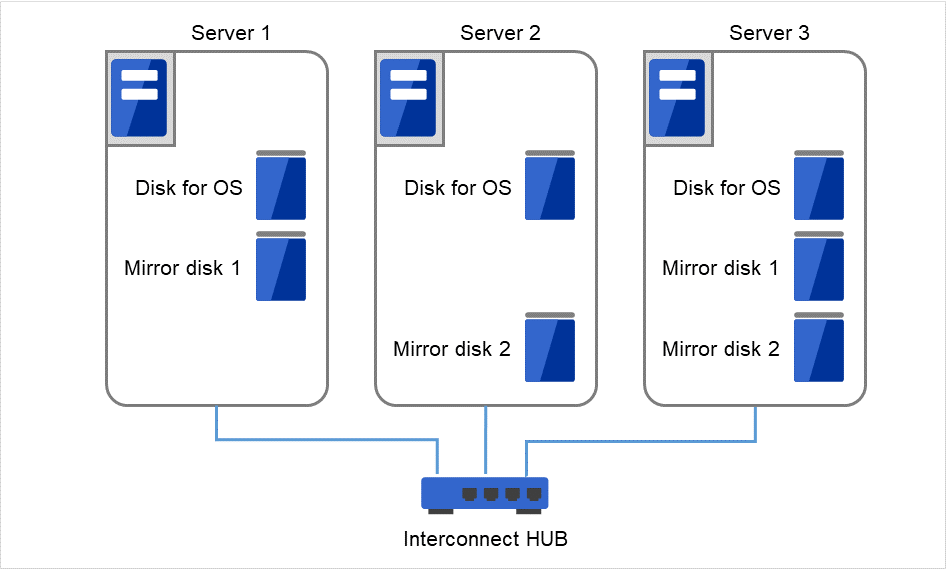

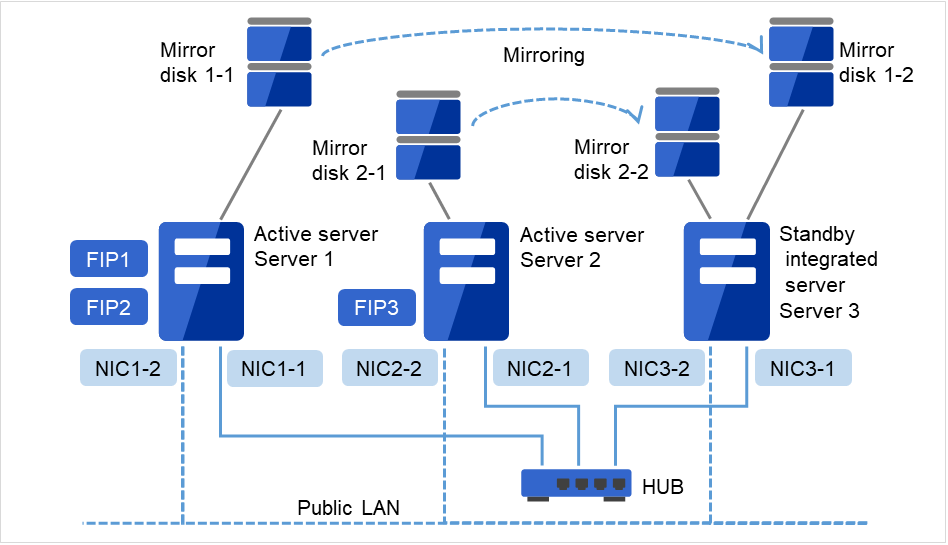

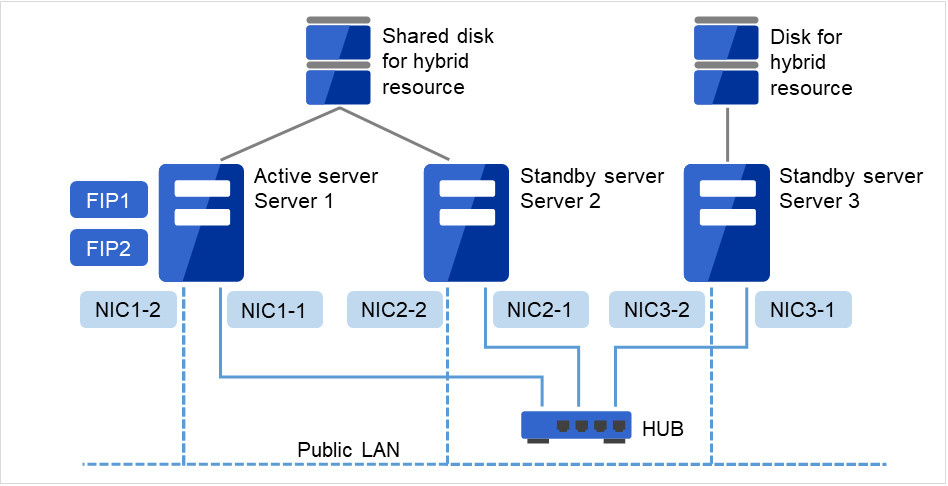

2.3.6. 3 ノードの構成例¶

3 ノードの場合、ミラーリソースが集約される待機系サーバ (下記の図では Server 3) に 2 つのミラーディスクを用意します。

インタコネクト兼ミラーディスクコネクトの LAN を専用 HUB (Interconnect HUB)経由で接続します。

HUB はできるだけ高速なものを使用してください。

RS-232C でサーバ間を接続する必要はありません。

図 2.8 3 ノードの構成例¶

インタコネクト LAN はインタコネクト用HUB(Interconnect HUB)に接続します。インタコネクト用HUBには他のサーバやクライアントは接続しません。

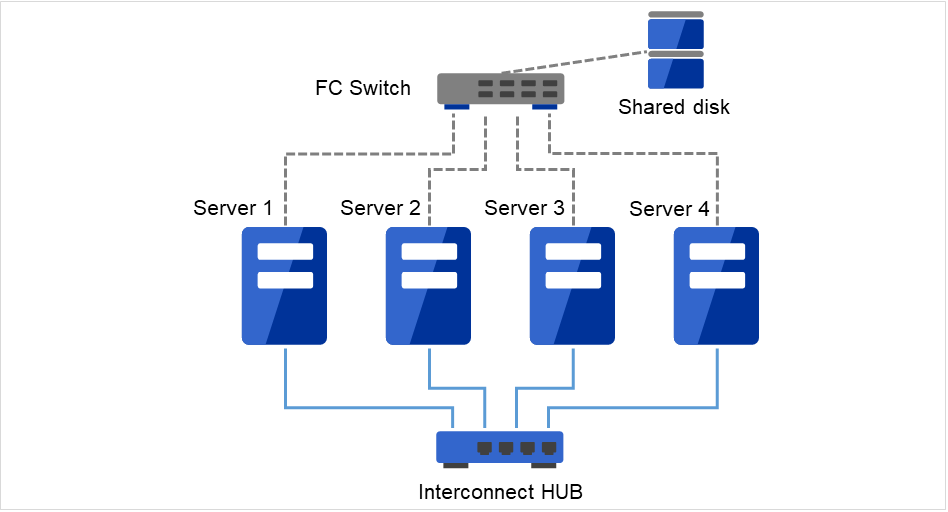

2.3.7. 4 ノードの構成例¶

2 ノードの場合と同様に共有ディスクを接続します。

インタコネクトを専用 HUB 経由で接続します。

RS-232C でサーバ間を接続する必要はありません。

図 2.9 4 ノードの構成例¶

インタコネクト LAN はインタコネクト用HUB(Interconnect HUB)に接続します。インタコネクト用HUBには他のサーバやクライアントは接続しません。

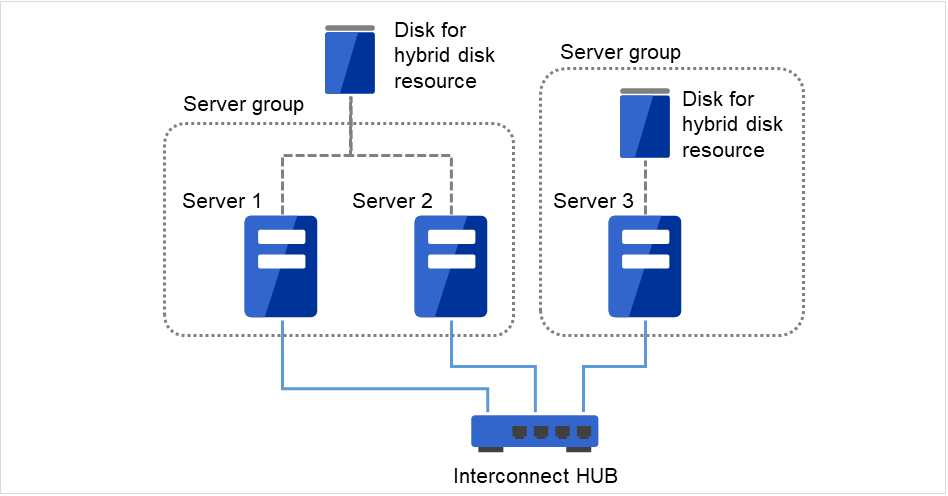

2.3.8. 3 ノードでハイブリッド方式を使用する場合の構成例¶

共有ディスクで接続された 2 ノード と ミラーリング対象のディスクを用意した1 ノードで構成される 3 ノードの構成例です。

サーバは異機種でも構いませんが、同一アーキテクチャである必要があります。

インタコネクト兼ミラーディスクコネクトの LAN を専用 HUB 経由で接続します。

HUB はできるだけ高速なものを使用してください。

図 2.10 3 ノードでハイブリッド方式を使用する場合の構成例¶

インタコネクト LAN はインタコネクト用HUB(Interconnect HUB)に接続します。インタコネクト用HUBには他のサーバやクライアントは接続しません。

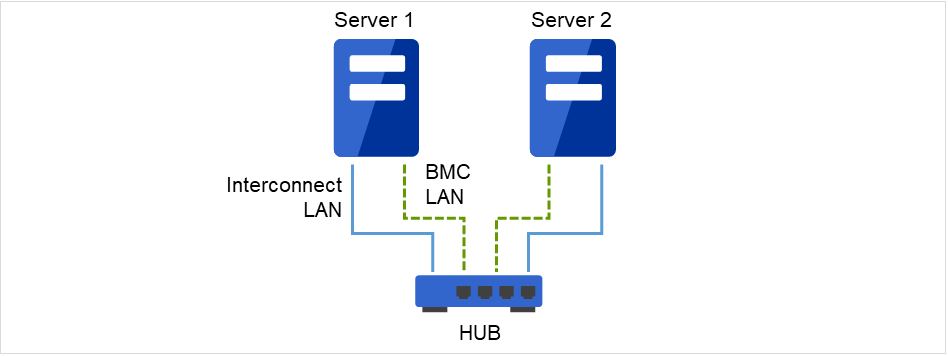

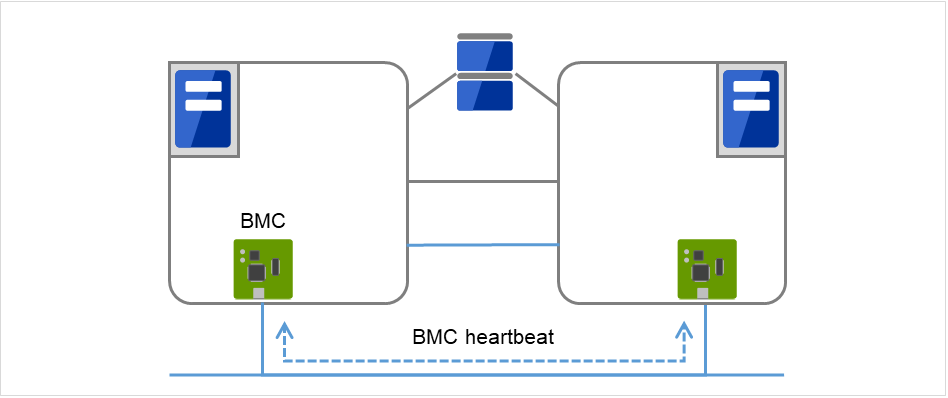

2.3.9. 2 ノードで BMC 関連機能を使用する場合の構成例¶

物理マシンの強制停止機能や筐体IDランプ連携機能、BMC ハートビートリソース、外部連携モニタの BMC 連携機能を利用する 2 ノードクラスタの構成例です。

サーバは異機種でも構いませんが、BMC 連携機能が利用可能である必要があります。

BMC ハートビートリソース以外の BMC 関連機能を利用する場合、インタコネクト LAN と BMC の管理用 LAN を専用 HUB 経由で接続します。

HUB はできるだけ高速なものを使用してください。

図 2.11 2 ノードで BMC 関連機能を使用する場合の構成例¶

インタコネクト LAN 、およびBMC LANをHUBに接続します。このHUBには他のサーバやクライアントは接続しません。

2.4. CLUSTERPRO モジュール別の動作環境を確認する¶

CLUSTERPRO X は、CLUSTERPRO Server (本体モジュール)、Cluster WebUIの 2 つで構成されています。各モジュールを使用するマシンごとに、動作環境を確認してください。動作環境については、『スタートアップガイド』の「CLUSTERPRO の動作環境」を参照してください。

2.5. CLUSTERPRO(本体モジュール)のハードウェア構成例¶

CLUSTERPRO の本体モジュールは、クラスタを構築する各サーバにインストールします。 Cluster WebUI は、 CLUSTERPRO 本体モジュールの一部です。CLUSTERPRO Server をインストールすると自動的にインストールされます。

2.5.1. CLUSTERPRO Server で推奨するスペック¶

CLUSTERPRO Server で推奨するスペックは下記の通りです。

RS-232C ポート 1 つ (3 ノード以上のクラスタを構築する場合は不要)

Ethernet ポート 2 つ以上

共有ディスク (ディスクリソース用またはハイブリッドディスクリソース用)

ミラーリング用ディスクまたは空きパーティション (ミラーディスクリソース用またはハイブリッドディスクリソース用)

CD-ROM ドライブ

参考

サポートされているハードウェアや OS の一覧など最新の動作環境情報については、『スタートアップガイド』を参照してください。

2.6. Cluster WebUI の動作環境を確認する¶

2.7. ハードウェア構成の決定¶

ハードウェア構成の決定は、クラスタシステム上で二重化するアプリケーションとクラスタシステムの設計を考慮して行う必要があります。次章の「3. クラスタシステムを設計する」を確認した後に行ってください。

2.8. ハードウェア構成後の設定¶

ハードウェア構成を決定し、実際にハードウェアの設置を行った後に、以下を確認してください。

2.8.2. ハイブリッドディスクリソース用の共有ディスクを設定する (Replicator DR 使用時は必須)¶

注釈

共有ディスク上のデータを引き続き使用する場合 (サーバの再インストール時など) は、パーティションの確保やファイルシステムの作成は行わないでください。パーティションの確保やファイルシステムの作成を行うと共有ディスク上のデータは削除されます。

- cluster パーティションの確保ミラードライバが独自に使用するパーティションを作成します。このパーティションはミラードライバやミラーエージェントがハイブリッドディスクの状態を管理するために使用します。パーティションは、共有ディスクを使用するクラスタ内のサーバのうちの 1 台のサーバにて作成します。fdisk コマンドを使用し、パーティションを確保します。

注釈

CLUSTER パーティションは 1024MiB 以上確保してください。(1024MB ちょうどを指定しても、ディスクのジオメトリの違いにより実際には 1024MB より大きなサイズが確保されますが、問題ありません)。また、CLUSTER パーティションにはファイルシステムを構築しないでください。

- CLUSTER パーティションの初期化(過去に CLUSTERPRO のミラーディスクやハイブリッドディスクとして使用していた共有ディスクを流用する場合にのみ必要)

CLUSTER パーティションに以前のデータが残っているため初期化が必要です。

パーティションを再確保してもパーティション上のデータは残っていますので、CLUSTERPRO のミラーディスクやハイブリッドディスクとして使用したことのあるディスクを再利用する場合には必ず実行してください。

共有ディスクを使用するクラスタ内のサーバのうちの 1 台のサーバから以下のコマンドを実行します。

dd if=/dev/zero of=<CLUSTERパーティションとして使用するパーティションデバイス名>

注釈

ddコマンドを実行するとof=で指定したパーティションのデータは初期化されます。パーティションデバイス名を十分に確認してからddコマンドを実行してください。

注釈

dd コマンドを実行したときに以下のメッセージが表示されますが、異常ではありません。

dd: writing to <CLUSTERパーティションとして使用するパーティションデバイス名>: No space left on device

- ハイブリッドディスクリソース用パーティションの確保共有ディスク上にハイブリッドディスクリソースで使用するパーティションを作成します。その共有ディスクを使用するクラスタ内のサーバのうちの 1 台のサーバにて作成します。fdisk コマンドを使用し、パーティションを確保します。

- ファイルシステムの作成についてハイブリッドディスクリソース用のパーティションに対してファイルシステムの作成が必要です。

複数台のサーバがあるグループリソース (共有ディスクでハイブリッドディスクリソース) を使用する場合、グループリソース内のいずれか 1 台のサーバでファイルシステムを作成してください

ハイブリッドディスクリソースはファイルシステムについて基本的に依存をしていませんが、ファイルシステムの fsck の仕様により問題が発生することがあります。

システムの対障害性の向上のために、ジャーナル機能を持つファイルシステムを使用することを推奨します。

現在動作確認を完了しているファイルシステムは下記の通りです。

ext2

ext3

ext4

xfs

reiserfs

jfs

ファイルシステムを作成せず、ダイレクトにパーティションへアクセスする使い方も可能です。

注釈

ハイブリッドディスクリソース上のファイルシステムは CLUSTERPRO が制御します。ハイブリッドディスクリソースやハイブリッドディスクリソース用のパーティションを OS の /etc/fstab にエントリしないでください。(ignore オプション付きでの /etc/fstab へのエントリも行わないでください。)

注釈

vxfs が使用可能なディストリビューション、カーネルは vxfs のサポート状況に依存します。

注釈

ファイルシステムを作成し忘れて問題が発生した場合には、下記を行ってください。

- クラスタが起動している場合には、クラスタを停止する。Cluster WebUI の場合 : [サービス] → [クラスタ停止]コマンドの場合 : clpcl コマンド使用 「clpcl -t -a」

- ミラーエージェントが起動している場合には、ミラーエージェントを停止する。Cluster WebUIの場合 : [サービス] → [ミラーエージェント停止]コマンドの場合 : 「service clusterpro_md stop」を各サーバにて実行

- ハイブリッドディスクパーティションへのアクセス制限を解除する。clproset コマンド使用 (例: clproset -w -d <パーティションデバイス> 等)

- ファイルシステムを作成する。mkfs コマンド等使用 (例: mkfs -t ext3 <パーティションデバイス> 等)

システムをリブートする。

- ディスクハートビート用パーティションの確保共有ディスク上に CLUSTERPRO が独自に使用するパーティションを作成します。このパーティションはディスクハートビートリソースで使用します。パーティションは、共有ディスクを使用するクラスタ内のサーバのうちの 1 台のサーバにて作成します。fdisk コマンドを使用し、パーティションを確保します。

注釈

通常、ハートビートリソースに使用するパーティションは1つです。しかし、ディスクの故障などでデバイス名がずれた場合には、他の LUN でハートビートを行う必要があります。このため、通常ハートビートに使用する LUN に加えて、各 LUN に1つ、予備としてダミーのディスクハートビートリソース用のパーティションを確保しておきます。この際、ディスクハートビート専用パーティションのパーティション番号は各 LUN で同じになるように確保してください。

注釈

ディスクハートビート用パーティションは 10MB (10*1024*1024 バイト) 以上確保してください。また、ディスクハートビート用パーティションにはファイルシステムを構築しないでください。

- マウントポイントの作成ハイブリッドディスクリソース用パーティションを mount するディレクトリを作成します。ハイブリッドディスクリソースを使用する、共有ディスクを接続している各サーバにて作成します。なお、ハイブリッドディスクリソース用パーティションに対してファイルシステムを使用しない場合は、マウントポイントの作成は不要です。

2.8.3. ハイブリッドディスクリソース用のパーティションを設定する (Replicator DR 使用時は必須)¶

注釈

単体サーバのクラスタ化やサーバの再インストール時など、既存のパーティション上のデータを引き続き使用する場合は、ハイブリッドディスクリソース用パーティションの確保やファイルシステムの作成は行わないでください。ハイブリッドディスクリソース用パーティションの確保やファイルシステムの作成を行うとパーティション上のデータは削除されます。

- CLUSTER パーティションの確保ミラードライバが独自に使用するパーティションを作成します。このパーティションはミラードライバやミラーエージェントがハイブリッドディスクの状態を管理するために使用します。fdisk コマンドを使用し、パーティションを確保します。

注釈

CLUSTER パーティションは 1024MiB 以上確保してください。(1024MB ちょうどを指定しても、ディスクのジオメトリの違いにより実際には 1024MB より大きなサイズが確保されますが、問題ありません)。また、CLUSTER パーティションにはファイルシステムを構築しないでください。

- CLUSTER パーティションの初期化(過去に CLUSTERPRO のミラーディスクやハイブリッドディスクとして使用していたディスクを流用する場合にのみ必要)

CLUSTER パーティションに以前のデータが残っているため初期化が必要です。

パーティションを再確保してもパーティション上のデータは残っていますので、CLUSTERPRO のミラーディスク、ハイブリッドディスクとして使用したことのあるディスクを再利用する場合には必ず実行してください。

以下のコマンドを実行します。

dd if=/dev/zero of=<CLUSTERパーティションとして使用するパーティションデバイス名>

注釈

ddコマンドを実行するとof=で指定したパーティションのデータは初期化されます。パーティションデバイス名を十分に確認してからddコマンドを実行してください。

注釈

dd コマンド実行時、以下のメッセージが表示されますが異常ではありません。

dd: writing to <CLUSTERパーティションとして使用するパーティションデバイス名>: No space left on device

- ハイブリッドディスクリソース用パーティションの確保ハイブリッドディスクリソースで使用するパーティションを作成します。fdisk コマンドを使用し、パーティションを確保します。

- ファイルシステムの作成についてハイブリッドディスクリソース用のパーティションに対してファイルシステムの作成が必要です。

ハイブリッドディスクリソースはファイルシステムに基本的に依存をしていませんが、ファイルシステムの fsck の仕様により問題が発生することがあります。

システムの対障害性の向上のために、ジャーナル機能を持つファイルシステムを使用することを推奨します。

現在動作確認を完了しているファイルシステムは下記の通りです。

ext2

ext3

ext4

xfs

reiserfs

jfs

ファイルシステムを作成せず、ダイレクトにパーティションへアクセスする使い方も可能です。

注釈

ハイブリッドディスクリソース上のファイルシステムは CLUSTERPRO が制御します。ハイブリッドディスクリソースやハイブリッドディスクリソース用のパーティションを OS の /etc/fstab にエントリしないでください。(ignore オプション付きでの /etc/fstab へのエントリも行わないでください。)

注釈

vxfs が使用可能なディストリビューション、カーネルは vxfs のサポート状況に依存します。

注釈

ファイルシステムを作成し忘れて問題が発生した場合には、下記を行ってください。

- クラスタが起動している場合には、クラスタを停止する。Cluster WebUI の場合 : [サービス] → [クラスタ停止]コマンドの場合 : clpcl コマンド使用 「clpcl -t -a」

- ミラーエージェントが起動している場合には、ミラーエージェントを停止する。Cluster WebUI の場合 : [サービス] → [ミラーエージェント停止]コマンドの場合 : 「service clusterpro_md stop」を各サーバにて実行

- ハイブリッドディスクパーティションへのアクセス制限を解除する。clproset コマンド使用 (例: clproset -w -d <パーティションデバイス> 等)

- ファイルシステムを作成する。mkfs コマンド等使用 (例: mkfs -t ext3 <パーティションデバイス> 等)

システムをリブートする。

- マウントポイントの作成ハイブリッドディスクリソース用パーティションを mount するディレクトリを作成します。なお、ハイブリッドディスクリソース用パーティションに対してファイルシステムを使用しない場合は、マウントポイントの作成は不要です。

2.8.4. ミラーディスクリソース用のパーティションを設定する (Replicator 使用時は必須)¶

以下の手順でミラー用パーティションの設定を行います。ハイブリッドディスクリソース使用時(Replicator DR 使用時) は「 2.8.3. ハイブリッドディスクリソース用のパーティションを設定する (Replicator DR 使用時は必須) 」を参照してください。

注釈

単体サーバをクラスタ化する場合など、既存のパーティション上のデータを引き続き使用する場合や、サーバの再インストール時などは、ミラーリソース用パーティションの確保は行わないでください。ミラーリソース用パーティションの確保を行うとパーティション上のデータは削除されます。

- CLUSTER パーティションの確保ミラードライバが独自に使用するパーティションを作成します。このパーティションはミラードライバやミラーエージェントがミラーリソースの状態を管理するために使用します。パーティションは、ミラーリソースを使用するクラスタ内のすべてのサーバで、それぞれ作成します。fdisk コマンドを使用し、パーティションを確保します。

注釈

CLUSTER パーティションは 1024MiB 以上確保してください。(1024MB ちょうどを指定しても、ディスクのジオメトリの違いにより実際には 1024MB より大きなサイズが確保されますが、問題ありません)。また、CLUSTER パーティションにはファイルシステムを構築しないでください。

- CLUSTER パーティションの初期化(過去に CLUSTERPRO のミラーディスクやハイブリッドディスクとして使用していたディスクを流用する場合にのみ必要)

CLUSTER パーティションに以前のデータが残っているため初期化が必要です。

パーティションを再確保してもパーティション上のデータは残っていますので、CLUSTERPRO のミラーディスクやハイブリッドディスクとして使用したことのあるディスクを再利用する場合には必ず実行してください。

以下のコマンドを実行します。

dd if=/dev/zero of=<CLUSTERパーティションとして使用するパーティションデバイス名>

注釈

ddコマンドを実行するとof=で指定したパーティションのデータは初期化されます。パーティションデバイス名を十分に確認してからddコマンドを実行してください。

注釈

ddコマンド実行時、以下のメッセージが表示されますが異常ではありません。dd: writing to <CLUSTERパーティションとして使用するパーティションデバイス名>: No space left on device

- ミラーリソース用パーティションの確保ミラーリソースで使用するパーティションを作成します。パーティションは、ミラーリソースを使用する、クラスタ内のすべてのサーバで、それぞれ作成します。fdisk コマンドを使用し、パーティションを確保します。

- ファイルシステムの作成についてミラーリソース用パーティションの作成については「初期 mkfs を行う」の設定により異なります。

- Cluster WebUI でクラスタ構成情報作成時に、「初期 mkfs を行う」を設定する場合、CLUSTERPRO が自動でファイルシステムを構築します。パーティション上の既存のデータは失われますので注意してください。

- Cluster WebUI でクラスタ構成情報作成時に、「初期 mkfs を行う」を選択しなければCLUSTERPRO でファイルシステムの作成を行いません。パーティション上の既存のファイルシステムを利用するため、事前にファイルシステムが作成されている必要があります。

ミラーリソース用パーティションについては下記の点にも注意してください。

ミラーリソースは使用するファイルシステムについて基本的に依存をしていませんが、ファイルシステムの fsck の仕様により問題が発生することがあります。

システムの対障害性の向上のために、ジャーナル機能を持つファイルシステムを使用することを推奨します。

現在動作確認を完了しているファイルシステムは下記の通りです。

ext2

ext3

ext4

xfs

reiserfs

jfs

ファイルシステムを作成せず、ダイレクトにパーティションへアクセスする使い方も可能です。

注釈

既存のパーティション上のデータを引き続き使用する場合や、サーバの再インストール時などは、「初期 mkfs を行う」を選択しないでください。

注釈

ミラーリソース上のファイルシステムは CLUSTERPRO が制御します。ミラーリソースやミラーリソース用のパーティションを OS の /etc/fstab にエントリしないでください。(ignore オプション付きでの /etc/fstab へのエントリも行わないでください。)

注釈

vxfs が使用可能なディストリビューション、カーネルは vxfs のサポート状況に依存します。

- マウントポイントの作成ミラーリソース用パーティションを mount するディレクトリを作成します。ミラーリソースを使用する、クラスタ内のすべてのサーバでそれぞれ作成します。なお、ミラーリソース用パーティションに対してファイルシステムを使用しない場合は、マウントポイントの作成は不要です。

2.8.5. OS 起動時間を調整する (必須)¶

クラスタシステムを構成する各サーバに電源を投入してから、サーバの OS が起動するまでの時間を、以下の 2 つより長くなるように設定する必要があります。

共有ディスクに電源を投入してから使用可能になるまでの時間 (共有ディスクを使用する場合)

- ハートビートタイムアウト時間Cluster WebUI での既定値は 90 秒です

これは、以下の問題を回避するためです。

共有ディスクとサーバの電源を入れてクラスタシステムを起動すると、ディスクリソースの活性に失敗する

サーバの再起動でフェイルオーバを発生させたい場合に、ハートビートタイムアウト時間内にそのサーバが再起動してしまうと、相手側からはハートビートが継続しているとみなされフェイルオーバが発生しない

上記2点の時間を計測後、OSのブートローダの設定に従って OS 起動時間を調整します。

(例) OS ローダに GRUB2 を使用している場合

例 起動時間90秒

GRUB_TIMEOUT=90コマンドを実行して、設定の変更を反映します。

BIOSベースのサーバの場合

# grub2-mkconfig -o /boot/grub2/grub.cfgUEFIベースのサーバの場合

# grub2-mkconfig -o /boot/efi/EFI/redhat/grub.cfg

2.8.6. ネットワーク設定を確認する (必須)¶

クラスタ内のすべてのサーバで、ifconfig コマンドや ping コマンドを使用して、ネットワークが正常に動作しているかどうかを確認します。また、複数のネットワークデバイス (eth0、eth1、eth2... ) が、意図した役割 (パブリック LAN、インタコネクト専用 LAN) に割り当てられているかを確認します。以下のネットワークの状態を確認します。

パブリック LAN (他のマシンとの通信用)

インタコネクト専用 LAN (CLUSTERPRO のサーバ間接続用)

ホスト名

注釈

クラスタで使用する フローティング IP リソース および 仮想 IP リソース の IP アドレスは、OS 側への設定は不要です。

2.8.7. ファイアウォールの設定を確認する (必須)¶

CLUSTERPRO はモジュール間の通信にいくつかのポート番号を使用します。使用するポート番号については、『スタートアップガイド』の「注意制限事項」の「OS インストール後、CLUSTERPRO インストール前」を参照してください。

2.8.8. サーバの時刻を同期させる (必須)¶

クラスタシステムでは、クラスタ内のすべてのサーバの時刻を定期的に同期する運用を推奨します。 1 日 1 回程度を目安に ntp などを使用してサーバの時刻を同期させる設定にしてください。

注釈

各サーバの時刻が同期されていない場合、障害時に原因の解析に時間がかかることがあります。

3. クラスタシステムを設計する¶

本章では、二重化するアプリケーション、運用形態、クラスタ構築情報の説明など、クラスタ設計に際して必要な情報を提供します。

本章で説明する項目は以下の通りです。

3.1. クラスタシステムの設計¶

本章では、クラスタシステムの設計について、以下を行います。

クラスタシステムの運用形態の決定

二重化するアプリケーションの決定

クラスタ構成情報の作成

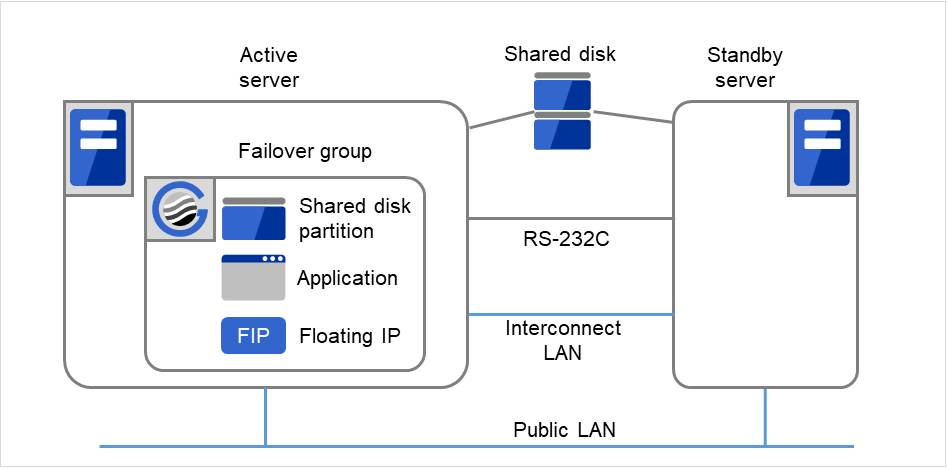

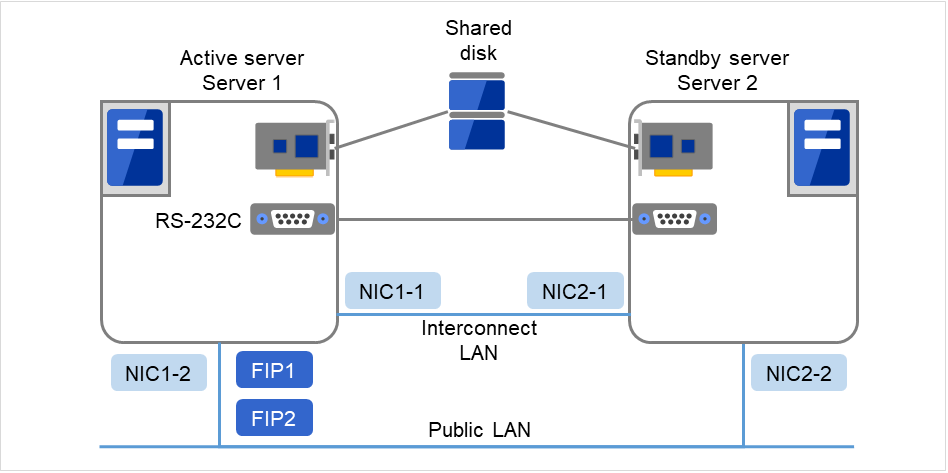

なお、本ガイドでは、以下の図に記載されている、典型的な 2 ノード、片方向スタンバイのクラスタ環境を構築する場合を例にとって説明を行います。

図 3.1 2 ノード、片方向スタンバイクラスタの例¶

FIP1 |

10.0.0.11

(Cluster WebUIクライアントからのアクセス先)

|

FIP2 |

10.0.0.12

(業務クライアントからのアクセス先)

|

NIC1-1 |

192.168.0.1 |

NIC1-2 |

10.0.0.1 |

NIC2-1 |

192.168.0.2 |

NIC2-2 |

10.0.0.2 |

RS-232C デバイス |

/dev/ttyS0 |

共有ディスク (Shared disk)

DISKハートビート デバイス名

/dev/sdb1

DISKハートビート Rawデバイス名

/dev/raw/raw1

共有ディスクデバイス

/dev/sdb2

マウントポイント

/mnt/sdb2

ファイルシステム

ext3

raw monitor デバイス名

設定しない

raw monitor 監視対象Rawデバイス名

/dev/raw/raw1

3.2. 運用形態を決定する¶

CLUSTERPRO は、複数の運用形態をサポートしています。片方のサーバを現用系、他方を待機系とする片方向スタンバイ形式と、両方のサーバがお互いに異なる業務の現用系、待機系となる双方向スタンバイ形式があります。

- 片方向スタンバイクラスタクラスタシステム全体で同一の業務アプリケーションが 1 つしか動作しないシステム形態です。フェイルオーバ発生後もパフォーマンスの劣化等はありませんが、正常時、待機系の資源が無駄になります。

図 3.2 片方向スタンバイクラスタ¶

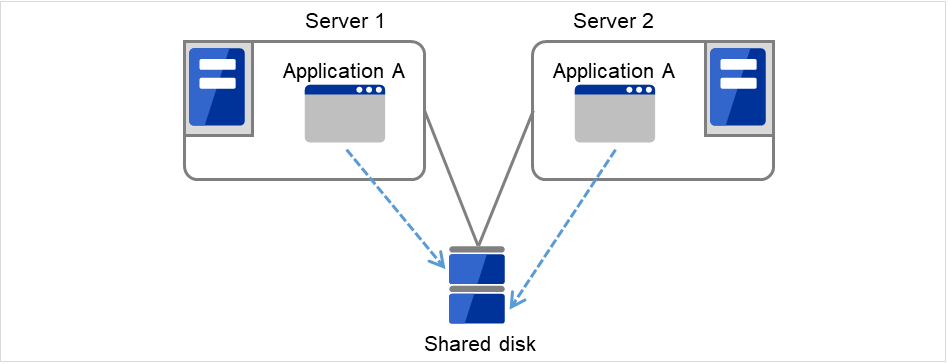

- 同一アプリケーション双方向スタンバイクラスタクラスタシステム全体で同一の業務アプリケーションが複数動作するシステム形態です。この構成を構築するには業務が多重起動に対応している必要があります。

図 3.3 同一アプリケーション双方向スタンバイクラスタ¶

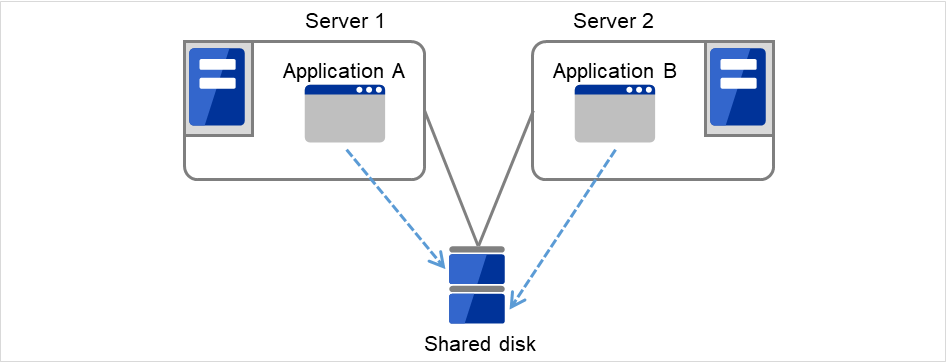

- 異種アプリケーション双方向スタンバイクラスタ複数の種類の業務アプリケーションが、それぞれ異なるサーバで稼動し、相互に待機するシステム形態です。正常時も資源が無駄になりません。ただし、フェイルオーバ発生後は、1 台のサーバで 2 種の業務が動作するため、業務のパフォーマンスが低下します。

図 3.4 異種アプリケーション双方向スタンバイクラスタ¶

3.2.1. 片方向スタンバイクラスタのフェイルオーバの流れ¶

片方向スタンバイクラスタでは、ある業務が動作するグループがクラスタ内で常に 1 台のサーバ上で動作するように制限されています。

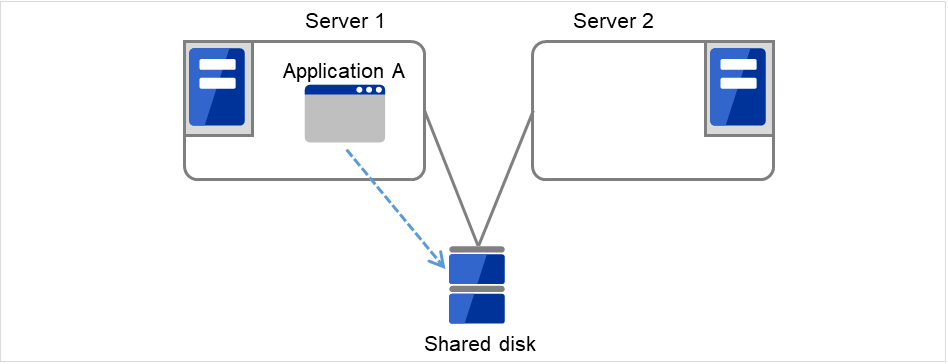

3.2.1.1. 共有ディスク使用時¶

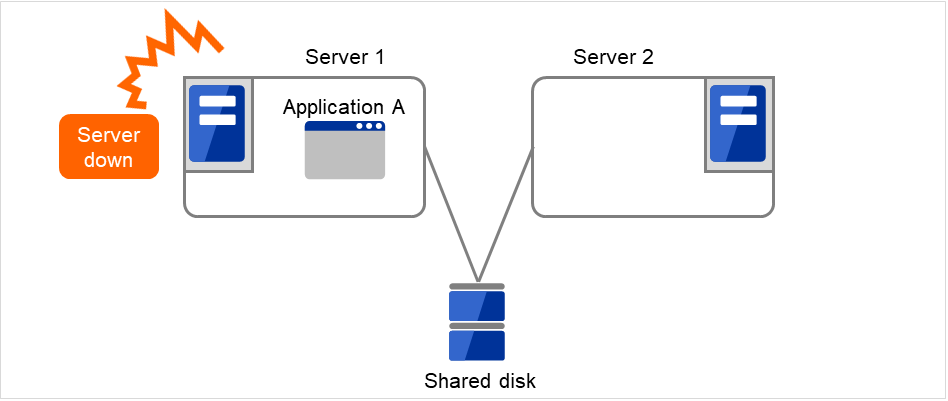

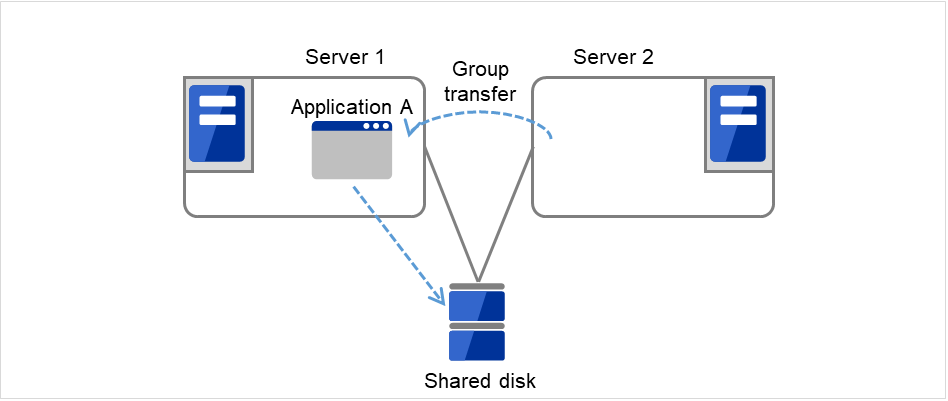

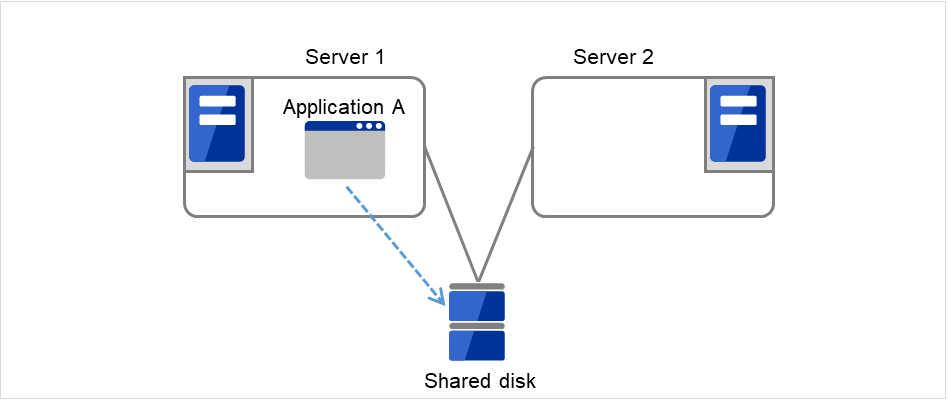

1. Server 1上で業務A(Application A)が実行されています。 ここで、業務Aは同一クラスタ内で複数実行することができません。

図 3.5 片方向スタンバイクラスタ(共有ディスク使用): (1) 通常運用時¶

3.2.1.2. ミラーディスク使用時¶

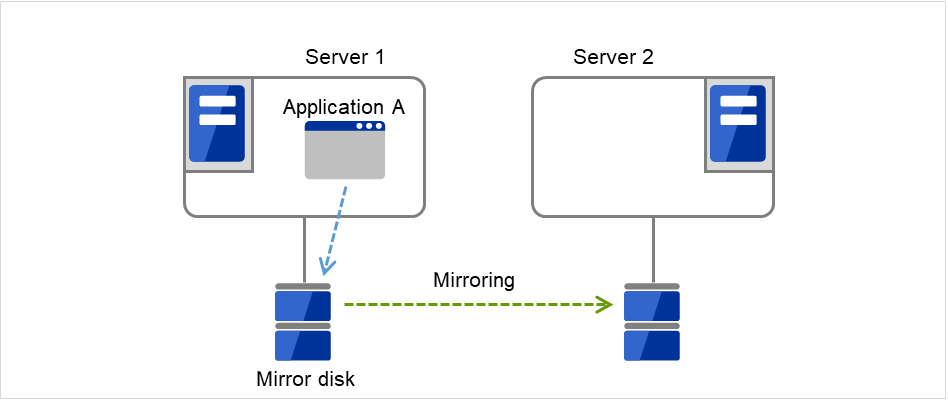

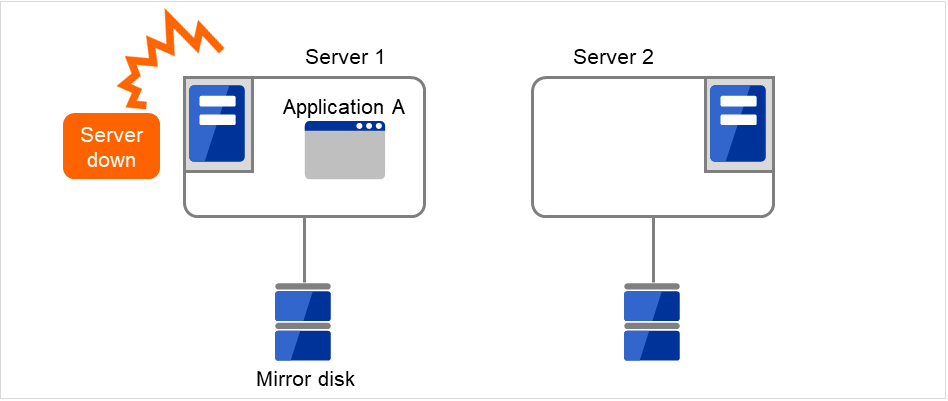

1. Server 1上で業務A(Application A)が実行されています。 ここで、業務Aは同一クラスタ内で複数実行することができません。

図 3.9 片方向スタンバイクラスタ(ミラーディスク使用): (1) 通常運用時¶

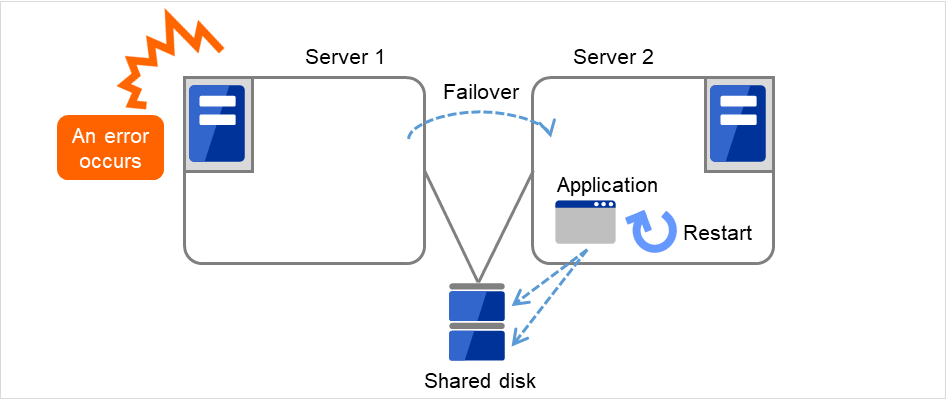

何らかの異常が発生し、Server 1がダウンします。

図 3.10 片方向スタンバイクラスタ(ミラーディスク使用): (2) サーバダウン時¶

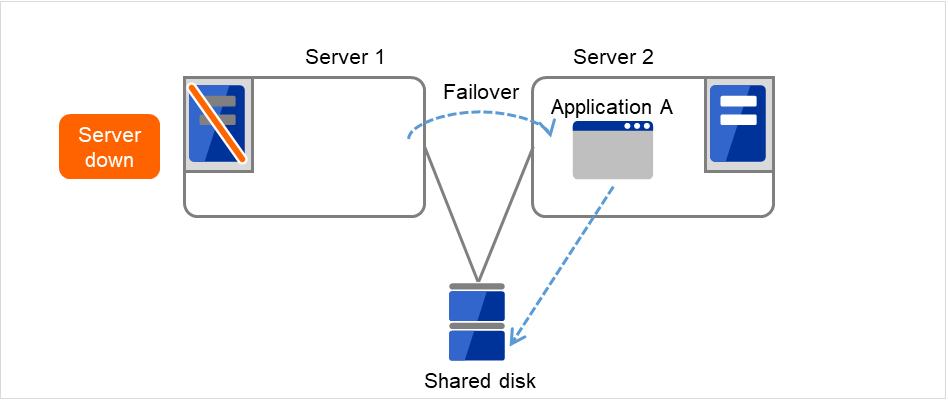

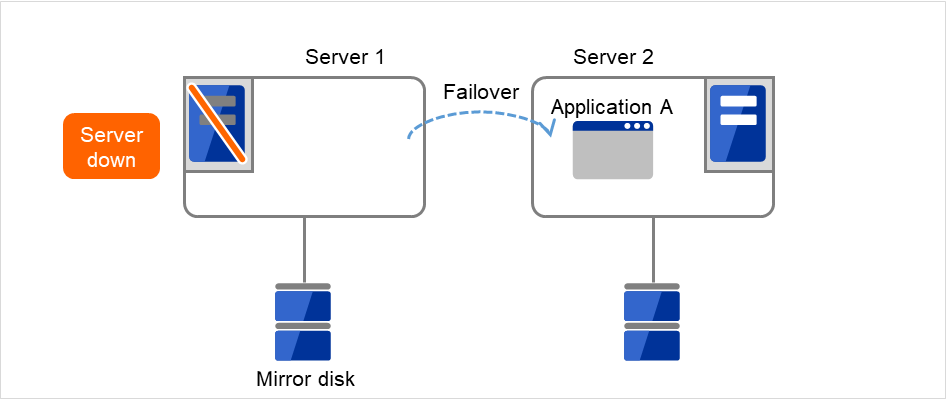

Server 1からServer 2へ、業務の引継ぎが行われます。

図 3.11 片方向スタンバイクラスタ(ミラーディスク使用): (3) フェイルオーバ時¶

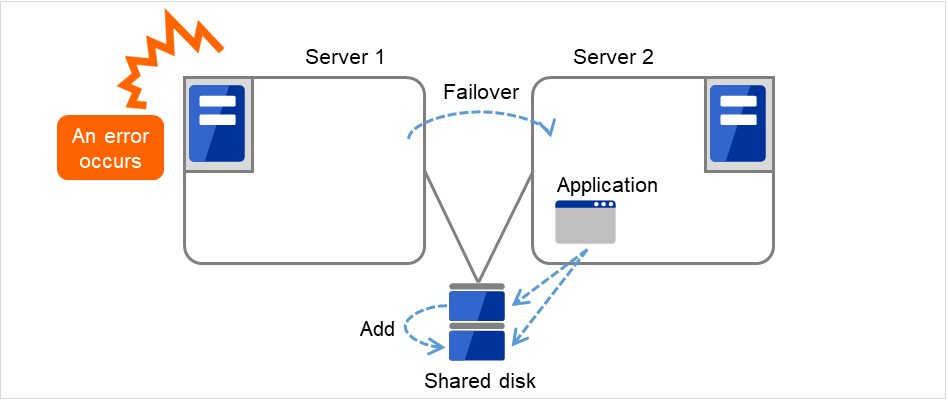

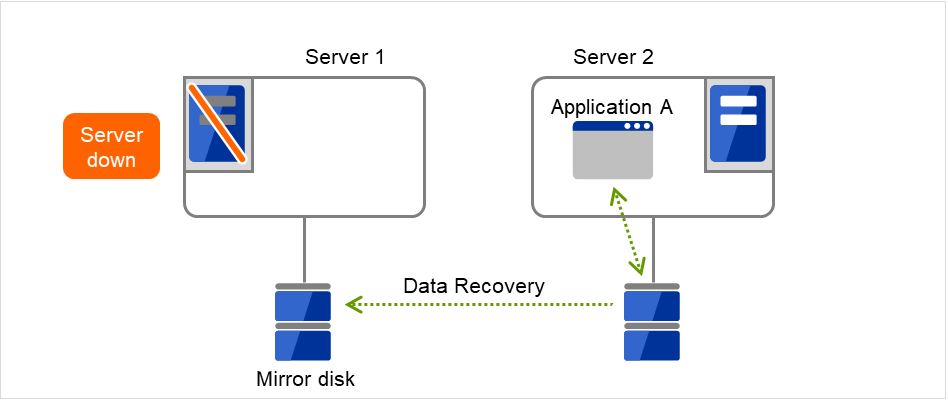

業務を再開するため、Server 2に接続されたMirror diskからデータ復旧を行います。

図 3.12 片方向スタンバイクラスタ(ミラーディスク使用): (4) データ復旧時¶

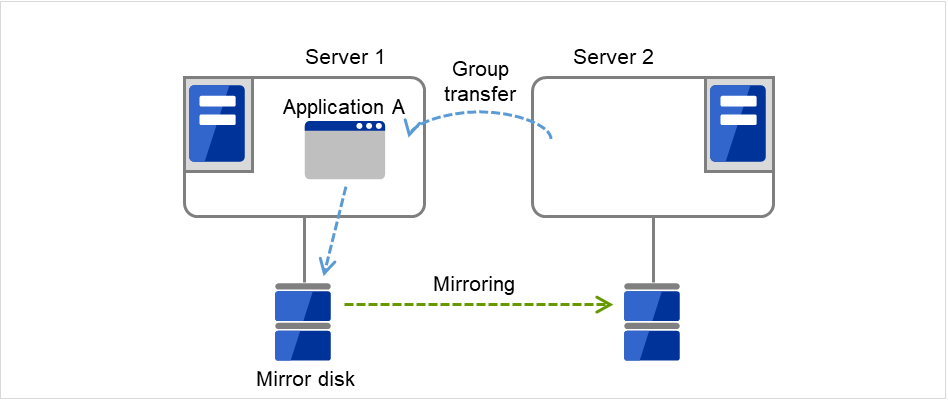

Server 1が復旧した後、Server 2からServer 1へ、業務A(Application A)のグループ移動を行うことができます。

図 3.13 片方向スタンバイクラスタ(ミラーディスク使用): (5) サーバ復旧後¶

3.2.2. 双方向スタンバイクラスタフェイルオーバの流れ¶

双方向スタンバイクラスタでは、ある業務が複数のサーバ上で同時に動作することが可能なため、フェイルオーバ実行時、現用系に負荷がかかります。

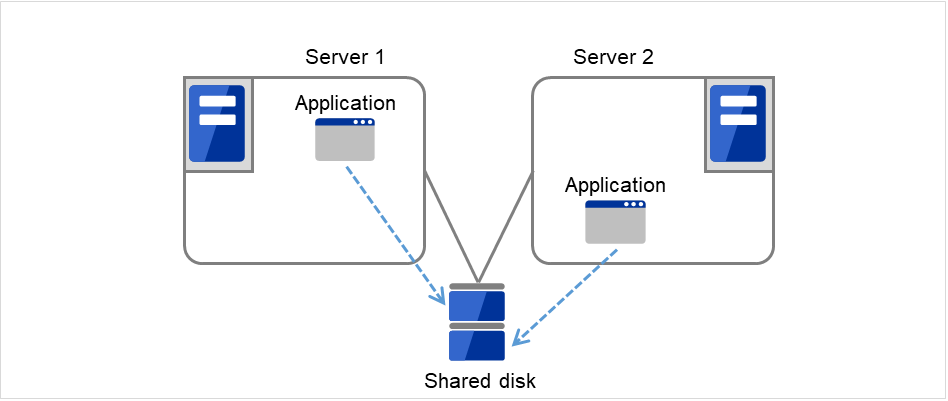

3.2.2.1. 共有ディスク使用時¶

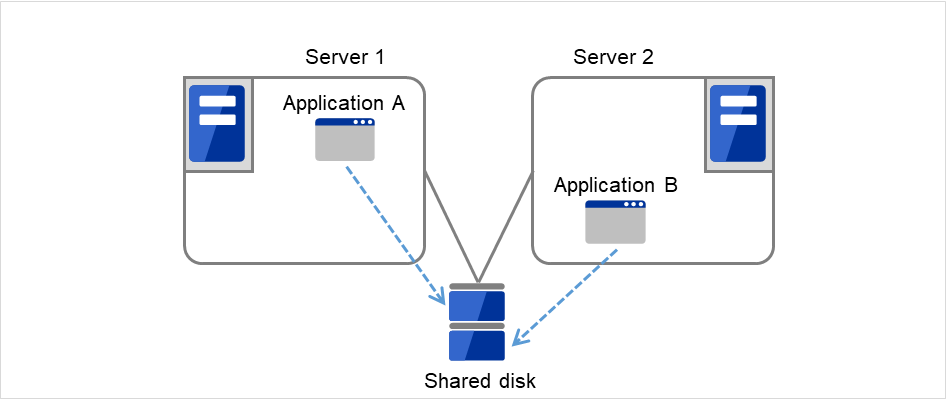

Server 1上で業務A(Application A)、Server 2上で業務B(Application B)が実行されています。

図 3.14 双方向スタンバイクラスタ(共有ディスク使用): (1) 通常運用時¶

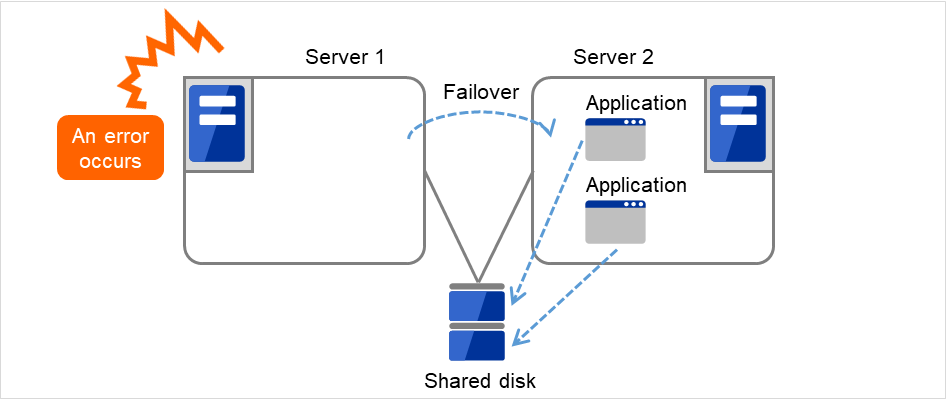

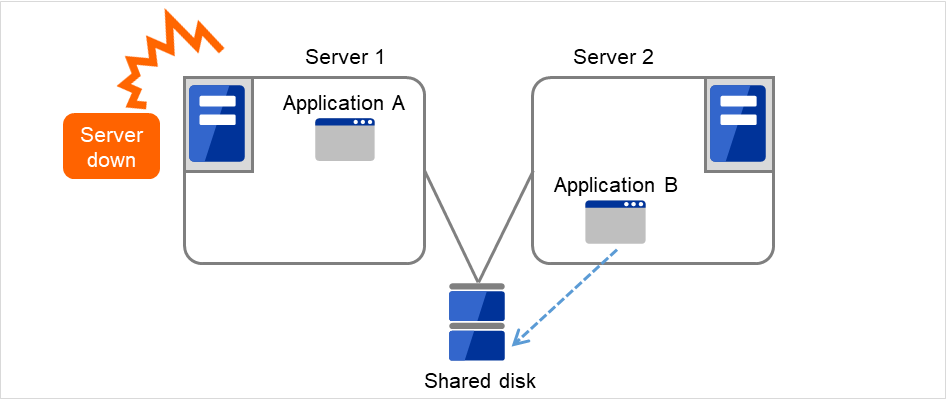

何らかの異常が発生し、Server 1がダウンします。

図 3.15 双方向スタンバイクラスタ(共有ディスク使用): (2) サーバダウン時¶

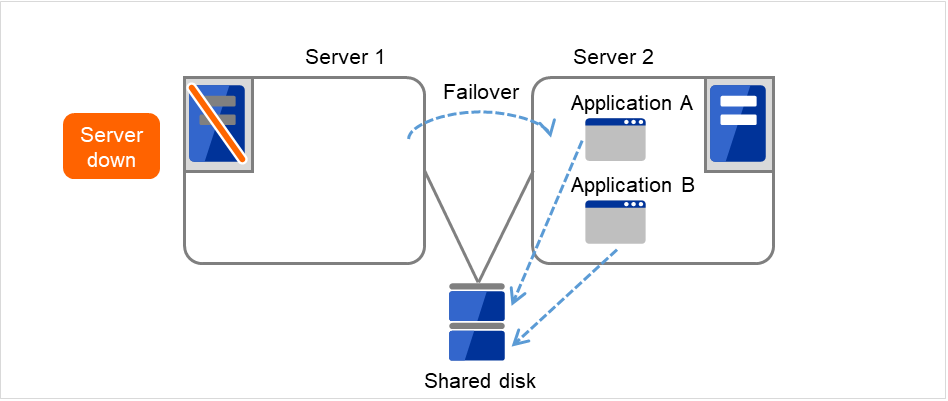

Server 1からServer 2へ、業務Aの引継ぎが行われます。

図 3.16 双方向スタンバイクラスタ(共有ディスク使用): (3) フェイルオーバ時¶

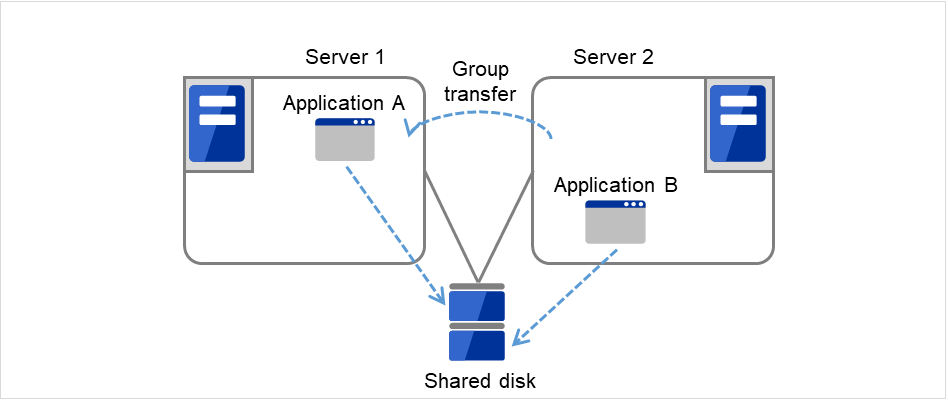

Server 1が復旧した後、Server 2からServer 1へ、業務A(Application A)のグループ移動を行うことができます。

図 3.17 双方向スタンバイクラスタ(共有ディスク使用): (4) サーバ復旧後¶

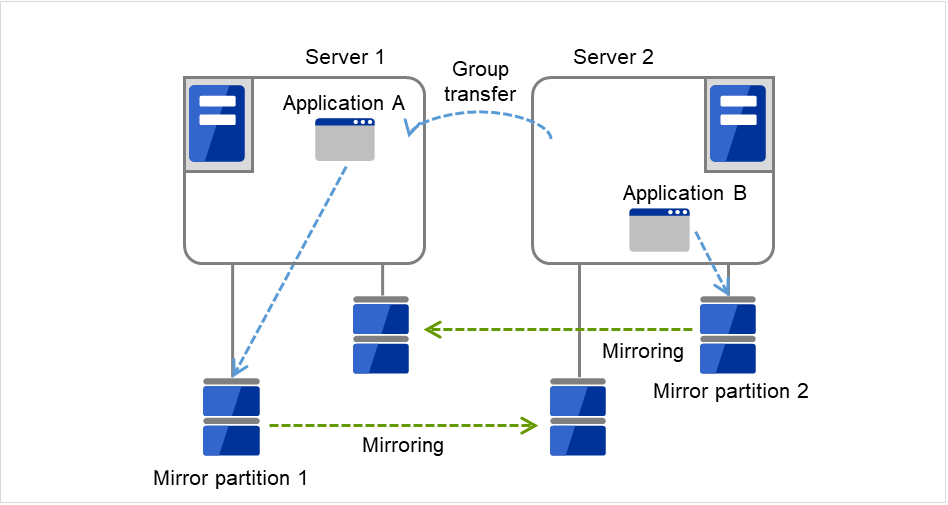

3.2.2.2. ミラーディスク使用時¶

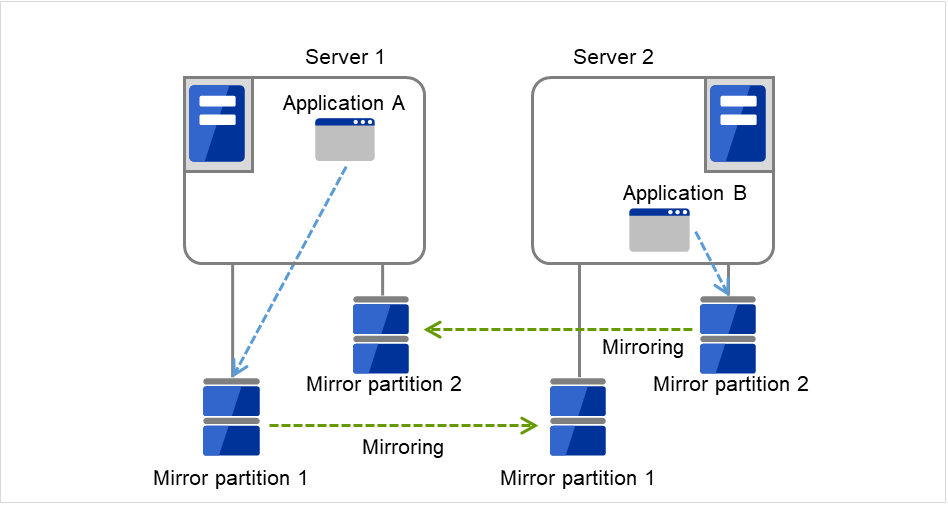

Server 1上で業務A(Application A)、Server 2上で業務B(Application B)が実行されています。

図 3.18 双方向スタンバイクラスタ(ミラーディスク使用): (1) 通常運用時¶

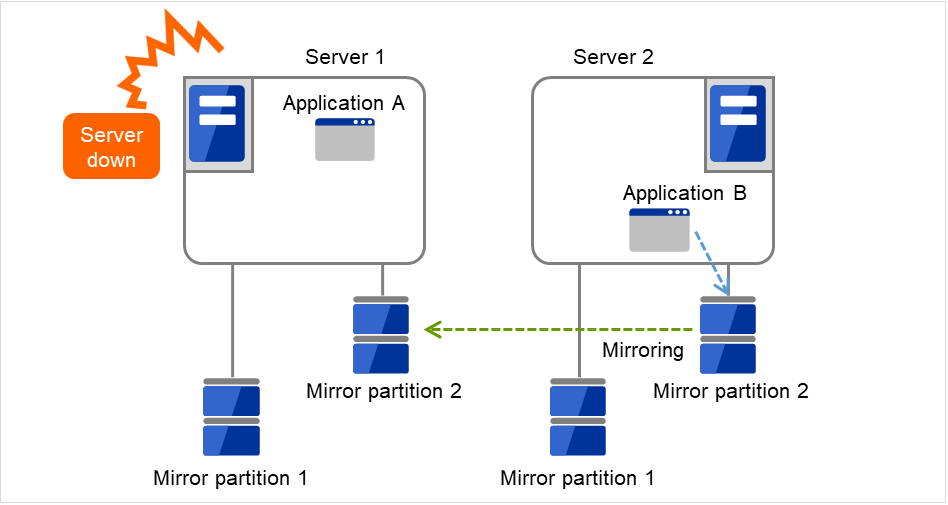

何らかの異常が発生し、Server 1がダウンします。

図 3.19 双方向スタンバイクラスタ(ミラーディスク使用): (2) サーバダウン時¶

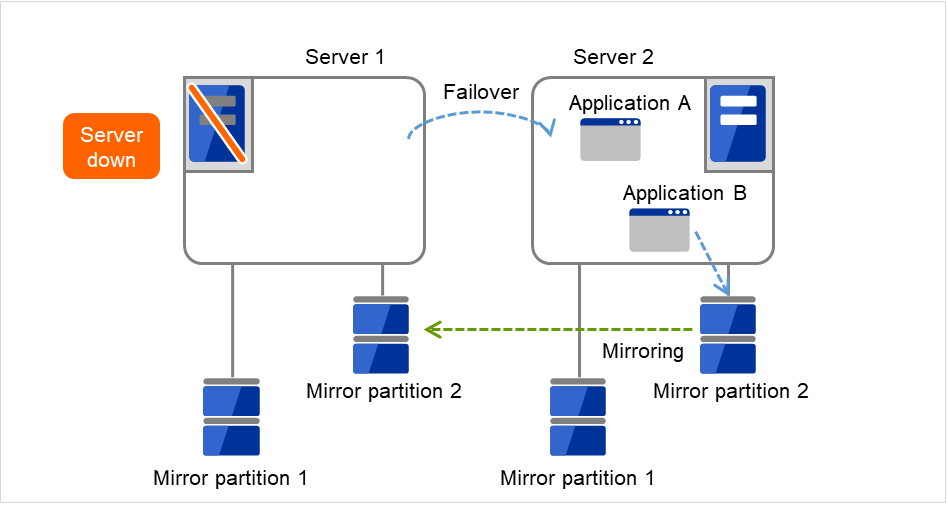

Server 1からServer 2へ、業務Aの引継ぎが行われます。

図 3.20 双方向スタンバイクラスタ(ミラーディスク使用): (3) フェイルオーバ時¶

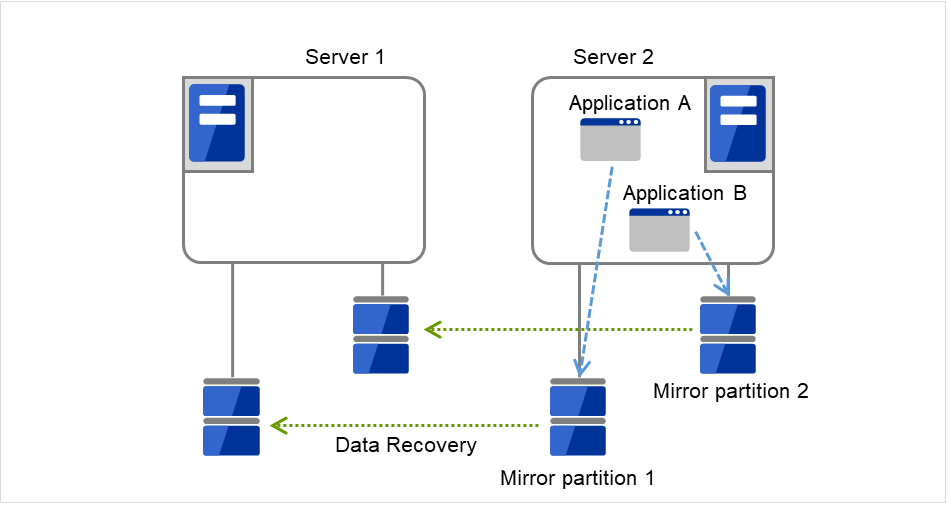

業務Aを再開するため、Server 2のMirror partition 1からデータ復旧を行います。

図 3.21 双方向スタンバイクラスタ(ミラーディスク使用): (4) データ復旧時¶

Server 1が復旧した後、Server 2からServer 1へ、業務A(Application A)のグループ移動を行うことができます。

図 3.22 双方向スタンバイクラスタ(ミラーディスク使用): (5) サーバ復旧後¶

3.3. 二重化するアプリケーションを決定する¶

二重化するアプリケーションを決定するには、アプリケーションが CLUSTERPRO によるクラスタシステム上でのクラスタ対象として適しているかどうかを、以下の内容を十分に検討して判断します。

3.3.1. 注意事項に該当する構成¶

対象アプリケーションをどのようなスタンバイ形態にするかで注意事項が異なります。注意事項については「3.3.2. 対象アプリケーションについての注意事項」 (1 ~ 5) に対応します。

片方向スタンバイ [現用-待機] 注意事項: 1 2 3 5

双方向スタンバイ [現用-現用] 注意事項: 1 2 3 4 5

- 共存動作 注意事項: 5クラスタシステムによるフェイルオーバの対象とはせず、共存動作する運用形態です。

3.3.2. 対象アプリケーションについての注意事項¶

3.3.2.1. 注意事項 1: 障害発生後のデータ修復¶

障害発生時に現用系のアプリケーションが更新していたファイルは、フェイルオーバ後に待機系でアプリケーションがそのファイルにアクセスするとき、データとして完結していない状態にある場合があります。 非クラスタ (単体サーバ) での障害後のリブートでも同様のことが発生するため、本来アプリケーションはこのような障害に対処するメカニズムを持っている必要があります。クラスタシステム上ではこれに加え人間の関与なしに (スクリプトから) 復旧が行える必要があります。 共有ディスクまたはミラーディスクのファイルシステムに fsck が必要な場合には、CLUSTERPRO が fsck を行います。

3.3.2.2. 注意事項 2: アプリケーションの終了¶

CLUSTERPRO が業務グループを停止・移動 (オンラインフェイルバック) する場合、その業務グループが使用していたファイルシステムをアンマウントします。このため、アプリケーションへの終了指示にて、共有ディスクまたはミラーディスク上の全てのファイルに対するアクセスを停止する必要があります。 通常は終了スクリプトでアプリケーション終了指示コマンドを実行しますが、終了指示コマンドが (アプリケーションの終了と) 非同期で完了してしまう場合注意が必要です。

3.3.2.3. 注意事項 3: データ格納位置¶

CLUSTERPRO がサーバ間で引き継ぐことのできるデータは次の通りです。

データの種類

例

配置場所

引き継ぎたいデータ

ユーザデータなど

共有ディスクまたはミラーディスク

引き継ぎたくないデータ

プログラム、設定情報など

サーバのローカルディスク

3.3.2.4. 注意事項 4: 複数業務グループ¶

双方向スタンバイの運用形態では、(障害による縮退時) 1つのサーバ上で同一アプリケーションによる複数業務グループが稼動することを想定しなくてはなりません。単一サーバが複数の業務グループを同時に実行できることが必要です。また、アプリケーションは、次のいずれかの方法で資源を引き継ぐことができなければなりません。ミラーディスクも同じ考え方です。

図 3.23 各サーバ上で業務が正常稼働(双方向スタンバイクラスタ)¶

3.3.2.5. 注意事項 5: アプリケーションとの相互干渉、相性問題¶

CLUSTERPRO の機能や動作に必要な OS 機能との相互干渉によってアプリケーションまたは CLUSTERPRO が動作できない場合があります。

3.3.3. 注意事項に対する対策¶

問題点 |

対策 |

注意事項に対応する

番号

|

|---|---|---|

データファイル更新中に障害が発生した場合、待機系にてアプリケーションが正常に動作しない |

プログラム修正 |

注意事項 1 |

アプリケーションを停止しても一定時間の間、ディスクやファイルシステムへアクセスしつづける |

停止スクリプト中にsleepコマンドを使用し待ち合わせる |

注意事項 2 |

一台のサーバ上で同一アプリケーションを複数起動できない |

双方向スタンバイ運用では、フェイルオーバ時にアプリケーションを再起動し共有データを引き継ぐ |

注意事項 3 |

3.3.4. 業務形態の決定¶

本章全体を踏まえた上で、業務形態を決定してください。

どのアプリケーションをいつ起動するか

起動時やフェイルオーバ時に必要な処理は何か

ディスクリソースまたはミラーディスクリソース、ハイブリッドディスクリソースに置くべき情報は何か

3.4. クラスタ構成を設計する¶

図 3.27 フェイルオーバグループとグループリソース¶

3.5. グループリソースを理解する¶

クラスタシステムでフェイルオーバを実現するには、フェイルオーバの単位となるグループを作成する必要があります。グループを構成するのは、グループリソースです。最適なクラスタを作成するためには、作成するグループにどのようなグループリソースを追加し、どのような設定で運用するかをよく理解する必要があります。

参考

各リソースの詳細は、『リファレンスガイド』を参照してください。

現在サポートされているグループリソースは以下です。

グループリソース名 |

略称 |

|---|---|

EXEC リソース |

exec |

ディスクリソース |

disk |

フローティング IP リソース |

fip |

仮想 IP リソース |

vip |

ミラーディスクリソース |

md |

ハイブリッドディスクリソース |

hd |

NAS リソース |

nas |

ボリュームマネージャリソース |

volmgr |

仮想マシンリソース |

vm |

ダイナミック DNS リソース |

ddns |

AWS Elastic IPリソース |

awseip |

AWS 仮想IPリソース |

awsvip |

AWS DNS リソース |

awsdns |

Azure プローブポートリソース |

azurepp |

Azure DNS リソース |

azuredns |

Google Cloud 仮想 IP リソース |

gcvip |

Google Cloud DNS リソース |

gcdns |

Oracle Cloud 仮想 IP リソース |

ocvip |

3.6. モニタリソースを理解する¶

- 常時監視

クラスタ起動時~クラスタ停止時まで監視します。

- 活性時監視

グループ活性時~グループ非活性時まで監視します。

現在サポートされているモニタリソースは以下です。

モニタリソース名 |

略称 |

常時監視 |

活性時監視 |

|---|---|---|---|

ディスクモニタリソース |

diskw |

✓ |

✓ |

IP モニタリソース |

ipw |

✓ |

✓ |

NIC Link Up/Down モニタリソース |

miiw |

✓ |

✓ |

BMC モニタリソース |

bmcw |

✓ |

|

ミラーディスクコネクトモニタリソース |

mdnw |

✓ |

|

ミラーディスクモニタリソース |

mdw |

✓ |

|

ハイブリッドディスクコネクトモニタリソース |

hdnw |

✓ |

|

ハイブリッドディスクモニタリソース |

hdw |

✓ |

|

PID モニタリソース |

pidw |

✓ |

|

ユーザ空間モニタリソース |

userw |

✓ |

|

カスタムモニタリソース |

genw |

✓ |

|

ボリュームマネージャモニタリソース |

volmgrw |

✓ |

✓ |

マルチターゲットモニタリソース |

mtw |

✓ |

|

仮想 IP モニタリソース |

vipw |

✓ |

|

ARP モニタリソース |

arpw |

✓ |

|

仮想マシンモニタリソース |

vmw |

✓ |

|

外部連携モニタリソース |

mrw |

✓ |

✓ |

ダイナミック DNS モニタリソース |

ddnsw |

✓ |

|

プロセス名モニタリソース |

psw |

✓ |

✓ |

DB2 モニタリソース |

db2w |

✓ |

|

フローティング IP モニタリソース |

fipw |

✓ |

|

FTP モニタリソース |

ftpw |

✓ |

✓ |

HTTP モニタリソース |

httpw |

✓ |

✓ |

IMAP4 モニタリソース |

imap4 |

✓ |

✓ |

MySQL モニタリソース |

mysqlw |

✓ |

|

NFS モニタリソース |

nfsw |

✓ |

✓ |

Oracle モニタリソース |

oraclew |

✓ |

|

Oracle Clusterware 同期管理モニタリソース |

osmw |

✓ |

|

POP3 モニタリソース |

pop3w |

✓ |

✓ |

PostgreSQL モニタリソース |

psqlw |

✓ |

|

Samba モニタリソース |

sambaw |

✓ |

✓ |

SMTP モニタリソース |

smtpw |

✓ |

✓ |

Sybase モニタリソース |

sybasew |

✓ |

|

Tuxedo モニタリソース |

tuxw |

✓ |

✓ |

WebLogic モニタリソース |

wlsw |

✓ |

✓ |

WebSphere モニタリソース |

wasw |

✓ |

✓ |

WebOTX モニタリソース |

otxw |

✓ |

✓ |

JVM モニタリソース |

jraw |

✓ |

✓ |

システムモニタリソース |

sraw |

✓ |

|

プロセスリソースモニタリソース |

psrw |

✓ |

|

AWS Elastic IP モニタリソース |

awseipw |

✓ |

|

AWS 仮想 IP モニタリソース |

awsvipw |

✓ |

|

AWS AZ モニタリソース |

awsazw |

✓ |

|

AWS DNS モニタリソース |

awsdnsw |

✓ |

|

Azure ロードバランスモニタリソース |

azurelbw |

✓ |

|

Azure プローブポートモニタリソース |

azureppw |

✓ |

|

Azure DNS モニタリソース |

azurednsw |

✓ |

|

Google Cloud 仮想 IP モニタリソース |

gcvipw |

✓ |

|

Google Cloud ロードバランスモニタリソース |

gclbw |

✓ |

|

Google Cloud DNS モニタリソース |

gcdnsw |

✓ |

|

Oracle Cloud 仮想 IP モニタリソース |

ocvipw |

✓ |

|

Oracle Cloud ロードバランスモニタリソース |

oclbw |

✓ |

3.7. ハートビートリソースを理解する¶

クラスタ内のサーバは他のサーバの死活監視を行います。サーバ間の死活監視はハートビートリソースを使用します。ハートビートデバイスには以下の種類があります。

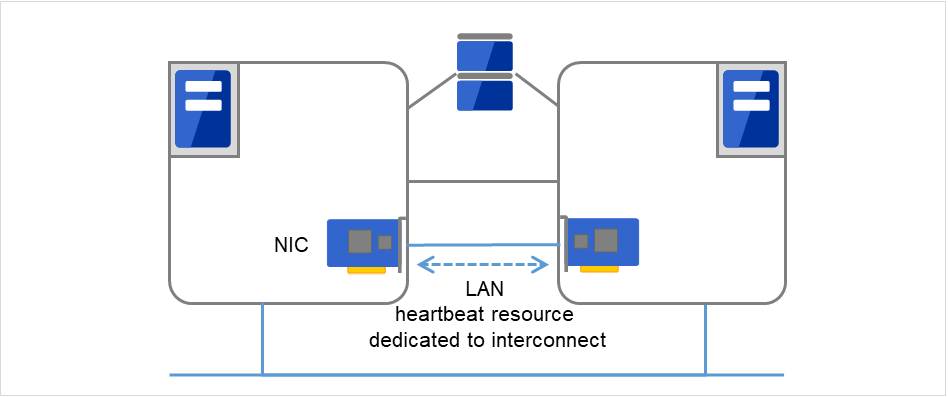

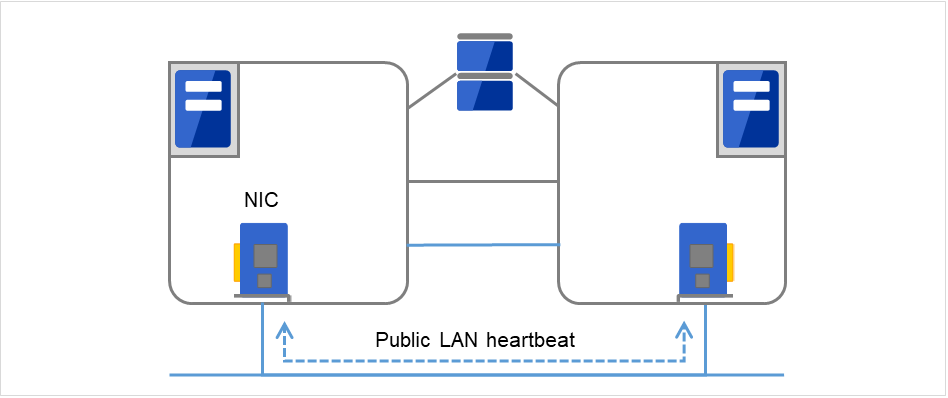

LANハートビート/カーネルモードLANハートビート(プライマリインタコネクト)

図 3.28 LANハートビート/カーネルモードLANハートビート(プライマリインタコネクト)¶

LANハートビート/カーネルモードLANハートビート(セカンダリインタコネクト)

図 3.29 LANハートビート/カーネルモードLANハートビート(セカンダリインタコネクト)¶

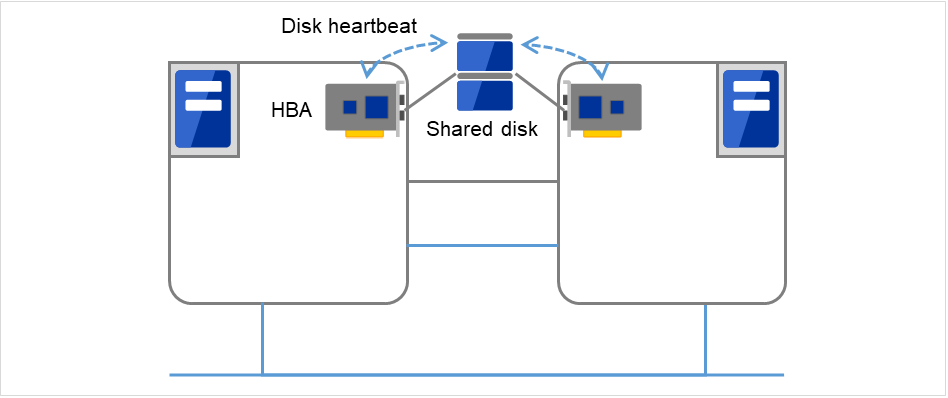

ディスクハートビート

図 3.30 ディスクハートビート¶

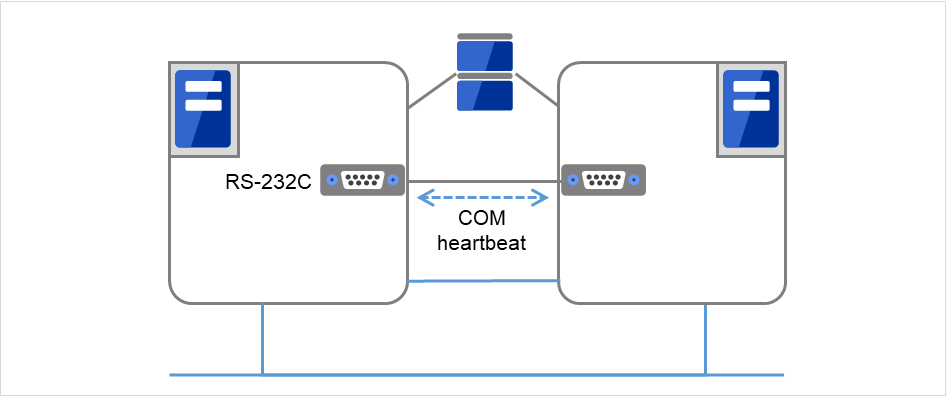

COMハートビート

図 3.31 COMハートビート¶

BMCハートビート

図 3.32 BMCハートビート¶

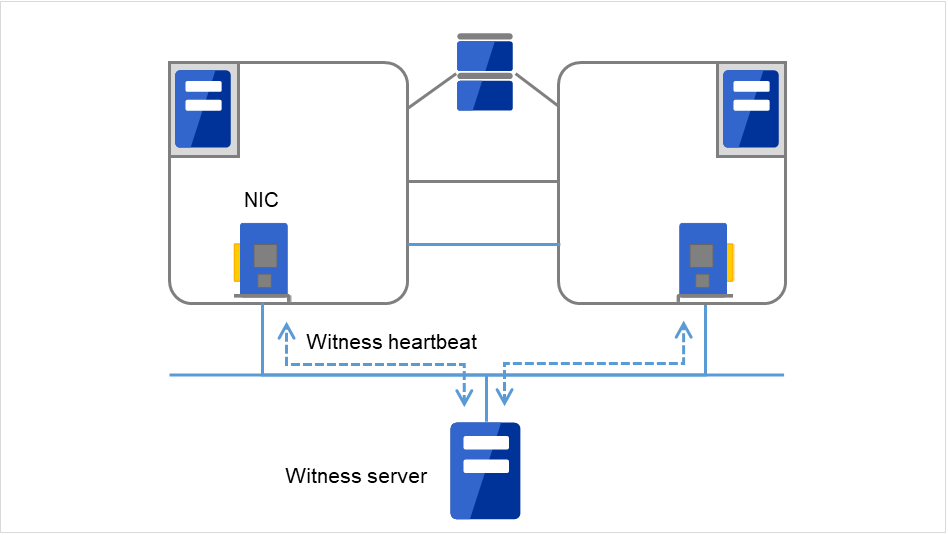

Witnessハートビート

図 3.33 Witnessハートビート¶

ハートビートリソース名 |

略称 |

機能概要 |

|---|---|---|

LAN ハートビートリソース (1) (2) |

lanhb |

LAN を使用してサーバの死活監視を行います

クラスタ内の通信でも使用します

|

カーネルモード LAN ハートビート

リソース (1) (2)

|

lankhb |

カーネルモードのモジュールが LAN を使用してサーバの死活監視を行います

クラスタ内の通信でも使用します

|

ディスクハートビートリソース (3) |

diskhb |

共有ディスク上の専用パーティションを使用してサーバの死活監視を行います |

COM ハートビートリソース (4) |

comhb |

2 台のサーバ間を COM ケーブルで接続してサーバの死活監視を行います |

BMC ハートビートリソース (5) |

bmchb |

BMC を使用してサーバの死活監視を行います |

Witness ハートビートリソース (6) |

witnesshb |

Witness サーバを使用してサーバの死活監視を行います。 |

優先度が一番高いインタコネクトには、全サーバ間で通信可能な LAN ハートビートまたはカーネルモード LAN ハートビートを設定してください。

カーネルモード LAN ハートビートリソースを 2 つ以上設定することを推奨します(クラウド環境や遠隔クラスタ環境のようにネットワークの追加が難しい場合はその限りではありません)。

インタコネクト専用の LAN を カーネルモード LAN ハートビートリソースとして登録し、さらにパブリックLAN も カーネルモード LAN ハートビートリソースとして登録することを推奨します。

ディスクハートビート及び COM ハートビートの I/F は、以下の基準で設定してください。

共有ディスクを使用するとき

[サーバ数 2 台まで] 基本的に COM I/F 方式とディスク I/F 方式[サーバ数 3 台以上] ディスク I/F 方式共有ディスクを使用しないとき

[サーバ数 2 台まで] COM I/F 方式

3.8. ネットワークパーティション解決リソースを理解する¶

Ping 方式

ping コマンドを受信し、応答を返却可能な常時稼動している装置(以下、「ping用装置」と省略します)が必要です。

ping 用装置は複数指定することができます。

他サーバからのハートビートの途絶を検出した際に、ping 用装置から ping コマンドの応答がある場合にはハートビートの途絶したサーバがダウンしたと判断してフェイルオーバを実施し、ping コマンドの応答がない場合はネットワークパーティション状態により自身がネットワークから孤立したものと判断して緊急シャットダウンします。これにより、ネットワークパーティション状態が発生した際に、クライアントと通信可能な方のサーバで業務を継続することができます。

ping 用装置の障害などにより、ハートビートが途絶する前に ping コマンドの応答が返らない状態が続くと、ネットワークパーティションの解決ができなくなりますので、この状態でハートビート切れを検出した場合、全サーバが緊急シャットダウンを実行します。

HTTP 方式

常時稼働している Web サーバが必要です。

他サーバからのハートビートの途絶を検出した際に、HTTP HEAD リクエストに対するレスポンスがある場合にはハートビートの途絶したサーバがダウンしたと判断してフェイルオーバを実施し、レスポンスがない場合はネットワークパーティション状態により自身がネットワークから孤立したものと判断して緊急シャットダウンします。これにより、ネットワークパーティション状態が発生した際に、クライアントと通信可能な方のサーバで業務を継続することができます。

Web サーバの障害などにより、ハートビートが途絶する前に HTTP HEAD リクエストへのレスポンスがない状態が続くと、ネットワークパーティションの解決ができなくなりますので、この状態でハートビート切れを検出した場合、全サーバが緊急シャットダウンを実行します。

ネットワークパーティション解決しない

万一、クラスタサーバ間の全てのネットワーク通信路に障害が発生した場合には、全サーバがフェイルオーバを実行します。

推奨するネットワークパーティション解決方式は下記です。

ネットワークパーティション解決方式

|

ノード数

|

必要HW

|

フェイル

オーバ不可のケース

|

全ネットワーク経路断線時

|

両サーバがフェイルオーバするケース

|

ネットワークパーティション解決に必要な時間

|

|---|---|---|---|---|---|---|

Ping |

制限なし |

pingコマンドを受信し応答を返却する装置 |

なし |

pingコマンドの応答が有るサーバが生存 |

pingコマンドが指定回数連続タイムアウト後に、全ネットワーク断線 |

0 |

HTTP |

制限なし |

Web サーバ |

Web サーバ障害 |

Web サーバと通信可能なサーバが生存 |

なし |

0 |

なし |

制限なし |

なし |

なし |

全サーバがフェイルオーバ実施 |

全ネットワーク断線時 |

0 |

4. CLUSTERPRO をインストールする¶

参考

旧バージョンの CLUSTERPRO Server からアップグレードするには『スタートアップガイド』 「アップグレード手順」を参照してください。

4.1. CLUSTERPRO のインストールからクラスタ生成までの流れ¶

CLUSTERPRO のインストールからライセンス登録、クラスタシステム生成、クラスタシステムの状態確認までの流れを以下に示します。

以下の手順に進む前に、必ず「2. システム構成を決定する」「3. クラスタシステムを設計する」 を読み、必要な動作環境や生成するクラスタの構成内容について確認してください。

- CLUSTERPRO Server のインストールクラスタを構成する各サーバに、CLUSTERPRO のメインのモジュールである CLUSTERPRO Server をインストールします。

参考

本ガイドの流れに従って操作を行うためには、本ガイドの手順に従いながら、随時『リファレンスガイド』を参照する必要があります。また、動作環境やリリース情報などの最新情報は、『スタートアップガイド』を参照してください。

4.2. CLUSTERPRO Server のセットアップ¶

CLUSTERPRO の本体モジュールである CLUSTERPRO Server は以下のシステムサービスで構成され、CLUSTERPRO Server RPM / debパッケージ のインストールによりセットアップされます。

システムサービス名 |

説明 |

|---|---|

clusterpro |

CLUSTERPRO デーモン

CLUSTERPRO 本体のサービスです。

|

clusterpro_evt |

CLUSTERPRO イベント

CLUSTERPRO が出力するログおよび syslog を制御するサービスです。

|

clusterpro_trn |

CLUSTERPRO データ転送

クラスタ内のライセンス同期や構成情報の転送を制御するサービスです。

|

clusterpro_ib |

CLUSTERPRO Information Base

CLUSTERPRO の情報を管理するサービスです。

|

clusterpro_api |

CLUSTERPRO API

CLUSTERPRO Restful API 機能を制御するサービスです。

|

clusterpro_md |

CLUSTERPRO ミラーエージェント

CLUSTERPRO のミラーディスクリソース、ハイブリッドディスクリソースとミラードライバを制御するサービスです。

|

clusterpro_alertsync |

CLUSTERPRO アラート同期

クラスタ内のサーバでアラートを同期するためのサービスです。

|

clusterpro_webmgr |

CLUSTERPRO WebManager

WebManager サーバのサービスです。

|

4.2.1. CLUSTERPRO RPM をインストールするには¶

以下の手順に従って、クラスタを構成する各サーバに CLUSTERPRO Server の RPM をインストールします。

注釈

CLUSTERPRO Server の RPM は root ユーザでインストールしてください。

CLUSTERPRO XのCD媒体には、新しいkernelに対応したrpmが含まれていない場合があります。運用環境でのkernelバージョンと 『スタートアップガイド』の「CLUSTERPRO の動作環境」の「動作可能なディストリビューションとkernel」を確認していただき、「CLUSTERPRO Version」に記載されているバージョンに適合したUpdateの適用をお願いいたします。

インストール CD-ROM を mount します。

- rpm コマンドを実行して、パッケージファイルをインストールします。製品によりインストール用 RPM が異なります。CD-ROM 内の /Linux/4.3/jp/server に移動して、以下を実行します。

rpm -i clusterpro-<バージョン>.<アーキテクチャ>.rpm

アーキテクチャには x86_64、IBM POWER、IBM POWER LE があります。インストール先の環境に応じて選択してください。アーキテクチャは、arch コマンドなどで確認できます。インストールが開始されます。注釈

CLUSTERPRO は以下の場所にインストールされます。このディレクトリは変更しないでください。また、このディレクトリをシンボリックリンクにしないでください。インストールディレクトリ: /opt/nec/clusterpro インストールが終了したら、インストール CD-ROM を umount します。

インストール CD-ROM を取り出します。ライセンス登録の手順に進んでください。

参考

4.2.2. CLUSTERPRO deb パッケージ をインストールするには¶

以下の手順に従って、クラスタを構成する各サーバに CLUSTERPRO Server の debパッケージ をインストールします。

注釈

CLUSTERPRO Server の debパッケージ は root ユーザでインストールしてください。

インストール CD-ROM を mount します。

- dpkg コマンドを実行して、パッケージファイルをインストールします。製品によりインストール用 debパッケージ が異なります。CD-ROM 内の /Linux/4.3/jp/server に移動して、以下を実行します。インストールが開始されます。

dpkg -i clusterpro-<バージョン>.amd64.deb

注釈

CLUSTERPRO は以下の場所にインストールされます。このディレクトリは変更しないでください。また、このディレクトリをシンボリックリンクにしないでください。インストールディレクトリ: /opt/nec/clusterpro インストールが終了したら、インストール CD-ROM を umount します。

インストール CD-ROM を取り出します。ライセンス登録の手順に進んでください。

参考

4.2.3. SNMP 連携機能を設定するには¶

注釈

SNMP トラップ送信機能のみを使う場合は、本手順は必要ありません。

注釈

root ユーザで設定してください。

インストール手順に現れる Net-SNMP 関連の記述はディストリビューション毎に異なる可能性があります。

Net-SNMP をインストールします。

- snmpd のバージョンを確認します。以下のコマンドを実行してください。

snmpd -v

snmpd デーモンを停止します。

注釈

通常、以下のコマンドを実行することで停止できます。

init.d 環境の場合:

/etc/init.d/snmpd stop

systemd 環境の場合:

systemctl stop snmpd

- snmpd デーモンの 構成ファイルに CLUSTERPRO のSNMP 連携機能を登録します。テキストエディタで構成ファイルを開いてください。snmpd のバージョンに応じて、ファイル末尾に以下を追記してください。

snmpd のバージョンが 5.7 未満の場合:

dlmod clusterManagementMIB /opt/nec/clusterpro/lib/libclpmgtmib.so

snmpd のバージョンが 5.7 以上の場合:

dlmod clusterManagementMIB /opt/nec/clusterpro/lib/libclpmgtmib2.so

注釈

通常、Net-SNMP snmpd デーモンの構成ファイルは以下に配置されています。

/etc/snmp/snmpd.conf

- snmpd デーモンが許可する MIB ビュー(snmpd.conf の view定義) に、CLUSTERPRO の OID を追加してください。CLUSTERPRO の OID は、「.1.3.6.1.4.1.119.2.3.207」です。

- 必要に応じてSNMP 連携機能の動作に必要なライブラリへのシンボリックリンクを作成します。必要なシンボリックリンクは次の 3 つです。

libnetsnmp.so libnetsnmpagent.so libnetsnmphelpers.so

以下の手順に従い作成してください。

1. シンボリックリンクの有無を確認します。次のディレクトリに移動してください。/usr/lib64

上に示した3つのシンボリックリンクが存在するか確認してください。存在する場合、手順 5-2は必要ありません。手順 6 に進んでください。存在しない場合、手順 5-2 を実施してください。2. シンボリックリンクを作成します。以下のコマンドを実行してください。ln -s libnetsnmp.so.X libnetsnmp.so ln -s libnetsnmpagent.so.X libnetsnmpagent.so ln -s libnetsnmphelpers.so.X libnetsnmphelpers.so

X の部分は整数値を表します。環境により異なりますので確認して指定してください。

snmpd デーモンを起動します。

注釈

通常、以下のコマンドを実行することで起動できます。

init.d 環境の場合:

/etc/init.d/snmpd start

systemd 環境の場合:

systemctl start snmpd

参考

CLUSTERPRO Server をアンインストールする際は、必ずSNMP 連携機能の設定解除も行ってください。SNMP 連携機能の設定解除は、「 11.1.2. SNMP 連携機能の設定を解除するには 」を参照してください。

注釈

SNMP 通信に必要な設定はNet-SNMP snmpd デーモン側で行います。

5. ライセンスを登録する¶

5.1. CPU ライセンスの登録¶

構築するクラスタシステムを実際に動作させるには、CPU ライセンスを登録する必要があります。

参考

以下に CPU ライセンスに該当するライセンス製品名の一覧を記載します。

ライセンス製品名 |

製品ID |

|---|---|

CLUSTERPRO X 4.3 for Linux |

BASE43 |

CLUSTERPRO X High-End Server Option 4.3 for Linux |

MCHE43 |

CLUSTERPRO X SingleServerSafe 4.3 for Linux |

XSSS43 |

CLUSTERPRO X SingleServerSafe for Linux アップグレードライセンス |

UPGR43 |

CPU ライセンスの登録は、クラスタを構築しようとしているサーバのうち、マスタサーバとして設定しているサーバで行います。登録形式には、ライセンスシートに記載された情報を記載する方法と、ライセンスファイルを指定する方法の 2 つがあります。製品版、試用版それぞれの場合について説明します。

製品版

ライセンス管理コマンドのパラメータにライセンス ファイルを指定し、ライセンスを登録する。 (「5.1.2. ライセンスファイル指定によるライセンス登録を行うには (製品版、試用版共通)」を参照)

ライセンス管理コマンドを実行し、対話形式でライセンス製品に添付されたライセンス情報を入力しライセンスを登録する。 (「5.1.3. コマンドラインから対話形式でライセンスを登録するには (製品版)」 を参照)

試用版

ライセンス管理コマンドのパラメータにライセンスファイルを指定し、ライセンスを登録する。(「5.1.2. ライセンスファイル指定によるライセンス登録を行うには (製品版、試用版共通)」を参照)

5.1.1. CPU ライセンスの注意事項¶

CPUライセンスを使用する場合の注意事項を示します。

マスタサーバでCPUライセンスを登録した後、「6. クラスタ構成情報を作成する」におけるクラスタ構成情報の作成と反映は、マスタサーバに接続した Cluster WebUI から実施する必要があります。

5.1.2. ライセンスファイル指定によるライセンス登録を行うには (製品版、試用版共通)¶

クラスタシステムを構築しようとしているサーバの中で、マスタサーバとして設定しようとしているサーバに root でログイン可能である。

ライセンスファイルが、クラスタシステムを構築しようとしているサーバの中で、マスタサーバとして設定しようとしているサーバの任意の位置に存在している。

- クラスタを構築しようとしているサーバのうち、マスタサーバとして設定しようとしているサーバに root でログインし、以下のコマンドを実行します。

# clplcnsc -i filepath

-iオプションで指定するfilepathには、ファイル名を含むライセンスファイルへのパスを指定します。コマンド実行後、正常にコマンドが終了した場合は、コンソールに「License registration succeeded.」と表示されます。その他の終了メッセージが表示された場合は、『リファレンスガイド』の「CLUSTERPRO コマンドリファレンス」を参照してください。 以下のコマンドを実行し、ライセンスの登録状況を確認します。

# clplcnsc -l -a

オプション製品を使用する場合には「5.3. ノードライセンスの登録」に進んでください。

- オプション製品を使用しない場合には、この後、ライセンス登録を有効にしクラスタを稼動させるため全サーバを OS のシャットダウンコマンドで再起動してください。再起動後、次の「6. クラスタ構成情報を作成する」に進み、手順に従ってください。

注釈

OS の起動時に clusterpro_md がエラーになりますが無視してください。クラスタ環境が未構築のために出力されたものです。

5.1.3. コマンドラインから対話形式でライセンスを登録するには (製品版)¶

- 販売元から正式に入手したライセンスシートが手元にある。ライセンスシートは製品を購入すると販売元から送付されます。このライセンスシートに記載されている値を入力します。

クラスタシステムを構築しようとしているサーバの中で、マスタサーバとして設定しようとしているサーバに root でログイン可能である。

参考

本手順では、clplcnsc コマンドを使用します。clplcnsc コマンドの使用方法の詳細については、『リファレンスガイド』の「CLUSTERPRO コマンドリファレンス」を参照してください。

- ライセンスシートを手元に用意します。本ステップでは、添付されているライセンスシートが以下の場合を例にとり説明を行います。入力時には、お手元のライセンスシートに記載される値に置き換えてください。

製品名 CLUSTERPRO X 4.3 for Linux ライセンス情報 製品区分 製品版 ライセンスキー A1234567-B1234567-C1234567-D1234567 シリアルナンバー AAAAAAAA000000 CPU 数 2

クラスタを構築しようとしているサーバのうち、マスタサーバとして設定しようとしているサーバに root でログインし、以下のコマンドを実行します。

# clplcnsc -i

製品区分の入力を促す以下の文字列が表示されます。 License Version (製品区分) は1 の Product (製品版) ですので、1 と入力します。

Selection of License Version. 1 Product version 2 Trial version e Exit Select License Version. [1, 2, or e (default:1)]...1シリアル No. の入力を促す以下の文字列が表示されます。ライセンスシートに記載されているシリアル No. を入力します。大文字と小文字は区別されますので気をつけてください。

Enter serial number [Ex. XXXXXXXX000000]... AAAAAAAA000000

ライセンスキーの入力を促す以下の文字列が表示されます。ライセンスシートに記載されているライセンスキーを入力します。大文字と小文字は区別されますので気をつけてください。

Enter license key [XXXXXXXX-XXXXXXXX-XXXXXXXX-XXXXXXXX]... A1234567-B1234567-C1234567-D1234567コマンド実行後、正常にコマンドが終了した場合は、コンソールに「License registration succeeded.」と表示されます。その他の終了メッセージが表示された場合は、『リファレンスガイド』の「CLUSTERPRO コマンドリファレンス」を参照してください。登録したライセンスを確認します。以下のコマンドを実行します。

# clplcnsc -l -a

- オプション製品を使用する場合には「5.3. ノードライセンスの登録 」に進んでください。

- オプション製品を使用しない場合には、全サーバを OS のシャットダウンコマンドで再起動してください。再起動後、次の「6. クラスタ構成情報を作成する」に進み、手順に従ってください。

注釈

OS の起動時に clusterpro_md がエラーになりますが無視してください。クラスタ環境が未構築のために出力されたものです。

5.2. VM ノードライセンスの登録¶

ライセンス製品名 |

製品ID |

|---|---|

CLUSTERPRO X 4.3 for Linux VM |

BASE43 |

CLUSTERPRO X SingleServerSafe 4.3 for Linux VM |

XSSS43 |

CLUSTERPRO X SingleServerSafe for Linux VM アップグレードライセンス |

UPGR43 |

VM ノードライセンスの登録は、クラスタを構築しようとしているサーバのうち、仮想サーバ全てで行います。登録形式には、ライセンスシートに記載された情報を記載する方法と、ライセンスファイルを指定する方法の2つがあります。

製品版

ライセンス管理コマンドのパラメータにライセンスファイルを指定し、ライセンスを登録する。 (「5.1.2. ライセンスファイル指定によるライセンス登録を行うには (製品版、試用版共通)」を参照)

ライセンス管理コマンドを実行し、対話形式でライセンス製品に添付されたライセンス情報を入力しライセンスを登録する。 (「5.1.3. コマンドラインから対話形式でライセンスを登録するには (製品版)」 を参照)

試用版

ライセンス管理コマンドのパラメータにライセンスファイルを指定し、ライセンスを登録する。(「5.1.2. ライセンスファイル指定によるライセンス登録を行うには (製品版、試用版共通)」を参照)

5.2.1. ライセンスファイル指定によるライセンス登録を行うには (製品版、試用版共通)¶

クラスタシステムを構築しようとしているサーバの中で、仮想サーバに root でログイン可能である。

クラスタを構築しようとしているサーバのうち、仮想サーバに root でログインし、以下のコマンドを実行します。

# clplcnsc -i filepath

-iオプションで指定するfilepathには、ファイル名を含むライセンスファイルへのパスを指定します。

コマンド実行後、正常にコマンドが終了した場合は、コンソールに「License registration succeeded.」と表示されます。その他の終了メッセージが表示された場合は、『リファレンスガイド』の「CLUSTERPRO コマンドリファレンス」を参照してください。

以下のコマンドを実行し、ライセンスの登録状況を確認します。

# clplcnsc -l -a

クラスタ内で他に仮想サーバがあれば、同様の手順で VM ノードライセンスを登録します。

オプション製品を使用する場合には「 5.3. ノードライセンスの登録 」を参照してください。

- オプション製品を使用しない場合には、この後、ライセンス登録を有効にしクラスタを稼動させるため全サーバを OS のシャットダウンコマンドで再起動してください。再起動後、次の「6. クラスタ構成情報を作成する」に進み、手順に従ってください。

注釈

OS の起動時に clusterpro_md がエラーになりますが無視してください。クラスタ環境が未構築のために出力されたものです。

5.2.2. コマンドラインから対話形式でライセンスを登録するには (製品版)¶

- 販売元から正式に入手したライセンスシートが手元にある。ライセンスシートは製品を購入すると販売元から送付されます。このライセンスシートに記載されている値を入力します。

クラスタシステムを構築しようとしているサーバの中で、仮想サーバに root でログイン可能である。

参考

本手順では、clplcnsc コマンドを使用します。clplcnsc コマンドの使用方法の詳細については、『リファレンスガイド』の「CLUSTERPRO コマンドリファレンス」を参照してください。

- ライセンスシートを手元に用意します。本ステップでは、添付されているライセンスシートが以下の場合を例にとり説明を行います。入力時には、お手元のライセンスシートに記載される値に置き換えてください。

製品名 CLUSTERPRO X 4.3 for Linux VM ライセンス情報 製品区分 製品版 ライセンスキー A1234567-B1234567-C1234567-D1234567 シリアルナンバー AAAAAAAA000000 ライセンスサーバ数 1

クラスタを構築しようとしているサーバのうち、仮想サーバに root でログインし、以下のコマンドを実行します。

# clplcnsc -i

製品区分の入力を促す以下の文字列が表示されます。License Version (製品区分) は1 の Product (製品版) ですので、1 と入力します。

Selection of License Version. 1 Product version 2 Trial version e Exit Select License Version. [1, 2, or e (default:1)]...1シリアル No. の入力を促す以下の文字列が表示されます。ライセンスシートに記載されているシリアル No. を入力します。大文字と小文字は区別されますので気をつけてください。

Enter serial number [Ex. XXXXXXXX000000]... AAAAAAAA000000

ライセンスキーの入力を促す以下の文字列が表示されます。ライセンスシートに記載されているライセンスキーを入力します。大文字と小文字は区別されますので気をつけてください。

Enter license key [XXXXXXXX-XXXXXXXX-XXXXXXXX-XXXXXXXX]... A1234567-B1234567-C1234567-D1234567コマンド実行後、正常にコマンドが終了した場合は、コンソールに「License registration succeeded.」と表示されます。その他の終了メッセージが表示された場合は、『リファレンスガイド』の「CLUSTERPRO コマンドリファレンス」を参照してください。

登録したライセンスを確認します。以下のコマンドを実行します。

# clplcnsc -l -a

クラスタ内で他に仮想サーバがあれば、同様の手順で VM ライセンスを登録します。

オプション製品を使用する場合には「 5.3. ノードライセンスの登録 」を参照してください。

- オプション製品を使用しない場合には、全サーバを OS のシャットダウンコマンドで再起動してください。再起動後、次の「6. クラスタ構成情報を作成する」に進み、手順に従ってください。

注釈

OS の起動時に clusterpro_md がエラーになりますが無視してください。クラスタ環境が未構築のために出力されたものです。

5.3. ノードライセンスの登録¶

ライセンス製品名 |

製品ID |

|---|---|

CLUSTERPRO X Replicator 4.3 for Linux |

REPL43 |

CLUSTERPRO X Database Agent 4.3 for Linux |

DBAG43 |

CLUSTERPRO X Internet Server Agent 4.3 for Linux |

ISAG43 |

CLUSTERPRO X File Server Agent 4.3 for Linux |

FSAG43 |

CLUSTERPRO X Application Server Agent 4.3 for Linux |

ASAG43 |

CLUSTERPRO X Java Resource Agent 4.3 for Linux |

JRAG43 |

CLUSTERPRO X System Resource Agent 4.3 for Linux |

SRAG43 |

CLUSTERPRO X Alert Service 4.3 for Linux |

ALRT43 |

CLUSTERPRO X Replicator DR 4.3 for Linux |

RPDR43 |

CLUSTERPRO X Replicator DR 4.3 for Linuxアップグレードライセンス |

RPUP43 |

ノードライセンスの登録は、クラスタを構築するサーバのうち、オプション製品を使用するサーバで行います。登録形式には、ライセンスシートに記載された情報を記載する方法と、ライセンスファイルを指定する方法の 2 つがあります。製品版、試用版それぞれの場合について説明します。

製品版

ライセンス管理コマンドのパラメータにライセンスファイルを指定し、ライセンスを登録する。(「5.1.2. ライセンスファイル指定によるライセンス登録を行うには (製品版、試用版共通)」を参照)

ライセンス管理コマンドを実行し、対話形式でライセンス製品に添付されたライセンス情報を入力しライセンスを登録する。

試用版

ライセンス管理コマンドのパラメータにライセンスファイルを指定し、ライセンスを登録する。(「5.1.2. ライセンスファイル指定によるライセンス登録を行うには (製品版、試用版共通)」を参照)

5.3.1. ライセンスファイル指定によるライセンス登録を行うには (製品版、試用版共通)¶

クラスタシステムを構築しようとしているサーバの中で、オプション製品を使用しようとしているサーバに root でログイン可能である。

クラスタを構築しようとしているサーバのうち、オプション製品を使用しようとしているサーバに root でログインし、以下のコマンドを実行します。

# clplcnsc -i filepath

-iオプションで指定するfilepathには、ファイル名を含むライセンスファイルへのパスを指定します。

注釈

オプション製品のライセンスがインストールされていない場合、ライセンスに対応するリソース・モニタリソースはCluster WebUIの一覧に表示されません。ライセンスが登録されている状態で一覧に表示されない場合や、Cluster WebUI を起動した後でライセンスを登録した場合は、 [ライセンス情報取得] ボタンを押してください。コマンド実行後、正常にコマンドが終了した場合は、コンソールに「License registration succeeded.」と表示されます。その他の終了メッセージが表示された場合は、『リファレンスガイド』の「CLUSTERPRO コマンドリファレンス」を参照してください。以下のコマンドを実行し、ライセンスの登録状況を確認します。

# clplcnsc -l -a

- クラスタ内で他にオプション製品を使用するサーバがあれば、同様の手順でノードライセンスを登録します。Replicator / Replicator DR のライセンスは両方のサーバで登録してください。

- この後、ライセンス登録を有効にしクラスタを稼動させるため、全サーバを OS のシャットダウンコマンドで再起動してください。再起動後、「6. クラスタ構成情報を作成する」に進み、手順に従ってください。

注釈

OS の起動時に clusterpro_md がエラーになりますが無視してください。クラスタ環境が未構築のために出力されたものです。注釈

クラスタとして運用を開始した後に Replicator / Replicator DR のライセンスを登録した場合には、クラスタシャットダウン、リブートを実行してください。リブート後から Replicator / Replicator DR が使用できます。

5.3.2. コマンドラインから対話形式でノードライセンスを登録するには (製品版)¶

販売元から正式に入手したライセンスシートが手元にある。ライセンスシートは製品を購入すると販売元から送付されます。ノードライセンスのライセンスシートはオプション製品を使用しようとしているサーバの台数分必要です。このライセンスシートに記載されている値を入力します。

クラスタシステムを構築しようとしているサーバの中で、オプション製品を使用しようとしているサーバに root でログイン可能である。

参考

本手順では、clplcnsc コマンドを使用します。clplcnsc コマンドの使用方法の詳細については、『リファレンスガイド』の「CLUSTERPRO コマンドリファレンス」を参照してください。

- ライセンスシートを手元に用意します。本ステップでは、添付されているライセンスシートが以下 (Replicator) の場合を例にとり説明を行います。入力時には、お手元のライセンスシートに記載される値に置き換えてください。

製品名 CLUSTERPRO X Replicator 4.3 for Linux ライセンス情報 製品区分 製品版 ライセンスキー A1234567-B1234567-C1234567-D1234567 シリアルナンバー AAAAAAAA000000 ノード数 1

クラスタを構築しようとしているサーバのうち、オプション製品を使用しようとして設定しようとしているサーバに root でログインし、以下のコマンドを実行します。

# clplcnsc -i

注釈

オプション製品のライセンスがインストールされていない場合、ライセンスに対応するリソース・モニタリソースはCluster WebUIの一覧に表示されません。

製品区分の入力を促す以下の文字列が表示されます。License Version (製品区分) は1 の Product (製品版) ですので、1 と入力します。

Selection of License Version. 1 Product Version 2 Trial Version e Exit Select License Version. [1, 2, or e (default:1)]...1シリアル No. の入力を促す以下の文字列が表示されます。ライセンスシートに記載されているシリアル No. を入力します。大文字と小文字は区別されますので気をつけてください。

Enter serial number [Ex. XXXXXXXX000000]... AAAAAAAA000000

ライセンスキーの入力を促す以下の文字列が表示されます。ライセンスシートに記載されているライセンスキーを入力します。大文字と小文字は区別されますので気をつけてください。

Enter license key [XXXXXXXX-XXXXXXXX-XXXXXXXX-XXXXXXXX]... A1234567-B1234567-C1234567-D1234567コマンド実行後、正常にコマンドが終了した場合は、コンソールに「License registration succeeded.」と表示されます。その他の終了メッセージが表示された場合は、『リファレンスガイド』の「CLUSTERPRO コマンドリファレンス」を参照してください。登録したライセンスを確認します。以下のコマンドを実行します。

# clplcnsc -l -a

- クラスタ内で他にオプション製品を使用するサーバがあれば、同様の手順でノードライセンスを登録します。Replicator / Replicator DR のライセンスは両方のサーバで登録してください。

- この後、ライセンス登録を有効にしクラスタを稼動させるため、全サーバを OS のシャットダウンコマンドで再起動してください。再起動後、次の「6. クラスタ構成情報を作成する」に進み、手順に従ってください。

注釈

OS の起動時に clusterpro_md がエラーになりますが無視してください。クラスタ環境が未構築のために出力されたものです。

注釈

クラスタとして運用を開始した後に Replicator / Replicator DR のライセンスを登録した場合には、クラスタシャットダウン、リブートを実行してください。リブート後から Replicator / Replicator DR が使用できます。

5.4. 期限付きライセンスの登録¶

本体製品

ライセンス製品名 |

製品ID |

|---|---|

CLUSTERPRO X 4.3 for Linux |

BASE43 |

オプション製品

ライセンス製品名 |

製品ID |

|---|---|

CLUSTERPRO X Replicator 4.3 for Linux |

REPL43 |

CLUSTERPRO X Database Agent 4.3 for Linux |

DBAG43 |

CLUSTERPRO X Internet Server Agent 4.3 for Linux |

ISAG43 |

CLUSTERPRO X File Server Agent 4.3 for Linux |

FSAG43 |

CLUSTERPRO X Application Server Agent 4.3 for Linux |

ASAG43 |

CLUSTERPRO X Java Resource Agent 4.3 for Linux |

JRAG43 |

CLUSTERPRO X System Resource Agent 4.3 for Linux |

SRAG43 |

CLUSTERPRO X Alert Service 4.3 for Linux |

ALRT43 |

CLUSTERPRO X Replicator DR 4.3 for Linux |

RPDR43 |

期限付きライセンスの登録は本体製品、オプション製品に関わらず、クラスタを構築しようとしているサーバのうち、マスタサーバとして設定しているサーバで行います。ライセンスの登録はライセンスファイルを指定することで行います。

ライセンス登録の手順は「 5.4.2. 期限付きライセンスを登録するには 」を参照してください。

5.4.1. 期限付きライセンスの注意事項¶

期限付きライセンスを使用する場合の注意事項を示します。

クラスタ内の一部のサーバのみに期限付きライセンスを登録し、運用することはできません。

マスタサーバでライセンスを登録した後、「6. クラスタ構成情報を作成する」におけるクラスタ構成情報の作成と反映は、マスタサーバに接続した Cluster WebUI から実施する必要があります。

期限付きライセンスは、クラスタを構成するサーバ台数以上のライセンスが必要です。

クラスタの運用開始後、期限付きライセンスを追加する場合も、マスタサーバ上でライセンスを登録する必要があります。

一度有効化された期限付きライセンスは、サーバ削除、サーバ交換、ライセンス削除した場合は期限内であっても再登録することはできません。

5.4.2. 期限付きライセンスを登録するには¶

クラスタシステムを構築しようとしているサーバの中で、マスタサーバとして設定しようとしているサーバに root でログイン可能である。

使用する製品の全てのライセンスファイルが、クラスタシステムを構築しようとしているサーバの中で、マスタサーバとして設定しようとしているサーバの任意の位置に存在している。

以下の手順で、使用する製品の全てのライセンスファイルを登録します。

クラスタを構築しようとしているサーバのうち、マスタサーバとして設定しようとしているサーバに root でログインし、以下のコマンドを実行します。

# clplcnsc -i filepath

-iオプションで指定するfilepathには、ファイル名を含むライセンスファイルへのパスを指定します。

注釈

オプション製品のライセンスがインストールされていない場合、ライセンスに対応するリソース・モニタリソースはCluster WebUIの一覧に表示されません。ライセンスが登録されている状態で一覧に表示されない場合や、Cluster WebUI を起動した後でライセンスを登録した場合は、 [ライセンス情報取得] ボタンを押してください。コマンド実行後、正常にコマンドが終了した場合は、コンソールに「License registration succeeded.」と表示されます。その他の終了メッセージが表示された場合は、『リファレンスガイド』の「CLUSTERPRO コマンドリファレンス」を参照してください。期限切れに備え、同一製品のライセンスファイルを複数入手している場合、同様の手順でコマンドを実行し、余剰分のライセンスを登録します。その他に使用する製品がある場合、手順 1 を繰り返します。

以下のコマンドを実行し、ライセンスの登録状況を確認します。

# clplcnsc -l -a

注釈

クラスタ環境が未構築の場合はライセンスが 「inactive」 状態となりますが、クラスタの構築完了後に有効化されるため問題ありません。

- ライセンス登録を有効にしクラスタを稼動させるため全サーバを OS のシャットダウンコマンドで再起動してください。再起動後、次の「6. クラスタ構成情報を作成する」に進み、手順に従ってください。

注釈

OS の起動時に clusterpro_md がエラーになりますが無視してください。クラスタ環境が未構築のために出力されたものです。

注釈

クラスタとして運用を開始した後に Replicator / Replicator DR のライセンスを登録した場合には、クラスタシャットダウン、リブートを実行してください。リブート後から Replicator / Replicator DR が使用できます。

6. クラスタ構成情報を作成する¶

CLUSTERPRO では、クラスタシステムの構成内容を記述するデータのことを、クラスタ構成情報と呼びます。Cluster WebUI を用いてクラスタ構成情報を作成します。本章では、Cluster WebUI の起動方法、およびクラスタ構成情報の作成手順をサンプルの構成例を用いて説明します。

本章で説明する項目は以下のとおりです。

6.1. クラスタ構成情報を作成する¶

6.2. Cluster WebUI を起動する¶

クラスタ構成情報を作成するには、Cluster WebUIにアクセスする必要があります。ここでは、まず Cluster WebUI の概要を説明し、その後、クラスタ構成情報を作成する方法について説明します。

参考

Cluster WebUI の動作環境については、『スタートアップガイド』の「CLUSTERPRO の動作環境」を参照してください。

6.2.1. Cluster WebUI とは¶

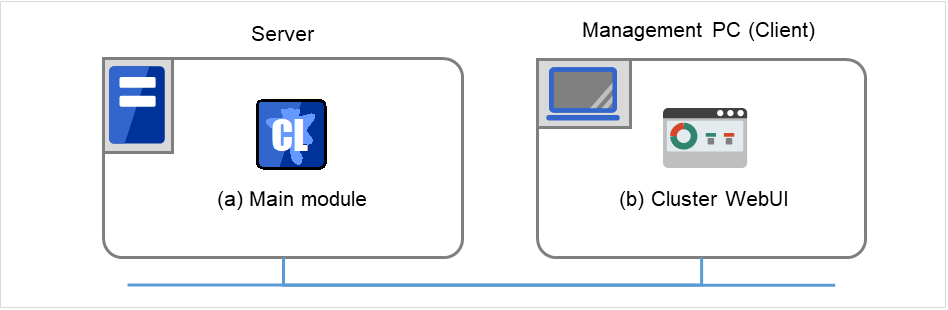

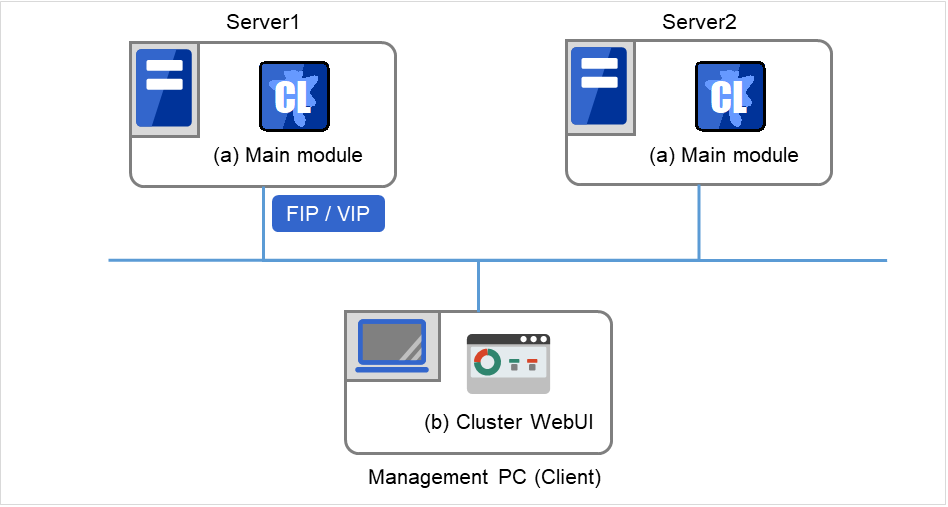

Cluster WebUI とは、Web ブラウザ経由でクラスタの設定と状態監視、サーバ/グループの起動/停止及び、クラスタ動作ログの収集などを行うための機能です。以下の図に Cluster WebUI の概要を示します。

CLUSTERPRO Server (Main module)

Cluster WebUI

図 6.1 Cluster WebUI¶

図の2台のサーバにはCLUSTERPROがインストールされています。管理用PC(Management PC)上のウェブブラウザを使っていずれかのサーバに接続すると、Cluster WebUIの画面が表示されます。 この際の接続先としては、管理グループのフローティングIP(FIP)アドレス、または仮想IP(VIP)アドレスを指定します。

6.2.2. Cluster WebUI がサポートしているブラウザ¶

Cluster WebUIの動作確認済 OS、動作確認済ブラウザ、必要メモリ容量/ディスク容量などの最新の動作環境情報については、『スタートアップガイド』を参照してください。

6.2.3. Cluster WebUI を起動するには¶

Cluster WebUI を起動する手順を示します。

Web ブラウザを起動します。

ブラウザのアドレスバーに、CLUSTERPRO Serverをインストールしたサーバの実 IP アドレスとポート番号を入力します。

http://ip-address:port/

- ip-address

インストール直後は管理グループが存在しないため、クラスタを構成する1台目のサーバの実IPアドレスを指定します。

- port

インストール時に指定したWebManagerのポート番号と同じ番号を指定します(既定値29003)。

Cluster WebUI が起動します。クラスタ構成情報を作成する場合、ツールバーのドロップダウンメニューで [設定モード] を選択してください。

[クラスタ生成ウィザード] をクリックしてウィザードを開始します。

参考

CLUSTERPRO サーバと暗号化通信を有効にして接続する場合は、『リファレンスガイド』の「パラメータの詳細」 - 「クラスタプロパティ」 - 「WebManagerタブ」を参照してください。暗号化通信を行う場合は下記を入力します。

https://ip-address:29003/

6.3. 2 ノードクラスタ環境の設定値を確認する¶

クラスタ生成ウィザードを使用して実際にクラスタ構成情報を作成する前に、クラスタ構成情報として設定する値を確認します。値を書き出して、クラスタが効果的に作成されているか、情報に漏れがないかを確認しておきましょう。

6.3.1. クラスタ環境のサンプル¶

本章では、以下の図に記載されている、典型的な 2 ノードのクラスタ環境を構築する場合を例にとって説明を行います。

6.3.1.1. ディスクリソース使用時¶

図 6.2 2 ノードクラスタの例(ディスクリソース使用時)¶

FIP1 |

10.0.0.11

(Cluster WebUIクライアントからのアクセス先)

|

FIP2 |

10.0.0.12

(業務クライアントからのアクセス先)

|

NIC1-1 |

192.168.0.1 |

NIC1-2 |

10.0.0.1 |

NIC2-1 |

192.168.0.2 |

NIC2-2 |

10.0.0.2 |

RS-232C デバイス |

/dev/ttyS0 |

共有ディスク (Shared disk)

DISKハートビート

デバイス名

/dev/sdb1

共有ディスクデバイス

/dev/sdb2

マウントポイント

/mnt/sdb2

ファイルシステム

ext3

ディスクモニタ設定

デバイス名

/dev/sdb1

監視対象Rawデバイス名

(空欄)

監視方法

read(O_DIRECT)

6.3.1.2. ミラーディスクリソース使用時¶

図 6.3 2 ノードクラスタの例(ミラーディスクリソース使用時)¶

FIP1 |

10.0.0.11

(Cluster WebUIクライアントからのアクセス先)

|

FIP2 |

10.0.0.12

(業務クライアントからのアクセス先)

|

NIC1-1 |

192.168.0.1 |

NIC1-2 |

10.0.0.1 |

NIC2-1 |

192.168.0.2 |

NIC2-2 |

10.0.0.2 |

RS-232C デバイス |

/dev/ttyS0 |

ミラーディスクリソース設定

データパーティション

/dev/sdb2

クラスタパーティション

/dev/sdb1

マウントポイント

/mnt/sdb2

ファイルシステム

ext3

ディスクモニタ設定

デバイス名

/dev/sdb1

監視対象Rawデバイス名

(空欄)

監視方法

read(O_DIRECT)

6.3.1.3. 遠隔構成 ミラーディスクリソース使用時¶

図 6.4 2 ノードクラスタの例(遠隔構成ミラーディスクリソース使用時)¶

FIP1 |

10.0.0.11

(Cluster WebUIクライアントからのアクセス先)

|

FIP2 |

10.0.0.12

(業務クライアントからのアクセス先)

|

NIC1 |

10.0.0.1 |

NIC2 |

10.0.0.2 |

ミラーディスクリソース設定

データパーティション

/dev/sdb2

クラスタパーティション

/dev/sdb1

マウントポイント

/mnt/sdb2

ファイルシステム

ext3

ディスクモニタ設定

デバイス名

/dev/sdb1

監視対象Rawデバイス名

(空欄)

監視方法

read(O_DIRECT)

※ この構成はWANがレイヤー2タイプの場合(拠点間で同一ネットワークアドレスを使用できる)の例です。

6.3.1.4. ボリュームマネージャリソース使用時¶

図 6.5 2 ノードクラスタの例(ボリュームマネージャリソース使用時)¶

FIP1: Cluster WebUIクライアントからのアクセス先

FIP2: 業務クライアントからのアクセス先

以下に、上図のクラスタシステムを構築するためのクラスタ構成情報のサンプル値を記載します。以降のトピックでは、この条件でクラスタ構成情報を作成する手順をステップバイステップで説明します。実際に値を設定する際には、構築するクラスタの構成情報と置き換えて入力してください。値の決定方法については、『リファレンスガイド』を参照してください。

2 ノードの構成設定例

設定対象

設定パラメータ

設定値(ディスクリソース使用時)

設定値(ミラーディスクリソース使用時)

設定値(遠隔構成ミラーディスクリソース使用時)

設定値(ボリュームマネージャリソース使用時)

クラスタ構成

クラスタ名

cluster

cluster

cluster

cluster

サーバ数

2

2

2

2

フェイルオーバグループ数

2

2

2

2

モニタリソース数

4

6

6

5

ハートビートリソース

カーネルモードLAN ハートビート数

2

2

1

2

COM ハートビート数

1

1

0

1

ディスクハートビート数

1

0

0

1

NPリソース

PingNP

0

0

1

0

1 台目のサーバの情報(マスタサーバ)

サーバ名 1

server1

server1

server1

server1

インタコネクトの IP アドレス(専用)

192.168.0.1 (NIC1-1)

192.168.0.1 (NIC1-1)

10.0.0.1 (NIC1-2)

192.168.0.1 (NIC1-1)

インタコネクトの IP アドレス(バックアップ)

10.0.0.1 (NIC1-2)

10.0.0.1 (NIC1-2)

10.0.0.1 (NIC1-2)

パブリックの IP アドレス

10.0.0.1 (NIC1-2)

10.0.0.1 (NIC1-2)

10.0.0.1 (NIC1-2)

10.0.0.1 (NIC1-2)

COM ハートビート デバイス

/dev/ttyS0

/dev/ttyS0

-

/dev/ttyS0

ディスクハートビートデバイス

/dev/sdb1

-

-

/dev/sdb1

ミラーディスクコネクト

-

192.168.0.1 (NIC1-1)

10.0.0.1 (NIC1-2)

-

2 台目のサーバの情報

サーバ名 1

server2

server2

server2

server2

インタコネクトの IP アドレス(専用)

192.168.0.2 (NIC2-1)

192.168.0.2 (NIC2-1)

10.0.0.2 (NIC2-2)

192.168.0.2 (NIC2-1)

インタコネクトの IP アドレス(バックアップ)

10.0.0.2 (NIC2-2)

10.0.0.2 (NIC2-2)

-

10.0.0.2 (NIC2-2)

パブリックの IP アドレス

10.0.0.2 (NIC2-2)

10.0.0.2 (NIC2-2)

10.0.0.2 (NIC2-2)

10.0.0.2 (NIC2-2)

COM ハートビートデバイス

/dev/ttyS0

/dev/ttyS0

-

/dev/ttyS0

ディスクハートビートデバイス

/dev/sdb1

-

-

/dev/sdb1

ミラーディスクコネクト

192.168.0.2 (NIC2-1)

10.0.0.2 (NIC2-2)

管理用のグループ(Cluster WebUI 用)

タイプ

フェイルオーバ

フェイルオーバ

フェイルオーバ

フェイルオーバ

グループ名

ManagementGroupManagementGroupManagementGroupManagementGroup起動サーバ

全てのサーバ

全てのサーバ

全てのサーバ

全てのサーバ

グループリソース数

1

1

1

1

管理用グループのグループリソース 2

タイプ

フローティング IP リソース

フローティング IP リソース

フローティング IP リソース

フローティング IP リソース

グループリソース名

ManagementIP

ManagementIP

ManagementIP

ManagementIP

IP アドレス

10.0.0.11 (FIP1)

10.0.0.11 (FIP1)

10.0.0.11 (FIP1)

10.0.0.11 (FIP1)

業務用のグループ

タイプ

フェイルオーバ

フェイルオーバ

フェイルオーバ

フェイルオーバ

グループ名

failover1

failover1

failover1

failover1

起動サーバ

全てのサーバ

全てのサーバ

全てのサーバ

全てのサーバ

グループリソース数

3

3

3

4

1 つ目のグループリソース

タイプ

フローティング IP リソース

フローティング IP リソース

フローティング IP リソース

フローティング IP リソース

グループリソース名

fip1

fip1

fip1

fip1

IP アドレス

10.0.0.12 (FIP2)

10.0.0.12 (FIP2)

10.0.0.12 (FIP2)

10.0.0.12 (FIP2)

2 つ目のグループリソース

タイプ

ディスクリソース

ミラーディスクリソース

ミラーディスクリソース

ディスクリソース

グループリソース名

disk1

md1

md1

disk1

ディスクタイプ

disk

lvm

ファイルシステム

ext3

ext3

デバイス名

/dev/sdb2

/dev/dg1/lv1

マウントポイント

/mnt/sdb2

/mnt/disk1

ミラーパーティションデバイス名

/dev/NMP1

/dev/NMP1

マウントポイント

/mnt/sdb2

/mnt/sdb2

データパーティションデバイス名

/dev/sdb2

/dev/sdb2

クラスタパーティションデバイス名

/dev/sdb1

/dev/sdb1

ファイルシステム

ext3

ext3

3 つ目のグループリソース

タイプ

EXEC リソース

EXEC リソース

EXEC リソース

EXEC リソース

グループリソース名

exec1

exec1

exec1

exec1

スクリプト

標準スクリプト

標準スクリプト

標準スクリプト

標準スクリプト

4 つ目のグループリソース(ボリュームマネージャ利用時のみ)

タイプ

ボリュームマネージャリソース

グループリソース名

volmgr1

ボリュームマネージャ

lvm

ターゲット名

vg1

1 つ目のモニタリソース(デフォルト作成)

タイプ

ユーザ空間モニタ

ユーザ空間モニタ

ユーザ空間モニタ

ユーザ空間モニタ

モニタリソース名

userw

userw

userw

userw

2 つ目のモニタリソース

タイプ

ディスクモニタ

ディスクモニタ

ディスクモニタ

ディスクモニタ

モニタリソース名

diskw1

diskw1

diskw1

diskw1

デバイス名

/dev/sdb1

/dev/sdb1

/dev/sdb1

/dev/vg1/lv1

監視対象Rawデバイス名-

-

-

-

監視方法

read(O_DIRECT)read(O_DIRECT)read(O_DIRECT)read(O_DIRECT)監視タイミング

常時

常時

常時

活性時

監視対象

-

-

-

volmgr1

異常検出時

クラスタサービス停止と OSシャットダウンクラスタサービス停止と OSシャットダウンクラスタサービス停止と OSシャットダウンクラスタサービス停止と OSシャットダウン3 つ目のモニタリソース(ManagementIPリソース作成後自動作成)

タイプ

フローティング IP モニタ

フローティング IP モニタ

フローティング IP モニタ

フローティング IP モニタ

モニタリソース名

fipw1

fipw1

fipw1

fipw1

監視対象

ManagementIP

ManagementIP

ManagementIP

ManagementIP

異常検出時

"Management Group"グループのフェイルオーバ 3

"Management Group"グループのフェイルオーバ 3

"Management Group"グループのフェイルオーバ 3

"Management Group"グループのフェイルオーバ 3

4 つ目のモニタリソース(fip1リソース作成後自動作成)

タイプ

フローティング IP モニタ

フローティング IP モニタ

フローティング IP モニタ

フローティング IP モニタ

モニタリソース名

fipw2

fipw2

fipw2

fipw2

監視対象

fip1

fip1

fip1

fip1

異常検出時

5 つ目のモニタリソース

タイプ

IP モニタ

IP モニタ

IP モニタ

IP モニタ

モニタリソース名

ipw1

ipw1

ipw1

ipw1

監視 IP アドレス

10.0.0.254(ゲートウェイ)10.0.0.254(ゲートウェイ)10.0.0.254(ゲートウェイ)10.0.0.254(ゲートウェイ)異常検出時

全グループのフェイルオーバ 3全グループのフェイルオーバ 3全グループのフェイルオーバ 3全グループのフェイルオーバ 36 つ目のモニタリソース(ミラーディスクリソース作成後自動作成)

タイプ

ミラーディスクコネクトモニタ

ミラーディスクコネクトモニタ

モニタリソース名

mdnw1

mdnw1

監視ミラーディスクリソースmd1

md1

異常検出時

何もしない

何もしない

7 つ目のモニタリソース(ミラーディスクリソース作成後自動作成)

タイプ

ミラーディスクモニタ

ミラーディスクモニタ

モニタリソース名

mdw1

mdw1

監視ミラーディスクリソース

md1

md1

異常検出時

何もしない

何もしない

8 つ目のモニタリソース(ボリュームマネージャ利用時のみ、ボリュームマネージャリソース作成後自動作成)

タイプ

ボリュームマネージャモニタ

モニタリソース名

volmgrw1

ボリュームマネージャ

lvm

ターゲット名

vg1

監視タイミング

活性時

監視対象

volmgr1

1 つ目のPingNPリソース

リソース名

xxxx

監視先1

xxxx

監視先2

xxxx

6.4. 2 ノードクラスタ構成情報の作成手順¶

クラスタ構成情報を作成するには、基本的に、クラスタの作成、グループの作成、モニタリソースの作成の 3 つのステップを踏みます。以下に手順の流れを示します。

注釈

クラスタ構成情報の操作は何度でも繰り返して行えます。また、設定した内容のほとんどは名称変更機能やプロパティ表示機能を使用して後から変更できます。

-

クラスタの生成、サーバの追加を行います。

「6.4.1.3. ネットワーク構成を設定する」:クラスタを構築するサーバ間のネットワーク構成を設定します。

- 「6.4.1.4. ネットワークパーティション解決処理を設定する」:ネットワークパーティション解決リソースを設定します。

-

フェイルオーバを行う際の単位である、フェイルオーバグループを作成します。

「6.4.2.1. フェイルオーバグループを追加する」:フェイルオーバの単位となる、グループを追加します。

「6.4.2.2. グループリソース (フローティング IP リソース) を追加する」:グループを構成するリソースを追加します。

「6.4.2.3. グループリソース (ボリュームマネージャリソース) を追加する」:グループを構成するリソースを追加します。

「6.4.2.4. グループリソース (ディスクリソース) を追加する」:ディスクリソースを使用する場合グループを構成するリソースを追加します。

「6.4.2.5. グループリソース (ミラーディスクリソース) を追加する」:ミラーディスクリソースを使用する場合グループを構成するリソースを追加します。

- 「6.4.2.6. グループリソース (EXEC リソース) を追加する」:グループを構成するリソースを追加します。

-

指定された監視対象を監視する、モニタリソースをクラスタ内に追加します。

「6.4.3.1. モニタリソース (ディスクモニタ) を追加する」:使用するモニタリソースを追加します。

- 「6.4.3.2. モニタリソース (IP モニタ) を追加する」:使用するモニタリソースを追加します。

-

クラスタ動作を有効、または無効にします。

6.4.1. クラスタの作成¶

まず、クラスタを作成します。作成したクラスタに、クラスタを構成するサーバを追加し、優先度とハートビートの優先度を決定します。

6.4.1.1. クラスタを追加する¶

[クラスタ生成ウィザード] の [クラスタ] 画面で、 [言語] フィールドをクリックして、Cluster WebUI を使用するマシンの OS で使用している言語を選択します。

注釈

1 つのクラスタ内で使用できる言語は 1 つのみです。複数の言語の OS をクラスタ内で使用している場合は、文字化けを避けるために「英語」を指定してください。

[クラスタ名] ボックスにクラスタ名 (cluster) を入力します。

- Cluster WebUI の接続に使用するフローティング IP アドレス (10.0.0.11) を [管理IPアドレス] ボックスに入力します。[次へ] をクリックします。サーバの[基本設定] 画面が表示されます。Cluster WebUI 起動時に URL で指定した IP アドレスのサーバ (server1) が一覧に登録されています。

6.4.1.2. サーバを追加する¶

クラスタを構成する 2 台目のサーバを追加します。

[サーバの定義一覧] で [追加] をクリックします。

[サーバ追加] ダイアログボックスが開きます。 2 台目のサーバのサーバ名か FQDN 名、または IP アドレスを入力し、[OK] を押します。 [サーバの定義一覧] に 2 台目のサーバ (server2) が追加されます。

[次へ] をクリックします。

6.4.1.3. ネットワーク構成を設定する¶

クラスタを構成するサーバ間のネットワーク構成を設定します。

[追加]・[削除] で通信経路を追加・削除し、各サーバの列のセルをクリックし IPアドレスを選択または入力してください。一部のサーバが接続されていない通信経路の場合は、接続されていないサーバのセルを空欄にしてください。

- ハートビートの送受信に使用する通信経路 (インタコネクト) は、[種別] 列のセルをクリックして、[カーネルモード] を選択してください。ハートビートに使用せず、ミラーディスク リソースやハイブリッドディスクリソースのデータミラーリング通信にのみ使用する場合は、 [ミラー通信専用] を選択してください。必ず一つ以上の通信経路をインタコネクトに設定する必要があります。なるべく全ての通信経路をインタコネクトに設定してください。なお、インタコネクトを複数設定する場合、[優先度] 列の番号が小さい通信経路が優先的にクラスタサーバ間の内部通信に使用されます。優先度を変更する場合は、矢印で通信経路の順位を変更してください。

COM ハートビートを使用する場合、[種別] 列のセルをクリックして、[COM] を選択してください。[サーバ名] 列のセルをクリックして COMデバイスを選択または入力してください。COM ハートビートを使用しないサーバは、[サーバ名] 列のセルを空白にしてください。

DISK ハートビートを使用する場合、[種別] 列のセルをクリックして、[DISK] を選択してください。[サーバ名]列のセルをクリックしてディスクデバイスを選択または入力してください。DISK ハートビートを使用しないサーバは、[サーバ名] 列のセルを空白にしてください。

BMC ハートビートを使用する場合、[種別] 列のセルをクリックし、[BMC] を選択してください。[サーバ名] 列のセルをクリックして BMC の IP アドレスを入力してください。BMC ハートビートを使用しないサーバは、[サーバ名] 列のセルを空白にしてください。

Witness ハートビートを使用する場合、[種別] 列のセルをクリックし、[Witness] を選択してください。[プロパティ] ボタンをクリックして、[ターゲットホスト] に Witness サーバのサーバアドレスを入力し、[サービスポート] にポート番号を入力してください。Witness ハートビートを使用しないサーバは、そのサーバのセルをクリックして [使用しない] を選択してください。

ミラーディスクリソースのデータミラーリング通信に使用する通信経路 (ミラーディスクコネクト) は、[MDC] 列のセルをクリックして、その通信経路に割り当てるミラーディスクコネクト名 (mdc1~mdc16) を選択してください。データミラーリング通信に使用しない通信経路は [使用しない] を選択してください。

[次へ] をクリックします。

6.4.1.4. ネットワークパーティション解決処理を設定する¶

ネットワークパーティション解決リソースを設定します。

- PING 方式の NP 解決を行う場合、[追加] をクリックして [NP解決一覧] に行を追加し、[種別] 列のセルをクリックして [Ping] を選択し、[Pingターゲット] 列のセルをクリックして各サーバのセルをクリックして ping 送信の対象とする機器 (ゲートウェイ等) の IP アドレスを入力します。カンマ区切りで複数の IP アドレスを入力すると、その全てに ping応答がない場合にネットワークから孤立した状態と判断します。一部のサーバのみ PING 方式を使用する場合、使用しないサーバのセルを [使用しない] にしてください。ping 関連のパラメータを既定値から変更する必要がある場合は、[プロパティ] を選択して、[Ping NPのプロパティ] ダイアログで設定します。本章の設定例では、PING 方式の行を1つ追加し、[Pingターゲット] に 192.168.0.254を設定します。

- HTTP 方式の NP 解決を行う場合、[追加] をクリックして [NP 解決一覧] に行を追加し、[種別] 列のセルをクリックして [HTTP/HTTPS] を選択してください。[プロパティ] ボタンをクリックして、[ターゲットホスト] に Web サーバのサーバアドレスを入力し、[サービスポート] にポート番号を入力してください。一部のサーバのみ HTTP 方式を使用する場合、使用しないサーバのセルを [使用しない] にしてください。本章の設定例では、HTTP 方式は使用しません。

- [調整] を選択し、ネットワークパーティション検出時の動作を設定します。[クラスタサービス停止と OS シャットダウン] か [クラスタサービス停止] を選択し、[OK] を押します。本章の設定例では、[クラスタサービス停止] を選択します。

[次へ] をクリックします。

6.4.2. フェイルオーバグループの作成¶

クラスタに、業務用のアプリケーションを実行するフェイルオーバグループ (以下「グループ」と省略する場合あり) を追加します。

6.4.2.1. フェイルオーバグループを追加する¶

障害発生時にフェイルオーバを行う単位となる、グループの設定を行います。

[グループ一覧] で [追加] をクリックします。

- [グループの定義] 画面が開きます。[名前] ボックスにグループ名 (failover1) を入力し、[次へ] をクリックします。

フェイルオーバグループが起動可能なサーバを設定します。本章の設定例では、共有ディスク及びミラーディスクを使用する場合、[全てのサーバでフェイルオーバ可能] チェックボックスをオンにします。

- フェイルオーバグループの各属性値を設定します。本章の設定例では、全て既定値を使用しますので、そのまま [次へ] をクリックします。[グループリソース] が表示されます。

6.4.2.2. グループリソース (フローティング IP リソース) を追加する¶

「6.8.2.1. フェイルオーバグループ (業務用1) を追加する」 で作成したフェイルオーバグループに、グループの構成要素であるグループリソースを追加します。

[グループリソース一覧] で、[追加] をクリックします。

[グループのリソース定義 | failover1] 画面が開きます。[タイプ] ボックスでグループリソースのタイプ (フローティング IP リソース) を選択し、[名前] ボックスにグループリソース名 (fip1) を入力します。[次へ] をクリックします。

依存関係設定のページが表示されます。何も指定せず [次へ] をクリックします。

[活性異常検出時の復旧動作]、[非活性異常検出時の復旧動作] が表示されます。[次へ] をクリックします。

[IP アドレス] ボックスに IP アドレス (10.0.0.12) を入力し [完了] をクリックします。

6.4.2.3. グループリソース (ボリュームマネージャリソース) を追加する¶

クラスタ環境がボリュームマネージャ使用時の場合は、ボリュームマネージャをグループリソースとして追加します。

[グループリソース一覧] で [追加] をクリックします。

[グループのリソース定義 | failover1] 画面が開きます。[タイプ] ボックスでグループリソースのタイプ (ボリュームマネージャリソース) を選択し、[名前] ボックスにグループリソース名 (volmgr1) を入力します。[次へ] をクリックします。

依存関係設定のページが表示されます。何も指定せず [次へ] をクリックします。

- [活性異常検出時の復旧動作]、[非活性異常検出時の復旧動作] が表示されます。[次へ] をクリックします。

利用するボリュームマネージャ名 (lvm) を選択し、ターゲット名 (vg1) をボックスに入力します。[完了] をクリックします。

6.4.2.4. グループリソース (ディスクリソース) を追加する¶

クラスタ環境が共有ディスク使用時の場合は、共有ディスクをグループリソースとして追加します。

[グループリソース一覧] で [追加] をクリックします。

[グループのリソース定義 | failover1] 画面が開きます。[タイプ] ボックスでグループリソースのタイプ (ディスクリソース) を選択し、[名前] ボックスにグループリソース名 (disk1) を入力します。[次へ] をクリックします。

依存関係設定のページが表示されます。何も指定せず [次へ] をクリックします。

- [活性異常検出時の復旧動作]、[非活性異常検出時の復旧動作] が表示されます。[次へ] をクリックします。

[ディスクのタイプ] ボックスでディスクのタイプ (disk)、[ファイルシステム] ボックスでファイルシステム (ext3) を選択し、デバイス名 (/dev/sdb2)、マウントポイント (/mnt/sdb2) をそれぞれのボックスに入力します。[完了] をクリックします。

6.4.2.5. グループリソース (ミラーディスクリソース) を追加する¶

クラスタ環境がミラーディスク使用時の場合は、ミラーディスクをグループリソースとして追加します。

[グループリソース一覧] で [追加] をクリックします。

[グループのリソース定義 | failover1] 画面が開きます。[タイプ] ボックスでグループリソースのタイプ (ミラーディスクリソース) を選択し、[名前] ボックスにグループリソース名 (md1) を入力します。[次へ] をクリックします。

依存関係設定のページが表示されます。何も指定せず [次へ] をクリックします。

- [活性異常検出時の復旧動作]、[非活性異常検出時の復旧動作] が表示されます。[次へ] をクリックします。

[ミラーパーティションデバイス名] ボックスでミラーパーティションデバイス名 (/dev/NMP1) を選択します。マウントポイント (/mnt/sdb2)、データパーティションデバイス名 (/dev/sdb2)、クラスタパーティションデバイス名 (/dev/sdb1) をそれぞれのボックスに入力します。[ファイルシステム] ボックスでファイルシステム (ext3) を選択します。 [完了] をクリックします。

注釈

[タイプ] ボックスに (ミラーディスクリソース) が表示されない場合は、CLUSTERPRO X Replicatorライセンスの登録状況を確認の上、[ライセンス情報取得] をクリックしてください。

6.4.2.6. グループリソース (EXEC リソース) を追加する¶

スクリプトによってアプリケーションの起動/終了を行う、EXEC リソースを追加します。

[グループリソース一覧] で [追加] をクリックします。

[グループのリソース定義 | failover1] 画面が開きます。[タイプ] ボックスでグループリソースのタイプ (EXEC リソース) を選択し、[名前] ボックスにグループリソース名 (exec1) を入力します。[次へ] をクリックします。

依存関係設定のページが表示されます。何も指定せず [次へ] をクリックします。

[活性異常検出時の復旧動作]、[非活性異常検出時の復旧動作] が表示されます。[次へ] をクリックします。

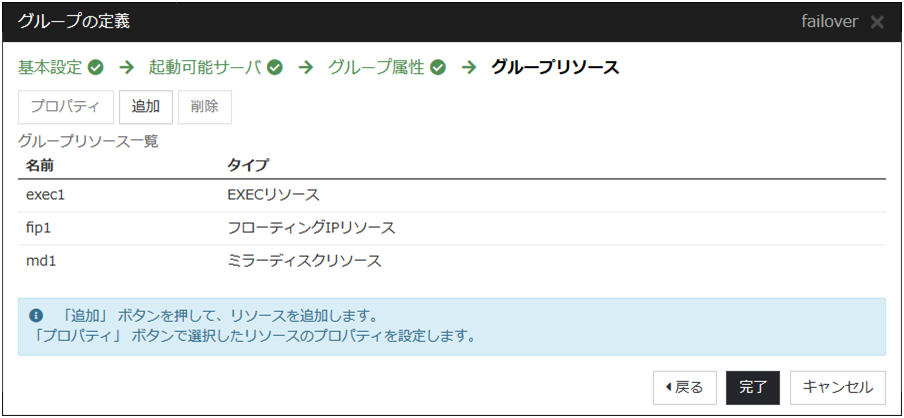

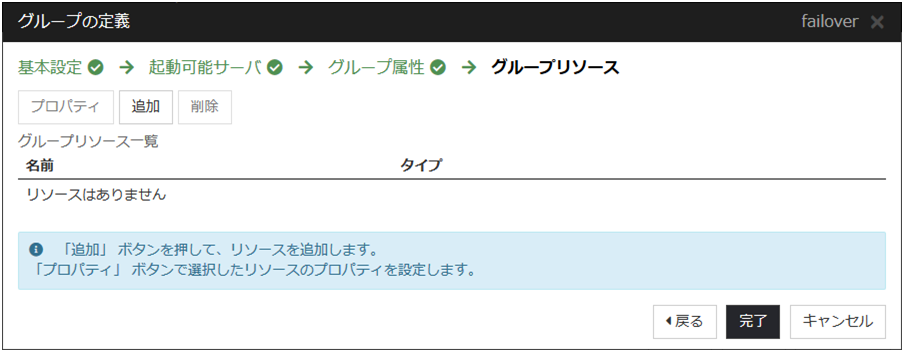

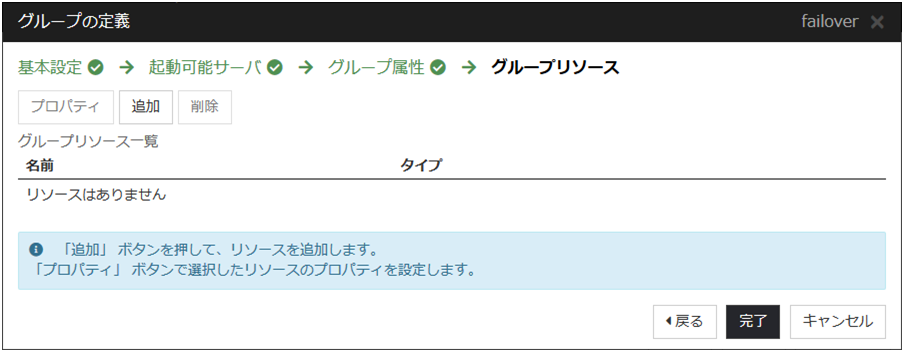

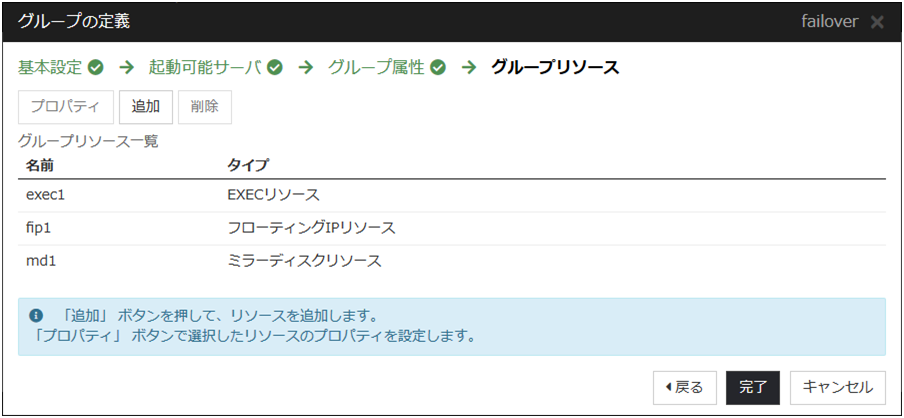

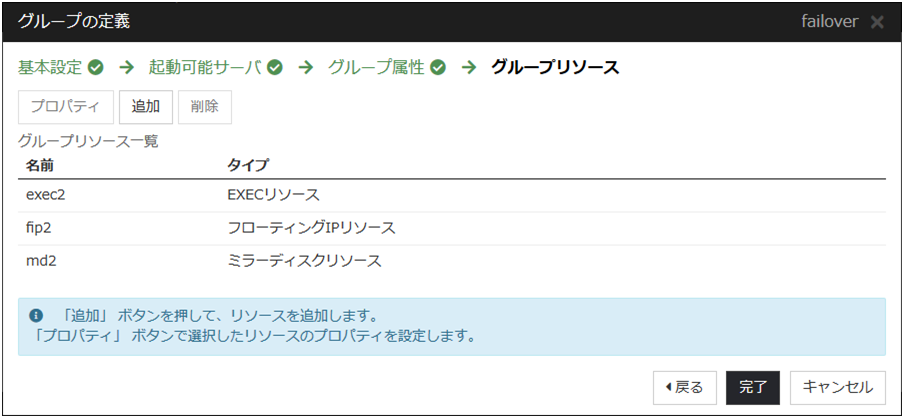

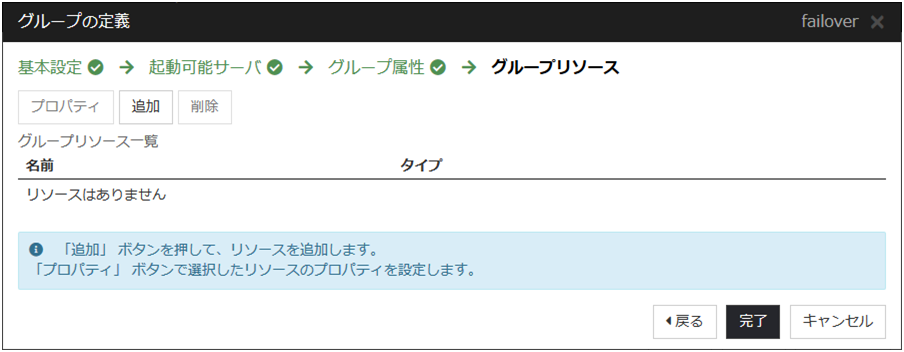

- [この製品で作成したスクリプト] をチェックします。ユーザはこのスクリプトを編集して、業務アプリケーションの起動および停止手順を記述します。すでに CLUSTERPRO で使用するアプリケーションが決定している場合は、ここでスクリプトを編集します。[完了] をクリックします。クラスタ環境が共有ディスク使用時の場合は、failover1 の [グループリソース一覧] は以下のようになります。

クラスタ環境がデータミラー型の場合は、failover1 の [グループリソース一覧] は以下のようになります。

クラスタ環境がデータミラー型の場合は、failover1 の [グループリソース一覧] は以下のようになります。

[完了] をクリックします。

6.4.3. モニタリソースの作成¶

指定した対象を監視するモニタリソースをクラスタに追加します。

6.4.3.1. モニタリソース (ディスクモニタ) を追加する¶

ディスクを監視するモニタリソースを追加します。この例では、ディスクモニタ を追加します。

[グループ] で、[次へ] をクリックします。

[モニタリソース一覧] が表示されます。[追加] をクリックします。

- [モニタリソースの定義] ダイアログボックスが開きます。クラスタ環境が共有ディスク使用時の場合、1 つ目のモニタリソースはクラスタ名を定義したときにデフォルトで作成されています。ミラーディスク使用時の場合、1 つ目のモニタリソースがクラスタ名を定義したときにデフォルトで作成されています。6 つ目と 7 つ目のモニタリソースはミラーディスク リソース追加時にデフォルトで作成されています。[タイプ] ボックスでモニタリソースのタイプ (ディスクモニタ) を選択し、[名前] ボックスにモニタリソース名 (diskw1) を入力します。[次へ] をクリックします。

監視設定を入力します。ボリュームマネージャ使用時には、監視タイミング (活性時)、監視対象 (volmgr1) を入力します。それ以外の場合、デフォルト値のまま変更しません。[次へ] をクリックします。

ボリュームマネージャ使用時には、監視方法 (READ (O_DIRECT) )、監視先 (/dev/vg1/lv1) を入力します。それ以外の場合、監視方法 (READ (O_DIRECT) )、監視先 (/dev/sdb1) を入力します。[次へ] をクリックします。

回復対象を設定します。[参照] をクリックします。

表示されるツリービューで [LocalServer] を選択し、[OK] をクリックします。[回復対象] に [LocalServer] が設定されます。

[最終動作] ボックスで [クラスタサービス停止と OS シャットダウン] を選択し、[完了] をクリックします。

6.4.3.2. モニタリソース (IP モニタ) を追加する¶

ネットワークを監視するモニタリソースを追加します。

[モニタリソース一覧] で [追加] をクリックします。

- [モニタリソースの定義] 画面が開きます。[タイプ] ボックスでモニタリソースのタイプ(IP モニタ) を選択し、[名前] ボックスにモニタリソース名 (ipw1) を入力します。[次へ] をクリックします。

監視設定を入力します。ここではデフォルト値のまま変更せず、[次へ] をクリックします。

- [追加] をクリックします。[IP アドレス] ボックスに監視 IP アドレス (10.0.0.254) を入力し [OK] をクリックします。

注釈

IP モニタリソースの監視対象には、パブリック LAN 上で、常時稼動が前提とされている機器 (例えば、ゲートウェイ) の IP アドレスを指定します。

入力した IP アドレスが [IP アドレス一覧] に設定されます。[次へ] をクリックします。

回復対象を設定します。[参照] をクリックします。

表示されるツリービューで [All Groups] を選択し、[OK] をクリックします。[回復対象] に [All Groups] が設定されます。

[完了] をクリックします。

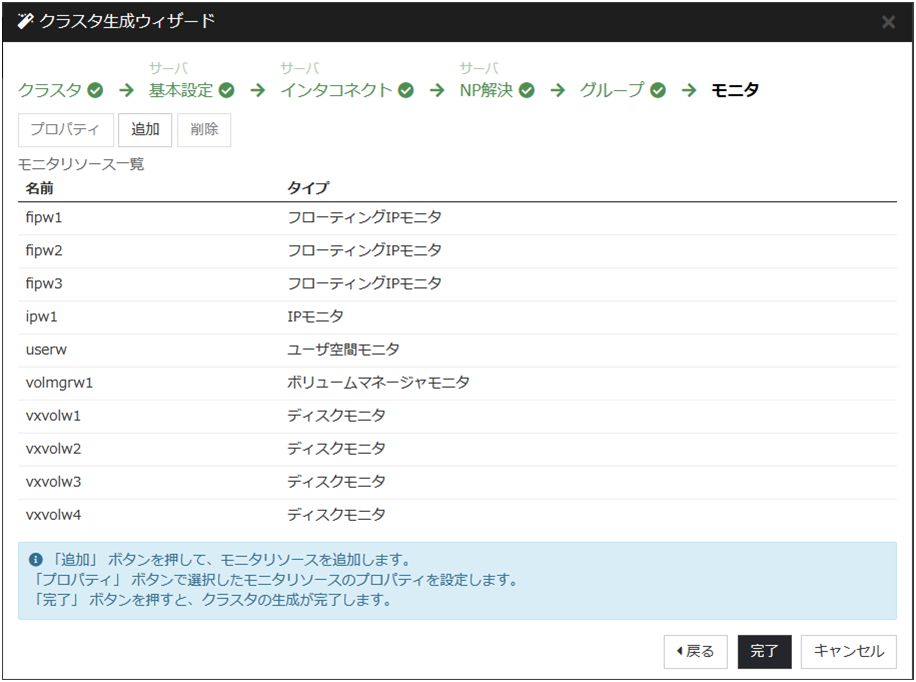

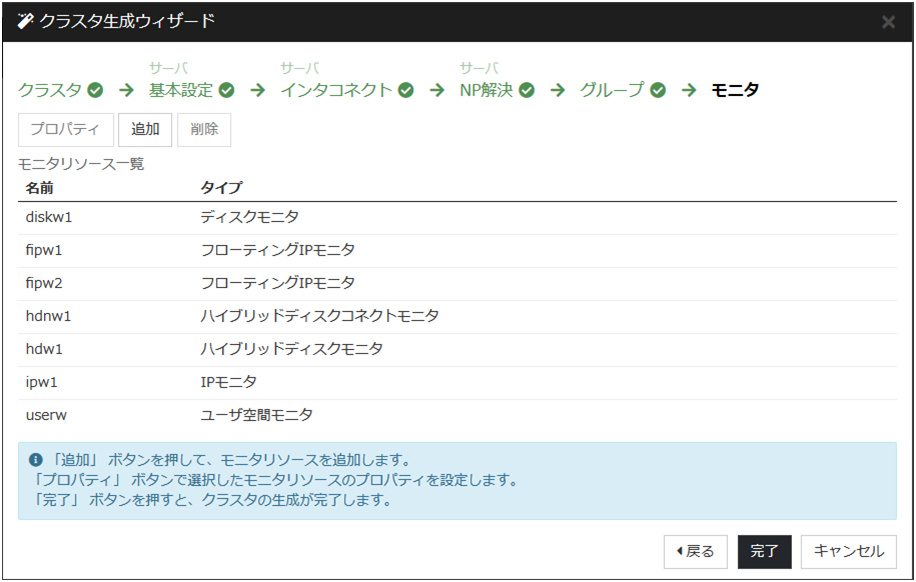

[モニタリソース一覧] は以下のようになります。ミラーディスクリソース使用時は、mdnw1、mdw1 が追加で表示されています。ボリュームマネージャリソース使用時は、volmgrw1が追加で表示されています。

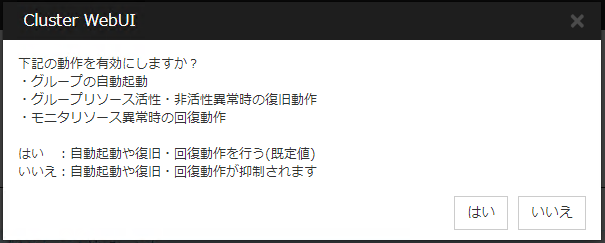

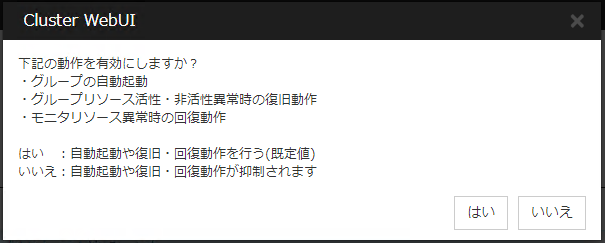

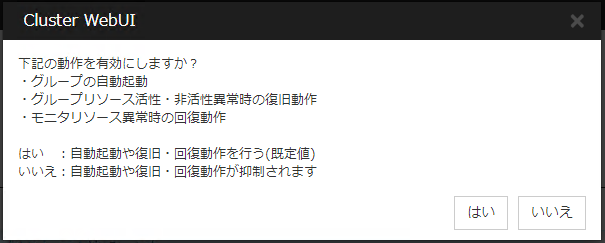

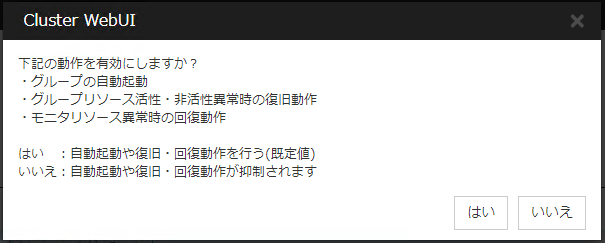

6.4.4. クラスタ動作を無効化する¶

[いいえ] をクリックすると、グループの自動起動、グループリソース活性・非活性異常時の復旧動作、およびモニタリソース異常時の回復動作を行わなくなります。クラスタ構成情報を作成した後で初めてクラスタを起動する場合は、自動起動や復旧・回復動作を無効化して、クラスタ構成情報に誤りがないか確認することを推奨します。

なお、本機能は、[クラスタのプロパティ] の [拡張] タブの [クラスタ動作の無効化] で設定可能です。

注釈

クラスタ動作を無効化した場合でも、サーバダウンによるフェイルオーバは行われます。

モニタリソース異常時の回復動作の無効化は、ユーザ空間モニタリソースには適用されません。

6.5. 2 ノードクラスタ(VxVM 利用)環境の設定値を確認する¶

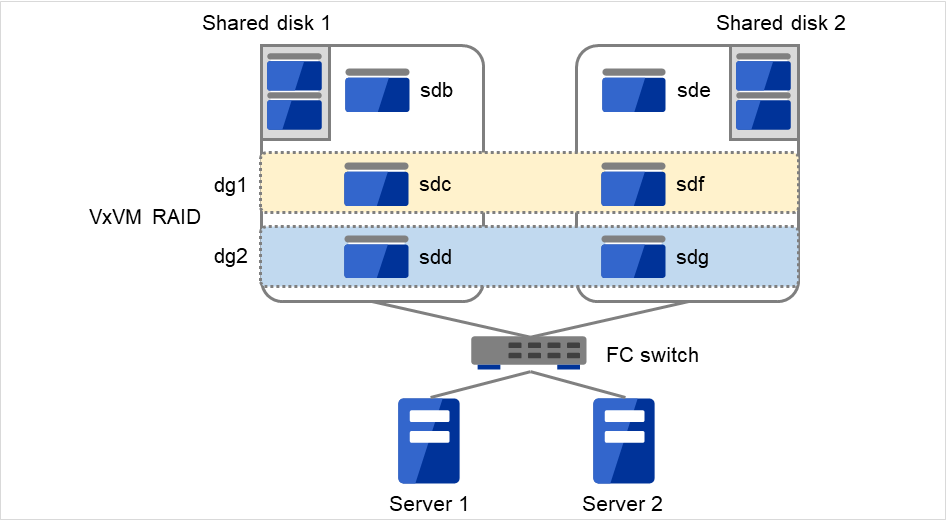

6.5.1. VERITAS Volume Manager の構成¶

CLUSTERPRO で動作確認済みの VERITAS Volume Manager の構成は以下のようになります。

図 6.6 VERITAS Volume Managerを使用した動作確認済みの構成¶

VxVM の構成の設定は、以下のようになります。

ディスクグループ1 |

dg1 |

|

|---|---|---|

物理ディスク 1 |

/dev/sdc |

|

物理ディスク 2 |

/dev/sdf |

|

ボリューム |

||

vol1 4 |

ボリュームデバイス名 |

/dev/vx/dsk/dg1/vol1 |

ボリューム RAW デバイス名 |

/dev/vx/rdsk/dg1/vol1 |

|

ファイルシステム |

vxfs |

|

vol2 4 |

ボリュームデバイス名 |

/dev/vx/dsk/dg1/vol2 |

ボリューム RAW デバイス名 |

/dev/vx/rdsk/dg1/vol2 |

|

ファイルシステム |

vxfs |

ディスクグループ2 |

dg2 |

|

|---|---|---|

物理ディスク 1 |

/dev/sdd |

|

物理ディスク 2 |

/dev/sdg |

|

ボリューム |

||

vol3 4 |

ボリュームデバイス名 |

/dev/vx/dsk/dg2/vol3 |

ボリューム RAW デバイス名 |

/dev/vx/rdsk/dg2/vol3 |

|

ファイルシステム |

vxfs |

|

vol4 4 |

ボリュームデバイス名 |

/dev/vx/dsk/dg2/vol4 |

ボリューム RAW デバイス名 |

/dev/vx/rdsk/dg2/vol4 |

|

ファイルシステム |

vxfs |

ディスクハートビートリソース用LUN |

|

|---|---|

共有ディスク 1 |

/dev/sdb のパーティション |

共有ディスク 2 |

/dev/sde のパーティション |

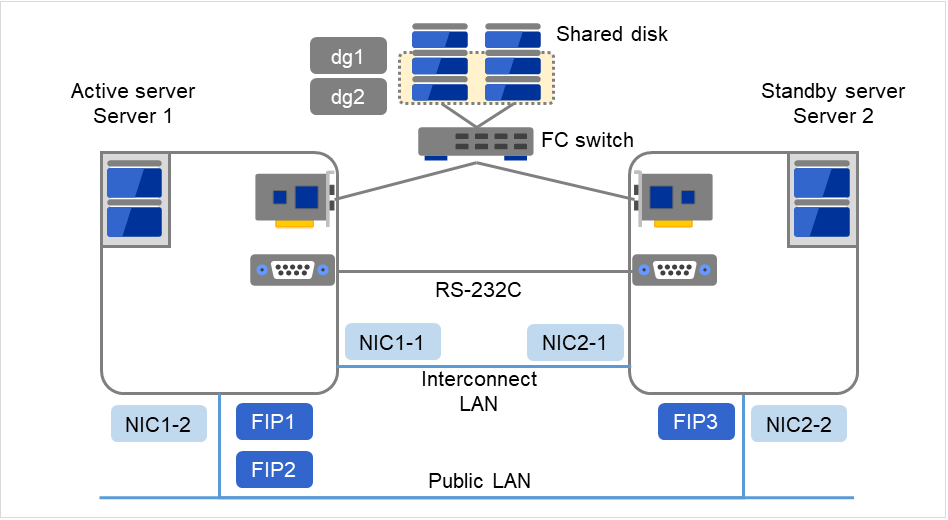

6.5.2. クラスタ環境のサンプル¶

本章では、前項の構成の VxVM を利用して、以下の図に記載されている 2 ノードクラスタ環境を構築する場合を例にとって説明を行います。

図 6.7 2 ノードクラスタの例(VxVM利用)¶

FIP1: Cluster WebUIクライアントからのアクセス先

FIP2: 業務クライアントからのアクセス先

以下に、上図のクラスタシステムを構築するためのクラスタ構成情報のサンプル値を記載します。以降のトピックでは、この条件でクラスタ構成情報を作成する手順をステップバイステップで説明します。実際に値を設定する際には、構築するクラスタの構成情報と置き換えて入力してください。値の決定方法については、『リファレンスガイド』を参照してください。

設定パラメータ |

設定値 |

|

|---|---|---|

クラスタ構成 |

クラスタ名 |

cluster |

サーバ数 |

2 |

|

フェイルオーバグループ数 |

3 |

|

モニタリソース数 |

8 |

|

ハートビートリソース |

LAN ハートビート数 |

2 |

COM ハートビート数 |

1 |

|

ディスクハートビート数 |

2 |

|

1 台目のサーバの情報(マスタサーバ) |

サーバ名 |

server1 |

インタコネクトの IP アドレス

(専用)

|

192.168.0.1 (NIC1-1) |

|

インタコネクトの IP アドレス

(バックアップ)

|

10.0.0.1 (NIC1-2) |

|

パブリックの IP アドレス |

10.0.0.1 (NIC1-2) |

|

COM ハートビートデバイス |

/dev/ttyS0 |

|

ディスクハートビートデバイス |

/dev/sdb1

/dev/raw/raw10

|

|

/dev/sde1

/dev/raw/raw11

|

||

2 台目のサーバの情報 |

サーバ名 |

server2 |

インタコネクトの IP アドレス

(専用)

|

192.168.0.2 (NIC2-1) |

|

インタコネクトの IP アドレス

(バックアップ)

|

10.0.0.2 (NIC2-2) |

|

パブリックの IP アドレス |

10.0.0.2 (NIC2-2) |

|

COM ハートビートデバイス |

/dev/ttyS0 |

|

ディスクハートビートデバイス |

/dev/sdb1

/dev/raw/raw10

|

|

/dev/sde1

/dev/raw/raw11

|

||

1 つ目のグループ(Cluster WebUI 用) |

タイプ |

フェイルオーバ |

グループ名 |

ManagementGroup |

|

起動サーバ |

全てのサーバ |

|

グループリソース数 |

1 |

|

1つ目のグループリソース 5 |

タイプ |

フローティング IP リソース |

グループリソース名 |

ManagementIP |

|

IP アドレス |

10.0.0.11 (FIP1) |

|

2 つ目のグループ(業務用) |

タイプ |

フェイルオーバ |

グループ名 |

failover1 |

|

起動サーバ |

全てのサーバ |

|

グループリソース数 |

4 |

|

1 つ目のグループリソース |

タイプ |

フローティング IP リソース |

グループリソース名 |

fip1 |

|

IP アドレス |

10.0.0.12 (FIP2) |

|

2 つ目のグループリソース |

タイプ |

ボリュームマネージャリソース |

グループリソース名 |

vxdg1 |

|

ボリュームマネージャ |

VXVM |

|

インポート対象 |

dg1 |

|

ホスト ID クリア |

ON |

|

強制インポート |

OFF |

|

3 つ目のグループリソース |

タイプ |

ディスクリソース |

グループリソース名 |

vxvol1 |

|

ディスクタイプ |

VXVM |

|

ファイルシステム |

vxfs |

|

デバイス名 |

/dev/vx/dsk/dg1/vol1 |

|

RAW デバイス名 |

/dev/vx/rdsk/dg1/vol1 |

|

マウントポイント |

/mnt/vol1 |

|

4 つ目のグループリソース |

タイプ |

ディスクリソース |

グループリソース名 |

vxvol2 |

|

ディスクタイプ |

VXVM |

|

ファイルシステム |

vxfs |

|

ボリュームデバイス名 |

/dev/vx/dsk/dg1/vol2 |

|

ボリューム RAW デバイス名 |

/dev/vx/rdsk/dg1/vol2 |

|

マウントポイント |

/mnt/vol2 |

|

3 つ目のグループ(業務用) |

タイプ |

フェイルオーバ |

グループ名 |

failover2 |

|

起動サーバ |

server2→server1 |

|

グループリソース数 |

4 |

|

1 つ目のグループリソース |

タイプ |

フローティング IP リソース |

グループリソース名 |

fip2 |

|

IP アドレス |

10.0.0.13 (FIP3) |

|

2 つ目のグループリソース |

タイプ |

ボリュームマネージャリソース |

グループリソース名 |

vxdg2 |

|

ボリュームマネージャ |

VXVM |

|

インポート対象 |

dg2 |

|

ホストIDクリア |

ON |

|

強制インポート |

OFF |

|

3 つ目のグループリソース |

タイプ |

ディスクリソース |

グループリソース名 |

vxvol3 |

|

ディスクタイプ |

VXVM |

|

ファイルシステム |

vxfs |

|

ボリュームデバイス名 |

/dev/vx/dsk/dg2/vol3 |

|

ボリューム RAW デバイス名 |

/dev/vx/rdsk/dg2/vol3 |

|

マウントポイント |

/mnt/vol3 |

|

4 つ目のグループリソース |

タイプ |

ディスクリソース |

グループリソース名 |

vxvol4 |

|

ディスクタイプ |

VXVM |

|

ファイルシステム |

Vxfs |

|

ボリュームデバイス名 |

/dev/vx/dsk/dg2/vol4 |

|

ボリューム RAW デバイス名 |

/dev/vx/rdsk/dg2/vol4 |

|

マウントポイント |

/mnt/vol4 |

|

1 つ目のモニタリソース(デフォルト作成) |

タイプ |

ユーザ空間モニタ |

モニタリソース名 |

Userw |

|

2 つ目のモニタリソース(ボリュームマネージャリソース作成後自動作成) |

タイプ |

ボリュームマネージャモニタ |

モニタリソース名 |

volmgrw1 |

|

ボリュームマネージャ |

VXVM |

|

3 つ目のモニタリソース(vxvol1の監視) |

タイプ |

ディスクモニタ |

モニタリソース名 |

vxvolw1 |

|

監視方法 |

READ (VXVM) |

|

監視対象 RAW デバイス名 |

/dev/vx/rdsk/dg1/vol1 |

|

監視対象リソース |

vxvol1 |

|

異常検出時 |

クラスタサービス停止と OS シャットダウン |

|

4 つ目のモニタリソース(vxvol2の監視) |

タイプ |

ディスクモニタ |

モニタリソース名 |

vxvolw2 |

|

監視方法 |

READ (VXVM) |

|

監視対象 RAW デバイス |

/dev/vx/rdsk/dg1/vol2 |

|

監視対象リソース |

vxvol2 |

|

異常検出時 |

クラスタサービス停止と OS シャットダウン |

|

5 つ目のモニタリソース(vxvol3の監視) |

タイプ |

ディスクモニタ |

モニタリソース名 |

vxvolw3 |

|

監視方法 |

READ (VXVM) |

|

監視対象 RAW デバイス |

/dev/vx/rdsk/dg2/vol3 |

|

監視対象リソース |

vxvol3 |

|

異常検出時 |

クラスタサービス停止と OS シャットダウン |

|

6 つ目のモニタリソース(vxvol4の監視) |

タイプ |

ディスクモニタ |

モニタリソース名 |

vxvolw4 |

|

監視方法 |

READ (VXVM) |

|

監視対象 RAW デバイス |

/dev/vx/rdsk/dg2/vol4 |

|

監視対象リソース |

vxvol4 |

|

異常検出時 |

クラスタサービス停止と OS シャットダウン |

|

7 つ目のモニタリソース(ManagementIPリソース作成後自動作成) |

タイプ |

フローティングIP モニタ |

モニタリソース名 |

fipw1 |

|

監視対象 |

ManagementIP |

|

異常検出時 |

"ManagementGroup"グループのフェイルオーバ |

|

8 つ目のモニタリソース(fip1リソース作成後自動作成) |

タイプ |

フローティングIP モニタ |

モニタリソース名 |

fipw2 |

|

監視対象 |

fip1 |

|

異常検出時 |

"failover1"グループのフェイルオーバ |

|

9 つ目のモニタリソース(fip2リソース作成後自動作成) |

タイプ |

フローティングIP モニタ |

モニタリソース名 |

fipw3 |

|

監視対象 |

fip2 |

|

異常検出時 |

"failover2"グループのフェイルオーバ |

|

10 個目のモニタリソース |

タイプ |

IP モニタ |

モニタリソース名 |

ipw1 |

|

監視 IP アドレス |

10.0.0.254

(ゲートウェイ)

|

|

異常検出時 |

全グループのフェイルオーバ |

- 5

Cluster WebUI を接続するフローティング IP を用意して専用のグループに入れます。Cluster WebUI 専用のグループが停止しない限り、Web ブラウザからはサーバの実 IP を意識することなくアクセスできます。

ディスクモニタリソースは、監視したいディスクリソースとそのボリューム RAW デバイスを正しく設定してください。

ボリュームマネージャモニタリソースは VxVM の vxconfigd デーモンを監視します。

以下のリソースで設定する raw デバイスのデバイス名は絶対に重複しないようにしてください。

ディスクハートビートリソースの raw デバイス

ディスクリソースの RAW デバイスの実 raw デバイス

ディスクモニタリソースの監視対象 raw デバイス

6.6. 2 ノードクラスタ (VxVM利用) 構成情報の作成手順¶

クラスタ構成情報を作成するには、基本的に、クラスタの作成、グループの作成、モニタリソースの作成のステップを踏みます。以下に手順の流れを示します。

注釈

クラスタ構成情報の操作は何度でも繰り返して行えます。また、設定した内容のほとんどは名称変更機能やプロパティ表示機能を使用して後から変更できます。

-

クラスタの生成、サーバの追加を行います。

「6.6.1.3. ネットワーク構成を設定する」:クラスタを構築するサーバ間のネットワーク構成を設定します。

- 「6.6.1.4. ネットワークパーティション解決処理を設定する」:ネットワークパーティション解決リソースを設定します。

-

フェイルオーバを行う際の単位である、フェイルオーバグループを作成します。

「6.6.2.1. フェイルオーバグループ (業務用1) を追加する」:フェイルオーバの単位となる、グループを追加します。

「6.6.2.2. グループリソース (フローティング IP リソース) を追加する」:グループを構成するリソースを追加します。

「6.6.2.3. グループリソース (ボリュームマネージャリソース) を追加する」:ボリュームマネージャリソースを使用する場合グループを構成するリソースを追加します。

「6.6.2.4. グループリソース (ディスクリソース) を追加する」:ディスクリソースを使用する場合グループを構成するリソースを追加します。

「6.6.2.5. フェイルオーバグループ (業務用2) を追加する」:フェイルオーバの単位となる、グループを追加します。

「6.6.2.6. グループリソース (フローティング IP リソース) を追加する」:グループを構成するリソースを追加します。

「6.6.2.7. グループリソース (ボリュームマネージャリソース) を追加する」:グループを構成するリソースを追加します。

- 「6.6.2.8. グループリソース (ディスクリソース) を追加する」:グループを構成するリソースを追加します。

-

指定された監視対象を監視する、モニタリソースをクラスタ内に追加します。