3. グループリソースの詳細¶

本章では、フェイルオーバグループを構成するグループリソースについての詳細を説明します。

グループの概要については、『インストール&設定ガイド』の「クラスタシステムを設計する」を参照してください。

3.1. グループリソースの一覧と対応する CLUSTERPRO のバージョン¶

各グループに登録することができるグループリソース数は以下のとおりです。

バージョン |

グループリソース数(1 グループあたり) |

|---|---|

4.0.0-1~ |

256 |

現在サポートされているグループリソースは以下のとおりです。

グループリソース名 |

略称 |

機能概要 |

対応バージョン |

|---|---|---|---|

EXEC リソース |

exec |

「 EXEC リソースを理解する 」を参照 |

4.0.0-1~ |

ディスクリソース |

disk |

「 ディスクリソースを理解する 」を参照 |

4.0.0-1~ |

フローティング IP リソース |

fip |

「 フローティング IP リソースを理解する 」を参照 |

4.0.0-1~ |

仮想 IP リソース |

vip |

「 仮想 IP リソースを理解する 」を参照 |

4.0.0-1~ |

ミラーディスクリソース |

md |

「 ミラーディスクリソースを理解する 」を参照 |

4.0.0-1~ |

ハイブリッドディスクリソース |

hd |

「 ハイブリッドディスクリソースを理解する 」を参照 |

4.0.0-1~ |

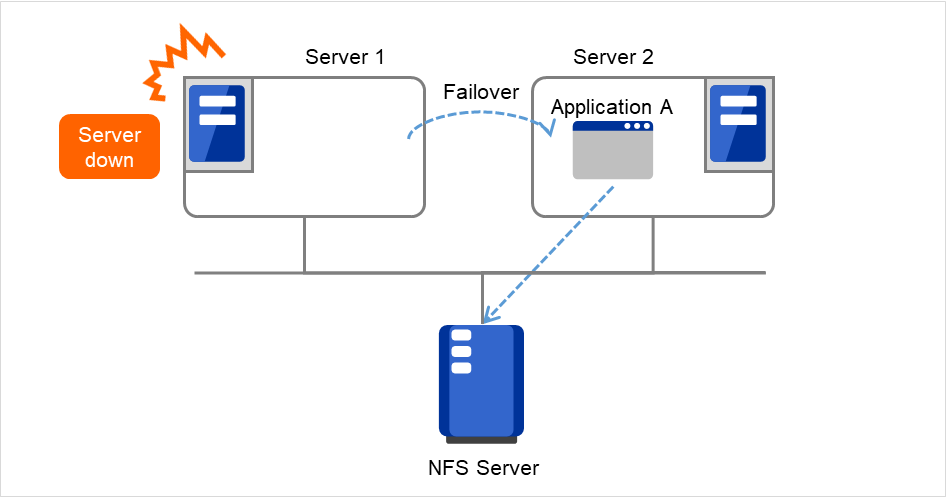

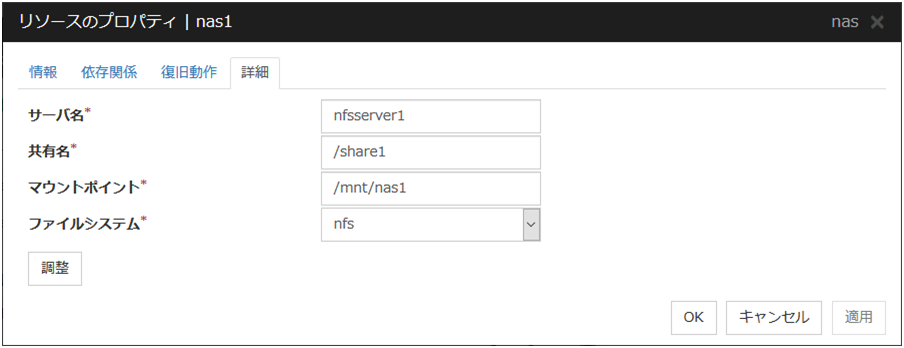

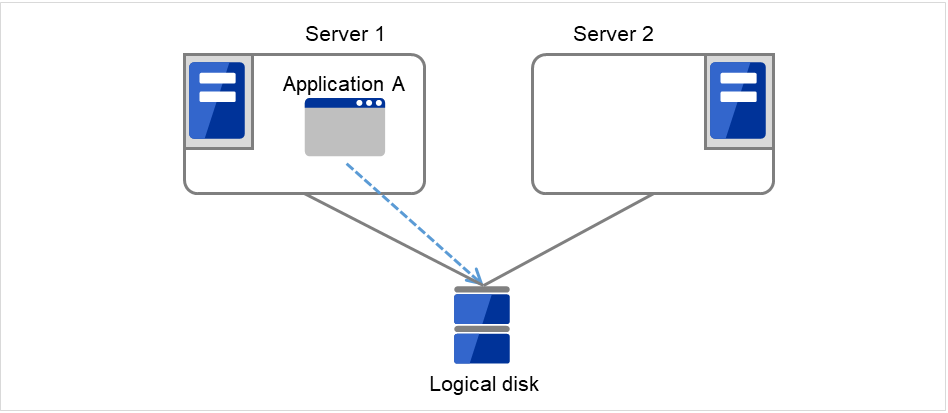

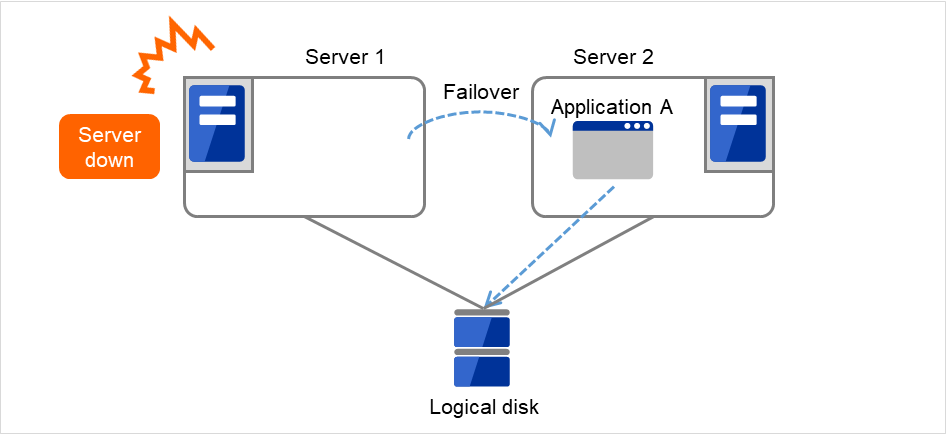

NAS リソース |

nas |

「 NAS リソースを理解する 」を参照 |

4.0.0-1~ |

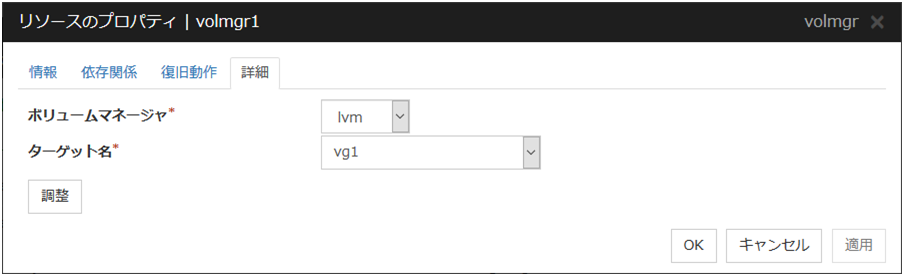

ボリュームマネージャリソース |

volmgr |

「 ボリュームマネージャリソースを理解する」を参照 |

4.0.0-1~ |

仮想マシンリソース |

vm |

「 仮想マシンリソースを理解する 」を参照 |

4.0.0-1~ |

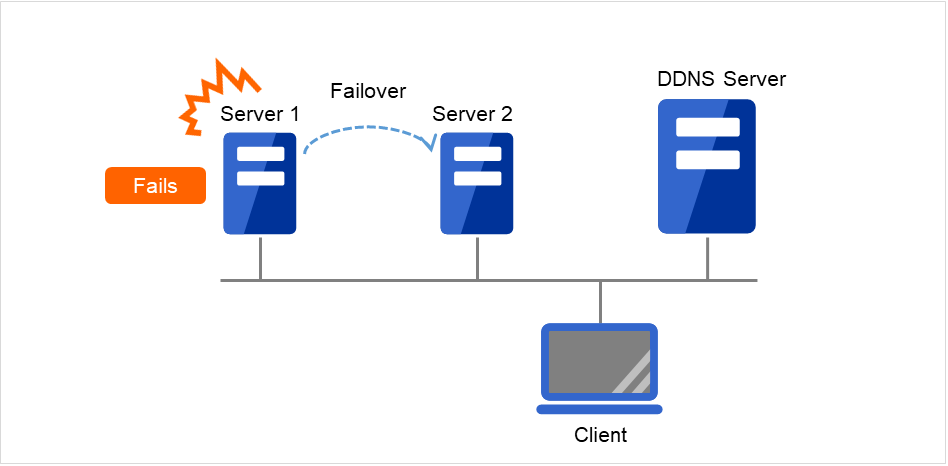

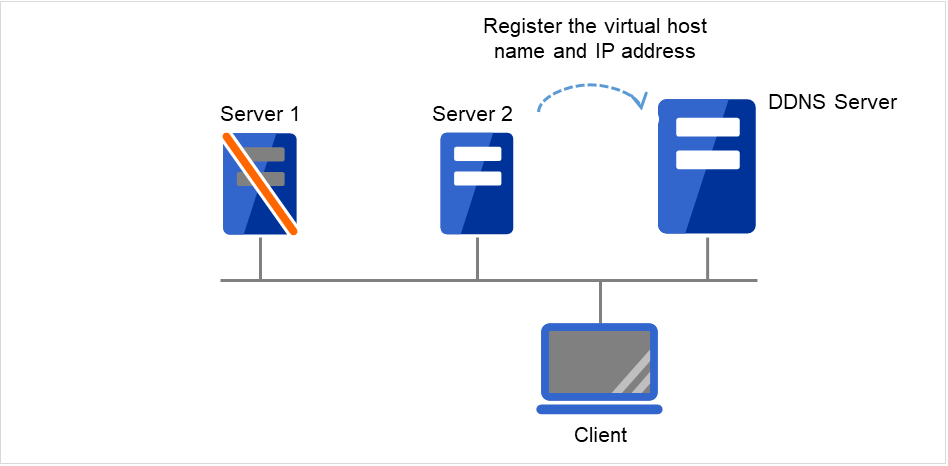

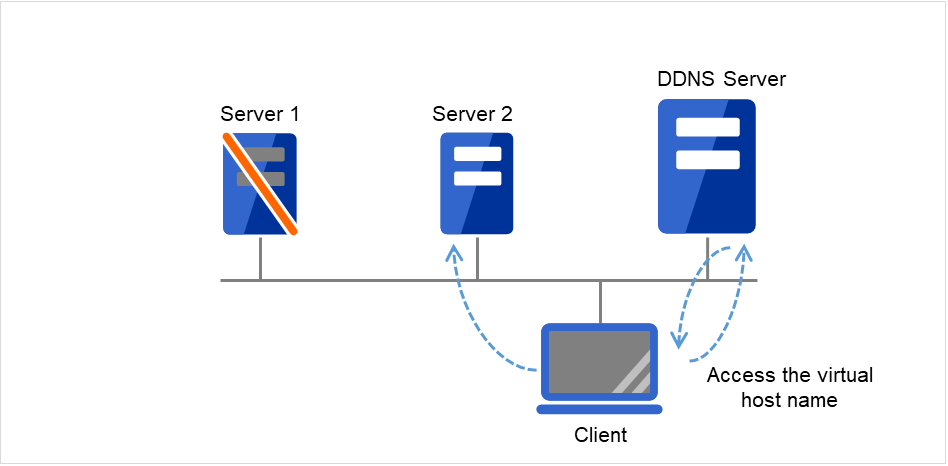

ダイナミック DNS リソース |

ddns |

「 ダイナミック DNS リソースを理解する 」を参照 |

4.0.0-1~ |

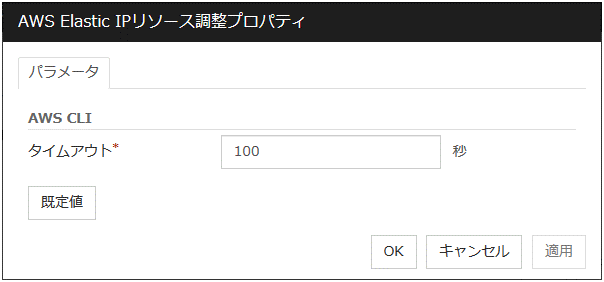

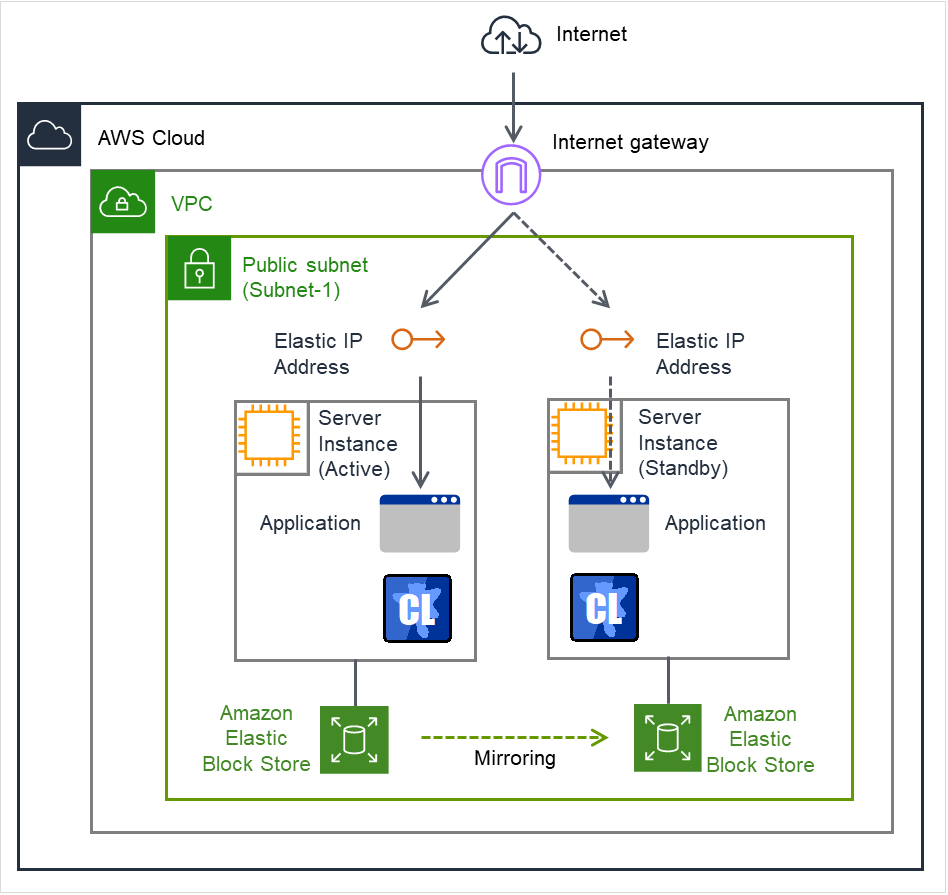

AWS Elastic IP リソース |

awseip |

「 AWS Elastic IPリソースを理解する 」を参照 |

4.0.0-1~ |

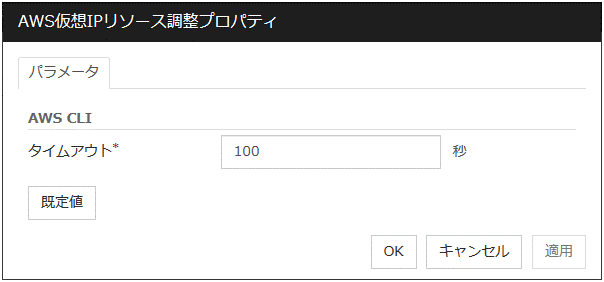

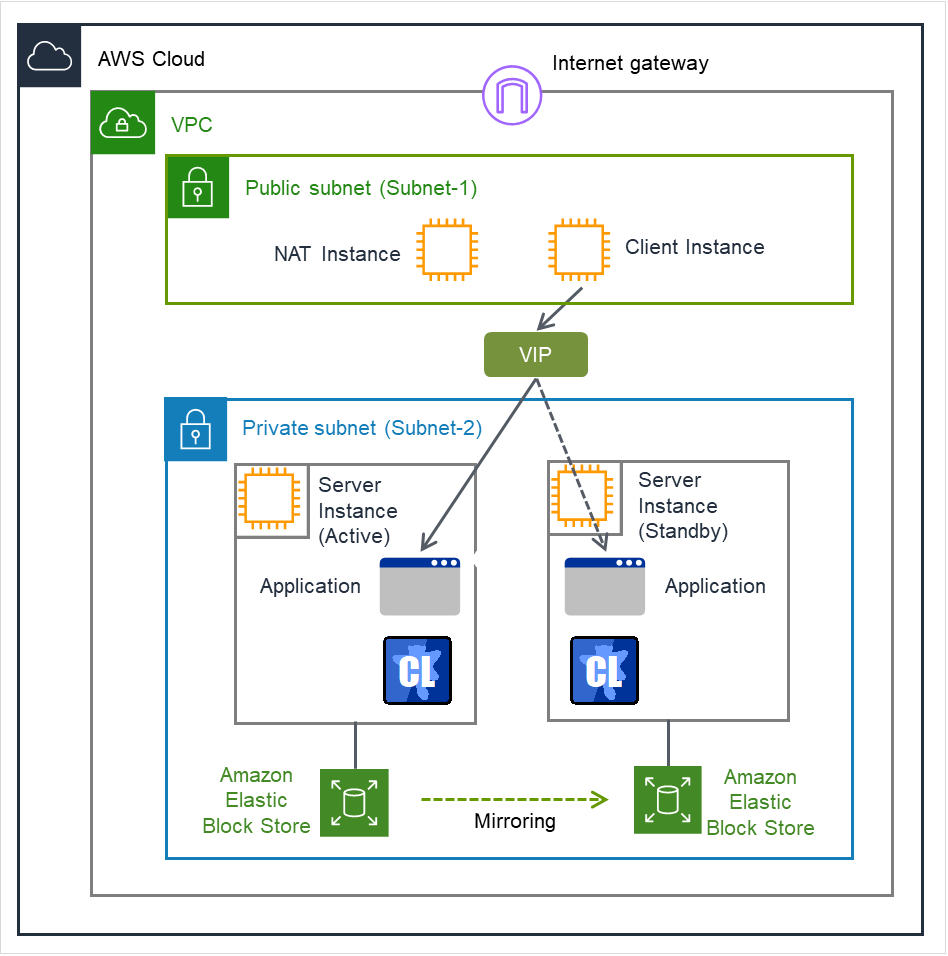

AWS 仮想 IP リソース |

awsvip |

「 AWS 仮想IPリソースを理解する 」を参照 |

4.0.0-1~ |

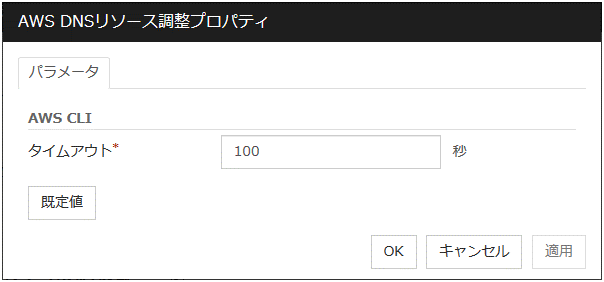

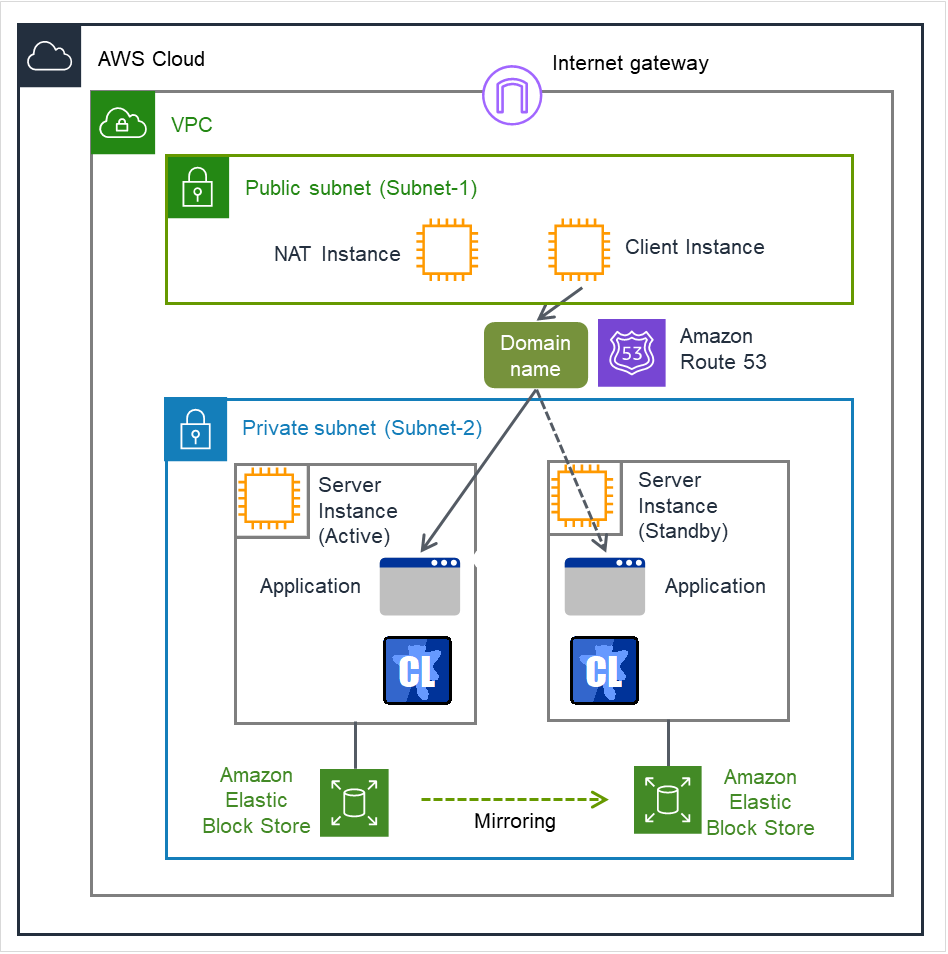

AWS DNS リソース |

awsdns |

「 AWS DNS リソースを理解する 」を参照 |

4.0.0-1~ |

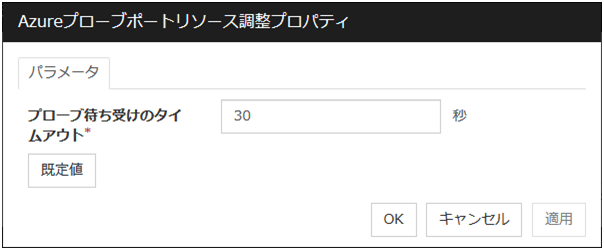

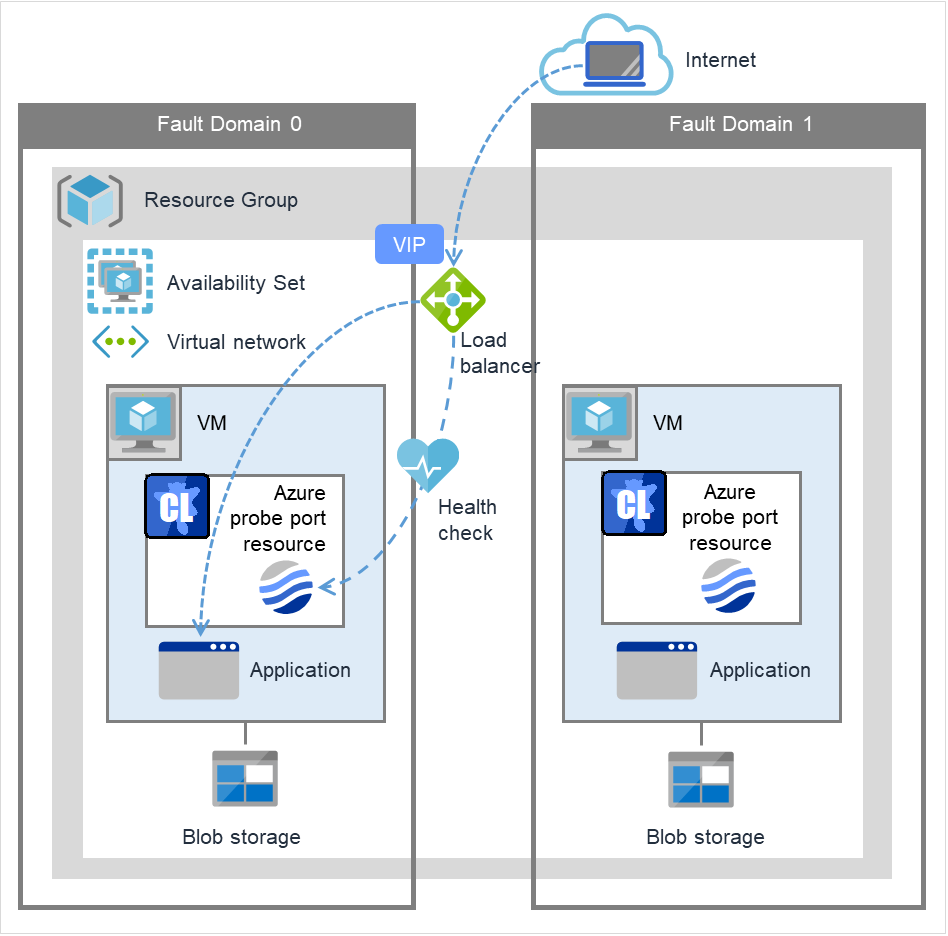

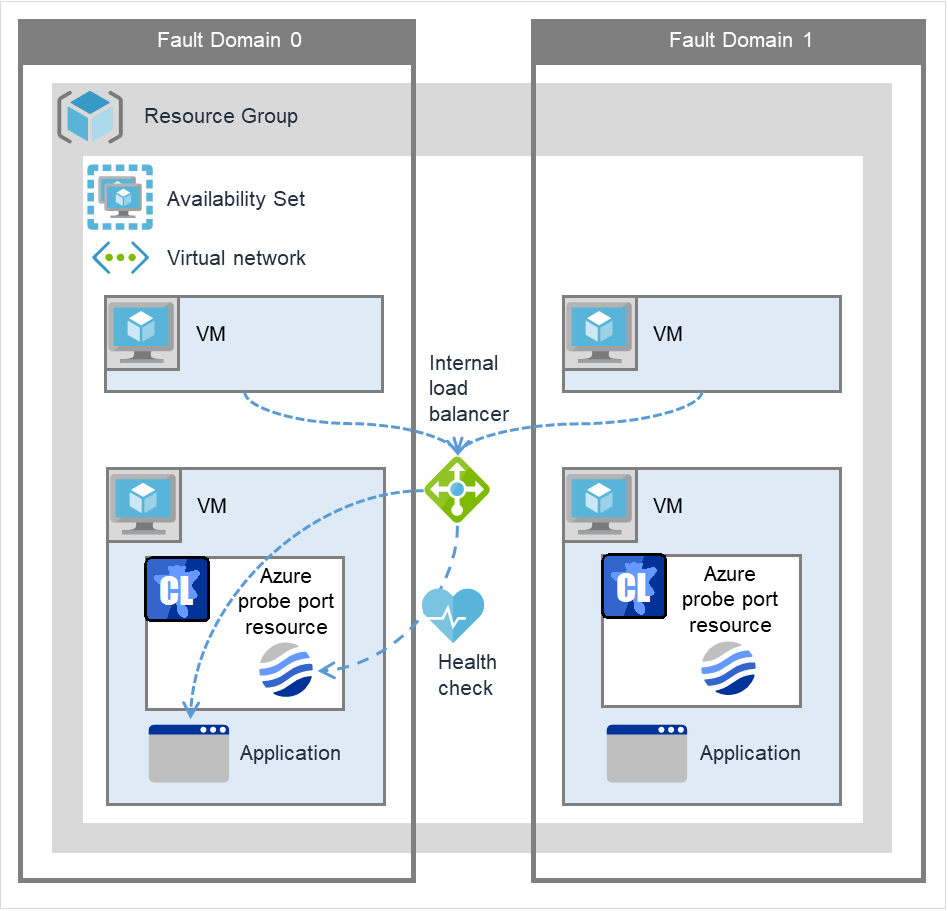

Azure プローブポートリソース |

azurepp |

「 Azure プローブポートリソースを理解する 」を参照 |

4.0.0-1~ |

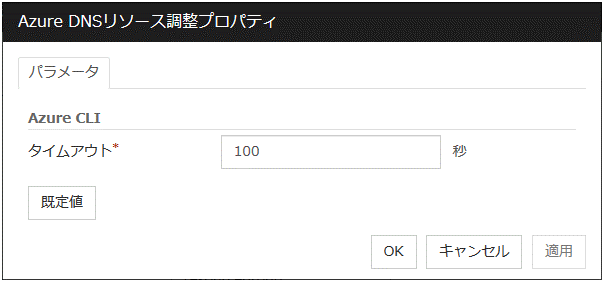

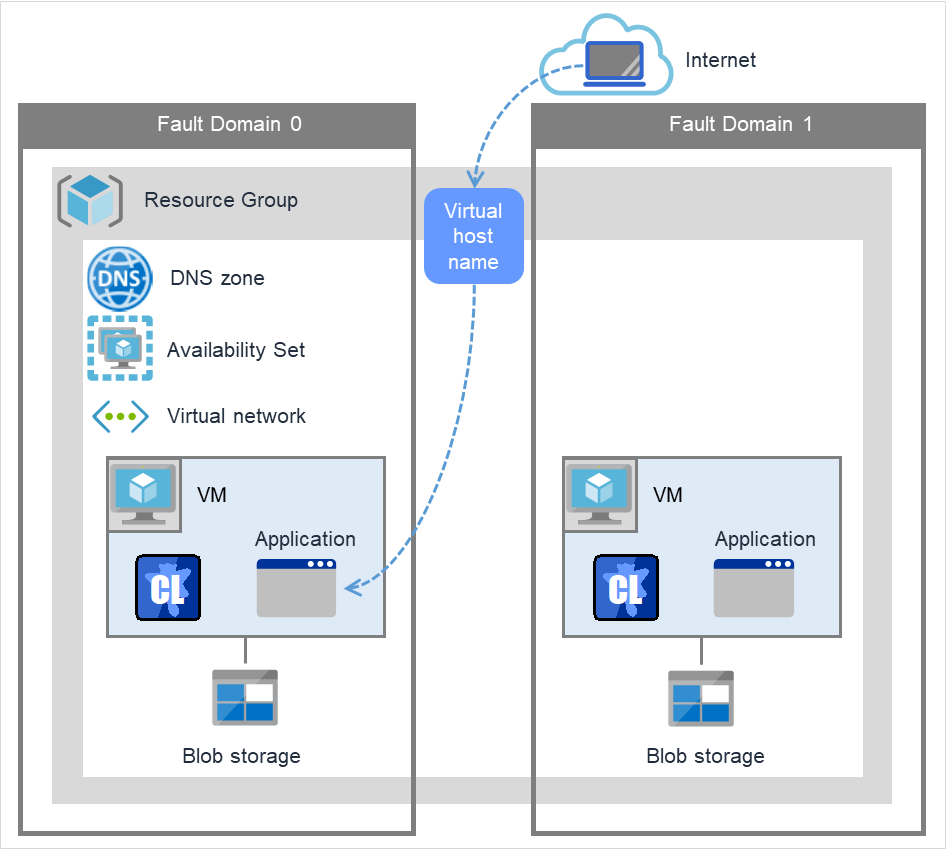

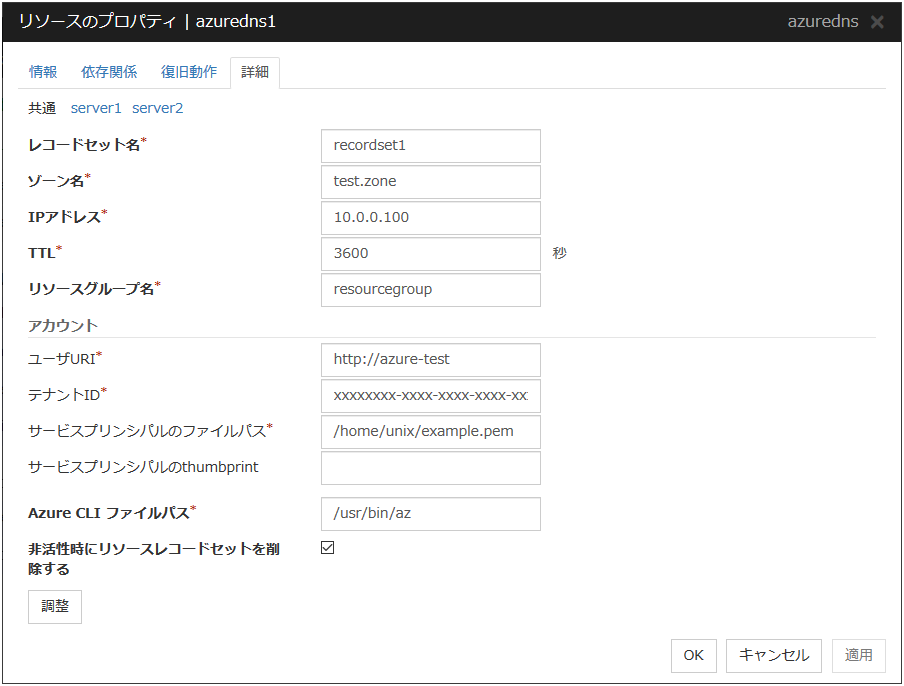

Azure DNS リソース |

azuredns |

「 Azure DNS リソースを理解する 」を参照 |

4.0.0-1~ |

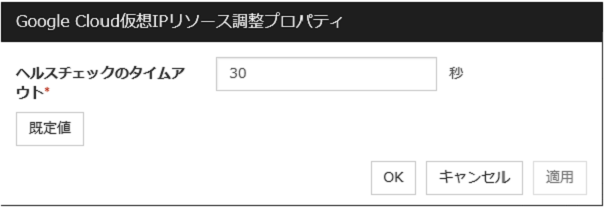

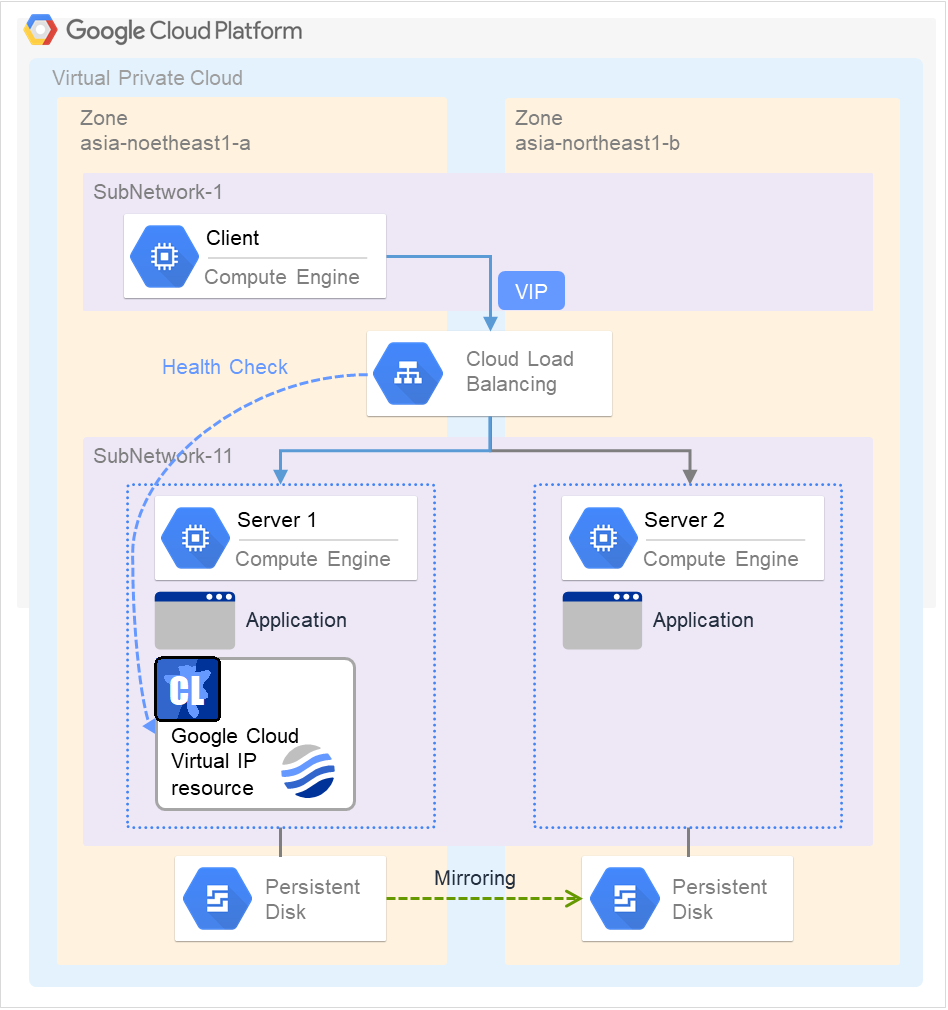

Google Cloud 仮想 IP リソース |

gcvip |

「 Google Cloud 仮想 IP リソースを理解する 」を参照 |

4.2.0-1~ |

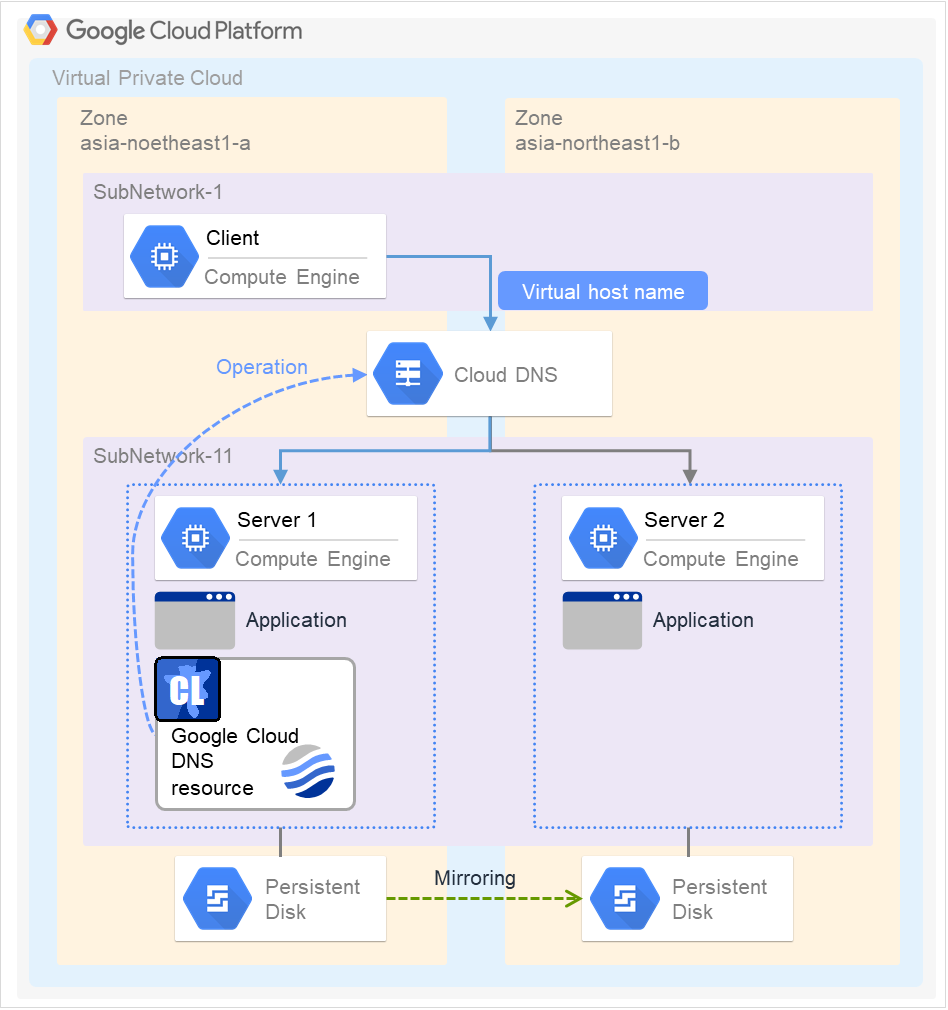

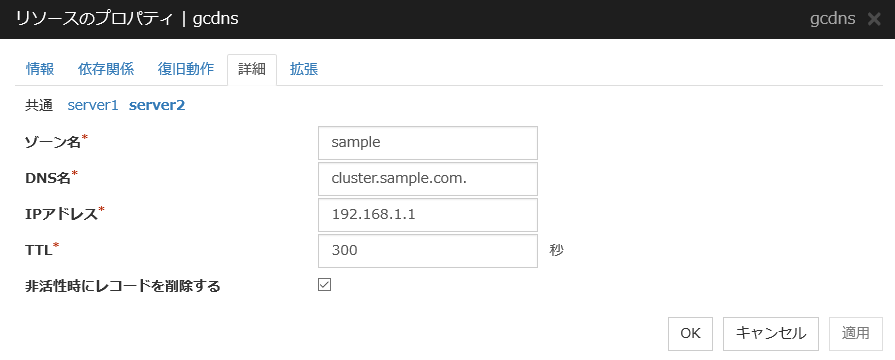

Google Cloud DNS リソース |

gcdns |

「 Google Cloud DNS リソースを理解する 」を参照 |

4.3.0-1~ |

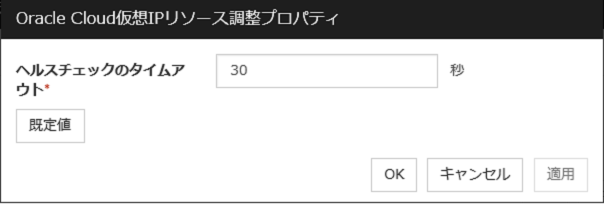

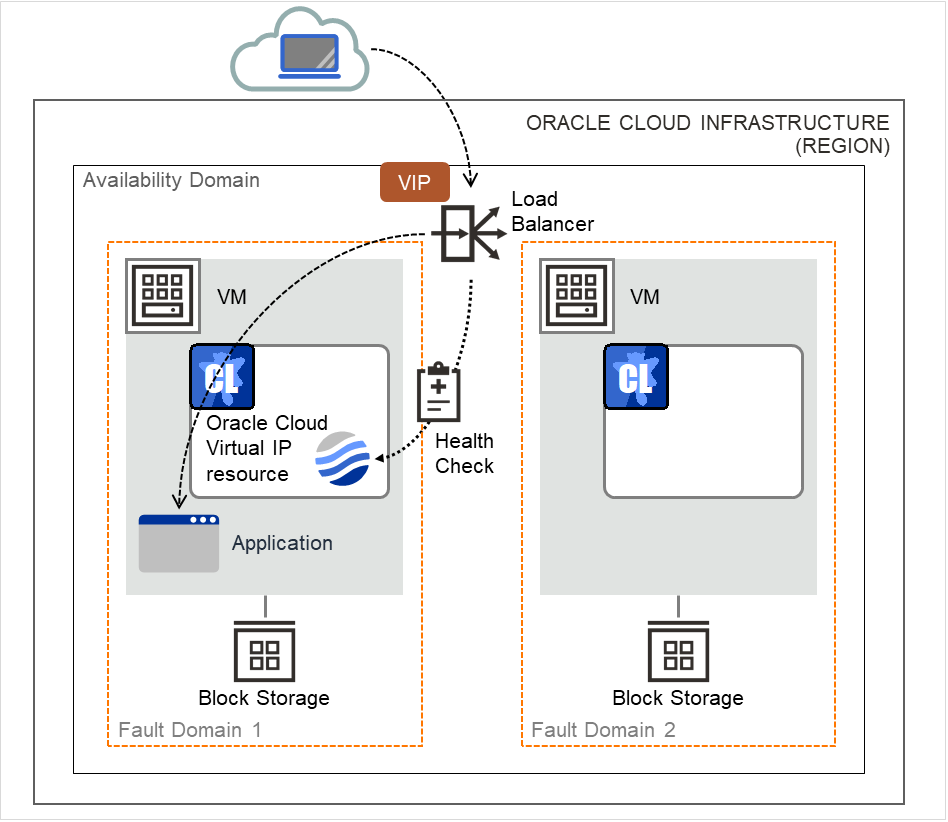

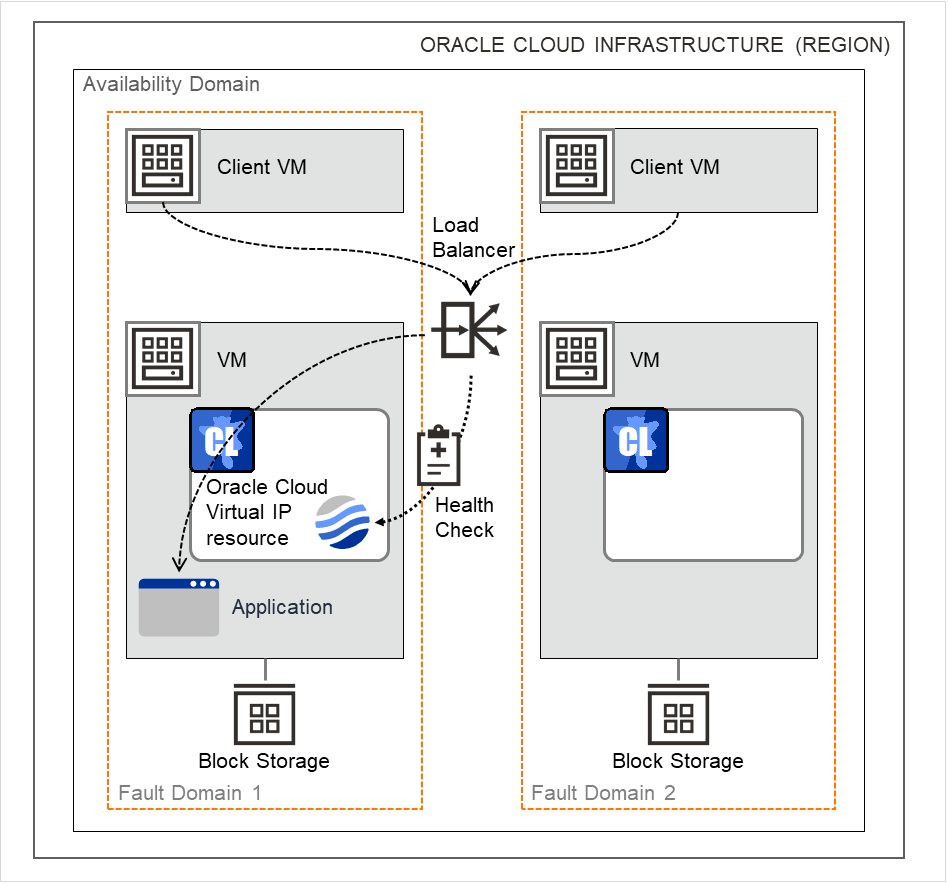

Oracle Cloud 仮想 IP リソース |

ocvip |

「 Oracle Cloud 仮想 IP リソースを理解する 」を参照 |

4.2.0-1~ |

現在動的リソース追加をサポートしているグループリソースは以下のとおりです。

グループリソース名 |

略称 |

機能概要 |

対応バージョン |

|---|---|---|---|

EXEC リソース |

exec |

「 EXEC リソースを理解する 」を参照 |

4.0.0-1~ |

ディスクリソース |

disk |

「 ディスクリソースを理解する 」を参照 |

4.0.0-1~ |

フローティング IP リソース |

fip |

「 フローティング IP リソースを理解する 」を参照 |

4.0.0-1~ |

仮想 IP リソース |

vip |

「 仮想 IP リソースを理解する 」を参照 |

4.0.0-1~ |

ボリュームマネージャリソース |

volmgr |

「 ボリュームマネージャリソースを理解する」を参照 |

4.0.0-1~ |

3.2. グループとは?¶

グループとはフェイルオーバを行う単位です。グループにはフェイルオーバ時の動作に関する規則 (フェイルオーバポリシー) が設定できます。

3.2.1. グループタイプを理解する¶

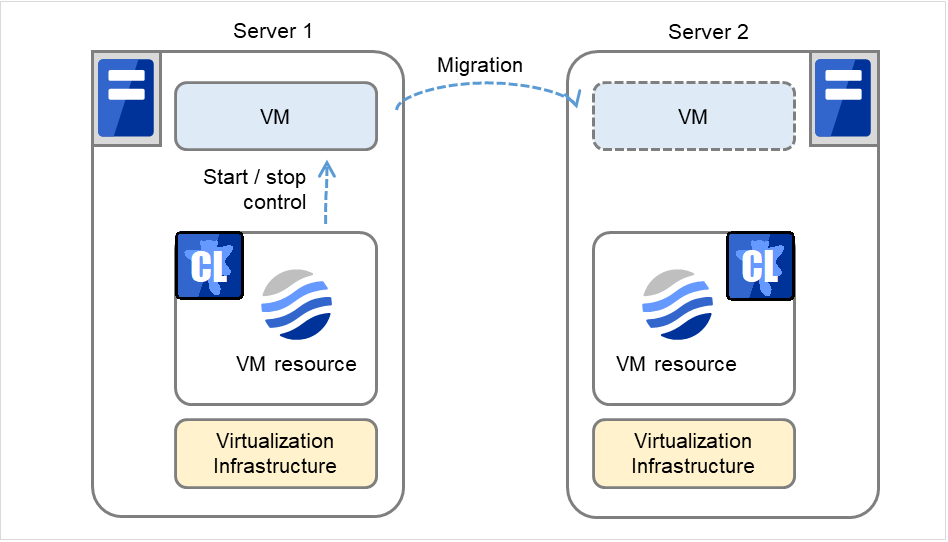

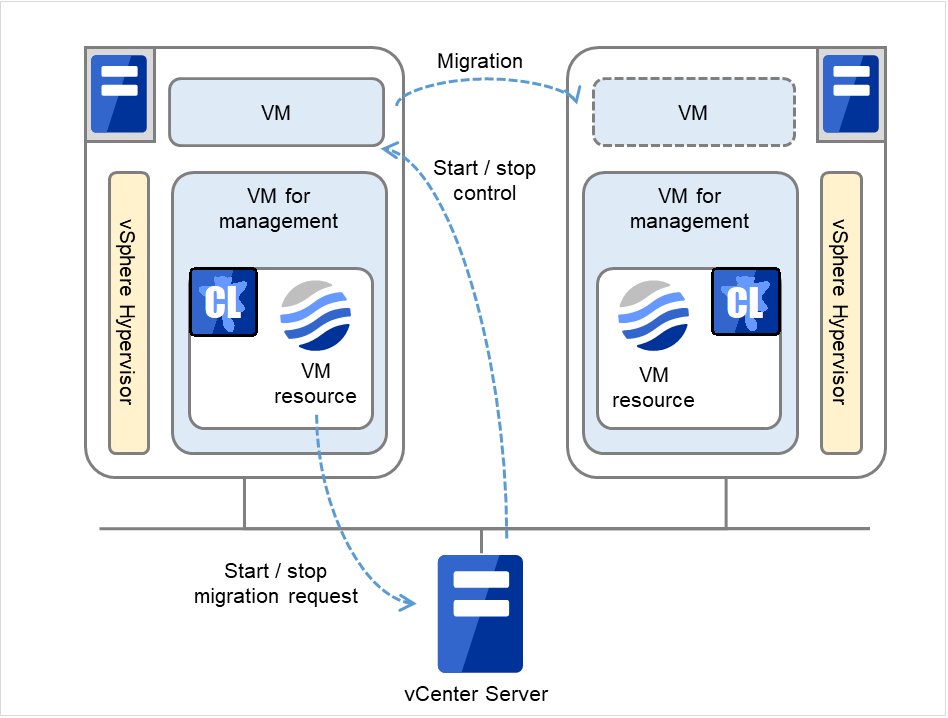

グループには「仮想マシングループ」と「フェイルオーバグループ」の2 つのタイプがあります。

- 仮想マシングループ仮想マシンを単位としてフェイルオーバ (マイグレーション) を行います。このグループには 仮想マシンリソース、ミラーディスクリソース、ディスクリソース、ハイブリッドディスクリソース、EXECリソース、NASリソース、ボリュームマネージャリソースが登録可能です。仮想マシングループは、CLUSTERPRO 以外の機能によって別サーバに仮想マシンが移動された場合でも、自動的に追随します。

- フェイルオーバグループ業務を継続するために必要なリソースをまとめ、業務単位でフェイルオーバを行います。各グループには最大 256のグループリソースが登録できます。ただし仮想マシンリソースは登録することができません。

3.2.2. グループプロパティを理解する¶

各グループで設定可能なプロパティは以下のとおりです。

- 起動可能サーバクラスタを構成するサーバからグループが起動可能なサーバを選択し設定します。また、起動可能なサーバに順位を設定し、グループが起動する優先順位を設定します。

- グループ起動属性グループの起動属性を自動起動、または手動起動に設定します。自動起動の場合、クラスタを開始する際に、グループが起動可能な最も優先順位の高いサーバで、グループが自動的に起動します。手動起動の場合、サーバが起動してもグループは起動しません。サーバ起動後、Cluster WebUI または [clpgrp] コマンドを使用してグループを手動で起動してください。Cluster WebUI の詳細はオンラインマニュアル、[clpgrp] コマンドの詳細は本ガイドの「8. CLUSTERPRO コマンドリファレンス」の「グループを操作する (clpgrp コマンド)」を参照してください。

- フェイルオーバ属性フェイルオーバ属性ではフェイルオーバの方法を設定します。設定可能なフェイルオーバ属性は以下になります。

自動フェイルオーバ

ハートビートがタイムアウトした場合、グループリソースやモニタリソースが異常を検出した場合、それらを契機に自動でフェイルオーバを行います。 自動フェイルオーバの場合、下記の方法を設定することができます。

- 起動可能なサーバ設定に従う起動可能なサーバに設定されているサーバのプライオリティに従い、フェイル オーバ先を決定します。

- ダイナミックフェイルオーバを行う各サーバのモニタやフェイルオーバグループのステータスを考慮し、フェイル オーバ先を決定してフェイルオーバを行います。フェイルオーバ先の決定の流れは以下のようになります。

判定要素

条件

結果

除外対象のモニタリソースの状態

異常(全サーバ)

フェイルオーバ先が無い場合に強制フェイルオーバを行うか判定する処理に進む。

〃

正常( 1 台のみ)

正常なサーバをフェイルオーバ先とする。

〃

正常(複数)

エラーレベルを比較する処理に進む。

強制フェイルオーバを行う

設定有り

除外対象のモニタリソースの状態を無視し、起動している全てのサーバに対してエラーレベルを比較する処理に進む。

〃

設定無し

フェイルオーバしない。

エラーレベルが 最小であるサーバ数

1

異常の度合いが最小であるサーバをフェイルオーバ先とする。

〃

2 以上

異常の度合いが最小であるサーバ内で、業務の度合いを比較する。

サーバグループ内のフェイルオーバポリシーを優先する

設定有りかつフェイルオーバ元と同じサーバグループ内にフェイルオーバ可能なサーバがある。サーバグループ内のサーバをフェイルオーバ先とする。

〃

設定有りかつフェイルオーバ元と同じサーバグループ内にフェイルオーバ可能なサーバが無い。スマートフェイルオーバによる判定処理に進む。

〃

設定無し

スマートフェイルオーバによる判定処理に進む。

スマートフェイルオーバを行う

設定有りかつフェイルオーバ先として推奨されるサーバ数が1。スマートフェイルオーバにより推奨されたサーバをフェイルオーバ先とする。

〃

設定有りかつフェイルオーバ先として推奨されるサーバ数が2以上。ランニングレベルの判定処理に進む。

〃

設定無し

ランニングレベルの判定処理に進む。

ランニングレベルが 最小であるサーバ数

1

ランニングレベルが最小であるサーバをフェイルオーバ先とする。

〃

2以上

起動しているサーバで最もプライオリティが高いサーバをフェイルオーバ先とする。

注釈

除外対象のモニタリソースモニタリソースで異常を検出しているサーバをフェイルオーバ先から除外します。除外モニタをCluster WebUI で設定することができます。エラーレベル異常を検出しているモニタリソース数です。スマートフェイルオーバSystem Resource Agentが収集したシステムリソース情報から負荷が最小であるサーバをフェイルオーバ先として決定する機能です。この機能を有効にするためには、フェイルオーバ先として設定されている全てのサーバにSystem Resource Agentのライセンスを登録する必要があります。また、システムモニタリソースをモニタリソースに設定する必要があります。システムモニタリソースについては、本ガイドの「4. モニタリソースの詳細」の「システムモニタリソースを理解する」を参照してください。ランニングレベル管理グループを除く、起動済みまたは起動中のフェイルオーバグループ数です。 - サーバグループ内のフェイルオーバポリシーを優先する同一サーバグループ内のサーバにフェイルオーバ可能な場合、そのサーバグループ内のサーバへ優先的にフェイルオーバを行います。同一サーバグループ内でフェイルオーバ可能なサーバが無い場合、他のサーバグループ内のサーバをフェイルオーバ先とします。

- サーバグループ間では手動フェイルオーバのみ有効とする上記 [サーバグループ内のフェイルオーバポリシーを優先する] が設定されている場合のみ、選択できます。同一サーバグループ内のサーバに対して、自動的にフェイルオーバを行います。同一サーバグループ内にフェイルオーバ可能なサーバが無い場合、他のサーバグループのサーバへのフェイルオーバを自動的に行うことはありません。他のサーバグループ内のサーバへグループを移動させるためには、Cluster WebUI または [clpgrp] コマンドでグループを移動させる必要があります。

手動フェイルオーバ

ハートビートがタイムアウトした際に自動でフェイルオーバを行いません。Cluster WebUI、または [clpgrp] コマンドから手動でフェイルオーバを行ってください。ただし、手動フェイルオーバが設定されていても、グループリソースやモニタリソースの異常検出時には、自動的にフェイルオーバを行います。

注釈

外部連携モニタリソースの設定で、[サーバグループ外にフェイルオーバする] が設定されている場合、ダイナミックフェイルオーバの設定やサーバグループ間のフェイルオーバ設定は無効となります。フェイルオーバ元のサーバが属するサーバグループとは別のサーバグループに属するサーバグループ内のサーバで、プライオリティが最も高いサーバにフェイルオーバします。

フェイルバック属性

自動フェイルバック、手動フェイルバックのどちらかを設定します。ただし、以下の条件の場合には設定できません。

フェイルオーバグループにミラーディスクリソースまたはハイブリッドディスクリソースが設定されている場合

フェイルオーバ属性が [ダイナミックフェイルオーバを行う] の場合

自動フェイルバックの場合、フェイルオーバした後、優先順位の最も高いサーバが起動する際に自動的にフェイルバックします。

手動フェイルバックの場合、サーバを起動してもフェイルバックは発生しません。

3.2.3. フェイルオーバポリシーを理解する¶

フェイルオーバポリシーとは、複数のサーバの中から、フェイルオーバ先となるサーバを決定するための優先度のことで、フェイルオーバ発生時に特定のサーバに負荷を与えないように設定する必要があります。

以下に、フェイルオーバ可能なサーバリストとその中でのフェイルオーバ優先順位の例を用いて、フェイルオーバ発生時のフェイルオーバポリシーによる動作の違いを説明します。

<図中記号の説明>

サーバ状態 |

説明 |

|---|---|

|

正常状態 (クラスタとして正常に動作している) |

|

停止状態 (クラスタが停止状態) |

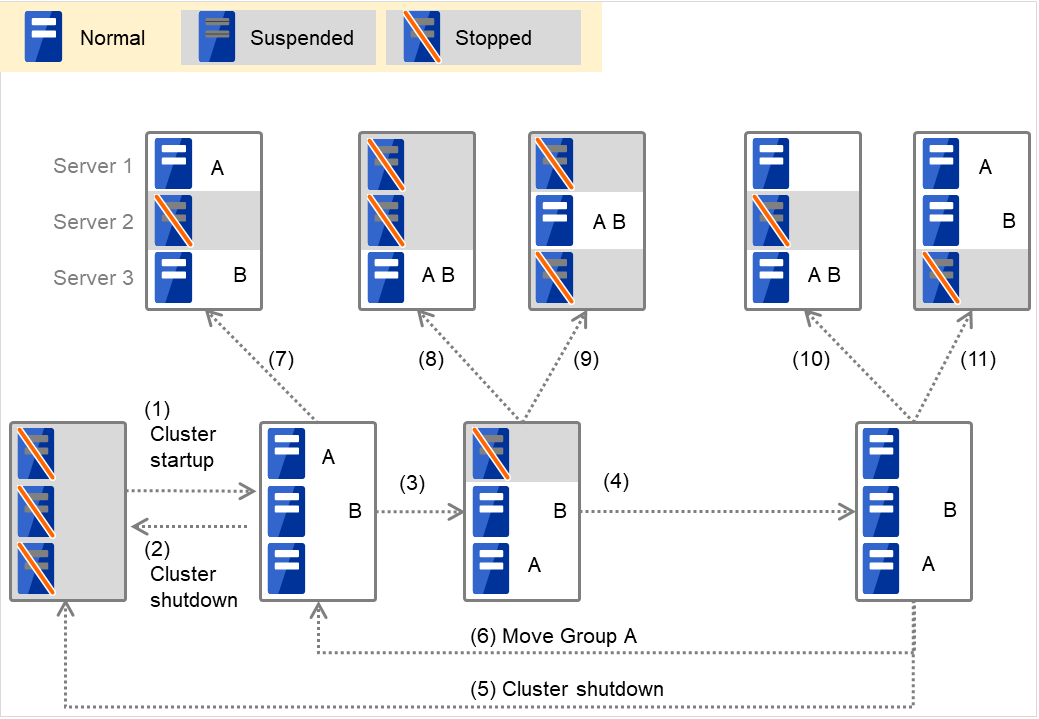

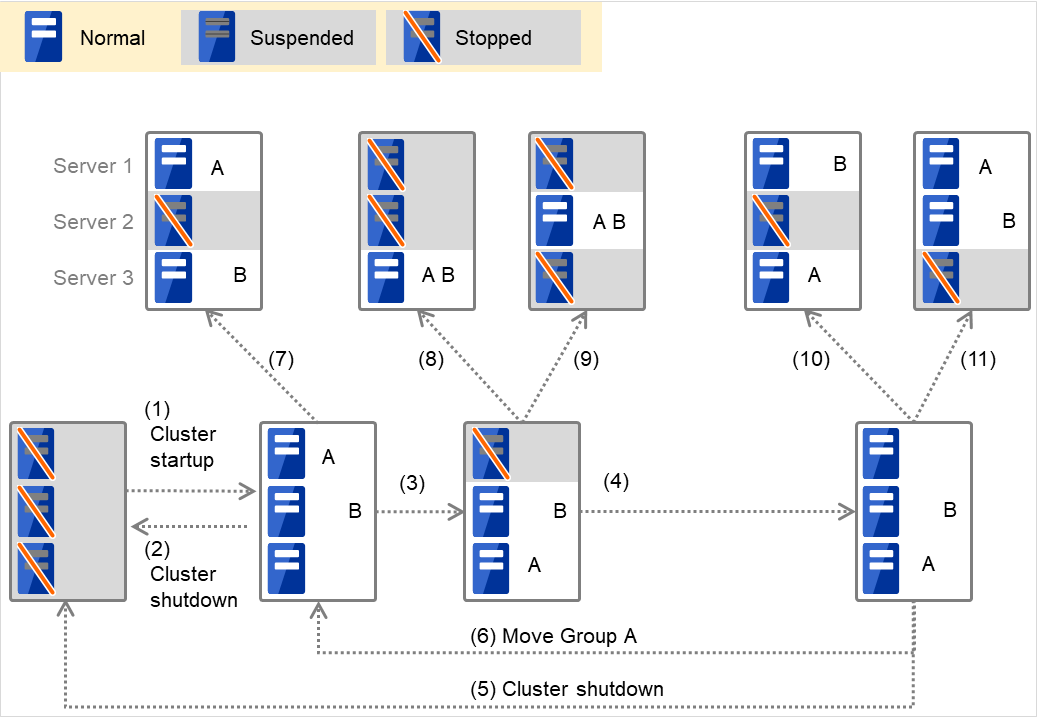

3ノードの場合

グループ |

サーバの優先順位 |

||

|---|---|---|---|

優先度1サーバ |

優先度2サーバ |

優先度3サーバ |

|

A |

Server 1 |

Server 3 |

Server 2 |

B |

Server 2 |

Server 3 |

Server 1 |

2ノードの場合

グループ |

サーバの優先順位 |

|

|---|---|---|

優先度1サーバ |

優先度2サーバ |

|

A |

Server 1 |

Server 2 |

B |

Server 2 |

Server 1 |

A と B はグループ起動属性が自動起動、フェイルバック属性が手動フェイルバックに設定されているものとします。

排他属性が「通常排他」あるいは「完全排他」に設定されている排他ルールに所属し、同じサーバで起動することのできない複数のグループが、同時に同じサーバで起動あるいはフェイルオーバしようとした場合、そのサーバに対する優先順位が高いグループが優先されます。サーバの優先順位が同じ場合には、グループ名の数字、特殊記号、アルファベット順で若い方が優先されます。グループの排他属性については、「グループの排他制御を理解する」を参照してください。

Group A と Group B が排他ルールに所属していない場合

図 3.1 各サーバの状態とGroup A、Group Bの起動状況¶

クラスタの立ち上げ

クラスタのシャットダウン

Server 1 ダウン:次に優先順位の高いサーバへフェイルオーバする

Server 1 の電源 ON

クラスタのシャットダウン

Group A の移動

Server 2 ダウン:次に優先順位の高いサーバへフェイルオーバする

Server 2 ダウン:次に優先順位の高いサーバへフェイルオーバする

Server 3 ダウン:次に優先順位の高いサーバへフェイルオーバする

Server 2 ダウン:次に優先順位の高いサーバへフェイルオーバする

Server 3 ダウン:次に優先順位の高いサーバへフェイルオーバする

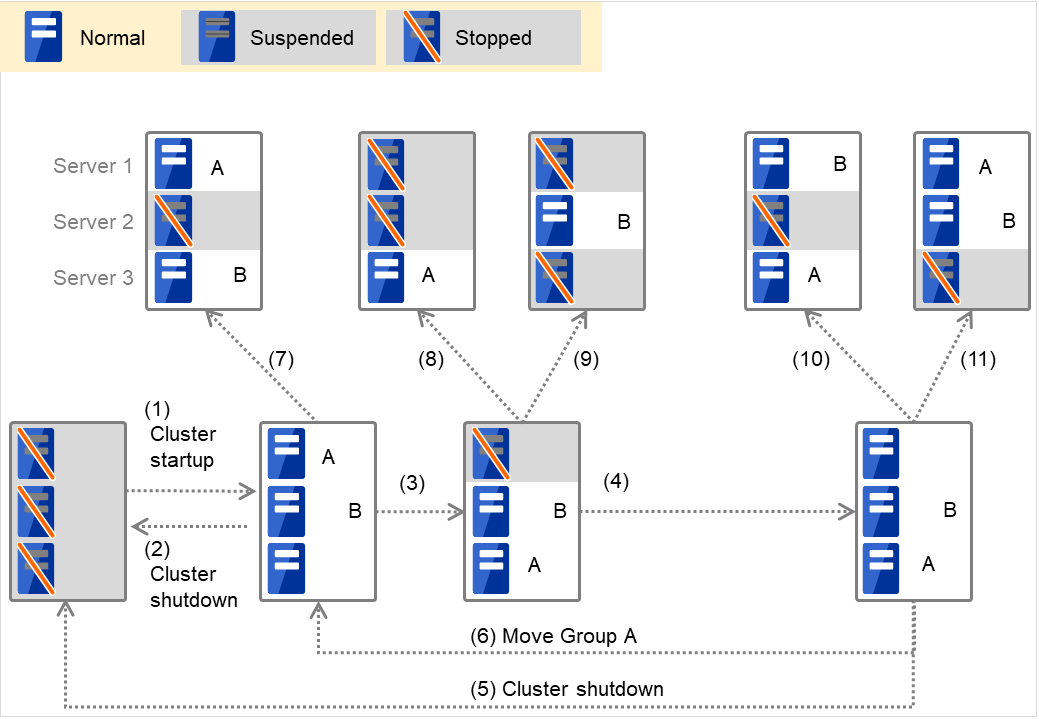

Group A と Group B が排他属性に「通常排他」が設定してある排他ルールに所属する場合

図 3.2 各サーバの状態とGroup A、Group Bの起動状況(A、Bは通常排他)¶

クラスタの立ち上げ

クラスタのシャットダウン

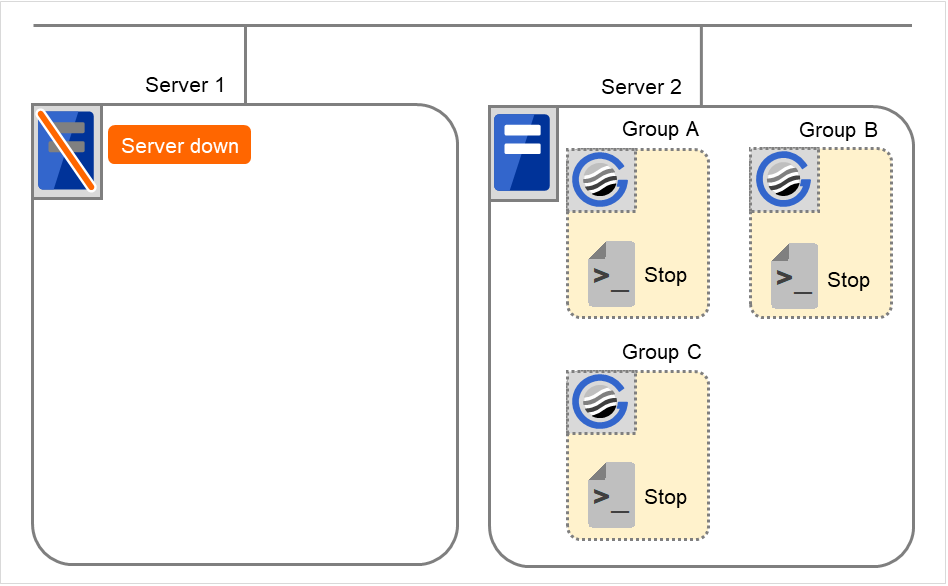

Server 1 ダウン:通常排他のグループが起動されていないサーバへフェイルオーバする

Server 1 の電源 ON

クラスタのシャットダウン

Group A の移動

Server 2 ダウン:通常排他のグループが起動されていないサーバへフェイルオーバする

Server 2 ダウン:通常排他のグループが起動されていないサーバは存在しないが、起動可能なサーバが存在するのでフェイルオーバする

Server 3 ダウン:通常排他のグループが起動されていないサーバは存在しないが、起動可能なサーバが存在するのでフェイルオーバする

Server 2 ダウン:通常排他のグループが起動されていないサーバへフェイルオーバする

Server 3 ダウン:通常排他のグループが起動されていないサーバへフェイルオーバする

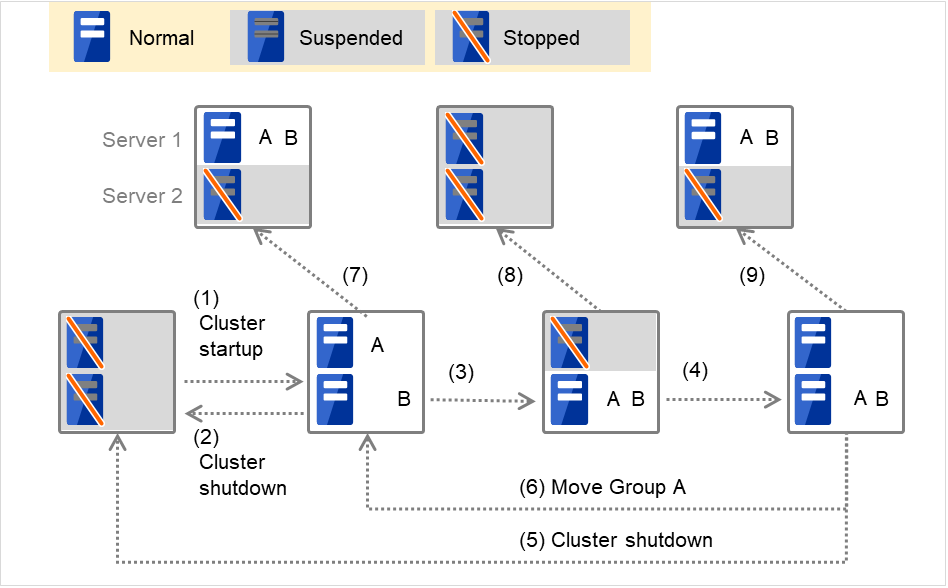

Group A と Group B が排他属性に「完全排他」が設定してある排他ルールに所属する場合

図 3.3 各サーバの状態とGroup A、Group Bの起動状況(A、Bは完全排他)¶

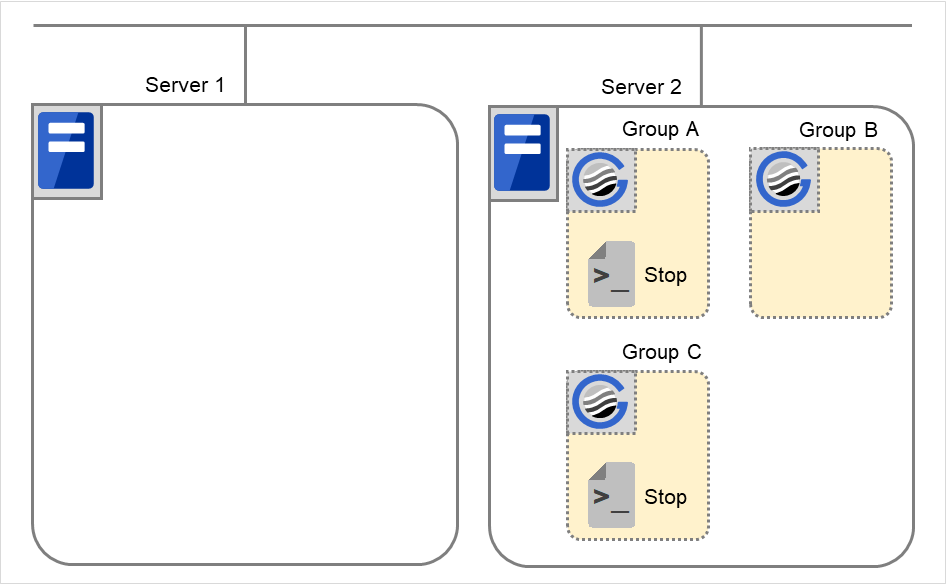

クラスタの立ち上げ

クラスタのシャットダウン

Server 1 ダウン:完全排他のグループが起動されていないサーバへフェイルオーバする

Server 1 の電源 ON

クラスタのシャットダウン

Group A の移動

Server 2 ダウン:完全排他のグループが起動されていないサーバへフェイルオーバする

Server 2 ダウン:フェイルオーバしない (Group B は停止する)

Server 3 ダウン:フェイルオーバしない (Group A は停止する)

Server 2 ダウン:完全排他のグループが起動されていないサーバへフェイルオーバする

Server 3 ダウン:完全排他のグループが起動されていないサーバへフェイルオーバする

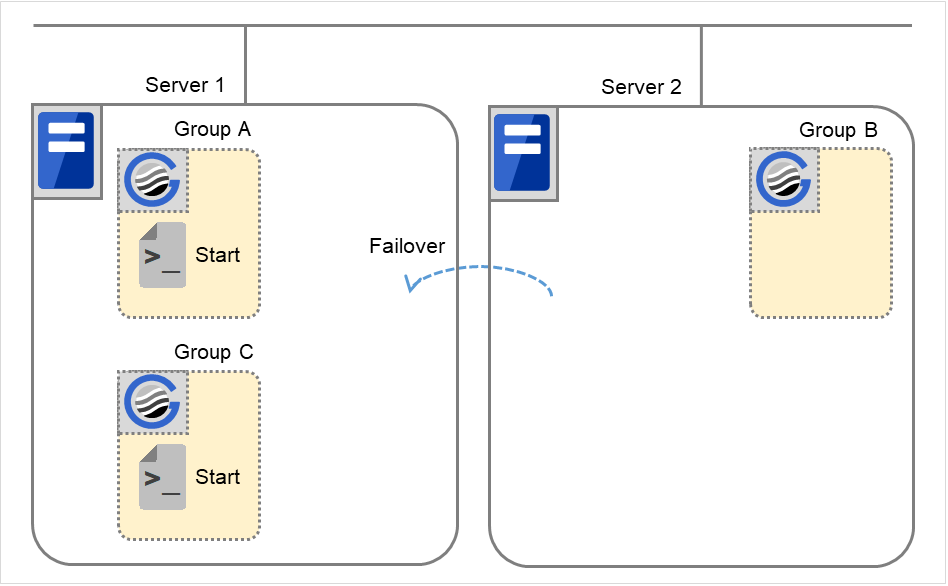

Replicator を使用している場合 (サーバ 2 台の場合)Group A と Group B が排他ルールに所属していない場合

図 3.4 各サーバの状態とGroup A、Group Bの起動状況(Replicator使用時)¶

クラスタの立ち上げ

クラスタのシャットダウン

Server 1 ダウン:Group A の待機系サーバへフェイルオーバする

Server 1 の電源 ON

クラスタのシャットダウン

Group A の移動

Server 2 ダウン:Group B の待機系サーバへフェイルオーバする

Server 2 ダウン

Server 2 ダウン:待機系サーバへフェイルオーバする

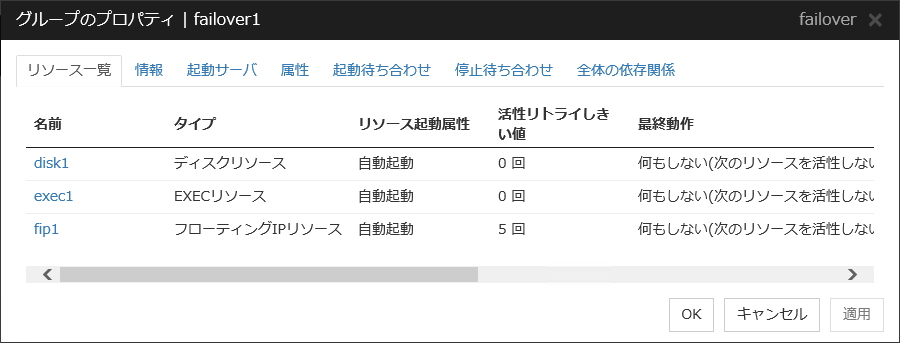

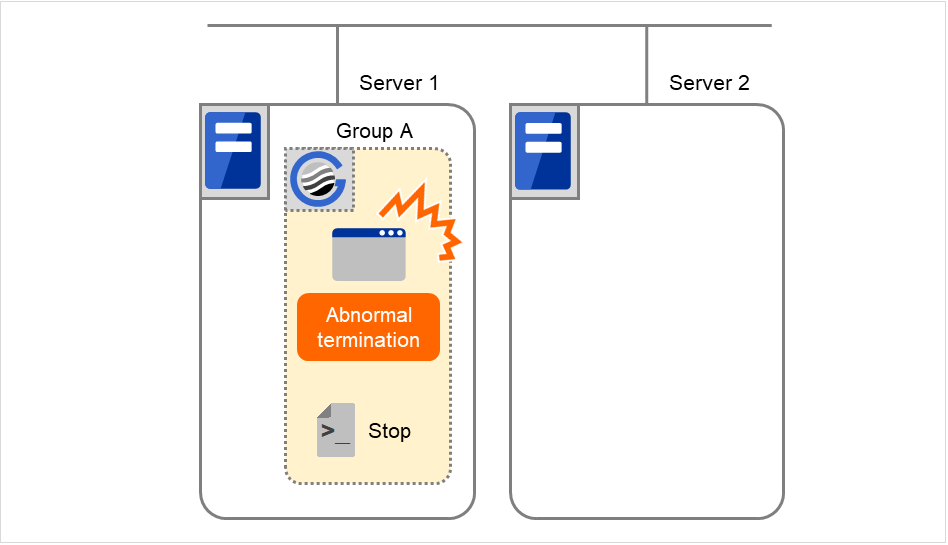

3.2.4. 活性異常、非活性異常検出時の動作¶

活性異常、非活性異常検出時には以下の制御が行われます。

グループリソース活性異常検出時の流れ

グループリソースの活性時に異常を検出した場合、活性リトライを行います。

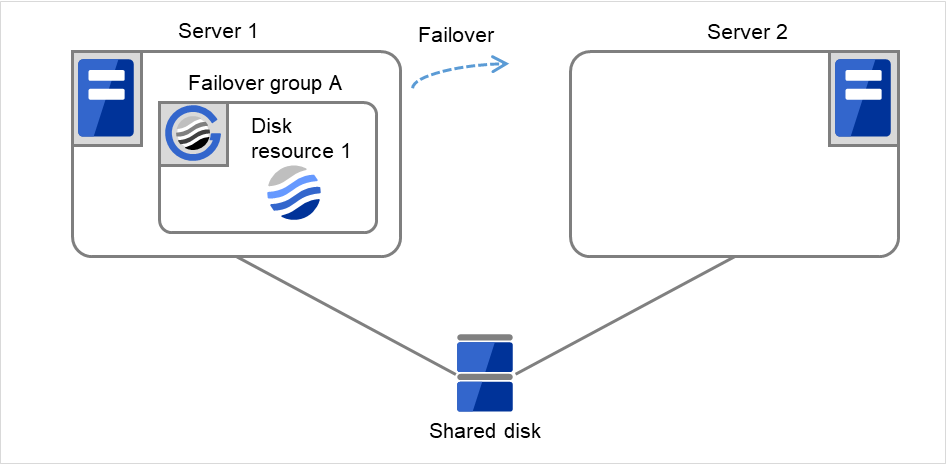

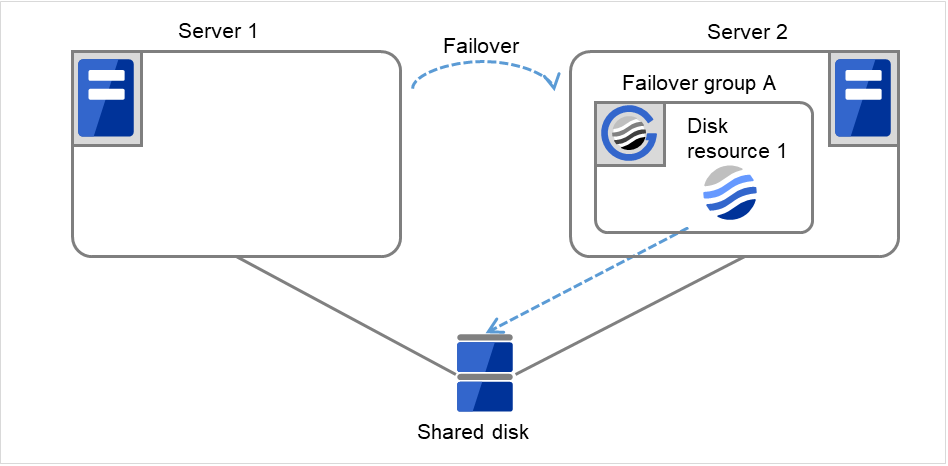

[活性リトライしきい値] に設定されている回数の活性リトライに失敗した場合、フェイルオーバを行います。

[フェイルオーバしきい値] のフェイルオーバを行っても活性できない場合、最終動作を行います。

グループリソース非活性異常検出時の流れ

非活性時に異常を検出した場合、非活性リトライを行います。

[非活性リトライしきい値] の非活性リトライに失敗した場合、最終動作を行います。

注釈

以下の設定例でグループリソース活性異常検出時の流れを説明します。

以下を指定している場合の挙動の例

設定例活性リトライしきい値 3 回フェイルオーバしきい値 1 回最終動作 グループ停止

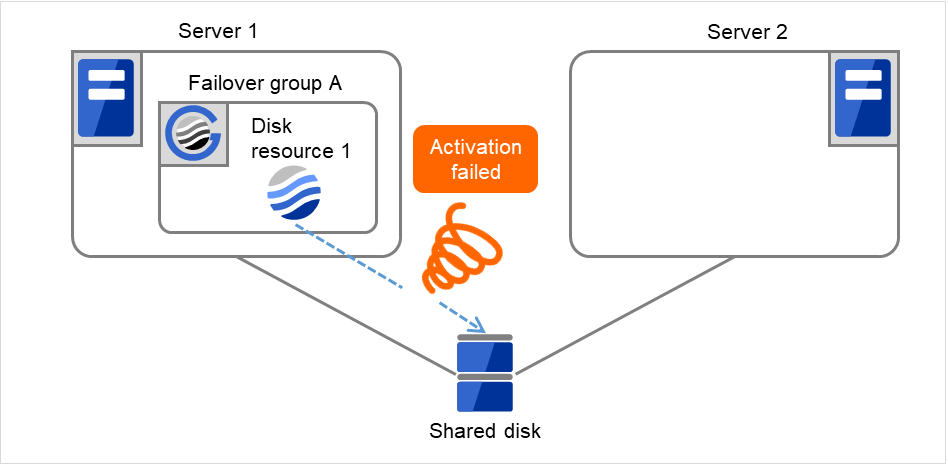

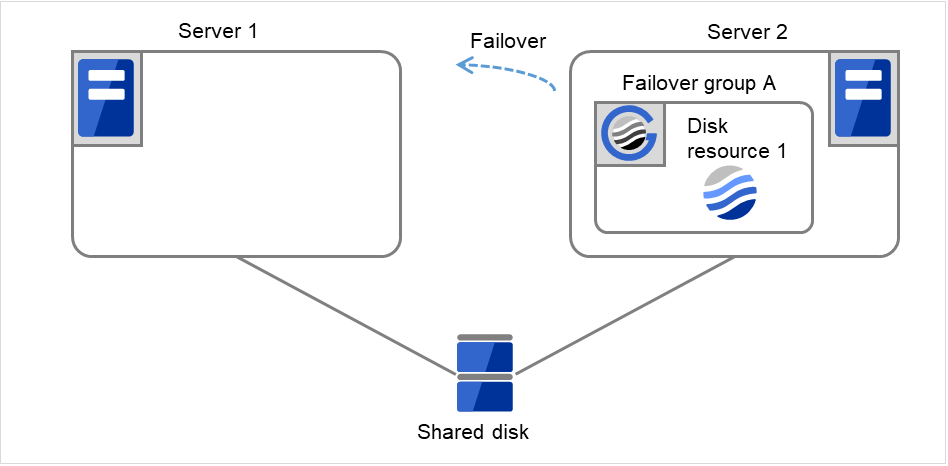

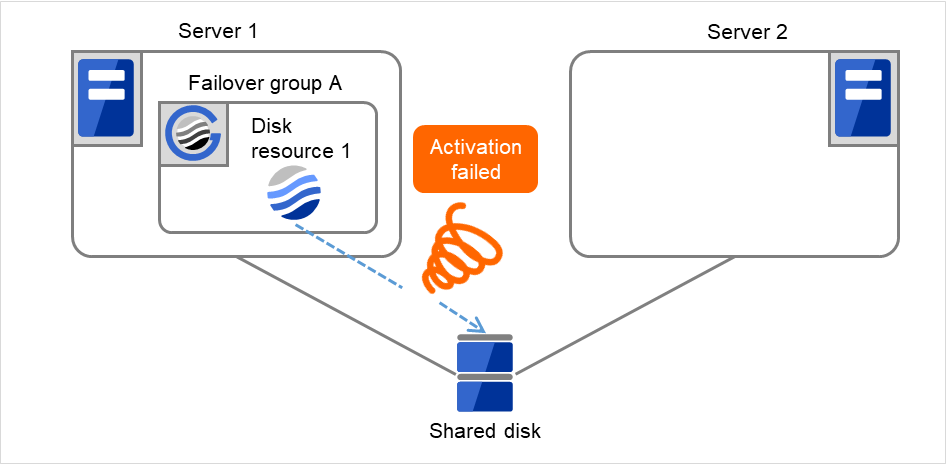

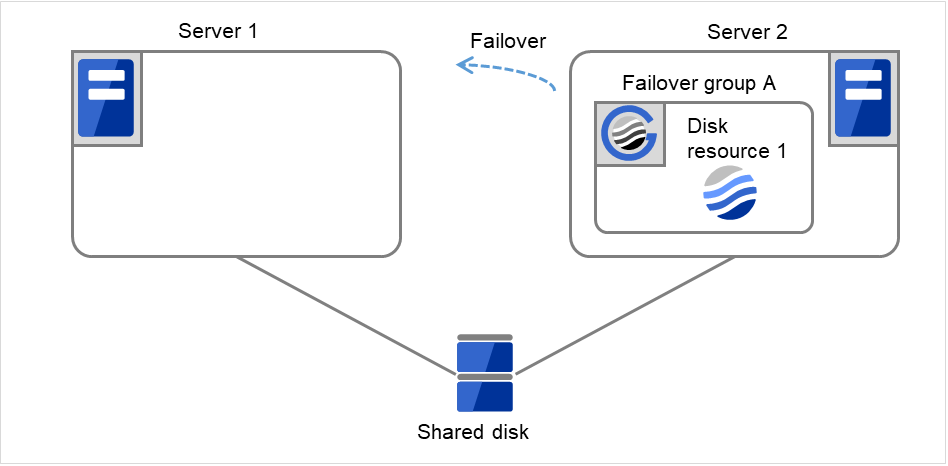

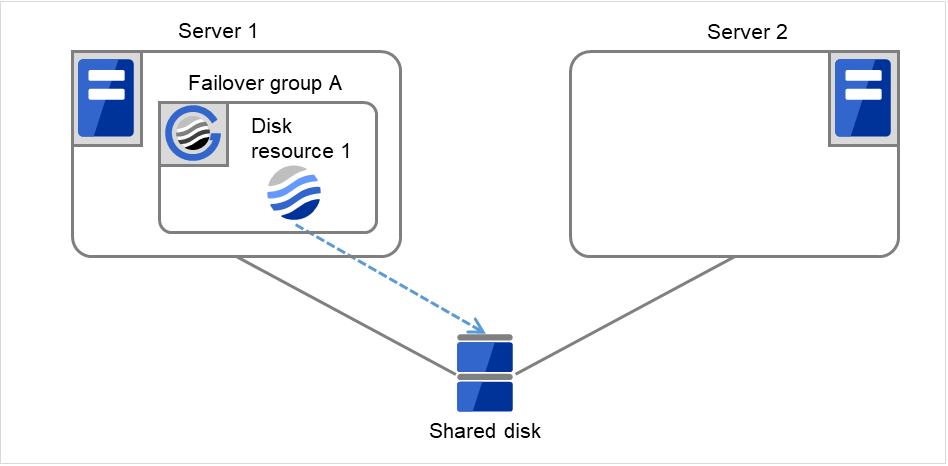

図 3.5 グループリソース活性異常検出時の流れ (1)¶

Disk resource 1の活性処理が異常(fsckの異常、mountのエラーなど)になりました。

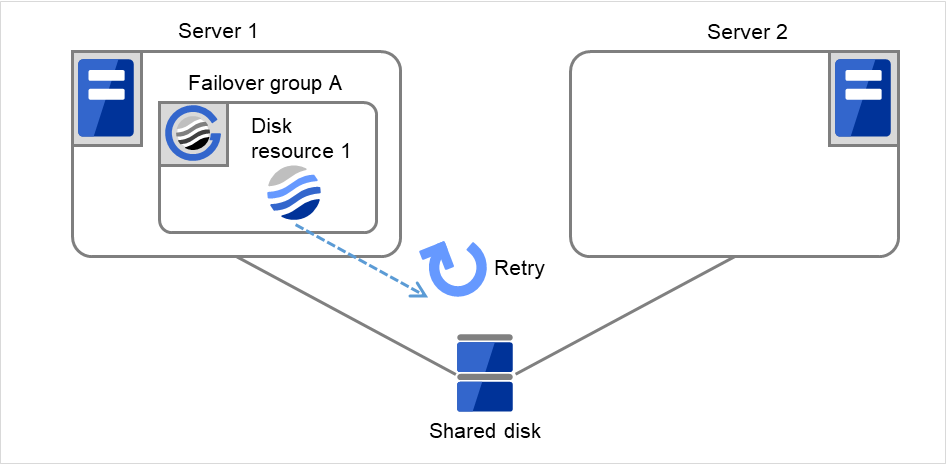

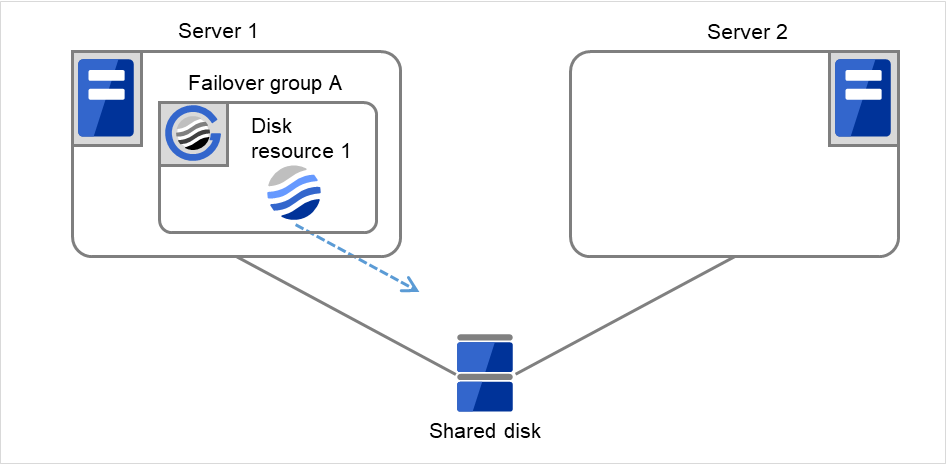

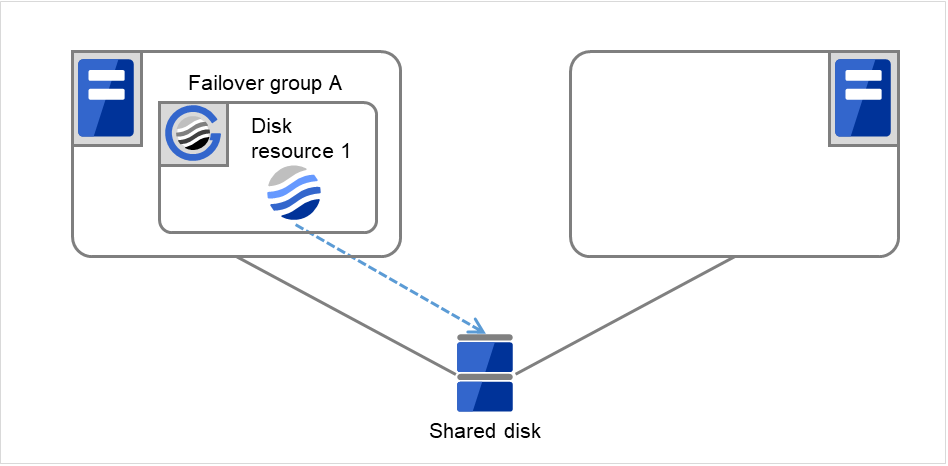

図 3.6 グループリソース活性異常検出時の流れ (2)¶

Disk resource 1の活性処理を3回(活性リトライ回数)までリトライします。

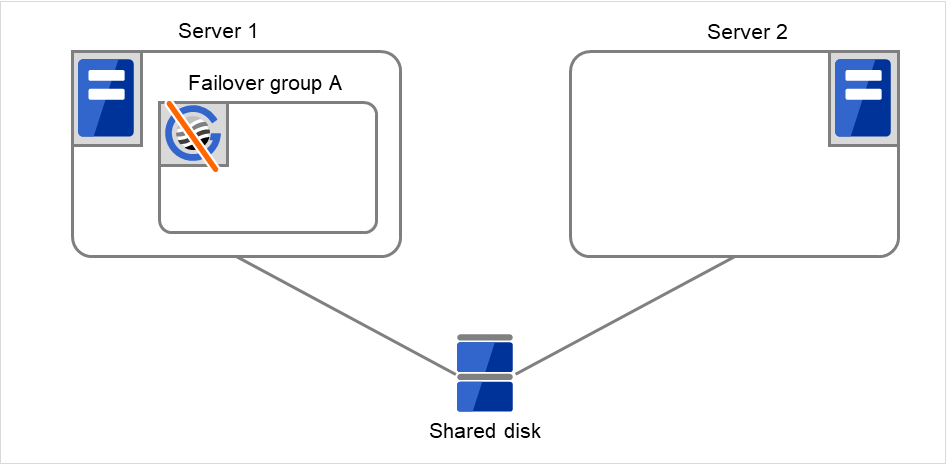

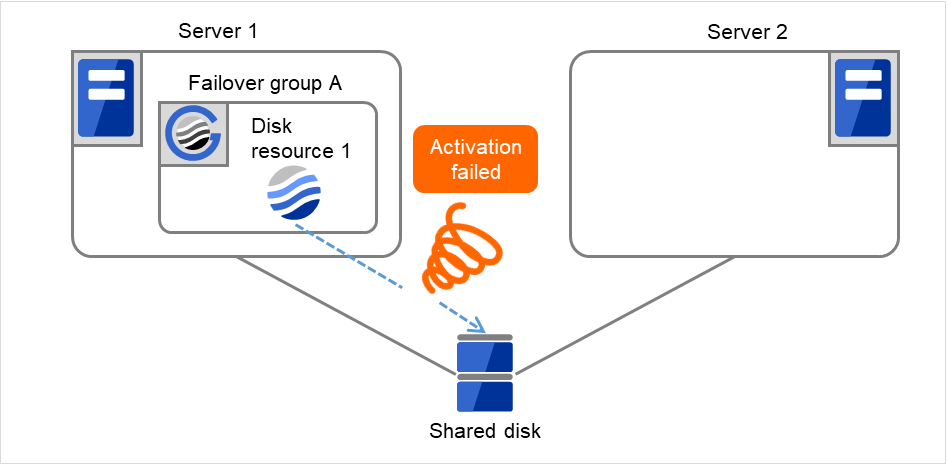

図 3.7 グループリソース活性異常検出時の流れ (3)¶

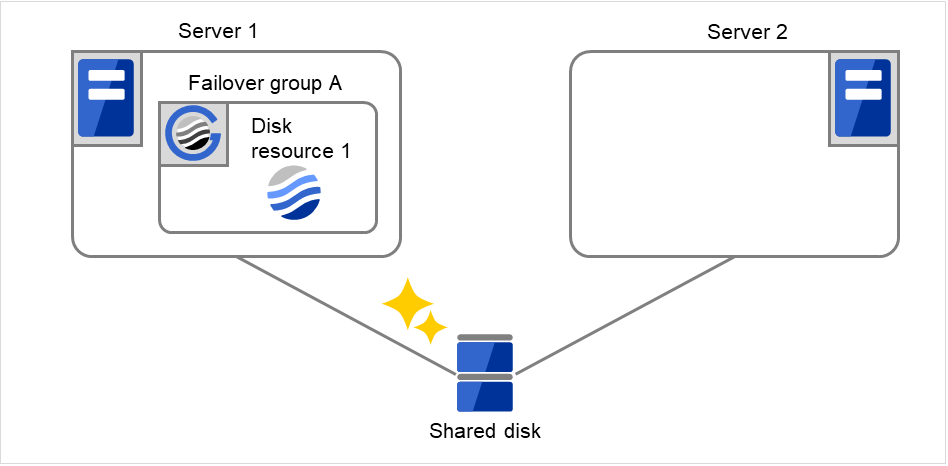

図 3.8 グループリソース活性異常検出時の流れ (4)¶

図 3.9 グループリソース活性異常検出時の流れ (5)¶

図 3.10 グループリソース活性異常検出時の流れ (6)¶

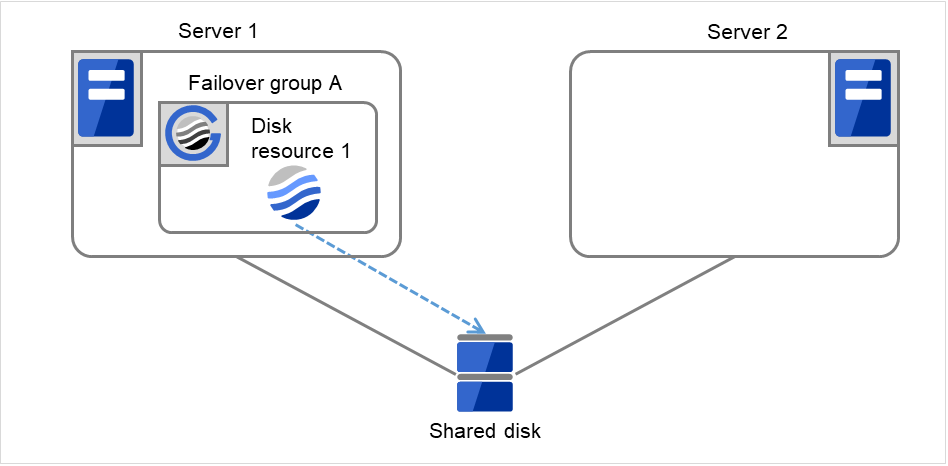

Server 1でDisk resource 1の活性処理を開始します。Disk resource 1の活性処理中に異常が発生した場合、活性処理を 3回までリトライします。

図 3.11 グループリソース活性異常検出時の流れ (7)¶

図 3.12 グループリソース活性異常検出時の流れ (8)¶

3.2.5. 最終動作前スクリプトについて¶

グループリソースの活性異常検出時、非活性異常検出時の最終動作前に、最終動作前スクリプトを実行させることが可能です。

最終動作前スクリプトで使用する環境変数

CLUSTERPRO はスクリプトを実行する場合に、どの状態で実行したか (活性異常時、非活性異常時) などの情報を環境変数にセットします。

スクリプト内で下図の環境変数を分岐条件として、システム運用にあった処理内容を記述できます。

環境変数 |

環境変数の値 |

意味 |

|---|---|---|

CLP_TIMING

…実行タイミング

|

START |

グループリソースの活性異常による最終動作前スクリプト実行を示します。 |

〃 |

STOP |

グループリソースの非活性異常による最終動作前スクリプト実行を示します。 |

CLP_GROUPNAME

…グループ名

|

グループ名 |

最終動作前スクリプトを実行する原因となる異常を検出したグループリソースが所属するグループ名を示します。 |

CLP_RESOURCENAME

…グループリソース名

|

グループリソース名 |

最終動作前スクリプトを実行する原因となる異常を検出したグループリソース名を示します。 |

最終動作前スクリプトの記述の流れ

前のトピックの環境変数と、実際のスクリプトの記述を関連付けて説明します。

活性異常時の最終動作前スクリプトの一例

#!/bin/sh # *************************************** # * preactaction.sh # *************************************** ulimit -s unlimited echo "START" # スクリプト実行要因の環境変数を参照して、処理の振り分けを行う。 if [ "$CLP_TIMING" = "START" ] then # ここに、活性異常時最終動作前に実行すべき回復処理を記述する。 # else echo "NO_CLP" fi echo "EXIT" exit 0最終動作前スクリプト作成のヒント

以下の点に注意して、スクリプトを作成してください。

スクリプト中にて、実行に時間を必要とするコマンドを実行する場合には、コマンドの実行が完了したことを示すトレースを残すようにしてください。この情報は、問題発生時、障害の切り分けを行う場合に使用することができます。clplogcmdを使用してトレースを残す方法があります。

(例:スクリプト中のイメージ)

clplogcmd -m "recoverystart.." recoverystart clplogcmd -m "OK"最終動作前スクリプト 注意事項

スクリプトから起動されるコマンド、アプリケーションのスタックサイズについて

スタックサイズが 2MB に設定された状態で回復スクリプト、回復動作前スクリプトが実行されます。このため、スクリプトから起動されるコマンドやアプリケーションで 2MB 以上のスタックサイズが必要な場合には、スタックオーバーフローが発生します。スタックオーバーフローが発生する場合には、コマンドやアプリケーションを起動する前にスタック サイズを設定してください。最終動作前スクリプトが実行される条件について

最終動作前スクリプトはグループリソースの活性異常検出時、非活性異常検出時の最終動作の前に実行されます。最終動作に [何もしない(次のリソースを活性/非活性する)] や、[何もしない(次のリソースを活性/非活性しない)] が設定されている場合にも、最終動作前スクリプトは実行されます。最大再起動回数や、他のサーバが全て停止している場合の最終動作抑制機能によって最終動作が実行されない場合は、最終動作前スクリプトは実行されません。

3.2.6. 活性/非活性前後スクリプトについて¶

グループリソースの活性/非活性前後に、任意のスクリプトを実行させることが可能です。

活性/非活性前後スクリプトで使用する環境変数

環境変数 |

環境変数の値 |

意味 |

|---|---|---|

CLP_TIMING

…実行タイミング

|

PRESTART |

グループリソース活性前のスクリプト実行を示します。 |

〃 |

POSTSTART |

グループリソース活性後のスクリプト実行を示します。 |

〃 |

PRESTOP |

グループリソース非活性前のスクリプト実行を示します。 |

〃 |

POSTSTOP |

グループリソース非活性後のスクリプト実行を示します。 |

CLP_GROUPNAME

…グループ名

|

グループ名 |

スクリプトが属しているグループリソースのグループ名を示します。 |

CLP_RESOURCENAME

…グループリソース名

|

グループリソース名 |

スクリプトが属しているグループリソース名を示します。 |

活性/非活性前後スクリプトの記述の流れ

前のトピックの、環境変数と実際のスクリプト記述を関連付けて説明します。

活性/非活性前後スクリプトの一例

#!/bin/sh #*********************************************** # rscextent.sh * #*********************************************** ulimit -s unlimited echo "START" if [ "$CLP_TIMING" = "PRESTART" ] then echo "$CLP_GROUPNAME" echo "$CLP_RESOURCENAME" # ここに、リソース活性前に実行したい任意の処理を記述する。 # elif [ "$CLP_TIMING" = "POSTSTART" ] then echo "$CLP_GROUPNAME" echo "$CLP_RESOURCENAME" # ここに、リソース活性後に実行したい任意の処理を記述する。 # elif [ "$CLP_TIMING" = "PRESTOP" ] then echo "$CLP_GROUPNAME" echo "$CLP_RESOURCENAME" # ここに、リソース非活性前に実行したい任意の処理を記述する。 # elif [ "$CLP_TIMING" = "POSTSTOP" ] then echo "$CLP_GROUPNAME" echo "$CLP_RESOURCENAME" # ここに、リソース非活性後に実行したい任意の処理を記述する。 # fi echo "EXIT" exit 0活性/非活性前後スクリプト作成のヒント

以下の点に注意して、スクリプトを作成してください。

スクリプト中にて、実行に時間を必要とするコマンドを実行する場合には、コマンドの実行が完了したことを示すトレースを残すようにしてください。この情報は、問題発生時、障害の切り分けを行う場合に使用することができます。clplogcmdを使用してトレースを残す方法があります。

(例:スクリプト中のイメージ)

clplogcmd -m "start.." : clplogcmd -m "OK"活性/非活性前後スクリプト 注意事項

3.2.7. 再起動回数制限について¶

活性異常、非活性異常検出時の最終動作として OS の再起動を伴うような設定をしている場合に、活性異常、非活性異常の検出によるシャットダウン回数、または再起動回数を制限することができます。

この最大再起動回数はサーバごとの再起動回数の上限になります。

注釈

再起動回数はサーバごとに記録されるため、最大再起動回数はサーバごとの再起動回数の上限になります。

また、グループ活性、非活性異常検出時の最終動作による再起動回数とモニタリソース異常の最終動作による再起動回数も別々に記録されます。

最大再起動回数をリセットする時間に 0 を設定した場合には、再起動回数はリセットされません。リセットする場合は [clpregctrl] コマンドを使用する必要があります。[clpregctrl] コマンドに関しては「8. CLUSTERPRO コマンドリファレンス」の「再起動回数を制御する (clpregctrl コマンド)」を参照してください。

以下の設定例で再起動回数制限の流れを説明します。

最大再起動回数が 1 回に設定されているため、一度だけ最終動作である[クラスタサービス停止と OS 再起動] が実行されます。

また、最大再起動回数をリセットする時間が 10 分に設定されているため、クラスタシャットダウン後再起動時にグループの活性に成功した場合には、10 分経過すると再起動回数はリセットされます。

以下を指定している場合の挙動の例

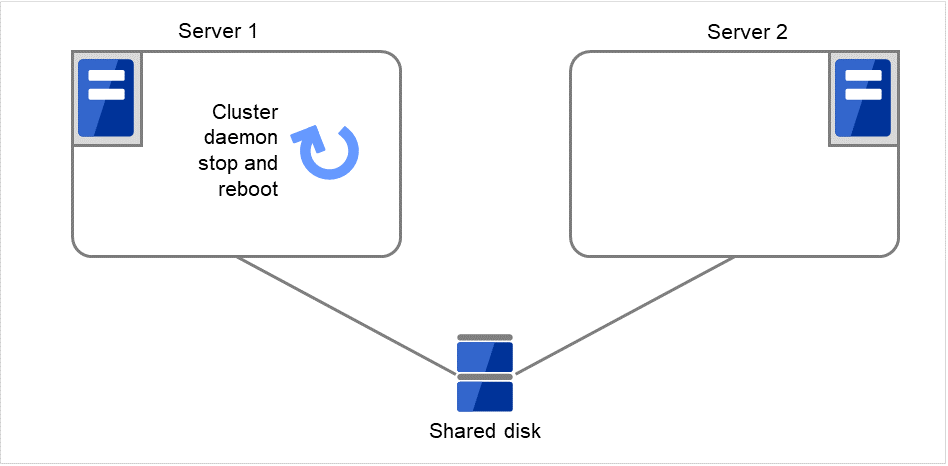

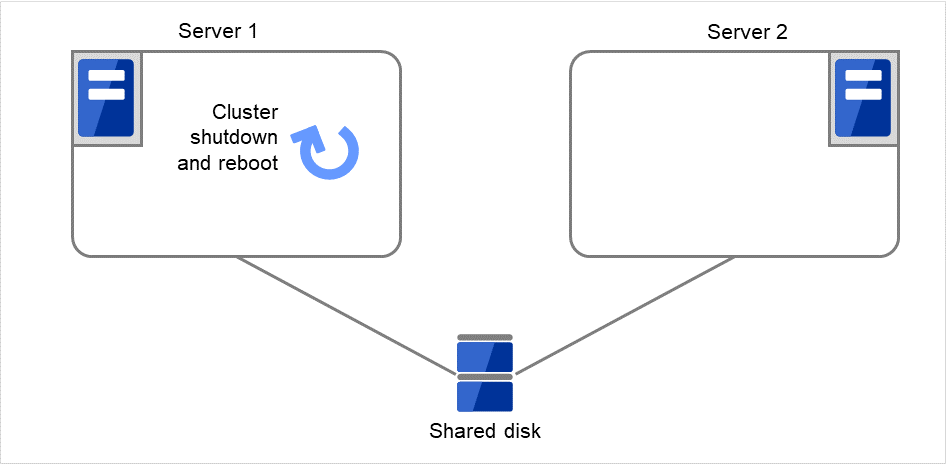

図 3.13 再起動回数制限時の処理 (1)¶

Server 1

Server 2

最大再起動回数

1回

1回

再起動回数

0回

0回

Disk resource 1の活性処理が異常(fsckの異常、mountのエラーなど)になりました。

図 3.14 再起動回数制限時の処理 (2)¶

Server 1

Server 2

最大再起動回数

1回

1回

再起動回数

0回

0回

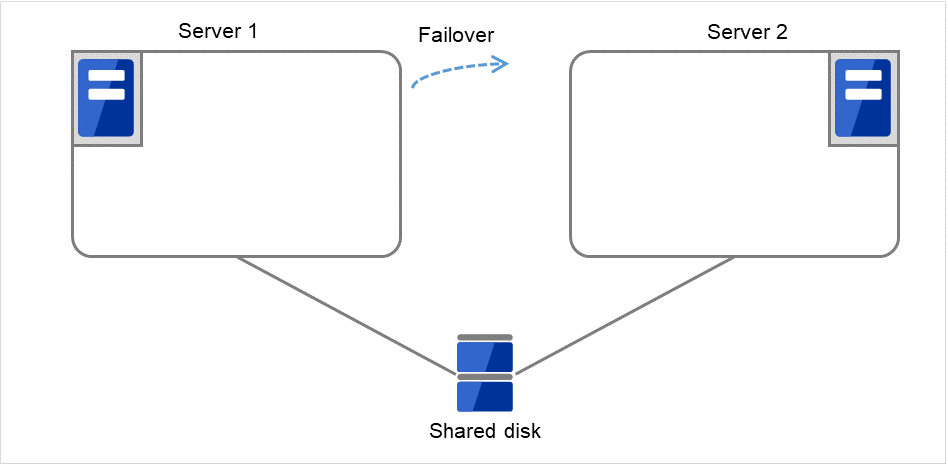

図 3.15 再起動回数制限時の処理 (3)¶

Server 1

Server 2

最大再起動回数

1回

1回

再起動回数

1回

0回

Failover group Aのフェイルオーバ処理を開始します。

図 3.16 再起動回数制限時の処理 (4)¶

Server 1

Server 2

最大再起動回数

1回

1回

再起動回数

1回

0回

図 3.17 再起動回数制限時の処理 (5)¶

Server 1

Server 2

最大再起動回数

1回

1回

再起動回数

1回

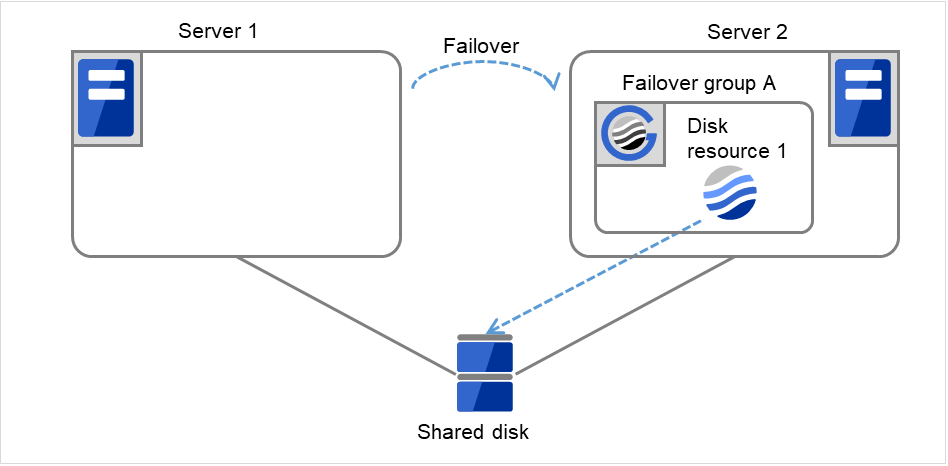

0回

clpgrpコマンド、Cluster WebUIを使用して、Failover group Aのフェイルオーバ処理を開始します。

図 3.18 再起動回数制限時の処理 (6)¶

Server 1

Server 2

最大再起動回数

1回

1回

再起動回数

1回

0回

Disk resource 1の活性処理(ファイルシステムのマウント処理等)を開始します。

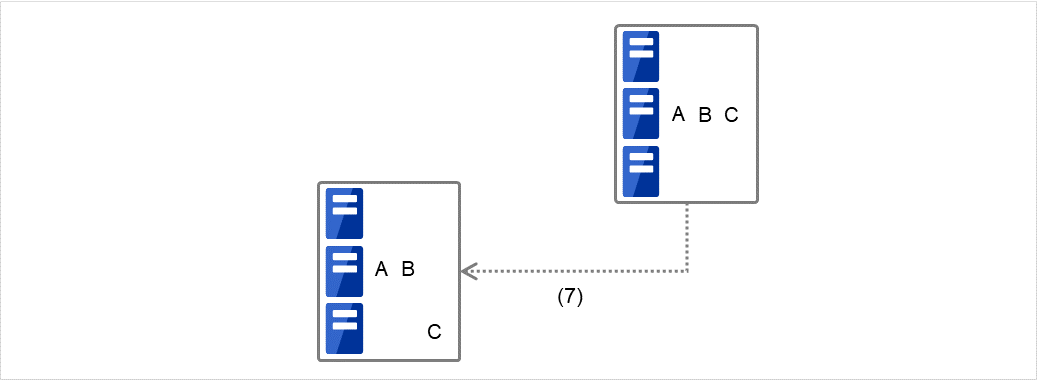

図 3.19 再起動回数制限時の処理 (7)¶

Server 1

Server 2

最大再起動回数

1回

1回

再起動回数

1回

0回

図 3.20 再起動回数制限時の処理 (8)¶

Server 1

Server 2

最大再起動回数

1回

1回

再起動回数

1回

0回

図 3.21 再起動回数制限時の処理 (9)¶

図 3.22 再起動回数制限時の処理 (10)¶

Server 1

Server 2

最大再起動回数

1回

1回

再起動回数

1回

0回

図 3.23 再起動回数制限時の処理 (11)¶

Server 1

Server 2

最大再起動回数

1回

1回

再起動回数

1回

0回

3.2.8. 再起動回数初期化¶

再起動回数を初期化する場合、[clpregctrl] コマンドを使用してください。[clpregctrl] コマンドに関しては本ガイドの「8. CLUSTERPRO コマンドリファレンス」の「再起動回数を制御する (clpregctrl コマンド)」を参照してください。

3.2.9. 両系活性チェックについて¶

グループ起動時に、両系活性が発生するか否かを確認することができます。

- 両系活性が発生しないと判断した場合グループの起動処理を開始します。

- 両系活性が発生すると判断した場合(タイムアウトした場合)グループの起動処理を開始しません。グループを起動しようとしたサーバでは、グループは停止状態となります。

注釈

グループが停止状態で、リソースの単体起動が実施された場合、両系活性チェックは実施されます。しかし、グループの中で1つでもリソースが活性している状態でリソースの単体起動を実施した場合は、両系活性チェックは実施されません。

[両系活性チェックを行う] がオンのグループに、フローティングIPリソースが存在しない場合、両系活性チェックは実行せず、グループの起動を開始します。

両系活性が発生すると判断した場合、グループやリソースの状態がサーバ間で不整合となる場合があります。

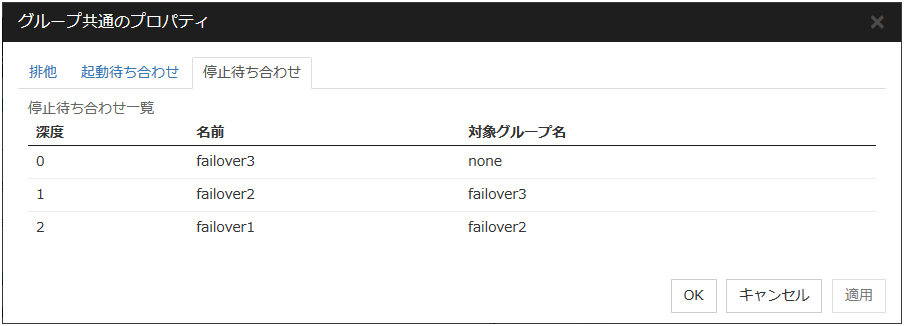

3.2.10. グループの起動、停止待ち合わせ設定を理解する¶

グループの起動、停止待ち合わせを設定することにより、グループを起動、停止する順序を設定することができます。

グループの起動待ち合わせを設定した場合:

グループ起動時は、起動待ち合わせ対象のグループの起動処理が正常に完了してから、このグループの起動処理が開始されます。

グループ起動時に、起動待ち合わせするように設定されているグループの待ち合わせタイムアウト時にはグループは起動しません。

グループの停止待ち合わせを設定した場合:

グループ停止時は、停止待ち合わせ対象のグループの停止処理が正常に完了してから、このグループの停止処理が開始されます。

停止待ち合わせ処理でタイムアウトが発生した場合、グループの停止処理は継続します。

停止待ち合わせは、Cluster WebUI で設定した条件で実行されます。

グループの起動、停止待ち合わせ設定を表示するには、Cluster WebUI の設定モードからグループのプロパティをクリックし、[起動待ち合わせ] タブ、[停止待ち合わせ] タブをクリックします。

例としてグループの起動待ち合わせする深度を一覧で表示します。

図 3.24 グループの起動順序¶

グループ起動の実行を、簡単な状態遷移の例で説明します。

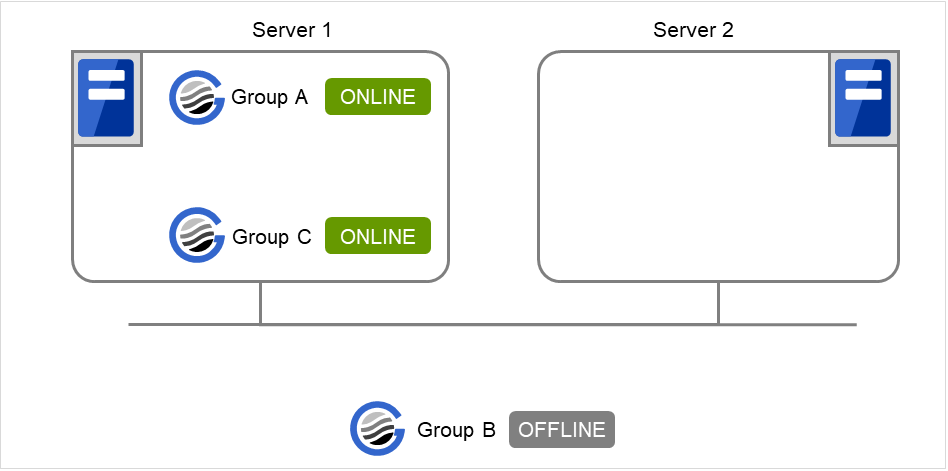

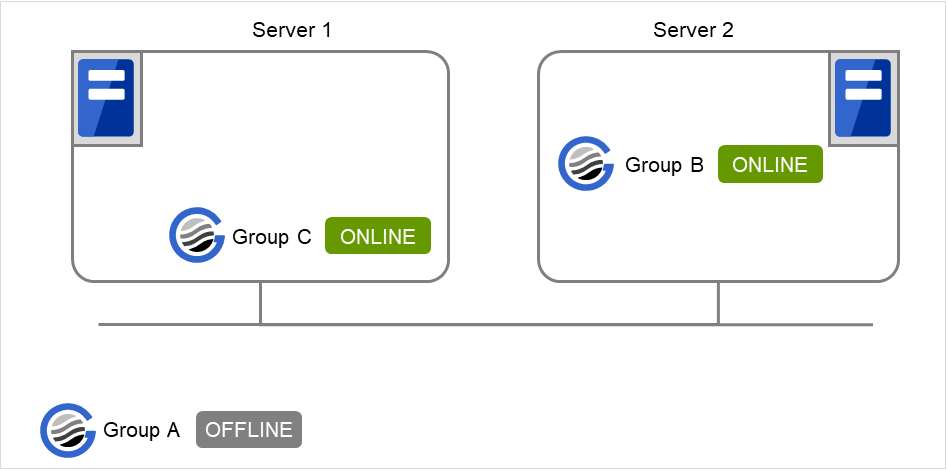

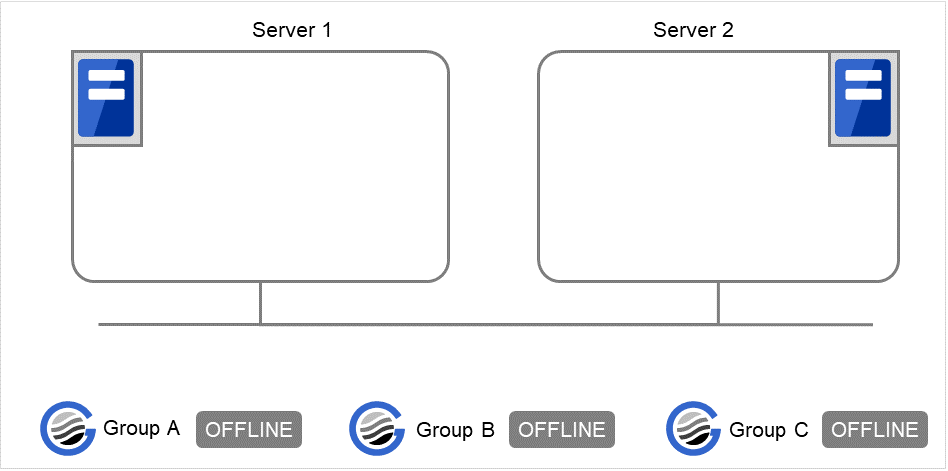

2 台構成のサーバで、グループを 3 つ持っている場合

グループのフェイルオーバポリシー

Group A

Server 1

Group B

Server 2

Group C

Server 1 → Server 2

グループの起動待ち合わせ設定

Group A

起動待ち合わせ設定なし

Group B

起動待ち合わせ設定なし

Group C

Server 1 でGroup AとGroup Cを起動する場合

Server 1 で、Group A の正常起動を待ってからGroup Cが起動します。

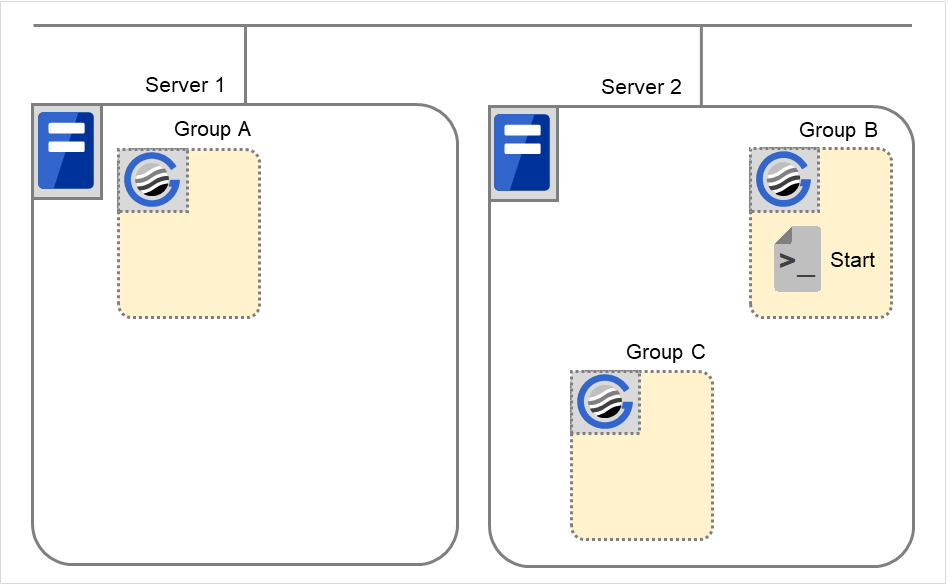

図 3.25 Server 1 でGroup AとGroup Cが起動¶

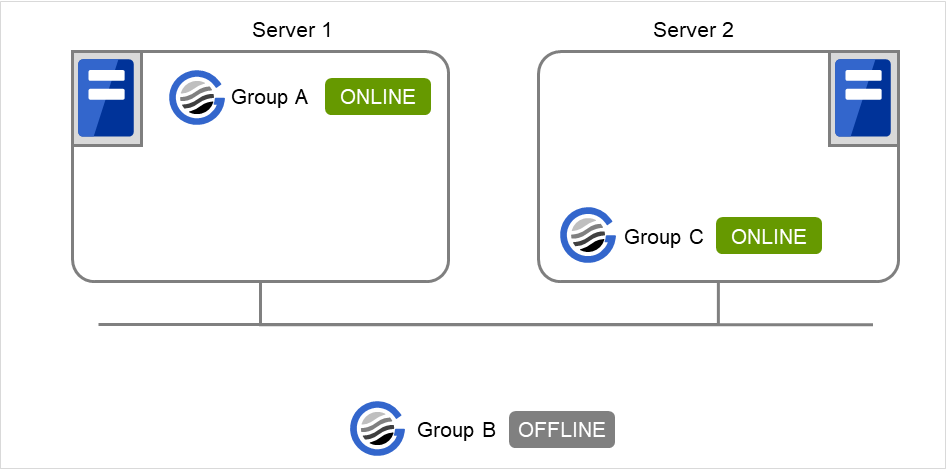

Server 1 でGroup A、Server 2でGroup Cを起動する場合

Server 1 でGroup A の正常起動を待ってから、Server 2でGroup Cが起動します。「同じサーバで起動する場合のみ待ち合わせを行う」が設定されていないため他サーバで起動するGroup Aの正常起動を待ち合わせます。

図 3.26 Server 1 でGroup A、Server 2でGroup Cが起動¶

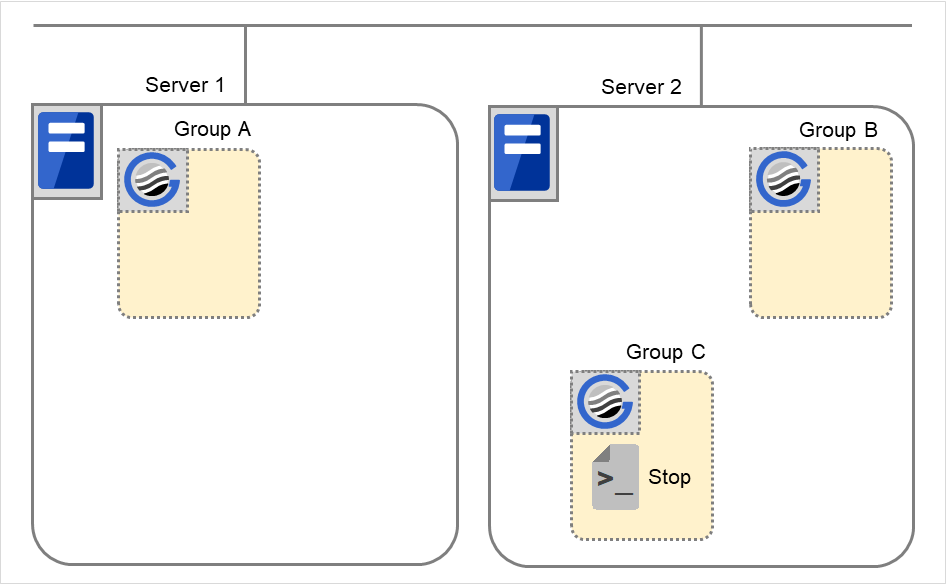

Server 1 でGroup C、Server 2でGroup Bを起動する場合

Server 1 でGroup B の正常起動を待たずにGroup Cが起動します。Group Cは同じサーバで起動する場合のみGroup Bの起動を待つように設定されていますが、Group BはServer 1では起動しない設定のため、待ち合わせしません。

図 3.27 Server 1 でGroup C、Server 2でGroup Bが起動¶

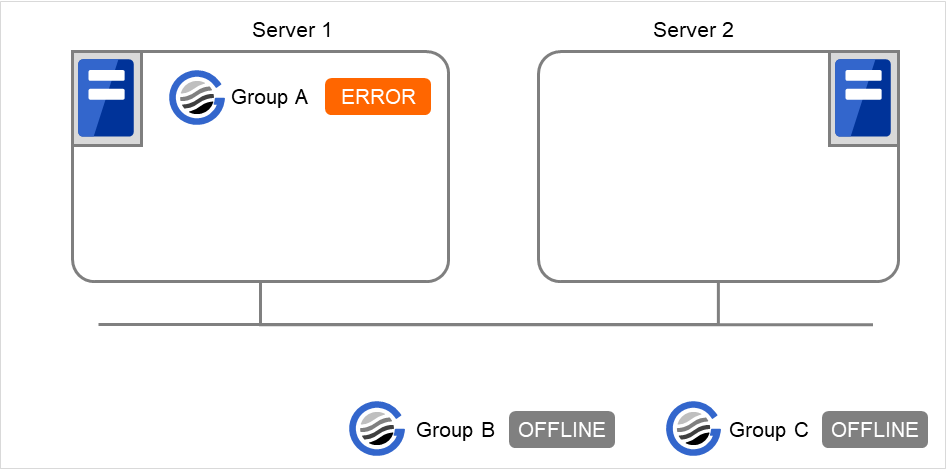

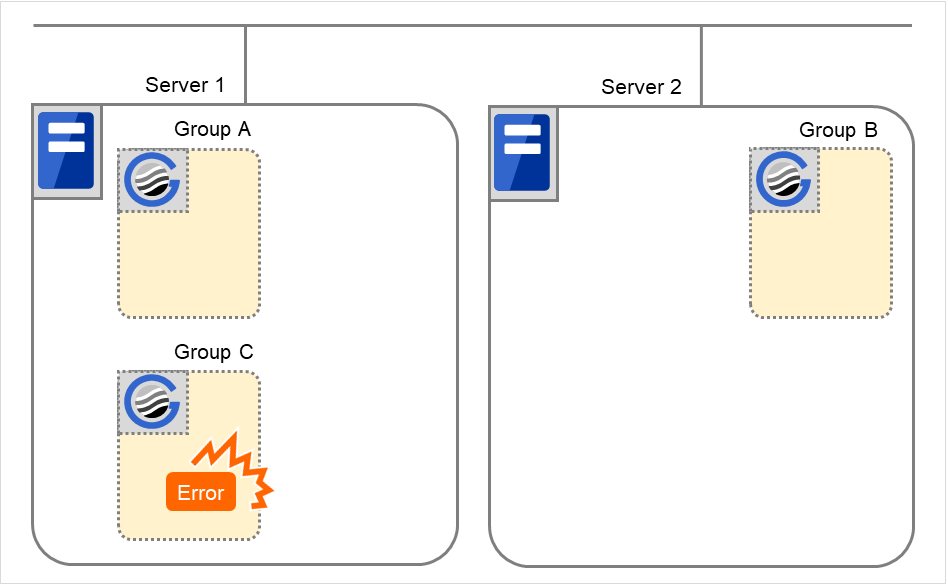

Server 1でGroup AとGroup Cを起動する場合

Server 1でGroup Aの起動がエラーになった場合、Group Cは起動しません。

図 3.28 Server 1でGroup Aの起動がエラー、Group Cが起動しない¶

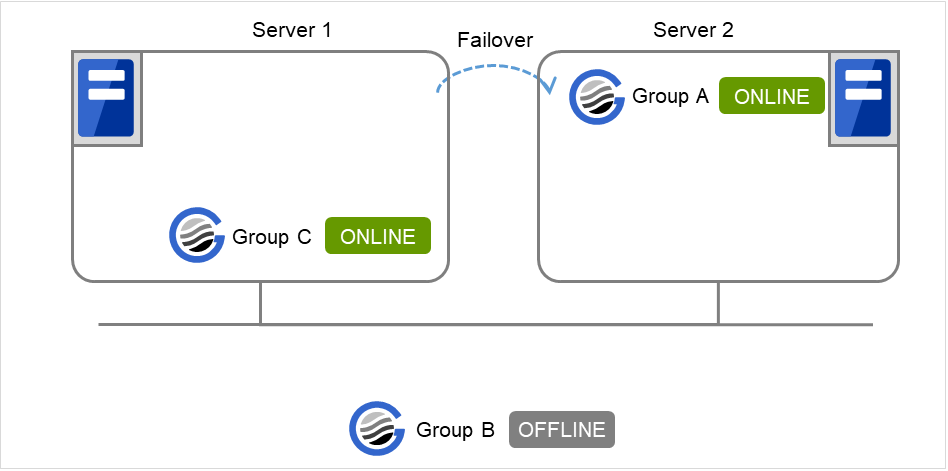

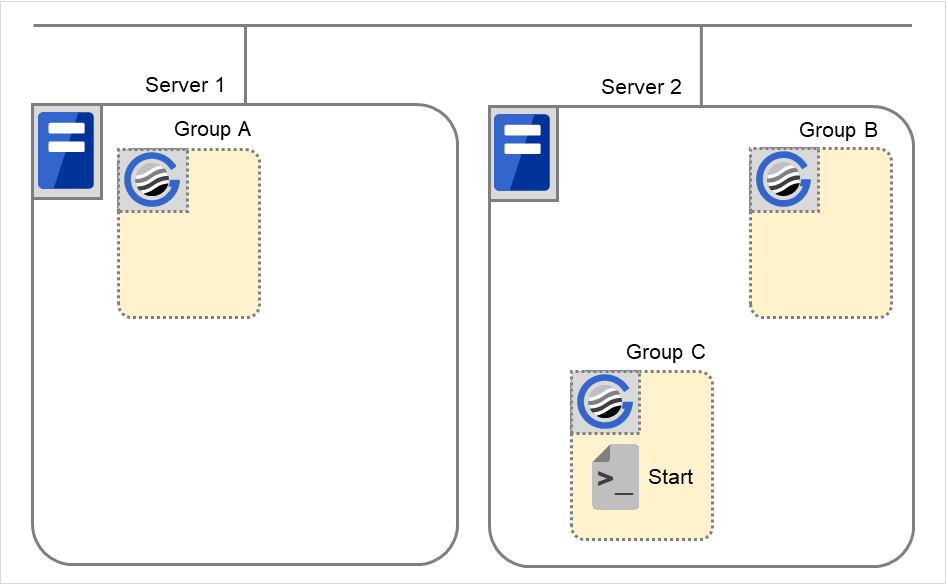

Server 1でGroup AとGroup Cを起動する場合

Server 1でGroup Aの起動が失敗しGroup Aのリソースの復旧動作によりServer 2にフェイルオーバが発生した場合、Server 2でGroup Aが起動した後でServer 1でGroup Cが起動します。

図 3.29 Group AはServer 2にフェイルオーバ、Server 1でGroup Cが起動¶

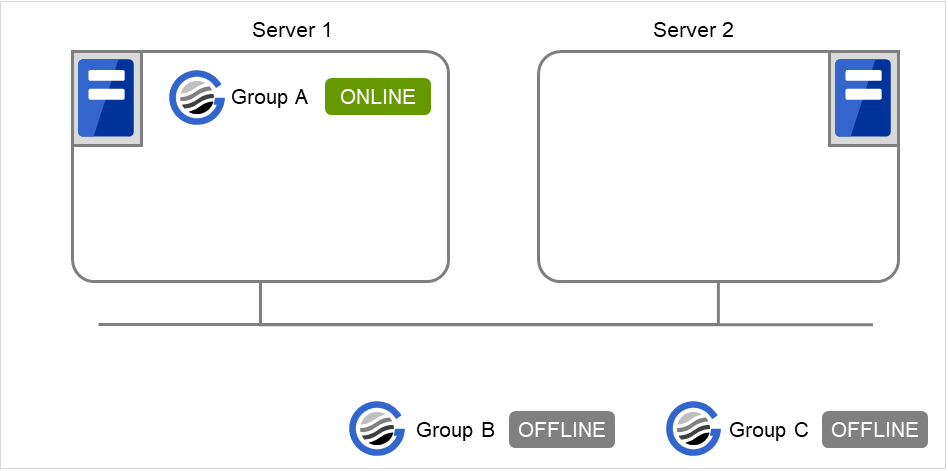

Server 1でGroup AとGroup Cを起動する場合

Server 1でGroup Aの起動待ち合わせタイムアウトが発生した場合、Group Cは起動しません。

図 3.30 Server 1 でGroup Aが起動¶

Server 1でGroup Cのみを起動する場合

Server 1でGroup Aが起動していないため、起動待ち合わせタイムアウトが発生しGroup Cは起動しません。

図 3.31 Server 1 でGroup A、Group Cは起動しない¶

注釈

グループ起動時に、起動待ち合わせするように設定されているグループを自動的に起動する機能はありません。

グループ起動時に、起動待ち合わせするように設定されているグループの待ち合わせタイムアウト時にはグループは起動しません。

グループ起動時に、起動待ち合わせするように設定されているグループが起動に失敗した場合にはグループは起動しません。

起動待ち合わせ対象のグループ内に正常に起動しているリソースと停止しているリソースが存在する場合、そのグループは正常に起動済みと判断します。

グループ停止時に、停止待ち合わせするように設定されているグループを自動的に停止する機能はありません。

グループ停止時に、停止待ち合わせするように設定されているグループの待ち合わせタイムアウト時にはグループの停止処理は継続します。

グループ停止時に、停止待ち合わせするように設定されているグループが停止に失敗した場合にはグループの停止処理は継続します。

Cluster WebUI やclpgrpコマンドによるグループ停止処理やリソース停止処理では、停止待ち合わせは行いません。停止待ち合わせは、Cluster WebUI で設定した条件(クラスタ停止時、またはサーバ停止時)で実行されます。

フェイルオーバ時に起動待ち合わせ処理でタイムアウトが発生した場合にはフェイルオーバは失敗します。

3.2.11. グループの排他制御を理解する¶

フェイルオーバ排他属性はフェイルオーバの際のグループの排他属性を設定します。 ただし、以下の条件の場合には設定できません。

フェイルオーバグループのタイプが [仮想マシン] の場合

フェイルオーバ属性が [ダイナミックフェイルオーバを行う], [サーバグループ内のフェイルオーバポリシーを優先する], [サーバグループ間では手動フェイルオーバのみ有効とする] の場合

設定可能なフェイルオーバ排他属性は以下になります。

排他なし

フェイルオーバの際、排他を行いません。フェイルオーバ可能なサーバのうち、最も 優先順位の高いサーバでフェイルオーバします。

通常排他

フェイルオーバの際、排他を行います。フェイルオーバ可能なサーバのうち、他の 通常排他のグループが起動していない最も優先順位の高いサーバでフェイルオーバします。

ただし、全てのフェイルオーバ可能なサーバで既に他の通常排他のグループが起動している場合、排他を行いません。フェイルオーバ可能なサーバのうち最も優先順位の高いサーバでフェイルオーバします。

完全排他

フェイルオーバの際、排他を行います。フェイルオーバ可能なサーバのうち、他の 完全排他のグループが起動していない最も優先順位の高いサーバでフェイルオーバします。

ただし、全てのフェイルオーバ可能なサーバで既に他の完全排他のグループが起動している場合、フェイルオーバを行いません。

注釈

異なる排他ルール同士は排他を行いません。同一の排他ルールに所属するグループのみ、設定された排他属性に従い、排他制御が行われます。いずれの場合も 排他なし のグループとは排他を行いません。フェイルオーバ排他属性の詳細は 「フェイルオーバポリシーを理解する」を参照してください。また、排他ルールの設定方法の詳細は「グループ共通のプロパティ」を参照してください。

3.2.12. サーバグループを理解する¶

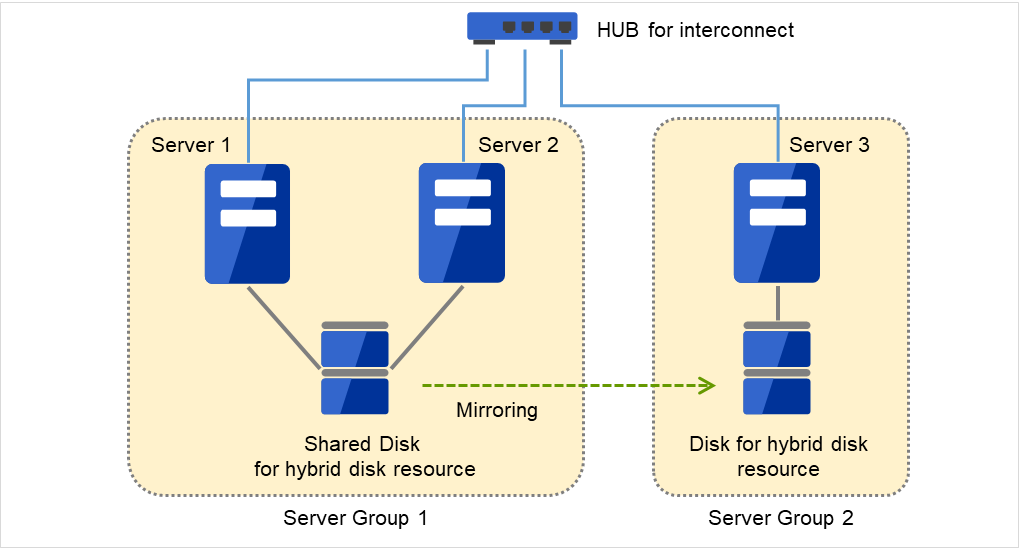

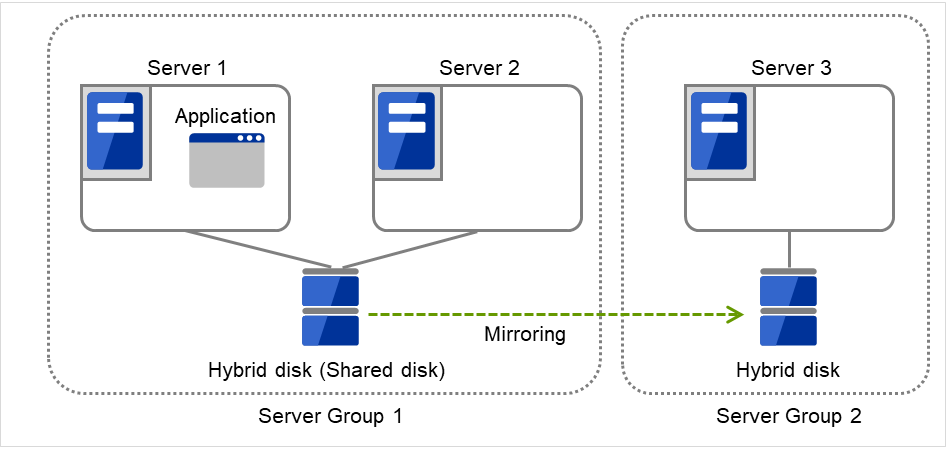

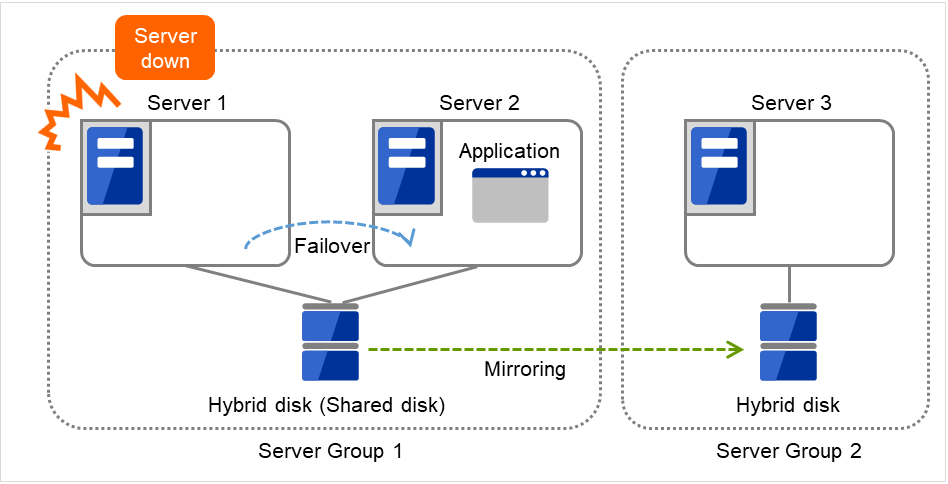

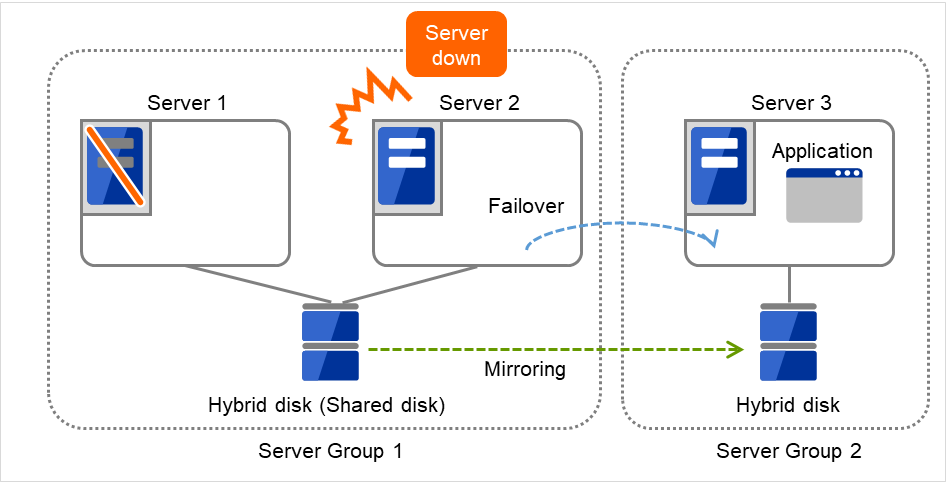

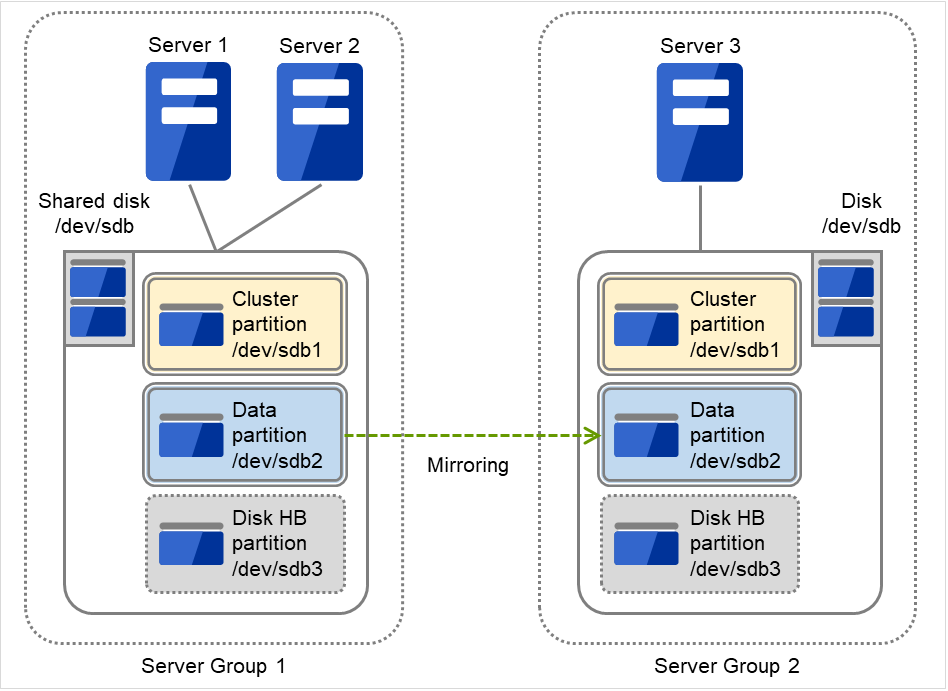

このトピックでは、サーバグループについて説明します。

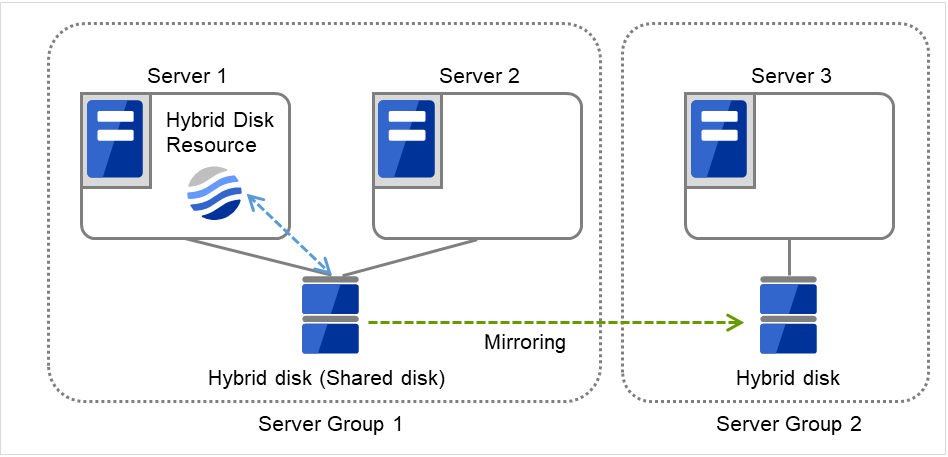

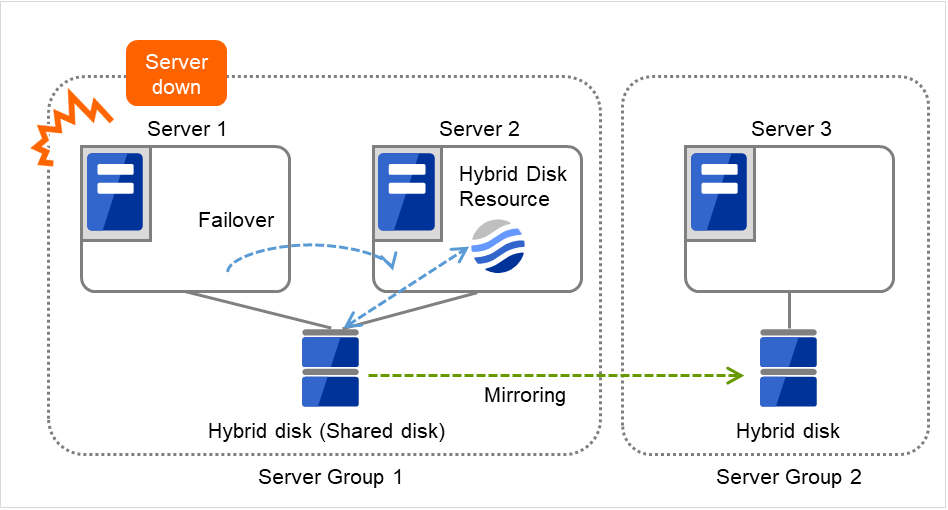

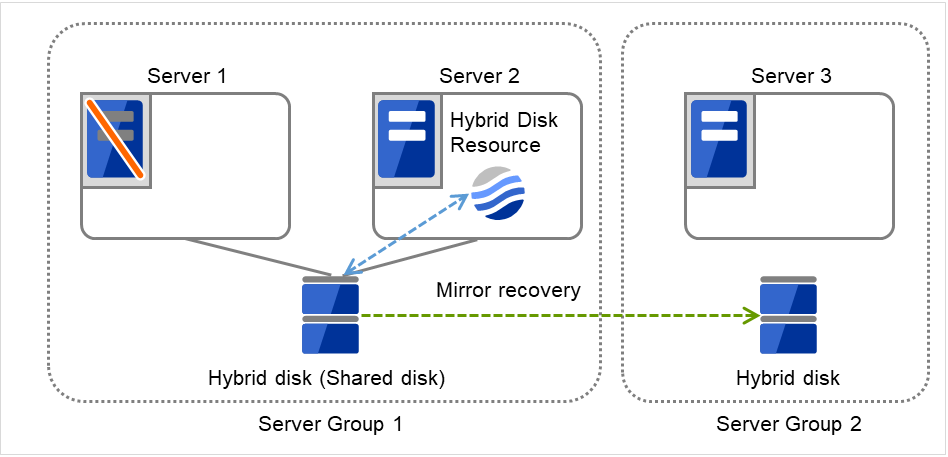

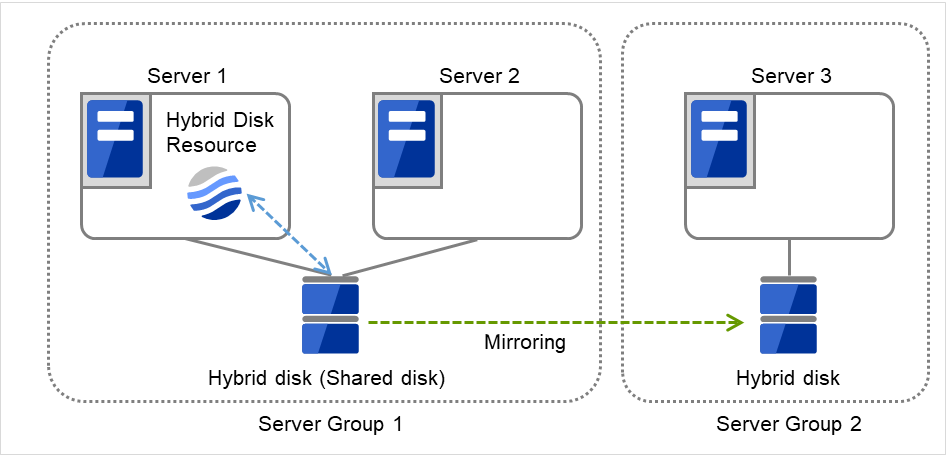

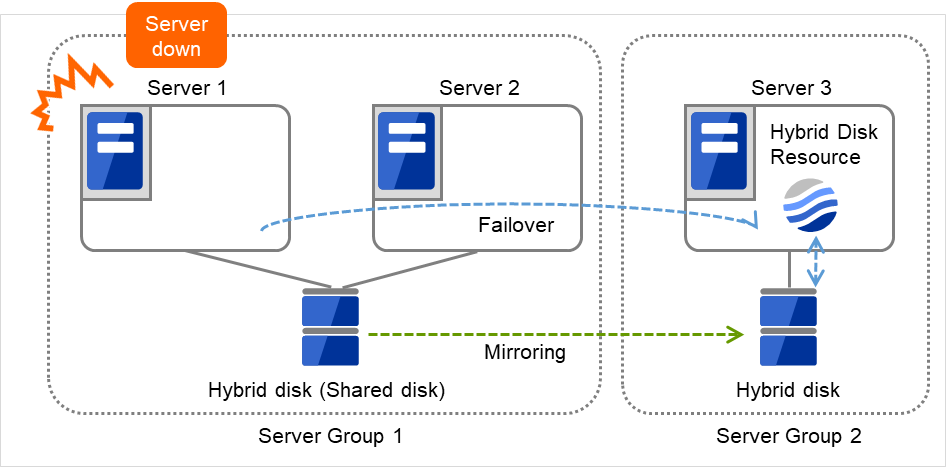

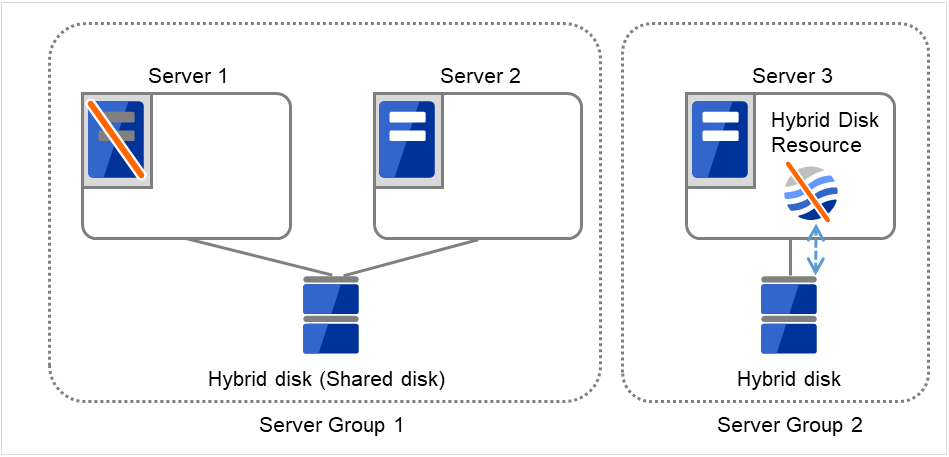

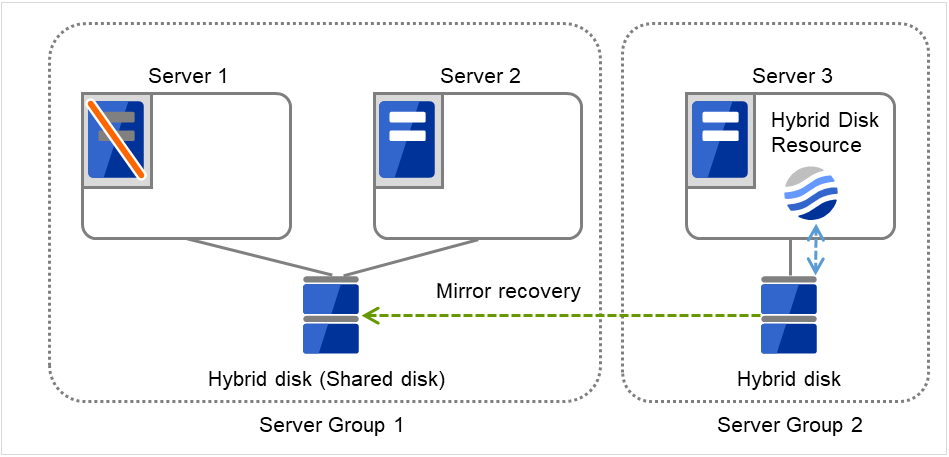

サーバグループとは、主にハイブリッドディスクリソースを使用する場合に必要なサーバ群のグループです。

共有ディスク装置でハイブリッドディスクリソースを使用する場合に同一の共有ディスク装置で接続されているサーバ群を 1 つサーバグループとして設定します。

共有型でないディスクでハイブリッドディスクリソースを使用する場合にも 1 台のサーバを1 つサーバグループとして設定します。

共有ディスク上のハイブリッドディスクリソースを使用する(ミラーリング元、ミラーリング先)サーバは、サーバグループ内の1台のサーバです。

図 3.32 サーバグループ¶

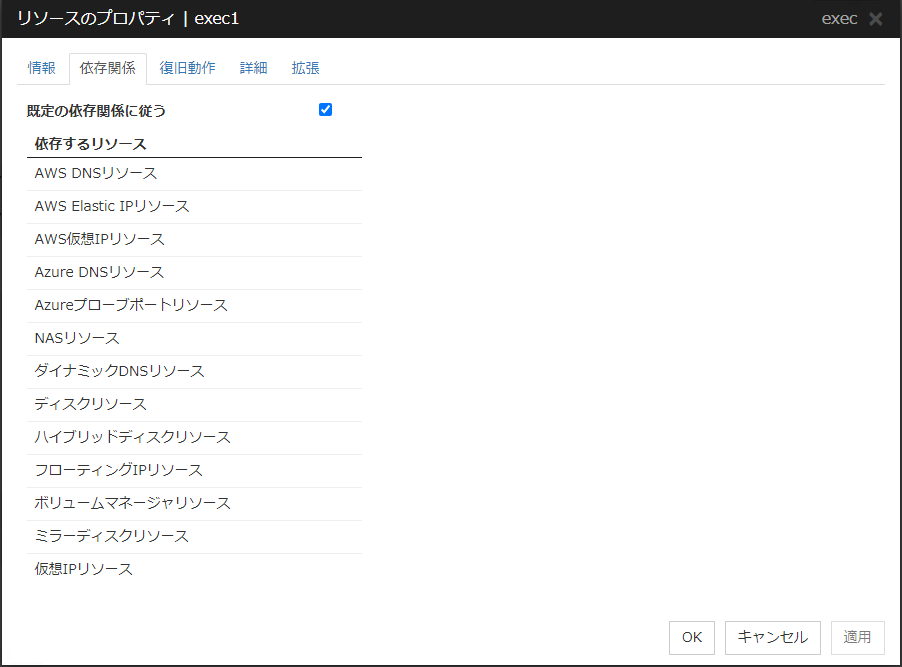

3.2.13. グループリソースの依存関係設定を理解する¶

グループリソース間に依存関係を設定することにより、グループリソースを活性する順序を設定することができます。

グループリソースに依存関係を設定した場合:

活性時は [依存するリソース] の活性化が完了してから、このグループリソースの活性化が開始されます。

非活性時はこのグループリソースの非活性化が完了してから、[依存するリソース] の非活性化が開始されます。

例として該当グループに所属するリソースの依存する深度を一覧で表示します。

図 3.33 グループリソースの活性順序の例¶

図 3.34 グループリソースの非活性順序の例¶

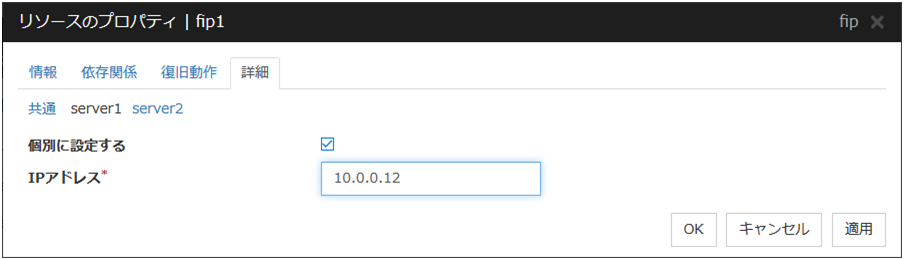

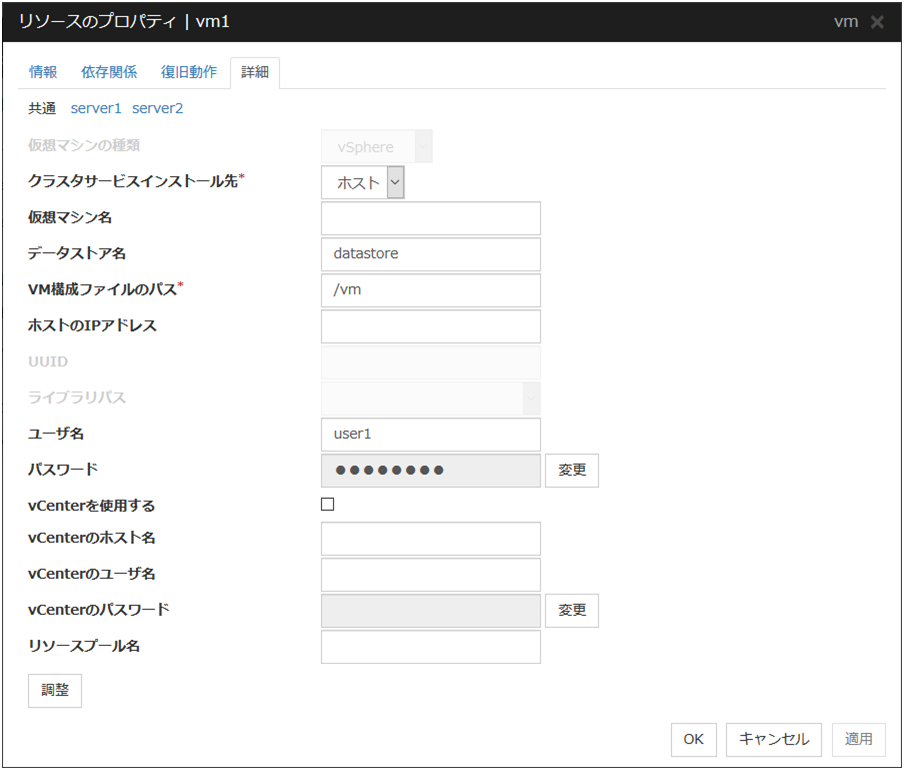

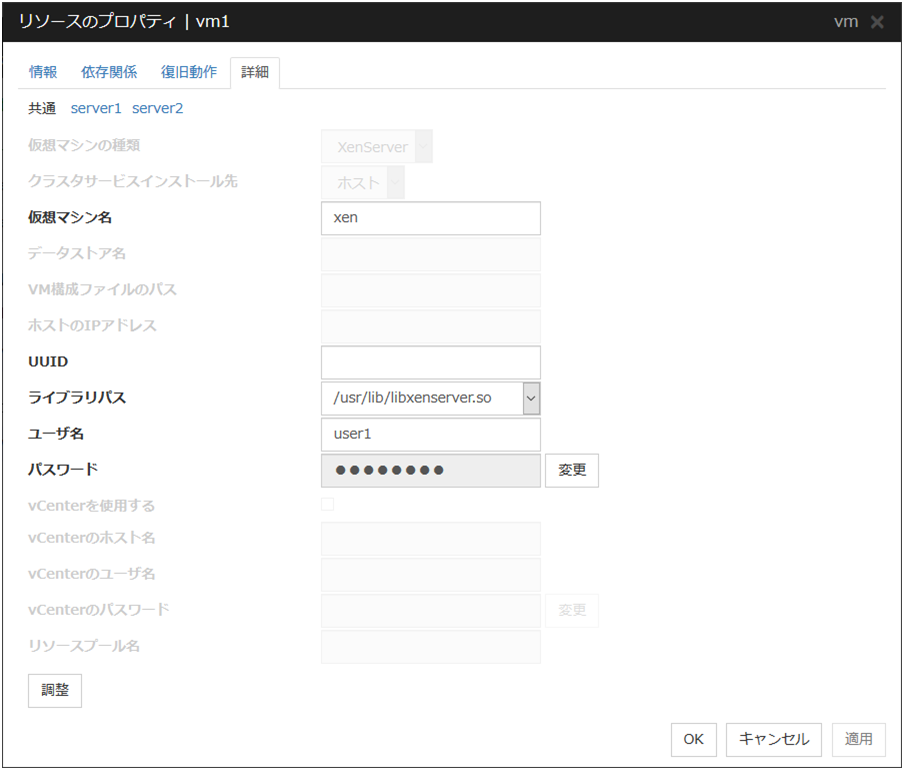

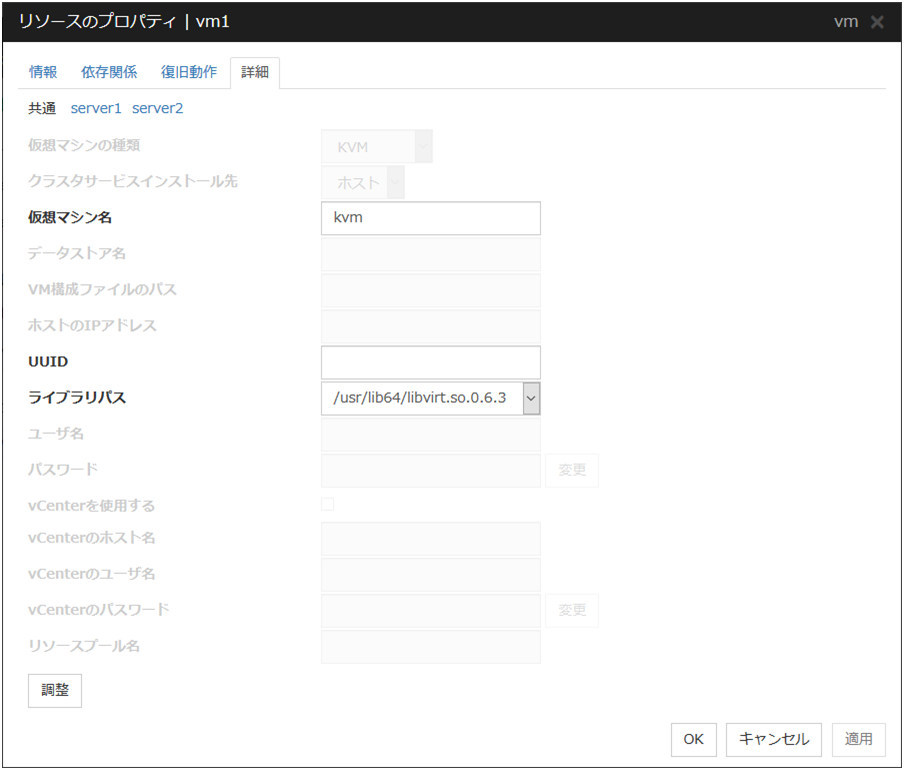

3.2.14. グループリソースをサーバ個別設定する¶

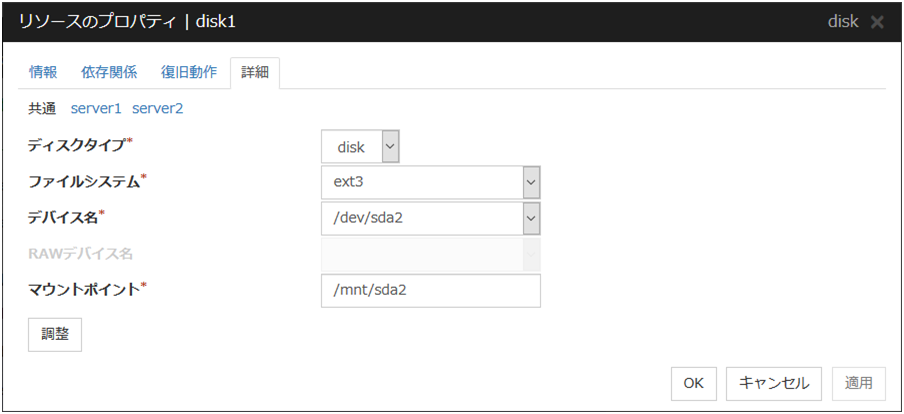

グループリソースの一部の設定値はサーバごとに異なる設定が可能です。サーバ別設定が可能なリソースは [詳細] タブに各サーバのタブが表示されます。

サーバ別設定が可能なグループリソースは下記です。

グループリソース名 |

対応バージョン |

|---|---|

ディスクリソース |

4.0.0-1~ |

フローティング IP リソース |

4.0.0-1~ |

仮想 IP リソース |

4.0.0-1~ |

ミラーディスクリソース |

4.0.0-1~ |

ハイブリッドディスクリソース |

4.0.0-1~ |

ダイナミック DNS リソース |

4.0.0-1~ |

仮想マシンリソース |

4.0.0-1~ |

AWS Elastic IP リソース |

4.0.0-1~ |

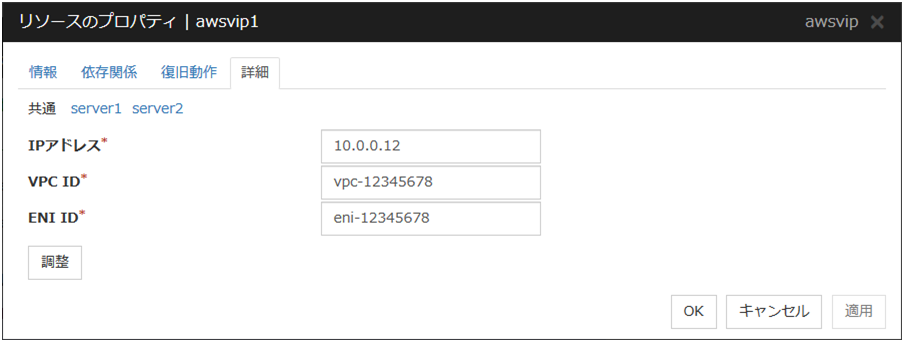

AWS 仮想 IP リソース |

4.0.0-1~ |

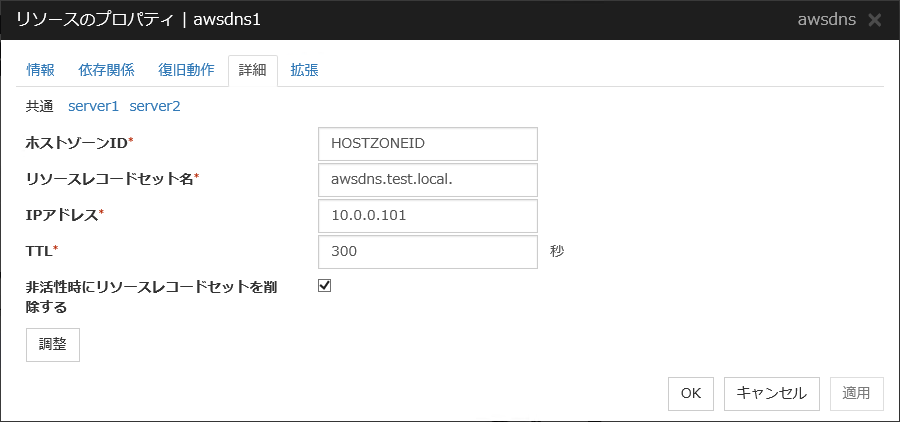

AWS DNS リソース |

4.0.0-1~ |

Azure DNS リソース |

4.0.0-1~ |

注釈

仮想 IP リソース、AWS Elastic IP リソース、AWS 仮想 IP リソース、Azure DNS リソースには必ずサーバ個別設定が必要なパラメータがあります。

サーバ個別設定可能なパラメータは各グループリソースのパラメータの説明を参照してください。サーバ個別設定可能なパラメータには「サーバ個別設定可能 」と付記しています。

ここではフローティング IP リソースでサーバ個別設定を説明します。

サーバ個別設定

フローティング IP リソースでサーバ個別設定可能なパラメータが表示されます。

個別に設定する

サーバ個別設定を行いたいサーバ名のタブを選択してチェックボックスをオンにするとディスクリソースでサーバ個別設定可能なパラメータが入力可能になります。必要なパラメータを入力します。

注釈

サーバ個別設定では [調整] は選択できません。

3.3. グループ共通のプロパティ¶

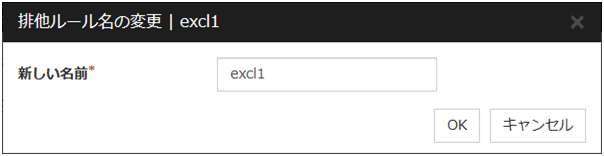

3.3.1. 排他タブ¶

追加

排他ルールを追加します。[追加]を選択すると[排他ルールの定義]ダイアログボックスが表示されます。

削除

排他ルールを削除します。

名称変更

選択している排他ルール名の変更ダイアログボックスが表示されます。

下記の入力規則があります。

最大 31 文字 (31 バイト) までです。

文字列先頭と文字列末尾にハイフン (-) とスペースは使えません。

文字列全て数字の場合は使用できません。

排他ルールで一意 (英大文字・小文字の区別なし) な名前を入力してください。

プロパティ

選択している排他ルールのプロパティを表示します。

排他ルールの定義

排他ルール名と排他属性を設定します。排他属性には通常排他と完全排他の設定が可能です。通常排他を設定可能な排他ルールは1つのみです。完全排他は複数設定可能です。通常排他に設定された排他ルールがすでに存在する場合は、通常排他を選択することはできません。

名前

排他ルール名を表示しています。

排他属性

排他ルールに設定した排他属性を表示します。

グループ

排他ルールに属しているフェイルオーバグループ名の一覧を表示しています。

[登録可能なグループ]から排他ルールに登録したいグループを選択し、[追加]ボタンを押下してください。[排他対象のグループ]には排他ルールに登録したグループが表示されます。他の排他ルールに追加したフェイルオーバグループは[登録可能なグループ]に表示されません。

3.4. グループのプロパティ¶

3.4.2. 情報タブ¶

タイプ

グループのタイプを表示します。

サーバグループ設定を使用する

名前

グループ名を表示します。

コメント (127 バイト以内)

グループのコメントを設定します。半角英数字のみ入力可能です。

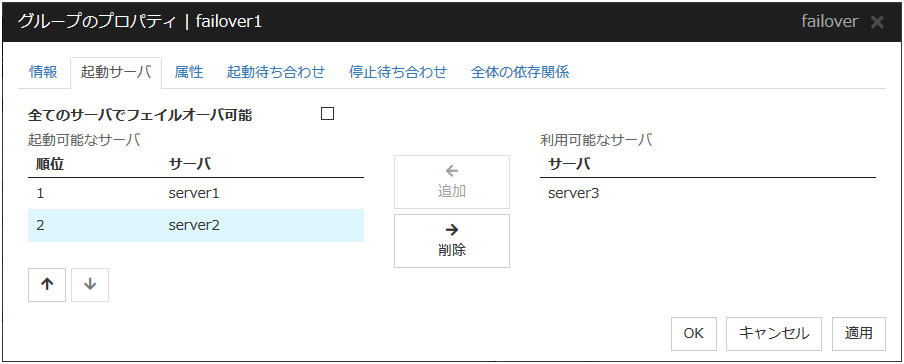

3.4.3. 起動サーバタブ¶

グループを起動するサーバの設定には、全サーバで起動する設定と、起動可能なサーバまたはサーバグループを選択する設定があります。

全サーバで起動する設定の場合は、クラスタに登録されている全サーバでグループを起動できます。グループを起動するサーバの起動順位は、サーバの優先順位と等しくなります。サーバの優先順位に関しては、本ガイドの「2. パラメータの詳細」 - 「Servers プロパティ」 - 「マスタサーバタブ」 を参照してください。

起動可能なサーバとサーバグループを選択する場合は、クラスタに登録されているサーバとサーバグループから任意に起動するサーバまたはサーバグループを選択できます。また、グループを起動するサーバまたはサーバグループの起動順位を変更することができます。

フェイルオーバグループを起動するサーバグループを設定する場合

全てのサーバでフェイルオーバ可能

グループを起動するサーバを指定します。

追加

起動可能なサーバを追加する場合に使用します。[利用可能なサーバ] から追加したいサーバを選択して、[追加] をクリックします。[起動可能なサーバ] に追加されます。

削除

起動可能なサーバを削除する場合に使用します。[起動可能なサーバ] から削除したいサーバを選択して、[削除] をクリックします。[利用可能なサーバ] に追加されます。

順位

起動可能なサーバの優先順位を変更する場合に使用します。[起動可能なサーバ] から変更したいサーバを選択して、矢印をクリックします。選択行が移動します。

サーバグループ設定を使用する場合

ハイブリッドディスクリソースを含むグループを起動するサーバの設定には、フェイルオーバグループを起動するサーバグループを設定する必要があります。

追加

[起動可能なサーバグループ] にサーバグループを追加する場合に使用します。[利用可能なサーバグループ] から追加したいサーバグループを選択して、[追加] をクリックします。 [起動可能なサーバグループ] に追加されます。

削除

[起動可能なサーバグループ] からサーバグループを削除する場合に使用します。[利用可能なサーバグループ] から削除したいサーバグループを選択して、[削除] をクリックします。[起動可能なサーバグループ] に追加されます。

順位

サーバグループの優先順位を変更する場合に使用します。[利用可能なサーバグループ] から変更したいサーバグループを選択して、矢印をクリックします。選択行が移動します。

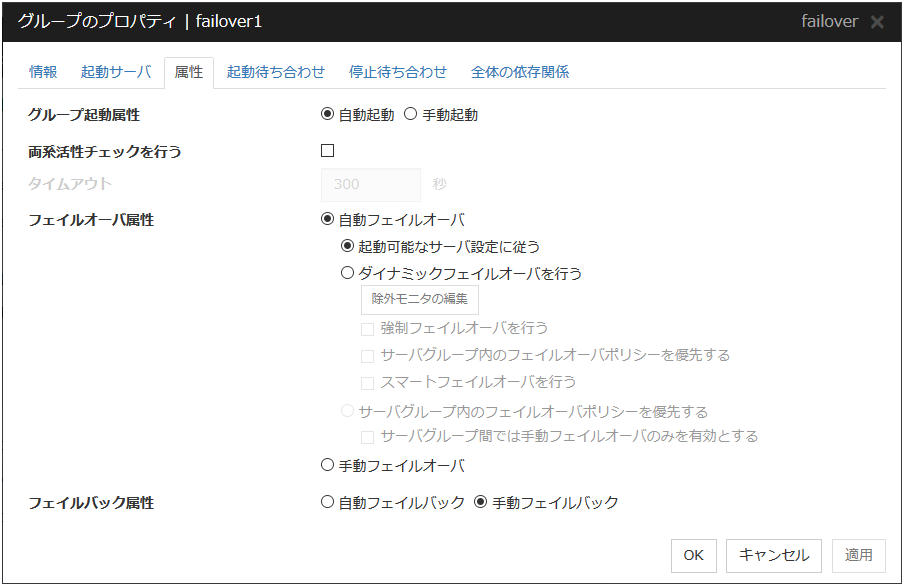

3.4.4. 属性タブ¶

グループ起動属性

クラスタ起動時に CLUSTERPRO によりグループを自動的に起動するか (自動起動)、もしくは Cluster WebUI または [clpgrp] コマンドからユーザが操作して起動するか (手動起動) の属性を設定します。

両系活性チェックを行う

グループ起動前に両系活性が発生するか否かを確認します。

タイムアウト (1~9999)

両系活性チェックを実施する最大時間を指定します。既定値は300秒です。グループに所属するフローティングIPリソースの [フローティングIPリソース 調整プロパティ] - [pingタイムアウト] に設定した値より大きな値を設定してください。

フェイルオーバ属性

サーバダウン発生時、自動的にフェイルオーバするかどうかを設定します。

フェイルバック属性

グループが起動しているサーバよりも高プライオリティのサーバが正常に起動してきたときに自動的にフェイルバックするかどうかを設定します。ミラーディスクリソースまたはハイブリッドディスクリソースを含めるグループは手動フェイルバック属性に設定してください。

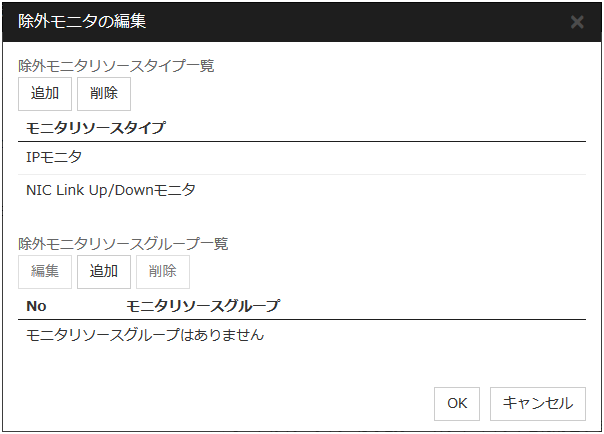

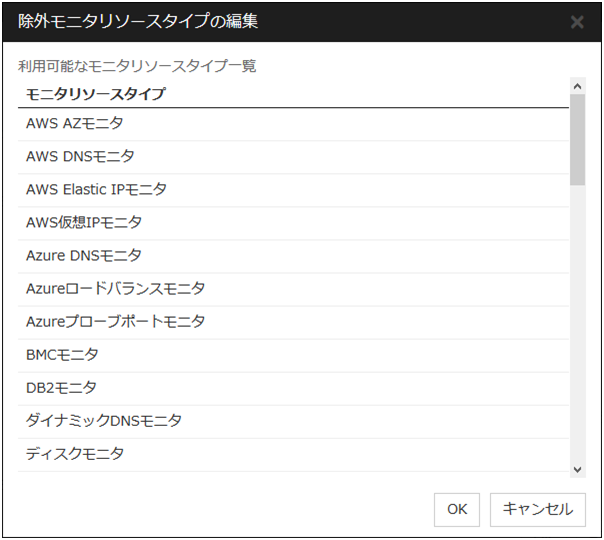

除外モニタの編集

ダイナミックフェイルオーバでは、モニタリソースが異常を検出しているサーバをフェイルオーバ先から除外します。フェイルオーバ属性として「ダイナミックフェイルオーバを行う」を選択した場合に、除外対象とするモニタリソースを設定することができます。

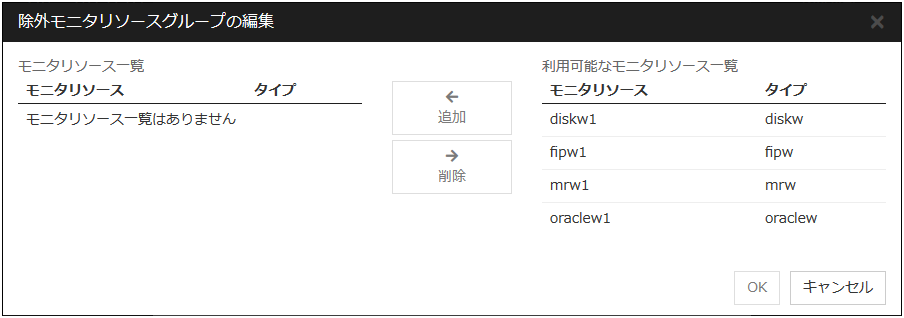

除外モニタは、モニタリソースタイプ、モニタリソース名による設定ができます。

選択したモニタリソースタイプを追加します。

一つの除外モニタリソースグループ内に複数のモニタリソースが登録されている場合、登録されている全てのモニタリソースが異常状態になっているサーバはフェイルオーバ先から除外されます。

また複数の除外モニタリソースグループが登録されている場合、いずれか一つでも条件を満たしたサーバはフェイルオーバ先から除外されます。

追加

[利用可能なモニタリソース一覧]で選択されているモニタリソースを[モニタリソース一覧]に追加します。

削除

[モニタリソース一覧]で選択されているモニタリソースを、一覧から削除します。

注釈

下記のモニタリソースタイプは除外モニタリソースタイプに登録できません。また、除外モニタリソースグループにリソース名を登録できません。

ユーザ空間モニタ

ARPモニタ

仮想IPモニタ

ミラーディスクコネクトモニタ

ハイブリッドディスクモニタ

ハイブリッドディスクコネクトモニタ

注釈

警告状態のモニタリソースは異常として扱いません。ただし、ミラーディスクモニタリソースは除きます。活性時監視に設定されているモニタリソースは、グループ起動サーバ以外のサーバでは監視を行わないため異常状態になりません。Cluster WebUI、clpmonctrlコマンドを使用して停止したモニタリソースは正常状態となります。モニタリソースの監視を行うサーバとして設定されていないサーバでは監視を行わないため異常状態になりません。注釈

ミラーディスクモニタリソースの場合は、ミラーディスクリソースの活性可否により判断します。ミラーディスクモニタリソースの状態には依存しません。ミラーディスクモニタリソースが異常状態であっても、ミラーディスクリソースが正常に活性できるサーバはフェイルオーバ先から除外されません。ミラーディスクモニタリソースが正常状態や警告状態であっても、ミラーディスクリソースが正常に活性できないサーバはフェイルオーバ先から除外されます。

3.4.5. 起動待ち合わせタブ¶

追加

[利用可能なグループ] で選択したグループを [対象グループ] に追加します。

削除

[対象グループ] で選択したグループを [対象グループ] から削除します。

対象グループの起動待ち時間 (0~9999)

対象グループの正常起動完了を待ち合わせる最大時間を指定します。既定値は 1800 秒です。

プロパティ

[対象グループ] で選択したグループのプロパティを変更します。

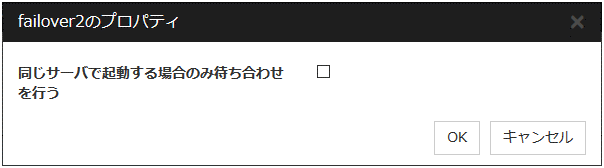

同じサーバで起動する場合のみ待ち合わせを行う

起動待ち合わせを行うグループと対象グループが同じサーバで起動する場合のみ待ち合わせるかどうかを設定します。

チェックボックスがオンの場合

起動待ち合わせを行うグループを起動するサーバが、対象グループの「起動サーバ」に含まれていない場合には待ち合わせを行いません。

起動待ち合わせを行うグループを起動するサーバ以外で対象グループが起動失敗になっている場合には待ち合わせを行いません。

3.4.6. 停止待ち合わせタブ¶

追加

[利用可能なグループ] で選択したグループを [対象グループ] に追加します。

削除

[対象グループ] で選択したグループを [対象グループ] から削除します。

対象グループの停止待ち時間 (0~9999)

対象グループの正常停止完了を待ち合わせる最大時間を指定します。既定値は 1800 秒です。

クラスタ停止時に対象グループの停止を待ち合わせる

クラスタ停止時に対象グループの停止を待ち合わせるかどうかを設定します。

サーバ停止時に対象グループの停止を待ち合わせる

サーバ単体停止時に対象グループの停止完了を待ち合わせるかどうかを設定します。対象グループのうち同じサーバで起動しているグループのみ停止を待ち合わせます。

グループ停止時に対象グループの停止を待ち合わせる

グループ停止操作時に対象グループの停止完了を待ち合わせるかどうかを設定します。対象グループのうち同じサーバで起動しているグループのみ停止を待ち合わせます。

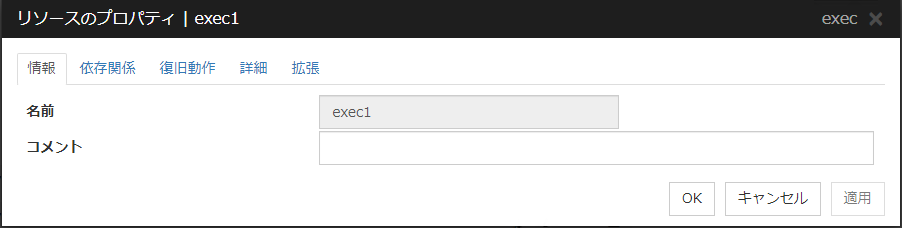

3.5. リソースのプロパティ¶

3.5.3. 復旧動作タブ¶

グループリソース活性異常検出時の流れ

グループリソースの活性時に異常を検出した場合、活性リトライを行います。

[活性リトライしきい値] の活性リトライに失敗した場合、フェイルオーバを行います。

[フェイルオーバしきい値] のフェイルオーバを行っても活性できない場合、最終動作を行います。

グループリソース非活性異常検出時の流れ

非活性時に異常を検出した場合、非活性リトライを行います。

[非活性リトライしきい値] の非活性リトライに失敗した場合、最終動作を行います。

活性異常検出時の復旧動作

活性リトライしきい値 (0~99)

活性異常検出時に活性リトライを行う回数を入力します。0 を設定すると活性リトライを行いません。

フェイルオーバしきい値 (0~99)

活性異常検出時に活性リトライが [活性リトライしきい値] で指定した回数失敗した後にフェイルオーバを行う回数を入力します。0 を設定するとフェイルオーバを行いません。

最終動作

活性異常検出時に活性リトライが [活性リトライしきい値] で指定した回数失敗し、フェイルオーバが [フェイルオーバしきい値] で指定した回数失敗した後の動作を選択します。

最終動作は以下の動作が選択できます。

注釈

sysrq パニックに失敗した場合、OS のシャットダウンを行います。

注釈

keepalive リセットに失敗した場合、OS のシャットダウンを行います。clpkhb ドライバ、clpka ドライバが対応していない OS、kernel では設定しないでください。注釈

keepalive パニックに失敗した場合、OS のシャットダウンを行います。clpkhb ドライバ、clpka ドライバが対応していない OS、kernel では設定しないでください。注釈

BMC リセットに失敗した場合、OS のシャットダウンを行います。OpenIPMI をインストールしていない、または [ipmitool] コマンドが動作しないサーバでは設定しないでください。注釈

BMC パワーオフに失敗した場合、OS のシャットダウンを行います。OpenIPMI をインストールしていない、または [ipmitool] コマンドが動作しないサーバでは設定しないでください。注釈

BMC パワーサイクルに失敗した場合、OS のシャットダウンを行います。OpenIPMI をインストールしていない、または [ipmitool] コマンドが動作しないサーバでは設定しないでください。注釈

BMC NMIに失敗した場合、OS のシャットダウンを行います。OpenIPMI をインストールしていない、または [ipmitool] コマンドが動作しないサーバでは設定しないでください。本機能を利用するにはハードウェアおよびファームウェアが対応している必要があります。利用可能な ハードウェア については『スタートアップガイド』の「CLUSTERPROの動作環境」の「NX7700xシリーズとの連携に対応したサーバ」を、設定については『ハードウェア連携ガイド』の「特定ハードウェアとの連携」の「NX7700x シリーズ連携を利用する構成情報の作成方法」を参照してください。

注釈

I/O Fencingに失敗した場合、OS のシャットダウンを行います。

最終動作前にスクリプトを実行する

活性異常検出時の最終動作を実行する前にスクリプトを実行するかどうかを指定します。

非活性異常検出時の復旧動作

非活性リトライしきい値 (0~99)

非活性異常検出時に非活性リトライ回数を入力します。0 を設定すると非活性リトライを行いません。

最終動作

非活性異常検出時に非活性リトライが [非活性リトライしきい値] で指定した回数失敗した後の動作を選択します。

最終動作は以下の動作が選択できます。

注釈

非活性異常検出時の最終動作に [何もしない] を選択すると、グループが非活性失敗のまま停止しません。本番環境では [何もしない] は設定しないように注意してください。

注釈

非活性異常検出時の最終動作に [何もしない] を選択すると、グループが非活性失敗のまま停止しません。本番環境では [何もしない] は設定しないように注意してください。

注釈

sysrq パニックに失敗した場合、OS のシャットダウンを行います。

注釈

keepalive リセットに失敗した場合、OS のシャットダウンを行います。clpkhb ドライバ、clpka ドライバが対応していない OS、kernel では設定しないでください。注釈

keepalive パニックに失敗した場合、OS のシャットダウンを行います。clpkhb ドライバ、clpka ドライバが対応していない OS、kernel では設定しないでください。注釈

BMC リセットに失敗した場合、OS のシャットダウンを行います。OpenIPMI をインストールしていない、または [ipmitool] コマンドが動作しないサーバでは設定しないでください。注釈

BMC パワーオフに失敗した場合、OS のシャットダウンを行います。OpenIPMI をインストールしていない、または [ipmitool] コマンドが動作しないサーバでは設定しないでください。注釈

BMC パワーサイクルに失敗した場合、OS のシャットダウンを行います。OpenIPMI をインストールしていない、または [ipmitool] コマンドが動作しないサーバでは設定しないでください。注釈

BMC NMI に失敗した場合、OS のシャットダウンを行います。OpenIPMI をインストールしていない、または [ipmitool] コマンドが動作しないサーバでは設定しないでください。本機能を利用するにはハードウェアおよびファームウェアが対応している必要があります。利用可能な ハードウェア については『スタートアップガイド』の「CLUSTERPROの動作環境」の「NX7700xシリーズとの連携に対応したサーバ」を、設定については『ハードウェア連携ガイド』の「特定ハードウェアとの連携」の「NX7700x シリーズ連携を利用する構成情報の作成方法」を参照してください。

注釈

I/O Fencingに失敗した場合、OS のシャットダウンを行います。

最終動作前にスクリプトを実行する

非活性異常検出時の最終動作を実行する前にスクリプトを実行するかどうかを指定します。

3.5.4. 詳細タブ¶

リソース固有のパラメータは各リソースの説明に記述しています。

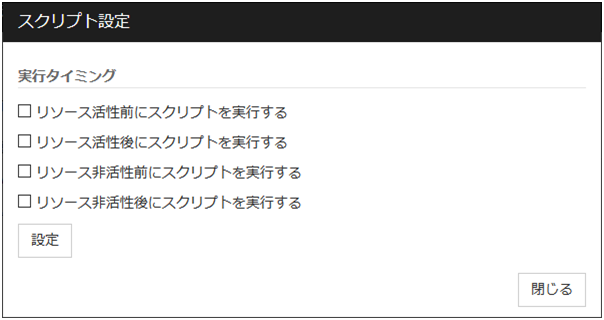

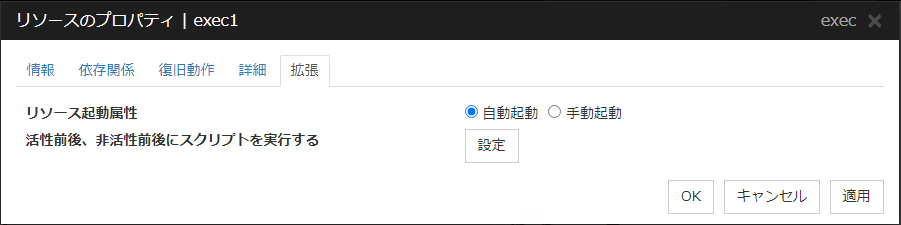

3.5.5. 拡張タブ¶

リソース起動属性

グループ起動時にリソースを自動的に起動するか (自動起動)、もしくは Cluster WebUI または [clprsc] コマンドからユーザが操作して起動するか (手動起動) の属性を設定します。

活性前後、非活性前後にスクリプトを実行する

リソース活性前、活性後、非活性前、非活性後にスクリプトを実行するかどうかを指定します。設定を行うためには [設定]をクリックしてください。

チェックボックスにチェックを入れることで、指定のタイミングでスクリプトが実行されます。

実行タイミング

リソース活性前にスクリプトを実行する

リソース活性後にスクリプトを実行する

リソース非活性前にスクリプトを実行する

リソース非活性後にスクリプトを実行する

スクリプトの設定を行うためには [設定]をクリックしてください。

ユーザアプリケーション

スクリプトとしてサーバ上の実行可能ファイル (実行可能なシェルスクリプトファイルや実行ファイル) を使用します。ファイル名にはサーバ上のローカルディスクの絶対パスまたは実行可能ファイル名を設定します。また、絶対パスやファイル名に空欄が含まれる場合は、下記のように、ダブルクォーテーション (") でそれらを囲ってください。

例:

"/tmp/user application/script.sh"各実行可能ファイルは、Cluster WebUI のクラスタ構成情報には含まれません。Cluster WebUI で編集やアップロードはできませんので、各サーバ上に準備する必要があります。

この製品で作成したスクリプト

スクリプトとして Cluster WebUI で準備したスクリプトファイルを使用します。必要に応じてCluster WebUI でスクリプトファイルを編集できます。スクリプトファイルは、クラスタ構成情報に含まれます。

ファイル (1023 バイト以内)

[ユーザアプリケーション] を選択した場合に、実行するスクリプト (実行可能なシェルスクリプトファイルや実行ファイル) を設定します。

表示

[この製品で作成したスクリプト] を選択した場合に、スクリプトファイルを表示します。エディタで編集して保存した内容は反映されません。

編集

[この製品で作成したスクリプト] を選択した場合に、スクリプトファイルを編集します。変更を反映するには [保存] をクリックしてください。スクリプトファイル名の変更はできません。

置換

[この製品で作成したスクリプト] を選択した場合に、スクリプトファイルの内容を、ファイル選択ダイアログボックスで選択したスクリプトファイルの内容に置換します。スクリプトが既に表示中または編集中の場合は置換できません。ここではスクリプトファイルを選択してください。バイナリファイル (アプリケーションなど) は選択しないでください。

タイムアウト (1~9999)

スクリプトの実行完了を待ち合わせる最大時間を指定します。活性前後、非活性前後に実行されるスクリプトの既定値は 30 秒です。[活性異常検出時の復旧動作] [非活性異常検出時の復旧動作]の[最終動作前にスクリプトを実行する]の[設定]ボタンから設定できるタイムアウトの既定値は 5 秒です。

3.6. EXEC リソースを理解する¶

CLUSTERPRO では、CLUSTERPRO によって管理され、グループの起動時、終了時、フェイルオーバ発生時および移動時に実行されるアプリケーションやシェルスクリプトを登録できます。EXEC リソースには、ユーザ独自のプログラムやシェルスクリプトなども登録できます。シェルスクリプトは、sh のシェルスクリプトと同じ書式なので、それぞれのアプリケーションの事情にあわせた処理を記述できます。

注釈

EXEC リソースで実行されるアプリケーションの同一レビジョンのものが、フェイルオーバポリシーに設定されている全サーバに存在していることが必須です。

3.6.1. EXEC リソースの依存関係¶

既定値では、以下のグループリソースタイプに依存します。

グループリソースタイプ |

|---|

フローティング IP リソース |

仮想 IP リソース |

ディスクリソース |

ミラーディスクリソース |

ハイブリッドディスクリソース |

NAS リソース |

仮想マシンリソース |

ボリュームマネージャーリソース |

ダイナミック DNS リソース |

AWS Elastic IPリソース |

AWS 仮想IPリソース |

AWS DNS リソース |

Azure プローブポートリソース |

Azure DNS リソース |

3.6.2. EXEC リソースの活性/非活性処理結果の判定方法について¶

3.6.3. EXEC リソースで使用するスクリプト¶

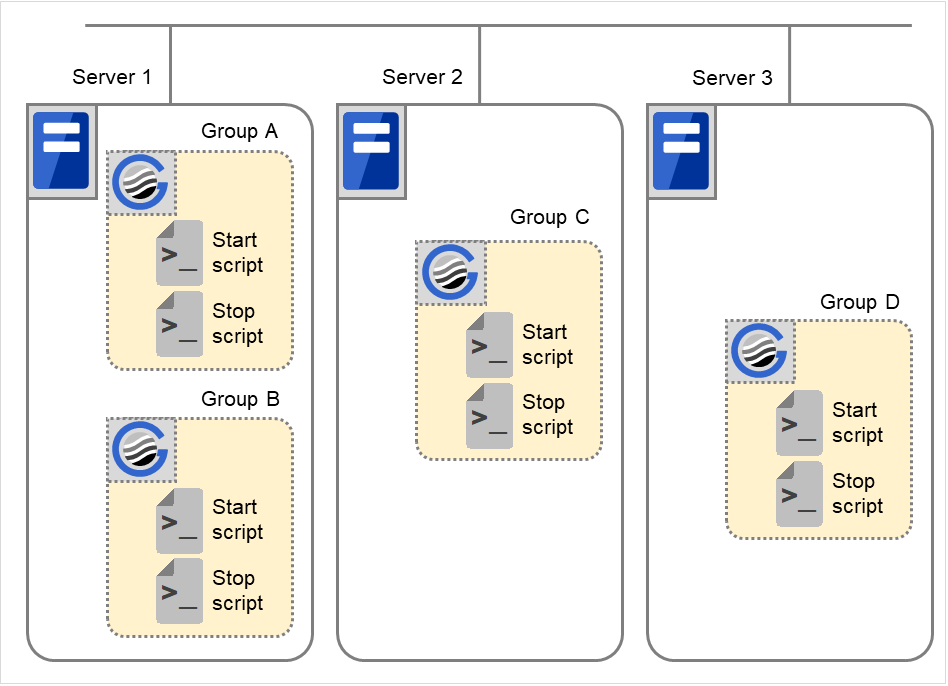

スクリプトの種類

EXEC リソースには、それぞれ開始スクリプトと終了スクリプトが用意されています。CLUSTERPRO は、クラスタの状態遷移が必要な場面において、EXEC リソースごとのスクリプトを実行します。クラスタ環境下で動作させたいアプリケーションの起動、終了、もしくは復旧の手順を、これらのスクリプトに記述する必要があります。

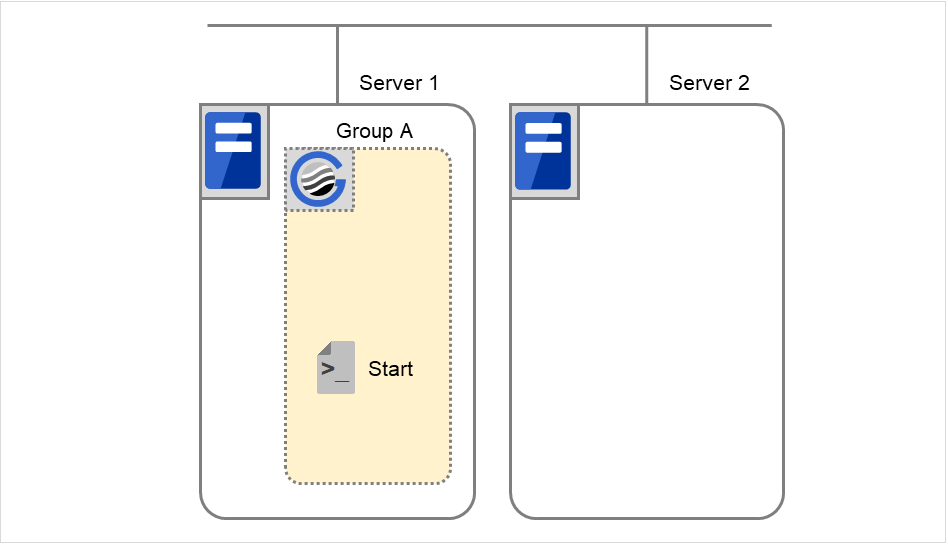

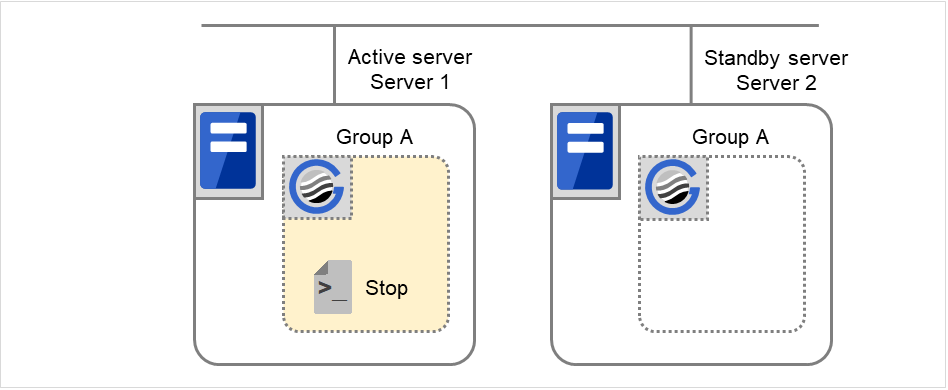

図 3.35 開始スクリプトと終了スクリプト¶

3.6.4. EXEC リソースのスクリプトで使用する環境変数¶

CLUSTERPRO は、スクリプトを実行する場合に、どの状態で実行したか (スクリプト実行要因) などの情報を環境変数にセットします。

スクリプト内で下図の環境変数を分岐条件として、システム運用にあった処理内容を記述できます。

終了スクリプトの環境変数は、直前に実行された開始スクリプトの内容を、値として返します。開始スクリプトでは CLP_FACTOR および CLP_PID の環境変数はセットされません。

CLP_LASTACTION の環境変数は、CLP_FACTOR の環境変数がCLUSTERSHUTDOWN または SERVERSHUTDOWN の場合にのみセットされます。

環境変数 |

環境変数の値 |

意味 |

|---|---|---|

CLP_EVENT

…スクリプト実行要因

|

START |

クラスタの起動により、実行された場合。

グループの起動により、実行された場合。

グループの移動により、移動先のサーバで実行された場合。

モニタリソースの異常検出によるグループの再起動により、同じサーバで実行された場合。

モニタリソースの異常検出によるグループリソースの再起動により、同じサーバで実行 された場合。

|

〃 |

FAILOVER |

サーバダウンにより、フェイルオーバ先の サーバで実行された場合。

モニタリソースの異常検出により、フェイルオーバ先のサーバで実行された場合。

グループリソースの活性失敗により、フェイルオーバ先のサーバで実行された場合。

|

CLP_FACTOR

…グループ停止要因

|

CLUSTERSHUTDOWN |

クラスタ停止により、グループの停止が実行された場合。 |

〃 |

SERVERSHUTDOWN |

サーバ停止により、グループの停止が実行された場合。 |

〃 |

GROUPSTOP |

グループ停止により、グループの停止が実行された場合。 |

〃 |

GROUPMOVE |

グループ移動により、グループの移動が実行された場合。 |

〃 |

GROUPFAILOVER |

モニタリソースの異常検出により、グループのフェイルオーバが実行された場合。

グループリソースの活性失敗により、グループのフェイルオーバが実行された場合。

|

〃 |

GROUPRESTART |

モニタリソースの異常検出により、グループの再起動が実行された場合。 |

〃 |

RESOURCERESTART |

モニタリソースの異常検出により、グループ リソースの再起動が実行された場合。 |

CLP_LASTACTION

…クラスタ停止後処理

|

REBOOT |

OS を reboot (再起動) する場合。 |

〃 |

HALT |

OS をhalt (シャットダウン) する場合。 |

〃 |

NONE |

何もしない。 |

CLP_SERVER

……スクリプトの実行サーバ

|

HOME |

グループの、プライマリサーバで実行された。 |

〃 |

OTHER |

グループの、プライマリサーバ以外で実行された。 |

SUCCESS |

接続に失敗しているパーティションはない。 |

|

〃 |

FAILURE |

接続に失敗しているパーティションがある。 |

CLP_PRIORITY

…スクリプトが実行されたサーバの

フェイルオーバポリシーの順位

|

1~クラスタ内のサーバ数 |

実行されているサーバの、プライオリティを示す。1 から始まる数字で、小さいほどプライオリティが高いサーバ。

CLP_PRIORITY が 1 の場合、プライマリサーバで実行されたことを示す。

|

CLP_GROUPNAME

…グループ名

|

グループ名 |

スクリプトが属している、グループ名を示す。 |

CLP_RESOURCENAME

…リソース名

|

リソース名 |

スクリプトが属している、リソース名を示す。 |

CLP_PID

…プロセス ID

|

プロセス ID |

プロパティとして開始スクリプトが非同期に設定されている場合、開始スクリプトのプロセスIDを示す。開始スクリプトが同期に設定されている場合、本環境変数は値を持たない。 |

CLP_VERSION_FULL

…CLUSTERPROフルバージョン

|

CLUSTERPROフルバージョン |

CLUSTERPROのフルバージョンを示す。(例) 4.3.4-1 |

CLP_VERSION_MAJOR

…CLUSTERPROメジャーバージョン

|

CLUSTERPROメジャーバージョン |

CLUSTERPROのメジャーバージョンを示す。(例)4 |

CLP_PATH

…CLUSTERPROインストールパス

|

CLUSTERPROインストールパス |

CLUSTERPROがインストールされているパスを示す。(例)/opt/nec/clusterpro |

CLP_OSNAME

…サーバOS名

|

サーバOS名 |

スクリプトが実行されたサーバのOS名を示す。

(例)1.OS名が取得できた場合:Red Hat Enterprise Linux Server release 6.8 (Santiago)

2.OS名が取得できなかった場合:Linux

|

CLP_OSVER

…サーバOS名

|

サーバOSバージョン |

スクリプトが実行されたサーバのOSバージョンを示す。

(例)1.OSバージョンが取得できた場合:6.8

2.OSバージョンが取得できなかった場合:※値なし

|

- 1

ディスクソース、ミラーディスクソース、ハイブリッドソース、NASソース、ボリュームマネージャリーソースが対象となります。

環境変数 |

環境変数の値 |

意味 |

|---|---|---|

CLP_EVENT

…スクリプト実行要因

|

STANDBY |

待機系サーバ上で実行された場合。

|

CLP_SERVER

……スクリプトの実行サーバ

|

HOME |

グループの、プライマリサーバで実行された。 |

〃 |

OTHER |

グループの、プライマリサーバ以外で実行された。 |

CLP_PRIORITY

…スクリプトが実行されたサーバの

フェイルオーバポリシーの順位

|

1~クラスタ内のサーバ数 |

実行されているサーバの、プライオリティを示す。1 から始まる数字で、小さいほどプライオリティが高いサーバ。

CLP_PRIORITY が 1 の場合、プライマリサーバで実行されたことを示す。

|

CLP_GROUPNAME

…グループ名

|

グループ名 |

スクリプトが属している、グループ名を示す。 |

CLP_RESOURCENAME

…リソース名

|

リソース名 |

スクリプトが属している、リソース名を示す。 |

CLP_VERSION_FULL

…CLUSTERPROフルバージョン

|

CLUSTERPROフルバージョン |

CLUSTERPROのフルバージョンを示す。(例) 4.3.4-1 |

CLP_VERSION_MAJOR

…CLUSTERPROメジャーバージョン

|

CLUSTERPROメジャーバージョン |

CLUSTERPROのメジャーバージョンを示す。(例)4 |

CLP_PATH

…CLUSTERPROインストールパス

|

CLUSTERPROインストールパス |

CLUSTERPROがインストールされているパスを示す。(例)/opt/nec/clusterpro |

CLP_OSNAME

…サーバOS名

|

サーバOS名 |

スクリプトが実行されたサーバのOS名を示す。

(例)1.OS名が取得できた場合:Red Hat Enterprise Linux Server release 6.8 (Santiago)

2.OS名が取得できなかった場合:Linux

|

CLP_OSVER

…サーバOSバージョン

|

サーバOSバージョン |

スクリプトが実行されたサーバのOSバージョンを示す。

(例)1.OSバージョンが取得できた場合:6.8

2.OSバージョンが取得できなかった場合:※値なし

|

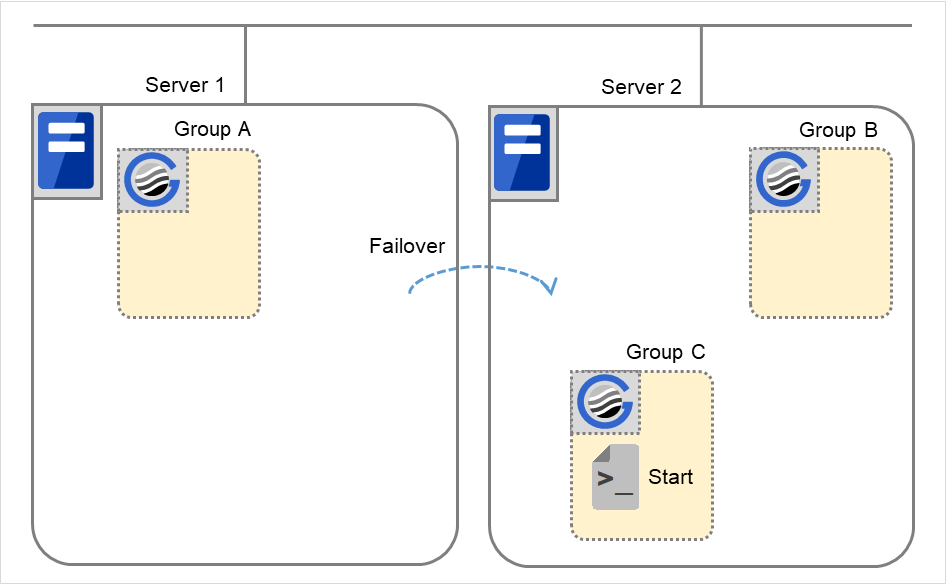

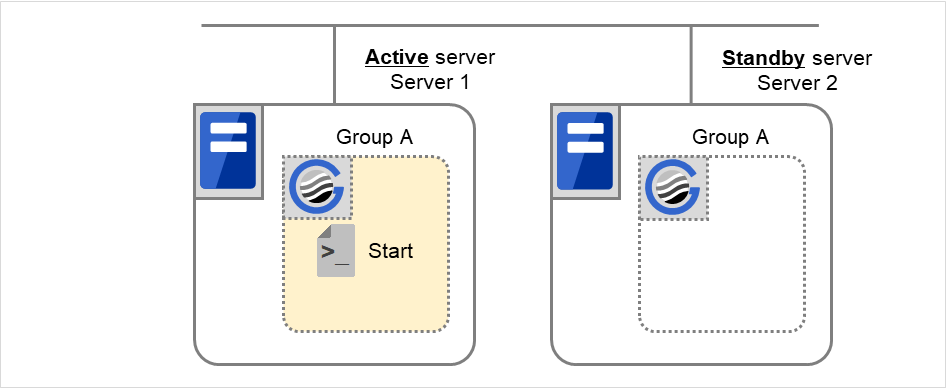

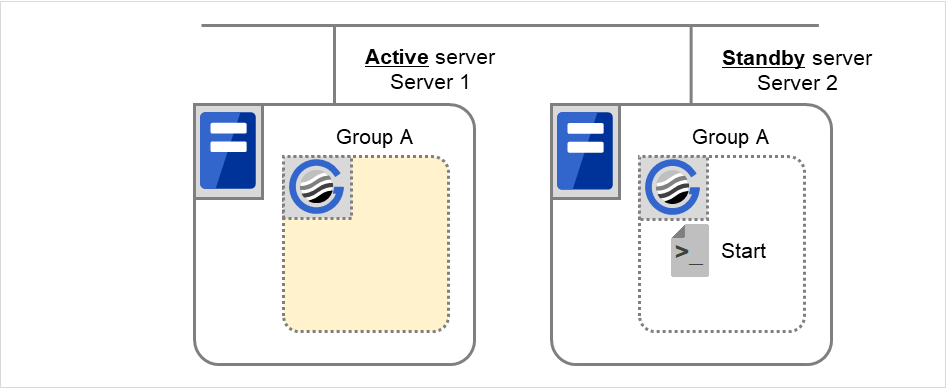

3.6.5. EXEC リソーススクリプトの実行タイミング¶

開始、終了スクリプトの実行タイミングと環境変数の関連を、クラスタ状態遷移図にあわせて説明します。

- 説明を簡略にするため、2 台構成のクラスタで説明します。3 台以上の構成の場合に、発生する可能性のある実行タイミングと環境変数の関連は、補足という形で説明します。

図中のサーバは以下の状態を表しています。

サーバ

サーバ状態

正常状態 (クラスタとして正常に動作している)

停止状態 (クラスタが停止状態)

(例) 正常状態にある Server 1 において Group A が動作している。

各グループは、起動したサーバの中で、最もプライオリティの高いサーバ上で起動されます。

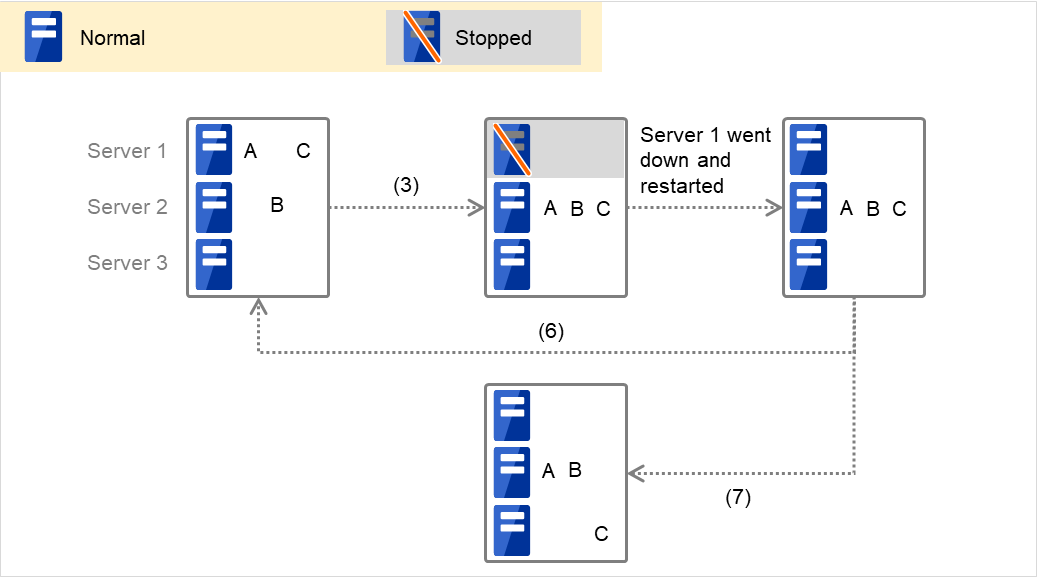

クラスタに定義されているグループは A、B、C の3つで、それぞれ以下のようなフェイルオーバポリシーを持っています。

グループ

優先度1サーバ

優先度2サーバ

A

Server 1

Server 2

B

Server 2

Server 1

C

Server 1

Server 2

【クラスタ状態遷移図】

代表的なクラスタ状態遷移について説明します。

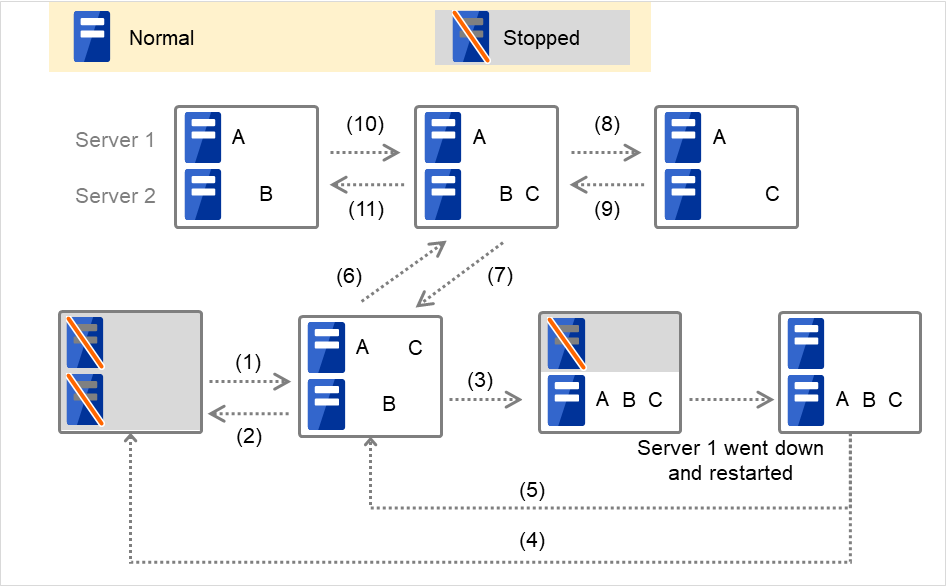

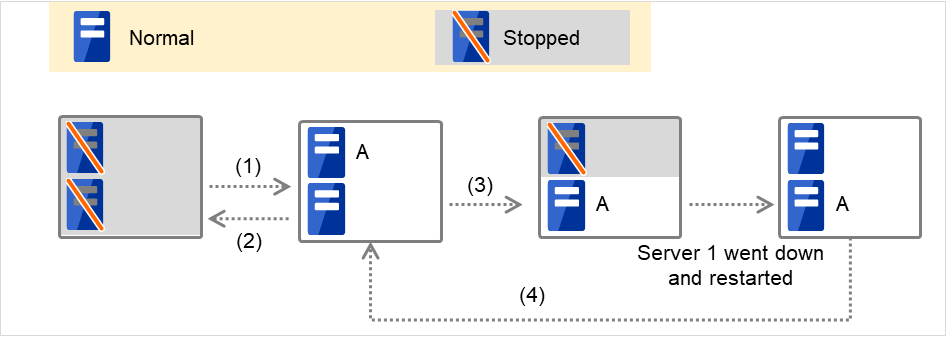

図 3.36 クラスタ状態遷移の例(概要)¶

図中の1. ~11. は、以下の説明に対応しています。

通常立ち上げ

ここでいう通常立ち上げとは、開始スクリプトがプライマリサーバで正常に実行された時を指します。

各グループは、起動したサーバの中で、最もプライオリティの高いサーバ上で起動されます。

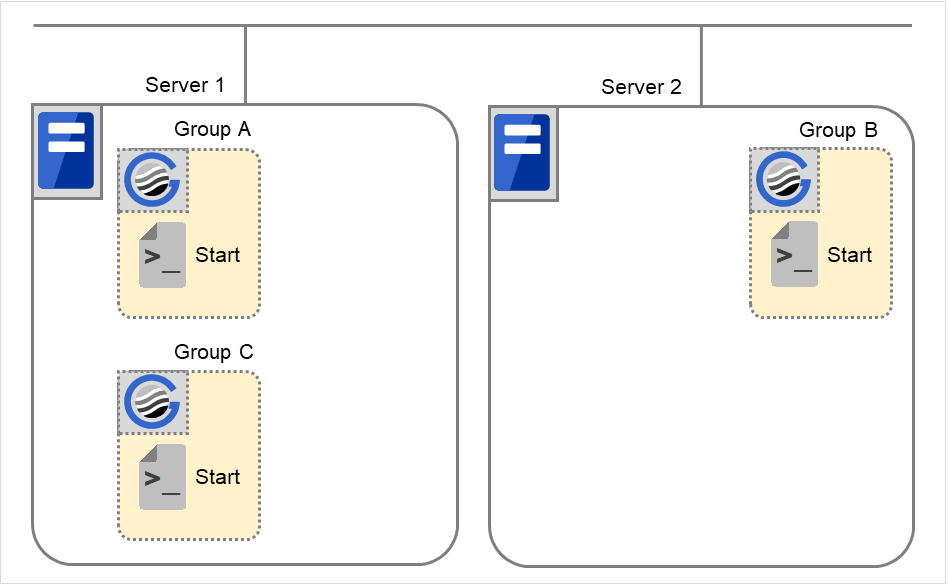

図 3.37 状態とスクリプト実行(通常立ち上げ)¶

Start に対する環境変数

Group A

Group B

Group C

CLP_EVENT

START

START

START

CLP_SERVER

HOME

HOME

HOME

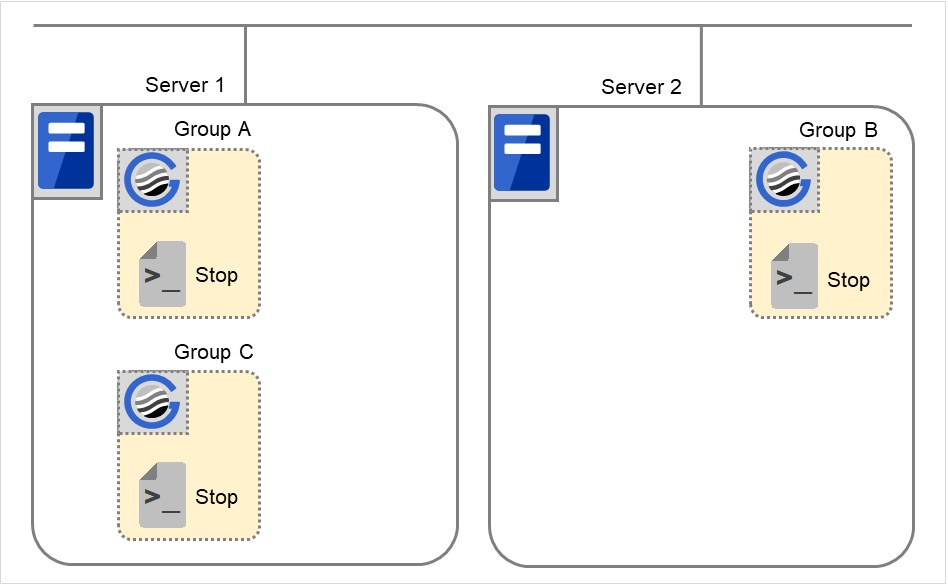

通常シャットダウン

ここでいう通常シャットダウンとは、終了スクリプトに対応する開始スクリプトが、通常立ち上げにより実行された、もしくはグループの移動 (オンラインフェイルバック) により実行された直後の、クラスタシャットダウンを指します。

図 3.38 状態とスクリプト実行(通常シャットダウン)¶

Stop に対する環境変数

Group A

Group B

Group C

CLP_EVENT

START

START

START

CLP_SERVER

HOME

HOME

HOME

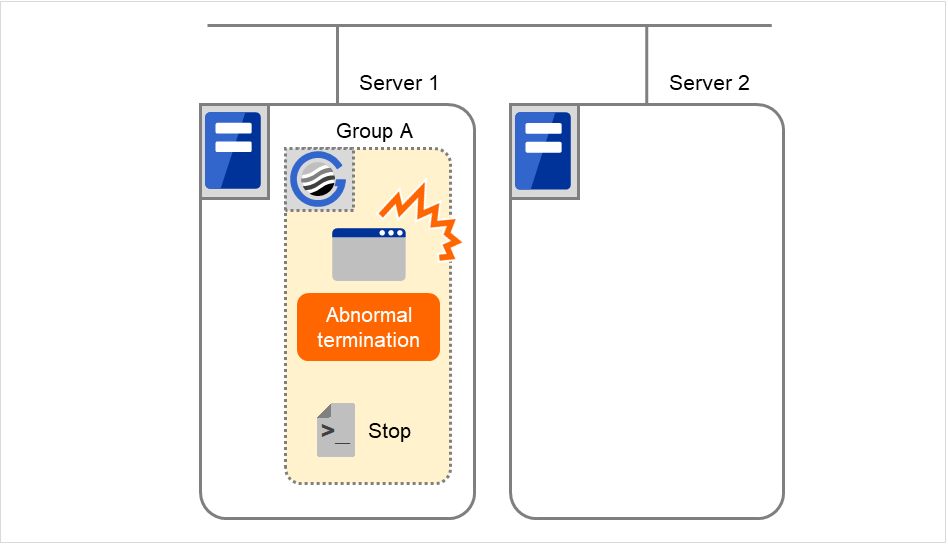

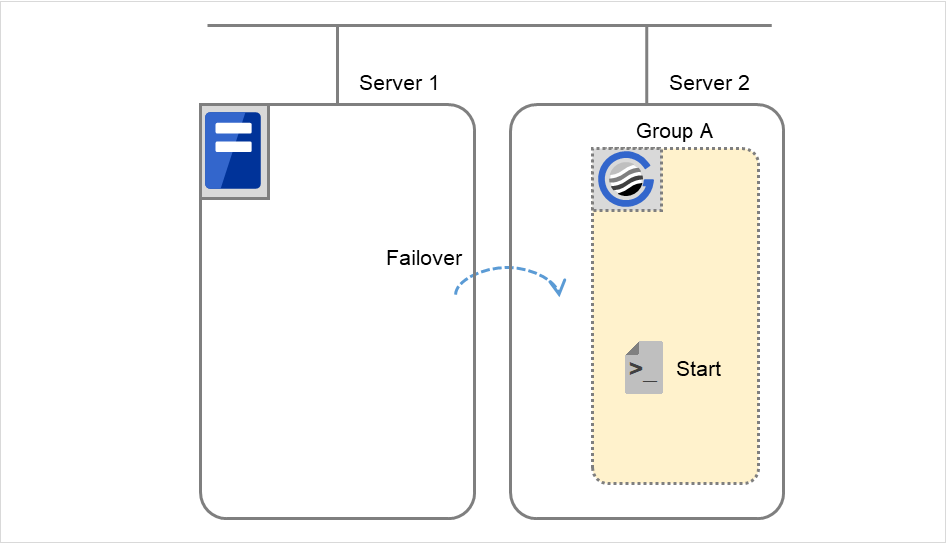

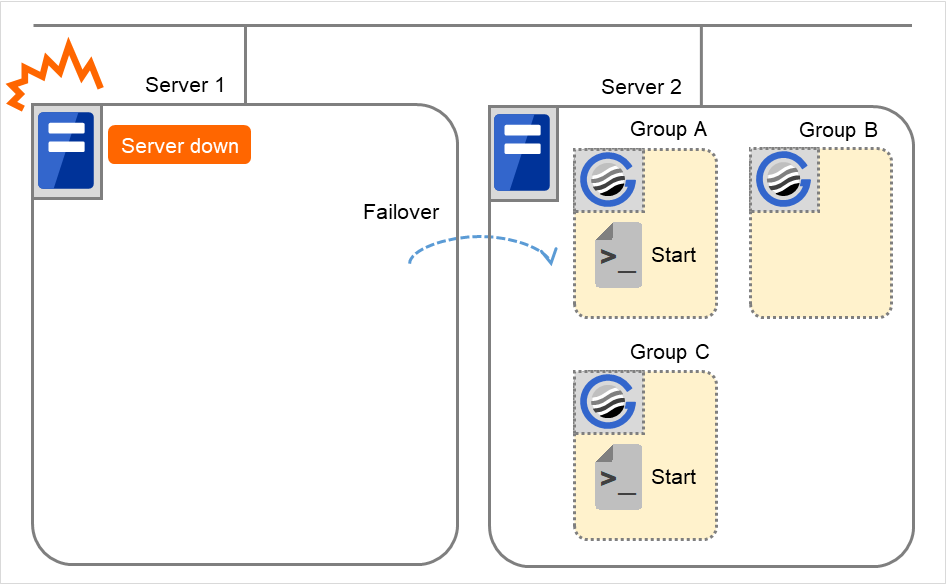

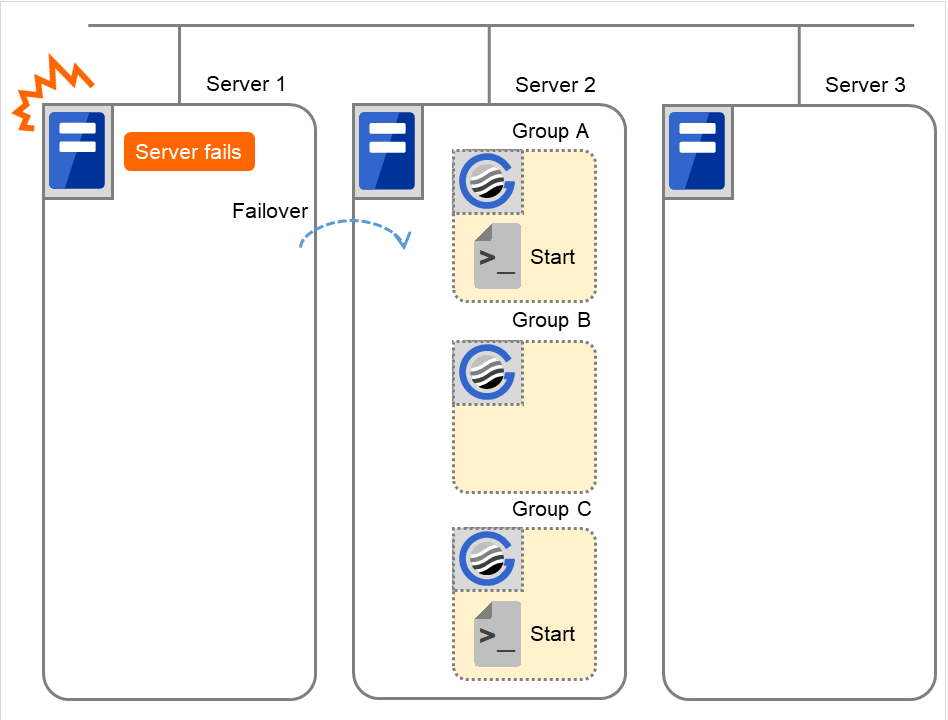

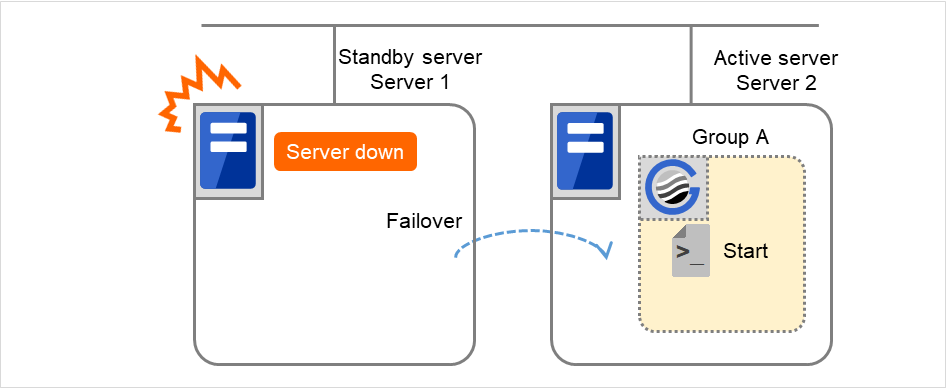

Server 1 ダウンによるフェイルオーバ

Server 1 をプライマリサーバとするグループの開始スクリプトが、障害発生により下位のプライオリティサーバ (Server 2) で実行されます。開始スクリプトには、CLP_EVENT (=FAILOVER) を分岐条件にして、業務の起動、復旧処理 (たとえばデータベースのロールバック処理など) を記述しておく必要があります。

プライマリサーバ以外でのみ実行したい処理がある場合は、CLP_SERVER (=OTHER) を分岐条件にして記述しておく必要があります。

図 3.39 状態とスクリプト実行(サーバダウンによるフェイルオーバ)¶

Start に対する環境変数

Group A

Group C

CLP_EVENT

FAILOVER

FAILOVER

CLP_SERVER

OTHER

OTHER

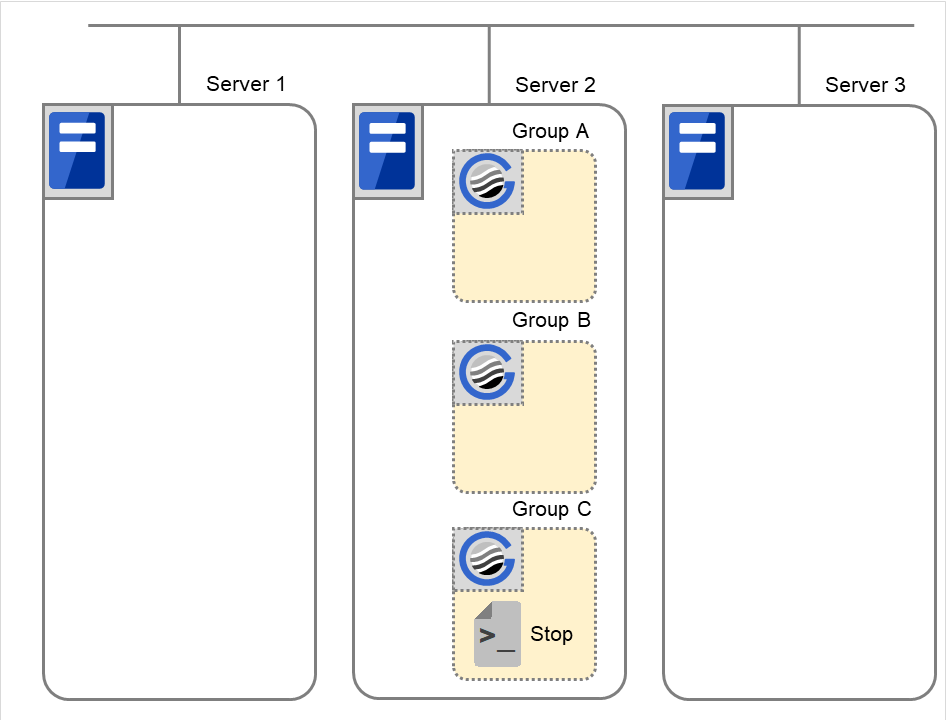

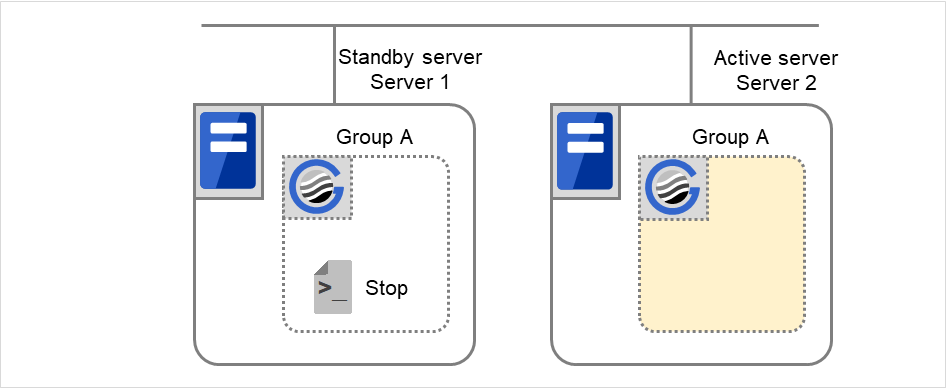

Server 1 フェイルオーバ後クラスタシャットダウン

Group A と Group C の終了スクリプトが、フェイルオーバ先のServer 2 で実行されます (Group B の終了スクリプトは、通常シャットダウンでの実行です)。

図 3.40 状態とスクリプト実行(フェイルオーバ後、クラスタシャットダウン)¶

Stop に対する環境変数

Group A

Group B

Group C

CLP_EVENT

FAILOVER

START

FAILOVER

CLP_SERVER

OTHER

HOME

OTHER

Group A と Group C の移動

Group A と Group C の終了スクリプトが、フェイルオーバ先のServer 2 で実行された後、Server 1 で開始スクリプトが実行されます。

図 3.41 状態とスクリプト実行(Group A、Group Cの移動)(1)¶

図 3.42 状態とスクリプト実行(Group A、Group Cの移動)(2)¶

Stop に対する環境変数

Group A

Group C

CLP_EVENT

FAILOVER 2

FAILOVER

CLP_SERVER

OTHER

OTHER

Startに対する環境変数

Group A

Group C

CLP_EVENT

START

START

CLP_SERVER

HOME

HOME

- 2

- 終了スクリプトの環境変数の値は、直前に実行された開始スクリプトの環境変数の値となる。「5. Group A と Group C の移動」の遷移の場合、直前にクラスタシャットダウンがないのでFAILOVERになるが、「5. Group A と Group C の移動」の前にクラスタシャットダウンが行われていると、STARTとなる。

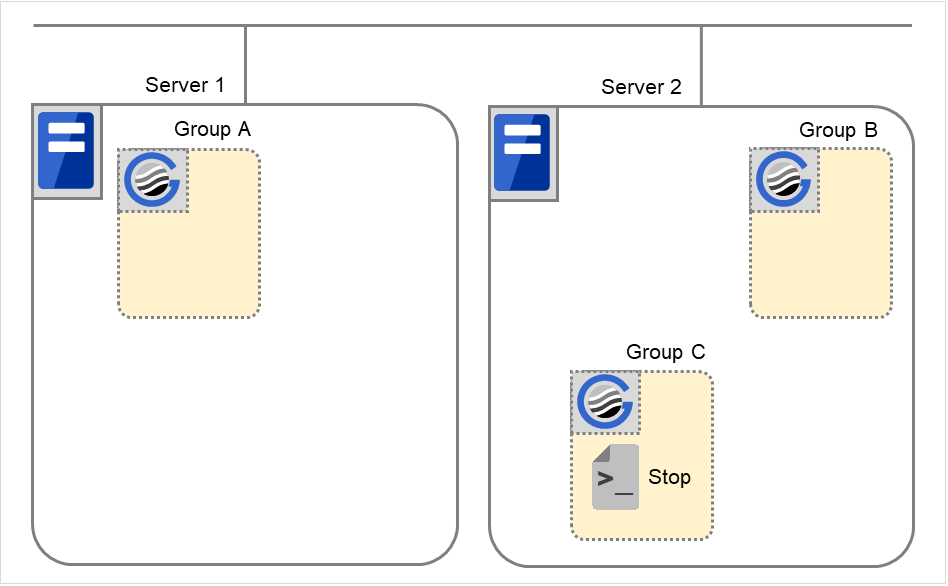

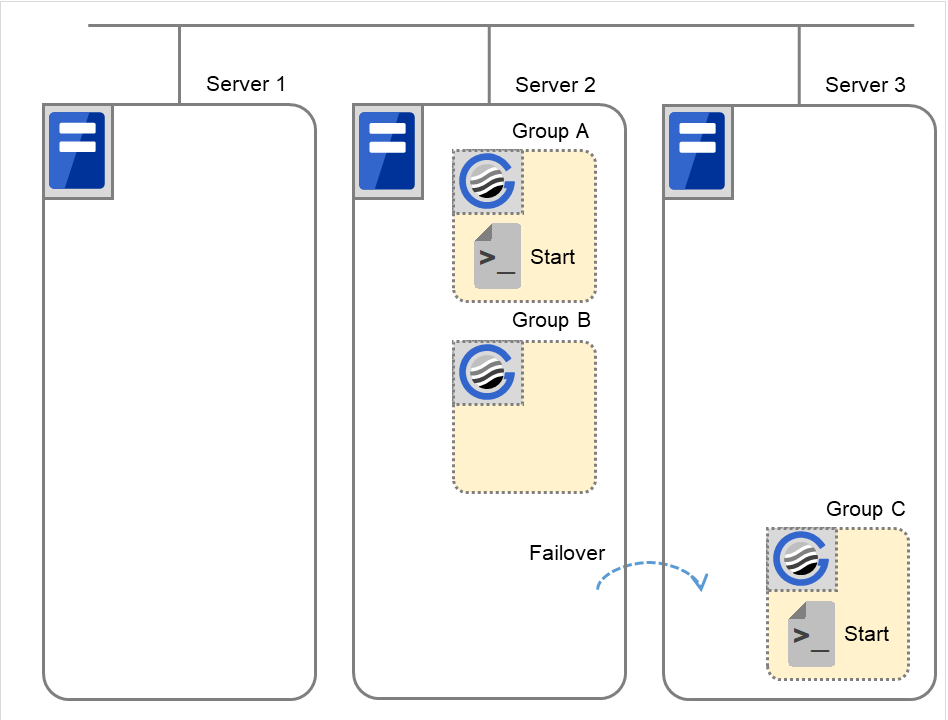

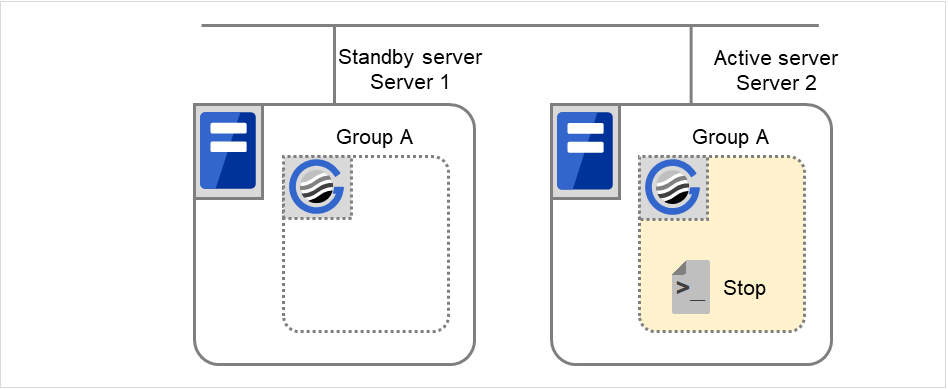

Group C の障害、フェイルオーバ

Group C に障害が発生すると、Server 1 でGroup C の終了スクリプトが実行され、Server 2 でGroup C の開始スクリプトが実行されます。

図 3.43 状態とスクリプト実行(Group Cの障害、フェイルオーバ)(1)¶

図 3.44 状態とスクリプト実行(Group Cの障害、フェイルオーバ)(2)¶

Server 1 のStopに対する環境変数

Group C

CLP_EVENT

START

CLP_SERVER

HOME

Server 2のStartに対する環境変数

Group C

CLP_EVENT

FAILOVER

CLP_SERVER

OTHER

Group C の移動

でServer 2 にフェイルオーバしてきたGroup C を、Server 2 よりServer 1 へ移動します。Server 2 で終了スクリプトを実行した後、Server 1 で開始スクリプトを実行します。

図 3.45 状態とスクリプト実行(Group Cの移動)(1)¶

Stopに対する環境変数 ( 6. よりフェイルオーバしてきたため)

Group C

CLP_EVENT

FAILOVER

CLP_SERVER

OTHER

図 3.46 状態とスクリプト実行(Group Cの移動)(2)¶

Startに対する環境変数

Group C

CLP_EVENT

START

CLP_SERVER

HOME

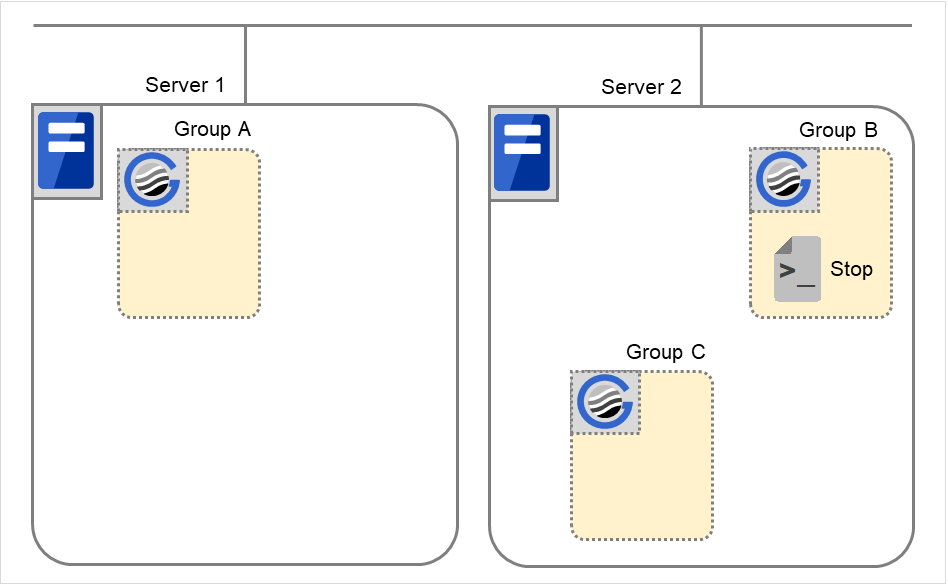

Group B の停止

Group B の終了スクリプトがServer 2 で実行されます。

図 3.47 状態とスクリプト実行(Group Bの停止)¶

Stopに対する環境変数

Group B

CLP_EVENT

START

CLP_SERVER

HOME

Group B の起動

Group B の開始スクリプトがServer 2 で実行されます。

図 3.48 状態とスクリプト実行(Group Bの起動)¶

Startに対する環境変数

Group B

CLP_EVENT

START

CLP_SERVER

HOME

Group C の停止

Group C の終了スクリプトがServer 2 で実行されます。

図 3.49 状態とスクリプト実行(Group Cの停止)¶

Stopに対する環境変数

Group C

CLP_EVENT

FAILOVER

CLP_SERVER

OTHER

Group C の起動

Group C の開始スクリプトがServer 2 で実行されます。

図 3.50 状態とスクリプト実行(Group Cの起動)¶

Startに対する環境変数

Group C

CLP_EVENT

START

CLP_SERVER

OTHER

【補足1】

フェイルオーバポリシーに設定されているサーバを 3 つ以上持つグループにおいて、プライマリサーバ以外のサーバで異なった動作を行う場合、 CLP_SERVER (HOME/OTHER) の代わりに、CLP_PRIORITY を使用します。

図 3.51 クラスタ状態遷移の例(サーバダウンによるフェイルオーバ)¶

(例1) クラスタ状態遷移図 「3. Server 1 ダウンによるフェイルオーバ」の場合

Server 1 をプライマリサーバとするグループの開始スクリプトが、障害発生により次に高いフェイルオーバポリシーを持つServer 2 で実行されます。開始スクリプトには、CLP_EVENT (=FAILOVER) を分岐条件にして、業務の起動、復旧処理 (たとえばデータベースのロールバック処理など) を記述しておく必要があります。

2 番目に高いフェイルオーバポリシーを持つサーバのみで実行したい処理がある場合は、CLP_PRIORITY (=2) を分岐条件にして記述しておく必要があります。

図 3.52 状態とスクリプト実行(Group A、Group Cの起動)¶

Start に対する環境変数

Group A

Group C

CLP_EVENT

FAILOVER

FAILOVER

CLP_SERVER

OTHER

OTHER

CLP_PRIORITY

2

2

(例2) クラスタ状態遷移図「7. Group C の移動」の場合

図 3.53 クラスタ状態遷移の例(Group Cの移動)¶

Group C の終了スクリプトが、フェイルオーバ元のServer 2 で実行された後、Server 3で開始スクリプトが実行されます。

図 3.54 状態とスクリプト実行(Group Cの移動)(1)¶

Stop に対する環境変数

Group C

CLP_EVENT

FAILOVER

CLP_SERVER

OTHER

CLP_PRIORITY

2

図 3.55 状態とスクリプト実行(Group Cの移動)(2)¶

Startに対する環境変数

Group C

CLP_EVENT

START

CLP_SERVER

OTHER

CLP_PRIORITY

3

【補足2】

リソースモニタがスクリプトを (再) 起動する場合

リソースモニタがアプリケーションの異常を検出し開始スクリプトを (再) 起動する場合の環境変数は以下のようになります。

(例1) リソースモニタがServer 1 で起動していたアプリケーションの異常終了を検出してServer 1 でGroup A の再起動を行う場合

(例2) リソースモニタがServer 1 で起動していたアプリケーションの異常終了を検出してServer 2 へフェイルオーバをして、Server 2 でGroup A の起動を行う場合

【補足3】

[EXECリソース調整プロパティ] の [待機系サーバで実行する] を有効に設定すると、グループを起動したサーバ (=現用系サーバ) で開始スクリプトや終了スクリプトが実行されるタイミングに合わせて、グループを起動していない他のサーバ (=待機系サーバ) でもスクリプトを実行することができます。

現用系サーバでのスクリプト実行と比較すると、待機系サーバでのスクリプト実行には以下の特徴があります。

スクリプトの実行結果 (エラーコード) がグループリソースのステータスに影響しません。

活性前後スクリプトや非活性前後スクリプトを実行しません。

活性時監視に設定されているモニタリソースの起動・停止を行いません。

セットされる環境変数の種類・値が異なります (前項「 EXEC リソースのスクリプトで使用する環境変数 」を参照してください)。

待機系サーバでスクリプトが実行されるタイミングと環境変数の関連について、クラスタ状態遷移図にあわせて説明します。

【クラスタ状態遷移図】

図 3.60 クラスタ状態遷移の例(サーバダウンによるフェイルオーバ)¶

図中の 1. ~ 4. は、以下の説明に対応しています。

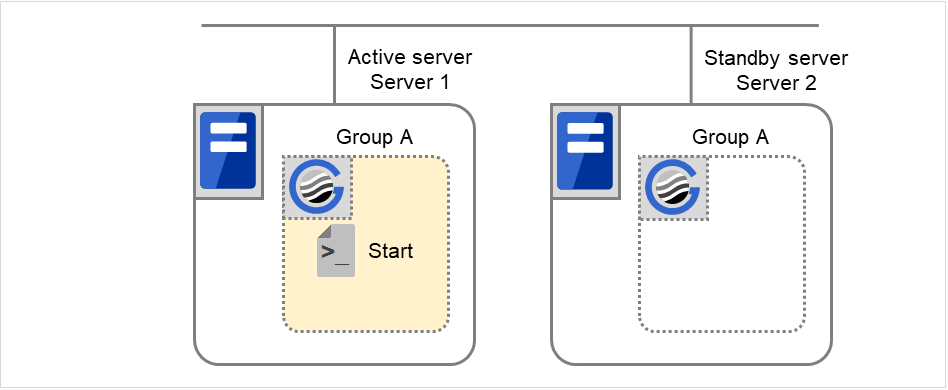

通常立ち上げ

図 3.61 状態とスクリプト実行(Group Aの通常起動)(1)¶

図 3.62 状態とスクリプト実行(Group Aの通常起動)(2)¶

Start に対する環境変数

Server 1

Server 2

CLP_EVENT

START

STANDBY

CLP_SERVER

HOME

OTHER

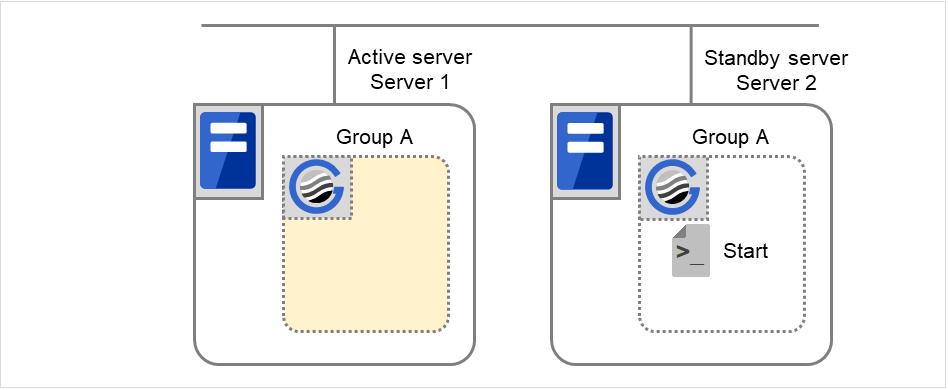

通常シャットダウン

図 3.63 状態とスクリプト実行(Group Aの通常シャットダウン)(1)¶

図 3.64 状態とスクリプト実行(Group Aの通常シャットダウン)(2)¶

Stop に対する環境変数

Server 1

Server 2

CLP_EVENT

START

STANDBY

CLP_SERVER

HOME

OTHER

Server 1 ダウンによるフェイルオーバ

Server 1 がダウン状態であるため、待機系サーバとしての開始スクリプトは実行されません。

図 3.65 クラスタ状態遷移の例(サーバダウンによるフェイルオーバ)¶

Start に対する環境変数

Server 2

CLP_EVENT

FAILOVER

CLP_SERVER

OTHER

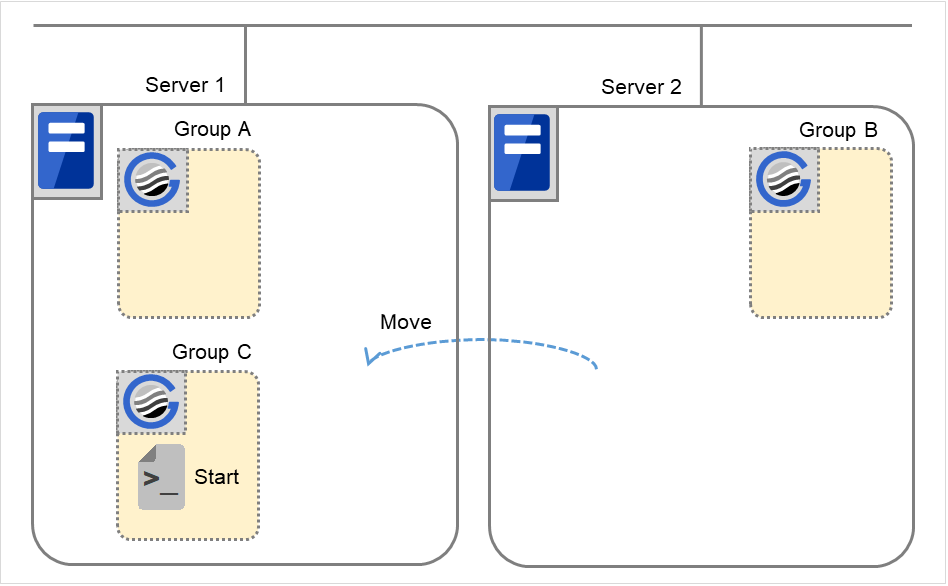

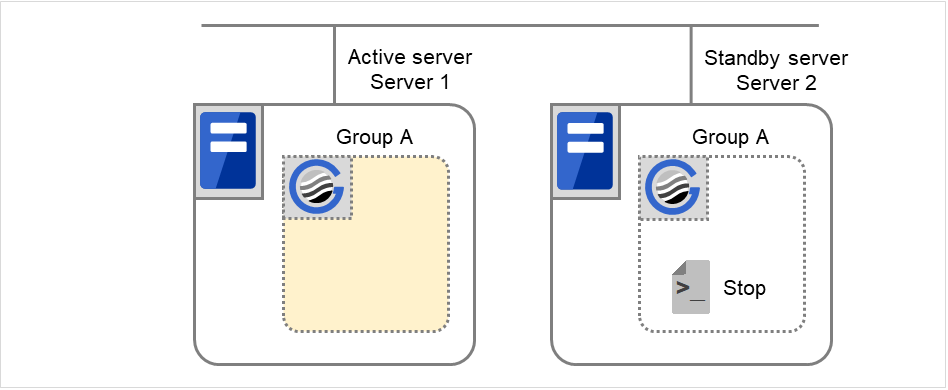

Group Aの移動

Group Aの終了スクリプトがServer 1 (= 待機系サーバ) とServer 2 (= 現用系サーバ) で実行された後、 開始スクリプトがServer 1 (= 現用系サーバ) とServer 2 (= 待機系サーバ) で実行されます。

図 3.66 状態とスクリプト実行(Group Aの移動)(1)¶

図 3.67 状態とスクリプト実行(Group Aの移動)(2)¶

図 3.68 状態とスクリプト実行(Group Aの移動)(3)¶

図 3.69 状態とスクリプト実行(Group Aの移動)(4)¶

Stop に対する環境変数

Server 1

Server 2

CLP_EVENT

STANDBY

FAILOVER 3

CLP_SERVER

HOME

OTHER

- 3

Start に対する環境変数

Server 1

Server 2

CLP_EVENT

START

STANDBY

CLP_SERVER

HOME

OTHER

3.6.6. EXEC リソーススクリプトの記述の流れ¶

前のトピックの、スクリプトの実行タイミングと実際のスクリプト記述を関連付けて説明します。文中の (数字) は 「 EXEC リソーススクリプトの実行タイミング 」の各動作をさします。

group A 開始スクリプト: start.sh の一例

#!/bin/sh

# ***************************************

# * start.sh *

# ***************************************

# スクリプト実行要因の環境変数を参照して処理の振り分けを行う。

if [ "$CLP_EVENT" = "START" ]

then

# DISK接続情報環境変数を参照してエラー処理の要否を判定する。

if [ "$CLP_DISK" = "SUCCESS" ]

then

# ここに、業務の通常起動処理を記述する。

# この処理は以下のタイミングで実行される。

#

# (1) 通常立ち上げ

# (5) Group A と Group C の移動

#

# 実行サーバ環境変数を参照して処理の振り分けを行う。

if [ "$CLP_SERVER" = "HOME" ]

then

# ここに、プライマリサーバで、業務が通常起動される場合にのみ行いたい処理を記述する。

# この処理は以下のタイミングで実行される。

#

# (1) 通常立ち上げ

# (5) Group A と Group C の移動

#

else

# ここに、プライマリサーバ以外で、業務が通常起動される場合にのみ行いたい処理を記述する。

#

fi

else

# ここに、ディスク関連のエラー処理を記述する。

#

fi

elif [ "$CLP_EVENT" = "FAILOVER" ]

then

# DISK接続情報環境変数を参照してエラー処理の要否を判定する。

if [ "$CLP_DISK" = "SUCCESS" ]

then

# ここに、業務の通常起動処理を記述する。

# この処理は以下のタイミングで実行される。

#

# (3) Server 1ダウンによるフェイルオーバ

#

# 実行サーバ環境変数を参照して処理の振り分けを行う。

if [ "$CLP_SERVER" = "HOME" ]

then

# ここに、フェイルオーバ後、プライマリサーバで業務が起動される場合にのみ行いたい処理を記述する。

#

else

# ここに、フェイルオーバ後、非プライマリサーバで業務が起動される場合にのみ行いたい処理を記述する。

# この処理は以下のタイミングで実行される。

#

# (3) Server 1ダウンによるフェイルオーバ

#

fi

else

# ここに、ディスク関連のエラー処理を記述する。

#

fi

else

# CLUSTERPROは動作していない。

fi

# 終了コードが0の場合、EXECリソースの活性処理は成功と判定される。

# スクリプト内でエラーが発生した場合には 0以外の終了コードを返却するように記述する。

exit 0

Group A 終了スクリプト: stop.sh の一例

#!/bin/sh

# ***************************************

# * stop.sh *

# ***************************************

# スクリプト実行要因の環境変数を参照して処理の振り分けを行う。

if [ "$CLP_EVENT" = "START" ]

then

if [ "$CLP_DISK" = "SUCCESS" ]

then

# ここに、業務の通常終了処理を記述する。以下のタイミングで実行される。

#

# (2) 通常シャットダウン

#

# 実行サーバ環境変数を参照して処理の振り分けを行う。

if [ "$CLP_SERVER" = "HOME" ]

then

# ここに、プライマリサーバで業務が通常終了される場合にのみ行いたい処理を記述する。

# この処理は以下のタイミングで実行される。

#

# (2) 通常シャットダウン

#

else

# ここに、プライマリサーバ以外で業務が通常終了される場合にのみ行いたい処理を記述する。

#

fi

else

# ここに、ディスク関連のエラー処理を記述する。

#

fi

elif [ "$CLP_EVENT" = "FAILOVER" ]

then

# DISK接続情報環境変数を参照してエラー処理の要否を判定する。

if [ "$CLP_DISK" = "SUCCESS" ]

then

# ここに、フェイルオーバ後の通常終了処理を記述する。

# この処理は以下のタイミングで実行される。

#

# (4) Server 1フェイルオーバ後、クラスタシャットダウン

# (5) Group A と Group C の移動

#

# 実行サーバ環境変数を参照して処理の振り分けを行う。

if [ "$CLP_SERVER" = "HOME" ]

then

# ここに、フェイルオーバ後、プライマリサーバで業務が終了される場合にのみ行いたい処理を記述する。

#

else

# ここに、フェイルオーバ後、非プライマリサーバで業務が終了される場合にのみ行いたい処理を記述する。

# この処理は以下のタイミングで実行される。

#

# (4) Server 1フェイルオーバ後、クラスタシャットダウン

# (5) Group A と Group C の移動

#

fi

else

# ここに、ディスク関連のエラー処理を記述する。

#

fi

else

# CLUSTERPROは動作していない。

fi

# 終了コードが0の場合、EXECリソースの非活性処理は成功と判定される。

# スクリプト内でエラーが発生した場合には 0以外の終了コードを返却するように記述する。

exit 0

3.6.7. EXEC リソーススクリプト作成のヒント¶

以下の点に注意して、スクリプトを作成してください。

スクリプト中にて、実行に時間を必要とするコマンドを実行する場合には、コマンドの実行が完了したことを示すトレースを残すようにしてください。この情報は、問題発生時、障害の切り分けを行う場合に使用することができます。トレースを残す方法は下記の 2 つがあります。

- スクリプト中に [echo] コマンドを記述して EXEC リソースのログ出力先を設定する方法トレースを [echo] コマンドにて標準出力することができます。その上で、スクリプトが属しているリソースのプロパティでログ出力先を設定します。デフォルトではログ出力されません。ログ出力先の設定については「詳細タブ」の「EXEC リソース調整プロパティ」にある「メンテナンスタブ」を参照してください。[ローテートする]チェックボックスがオフの場合は、ログ出力先に設定されたファイルには、サイズが無制限に出力されますのでファイルシステムの空き容量に注意してください。

(例:スクリプト中のイメージ)

echo "appstart.." appstart echo "OK"

- スクリプト中に clplogcmd を記述する方法clplogcmd で Cluster WebUI のアラートログや OS の syslog に、メッセージを出力できます。clplogcmd については、本ガイドの「8. CLUSTERPRO コマンドリファレンス」の「メッセージを出力する (clplogcmd コマンド)」を参照してください。

(例:スクリプト中のイメージ)

clplogcmd -m "appstart.." appstart clplogcmd -m "OK"

3.6.8. EXEC リソース 注意事項¶

スクリプトのログローテート機能について

スクリプトのログローテート機能を有効にした場合、ログ出力を仲介するプロセス(仲介プロセス)が生成されます。仲介プロセスは、「開始・停止スクリプト」および「開始・停止スクリプトから標準出力・標準エラー出力のいずれかまたは両方を継承した子孫プロセス」からのログ出力が全て停止 (ファイルディスクリプタがクローズ) するまで動作を継続します。子孫プロセスの出力をログから除外する場合は、スクリプトからのプロセス生成時に標準出力および標準エラー出力をリダイレクトしてください。

開始スクリプト/終了スクリプトはroot ユーザで実行されます。

環境変数に依存するアプリケーションを起動する際には必要に応じてスクリプト側で環境変数の設定を行っていただく必要があります。

3.6.9. 詳細タブ¶

ユーザアプリケーション

スクリプトとしてサーバ上の実行可能ファイル (実行可能なシェルスクリプトやバイナリファイル) を使用します。各実行可能ファイル名は、サーバ上のローカルディスクのパスで設定します。

各実行可能ファイルは、各サーバに配布されません。各サーバ上に準備する必要があります。Cluster WebUI のクラスタ構成情報には含まれません。スクリプトファイルは Cluster WebUI では編集できません。

この製品で作成したスクリプト

スクリプトとして Cluster WebUI で準備したスクリプトファイルを使用します。必要に応じてCluster WebUI でスクリプトファイルを編集できます。スクリプトファイルは、クラスタ構成情報に含まれます。

表示

[この製品で作成したスクリプト] を選択した場合に、スクリプトファイルを表示します。

編集

[この製品で作成したスクリプト] を選択した場合に、スクリプトファイルを編集します。変更を反映するには [保存] をクリックしてください。スクリプトファイル名の変更はできません。

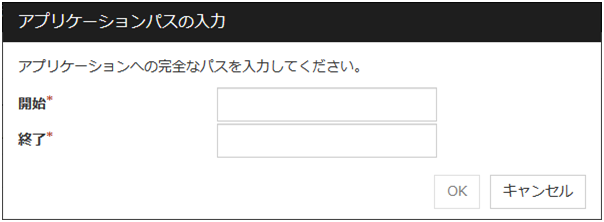

[ユーザアプリケーション] を選択している場合は [アプリケーション・パスの入力] ダイアログボックスが表示されます。

アプリケーション・パスの入力

EXEC リソースの実行可能ファイル名を設定します。

開始 (1023 バイト以内)

EXEC リソースの開始時の実行可能ファイル名を設定します。「/」 で始まる必要があります。引数を指定することも可能です。

終了 (1023 バイト以内)

EXEC リソースの終了時の実行可能ファイル名を設定します。「/」 で始まる必要があります。終了スクリプトは省略可能です。

実行可能ファイル名はクラスタサーバ上のファイルを 「/」 から始まる完全なパス名で設定する必要があります。引数を指定することも可能です。

置換

[この製品で作成したスクリプト] を選択した場合に、[ファイル選択] ダイアログボックスが表示されます。

[リソースのプロパティ] で選択したスクリプトファイルの内容が、[ファイル選択] ダイアログボックスで選択したスクリプトファイルの内容に置換されます。スクリプトが表示中または編集中の場合は置換できません。ここではスクリプトファイルを選択してください。バイナリファイル (アプリケーションなど) は選択しないでください。

調整

EXEC リソース調整プロパティダイアログを表示します。EXEC リソースの詳細設定を行います。EXEC リソースを PID モニタリソースで監視するには、開始スクリプトの設定を非同期にする必要があります。

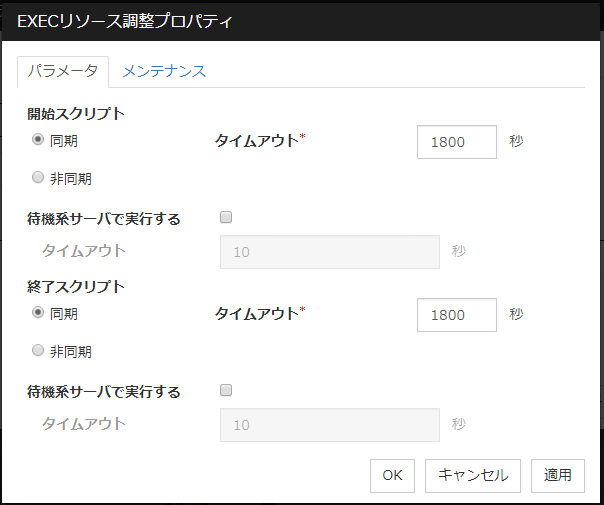

EXEC リソース調整プロパティ

パラメータタブ

[開始スクリプト]、[終了スクリプト] 全スクリプト共通

同期

スクリプトの実行時にスクリプトの終了を待ちます。常駐しない (実行後に処理がすぐ戻る) 実行可能ファイルの場合に選択します。

非同期

スクリプトの実行時にスクリプトの終了を待ちません。常駐する実行可能ファイルの場合に選択します。EXEC リソースの開始スクリプトを非同期で実行する場合は、PID モニタリソースで監視できます。

タイムアウト (1~9999)

スクリプトの実行時に終了を待つ場合 ([同期]) のタイムアウトを設定します。[同期] を選択している場合のみ入力可能です。設定時間内にスクリプトが終了しないと、異常と判断します。

待機系サーバで実行する

スクリプトを待機系サーバで実行するか否かを設定します。本パラメータを有効にした場合、待機系サーバで実行する際のタイムアウト (1~9999) が設定可能となります。

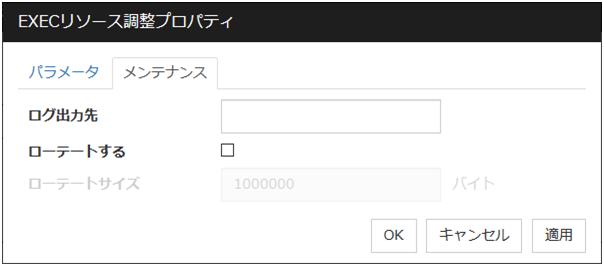

メンテナンスタブ

ログ出力先 (1023バイト以内)

EXEC リソースのスクリプトや実行可能ファイルの標準出力と標準エラー出力のリダイレクト先を指定します。何も指定しない場合、/dev/null に出力されます。「/」 で始まる必要があります。[ローテートする]チェックボックスがオフの場合は無制限に出力されますのでファイルシステムの空き容量に注意してください。[ローテートする]チェックボックスがオンの場合は、出力されるログファイルは、ローテートします。また、以下の注意事項があります。

[ログの出力先] には 1009 バイト以内でログのパスを記述してください。1010 バイトを超えた場合、ログの出力が行えません。

ログファイルの名前の長さは 31 バイト以内で記述してください。32 バイト以上の場合、ログの出力が行えません。

ローテートする

EXEC リソースのスクリプトや実行可能ファイルの実行ログを、オフの場合は無制限のファイルサイズで、オンの場合はローテートして出力します。

ローテートサイズ (1~999999999)[ローテートする]チェックボックスがオンの場合に、ローテートするサイズを指定します。ローテート出力されるログファイルの構成は、以下のとおりです。

ファイル名

内容

[ログ出力先]指定のファイル名

最新のログです。

[ログ出力先]指定のファイル名.pre

ローテートされた以前のログです。

3.7. ディスクリソースを理解する¶

3.7.1. ディスクリソースの依存関係¶

既定値では、以下のグループリソースタイプに依存します。

グループリソースタイプ |

|---|

ダイナミック DNS リソース |

フローティング IP リソース |

仮想 IP リソース |

ボリュームマネージャリソース |

AWS Elastic IPリソース |

AWS 仮想IPリソース |

AWS DNS リソース |

Azure プローブポートリソース |

Azure DNS リソース |

3.7.2. 切替パーティションとは?¶

注釈

ディスクタイプが「raw」の場合には、CLUSTERPRO が切替パーティションを OS の raw デバイスにマップ (bind) することで実現しています。また、ディスクリソース調整プロパティの[アンバインドを実行する]チェックボックスがオンの場合には、ディスクリソース非活性時にアンバインド処理を行います。

切替パーティションが全サーバで、同じデバイス名でアクセスできない場合は、サーバ個別設定を行ってください。

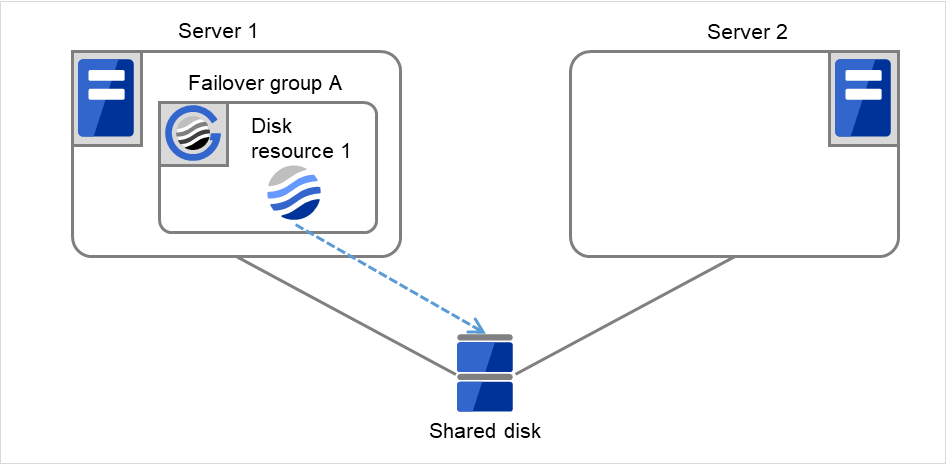

図 3.70 切替パーティション (1)¶

図 3.71 切替パーティション (2)¶

3.7.3. ディスクリソース制御下のデバイス領域拡張方法¶

対象デバイスの領域拡張は以下の手順で行ってください。 なお、以下の手順は必ず、該当ディスクリソースが活性しているサーバ上にて実行してください。

該当ディスクリソースが所属するグループを、clpgrp コマンド等で非活性にしてください。

ディスクが mount されていないことを、mount コマンドや df コマンドを使用して確認します。

- 該当ディスクリソースの種類に応じて、以下のコマンドを実行してディスクを Read Only から Read Write の状態にします。

# clproset -w -d (デバイス名)

デバイスの領域拡張を実施します。

- 該当ディスクリソースの種類に応じて、以下のコマンドを実行して、ディスクを Read Write から Read Only の状態にします。

# clproset -o -d (デバイス名)

該当ディスクリソースが所属するグループを、clpgrp コマンド等で活性にしてください。

3.7.4. ディスクリソースに関する注意事項¶

<ディスクリソース全般>

ファイルシステムのアクセス制御 (mount/umount) は、CLUSTERPRO が行いますので、OS 側で mount/umount する設定を行わないでください。また、共有ディスクのファイルシステムを OS の /etc/fstab にエントリしないでください。(/etc/fstabへのエントリが必要な場合には、ignoreオプションは使用せずnoautoオプションを使用してください。)

ディスクリソースに設定されたパーティションデバイス名はクラスタ内の全サーバでリードオンリーの状態になります。グループを活性するサーバで、活性時にリードオンリーは解除されます。

クラスタプロパティの [拡張] タブで、[マウント、アンマウントコマンドを排他する] にチェックを入れている場合、ディスクリソース、NAS リソース、ミラーリソースの mount/umount は同一サーバ内で排他的に動作するため、ディスクリソースの活性/非活性に時間がかかることがあります。

- マウントポイントにシンボリックリンクを含むパスを指定すると、異常検出時の動作に [強制終了] を選択しても強制終了できません。また、同様に「//」を含むパスを指定した場合にも、強制終了できません。

OS 起動時にデバイス順序の入れ替わりを防止するには、udevデバイス(例:/dev/disk/by-id/[デバイス名])をデバイス名に設定してください。

OS 上でランレベルの変更操作を行った際、デバイスのパスの故障/復旧が発生した際などに、ディスクリソースに設定されたパーティションデバイスのデバイスファイルが再作成され、その結果として、ディスクリソースに設定されたパーティションデバイスのリードオンリーが解除される場合があります。

<ディスクタイプ [LVM] での利用時>

本設定を利用する場合は、ボリュームマネージャリソースも併用してボリュームグループの制御を行うことを推奨します。詳細は本ガイド 「ボリュームマネージャリソースを理解する」を参照してください。

ボリュームの定義は CLUSTERPRO 側で行いません。

ファイルシステムに [zfs] を指定しないでください。

<ディスクタイプ [VXVM] での利用時>

本設定を利用する場合は、「ボリュームマネージャリソースを理解する」も参照してください。

ボリュームの定義は CLUSTERPRO 側で行いません。

ディスクグループをインポートし、ボリュームが起動された状態でアクセス可能な raw デバイス (/dev/vx/rdsk/[ディスクグループ名]/[ボリューム名]) のみを使用する場合 (ボリューム上にファイルシステムを構築しないで raw アクセスを行う場合) にはディスクリソースは不要です。

ファイルシステムに [zfs] を指定しないでください。

3.7.5. 詳細タブ¶

ディスクのタイプ サーバ個別設定可能

ディスクのタイプを指定します。以下の中から選択します。

disk

raw

lvm

vxvm

ファイルシステム (15バイト以内) サーバ個別設定可能

ディスクデバイス上に作成しているファイルシステムのタイプを指定します。以下の中から選択します。直接入力することもできます。[ディスクのタイプ] に [raw] 以外を設定した場合に設定が必要になります。

ext3

ext4

xfs

reiserfs

vxfs

zfs

デバイス名 (1023バイト以内) サーバ個別設定可能

ディスクリソースとして使用するディスクデバイス名を選択します。直接入力することもできます。[ファイルシステム] が [zfs] 以外の場合は 「/」 で始まる必要があります。[ファイルシステム] が [zfs] の場合はZFSデータセット名を指定します。

RAWデバイス名 (1023バイト以内) サーバ個別設定可能

ディスクリソースとして使用する RAW ディスクデバイス名を設定します。[ディスクのタイプ] が[raw] または [vxvm] の場合に設定が必要になります。

マウントポイント (1023バイト以内) サーバ個別設定可能

ディスクデバイスをマウントするディレクトリを設定します。「/」 で始まる必要があります。 [ディスクのタイプ] が [raw] 以外の場合に設定が必要になります。

調整

[ディスクリソース調整プロパティ] ダイアログボックスを表示します。ディスクリソースの詳細設定を行います。

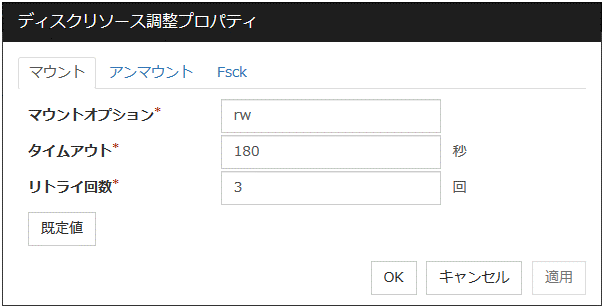

ディスクリソース調整プロパティ([ディスクのタイプ] が [raw] 以外の場合)

マウントタブ

マウントに関する詳細設定が表示されます。

マウントオプション (1023バイト以内)

ディスクデバイス上のファイルシステムをマウントする場合に [mount] コマンドへ渡すオプションを設定します。複数のオプションは [,(カンマ)] で区切ります。

マウントオプションの例

設定項目

設定値

デバイス名

/dev/sdb5

マウントポイント

/mnt/sdb5

ファイルシステム

ext3

マウントオプション

rw,data=journal

上記設定時に実行される [mount] コマンド

mount -t ext3 -o rw,data=journal /dev/sdb5 /mnt/sdb5

タイムアウト (1~999)

ディスクデバイス上のファイルシステムをマウントする場合の [mount] コマンドの終了を待つタイムアウトを設定します。ファイルシステムの容量が大きいと時間がかかる場合があります。設定する値が小さすぎないように注意してください。

リトライ回数 (0~999)

ディスクデバイス上のファイルシステムのマウントに失敗した場合のマウントリトライ回数を設定します。0 を設定するとリトライを実行しません。

既定値

[既定値] をクリックすると全ての項目に既定値が設定されます。

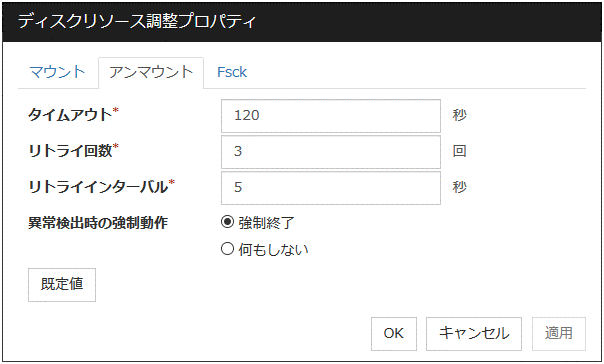

アンマウントタブ

アンマウントに関する詳細設定が表示されます。

タイムアウト (1~999)

ディスクデバイス上のファイルシステムをアンマウントする場合の、[umount] コマンドの終了を待つタイムアウトを設定します。

リトライ回数 (0~999)

ディスクデバイス上のファイルシステムのアンマウントに失敗した場合の、アンマウントリトライ回数を指定します。0 を設定するとリトライを実行しません。

リトライインターバル (0~999)

ディスクデバイス上のファイルシステムのアンマウントに失敗した場合に、次のリトライを実行するまでの間隔を指定します。

異常検出時の強制動作

アンマウントに失敗後、アンマウントリトライする場合に実行する動作を下記より選択します。

既定値

[既定値] をクリックすると全ての項目に既定値が設定されます。

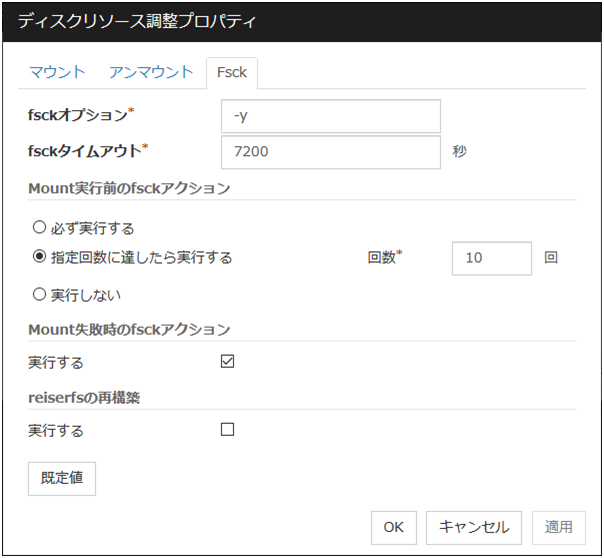

Fsckタブ

[fsck] に関する詳細設定が表示されます。ファイルシステムに[xfs] 以外を指定した場合に表示されます。ファイルシステムに [zfs] を指定した場合には無効となります。

fsckオプション (1023バイト以内)

ディスクデバイス上のファイルシステムをチェックする場合に [fsck] コマンドに渡すオプションを指定します。複数のオプションはスペースで区切って設定してください。ここで、[fsck] コマンドが対話形式にならないようにオプションを指定してください。[fsck] コマンドが対話形式になると、[fsck タイムアウト] が経過後リソースの活性がエラーになります。ファイルシステムが[reiserfs] の場合は対話形式になりますが、CLUSTERPRO が "Yes" を [reiserfsck] に渡すことによって回避します。

fsckタイムアウト (1~9999)

ディスクデバイス上のファイルシステムをチェックする場合に [fsck] コマンドの終了を待つタイムアウトを指定します。ファイルシステムの容量が大きいと時間がかかる場合があります。設定する値が小さすぎないように注意してください。

Mount実行前のfsckアクション

ディスクデバイス上のファイルシステムをマウントする前の [fsck] の動作を下記より選択します。

注釈

[fsck] の指定回数はファイルシステムが管理しているチェックインターバルとは無関係です。

Mount失敗時のfsckアクション

ディスクデバイス上のファイルシステムのマウントに失敗した場合の [fsck] の動作を設定します。この設定は [マウントリトライ回数] の設定値が 0 以外の場合に有効になります。

注釈

Mount 実行前の [fsck アクション] が [実行しない] の場合との組み合わせは推奨しません。この設定では、ディスクリソースは [fsck] を実行しないため、切替パーティションに [fsck]で修復可能な異常があった場合、ディスクリソースをフェイルオーバできません

reiserfsの再構築

[reiserfsck] が修復可能なエラーで失敗した場合の挙動を指定します。

既定値

[既定値] をクリックすると全ての項目に既定値が設定されます。

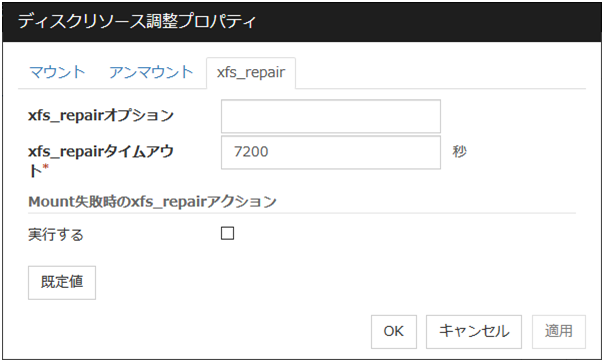

xfs_repairタブ

[xfs_repair] に関する詳細設定が表示されます。ファイルシステムに[xfs] を設定した場合のみ表示されます。

xfs_repairオプション (1023バイト以内)

ディスクデバイス上のファイルシステムをチェックする場合に [xfs_repair] コマンドに渡すオプションを指定します。複数のオプションはスペースで区切って設定してください。

xfs_repairタイムアウト (1~9999)

ディスクデバイス上のファイルシステムをチェックする場合に [xfs_repair] コマンドの終了を待つタイムアウトを指定します。ファイルシステムの容量が大きいと時間がかかる場合があります。設定する値が小さすぎないように注意してください。

Mount失敗時のxfs_repairアクション

ディスクデバイス上のファイルシステムのマウントに失敗した場合の [xfs_repair] の動作を設定します。この設定は [マウントリトライ回数] の設定値が 0 以外の場合に有効になります。

既定値

[既定値] をクリックすると全ての項目に既定値が設定されます。

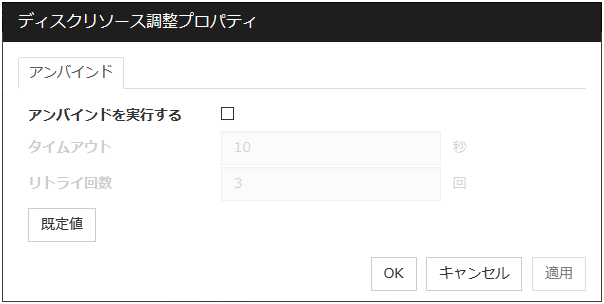

ディスクリソース調整プロパティ([ディスクのタイプ] が [raw] の場合)

アンバインドタブ

アンバインドに関する詳細設定が表示されます。

アンバインドを実行する

RAWディスクデバイスのアンバインド実行有無を指定します。

タイムアウト (1~999)

[アンバインドを実行する]チェックボックスがオンの場合に、RAWディスクデバイスのアンバインド処理の終了を待つタイムアウトを設定します。

リトライ回数 (1~999)

[アンバインドを実行する]チェックボックスがオンの場合に、RAWディスクデバイスのアンバインド処理に失敗した場合の、アンバインドリトライ回数を指定します。

既定値

[既定値] をクリックすると全ての項目に既定値が設定されます。

3.8. フローティング IP リソースを理解する¶

3.8.1. フローティング IP リソースの依存関係¶

既定値では、依存するグループリソースタイプはありません。

3.8.2. フローティング IP とは?¶

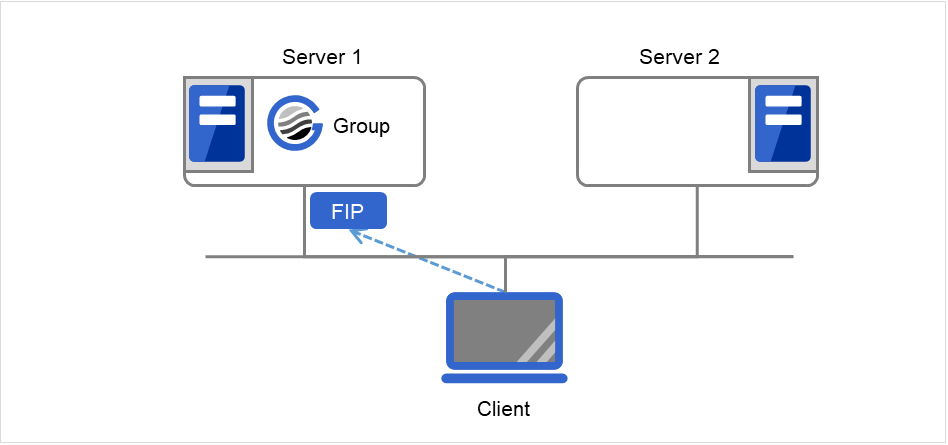

クライアントアプリケーションは、フローティング IP アドレスを使用してクラスタサーバに接続することができます。フローティング IP アドレスを使用することにより、"フェイルオーバ" または、"グループの移動" が発生しても、クライアントは、接続先サーバの切り替えを意識する必要がありません。

フローティング IP アドレスは、同一 LAN 上でもリモート LAN からでも使用可能です。

[ifconfig] コマンドもしくは API を実行し、OS に IP アドレスを付与します。[ifconfig] コマンドもしくは API のどちらを実行するかは、フローティング IP リソースが自動的に判定します。[ifconfig] コマンドが以下のフォーマット以外の場合はAPI を実行します。

eth0 Link encap:Ethernet HWaddr 00:50:56:B7:1B:C0

inet addr:192.168.1.113 Bcast:192.168.1.255 Mask:255.255.255.0

inet6 addr: fe80::250:56ff:feb7:1bc0/64 Scope:Link

:

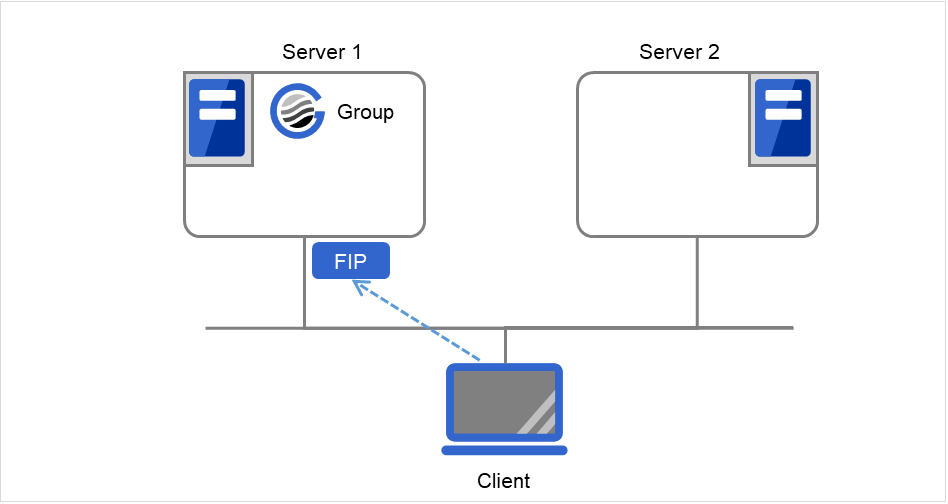

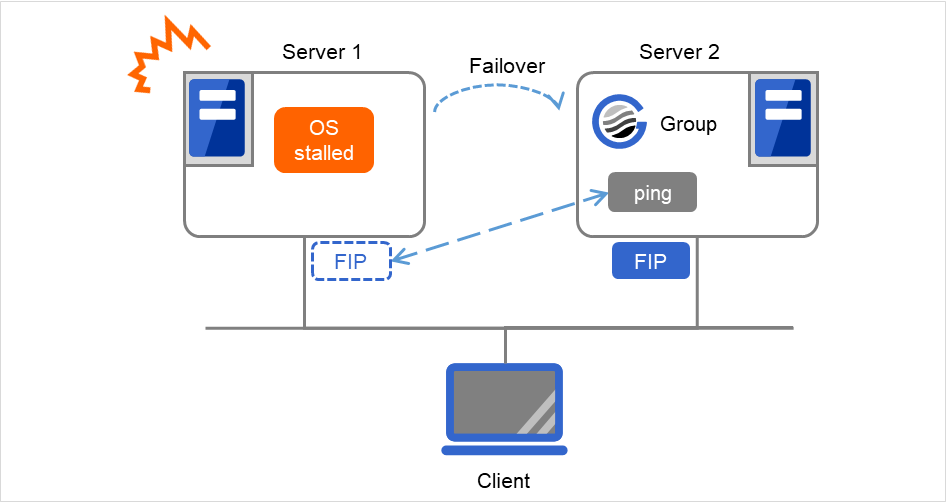

ClientはフローティングIP(FIP)によって Server 1へアクセスします。

図 3.72 フローティングIPによるアクセス (1)¶

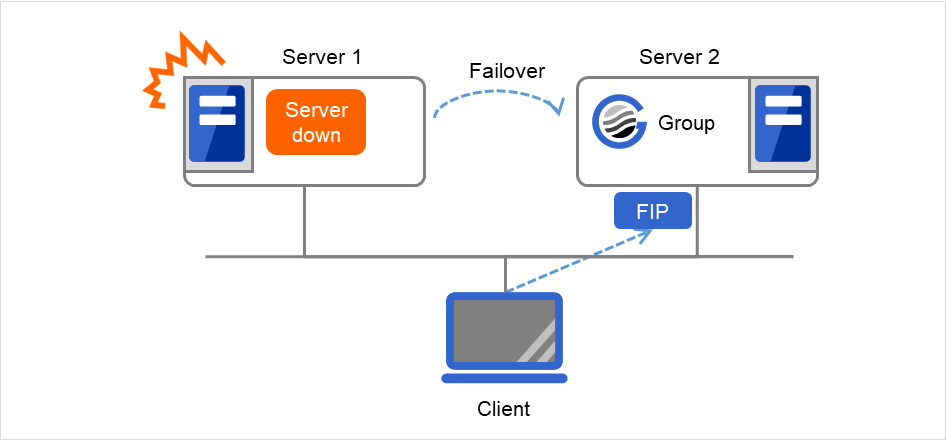

Server 1からServer 2へのフェイルオーバが発生しても、Clientからの接続先はFIPであり、接続先サーバが変わったことを意識する必要はありません。

図 3.73 フローティングIPによるアクセス (2)¶

アドレスの割り当て

フローティングIP アドレスに割り当てるIP アドレスは、以下の条件を満たす必要があります。

クラスタサーバが所属する LAN と同じネットワークアドレス内でかつ使用していないホストアドレス

この条件内で必要な数 (一般的にはフェイルオーバグループ数分) の IP アドレスを確保してください。この IP アドレスは一般のホストアドレスと変わらないため、インターネットなどのグローバル IP アドレスから割り当てることも可能です。

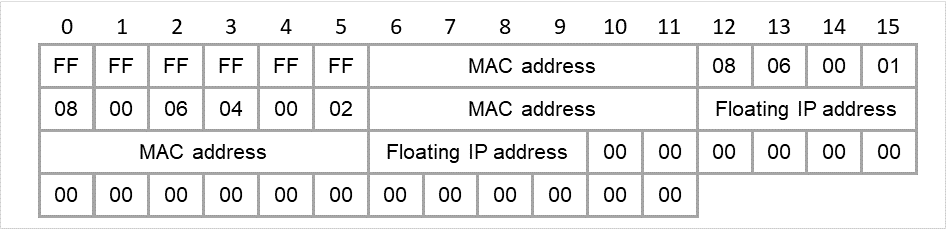

切替方式の仕組み

IPv4 の場合、FIP リソースが活性するサーバからの ARP ブロードキャストを送信することにより、ARP テーブル上の MAC アドレスが切り替わります。

IPv6 の場合、ARP ブロードキャストは送信しません。

以下はCLUSTERPRO が送信する ARP ブロードキャストパケットの内容です。

図 3.74 CLUSTERPRO が送信する ARP ブロードキャストパケット¶

経路制御

ルーティングテーブルの設定は不要です。

使用条件

以下のマシンからフローティング IP アドレスにアクセスできます。

クラスタサーバ自身

同一クラスタ内の他のサーバ、他のクラスタシステム内のサーバ

クラスタサーバと同一 LAN 内およびリモート LAN のクライアント

さらに以下の条件であれば上記以外のマシンからでもフローティング IP アドレスが使用できます。ただし、すべてのマシン、アーキテクチャの接続を保障できません。事前に充分に評価をしてください。

通信プロトコルが TCP/IP、もしくはSCTP/IP であること

ARP プロトコルをサポートしていること

スイッチング HUB により構成された LAN であっても、フローティング IP アドレスのメカニズムは問題なく動作します。

サーバダウン時には、接続していた TCP/IP コネクションは切断されます。

3.8.3. フローティング IP リソースに関する注意事項¶

フローティング IP リソースが活性しているサーバでネットワーク再起動を実行しないでください。ネットワークを再起動するとフローティング IP リソースが追加した IP アドレスが削除されます。

- [ifconfig] コマンドのタイムラグによる IP アドレス重複についてフローティング IP リソースで以下の設定の場合、リソースのフェイルオーバに失敗することがあります。

[活性リトライしきい値] に既定値より小さい値を設定している場合

[Ping リトライ回数]、[Ping インターバル] を設定していない場合

この現象は以下の原因で発生します。

フェイルオーバ元となるサーバでフローティング IP アドレスを非活性後、[ifconfig] コマンドの仕様により IP アドレスの解放に時間がかかることがある

フェイルオーバ先のサーバからフローティング IP アドレスに対する [ping] コマンドが到達すると、リソース活性異常となる(二重活性を防止するため)

この現象は以下の設定により回避できます。

リソースの [活性リトライしきい値] を大きくする (既定値 5 回)

[Ping リトライ回数]、[Ping インターバル] を大きくする

ClientはフローティングIP(FIP)によって Server 1へアクセスします。

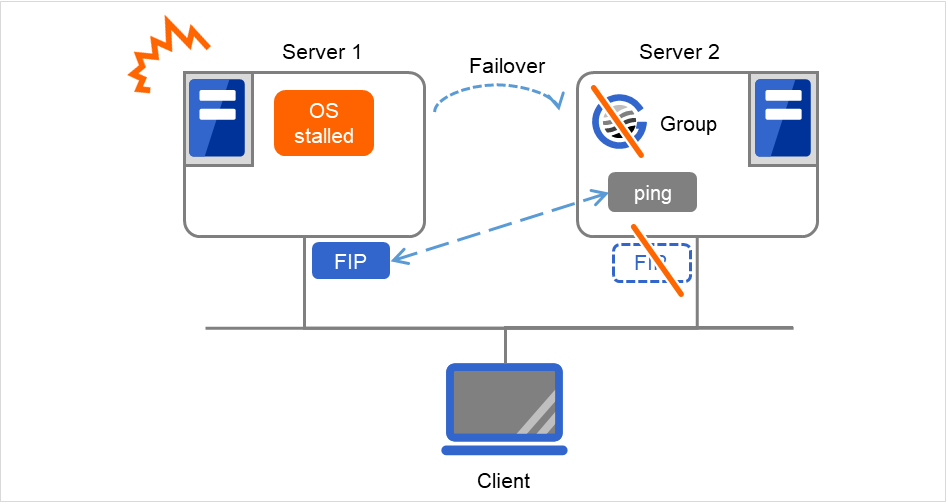

図 3.75 フローティングIP構成 (1)(通常時)¶

Server 1がダウンし、フェイルオーバが発生します。しかし、Server 1側でフローティングIPアドレス(FIP)の開放に時間がかかり、その間、Server 2から FIPへのpingが到達するため、FIPの重複と判断して、Server 2での活性は失敗します(ClientからFIPへのアクセス不可)。

図 3.76 フローティングIP構成 (2)(フェイルオーバ失敗)¶

- OS ストール時の IP アドレス重複についてフローティング IP アドレスを活性した状態で OS のストールが発生した場合、以下の設定の場合にリソースのフェイルオーバに失敗することがあります。

[Ping タイムアウト] に 0 以外を指定した場合

[FIP 強制活性] が OFF の場合

この現象は以下の原因で発生します。

フローティング IP アドレスを活性した状態で以下のような OS の部分的なストールが発生

ネットワークモジュールは動作し、他ノードからの ping に反応する状態

ユーザ空間モニタリソースでストール検出不可の状態

フェイルオーバ先のサーバでフローティング IP アドレスの活性時に、二重活性防止のために活性予定のフローティング IP アドレスに対して [ping] コマンドを実行すると、上記のために ping が到達し、リソース活性異常となる

この現象が多発するマシン環境では、以下の設定により回避できます。ただし、フェイルオーバ後、ストールの状況によってはグループの両系活性が発生することがあり、タイミングによってサーバシャットダウンが起こるので注意してください。両系活性の詳細は『メンテナンスガイド』の「保守情報」の「サーバダウンの発生条件」の「ネットワークパーティションからの復帰」を参照してください。

- [Ping タイムアウト] に 0 を設定するフローティング IP アドレスに対して重複確認を行いません。

- [FIP 強制活性] を On に設定するフローティング IP アドレスが他のサーバで使用されている場合でも、強制的にフローティング IP アドレスを活性します。

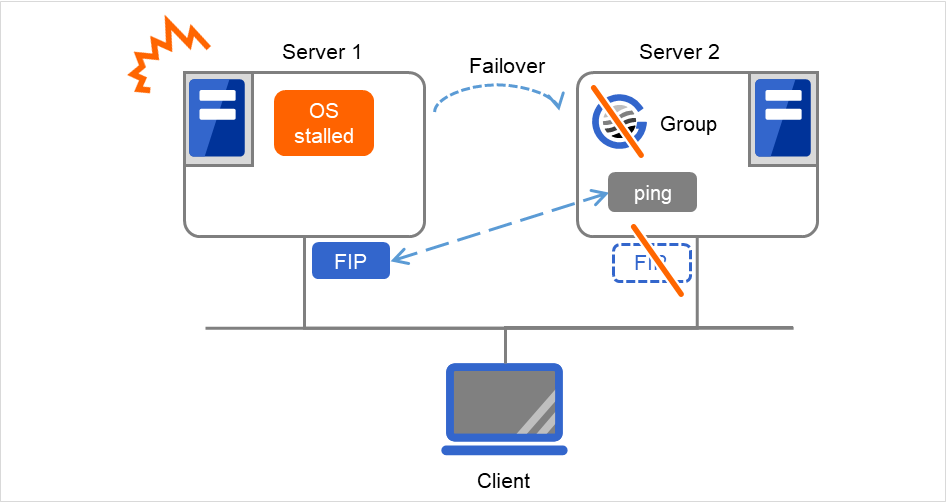

pingタイムアウトの設定が0以外かつFIP強制活性がOFFの場合

Server 1のOSがストールしたため、FIPが活性状態のままフェイルオーバが発生します。 しかしその直後は、Server 2でFIP活性前に実行したpingコマンドに対して応答が返ります。 そのため、二重活性が発生することのないよう、Server 2におけるFIP活性は失敗します。

図 3.77 pingタイムアウトの設定が0以外かつFIP強制活性がOFFの場合¶

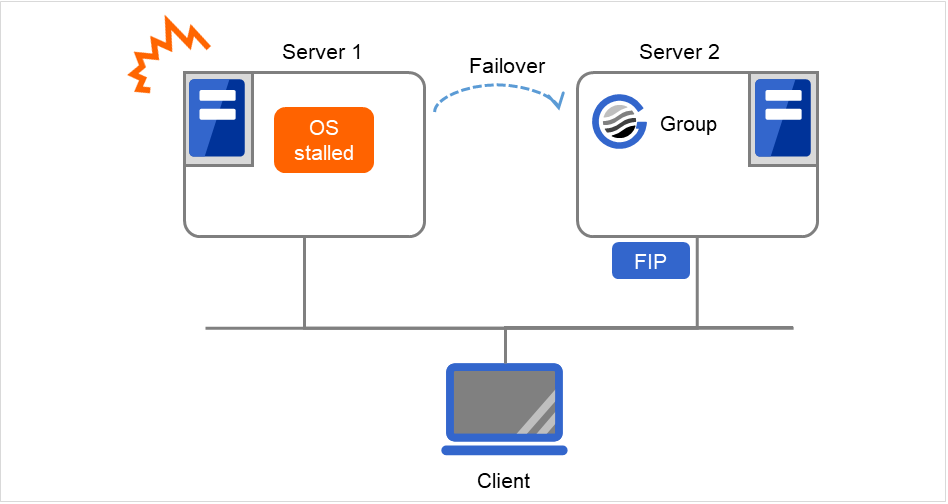

pingタイムアウトが0の場合

Server 1のOSがストールしたため、FIPが活性状態のままフェイルオーバが発生します。 Server 2ではFIPに対するpingコマンドを実行せず、Server 2におけるFIP活性は成功します。

図 3.78 pingタイムアウトが0の場合¶

pingタイムアウトの設定が0以外かつFIP強制活性がONの場合

Server 1のOSがストールしたため、FIPが活性状態のままフェイルオーバが発生します。 Server 2ではFIPに対するpingコマンドを実行しますが、その結果に関係なく、Server 2におけるFIP活性は強制的に成功します。

図 3.79 pingタイムアウトの設定が0以外かつFIP強制活性がONの場合¶

- フローティング IP が割り当てられる仮想 NIC の MAC アドレスについてフローティング IP が割り当てられる仮想 NIC の MAC アドレスは、実 NIC の MACアドレスとなります。そのため、フローティング IP リソースがフェイルオーバすると、対応する MAC アドレスが変更されます。

- リソース活性時の現用系サーバからの IP 通信のソースアドレスについてサーバからの IP 通信の送信元アドレスは、フローティング IP リソースが活性している場合でも基本的にサーバの実 IP となります。送信元アドレスをフローティング IP に変更したい場合はアプリケーション側で設定が必要です。

FIP強制活性をオンに設定した場合、フローティング IP アドレスを起動した後に同じネットワークセグメント上のマシンからフローティング IP アドレスに接続すると、先に存在していた IP アドレスのマシンに接続することがあります。

フローティング IP リソースは OpenVPN が起動している環境での動作に対応しておりません。

フローティング IP リソースでは、IPアドレスを付与する NIC 名(ネットワークインタフェース名、例:eth0)の長さは15文字が上限です。15文字を超える場合は、活性異常になります。その際は NIC 名(ネットワークインタフェース名)を見直してください。

フローティング IP リソースは活性する前に、重複した IP アドレスがないかチェックするために [ping] を発行しています。このため、重複 IP アドレスを保持するネットワーク機器がファイアウォールなどで ICMP の受信拒否を設定している場合は [ping] コマンドを使用した重複 IP アドレスの確認が行えないため、フローティングIPアドレスが重複することがあります。

3.8.4. フローティング IP リソース非活性待ち合わせ処理¶

フローティング IP アドレスの非活性化を実行した後に以下の処理を行います。

待ち合わせ処理

[ifconfig] コマンドもしくは API を実行し、OS に付加されている IP アドレスの一覧を取得します。[ifconfig] コマンドもしくは API のどちらを実行するかは、フローティング IP リソースが自動的に判定します。IP アドレスの一覧にフローティング IP アドレスが存在しなければ非活性と判断します。

IP アドレスの一覧にフローティング IP アドレスが存在する場合は、 1 秒間待ち合わせます。待ち合わせ時間は Cluster WebUI では変更できません。

上記の処理を最大 4 回繰り返します。この回数は Cluster WebUI で変更できません。

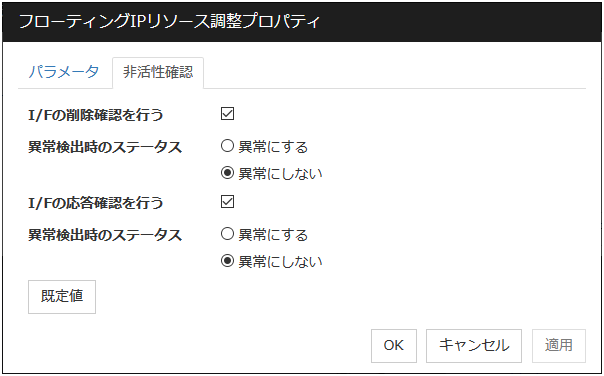

この結果が異常となった場合にフローティング IP リソースを非活性異常とするかしないかは、フローティング IP リソースの非活性確認タブの [I/F の削除確認を行う] の [異常検出時のステータス] で変更します。

[ping] コマンドによる非活性確認処理

[ping] コマンドを実行し、フローティング IP アドレスからの応答有無を確認します。フローティング IP アドレスから応答がなければ非活性と判断します。

フローティング IP アドレスから応答がある場合は、1 秒間待ち合わせます。待ち合わせ時間は Cluster WebUI では変更できません。

上記の処理を最大 4 回繰り返します。この回数は Cluster WebUI で変更できません。

[ping] コマンドはタイムアウト 1 秒で実行します。このタイムアウトは Cluster WebUI で変更できません。

この結果が異常となった場合にフローティング IP リソースを非活性異常とするかしないかは、フローティング IP リソースの非活性確認タブの [I/F の応答確認を行う] の [異常検出時のステータス] で変更します。

注釈

3.8.5. 詳細タブ¶

IPアドレス サーバ個別設定可能

使用するフローティング IP アドレスを入力します。bonding の設定を行った場合、環境によっては bonding のマスターインターフェースに設定したIPアドレスがスレーブインターフェースにも表示される場合があります。上記のような環境で bonding のマスターインターフェースにフローティングIPアドレスを設定する場合、IPアドレスの後ろに "%" で区切って bonding デバイスを指定してください。詳しくは本ガイドの「7. その他の設定情報」の「bonding」を参照してください。

bonding を設定する場合の例 : 10.0.0.12%bond0

フローティング IP リソースは、既定値ではマスクビット数を IPv4の場合は24bit、IPv6の場合は128bit として、ローカルコンピュータ上のサブネットマスクが一致するアドレスを検索し、該当するネットワークインタフェースにエイリアスを付与してフローティング IP アドレスを追加します。

マスクビット数を明示的に指定する場合は、アドレスの後、[/マスクビット数] を指定します。(IPv6アドレスの場合は必ず[/マスクビット数]を指定してください)

例) 10.0.0.12/8、 fe80::1/8

ネットワークインタフェースを明示的に指定する場合、アドレスの後、[%インタフェース名] を指定します。

例) 10.0.0.12%eth1、fe80::1/8%eth1

上記の例ではネットワークインタフェースeth1 にマスクビット数8のフローティング IP アドレスを追加します。

tagVLAN を設定するときは "%" で区切って tagVLAN の I/F 名を指定してください。

tagVLAN を設定する場合の例 : 10.0.0.12%eth0.1

IPv6アドレスかつ[ifconfig] コマンドが利用可能な環境の場合、大文字と小文字を区別して判定するため、ifconfig コマンドの出力書式とフローティング IP の IP アドレスの書式を一致させてください。

調整

[フローティング IP リソース調整プロパティ] ダイアログボックスを表示します。フローティングIP リソースの詳細設定を行います。

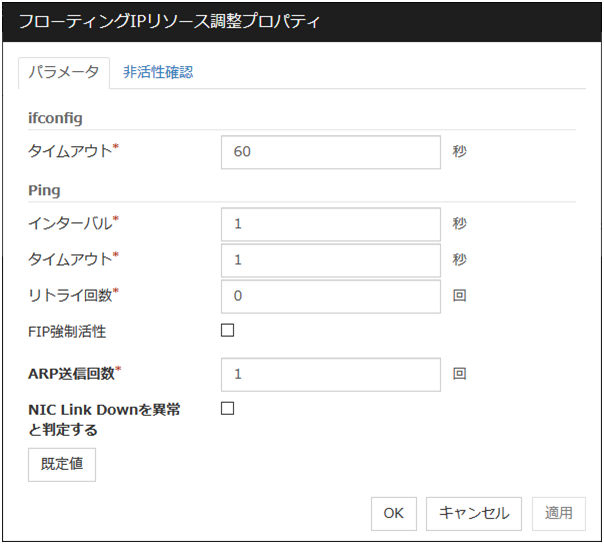

フローティング IP リソース調整プロパティ

パラメータタブ

フローティング IP リソースのパラメータに関する詳細設定が表示されます。

ifconfig

IP アドレス一覧の取得、および [ifconfig] コマンドによるフローティング IP リソースの活性/非活性の各処理で実行される [ifconfig] コマンドに関する詳細設定です。

ping

フローティング IP リソースを活性する前に、重複した IP アドレスがないかチェックするために発行される [ping] コマンドに関する詳細設定です。

ARP 送信回数 (0~999)

フローティング IP リソースを活性化する場合に送信する ARP パケットの送信回数を設定します。0 を設定すると ARP パケットを送信しません。

NIC Link Down を異常と判定する

フローティング IP リソースを活性する前に、NIC Link Downの確認を行うかどうかを設定します。NIC のボード、ドライバによっては、必要な ioctl( ) がサポートされていない場合があります。NIC の Link Up/Down 監視の動作可否は、各ディストリビュータが提供する [ethtool]コマンドで確認することができます。[ethtool]コマンドでの確認方法は、本ガイドの「NIC Link Up/Down モニタリソースを理解する」 - 「NIC Link Up/Down モニタリソースの注意事項」を参照してください。

bonding デバイスの場合、活性時に bonding を構成するすべての NIC が Link Down 状態であれば異常と判定します。

既定値

[既定値] をクリックすると全ての項目に既定値が設定されます。

非活性確認タブ

フローティング IP リソースの非活性確認に関する詳細設定が表示されます。

I/F の削除確認

I/F の応答確認

3.9. 仮想 IP リソースを理解する¶

3.9.1. 仮想 IP リソースの依存関係¶

既定値では、依存するグループリソースタイプはありません。

3.9.2. 仮想 IP とは?¶

クライアントアプリケーションは、仮想 IP アドレスを使用してクラスタサーバに接続することができます。また、サーバ間でも仮想 IP アドレスを使用しての接続が可能です。仮想 IP アドレスを使用することにより、フェイルオーバ/フェイルオーバグループの移動が発生しても、クライアントは、接続先サーバの切り替えを意識する必要がありません。

IP アドレス一覧の取得、および仮想 IP リソースの活性/非活性の各処理では[ifconfig] コマンドもしくは API を実行します。[ifconfig] コマンドもしくは API のどちらを実行するかは、仮想 IP リソースが自動的に判定します。以下に例を示します。

RHEL 7 以降(RHEL 7 互換OS含む)のように[ifconfig] コマンドが利用できない環境の場合:API を実行。

RHEL 7 以降(RHEL 7 互換OS含む)にてnet-toolsパッケージにより[ifconfig] コマンドが利用可能な環境の場合:API を実行。これは[ifconfig] コマンドの出力形式が RHEL 6 以前と互換性がないためです。

RHEL 6 のように[ifconfig] コマンドが利用可能な環境の場合:[ifconfig] コマンドを実行。

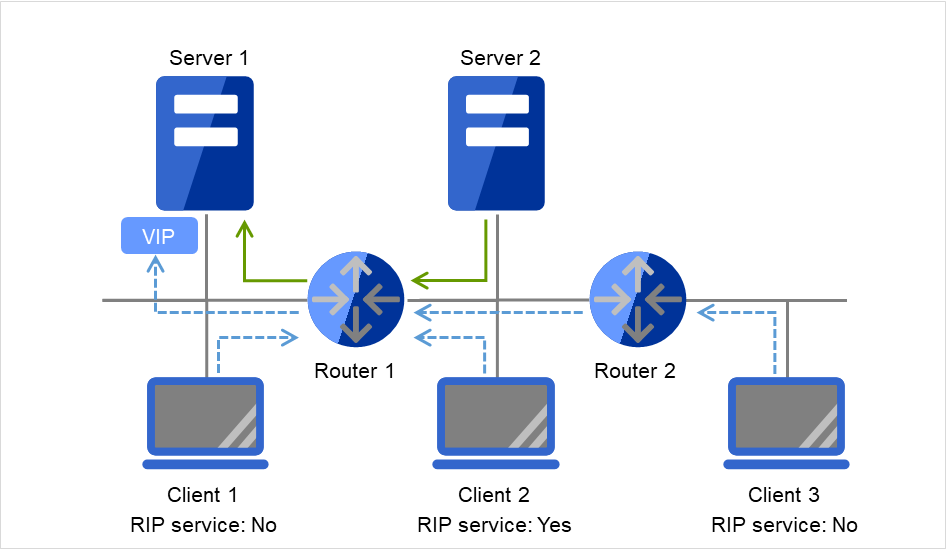

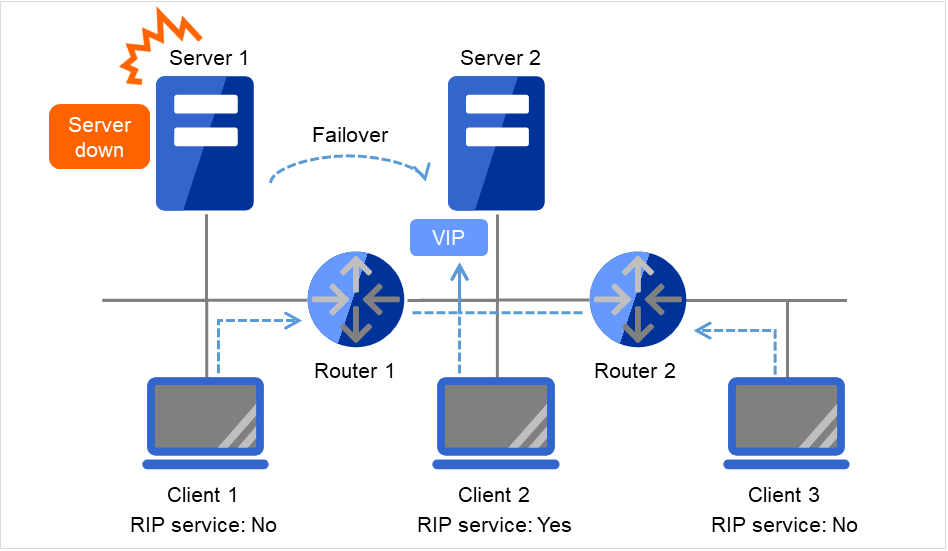

図 3.80 仮想IPを使用した構成 (1)¶

図 3.81 仮想IPを使用した構成 (2)¶

- サーバの設定事項1同一LAN内のクラスタサーバは、RIPパケットを受け取ることにより経路変更が可能か、またはルータにアクセスすることにより仮想IPアドレスの経路情報を解決できる必要があります。

- サーバの設定事項2別セグメントのクラスタサーバは、ルータにアクセスすることにより仮想IPアドレスの経路情報を解決できる必要があります。

- 仮想IPリソースの設定事項1クラスタサーバが所属するLANの、ネットワークアドレスの範囲外であり、既存のIPアドレスと衝突しないIPアドレスを設定してください。

- ルータの設定事項1各ルータは、RIPパケットを解釈して動的経路の制御が行えるか、または仮想IPアドレスの経路に関する情報が静的経路情報として解決できる必要があります。

- 仮想IPリソースの設定事項2RIPパケットを正しく送信するため、送信元IPアドレスは必ずサーバごとに設定してください。

- ルータの設定事項2各ルータのフラッシュタイマーは、ハートビートタイムアウト以内に設定してください。

- クライアントの設定事項1同一LAN内のクライアントは、RIPパケットを受け取ることにより経路変更が可能か、または ルータにアクセスすることにより仮想IPアドレスの経路情報を解決できる必要があります。

- クライアントの設定事項2別セグメントのクライアントマシンは、ルータにアクセスすることにより仮想IPアドレスの経路情報を解決できる必要があります。

3.9.3. 仮想 IP アドレスの検討¶

仮想 IP アドレスに割り当てる IP アドレスは、以下の条件を満たす必要があります。

クラスタサーバが所属する LAN の、ネットワークアドレスの範囲外である

既存のネットワークアドレスと衝突しない

この 2 つの条件を満たすために、以下の 2 つの割り当て方法で、いずれかを選択してください。

仮想 IP アドレス用に新たに正当なネットワーク IP アドレスを取得し、そこから仮想 IP アドレスを割り当てる。

プライベート IP アドレス空間から、適当なネットワーク IP アドレスを決定し、そこからそれぞれの仮想 IP アドレスを割り当てます。具体例を示すと、以下のような手順になります。

ネットワークアドレス 192.168.0~192.168.255 から、仮想 IP アドレス用に 1 つ選択します。

上記で選択したネットワークアドレスの中から、仮想 IP アドレス用のホスト IP アドレスを 64 個以内で割り当てます。(例えば、ネットワークアドレス 192.168.10 を 選択し、その中からホスト IP アドレスを 192.168.10.1 と 192.168.10.254 の 2 個を割り当てる。)

仮想 IP アドレスのネットマスクは、255.255.255.0 に設定します。

複数の仮想 IP リソースを設定する場合には、ダミー用の仮想 IP アドレスが必要になる場合があります。詳しくは、「仮想 IP リソースを使用する場合の事前準備」を参照してください。

さらに以下の点に注意が必要です。

プライベート IP アドレスは、組織内で閉じたネットワークのためのアドレスであるため、インターネットプロバイダ等を隔てた組織外から、仮想 IP アドレスを用いてアクセスはできません。

プライベート IP アドレスに関する経路情報を、組織外に流してはいけません。

プライベート IP アドレスの衝突が起こらないよう、組織内での調整が必要です。

3.9.4. 仮想 IP リソースを使用する場合の事前準備¶

クラスタ構成が以下の条件に該当する場合、各サーバに仮想 IP アドレスと同じネットワークアドレスのダミーの仮想 IP アドレスを設定する必要があります。

複数の仮想 IP リソースが存在する

ネットワークアドレスと NIC エイリアス名が同じリソースが存在する

注釈

ダミーの仮想 IP アドレスが設定できない場合、任意の仮想 IP リソースの非活性時に同じ NIC エイリアスに付与されている他の仮想 IP アドレスも OS より削除される場合があります。

ダミーの仮想 IP アドレスは、以下の条件を満たす必要があります。

仮想 IP リソースの IP アドレスと同じネットワークアドレスで、固有の IP アドレスである

クラスタを構成する各サーバ用にダミーの仮想 IP アドレスを用意できる

NIC エイリアス毎に用意する

以下の設定例の場合、各サーバにダミーの仮想 IP アドレスの設定が必要です。

- 仮想 IP リソース 1IP アドレス 10.0.1.11/24NIC エイリアス名 eth1

- 仮想 IP リソース 2IP アドレス 10.0.1.12/24NIC エイリアス名 eth1

例としてダミーの仮想 IP アドレスを以下のように設定します。

- Server 1 のダミー仮想 IP アドレスIP アドレス 10.0.1.100/24NIC エイリアス名 eth1:0

- Server 2 のダミー仮想 IP アドレスIP アドレス 10.0.1.101/24NIC エイリアス名 eth1:0

ダミーの仮想 IP アドレスが OS 起動時に有効になるように以下の手順で OS へ設定してください。

以下の手順はServer 1 の eth1 に 10.0.1.100/24 を設定する例です。

ディストリビューションごとに下記の設定を行います。

- SUSE LINUX Enterprise Server の場合下記のパスのファイルを編集し、設定内容の斜体部分を追加します。

パス

/etc/sysconfig/network/ifcfg-eth1-"eth1のMACアドレス"

設定内容

BOOTPROTO='static' BROADCAST='10.0.0.255' IPADDR='10.0.0.1' MTU='' NETMASK='255.255.255.0' NETWORK='10.0.0.0' IPADDR_1='10.0.1.100' NETMASK_1='255.255.255.0' NETWORK_1='10.0.1.0' LABEL_1=1 REMOTE_IPADDR='' STARTMODE='onboot' UNIQUE='xxxx' _nm_name='xxxx'

- SUSE LINUX Enterprise Server 以外の場合下記のパスのファイルを作成し、設定内容を追加します。

パス

/etc/sysconfig/network-scripts/ifcfg-eth1:0

設定内容

DEVICE=eth1:0 BOOTPROTO=static BROADCAST=10.0.1.255 HWADDR=eth1のMACアドレス IPADDR=10.0.1.100 NETMASK_1='255.255.255.0' NETWORK=10.0.1.0 ONBOOT=yes TYPE=Ethernet

OS を再起動します。

OS 再起動後にダミーの仮想 IP アドレスが有効になります。Server 2 も同様に設定してください。

クラスタの構成変更で上記の設定が必要になった場合は、以下の手順で行ってください。

クラスタを停止します。手順は『インストール&設定ガイド』の「運用開始前の準備を行う」 - 「CLUSTERPRO を一時停止する」 - 「CLUSTERPROデーモンの停止」を参照してください。

クラスタデーモンを無効にします。手順は『インストール&設定ガイド』の「運用開始前の準備を行う」 - 「CLUSTERPRO を一時停止する」 - 「CLUSTERPRO デーモンの無効化」を参照してください。

上記の設定を変更します。

OS を再起動して、設定が反映されていることを確認します。

クラスタデーモンを有効にします。手順は『インストール&設定ガイド』の「運用開始前の準備を行う」 - 「CLUSTERPRO を一時停止する」 - 「無効化したCLUSTERPROデーモンを有効にする」を参照してください。

クラスタの構成を変更します。手順は『インストール&設定ガイド』の「クラスタ構成情報を変更する」を参照してください。

3.9.5. 経路制御¶

リモート LAN から仮想 IP アドレスにアクセスするために、リモート LAN とクラスタサーバの LAN まで経路上の全てのルータに、仮想 IP アドレスの経路情報が有効になっていなければなりません。

具体的には、以下のような設定が必要です。

クラスタサーバの LAN 上のルータがホスト RIP を解釈する。

クラスタサーバからリモートサーバまでの経路上のルータが、全て動的経路制御であるか、または仮想 IP アドレスの経路に関する情報が、静的経路情報として設定されている。

3.9.6. 仮想 IP アドレスの使用条件¶

仮想 IP アドレスが使用できる環境

以下のマシンからは仮想 IP アドレスに正しくアクセスできます。スイッチングハブが使われたLAN であっても、仮想 IP アドレスメカニズムは問題なく動作します。

ただし、サーバダウン時には、接続していた TCP/IP コネクションは切断されます。

ホスト形式の RIP を受信してホスト形式のルーティングテーブルを作成するように設定できないスイッチング HUB で仮想 IP アドレスを使用する場合は、ネットワークアドレスを新たに1 つ確保して、それぞれのサーバの仮想 IP アドレスが別々のネットワークアドレスに所属するように仮想 IP アドレスを設定する必要があります。

仮想 IP が活性するサーバと同一 LAN にあるクラスタサーバ

以下の条件を満たすものであれば、仮想 IP アドレスが使用できます。

RIP パケットを受け取ることにより経路変更が可能なマシン

ルータにアクセスすることにより仮想 IP アドレスの経路情報を解決できるマシン

仮想 IP が活性するサーバと異なる LAN にあるクラスタサーバ

以下の条件を満たすものであれば、仮想 IP アドレスが使用できます。

ルータにアクセスすることにより仮想 IP アドレスの経路情報を解決できるマシン

クラスタサーバと同一 LAN に属するクライアント

以下の条件を満たすものであれば、仮想 IP アドレスが使用できます。

RIP パケットを受け取ることにより経路変更が可能なマシン

ルータにアクセスすることにより仮想 IP アドレスの経路情報を解決できるマシン

リモート LAN 上のクライアント

以下の条件を満たすものであれば、仮想 IP アドレスが使用できます。

ルータにアクセスすることにより仮想 IP アドレスの経路情報を解決できるマシン

3.9.7. 仮想 IP リソースに関する注意事項¶

仮想 IP リソースが活性しているサーバでネットワーク再起動を実行しないでください。ネットワークを再起動すると仮想 IP リソースが追加した IP アドレスが削除されます。

仮想 IP アドレスには、以下の規則があります。

- 仮想 IP リソースが正常に非活性されない場合 (サーバダウン時など)、仮想 IP リソースの経路情報が削除されません。経路情報が削除されない状態で仮想 IP リソースが活性した場合、ルータまたはルーティングデーモンが経路情報をリセットするまで仮想 IPアドレスにアクセスできません。

仮想 IP が割り当てられる仮想 NIC の MAC アドレスについて

仮想 IP が割り当てられる仮想 NIC の MAC アドレスは、実 NIC の MAC アドレスとなります。そのため、仮想 IP リソースがフェイルオーバすると、対応する MAC アドレスが変更されます。

リソース活性時の現用系サーバからの IP 通信のソースアドレスについて

サーバからの IP 通信の送信元アドレスは、仮想 IP リソースが活性している場合でも基本的にサーバの実 IP となります。送信元アドレスを仮想 IP に変更したい場合はアプリケーション側で設定が必要です。

使用するルーティングプロトコルについて

使用するルーティングプロトコルを「RIPver2」に設定した場合、送出するRIPパケット内のサブネットマスクは「255.255.255.255」となります。

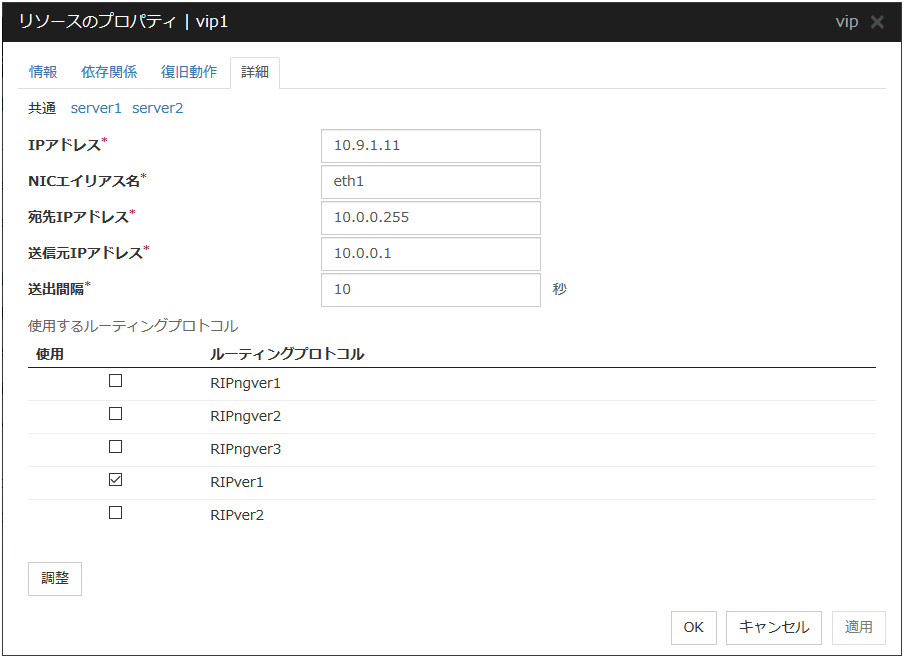

3.9.8. 詳細タブ¶

IPアドレス サーバ個別設定可能

使用する仮想 IP アドレスを入力します。マスクビット数を明示的に指定する場合は、アドレスの後、[/マスクビット数] を指定します。(IPv6アドレスの場合は必ず[/マスクビット数]を指定してください)

NICエイリアス名 サーバ個別設定可能

使用する仮想 IP アドレスを活性する NIC インタフェース名を入力します。

宛先IPアドレス サーバ個別設定可能

RIP パケットの送出先 IP アドレスを入力します。IPv4 はブロードキャストアドレス、IPv6 はルータの IPv6 アドレスを指定します。

送信元IPアドレス サーバ個別設定可能

RIP パケット送出時にバインドする IP アドレスを入力します。仮想 IP アドレスを活性するNIC で活性している実 IP アドレスを指定します。

IPv6アドレスを使用する場合は、送信元IPアドレスとしてリンクローカルアドレスを指定します。

注釈

送信元 IP アドレスは必ずサーバ個別設定を行い、各サーバの実 IP アドレスを設定してください。送信元アドレスが不正な場合、仮想 IP リソースは正常に動作しません。[共通]タブでは、任意のサーバの送信元 IP アドレスを記載し、他のサーバは個別設定を行うようにしてください。

送出間隔 (1~30) サーバ個別設定可能

RIP パケットの送出間隔を入力します。

使用するルーティングプロトコル サーバ個別設定可能

使用する RIP バージョンを入力します。IPv4 環境では RIPver1、RIPver2 から選択します。IPv6 環境では RIPngver1、RIPngver2、RIPngver3 から選択します。複数のルーティングプロトコルを選択することも可能です。

調整

[仮想 IP リソース調整プロパティ] ダイアログボックスを表示します。仮想 IP リソースの詳細設定を行います。

仮想 IP リソース調整プロパティ

パラメータタブ

仮想 IP リソースのパラメータに関する詳細設定が表示されます。

ifconfig

IP アドレス一覧の取得、および仮想 IP リソースの活性/非活性の各処理で実行される [ifconfig] コマンドに関する詳細設定です。

ping

仮想 IP リソースを活性する前に、重複した IP アドレスがないかチェックするために発行される [ping] コマンドに関する詳細設定です。

ARP送信回数 (0~999)

仮想 IP リソースを活性化する場合に送信する ARP パケットの送信回数を設定します。 0 を設定すると ARP パケットを送信しません。

NIC Link Down を異常と判定する

仮想 IP リソースを活性する前に、NIC Link Downの確認を行うかどうかを設定します。NIC のボード、ドライバによっては、必要な ioctl( ) がサポートされていない場合があります。NIC の Link Up/Down 監視の動作可否は、各ディストリビュータが提供する [ethtool]コマンドで確認することができます。[ethtool]コマンドでの確認方法は、本書の「NIC Link Up/Down モニタリソースを理解する」 - 「NIC Link Up/Down モニタリソースの注意事項」を参照してください。

既定値

[既定値] をクリックすると全ての項目に既定値が設定されます。

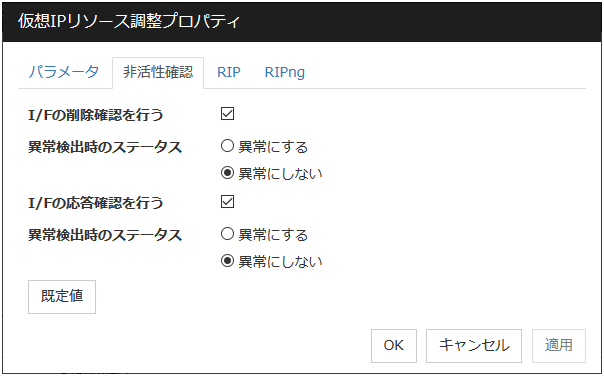

非活性確認タブ

仮想 IP リソースの非活性確認に関する詳細設定が表示されます。

I/F の削除確認

I/F の応答確認

RIPタブ

仮想 IP リソースの RIP に関する詳細設定が表示されます。

ネクストホップ IP アドレス

RIP の次ホップアドレス (次ルータのアドレス) を入力します。ネクストホップ IP アドレスは省略可能で RIPver2 の場合のみ指定することが可能です。ネットマスクまたは prefix の指定はできません。

メトリック (1~15)

RIP のメトリック値を入力します。メトリックは宛先に到達するための RIP のホップカウントです。

ポート

[ポート番号] には RIP の送信に使用する通信ポートの一覧が表示されます。

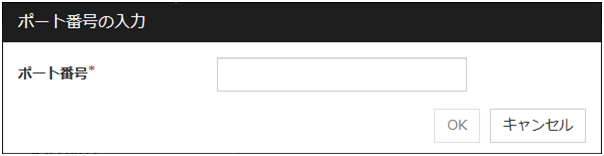

追加

RIP の送信に使用するポート番号を追加します。[ポート番号の入力] ダイアログボックスが表示されます。

ポート番号

RIP の送信に使用するポート番号を入力して [OK] を選択してください。

編集

[ポート番号の入力] ダイアログボックスが表示されます。[ポート番号] で選択しているポートが表示されるので、編集して [OK] を選択します。

削除

[ポート番号] で選択しているポートをリストから削除します。

RIPngタブ

仮想 IP リソースの RIPng に関する詳細設定が表示されます。

メトリック (1~15)

RIPng のメトリック値を入力します。メトリックは宛先に到達するための RIPng のホップカウントです。

ポート

[ポート番号] には RIPng を送信するポート番号の一覧が表示されます。

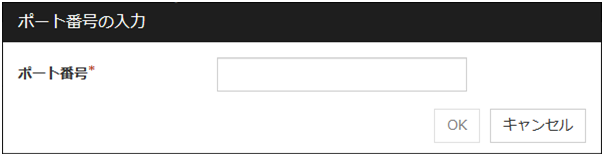

追加

RIPng の送信に使用するポート番号を追加します。[ポート番号の入力] ダイアログボックスが表示されます。

ポート番号

RIPng の送信に使用するポート番号を入力して [OK] を選択してください。

編集

[ポート番号の入力] ダイアログボックスが表示されます。[ポート番号] で選択しているポートが表示されるので、編集して [OK] を選択します。

削除

[ポート番号] で選択しているポートをリストから削除します。

3.10. ミラーディスクリソースを理解する¶

3.10.1. ミラーディスクリソースの依存関係¶

既定値では、以下のグループリソースタイプに依存します。

グループリソースタイプ |

|---|

フローティング IP リソース |

仮想 IP リソース |

AWS Elastic IPリソース |

AWS 仮想IPリソース |

AWS DNS リソース |

Azure プローブポートリソース |

Azure DNS リソース |

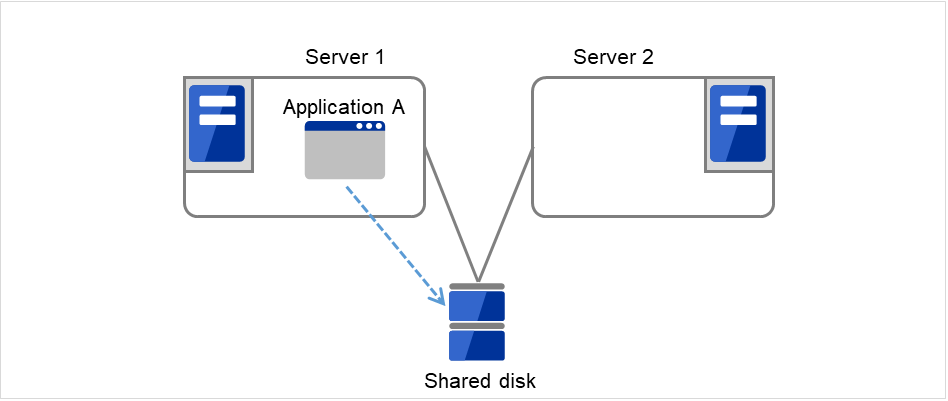

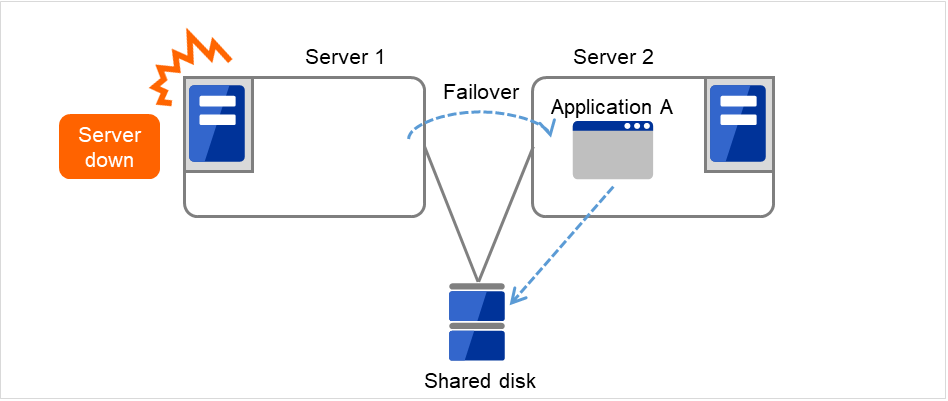

3.10.2. ミラーディスクとは?¶

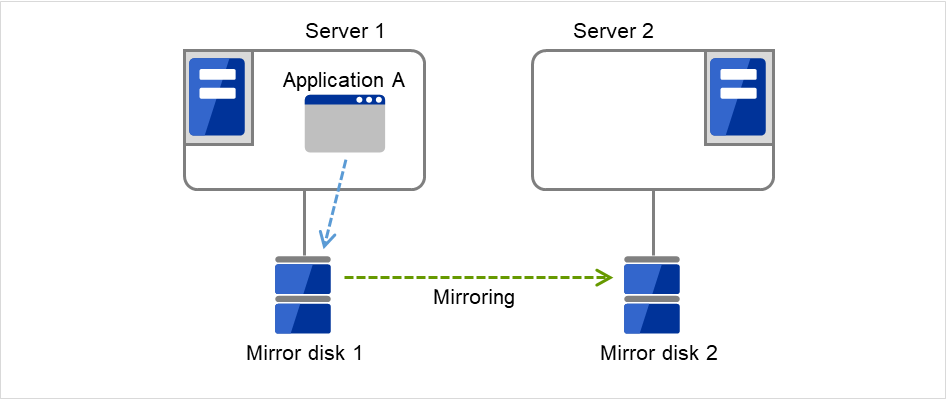

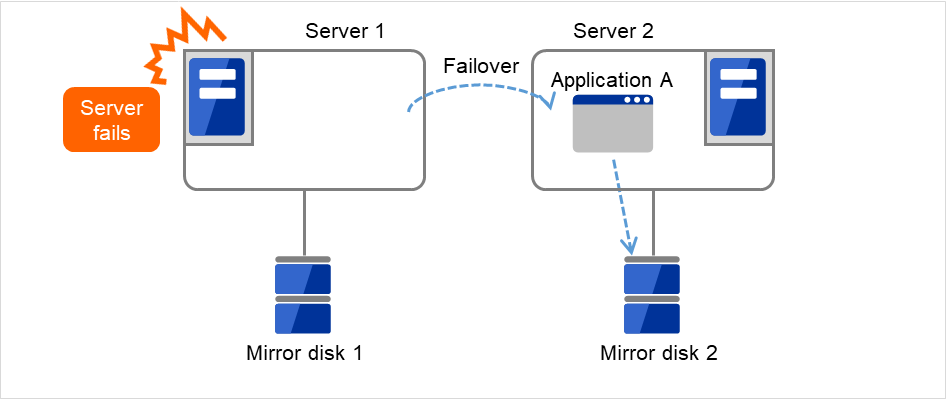

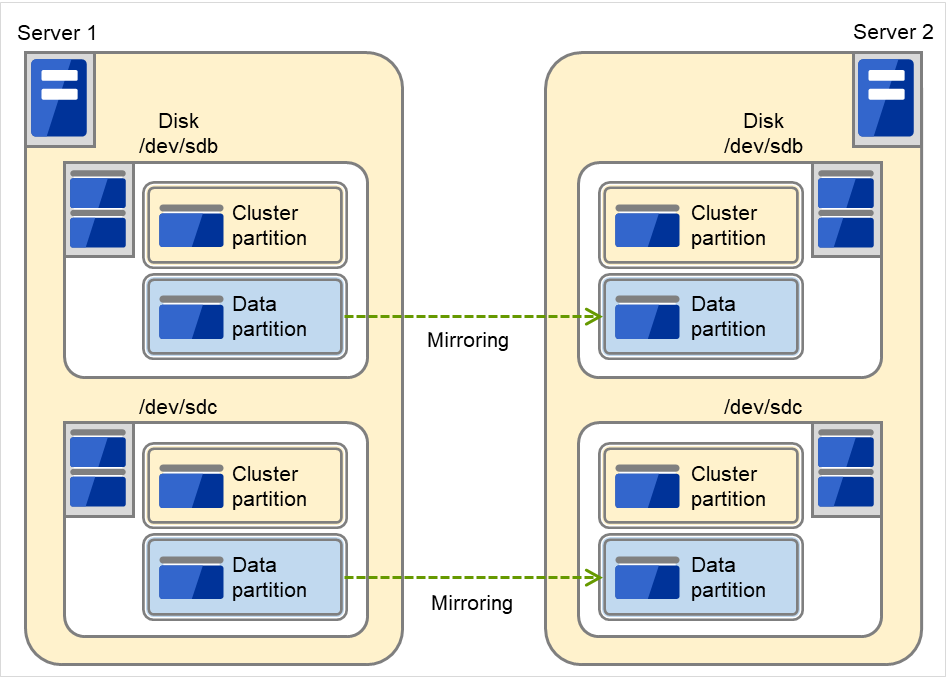

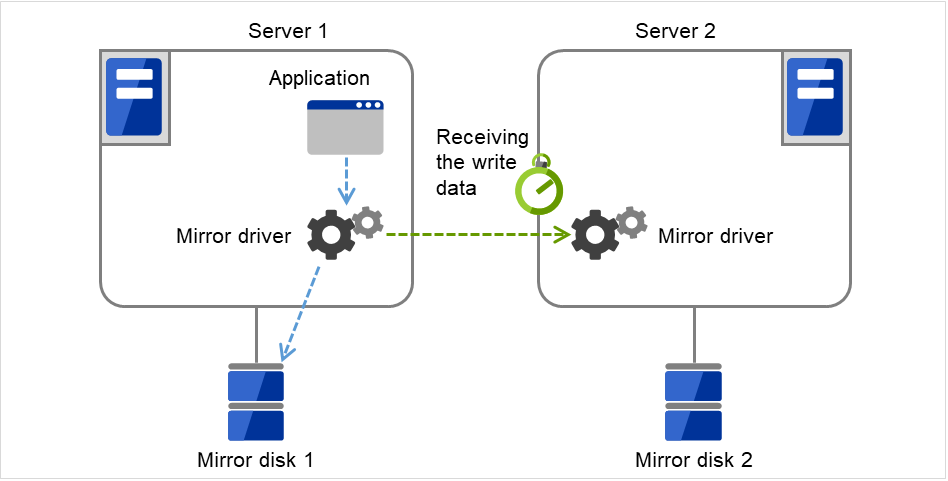

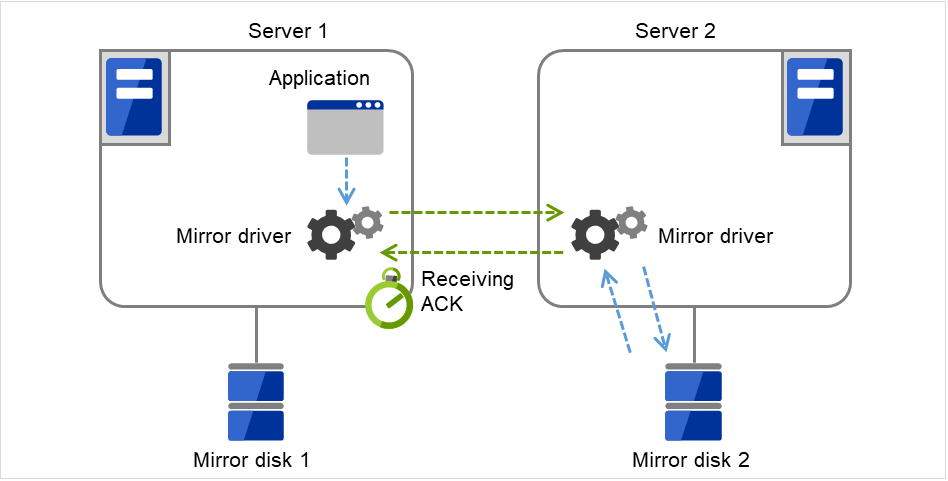

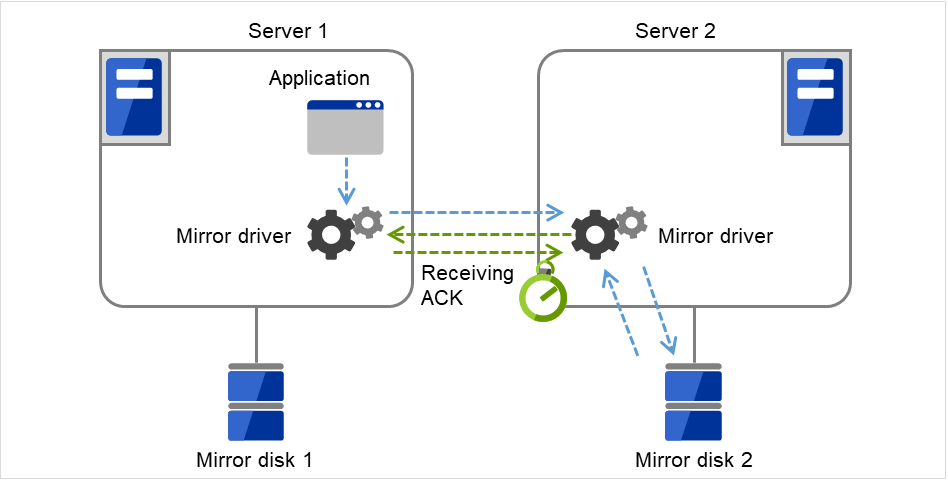

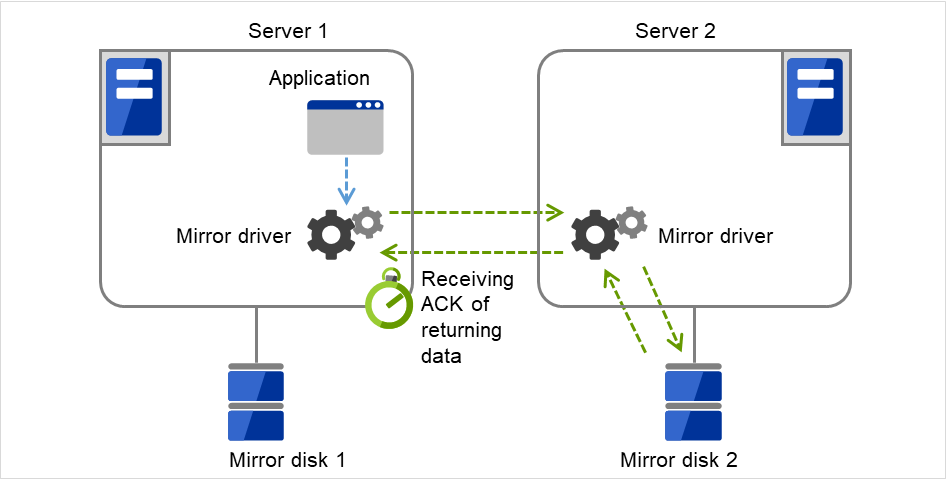

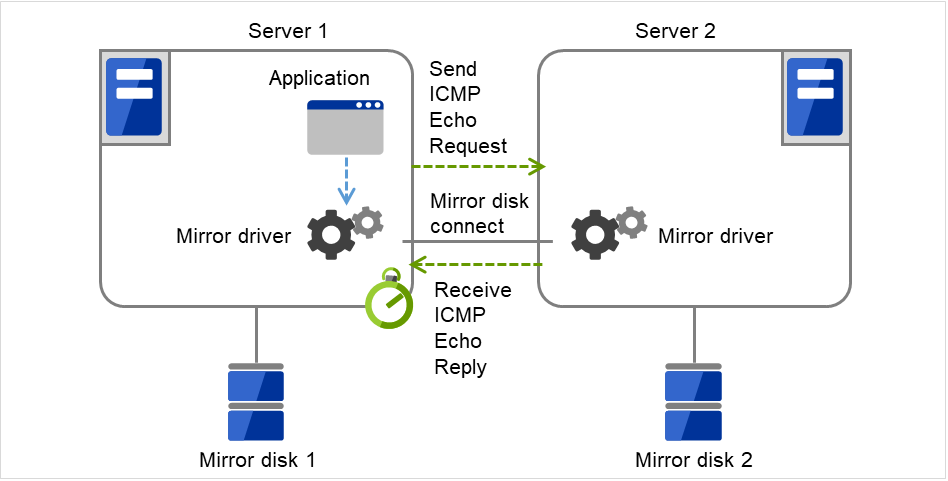

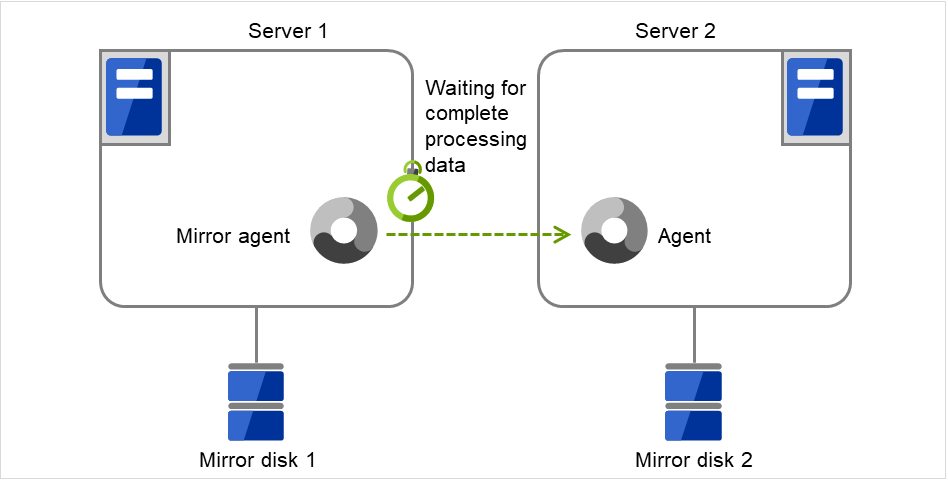

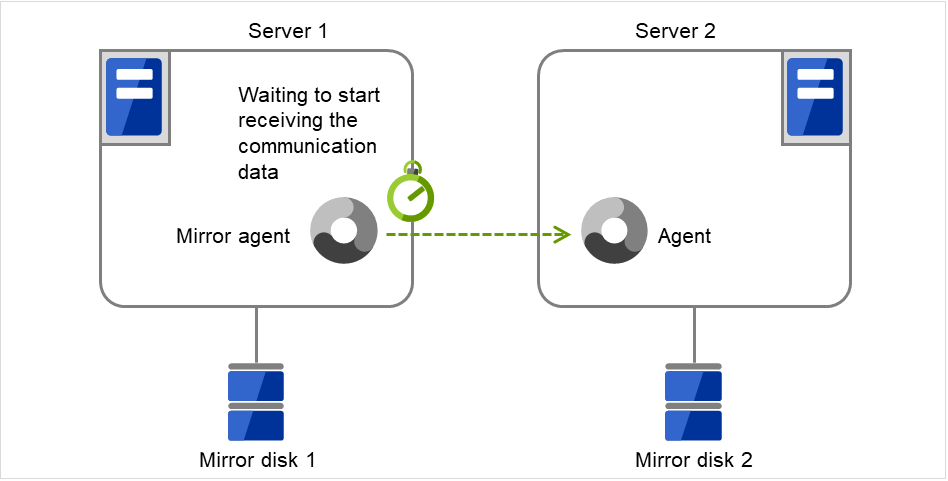

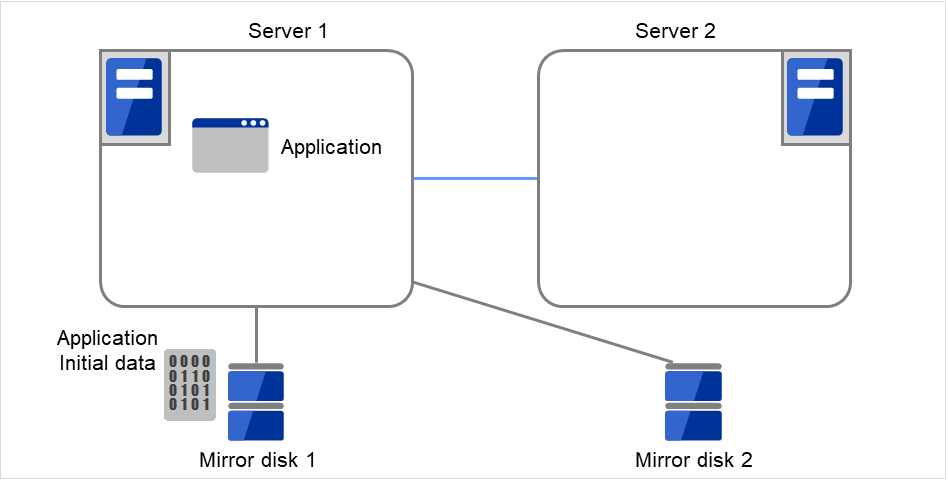

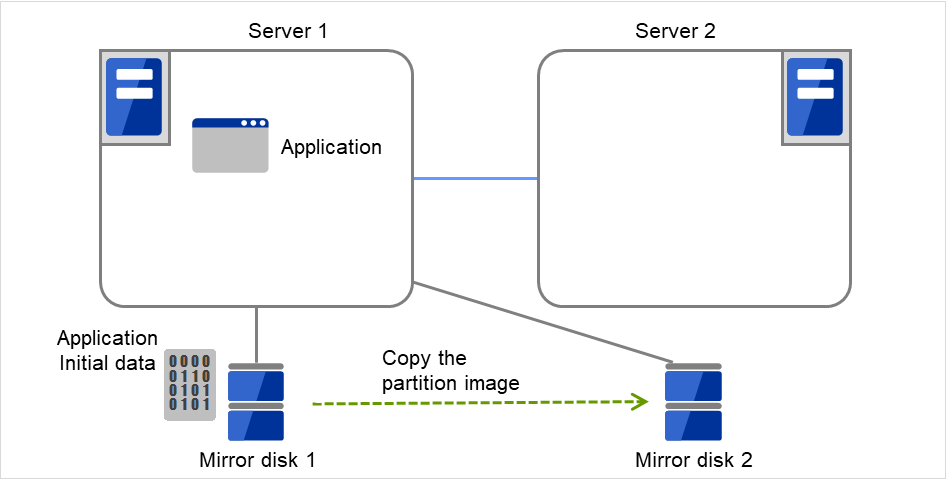

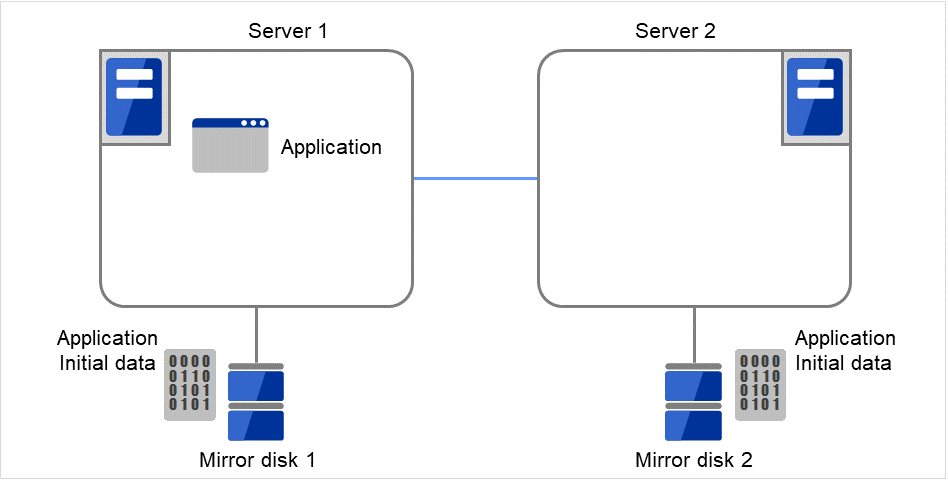

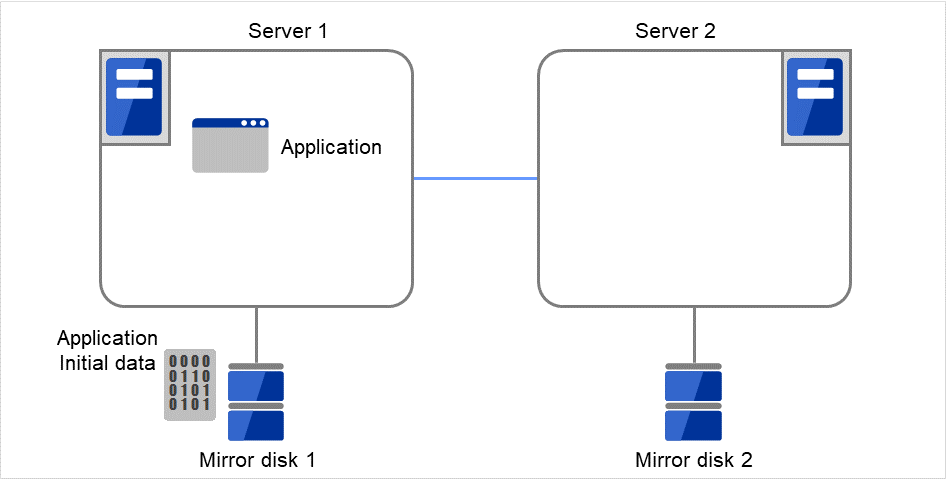

ミラーディスクとは、クラスタを構成する 2 台のサーバ間でディスクデータのミラーリングを行うディスクのペアのことです。

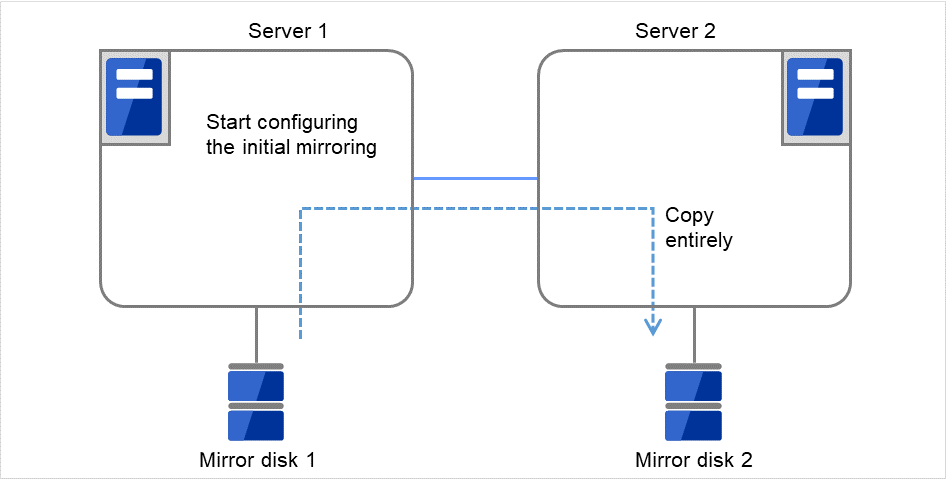

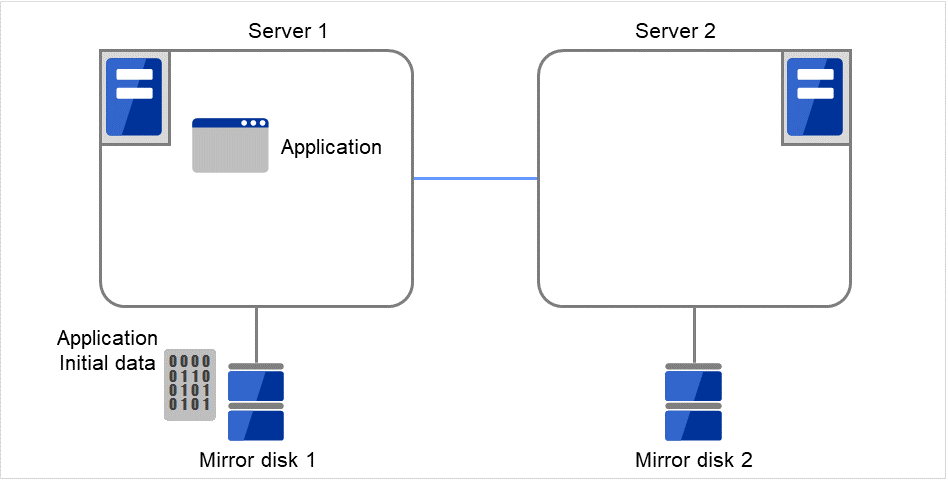

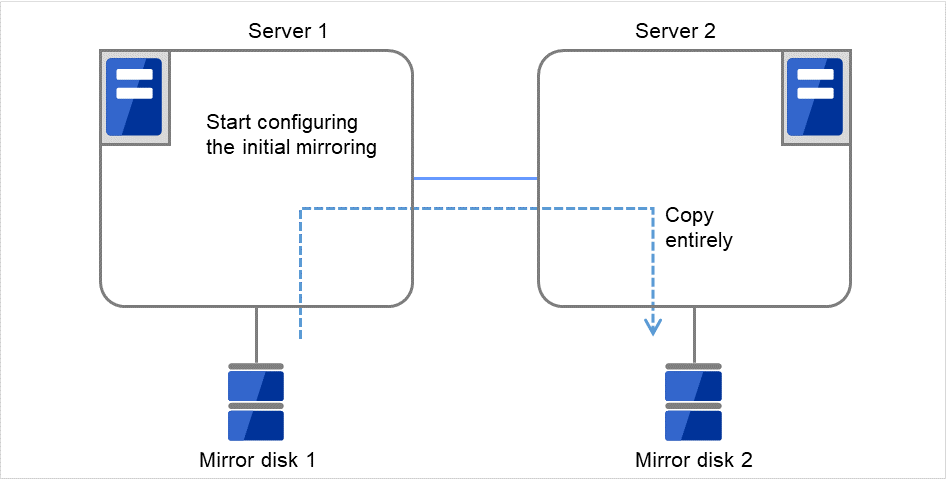

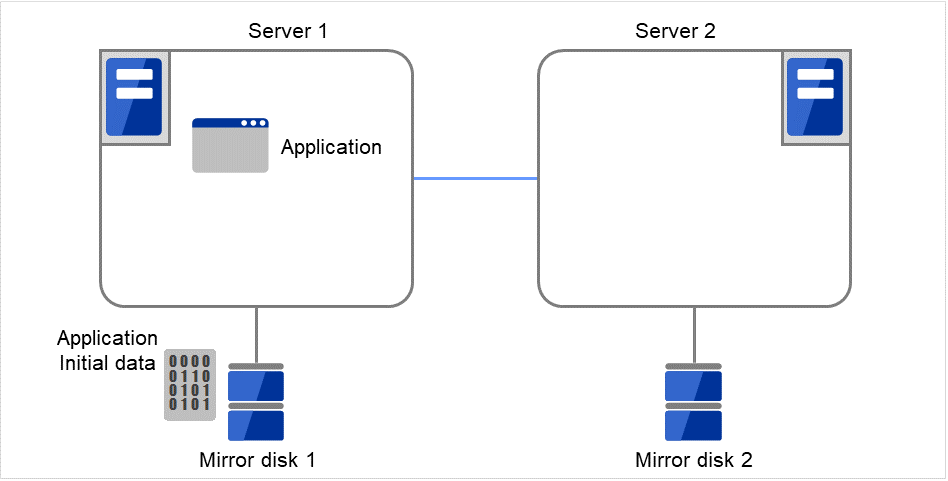

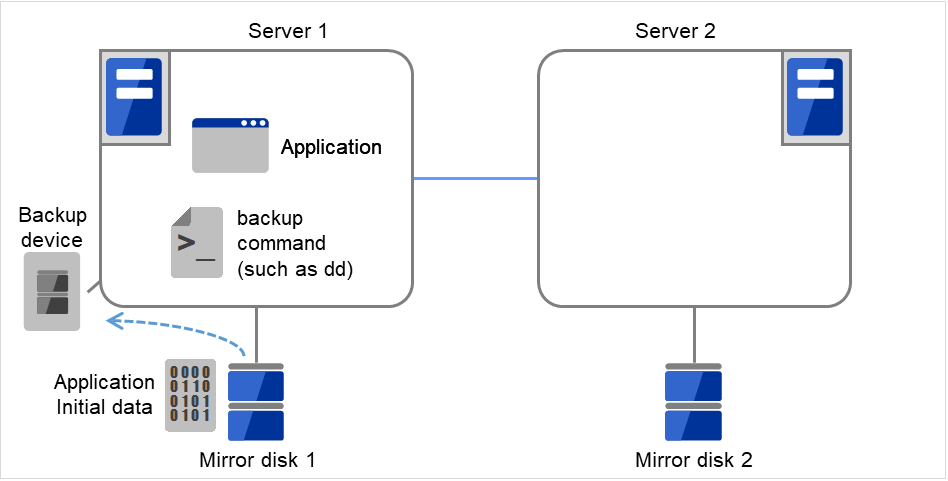

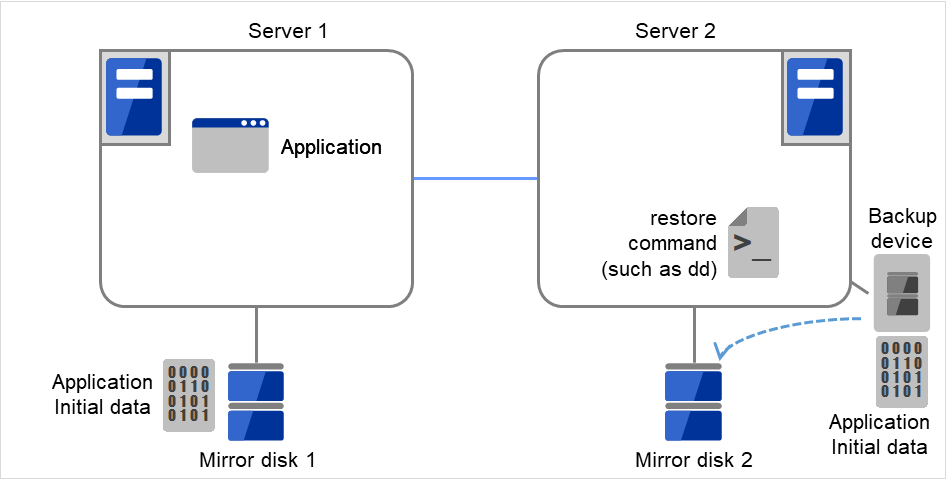

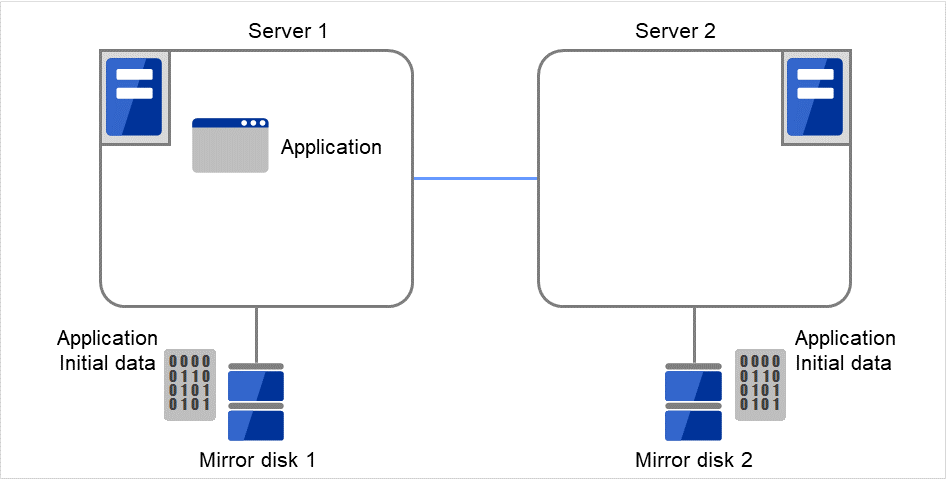

以下の図で、Server 1に接続されている Mirror disk 1 および Server 2に接続されている Mirror disk 2は、ペアとしてディスクデータのミラーリングを行います。

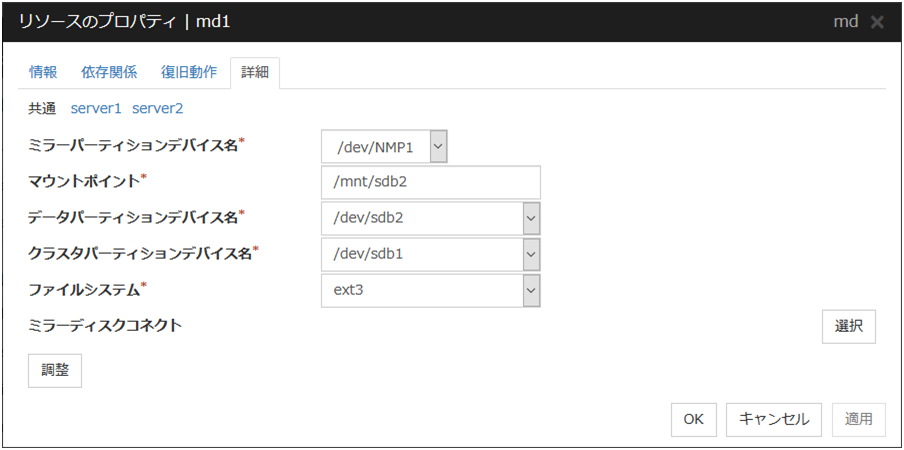

図 3.82 ミラーディスク構成 (1)¶

図 3.83 ミラーディスク構成 (2)¶

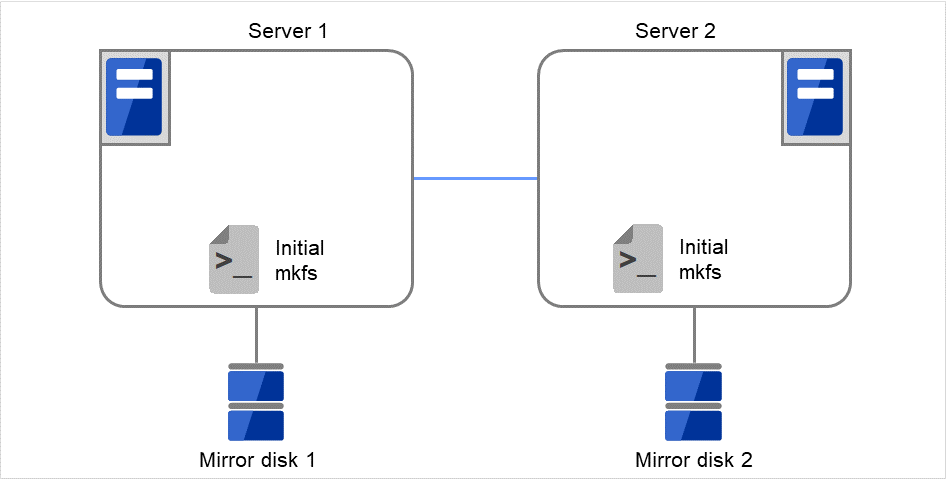

データパーティション

ミラーリングするデータ (業務データなど) を格納するパーティションのことを、データパーティションといいます。

データパーティションは以下のように割り当ててください。

- データパーティションのサイズ1GB 以上、1TB 未満のパーティションを確保してください。※ データの構築時間、復旧時間の観点より、1TB 未満のサイズを推奨します。

- パーティション ID83 (Linux)

- ファイルシステムは、ミラーリソースの mkfs の設定が [する] の場合にはクラスタ生成時に自動的に構築されます。

- ファイルシステムのアクセス制御 (mount/umount) は、CLUSTERPRO が行いますので、OS 側でデータパーティションを mount/umount する設定を行わないでください。

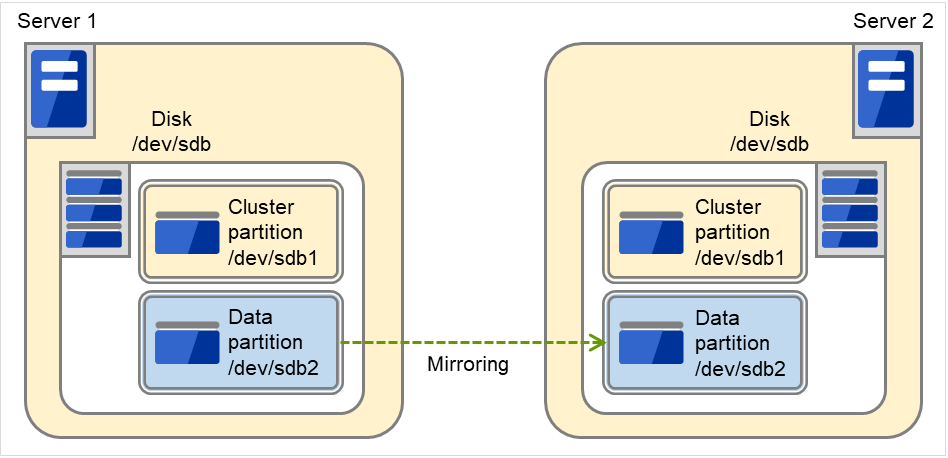

クラスタパーティション

CLUSTERPRO がミラーパーティション制御のために使用する専用パーティションを、クラスタパーティションといいます。

クラスタパーティションは以下のように割り当ててください。

- クラスタパーティションのサイズ最低 1024MiB 確保してください。ジオメトリによって 1024MB 以上になる場合がありますが、1024MB 以上でも問題ありません。

- パーティション ID83 (Linux)

- クラスタパーティションは、データミラーリング用のデータパーティションとペアで割り当てる必要があります。

- クラスタパーティションにファイルシステムを構築しないでください。

- ファイルシステムのアクセス制御 (mount/umount) は、CLUSTERPRO がミラーパーティションデバイスをマウントするデバイスとして行いますので、OS 側でクラスタパーティションを mount/umount する設定を行わないでください。

ミラーパーティションデバイス (/dev/NMPx)

1 つのミラーディスクリソースで 1 つのミラーパーティションデバイスをファイルシステムに提供します。ミラーディスクリソースとして登録すると、 1 台のサーバ (通常はリソースグループのプライマリサーバ) からのみアクセス可能になります。

通常、ユーザ (AP) はファイルシステムを経由して I/O を行うため、ミラーパーティションデバイス (dev/NMPx) を意識する必要はありません。Cluster WebUI で情報を作成するときに重複しないようにデバイス名を割り当てます。

- ファイルシステムのアクセス制御 (mount/umount) は、CLUSTERPRO が行いますのでOS 側でミラーパーティションデバイスを mount/umount する設定を行わないでください。業務アプリケーションなどからの、ミラーパーティション (ミラーディスクリソース) へのアクセス可否の考え方は、共有ディスクを使用した切替パーティション (ディスクリソース) と同じです。

ミラーパーティションの切り替えは、フェイルオーバグループごとにフェイルオーバポリシーにしたがって行われます。

ミラーディスクコネクト

ミラーディスクリソースごとに最大 2 つのミラーディスクコネクトを登録できます。

2 つのミラーディスクコネクトを登録した場合、切替時の動作などは以下のようになります。

ミラーデータの同期に使用する経路を二重化することができます。1 つのミラーディスクコネクトが断線等で使用できなくなった場合でもミラーデータを同期することができます。

ミラーリングの速度は変わりません。

データ書き込み中にミラーディスクコネクトが切り替わる場合には、一時的にミラーブレイク状態になり、ミラーディスクコネクトの切替が完了した後で差分ミラー復帰が実行されることがあります。

ミラー復帰中にミラーディスクコネクトが切り替わる場合には、ミラー復帰が中断されることがあります。自動ミラー復帰を行う設定にしている場合には、ミラーディスクコネクトの切替が完了した後でミラー復帰が自動的に再開されます。自動ミラー復帰を行わない設定の場合には、ミラーディスクコネクトの切替が完了した後でミラー復帰を再実行する必要があります。

ミラーディスクコネクトの設定に関しては、本ガイドの「2. パラメータの詳細」 - 「クラスタプロパティ」 - 「インタコネクトタブ」を参照して下さい。

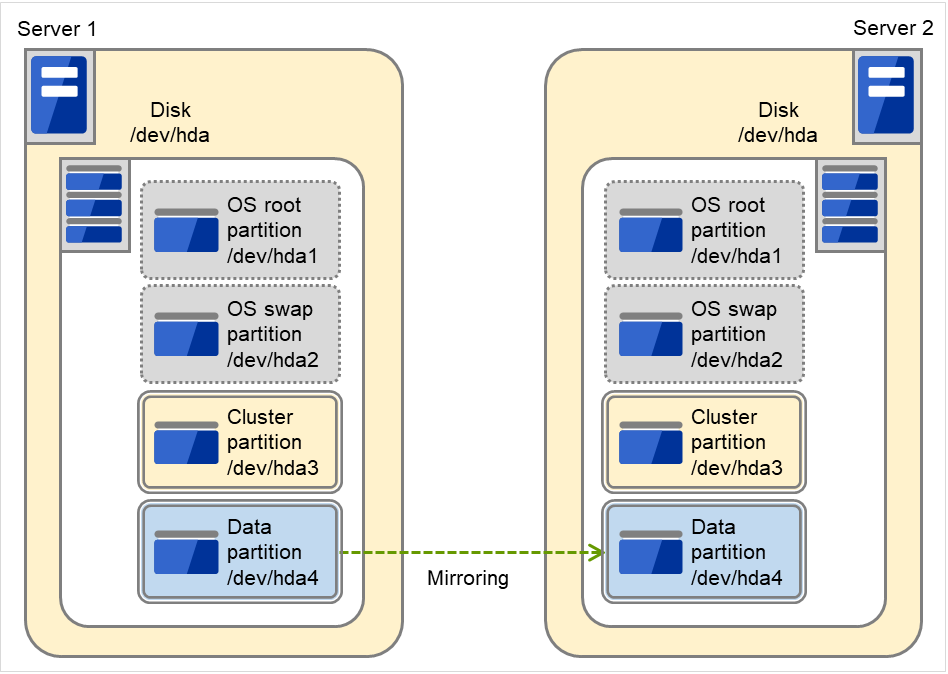

ディスクのパーティション

OS (root パーティションや swap パーティション) と同じディスク上に、ミラーパーティション (クラスタパーティション、データパーティション) を確保することも可能です。

- 障害時の保守性を重視する場合OS (root パーティションや swap パーティション) と別にミラー用のディスクを用意することを推奨します。

- H/W RAID の仕様の制限で LUN の追加ができない場合H/W RAID のプリインストールモデルで LUN 構成変更が困難な場合OS (root パーティションや swap パーティション) と同じディスクに、ミラーパーティション (クラスタパーティション、データパーティション) を確保することも可能です。

両サーバに 1 つの SCSI ディスクを増設して 1 つのミラーディスクのペアにする場合

図 3.84 増設したディスク1つをミラーディスクのペアにする場合¶

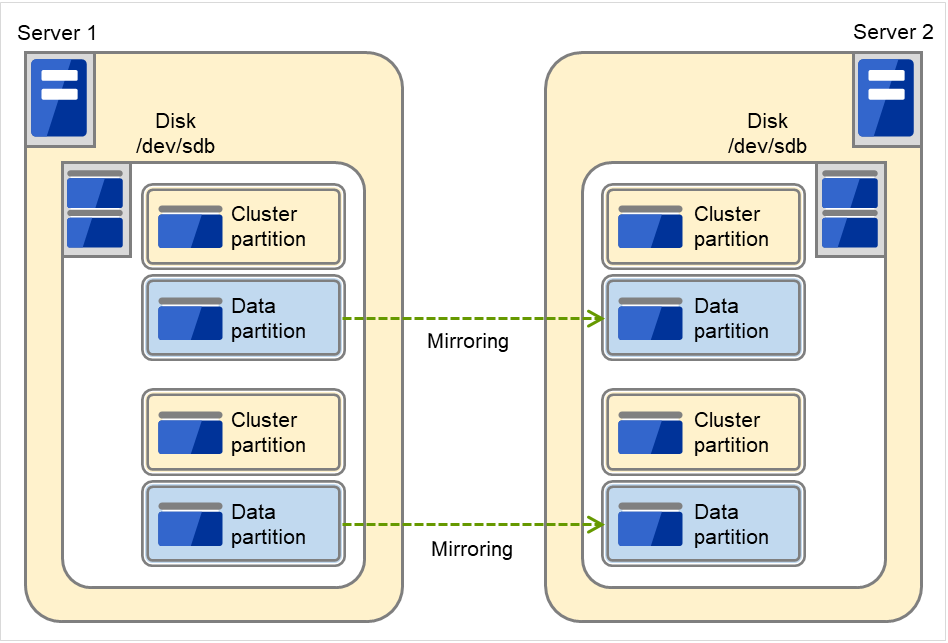

両サーバの OS が格納されている IDE ディスクの空き領域を使用してミラーディスクのペアにする場合

以下の図では、ディスクのOS等が使用していない領域をミラーパーティションデバイス(クラスタパーティション、データパーティション)として使用しています。

図 3.85 ディスクの空き領域をミラーパーティションにする場合¶

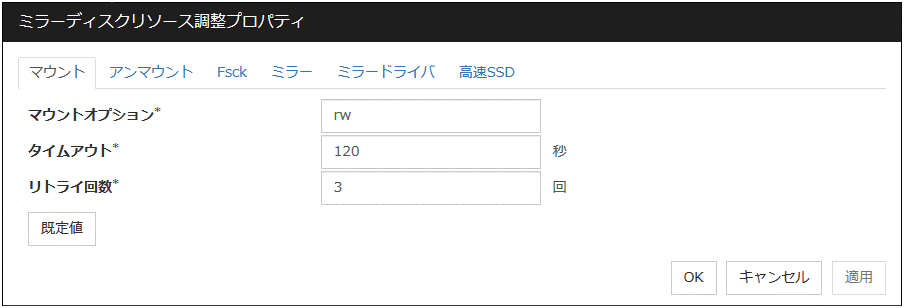

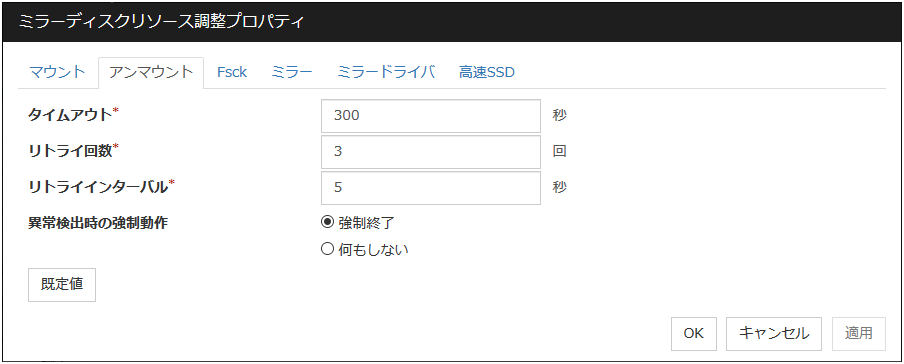

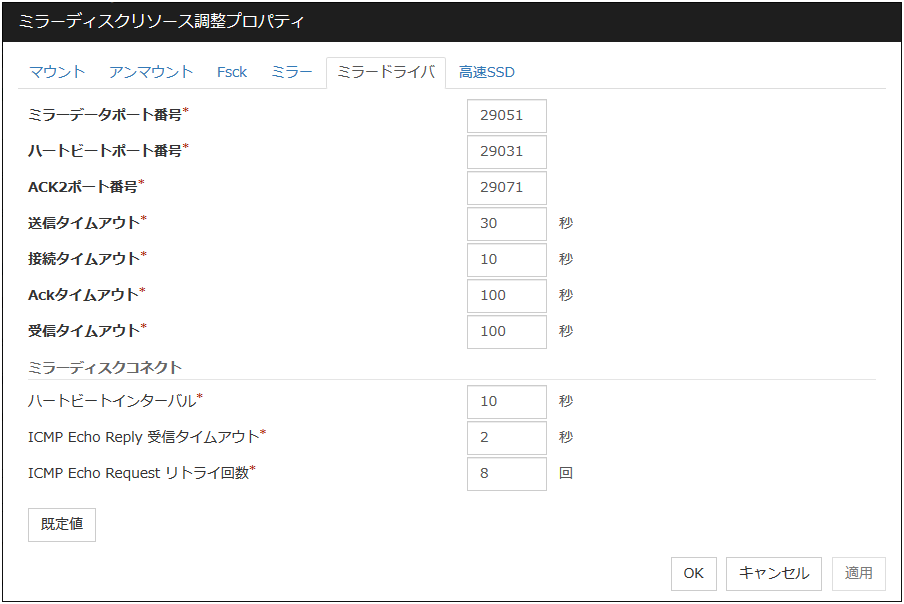

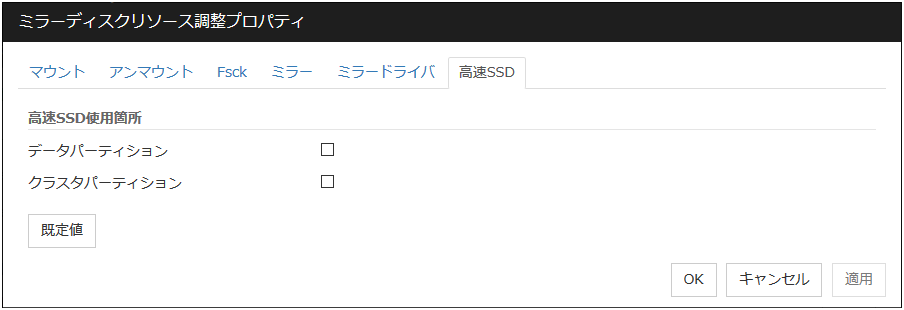

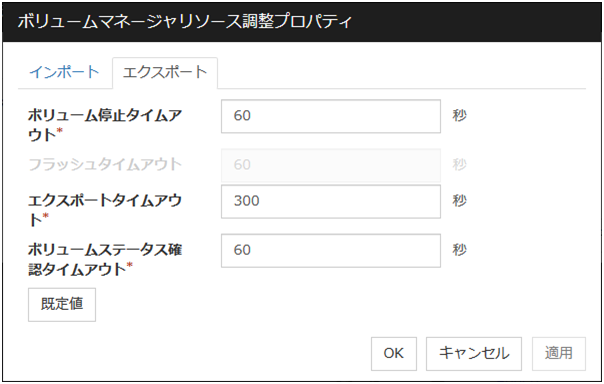

- ディスクの配置ミラーディスクとして複数のディスクを使用することができます。また 1 つのディスクに複数のミラーパーティションデバイスを割り当てて使用することができます。